Introduction

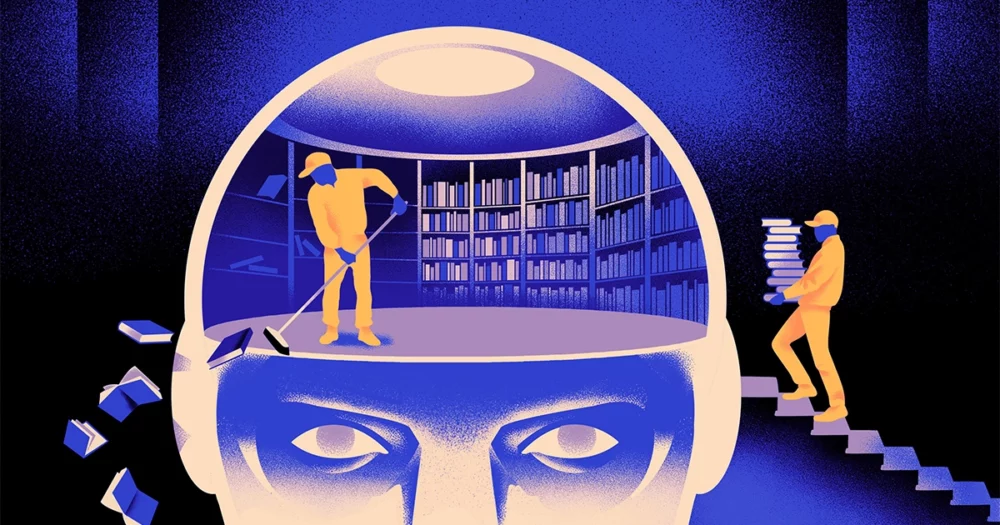

Une équipe d'informaticiens a créé un type plus agile et plus flexible du modèle d’apprentissage automatique. L’astuce : il doit périodiquement oublier ce qu’il sait. Et même si cette nouvelle approche ne remplacera pas les énormes modèles qui sous-tendent les plus grandes applications, elle pourrait en révéler davantage sur la manière dont ces programmes comprennent le langage.

La nouvelle recherche marque « une avancée significative dans le domaine », a déclaré Jea Kwon, ingénieur en IA à l'Institut des sciences fondamentales en Corée du Sud.

Les moteurs de langage d'IA utilisés aujourd'hui sont principalement alimentés par réseaux de neurones artificiels. Chaque « neurone » du réseau est une fonction mathématique qui reçoit des signaux d'autres neurones similaires, effectue des calculs et envoie des signaux à travers plusieurs couches de neurones. Au départ, le flux d'informations est plus ou moins aléatoire, mais grâce à l'entraînement, le flux d'informations entre les neurones s'améliore à mesure que le réseau s'adapte aux données d'entraînement. Si un chercheur en IA souhaite créer un modèle bilingue, par exemple, il entraînerait le modèle avec une grande pile de textes des deux langues, ce qui ajusterait les connexions entre les neurones de manière à relier le texte dans une langue avec des textes équivalents. mots dans l'autre.

Mais ce processus de formation nécessite beaucoup de puissance de calcul. Si le modèle ne fonctionne pas très bien ou si les besoins de l'utilisateur évoluent par la suite, il est difficile de l'adapter. "Disons que vous disposez d'un modèle comportant 100 langues, mais imaginez qu'une langue souhaitée n'est pas couverte", a déclaré Mikel Artetxe, co-auteur de la nouvelle recherche et fondateur de la startup d'IA Reka. « On pourrait repartir de zéro, mais ce n'est pas l'idéal. »

Artetxe et ses collègues ont tenté de contourner ces limitations. Il y a quelques années, Artetxe et d’autres ont formé un réseau neuronal dans une langue, puis ont effacé ce qu’il savait des éléments constitutifs des mots, appelés jetons. Ceux-ci sont stockés dans la première couche du réseau neuronal, appelée couche d’intégration. Ils ont laissé toutes les autres couches du modèle seules. Après avoir effacé les jetons de la première langue, ils ont recyclé le modèle sur la deuxième langue, ce qui a rempli la couche d'intégration avec de nouveaux jetons de cette langue.

Même si le modèle contenait des informations incompatibles, le recyclage a fonctionné : le modèle a pu apprendre et traiter le nouveau langage. Les chercheurs ont supposé que si la couche d'intégration stockait des informations spécifiques aux mots utilisés dans la langue, les niveaux plus profonds du réseau stockaient des informations plus abstraites sur les concepts derrière les langues humaines, ce qui aidait ensuite le modèle à apprendre la deuxième langue.

« Nous vivons dans le même monde. Nous conceptualisons les mêmes choses avec des mots différents » dans différentes langues, a déclaré Yi Hong Chen, l'auteur principal de l'article récent. « C'est pourquoi vous avez ce même raisonnement de haut niveau dans le modèle. Une pomme est quelque chose de sucré et juteux, pas seulement un mot.

Introduction

Même si cette approche par oubli était un moyen efficace d'ajouter une nouvelle langue à un modèle déjà formé, le recyclage était toujours exigeant : il nécessitait beaucoup de données linguistiques et de puissance de traitement. Chen a suggéré un ajustement : au lieu de s'entraîner, d'effacer la couche d'intégration, puis de se recycler, ils devraient périodiquement réinitialiser la couche d'intégration pendant le cycle initial de formation. "En faisant cela, tout le modèle s'habitue à la réinitialisation", a déclaré Artetxe. "Cela signifie que lorsque vous souhaitez étendre le modèle à une autre langue, c'est plus facile, car c'est ce que vous avez fait."

Les chercheurs ont utilisé un modèle de langage couramment utilisé appelé Roberta, l'ont entraîné à l'aide de leur technique d'oubli périodique et l'ont comparé aux performances du même modèle lorsqu'il a été entraîné avec l'approche standard de non-oubli. Le modèle d'oubli a obtenu des résultats légèrement moins bons que le modèle conventionnel, recevant un score de 85.1 contre 86.1 sur une mesure courante de précision linguistique. Ensuite, ils ont recyclé les modèles sur d’autres langages, en utilisant des ensembles de données beaucoup plus petits de seulement 5 millions de jetons, au lieu des 70 milliards utilisés lors de la première formation. La précision du modèle standard a diminué à 53.3 en moyenne, mais celle du modèle d'oubli n'a chuté qu'à 62.7.

Le modèle d’oubli s’est également bien mieux comporté si l’équipe imposait des limites de calcul lors du recyclage. Lorsque les chercheurs ont réduit la durée d'entraînement de 125,000 5,000 pas à seulement 57.8 37.2, la précision du modèle d'oubli a diminué à XNUMX en moyenne, tandis que le modèle standard a plongé à XNUMX, ce qui n'est rien de mieux que des suppositions aléatoires.

Introduction

L’équipe a conclu que l’oubli périodique semble améliorer le modèle dans l’apprentissage des langues en général. "Comme [ils] continuent d'oublier et de réapprendre pendant la formation, il devient plus facile d'enseigner au réseau quelque chose de nouveau plus tard", a déclaré Evgenii Nikishine, chercheur à Mila, un centre de recherche en apprentissage profond au Québec. Cela suggère que lorsque les modèles linguistiques comprennent une langue, ils le font à un niveau plus profond que la simple signification de mots individuels.

L’approche est similaire au fonctionnement de notre propre cerveau. « La mémoire humaine en général n’est pas très efficace pour stocker avec précision de grandes quantités d’informations détaillées. Au lieu de cela, les humains ont tendance à se souvenir de l’essentiel de nos expériences, en les extrapolant et en les extrapolant », a déclaré Benjamin Lévy, neuroscientifique à l'Université de San Francisco. "Permettre à l'IA des processus plus humains, comme l'oubli adaptatif, est un moyen de les amener à des performances plus flexibles."

En plus de ce qu'il pourrait dire sur le fonctionnement de la compréhension, Artetxe espère que des modèles de langage d'oubli plus flexibles pourraient également contribuer à apporter les dernières avancées de l'IA à davantage de langues. Bien que les modèles d'IA maîtrisent bien l'espagnol et l'anglais, deux langues dotées de nombreux supports de formation, les modèles ne sont pas aussi bons avec son basque natal, la langue locale spécifique au nord-est de l'Espagne. "La plupart des modèles des grandes entreprises technologiques ne le font pas bien", a-t-il déclaré. « Adapter les modèles existants au basque est la voie à suivre. »

Chen attend également avec impatience un monde où davantage de fleurs d’IA s’épanouissent. « Je pense à une situation dans laquelle le monde n'a pas besoin d'un grand modèle linguistique. Nous en avons tellement », a-t-elle déclaré. « S'il existe une usine fabriquant des modèles linguistiques, vous avez besoin de ce type de technologie. Il dispose d’un modèle de base qui peut s’adapter rapidement à de nouveaux domaines.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :possède

- :est

- :ne pas

- :où

- ][p

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- A Propos

- RÉSUMÉ

- précision

- avec précision

- adapter

- adaptatif

- s'adapte

- ajouter

- ajout

- avancer

- Après

- AI

- Modèles AI

- Tous

- seul

- déjà

- aussi

- quantités

- an

- et les

- Une autre

- Apple

- une approche

- applications

- SONT

- AS

- At

- auteur

- moyen

- base

- Essentiel

- car

- devient

- était

- derrière

- Améliorée

- jusqu'à XNUMX fois

- Big

- grande technologie

- Le plus grand

- Milliards

- Blocs

- Bloom

- tous les deux

- percées

- apporter

- Développement

- mais

- by

- calculs

- appelé

- CAN

- Canaux centraux

- Change

- chen

- circonvenir

- Coauteur

- collègues

- Commun

- communément

- Sociétés

- par rapport

- calcul

- ordinateur

- informatique

- Puissance de calcul

- concepts

- conclu

- Connexions

- contenu

- conventionnel

- pourriez

- couvert

- engendrent

- créée

- Cut/Taille

- données

- ensembles de données

- diminué

- profond

- l'apprentissage en profondeur

- profond

- exigeant

- détaillé

- DID

- différent

- do

- Ne fait pas

- faire

- domaines

- Ne pas

- chuté

- pendant

- chacun

- plus facilement

- Efficace

- enrobage

- ingénieur

- Moteurs

- Anglais

- Tout

- Équivalent

- exemple

- existant

- Expériences

- étendre

- PERSONNEL

- few

- champ

- rempli

- Prénom

- flexible

- flux

- Pour

- Avant

- fondateur

- Francisco

- De

- fonction

- Général

- généralement

- obtenez

- GitHub

- Go

- Bien

- Maniabilité

- Dur

- Vous avez

- he

- vous aider

- a aidé

- de haut niveau

- sa

- espoirs

- Comment

- HTTPS

- majeur

- humain

- Humain-Comme

- Les êtres humains

- idéal

- if

- image

- imposé

- améliore

- in

- individuel

- d'information

- initiale

- possible

- plutôt ;

- Institut

- IT

- juste

- XNUMX éléments à

- Genre

- sait

- Corée

- langue

- Langues

- gros

- plus tard

- Nouveautés

- couche

- poules pondeuses

- conduire

- APPRENTISSAGE

- apprentissage

- à gauche

- Longueur

- moins

- Niveau

- niveaux

- comme

- limites

- limites

- le travail

- locales

- LOOKS

- Lot

- click

- machine learning

- magazine

- a prendre une

- Fabrication

- de nombreuses

- matières premières.

- mathématique

- significations

- veux dire

- mesurer

- Mémoire

- pourrait

- million

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- la plupart

- beaucoup

- plusieurs

- must

- indigène

- Besoin

- Besoins

- réseau et

- neural

- Réseau neuronal

- Neurones

- Nouveauté

- aucune

- of

- on

- ONE

- uniquement

- or

- Autre

- Autres

- nos

- plus de

- propre

- Papier

- performant

- périodique

- Platon

- Intelligence des données Platon

- PlatonDonnées

- plongé

- power

- alimenté

- processus

- les process

- traitement

- Puissance de calcul

- Programmes

- Quantamamagazine

- Québec

- vite.

- aléatoire

- plutôt

- reçoit

- recevoir

- récent

- rappeler

- conditions

- un article

- chercheur

- chercheurs

- révéler

- Round

- fonctionne

- Saïd

- même

- San

- San Francisco

- dire

- Sciences

- scientifiques

- But

- gratter

- Deuxièmement

- semble

- sélectif

- envoie

- Sets

- elle

- devrait

- signaux

- significative

- similaires

- situation

- faibles

- So

- quelques

- quelque chose

- Région Sud

- South Korea

- Espagne

- Espagnol

- groupe de neurones

- Standard

- Commencer

- Commencez

- Étapes

- Encore

- stockée

- stockage

- tel

- Suggère

- sucré

- prend

- Enseignement

- équipe

- technologie

- entreprises technologiques

- technique

- Technologie

- Avoir tendance

- texte

- que

- qui

- Le

- les informations

- le monde

- leur

- Les

- puis

- Ces

- l'ont

- des choses

- En pensant

- this

- bien que?

- Avec

- à

- aujourd'hui

- Tokens

- a

- Train

- qualifié

- Formation

- astuce

- essayé

- pincer

- deux

- comprendre

- compréhension

- université

- utilisé

- d'utiliser

- en utilisant

- très

- souhaitez

- veut

- était

- Façon..

- we

- webp

- WELL

- Quoi

- quand

- qui

- tout en

- why

- comprenant

- Word

- des mots

- activités principales

- travaillé

- vos contrats

- world

- pire

- pourra

- années

- Vous n'avez

- zéphyrnet