La perte de vision se présente sous diverses formes. Pour certains, c'est dès la naissance, pour d'autres, c'est une lente descente dans le temps qui s'accompagne de nombreuses dates de péremption : Le jour où vous ne pouvez plus voir de photos, vous reconnaître, ni les visages de vos proches ni même lire votre courrier. Dans notre précédent article de blog Permettre aux malvoyants d'entendre des documents à l'aide d'Amazon Textract et d'Amazon Polly, nous vous avons montré notre application Text to Speech appelée "Lisez pour moi". L'accessibilité a parcouru un long chemin, mais qu'en est-il des images ?

Lors de la conférence AWS re:Invent 2022 à Las Vegas, nous avons démontré "Décrivez-moi" à l'AWS Builders' Fair, un site Web qui aide les malvoyants à comprendre les images grâce à la légende des images, à la reconnaissance faciale et à la synthèse vocale, une technologie que nous appelons « Image to Speech ». Grâce à l'utilisation de plusieurs services AI/ML, "Describe For Me" génère une légende d'une image d'entrée et la relira d'une voix claire et naturelle dans une variété de langues et de dialectes.

Dans cet article de blog, nous vous expliquons l'architecture de la solution derrière "Describe For Me" et les considérations de conception de notre solution.

Présentation de la solution

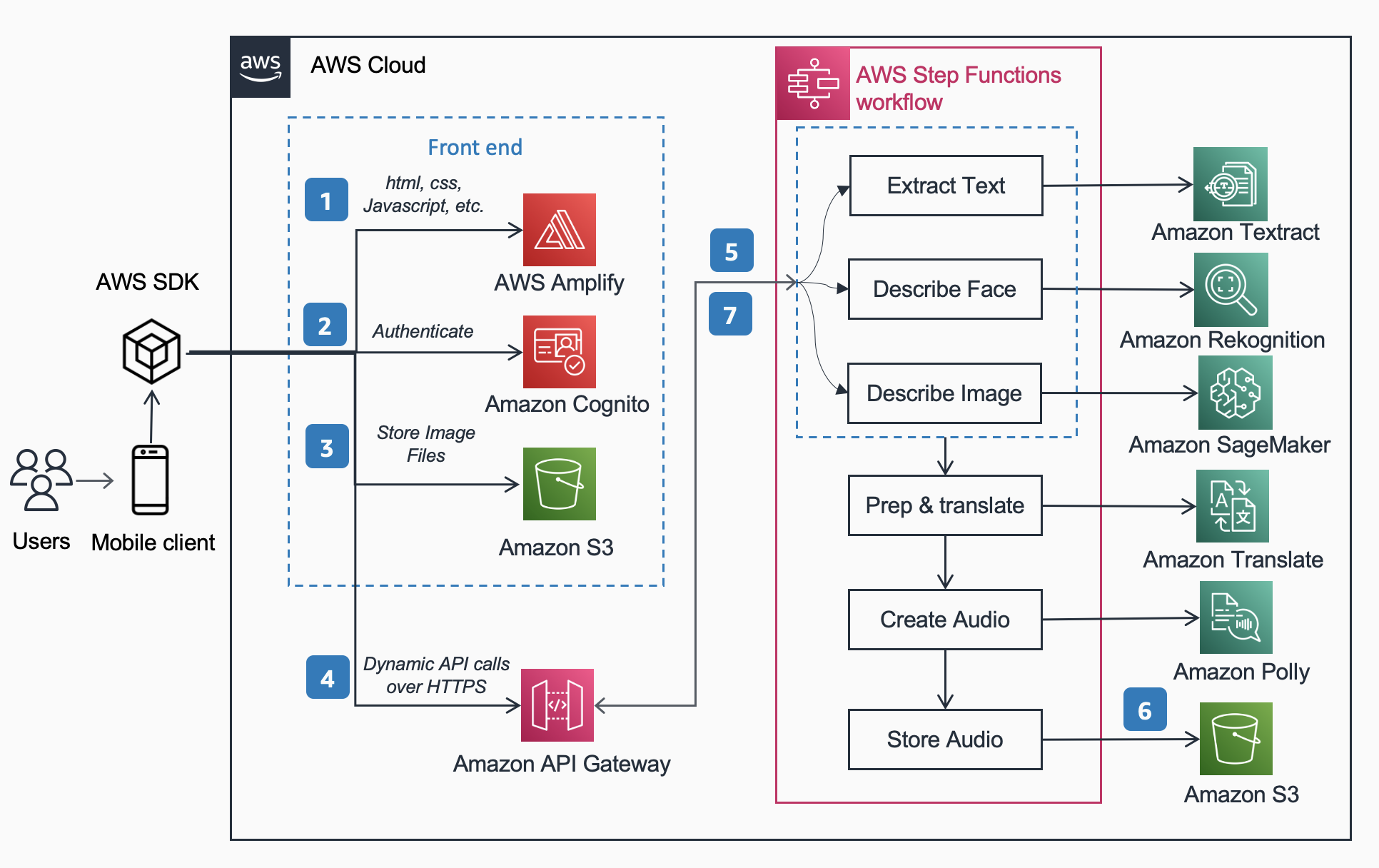

L'architecture de référence suivante montre le flux de travail d'un utilisateur prenant une photo avec un téléphone et lisant un MP3 du sous-titrage de l'image.

Le flux de travail comprend les étapes ci-dessous,

- AWS Amplifier distribue l'application Web DescribeForMe composée de HTML, JavaScript et CSS sur les appareils mobiles des utilisateurs finaux.

- Le Amazon Cognito Le groupe d'identités accorde un accès temporaire au Amazon S3 seau.

- L'utilisateur télécharge un fichier image sur le Amazon S3 seau à l'aide SDK AWS via l'application Web.

- L'application Web DescribeForMe appelle les services d'IA backend en envoyant le Amazon S3 objet Saisissez la charge utile pour Passerelle d'API Amazon

- Passerelle d'API Amazon instancie un Fonctions d'étape AWS flux de travail. La State Machine orchestre les services d'Intelligence Artificielle/Machine Learning (AI/ML) Amazon Reconnaissance, Amazon Sage Maker, Extrait d'Amazon, Amazon Traduction, et les Amazon Polly en utilisant AWS lambda fonctions.

- Le Fonctions d'étape AWS Workflow crée un fichier audio en sortie et le stocke dans Amazon S3 au format MP3.

- Une URL pré-signée avec l'emplacement du fichier audio stocké dans Amazon S3 est renvoyé au navigateur de l'utilisateur via Passerelle d'API Amazon. L'appareil mobile de l'utilisateur lit le fichier audio à l'aide de l'URL pré-signée.

Présentation de la solution

Dans cette section, nous nous concentrons sur les considérations de conception pour lesquelles nous avons choisi

- traitement parallèle au sein d'un Fonctions d'étape AWS workflow

- modèle OFA (One For All) d'apprentissage automatique pré-entraîné unifié de séquence à séquence Étreindre le visage à Amazon Sage Maker pour la légende de l'image

- Amazon Reconnaissance pour la reconnaissance faciale

Pour un aperçu plus détaillé des raisons pour lesquelles nous avons choisi une architecture sans serveur, un flux de travail synchrone, un flux de travail de fonctions d'étape express, une architecture sans tête et les avantages obtenus, veuillez lire notre article de blog précédent Permettre aux malvoyants d'entendre des documents à l'aide d'Amazon Textract et d'Amazon Polly.

Traitement parallèle

L'utilisation du traitement parallèle dans le flux de travail Step Functions a réduit le temps de calcul jusqu'à 48 %. Une fois que l'utilisateur a chargé l'image dans le compartiment S3, Amazon API Gateway instancie un flux de travail AWS Step Functions. Ensuite, les trois fonctions Lambda ci-dessous traitent l'image dans le flux de travail Step Functions en parallèle.

- La première fonction Lambda appelée

describe_imageanalyse l'image à l'aide de Modèle OFA_IMAGE_CAPTION hébergé sur un point de terminaison en temps réel SageMaker pour fournir une légende d'image. - La deuxième fonction Lambda appelée

describe_facesvérifie d'abord s'il y a des visages à l'aide d'Amazon Rekognition Détecter les visages API, et si vrai, il appelle l'API Compare Faces. La raison en est que Compare Faces générera une erreur s'il n'y a pas de visages trouvés dans l'image. De plus, appeler Détecter les visages en premier est plus rapide que simplement exécuter Comparer les visages et gérer les erreurs, donc pour les images sans visages, le temps de traitement sera plus rapide. - La troisième fonction Lambda appelée

extract_textgère la synthèse vocale à l'aide d'Amazon Textract et d'Amazon Comprehend.

L'exécution successive des fonctions Lambda est appropriée, mais le moyen le plus rapide et le plus efficace consiste à effectuer un traitement parallèle. Le tableau suivant montre le temps de calcul économisé pour trois exemples d'images.

| Image(s) | Personnes | Temps séquentiel | Temps parallèle | Gain de temps (%) | Légende |

|

0 | 1869ms | 1702ms | 8% | Un chat tigré recroquevillé dans un lit blanc moelleux. |

|

1 | 4277ms | 2197ms | 48% | Une femme vêtue d'un chemisier vert et d'un cardigan noir sourit à la caméra. Je reconnais une personne : Kanbo. |

|

4 | 6603ms | 3904ms | 40% | Les gens debout devant les Amazon Spheres. Je reconnais 3 personnes : Kanbo, Jack et Ayman. |

Légende

Hugging Face est une communauté open source et une plate-forme de science des données qui permet aux utilisateurs de partager, créer, former et déployer des modèles d'apprentissage automatique. Après avoir exploré les modèles disponibles dans le hub de modèles Hugging Face, nous avons choisi d'utiliser le Modèle OFA car, comme le décrivent les auteurs, il s'agit d'un "cadre indépendant des tâches et des modalités qui prend en charge l'exhaustivité des tâches".

OFA est une étape vers "One For All", car il s'agit d'un modèle pré-formé multimodal unifié qui peut être transféré efficacement à un certain nombre de tâches en aval. Bien que le modèle OFA prenne en charge de nombreuses tâches, notamment l'ancrage visuel, la compréhension du langage et la génération d'images, nous avons utilisé le Modèle OFA pour le sous-titrage des images dans le projet Describe For Me pour effectuer la partie image en texte de l'application. Consultez le référentiel officiel d'OFA (ICML 2022), papier pour en savoir plus sur les architectures, les tâches et les modalités unificatrices d'OFA grâce à un cadre d'apprentissage simple de séquence à séquence.

Pour intégrer OFA dans notre application, nous avons cloné le référentiel de Hugging Face et conteneurisé le modèle pour le déployer sur un point de terminaison SageMaker. Le bloc-notes dans ce dépôt est un excellent guide pour déployer le grand modèle OFA dans un notebook Jupyter dans SageMaker. Après avoir conteneurisé votre script d'inférence, le modèle est prêt à être déployé derrière un point de terminaison SageMaker, comme décrit dans le SageMaker Documentation. Une fois le modèle déployé, créez un point de terminaison HTTPS qui peut être intégré à la fonction lambda « describe_image » qui analyse l'image pour créer la légende de l'image. Nous avons déployé le petit modèle OFA car il s'agit d'un modèle plus petit et peut être déployé dans un délai plus court tout en obtenant des performances similaires.

Des exemples de contenu image-parole généré par "Describe For Me" sont présentés ci-dessous :

Les aurores boréales, ou aurores boréales, remplissent le ciel nocturne au-dessus de la silhouette d'une maison.

Un chien dort sur une couverture rouge sur un plancher de bois franc, à côté d'une valise ouverte remplie de jouets.

Un chat tigré recroquevillé dans un lit blanc moelleux.

La reconnaissance faciale

Amazon Rekognition Image fournit la Détecter les visages opération qui recherche les principales caractéristiques du visage telles que les yeux, le nez et la bouche pour détecter les visages dans une image d'entrée. Dans notre solution, nous exploitons cette fonctionnalité pour détecter toute personne dans l'image d'entrée. Si une personne est détectée, nous utilisons alors le Comparer les visages opération pour comparer le visage dans l'image d'entrée avec les visages avec lesquels "Describe For Me" a été formé et décrire la personne par son nom. Nous avons choisi d'utiliser Rekognition pour la détection faciale en raison de sa grande précision et de la simplicité de son intégration dans notre application avec les fonctionnalités prêtes à l'emploi.

Un groupe de personnes posant pour une photo dans une pièce. Je reconnais 4 personnes : Jack, Kanbo, Alak et Trac. Il y avait aussi du texte dans l'image. Il se lit comme suit : AWS concernant : inventer

Cas d'utilisation potentiels

Génération de texte alternatif pour les images Web

Toutes les images d'un site Web doivent avoir un texte alternatif afin que les lecteurs d'écran puissent les parler aux malvoyants. C'est aussi bon pour l'optimisation des moteurs de recherche (SEO). La création de sous-titres alternatifs peut prendre du temps car un rédacteur est chargé de les fournir dans un document de conception. L'API Describe For Me pourrait générer automatiquement un texte alternatif pour les images. Il pourrait également être utilisé comme plug-in de navigateur pour ajouter automatiquement une légende d'image aux images manquant de texte alternatif sur n'importe quel site Web.

Description audio pour la vidéo

La description audio fournit une piste de narration pour le contenu vidéo afin d'aider les malvoyants à suivre les films. À mesure que la légende d'image devient plus robuste et précise, un flux de travail impliquant la création d'une piste audio basée sur des descriptions pour les parties clés d'une scène pourrait être possible. Amazon Rekognition peut déjà détecter les changements de scène, les logos et les séquences de générique, ainsi que la détection des célébrités. Une future version de describe permettrait d'automatiser cette fonctionnalité clé pour les films et les vidéos.

Conclusion

Dans cet article, nous avons expliqué comment utiliser les services AWS, y compris l'IA et les services sans serveur, pour aider les malvoyants à voir des images. Vous pouvez en savoir plus sur le projet Describe For Me et l'utiliser en visitant descriptionforme.com. En savoir plus sur les caractéristiques uniques de Amazon Sage Maker, Reconnaissance Amazon et les terres parsemées de Partenariat AWS avec Hugging Face.

Clause de non-responsabilité du modèle ML tiers à titre indicatif

Ce guide est fourni à titre informatif uniquement. Vous devez toujours effectuer votre propre évaluation indépendante et prendre des mesures pour vous assurer que vous vous conformez à vos propres pratiques et normes spécifiques de contrôle de la qualité, ainsi qu'aux règles, lois, réglementations, licences et conditions d'utilisation locales qui s'appliquent à vous, à votre contenu et à le modèle d'apprentissage automatique tiers référencé dans ce guide. AWS n'a aucun contrôle ou autorité sur le modèle d'apprentissage automatique tiers référencé dans ce guide, et ne fait aucune représentation ou garantie que le modèle d'apprentissage automatique tiers est sécurisé, exempt de virus, opérationnel ou compatible avec votre environnement de production. et normes. AWS ne fait aucune représentation, garantie ou garantie que toute information contenue dans ce guide se traduira par un résultat ou un résultat particulier.

À propos des auteurs

Jack Marchetti est un architecte de solutions senior chez AWS, dont l'objectif est d'aider les clients à moderniser et à mettre en œuvre des architectures sans serveur et axées sur les événements. Jack est légalement aveugle et réside à Chicago avec sa femme Erin et son chat Minou. Il est également scénariste et réalisateur et se concentre principalement sur les films de Noël et l'horreur. Voir la filmographie de Jack à son Page IMDb.

Jack Marchetti est un architecte de solutions senior chez AWS, dont l'objectif est d'aider les clients à moderniser et à mettre en œuvre des architectures sans serveur et axées sur les événements. Jack est légalement aveugle et réside à Chicago avec sa femme Erin et son chat Minou. Il est également scénariste et réalisateur et se concentre principalement sur les films de Noël et l'horreur. Voir la filmographie de Jack à son Page IMDb.

Alak Eswaradas est architecte de solutions senior chez AWS basé à Chicago, Illinois. Elle se passionne pour aider les clients à concevoir des architectures cloud en utilisant les services AWS pour résoudre les défis commerciaux. Alak est enthousiaste à l'idée d'utiliser SageMaker pour résoudre une variété de cas d'utilisation ML pour les clients AWS. Lorsqu'elle ne travaille pas, Alak aime passer du temps avec ses filles et explorer le plein air avec ses chiens.

Alak Eswaradas est architecte de solutions senior chez AWS basé à Chicago, Illinois. Elle se passionne pour aider les clients à concevoir des architectures cloud en utilisant les services AWS pour résoudre les défis commerciaux. Alak est enthousiaste à l'idée d'utiliser SageMaker pour résoudre une variété de cas d'utilisation ML pour les clients AWS. Lorsqu'elle ne travaille pas, Alak aime passer du temps avec ses filles et explorer le plein air avec ses chiens.

Kandyce Bohannon est un architecte de solutions senior basé à Minneapolis, MN. Dans ce rôle, Kandyce travaille en tant que conseiller technique auprès des clients AWS alors qu'ils modernisent les stratégies technologiques, en particulier liées aux données et DevOps, pour mettre en œuvre les meilleures pratiques dans AWS. De plus, Kandyce est passionnée par le mentorat des futures générations de technologues et la mise en valeur des femmes dans la technologie par le biais du programme AWS She Builds Tech Skills.

Kandyce Bohannon est un architecte de solutions senior basé à Minneapolis, MN. Dans ce rôle, Kandyce travaille en tant que conseiller technique auprès des clients AWS alors qu'ils modernisent les stratégies technologiques, en particulier liées aux données et DevOps, pour mettre en œuvre les meilleures pratiques dans AWS. De plus, Kandyce est passionnée par le mentorat des futures générations de technologues et la mise en valeur des femmes dans la technologie par le biais du programme AWS She Builds Tech Skills.

Trac-Do est architecte de solutions chez AWS. Dans son rôle, Trac travaille avec les entreprises clientes pour soutenir leurs migrations vers le cloud et leurs initiatives de modernisation des applications. Il est passionné par l'apprentissage des défis des clients et leur résolution avec des solutions robustes et évolutives utilisant les services AWS. Trac vit actuellement à Chicago avec sa femme et ses 3 garçons. Il est un grand passionné d'aviation et est en train de terminer sa licence de pilote privé.

Trac-Do est architecte de solutions chez AWS. Dans son rôle, Trac travaille avec les entreprises clientes pour soutenir leurs migrations vers le cloud et leurs initiatives de modernisation des applications. Il est passionné par l'apprentissage des défis des clients et leur résolution avec des solutions robustes et évolutives utilisant les services AWS. Trac vit actuellement à Chicago avec sa femme et ses 3 garçons. Il est un grand passionné d'aviation et est en train de terminer sa licence de pilote privé.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoAiStream. Intelligence des données Web3. Connaissance Amplifiée. Accéder ici.

- Frapper l'avenir avec Adryenn Ashley. Accéder ici.

- Achetez et vendez des actions de sociétés PRE-IPO avec PREIPO®. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/introducing-an-image-to-speech-generative-ai-application-using-amazon-sagemaker-and-hugging-face/

- :possède

- :est

- :ne pas

- $UP

- 100

- 2022

- 7

- a

- A Propos

- au dessus de

- accès

- précision

- Avec cette connaissance vient le pouvoir de prendre

- la réalisation de

- ajouter

- En outre

- conseiller

- Après

- AI

- Services d'IA

- AI / ML

- Aide

- Tous

- permettre

- permet

- le long de

- déjà

- aussi

- alternative

- Amazon

- Passerelle d'API Amazon

- Amazon comprendre

- Amazon Reconnaissance

- Amazon Sage Maker

- Extrait d'Amazon

- Amazon Web Services

- an

- des analyses

- et les

- tous

- api

- appli

- Application

- Appliquer

- architecture

- SONT

- artificiel

- intelligence artificielle

- AS

- Évaluation de risque climatique

- At

- acoustique

- Aurora

- autorité

- auteurs

- automatiquement

- automatiser

- disponibles

- aviation

- AWS

- Fonctions d'étape AWS

- RETOUR

- backend

- basé

- BE

- car

- devient

- était

- derrière

- ci-dessous

- avantages.

- LES MEILLEURS

- les meilleures pratiques

- Big

- Noir

- Blog

- Box

- navigateur

- construire

- construit

- la performance des entreprises

- mais

- by

- appelé

- appel

- Appels

- appareil photo

- CAN

- capacités

- légendes

- cas

- CHAT

- Célébrité

- globaux

- Modifications

- vérifier

- Contrôles

- Chicago

- choisir

- Noël

- clair

- le cloud

- comment

- vient

- Communautés

- comparer

- compatible

- compléter

- comprendre

- calcul

- Congrès

- considérations

- Qui consiste

- contenu

- des bactéries

- contrôles

- pourriez

- engendrent

- crée des

- La création

- création

- crédit

- CSS

- Lecture

- Clients

- données

- science des données

- Dates

- journée

- démontré

- déployer

- déployé

- décrire

- décrit

- la description

- Conception

- détaillé

- détecté

- Détection

- dispositif

- Compatibles

- Directeur

- discuté

- do

- document

- INSTITUTIONNELS

- Chien

- faire

- de manière efficace

- efficace

- fin

- Endpoint

- Moteur

- assurer

- Entreprise

- passionné

- enthousiaste

- Environment

- erreur

- Erreurs

- notamment

- Pourtant, la

- excellent

- expiration

- Explorer

- express

- Yeux

- Visage

- visages

- Soin du visage

- la reconnaissance faciale

- juste

- plus rapide

- Fonctionnalité

- Fonctionnalités:

- Déposez votre dernière attestation

- remplir

- rempli

- Prénom

- Etage

- Focus

- concentré

- suivre

- Abonnement

- Pour

- le format

- document

- trouvé

- Framework

- De

- avant

- fonction

- fonctions

- avenir

- porte

- générer

- généré

- génère

- génération

- Les générations

- génératif

- IA générative

- Bien

- subventions

- Vert

- Réservation de groupe

- garantit

- l'orientation

- guide

- Poignées

- Maniabilité

- Vous avez

- he

- entendre

- vous aider

- aider

- aide

- ici

- Haute

- sa

- horreur

- organisé

- Villa

- Comment

- How To

- HTML

- HTTPS

- Moyeu

- i

- if

- Illinois

- image

- satellite

- Mettre en oeuvre

- in

- inclut

- Y compris

- indépendant

- d'information

- D'information

- les initiatives

- contribution

- intégrer

- des services

- Intelligence

- développement

- Découvrez le tout nouveau

- invoque

- impliquant

- IT

- jack

- JavaScript

- jpg

- ACTIVITES

- langue

- Langues

- gros

- LAS

- Las Vegas

- Lois

- APPRENTISSAGE

- apprentissage

- Levier

- Licence

- licences

- Vit

- locales

- emplacement

- Location

- LOOKS

- perte

- aimé

- click

- machine learning

- a prendre une

- de nombreuses

- les mesures

- mentorat

- manquant

- ML

- Breeze Mobile

- appareil mobile

- appareils mobiles

- modèle

- numériques jumeaux (digital twin models)

- moderniser

- PLUS

- plus efficace

- bouche

- Films

- plusieurs

- prénom

- next

- nuit

- aucune

- nez

- cahier

- nombre

- of

- officiel

- on

- une fois

- ONE

- et, finalement,

- uniquement

- ouvert

- open source

- opération

- opérationnel

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- or

- Autres

- nos

- ande

- Résultat

- l'extérieur

- sortie

- plus de

- vue d'ensemble

- propre

- Parallèle

- particulier

- Partenariat

- les pièces

- fête

- passionné

- Personnes

- Effectuer

- performant

- période

- personne

- Téléphone

- image

- PHOTOS

- pilote

- plateforme

- Platon

- Intelligence des données Platon

- PlatonDonnées

- jouer

- joue

- veuillez cliquer

- plug-in

- pool

- partieInvestir dans des appareils économes en énergie et passer à l'éclairage

- possible

- Post

- pratiques

- précédent

- primaire

- Privé

- processus

- traitement

- Vidéo

- Programme

- Projet

- fournir

- fournit

- aportando

- des fins

- qualité

- RE

- Lire

- lecteurs

- solutions

- en temps réel

- raison

- reconnaissance

- reconnaître

- Rouge

- Prix Réduit

- règlements

- en relation

- dépôt

- conditions

- résultat

- robuste

- Rôle

- Salle

- pour le running

- sagemaker

- Épargnes

- évolutive

- scène

- Sciences

- pour écran

- lecteurs d'écran

- Sdk

- Rechercher

- moteur de recherche

- Deuxièmement

- Section

- sécurisé

- sur le lien

- envoi

- supérieur

- envoyé

- seo

- Sans serveur

- Services

- Partager

- elle

- devrait

- mettre en valeur

- montré

- montré

- Spectacles

- similaires

- étapes

- simplement

- site

- compétences

- Sky

- lent

- faibles

- So

- sur mesure

- Solutions

- RÉSOUDRE

- Résoudre

- quelques

- parler

- groupe de neurones

- discours

- Dépenses

- Normes

- Région

- étapes

- Étapes

- Encore

- stockée

- STORES

- les stratégies

- tel

- convient

- Support

- Les soutiens

- chat tigré

- table

- Prenez

- prise

- Tâche

- tâches

- technologie

- Technique

- technologues

- Technologie

- temporaire

- conditions

- Text-to-Speech

- que

- qui

- Le

- L'État

- leur

- Les

- puis

- Là.

- l'ont

- Troisièmement

- des tiers.

- this

- trois

- Avec

- fiable

- à

- vers

- suivre

- Train

- qualifié

- transférer

- oui

- comprendre

- compréhension

- unifiée

- expérience unique et authentique

- sur

- URL

- utilisé

- d'utiliser

- Utilisateur

- utilisateurs

- en utilisant

- utilisé

- Utilisant

- variété

- divers

- VEGAS

- version

- Vidéo

- Vidéos

- Voir

- Voix

- était

- Façon..

- we

- web

- services Web

- Site Web

- WELL

- Quoi

- quand

- qui

- tout en

- blanc

- why

- femme

- sera

- comprenant

- dans les

- sans

- femme

- Femme

- femmes dans la technologie

- de travail

- vos contrats

- pourra

- Vous n'avez

- Votre

- vous-même

- zéphyrnet