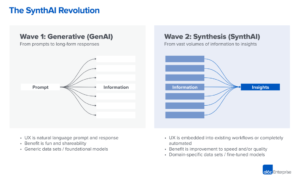

Avec l'inflexion des grands modèles de langage (LLM), nous assistons à un changement de paradigme dans le développement de logiciels et l'industrie informatique dans son ensemble. L'IA se produit et une nouvelle pile se forme sous nos yeux. C'est à nouveau comme Internet, qui met en service de nouveaux composants d'infrastructure conçus pour la nouvelle façon de faire les choses.

Il est de plus en plus reconnu que les LLM sont en fait une nouvelle forme d'ordinateur, en quelques sortes. Ils peuvent exécuter des "programmes" écrits en langage naturel (c'est-à-dire des invites), exécuter des tâches informatiques arbitraires (par exemple, écrire du code Python ou rechercher sur Google) et renvoyer les résultats à l'utilisateur sous une forme lisible par l'homme. C'est un gros problème, pour deux raisons:

- Une nouvelle classe d'applications autour du résumé et du contenu génératif est désormais possible entraînant un changement de comportement des consommateurs autour de la consommation de logiciels.

- Une nouvelle classe de développeurs est désormais capable d'écrire des logiciels. La programmation informatique ne nécessite désormais que la maîtrise de l'anglais (ou d'un autre langage humain), et non une formation dans un langage de programmation traditionnel comme Python ou JavaScript.

L'une de nos principales priorités chez Andreessen Horowitz est d'identifier les entreprises qui construisent les composants clés de cette nouvelle pile d'IA. Nous sommes ravis d'annoncer que nous menons un tour de table de série B de 100 millions de dollars en Pinecone, pour soutenir leur vision de devenir la couche de mémoire pour les applications d'IA.

Le problème : les LLM hallucinent et sont apatrides

Un énorme défi avec les LLM actuels est l'hallucination. Ils donnent des réponses très confiantes qui sont factuellement et parfois logiquement incorrectes. Par exemple, demander à un LLM la marge brute d'Apple pour le dernier trimestre peut aboutir à une réponse confiante de 63 milliards de dollars. Le modèle peut même étayer sa réponse en expliquant qu'en soustrayant 25 milliards de dollars du coût des marchandises de 95 milliards de dollars de revenus, vous obtenez une marge brute de 63 milliards de dollars. Bien sûr, c'est faux sur plusieurs dimensions :

- Premièrement, le chiffre d'affaires est erroné, car le LLM ne dispose pas de données en temps réel. Il travaille à partir de données d'entraînement obsolètes qui datent de plusieurs mois ou probablement d'années.

- Deuxièmement, il a récupéré ces chiffres de revenus et de coûts de marchandises au hasard dans les états financiers d'une autre entreprise fruitière.

- Troisièmement, le calcul de sa marge brute n'est pas mathématiquement correct.

Imaginez que vous donniez cette réponse au PDG d'une fortune 500 compagnie.

Tout cela se produit parce qu'en fin de compte, les LLM sont des machines de prédiction formées sur de grandes quantités de données Internet tierces. Souvent, les informations dont l'utilisateur a besoin ne figurent tout simplement pas dans l'ensemble de formation. Ainsi, le modèle donnera les réponses les plus probables et linguistiquement bien formatées en fonction de ses données de formation obsolètes. Nous pouvons déjà commencer à voir une solution potentielle au problème ci-dessus : fournir aux LLM des données contextuelles pertinentes sur les entreprises privées en temps réel.

La forme générale de ce problème est que, du point de vue des systèmes, les LLM et la plupart des autres modèles d'IA sont sans état à l'étape d'inférence. Chaque fois que vous appelez l'API GPT-4, le résultat dépend uniquement sur les données et les paramètres que vous envoyez dans la charge utile. Le modèle n'a aucun moyen intégré d'incorporer des données contextuelles ou de se souvenir de ce que vous avez déjà demandé. Le réglage fin du modèle est possible, mais il est coûteux et relativement rigide (c'est-à-dire que le modèle ne peut pas répondre aux nouvelles données en temps réel). Étant donné que les modèles ne gèrent pas l'état ou la mémoire par eux-mêmes, c'est aux développeurs de combler le vide.

La solution : les bases de données vectorielles sont la couche de stockage des LLM

C'est là que Pinecone entre en jeu.

Pinecone est une base de données externe où les développeurs peuvent stocker des données contextuelles pertinentes pour les applications LLM. Plutôt que d'envoyer de grandes collections de documents dans les deux sens à chaque appel d'API, les développeurs peuvent les stocker dans une base de données Pinecone, puis sélectionner uniquement les quelques-uns les plus pertinents pour une requête donnée - une approche appelée apprentissage en contexte. C'est un incontournable pour que les cas d'utilisation en entreprise s'épanouissent vraiment.

En particulier, Pinecone est un vecteur base de données, ce qui signifie que les données sont stockées sous la forme d'informations sémantiquement significatives plongements. Bien qu'une explication technique des incorporations dépasse le cadre de cet article, la partie importante à comprendre est que les LLM fonctionnent également sur des intégrations vectorielles - donc en stockant les données dans Pinecone dans ce format, une partie du travail d'IA a effectivement été pré-traitée et déchargé dans la base de données.

Contrairement aux bases de données existantes, qui sont conçues pour des charges de travail analytiques transactionnelles ou exhaustives atomiques, la base de données vectorielle (Pinecone) est conçue pour une recherche de voisins approximative cohérente à terme, le bon paradigme de base de données pour les vecteurs de plus grande dimension. Ils fournissent également des API de développement s'intégrant à d'autres composants clés des applications d'IA, telles que OpenAI, Cohere, LangChain, etc. Une telle conception bien pensée facilite grandement la vie des développeurs. Des tâches d'IA simples telles que la recherche sémantique, les recommandations de produits ou le classement des flux peuvent également être modélisées directement en tant que problèmes de recherche vectorielle et exécutées sur la base de données vectorielle sans étape finale d'inférence de modèle - quelque chose que les bases de données existantes ne peuvent pas faire.

Pinecone est la norme émergente pour la gestion des données d'entreprise d'état et contextuelles dans les applications LLM. Nous pensons qu'il s'agit d'un composant d'infrastructure important, fournissant la couche de stockage, ou « mémoire », à une toute nouvelle pile d'applications d'IA.

Des progrès incroyables pour Pinecone à ce jour

Pinecone n'est pas la seule base de données vectorielles, mais nous pensons que c'est la principale base de données vectorielles - prête maintenant pour une adoption dans le monde réel - avec une marge significative. Pinecone a vu le nombre de clients payants multiplié par 8 (environ 1,600 XNUMX) en seulement trois mois, y compris des entreprises technologiques tournées vers l'avenir comme Shopify, Gong, Zapier, etc. Il est utilisé dans un large éventail d'industries, y compris les logiciels d'entreprise, les applications grand public, le commerce électronique, la fintech, l'assurance, les médias et l'IA/ML.

Nous attribuons ce succès non seulement à la profonde compréhension de l'équipe de l'utilisateur, du marché et de la technologie, mais aussi - surtout - à leur approche produit native du cloud dès le départ. L'une des parties les plus difficiles de la construction de ce service consiste à fournir un backend cloud fiable et hautement disponible qui répond à un large éventail d'objectifs de performances et de SLA pour les clients. Avec de multiples itérations sur l'architecture du produit et la gestion de nombreux clients payants à grande échelle en production, cette équipe a fait preuve de l'excellence opérationnelle attendue d'une base de données de production.

Pinecone a été fondée par Edo Liberty, qui est depuis longtemps un ardent défenseur de l'importance des bases de données vectorielles dans l'apprentissage automatique, notamment de la manière dont elles peuvent permettre à chaque entreprise de créer des cas d'utilisation en plus des LLM. En tant que mathématicien appliqué, il a passé sa carrière à étudier et à mettre en œuvre des algorithmes de recherche vectorielle de pointe. En même temps, il était un pragmatique, construisant des outils ML de base comme Sagemaker chez AWS et traduisant la recherche appliquée en ML en produits pratiques que les clients peuvent utiliser. Il est rare de voir une telle combinaison de recherche approfondie et de réflexion pragmatique sur les produits.

Edo est rejoint par Bob Wiederhold, un PDG et opérateur expérimenté (anciennement de Couchbase), en tant que partenaire du côté des opérations en tant que président et directeur de l'exploitation. Pinecone dispose également d'une équipe fantastique de cadres et d'ingénieurs possédant une expertise approfondie des systèmes cloud provenant d'endroits comme AWS, Google et Databricks. Nous sommes impressionnés par l'expertise approfondie en ingénierie de l'équipe, l'accent mis sur l'expérience des développeurs et l'exécution efficace de GTM, et nous avons le privilège de nous associer à eux pour construire la couche de mémoire pour les applications d'IA.

* * *

Les opinions exprimées ici sont celles du personnel individuel d'AH Capital Management, LLC (« a16z ») cité et ne sont pas les opinions d'a16z ou de ses sociétés affiliées. Certaines informations contenues ici ont été obtenues de sources tierces, y compris de sociétés de portefeuille de fonds gérés par a16z. Bien qu'elles proviennent de sources considérées comme fiables, a16z n'a pas vérifié ces informations de manière indépendante et ne fait aucune déclaration quant à l'exactitude durable des informations ou à leur pertinence dans une situation donnée. De plus, ce contenu peut inclure des publicités de tiers ; a16z n'a pas examiné ces publicités et n'approuve aucun contenu publicitaire qu'elles contiennent.

Ce contenu est fourni à titre informatif uniquement et ne doit pas être considéré comme un conseil juridique, commercial, d'investissement ou fiscal. Vous devriez consulter vos propres conseillers sur ces questions. Les références à des titres ou à des actifs numériques sont uniquement à des fins d'illustration et ne constituent pas une recommandation d'investissement ou une offre de fournir des services de conseil en investissement. En outre, ce contenu n'est ni destiné ni destiné à être utilisé par des investisseurs ou des investisseurs potentiels, et ne peut en aucun cas être invoqué pour prendre une décision d'investir dans un fonds géré par a16z. (Une offre d'investissement dans un fonds a16z ne sera faite que par le mémorandum de placement privé, le contrat de souscription et toute autre documentation pertinente de ce fonds et doit être lu dans son intégralité.) Tous les investissements ou sociétés de portefeuille mentionnés, référencés ou décrits ne sont pas représentatifs de tous les investissements dans des véhicules gérés par a16z, et rien ne garantit que les investissements seront rentables ou que d'autres investissements réalisés à l'avenir auront des caractéristiques ou des résultats similaires. Une liste des investissements effectués par des fonds gérés par Andreessen Horowitz (à l'exclusion des investissements pour lesquels l'émetteur n'a pas autorisé a16z à divulguer publiquement ainsi que des investissements non annoncés dans des actifs numériques cotés en bourse) est disponible sur https://a16z.com/investments /.

Les tableaux et graphiques fournis ici sont uniquement à des fins d'information et ne doivent pas être utilisés pour prendre une décision d'investissement. Les performances passées ne représentent pas les résultats futurs. Le contenu ne parle qu'à la date indiquée. Toutes les projections, estimations, prévisions, objectifs, perspectives et/ou opinions exprimées dans ces documents sont susceptibles d'être modifiées sans préavis et peuvent différer ou être contraires aux opinions exprimées par d'autres. Veuillez consulter https://a16z.com/disclosures pour des informations supplémentaires importantes.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoAiStream. Intelligence des données Web3. Connaissance Amplifiée. Accéder ici.

- Frapper l'avenir avec Adryenn Ashley. Accéder ici.

- La source: https://a16z.com/2023/04/27/investing-in-pinecone/

- :possède

- :est

- :ne pas

- :où

- 100 millions de dollars

- $UP

- 1

- 500

- a

- a16z

- Capable

- A Propos

- au dessus de

- précision

- à travers

- actually

- ajout

- Supplémentaire

- Adoption

- Numérique

- conseils

- consultatif

- services de conseil

- avocat

- Affiliés

- encore

- contrat

- AI

- AI / ML

- algorithmes

- Tous

- déjà

- aussi

- quantités

- an

- Analytique

- ainsi que

- Andreessen

- Andreessen Horowitz

- Annoncer

- Une autre

- répondre

- réponses

- tous

- api

- Apis

- Apple

- Application

- applications

- appliqué

- une approche

- d'environ

- applications

- architecture

- SONT

- autour

- AS

- Outils

- assurance

- At

- disponibles

- AWS

- RETOUR

- backend

- basé

- BE

- car

- devenir

- était

- before

- CROYONS

- cru

- Au-delà

- Big

- Milliards

- Bloom

- grain

- brand

- NOUVEAU

- construire

- Développement

- construit

- intégré

- la performance des entreprises

- mais

- by

- Appelez-nous

- appelé

- Appels

- CAN

- capital

- Carrière

- cas

- CEO

- certaines

- challenge

- Change

- caractéristiques

- conditions

- classe

- le cloud

- code

- collections

- combinaison

- vient

- Sociétés

- Société

- De l'entreprise

- composant

- composants électriques

- ordinateur

- informatique

- confiance

- cohérent

- constituer

- consommateur

- consommation

- contenu

- contextuel

- contraire

- roucouler

- Core

- Prix

- Couchbase

- Cours

- Courant

- des clients

- Clients

- En investissant dans une technologie de pointe, les restaurants peuvent non seulement rester compétitifs dans un marché en constante évolution, mais aussi améliorer significativement l'expérience de leurs clients.

- données

- Base de données

- bases de données

- Date

- journée

- affaire

- décision

- profond

- dépend

- décrit

- Conception

- un

- Développeur

- mobiles

- Développement

- différer

- numérique

- Actifs numériques

- dimensions

- directement

- Divulguer

- do

- document

- Documentation

- Ne fait pas

- faire

- Ne pas

- e

- e-commerce

- chacun

- plus facilement

- de manière efficace

- efficace

- économies émergentes.

- permettre

- fin

- endosser

- durable

- ENGINEERING

- Les ingénieurs

- Anglais

- Entreprise

- logiciels d'entreprise

- intégralité

- estimations

- etc

- Pourtant, la

- faire une éventuelle

- Chaque

- exemple

- Excellence

- à l'exclusion

- exécuter

- exécution

- cadres

- existant

- attendu

- cher

- d'experience

- expérimenté

- nous a permis de concevoir

- expliquant

- explication

- exprimé

- externe

- Yeux

- fantastique

- alimentation

- few

- remplir

- finale

- la traduction de documents financiers

- FinTech

- Focus

- Pour

- prévisions

- formulaire

- le format

- anciennement

- en avant

- tourné vers l'avenir

- Fondée

- De

- fund

- fonds

- En outre

- avenir

- écart

- Général

- génératif

- obtenez

- Donner

- donné

- Don

- pour les

- graphiques

- brut

- Croissance

- Croissance

- EN COURS

- arrive

- Vous avez

- he

- ici

- très

- sa

- Horowitz

- Comment

- HTTPS

- majeur

- humain

- lisible par l'homme

- i

- identifier

- la mise en œuvre

- importance

- important

- impressionné

- in

- comprendre

- Y compris

- intégrer

- indépendamment

- indiqué

- individuel

- secteurs

- industrie

- d'information

- D'information

- Infrastructure

- Assurance

- Intégration

- Internet

- développement

- Investir

- sueñortiendo

- un investissement

- conseil en investissement

- Investissements

- Investisseurs

- Emetteur

- IT

- itérations

- SES

- JavaScript

- rejoint

- juste

- ACTIVITES

- langue

- gros

- Nom de famille

- couche

- conduisant

- apprentissage

- Légal

- Liberty

- comme

- Liste

- Vit

- LLM

- click

- machine learning

- Les machines

- LES PLANTES

- a prendre une

- FAIT DU

- Fabrication

- gérer

- gérés

- gestion

- les gérer

- de nombreuses

- Marge

- Marché

- matières premières.

- mathématiquement

- compte

- Mai..

- significative

- veux dire

- Médias

- Se rencontre

- Mémorandum

- Mémoire

- mentionné

- million

- ML

- modèle

- numériques jumeaux (digital twin models)

- mois

- PLUS

- (en fait, presque toutes)

- beaucoup

- plusieurs

- Doit avoir

- Nature

- Besoins

- Nouveauté

- aucune

- Remarquer..

- maintenant

- nombre

- numéros

- obtenu

- of

- de rabais

- code

- offrant

- souvent

- Vieux

- on

- ONE

- uniquement

- OpenAI

- fonctionner

- opérationnel

- Opérations

- opérateur

- Avis

- or

- Autre

- Autres

- nos

- sortie

- plus de

- propre

- payé

- paradigme

- paramètres

- partie

- particulier

- les partenaires

- les pièces

- passé

- performant

- autorisation

- personnel

- objectifs

- en particulier pendant la préparation

- choisi

- Des endroits

- Platon

- Intelligence des données Platon

- PlatonDonnées

- veuillez cliquer

- portefeuille

- possible

- Post

- défaillances

- Méthode

- pragmatique

- prédiction

- président

- Privé

- privilégié

- Probablement

- Problème

- d'ouvrabilité

- Produit

- Vidéo

- Produits

- rentable

- Programmation

- Progrès

- projections

- éventuel

- perspectives

- fournir

- à condition de

- aportando

- publiquement

- des fins

- Python

- Trimestre

- gamme

- RARE

- plutôt

- Lire

- solutions

- réal

- monde réel

- en temps réel

- données en temps réel à grande vitesse.

- Les raisons

- reconnaissance

- Recommandation

- recommandations

- visée

- relativement

- pertinent

- fiable

- rappeler

- représentant

- a besoin

- un article

- Réagir

- résultat

- résultant

- Résultats

- retourner

- de revenus

- examiné

- Round

- Courir

- sagemaker

- même

- portée

- Rechercher

- recherche

- titres

- sur le lien

- vu

- envoyer

- envoi

- sens

- Série

- Série B

- service

- Services

- set

- plusieurs

- décalage

- devrait

- montré

- côté

- significative

- similaires

- simplement

- depuis

- situation

- So

- Logiciels

- développement de logiciels

- sur mesure

- quelques

- quelque chose

- Sources

- parle

- dépensé

- empiler

- Standard

- Commencer

- Région

- déclarations

- étapes

- storage

- Boutique

- stockée

- stockage

- Étudier

- sujet

- abonnement

- succès

- tel

- Support

- Système

- objectifs

- tâches

- impôt

- équipe

- technologie

- entreprises technologiques

- Technique

- Technologie

- que

- qui

- La

- El futuro

- les informations

- leur

- Les

- puis

- Là.

- la bride

- Ces

- l'ont

- penser

- En pensant

- des tiers.

- this

- ceux

- trois

- ravi

- fiable

- à

- les outils

- top

- échangés

- traditionnel

- qualifié

- Formation

- transactionnel

- vraiment

- deux

- sous

- comprendre

- compréhension

- sur

- utilisé

- d'utiliser

- Utilisateur

- Vaste

- Véhicules

- vérifié

- très

- vues

- vision

- était

- Façon..

- we

- WELL

- Quoi

- quand

- qui

- tout en

- WHO

- la totalité

- large

- Large gamme

- sera

- comprenant

- dans les

- sans

- Témoin

- activités principales

- de travail

- écrire

- écriture

- code écrit

- faux

- années

- Vous n'avez

- Votre

- zéphyrnet