Cet article vous présente les défis les plus courants auxquels les clients sont confrontés lors de la recherche de documents internes et vous donne des conseils concrets sur la manière dont les services AWS peuvent être utilisés pour créer un robot conversationnel d'IA génératif qui rend les informations internes plus utiles.

Les données non structurées représentent 80 % de toutes les données trouvés au sein des organisations, constitués de référentiels de manuels, de PDF, de FAQ, d'e-mails et d'autres documents qui s'agrandissent quotidiennement. Les entreprises d’aujourd’hui s’appuient sur des référentiels d’informations internes en constante augmentation, et des problèmes surviennent lorsque la quantité de données non structurées devient ingérable. Souvent, les utilisateurs se retrouvent à lire et à vérifier de nombreuses sources internes différentes pour trouver les réponses dont ils ont besoin.

Les forums de questions et réponses internes peuvent aider les utilisateurs à obtenir des réponses très spécifiques, mais nécessitent également des temps d'attente plus longs. Dans le cas des FAQ internes spécifiques à l'entreprise, les longs temps d'attente entraînent une baisse de la productivité des employés. Les forums de questions et réponses sont difficiles à adapter car ils reposent sur des réponses écrites manuellement. Avec l’IA générative, on assiste actuellement à un changement de paradigme dans la manière dont les utilisateurs recherchent et trouvent des informations. La prochaine étape logique consiste à utiliser l’IA générative pour condenser des documents volumineux en informations plus petites afin de faciliter la consommation des utilisateurs. Au lieu de passer beaucoup de temps à lire un texte ou à attendre des réponses, les utilisateurs peuvent générer des résumés en temps réel basés sur plusieurs référentiels d'informations internes existants.

Vue d'ensemble de la solution

La solution permet aux clients de récupérer des réponses organisées aux questions posées sur les documents internes en utilisant un modèle de transformateur pour générer des réponses aux questions sur les données sur lesquelles il n'a pas été formé, une technique connue sous le nom d'invite zéro-shot. En adoptant cette solution, les clients peuvent bénéficier des avantages suivants :

- Trouver des réponses précises aux questions basées sur les sources existantes de documents internes

- Réduisez le temps que les utilisateurs passent à chercher des réponses en utilisant des modèles linguistiques étendus (LLM) pour fournir des réponses quasi immédiates à des requêtes complexes en utilisant des documents contenant les informations les plus récentes.

- Rechercher des questions déjà répondues via un tableau de bord centralisé

- Réduisez le stress causé par le temps passé à lire manuellement des informations pour chercher des réponses

Génération augmentée de récupération (RAG)

La génération augmentée de récupération (RAG) réduit certaines des lacunes des requêtes basées sur LLM en trouvant les réponses à partir de votre base de connaissances et en utilisant le LLM pour résumer les documents en réponses concises. Lis ça s'il te plait poster apprendre à mettre en œuvre l’approche RAG avec Amazone Kendra. Les risques et limitations suivants sont associés aux requêtes basées sur LLM auxquelles répond une approche RAG avec Amazon Kendra :

- Hallucinations et traçabilité – Les LLMS sont formés sur de grands ensembles de données et génèrent des réponses sur des probabilités. Cela peut conduire à des réponses inexactes, appelées hallucinations.

- Plusieurs silos de données – Afin de référencer des données provenant de plusieurs sources dans votre réponse, il faut mettre en place un écosystème de connecteurs pour agréger les données. L'accès à plusieurs référentiels est manuel et prend du temps.

- Sécurité – La sécurité et la confidentialité sont des considérations essentielles lors du déploiement de robots conversationnels alimentés par RAG et LLM. Malgré l'utilisation Amazon comprendre pour filtrer les données personnelles pouvant être fournies via les requêtes des utilisateurs, il reste une possibilité de faire apparaître involontairement des informations personnelles ou sensibles, en fonction des données ingérées. Cela signifie que contrôler l’accès au chatbot est crucial pour empêcher tout accès involontaire à des informations sensibles.

- Pertinence des données – Les LLMS sont formés sur des données jusqu'à une certaine date, ce qui signifie que les informations ne sont souvent pas à jour. Le coût associé à la formation des modèles sur des données récentes est élevé. Afin de garantir des réponses précises et à jour, les organisations ont la responsabilité de mettre à jour et d'enrichir régulièrement le contenu des documents indexés.

- Coût – Le coût associé au déploiement de cette solution doit être pris en compte par les entreprises. Les entreprises doivent évaluer soigneusement leur budget et leurs exigences de performances lors de la mise en œuvre de cette solution. L’exécution de LLM peut nécessiter des ressources informatiques importantes, ce qui peut augmenter les coûts opérationnels. Ces coûts peuvent devenir une limitation pour les applications devant fonctionner à grande échelle. Cependant, l'un des avantages du AWS Cloud est la flexibilité de ne payer que ce que vous utilisez. AWS propose un modèle de tarification simple et cohérent, de type paiement à l'utilisation, de sorte que vous n'êtes facturé que pour les ressources que vous consommez.

Utilisation d'Amazon SageMaker JumpStart

Pour les modèles de langage basés sur des transformateurs, les organisations peuvent bénéficier de l'utilisation Amazon Sage Maker JumpStart, qui propose une collection de modèles d'apprentissage automatique prédéfinis. Amazon SageMaker JumpStart propose une large gamme de modèles fondamentaux de génération de texte et de questions-réponses (Q&A) qui peuvent être facilement déployés et utilisés. Cette solution intègre un modèle FLAN T5-XL Amazon SageMaker JumpStart, mais il y a différents aspects à garder à l'esprit lorsque choisir un modèle de fondation.

Intégrer la sécurité dans notre flux de travail

Suivant les bonnes pratiques du pilier sécurité du Cadre bien architecturé, Amazon Cognito est utilisé pour l’authentification. Les groupes d'utilisateurs Amazon Cognito peuvent être intégrés à des fournisseurs d'identité tiers qui prennent en charge plusieurs cadres utilisés pour le contrôle d'accès, notamment Open Authorization (OAuth), OpenID Connect (OIDC) ou Security Assertion Markup Language (SAML). L’identification des utilisateurs et de leurs actions permet à la solution de maintenir une traçabilité. La solution utilise également le Détection d'informations personnelles identifiables (PII) par Amazon Comprehend fonctionnalité pour identifier et rédiger automatiquement les informations personnelles. Les informations personnelles expurgées incluent les adresses, les numéros de sécurité sociale, les adresses e-mail et d'autres informations sensibles. Cette conception garantit que toutes les informations personnelles fournies par l'utilisateur via la requête d'entrée sont rédigées. Les informations personnelles ne sont pas stockées, utilisées par Amazon Kendra ou transmises au LLM.

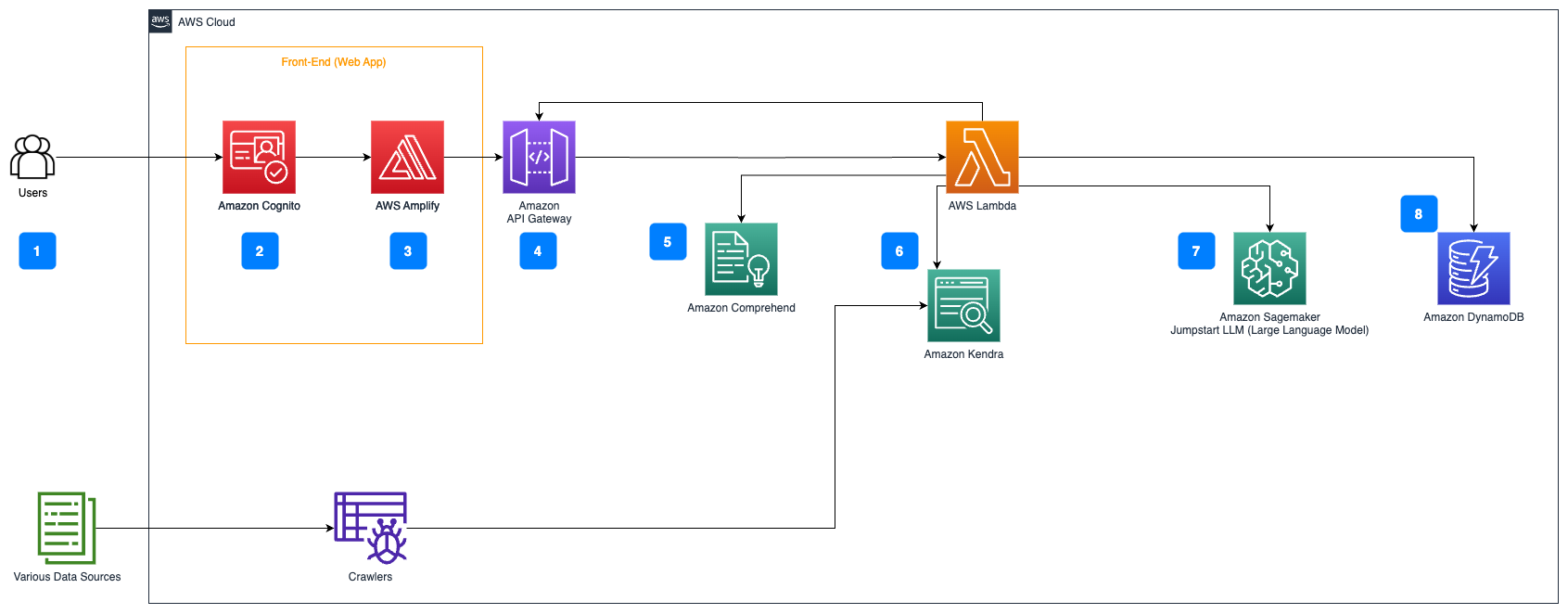

Présentation de la solution

Les étapes suivantes décrivent le flux de travail de réponse aux questions sur le flux de documents :

- Les utilisateurs envoient une requête via une interface Web.

- Amazon Cognito est utilisé pour l’authentification, garantissant un accès sécurisé à l’application Web.

- Le front-end de l’application Web est hébergé sur AWS Amplifier.

- Passerelle d'API Amazon héberge une API REST avec divers points de terminaison pour gérer les demandes des utilisateurs authentifiées à l'aide d'Amazon Cognito.

- Rédaction des informations personnelles avec Amazon comprendre:

- Traitement des requêtes utilisateur : lorsqu'un utilisateur soumet une requête ou une entrée, celle-ci est d'abord transmise via Amazon Comprehend. Le service analyse le texte et identifie toutes les entités PII présentes dans la requête.

- Extraction des PII : Amazon Comprehend extrait les entités PII détectées de la requête de l'utilisateur.

- Récupération d'informations pertinentes avec Amazone Kendra:

- Amazon Kendra est utilisé pour gérer un index de documents contenant les informations utilisées pour générer des réponses aux requêtes de l'utilisateur.

- Le Récupération du contrôle qualité LangChain Le module est utilisé pour créer une chaîne de conversation contenant des informations pertinentes sur les requêtes de l'utilisateur.

- Intégration avec Amazon SageMaker JumpStart:

- La fonction AWS Lambda utilise la bibliothèque LangChain et se connecte au point de terminaison Amazon SageMaker JumpStart avec une requête contextuelle. Le point de terminaison Amazon SageMaker JumpStart sert d'interface du LLM utilisé pour l'inférence.

- Stocker les réponses et les renvoyer à l'utilisateur :

- La réponse du LLM est stockée dans Amazon DynamoDB ainsi que la requête de l'utilisateur, l'horodatage, un identifiant unique et d'autres identifiants arbitraires pour l'élément tels que la catégorie de question. Le stockage de la question et de la réponse sous forme d'éléments discrets permet à la fonction AWS Lambda de recréer facilement l'historique des conversations d'un utilisateur en fonction de l'heure à laquelle les questions ont été posées.

- Enfin, la réponse est renvoyée à l'utilisateur via une requête HTTP via la réponse d'intégration de l'API REST d'Amazon API Gateway.

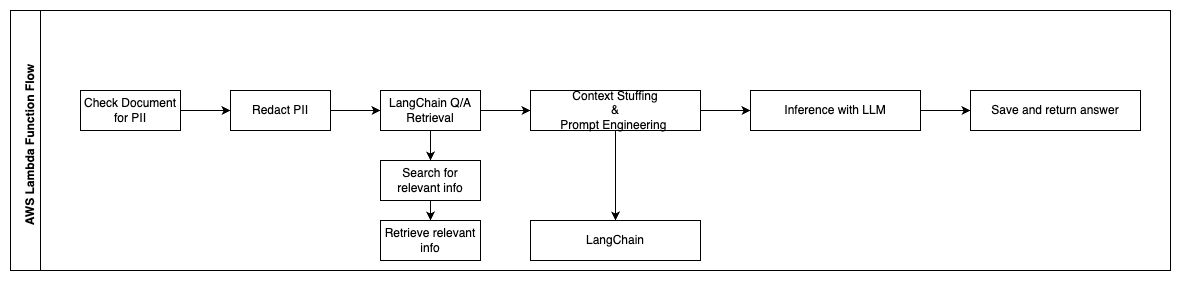

Les étapes suivantes décrivent les fonctions AWS Lambda et leur déroulement tout au long du processus :

- Vérifiez et expurgez toutes les informations personnelles/sensibles

- Chaîne de récupération d'assurance qualité LangChain

- Rechercher et récupérer des informations pertinentes

- Bourrage de contexte et ingénierie d'invite

- Inférence avec LLM

- Renvoyez la réponse et enregistrez-la

Les cas d'utilisation

Il existe de nombreux cas d'utilisation professionnelle dans lesquels les clients peuvent utiliser ce flux de travail. La section suivante explique comment le flux de travail peut être utilisé dans différents secteurs et secteurs verticaux.

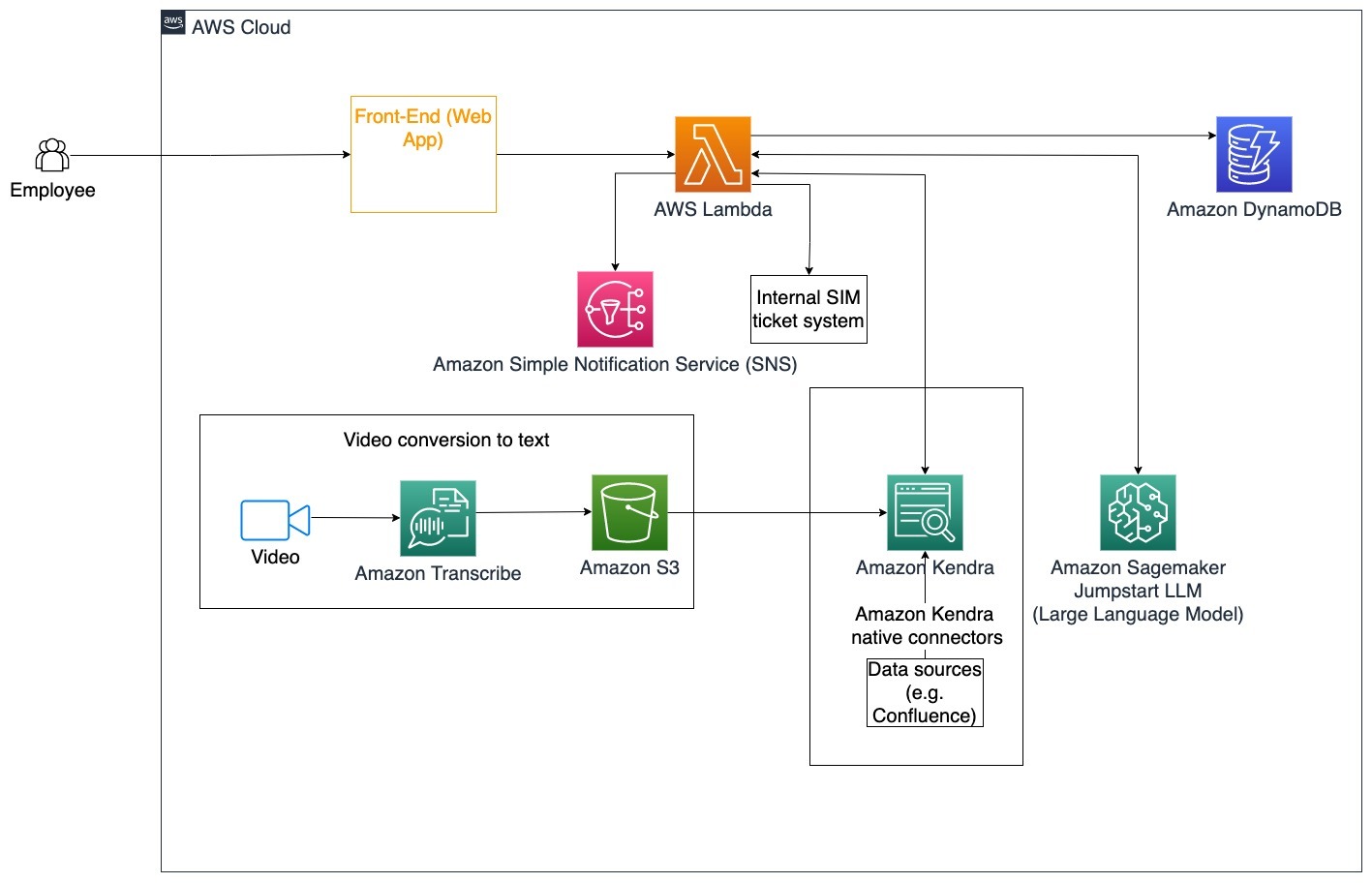

Assistance aux employés

Une formation en entreprise bien conçue peut améliorer la satisfaction des employés et réduire le temps nécessaire à l’intégration des nouveaux employés. À mesure que les organisations se développent et que leur complexité augmente, les employés ont du mal à comprendre les nombreuses sources de documents internes. Les documents internes dans ce contexte comprennent les directives, les politiques et les procédures opérationnelles standard de l'entreprise. Pour ce scénario, un employé se demande comment procéder et modifier un ticket de ticket de problème interne. L'employé peut accéder et utiliser le robot conversationnel d'intelligence artificielle (IA) générative pour demander et exécuter les étapes suivantes pour un ticket spécifique.

Cas d'utilisation spécifique : Automatisez la résolution des problèmes pour les employés en fonction des directives de l'entreprise.

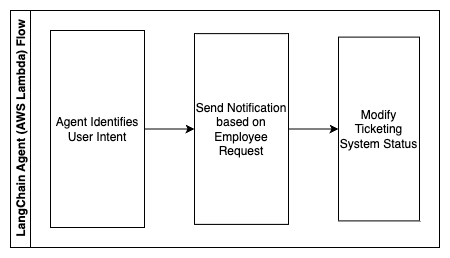

Les étapes suivantes décrivent les fonctions AWS Lambda et leur déroulement tout au long du processus :

- Agent LangChain pour identifier l'intention

- Envoyer une notification en fonction de la demande de l'employé

- Modifier le statut du ticket

Dans ce diagramme d'architecture, les vidéos de formation d'entreprise peuvent être ingérées via Amazon Transcribe pour collecter un journal de ces scripts vidéo. De plus, le contenu de formation d'entreprise stocké dans diverses sources (c'est-à-dire Confluence, Microsoft SharePoint, Google Drive, Jira, etc.) peut être utilisé pour créer des index via les connecteurs Amazon Kendra. Lisez cet article pour en savoir plus sur la collection d'autochtones connecteurs vous pouvez utiliser dans Amazon Kendra comme point source. Le robot d'exploration Amazon Kendra est alors capable d'utiliser à la fois les scripts vidéo de formation d'entreprise et la documentation stockée dans ces autres sources pour aider le robot conversationnel à répondre aux questions spécifiques aux directives de formation d'entreprise de l'entreprise. L'agent LangChain vérifie les autorisations, modifie le statut du ticket et informe les bonnes personnes à l'aide d'Amazon Simple Notification Service (Amazon SNS).

Équipes de support client

La résolution rapide des requêtes des clients améliore l’expérience client et encourage la fidélité à la marque. Une clientèle fidèle contribue à stimuler les ventes, ce qui contribue aux résultats financiers et augmente l'engagement des clients. Les équipes de support client consacrent beaucoup d’énergie à référencer de nombreux documents internes et logiciels de gestion de la relation client pour répondre aux questions des clients sur les produits et services. Les documents internes dans ce contexte peuvent inclure des scripts d'appel de support client génériques, des playbooks, des directives de remontée d'informations et des informations commerciales. Le robot conversationnel génératif d’IA contribue à l’optimisation des coûts car il gère les requêtes au nom de l’équipe de support client.

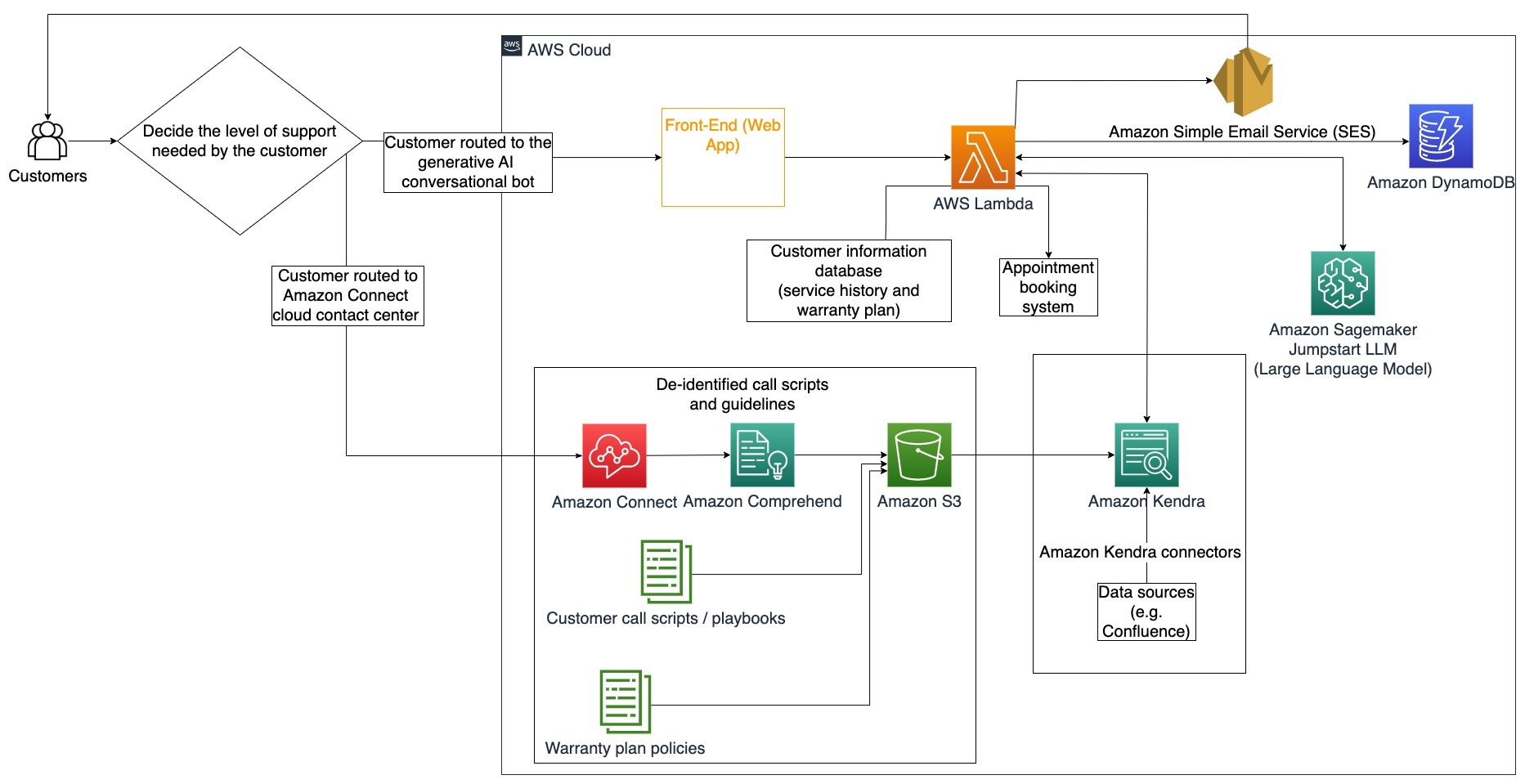

Cas d'utilisation spécifique : Gérer une demande de vidange d'huile en fonction de l'historique d'entretien et du plan de service client acheté.

Dans ce diagramme d'architecture, le client est dirigé soit vers le robot conversationnel génératif d'IA, soit vers le Connexion Amazon centre d'appels. Cette décision peut être basée sur le niveau de support nécessaire ou la disponibilité des agents de support client. L'agent LangChain identifie l'intention du client et vérifie son identité. L'agent LangChain vérifie également l'historique du service et le plan de support acheté.

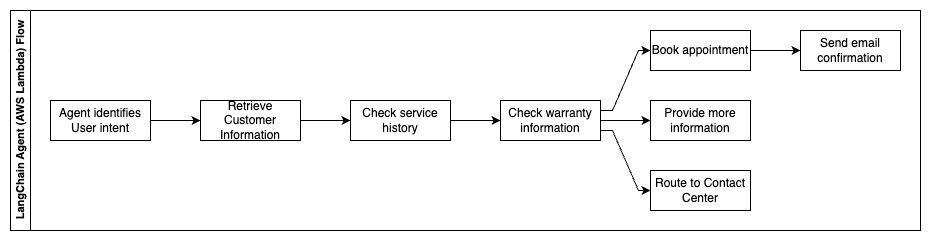

Les étapes suivantes décrivent les fonctions AWS Lambda et leur déroulement tout au long du processus :

- L'agent LangChain identifie l'intention

- Récupérer les informations client

- Vérifier l'historique du service client et les informations de garantie

- Prendre rendez-vous, fournir plus d'informations ou vous rendre au centre de contact

- Envoyer un e-mail de confirmation

Amazon Connect est utilisé pour collecter les journaux de voix et de discussion, et Amazon Comprehend est utilisé pour supprimer les informations personnelles identifiables (PII) de ces journaux. Le robot d'exploration Amazon Kendra est ensuite capable d'utiliser les journaux de voix et de discussion rédigés, les scripts d'appel des clients et les politiques du plan de support du service client pour créer l'index. Une fois la décision prise, le robot conversationnel génératif à IA décide s'il doit prendre rendez-vous, fournir plus d'informations ou diriger le client vers le centre de contact pour obtenir une assistance supplémentaire. Pour optimiser les coûts, l'agent LangChain peut également générer des réponses en utilisant moins de jetons et un grand modèle de langage moins coûteux pour les requêtes clients de moindre priorité.

Services financiers

Les sociétés de services financiers s’appuient sur une utilisation opportune des informations pour rester compétitives et se conformer aux réglementations financières. Grâce à un robot conversationnel à IA générative, les analystes financiers et les conseillers peuvent interagir avec des informations textuelles de manière conversationnelle et réduire le temps et les efforts nécessaires pour prendre des décisions plus éclairées. En dehors des investissements et des études de marché, un robot conversationnel à IA générative peut également augmenter les capacités humaines en gérant des tâches qui nécessiteraient traditionnellement plus d’efforts et de temps humains. Par exemple, une institution financière spécialisée dans les prêts personnels peut augmenter la rapidité de traitement des prêts tout en offrant une meilleure transparence aux clients.

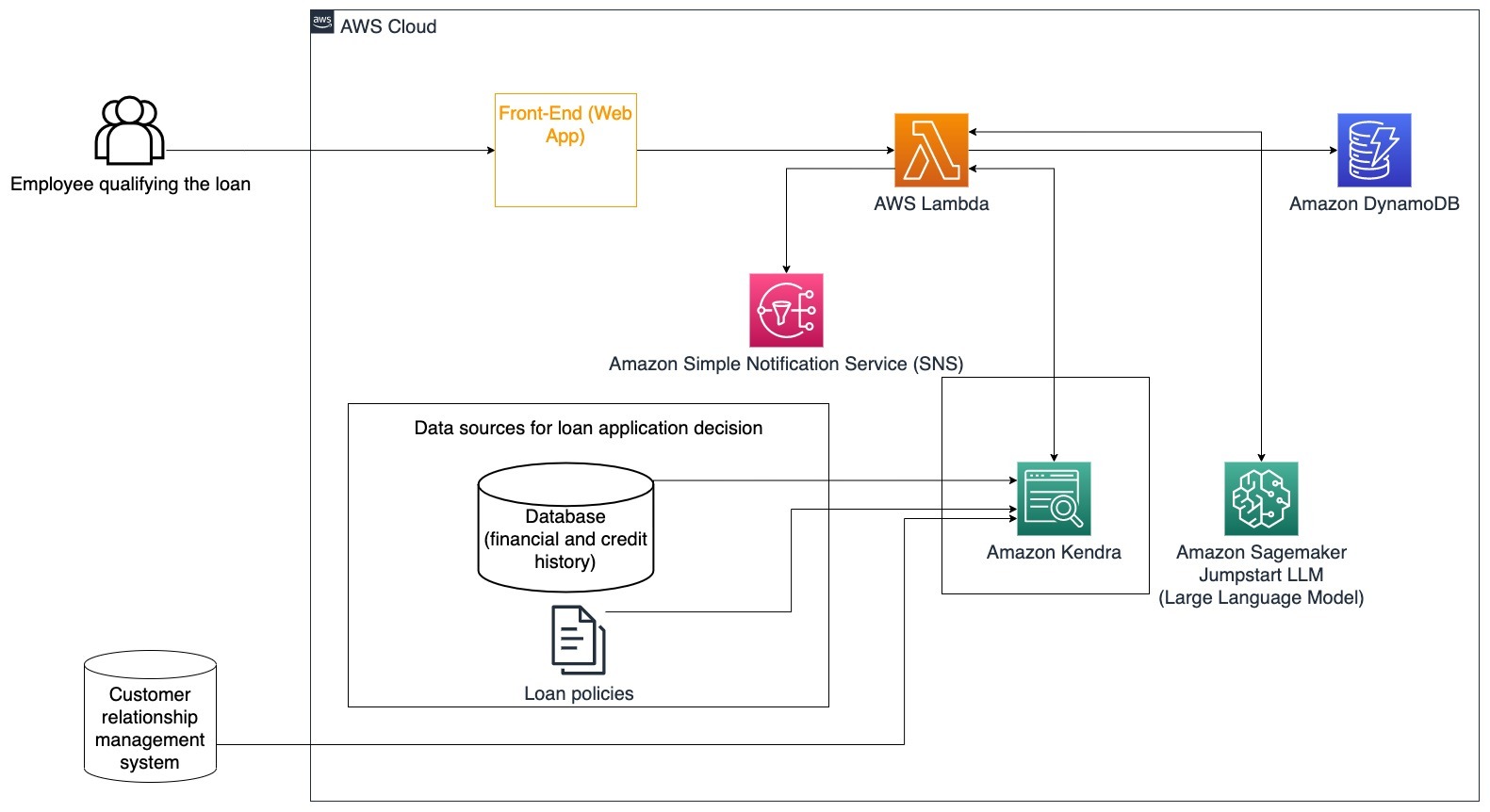

Cas d'utilisation spécifique : Utilisez l’historique financier des clients et les demandes de prêt antérieures pour décider et expliquer la décision de prêt.

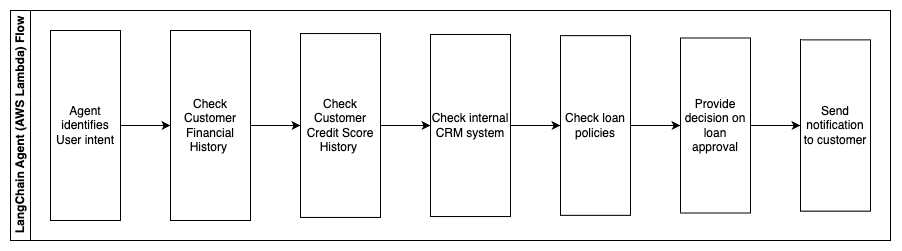

Les étapes suivantes décrivent les fonctions AWS Lambda et leur déroulement tout au long du processus :

- Agent LangChain pour identifier l'intention

- Vérifier l'historique financier et de crédit des clients

- Vérifier le système interne de gestion de la relation client

- Vérifiez les politiques de prêt standard et suggérez une décision aux employés admissibles au prêt.

- Envoyer une notification au client

Cette architecture intègre les données financières des clients stockées dans une base de données et les données stockées dans un outil de gestion de la relation client (CRM). Ces points de données sont utilisés pour éclairer une décision basée sur les politiques de prêt internes de l'entreprise. Le client est en mesure de poser des questions de clarification pour comprendre à quels prêts il est admissible et les conditions des prêts qu'il peut accepter. Si le robot conversationnel génératif d’IA n’est pas en mesure d’approuver une demande de prêt, l’utilisateur peut toujours poser des questions sur l’amélioration des cotes de crédit ou sur des options de financement alternatives.

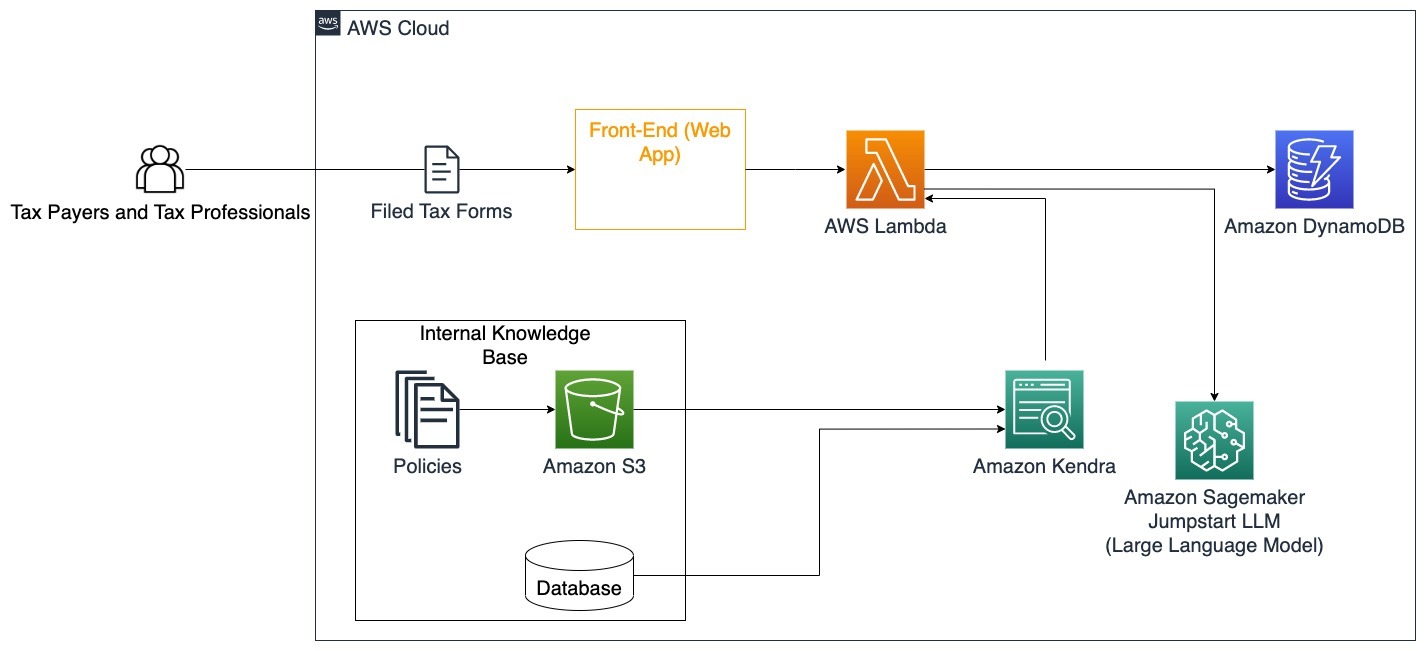

Gouvernement

Les robots conversationnels d’IA générative peuvent grandement bénéficier aux institutions gouvernementales en accélérant les processus de communication, d’efficacité et de prise de décision. Les robots conversationnels d'IA générative peuvent également fournir un accès instantané aux bases de connaissances internes pour aider les employés du gouvernement à récupérer rapidement des informations, des politiques et des procédures (c'est-à-dire les critères d'éligibilité, les processus de candidature, ainsi que les services et l'assistance aux citoyens). Une solution est un système interactif, qui permet aux contribuables et aux professionnels de la fiscalité de trouver facilement des détails et des avantages fiscaux. Il peut être utilisé pour comprendre les questions des utilisateurs, résumer les documents fiscaux et fournir des réponses claires via des conversations interactives.

Les utilisateurs peuvent poser des questions telles que :

- Comment fonctionnent les droits de succession et quels sont les seuils fiscaux ?

- Pouvez-vous expliquer la notion d’impôt sur le revenu ?

- Quelles sont les implications fiscales lors de la vente d’un deuxième bien immobilier ?

De plus, les utilisateurs peuvent avoir la possibilité de soumettre des formulaires fiscaux à un système, ce qui peut aider à vérifier l'exactitude des informations fournies.

Cette architecture illustre comment les utilisateurs peuvent télécharger des formulaires fiscaux remplis vers la solution et les utiliser pour une vérification interactive et des conseils sur la façon de remplir avec précision les informations nécessaires.

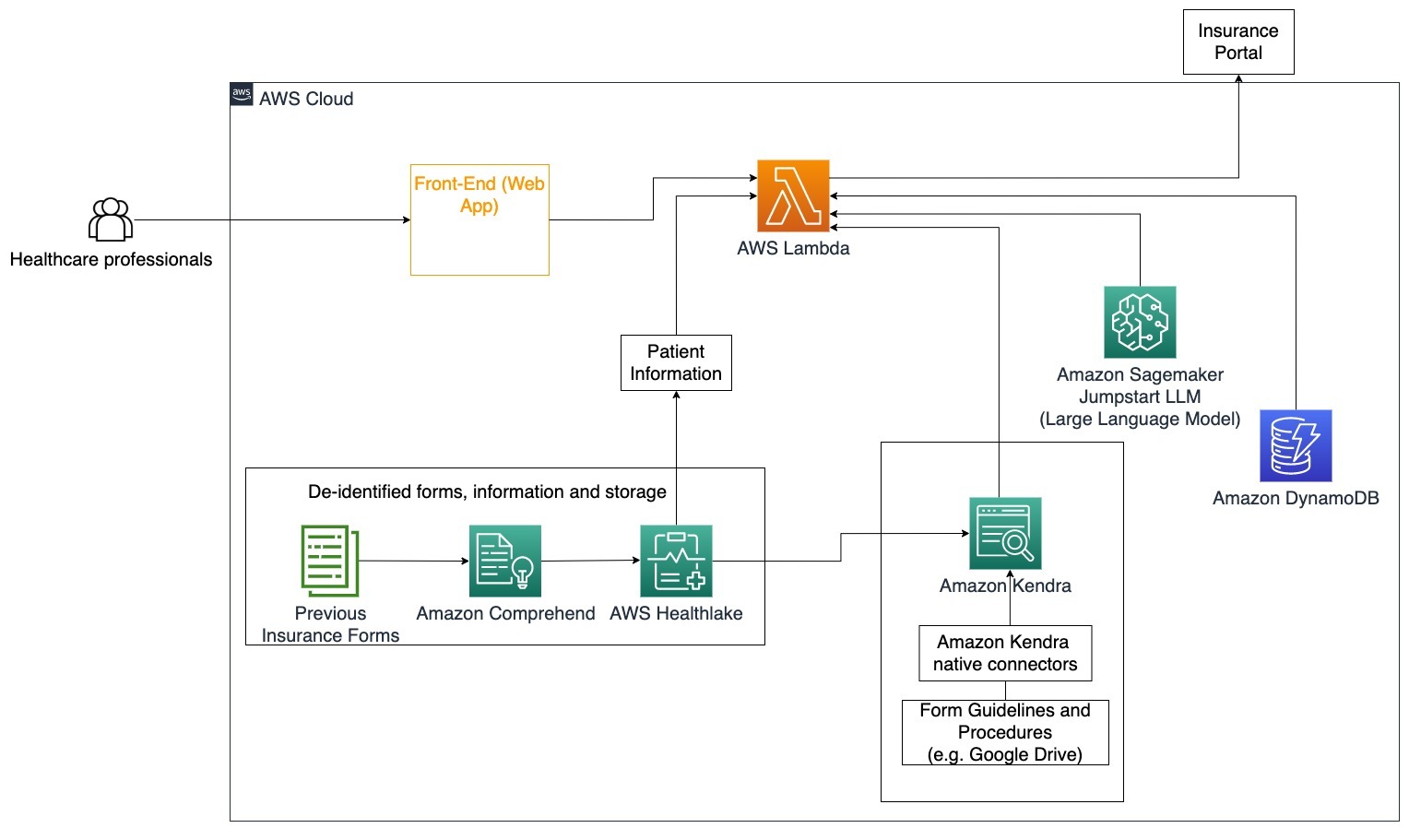

Système de santé

Les entreprises de soins de santé ont la possibilité d'automatiser l'utilisation de grandes quantités d'informations internes sur les patients, tout en répondant aux questions courantes concernant les cas d'utilisation, telles que les options de traitement, les réclamations d'assurance, les essais cliniques et la recherche pharmaceutique. L’utilisation d’un robot conversationnel à IA générative permet de générer rapidement et précisément des réponses sur les informations de santé à partir de la base de connaissances fournie. Par exemple, certains professionnels de la santé passent beaucoup de temps à remplir des formulaires pour déposer des réclamations d’assurance.

Dans des contextes similaires, les administrateurs d’essais cliniques et les chercheurs doivent trouver des informations sur les options de traitement. Un robot conversationnel à IA générative peut utiliser les connecteurs prédéfinis d'Amazon Kendra pour récupérer les informations les plus pertinentes parmi les millions de documents publiés dans le cadre de recherches en cours menées par des sociétés pharmaceutiques et des universités.

Cas d'utilisation spécifique : Réduisez les erreurs et le temps nécessaire pour remplir et envoyer les formulaires d’assurance.

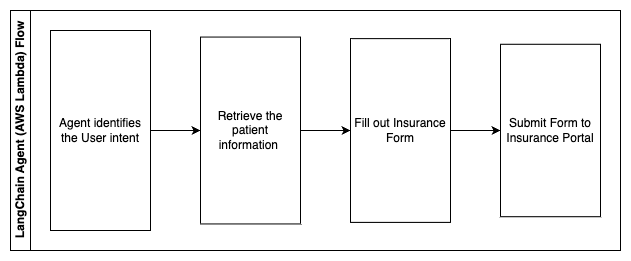

Dans ce diagramme d'architecture, un professionnel de la santé peut utiliser le robot conversationnel génératif d'IA pour déterminer quels formulaires doivent être remplis pour l'assurance. L'agent LangChain est alors capable de récupérer les bons formulaires et d'ajouter les informations nécessaires à un patient, ainsi que de donner des réponses aux parties descriptives des formulaires en fonction des polices d'assurance et des formulaires précédents. Le professionnel de santé peut éditer les réponses données par le LLM avant de valider et de faire transmettre le formulaire sur le portail de l'assurance.

Les étapes suivantes décrivent les fonctions AWS Lambda et leur déroulement tout au long du processus :

- Agent LangChain pour identifier l'intention

- Récupérer les informations patient nécessaires

- Remplissez le formulaire d'assurance en fonction des informations du patient et des directives du formulaire.

- Soumettre le formulaire au portail d'assurance après approbation de l'utilisateur

AWS HealthLake est utilisé pour stocker en toute sécurité les données de santé, y compris les formulaires d'assurance précédents et les informations sur les patients, et Amazon Comprehend est utilisé pour supprimer les informations personnelles identifiables (PII) des formulaires d'assurance précédents. Le robot d'exploration Amazon Kendra est ensuite en mesure d'utiliser l'ensemble des formulaires et des directives d'assurance pour créer l'index. Une fois le(s) formulaire(s) rempli(s) par l'IA générative, le(s) formulaire(s) examiné(s) par le professionnel de la santé peuvent être envoyés au portail d'assurance.

Prix estimé

Le coût de déploiement de la solution de base comme preuve de concept est indiqué dans le tableau suivant. Étant donné que la solution de base est considérée comme une preuve de concept, Amazon Kendra Developer Edition a été utilisée comme option peu coûteuse puisque la charge de travail ne serait pas en production. Notre hypothèse pour Amazon Kendra Developer Edition était de 730 heures actives pour le mois.

Pour Amazon SageMaker, nous avons supposé que le client utiliserait l'instance ml.g4dn.2xlarge pour l'inférence en temps réel, avec un seul point de terminaison d'inférence par instance. Vous pouvez trouver plus d'informations sur les tarifs d'Amazon SageMaker et les types d'instances d'inférence disponibles. ici.

| Service | Ressources consommées | Estimation du coût par mois en USD |

| AWS Amplifier | 150 minutes de construction 1 Go de données servies Demandes 500,000 |

15.71 |

| Passerelle d'API Amazon | 1 million d'appels API REST | 3.5 |

| AWS Lambda | 1 million de demandes Durée de 5 secondes par demande 2 Go de mémoire allouée |

160.23 |

| Amazon DynamoDB | 1 millions de lectures 1 million d'écritures Stockage: 100 GB |

26.38 |

| Amazon Sage Maker | Inférence en temps réel avec ml.g4dn.2xlarge | 676.8 |

| Amazone Kendra | Developer Edition avec 730 heures/mois 10,000 XNUMX documents numérisés 5,000 XNUMX requêtes/jour |

821.25 |

| . | . | Coût total : 1703.87 |

* Amazon Cognito propose un niveau gratuit de 50,000 50 utilisateurs actifs mensuels qui utilisent les groupes d'utilisateurs Cognito ou de 2.0 utilisateurs actifs mensuels qui utilisent des fournisseurs d'identité SAML XNUMX.

Clean Up

Pour réduire les coûts, supprimez toutes les ressources que vous avez déployées dans le cadre du didacticiel. Vous pouvez supprimer tous les points de terminaison SageMaker que vous avez créés via la console SageMaker. N'oubliez pas que la suppression d'un index Amazon Kendra ne supprime pas les documents originaux de votre stockage.

Conclusion

Dans cet article, nous vous avons montré comment simplifier l'accès aux informations internes en résumant à partir de plusieurs référentiels en temps réel. Après le développement récent des LLM disponibles dans le commerce, les possibilités de l’IA générative sont devenues plus évidentes. Dans cet article, nous avons présenté des façons d'utiliser les services AWS pour créer un chatbot sans serveur qui utilise l'IA générative pour répondre aux questions. Cette approche intègre une couche d'authentification et la détection des informations personnelles d'Amazon Comprehend pour filtrer toutes les informations sensibles fournies dans la requête de l'utilisateur. Qu'il s'agisse de professionnels de la santé qui comprennent les nuances du dépôt de réclamations d'assurance ou de RH qui comprennent les réglementations spécifiques à l'échelle de l'entreprise, de nombreux secteurs et secteurs verticaux peuvent bénéficier de cette approche. Un modèle de base Amazon SageMaker JumpStart est le moteur derrière le chatbot, tandis qu'une approche de bourrage de contexte utilisant la technique RAG est utilisée pour garantir que les réponses font référence plus précisément aux documents internes.

Pour en savoir plus sur l'utilisation de l'IA générative sur AWS, reportez-vous à Annonce de nouveaux outils pour créer avec l'IA générative sur AWS. Pour des conseils plus détaillés sur l'utilisation de la technique RAG avec les services AWS, reportez-vous à Créez rapidement des applications d'IA générative de haute précision sur les données d'entreprise à l'aide d'Amazon Kendra, LangChain et de grands modèles de langage. Étant donné que l'approche de ce blog est indépendante du LLM, n'importe quel LLM peut être utilisé à des fins d'inférence. Dans notre prochain article, nous présenterons les moyens de mettre en œuvre cette solution à l'aide d'Amazon Bedrock et d'Amazon Titan LLM.

À propos des auteurs

Abhishek Maligehalli Shivalingaiah est architecte principal de solutions de services d'IA chez AWS. Il est passionné par la création d'applications utilisant Generative AI, Amazon Kendra et NLP. Il possède environ 10 ans d'expérience dans la création de solutions de données et d'IA pour créer de la valeur pour les clients et les entreprises. Il a même construit un chatbot (personnel) pour s'amuser pour répondre aux questions sur sa carrière et son parcours professionnel. En dehors du travail, il aime réaliser des portraits de sa famille et de ses amis, ainsi que créer des œuvres d'art.

Abhishek Maligehalli Shivalingaiah est architecte principal de solutions de services d'IA chez AWS. Il est passionné par la création d'applications utilisant Generative AI, Amazon Kendra et NLP. Il possède environ 10 ans d'expérience dans la création de solutions de données et d'IA pour créer de la valeur pour les clients et les entreprises. Il a même construit un chatbot (personnel) pour s'amuser pour répondre aux questions sur sa carrière et son parcours professionnel. En dehors du travail, il aime réaliser des portraits de sa famille et de ses amis, ainsi que créer des œuvres d'art.

Medha Aiyah est un architecte de solutions associé chez AWS, basé à Austin, au Texas. Elle a récemment obtenu en décembre 2022 une maîtrise ès sciences en informatique avec une spécialisation en systèmes intelligents axés sur l'IA/ML. Elle souhaite en savoir plus sur l'IA/ML et sur l'utilisation des services AWS pour découvrir les solutions dont les clients peuvent bénéficier.

Medha Aiyah est un architecte de solutions associé chez AWS, basé à Austin, au Texas. Elle a récemment obtenu en décembre 2022 une maîtrise ès sciences en informatique avec une spécialisation en systèmes intelligents axés sur l'IA/ML. Elle souhaite en savoir plus sur l'IA/ML et sur l'utilisation des services AWS pour découvrir les solutions dont les clients peuvent bénéficier.

Hugo Tsé est un architecte de solutions associé chez AWS basé à Seattle, Washington. Il est titulaire d'une maîtrise en technologies de l'information de l'Arizona State University et d'un baccalauréat en économie de l'Université de Chicago. Il est membre de l’Information Systems Audit and Control Association (ISACA) et de l’International Information System Security Certification Consortium (ISC)2. Il aime aider les clients à bénéficier de la technologie.

Hugo Tsé est un architecte de solutions associé chez AWS basé à Seattle, Washington. Il est titulaire d'une maîtrise en technologies de l'information de l'Arizona State University et d'un baccalauréat en économie de l'Université de Chicago. Il est membre de l’Information Systems Audit and Control Association (ISACA) et de l’International Information System Security Certification Consortium (ISC)2. Il aime aider les clients à bénéficier de la technologie.

Ayman Ishimwe est un architecte de solutions associé chez AWS basé à Seattle, Washington. Il est titulaire d'une maîtrise en génie logiciel et informatique de l'Université d'Oakland. Il possède une expérience préalable dans le développement de logiciels, en particulier dans la création de microservices pour les applications Web distribuées. Il se passionne pour aider les clients à créer des solutions robustes et évolutives sur les services cloud AWS en suivant les meilleures pratiques.

Ayman Ishimwe est un architecte de solutions associé chez AWS basé à Seattle, Washington. Il est titulaire d'une maîtrise en génie logiciel et informatique de l'Université d'Oakland. Il possède une expérience préalable dans le développement de logiciels, en particulier dans la création de microservices pour les applications Web distribuées. Il se passionne pour aider les clients à créer des solutions robustes et évolutives sur les services cloud AWS en suivant les meilleures pratiques.

Shervin Suresh est un architecte de solutions associé chez AWS basé à Austin, au Texas. Il est titulaire d'une maîtrise en génie logiciel avec une concentration en cloud computing et virtualisation et d'un baccalauréat en génie informatique de l'Université d'État de San Jose. Il est passionné par l’utilisation de la technologie pour contribuer à améliorer la vie des personnes de tous horizons.

Shervin Suresh est un architecte de solutions associé chez AWS basé à Austin, au Texas. Il est titulaire d'une maîtrise en génie logiciel avec une concentration en cloud computing et virtualisation et d'un baccalauréat en génie informatique de l'Université d'État de San Jose. Il est passionné par l’utilisation de la technologie pour contribuer à améliorer la vie des personnes de tous horizons.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Automobile / VE, Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- GraphiquePrime. Élevez votre jeu de trading avec ChartPrime. Accéder ici.

- Décalages de bloc. Modernisation de la propriété des compensations environnementales. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :possède

- :est

- :ne pas

- :où

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Capable

- A Propos

- Accepter

- accès

- accès

- hybrides

- Avec cette connaissance vient le pouvoir de prendre

- avec précision

- actes

- infection

- ajouter

- En outre

- adresses

- adresser

- administrateurs

- L'adoption d'

- conseillers

- Après

- Agent

- agents

- agrégat

- AI

- Services d'IA

- AI / ML

- Tous

- permet

- le long de

- aussi

- alternative

- Amazon

- Passerelle d'API Amazon

- Amazon Cognito

- Amazon comprendre

- Amazone Kendra

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- montant

- quantités

- an

- Analystes

- des analyses

- et les

- répondre

- réponses

- tous

- api

- apparent

- Application

- applications

- rendez-vous

- une approche

- approuver

- architecture

- SONT

- survenir

- Arizona

- autour

- article

- artificiel

- intelligence artificielle

- Intelligence artificielle (AI)

- oeuvres d'art

- AS

- demander

- aspects

- Evaluer

- aider

- Assistance

- Associé(e)

- associé

- Association

- hypothèse

- At

- audit

- augmentée

- austin

- authentifié

- Authentification

- autorisation

- automatiser

- automatiquement

- disponibilité

- disponibles

- AWS

- AWS Lambda

- RETOUR

- milieux

- base

- basé

- BE

- Gardez

- car

- devenez

- devient

- était

- before

- nom

- derrière

- profiter

- avantages.

- LES MEILLEURS

- les meilleures pratiques

- Améliorée

- Blog

- livre

- Bot

- tous les deux

- les robots

- Bas et Leggings

- brand

- budget

- construire

- Développement

- construit

- la performance des entreprises

- entreprises

- mais

- by

- Appelez-nous

- CAN

- capacités

- Carrière

- prudemment

- maisons

- cas

- Catégories

- causé

- Canaux centraux

- centralisée

- certaines

- Certifications

- chaîne

- globaux

- Change

- accusé

- Chatbot

- vérification

- Contrôles

- Chicago

- prétentions

- clair

- Infos sur les

- essais cliniques

- le cloud

- le cloud computing

- services de cloud computing

- recueillir

- collection

- commercialement

- Commun

- Communication

- Sociétés

- Société

- De l'entreprise

- compétitif

- Complété

- compléter

- complexe

- complexité

- se conformer

- comprendre

- ordinateur

- Ingénierie informatique

- Informatique

- informatique

- concentration

- concept

- concis

- menée

- confluence

- NOUS CONTACTER

- connecte

- considération

- considérations

- considéré

- cohérent

- Qui consiste

- Console

- consortium

- consommer

- consommation

- contact

- centre de contact

- contient

- contenu

- contexte

- continuellement

- contribue

- des bactéries

- contrôle

- commodité

- Conversation

- de la conversation

- conversations

- Entreprises

- correct

- Prix

- Costs

- chenilles

- engendrent

- Créer de la valeur

- créée

- La création

- crédit

- critères

- critique

- CRM

- crucial

- organisée

- Courant

- Lecture

- des clients

- L'engagement des clients

- expérience client

- Service à la clientèle

- Support à la clientèle

- Clients

- Tous les jours

- Dallas

- données

- points de données

- ensembles de données

- Base de données

- Date

- Décembre

- décider

- décision

- La prise de décision

- décisions

- Degré

- livré

- Selon

- déployé

- déployer

- décrire

- Conception

- Malgré

- détails

- détecté

- Détection

- Développeur

- Développement

- développements

- différent

- difficile

- découvrez

- distribué

- Documentation

- INSTITUTIONNELS

- Ne fait pas

- motivation

- durée

- e

- plus facilement

- même

- Économie

- risque numérique

- édition

- efficace

- effort

- non plus

- admissibilité

- emails

- Employés

- employés

- permet

- encourage

- Endpoint

- énergie

- participation

- Moteur

- ENGINEERING

- enrichissant

- assurer

- Assure

- assurer

- Entreprise

- entreprises

- entités

- Erreurs

- escalade

- estimation

- etc

- Pourtant, la

- exemple

- exécuter

- existant

- cher

- d'experience

- Expliquer

- Explique

- extraction

- Extraits

- Visage

- famille

- Fonctionnalité

- Fed

- moins

- Figure

- Déposez votre dernière attestation

- remplir

- rempli

- remplissage

- une fonction filtre

- la traduction de documents financiers

- données financières

- histoire financière

- institution financière

- financement

- Trouvez

- trouver

- Prénom

- Flexibilité

- flux

- mettant l'accent

- Abonnement

- Pour

- formulaire

- document

- forums

- trouvé

- Fondation

- cadres

- gratuitement ici

- amis

- De

- amusement

- fonction

- fonctions

- plus

- Gain

- porte

- générer

- génération

- génératif

- IA générative

- obtenez

- donné

- donne

- Don

- Gouvernement

- considérablement

- Croître

- Croissance

- Pousse

- l'orientation

- lignes directrices

- manipuler

- Poignées

- Maniabilité

- Vous avez

- ayant

- he

- Santé

- information sur la santé

- la médecine

- vous aider

- aider

- aide

- ici

- Haute

- très

- sa

- Histoire

- détient

- organisé

- hôtes

- HEURES

- Comment

- How To

- Cependant

- hr

- HTML

- HTTPS

- humain

- i

- identifiant

- Identificateurs

- identifie

- identifier

- identifier

- Identite

- if

- illustre

- Mettre en oeuvre

- la mise en œuvre

- implications

- améliorer

- améliore

- l'amélioration de

- in

- en profondeur

- inexacte

- comprendre

- inclut

- Y compris

- passif

- impôt sur le revenu

- Améliore

- Augmente

- indice

- indexé

- index

- individus

- secteurs

- informer

- d'information

- Systèmes D'Information

- technologie de l'information

- Actualités

- héritage

- contribution

- instance

- instantané

- plutôt ;

- Institution

- les établissements privés

- Assurance

- des services

- Intègre

- l'intégration

- Intelligence

- Intelligent

- intention

- interagir

- Interactif

- intéressé

- Interfaces

- interne

- International

- développement

- un investissement

- aide

- IT

- articles

- chemin

- jpg

- XNUMX éléments à

- spécialisées

- connu

- langue

- gros

- couche

- conduire

- APPRENTISSAGE

- apprentissage

- moins

- Niveau

- en tirant parti

- Bibliothèque

- limitation

- limites

- Gamme

- Vit

- LLM

- prêt

- Prêts

- enregistrer

- logique

- Location

- Longtemps

- plus long

- Style

- Lot

- aime

- low cost

- baisser

- fidèle

- Fidélité

- click

- machine learning

- LES PLANTES

- maintenir

- a prendre une

- FAIT DU

- Fabrication

- gérer

- gestion

- manière

- Manuel

- manuellement

- de nombreuses

- Marché

- Étude de marché

- maîtrise

- Mai..

- veux dire

- médical

- membre

- Mémoire

- microservices

- Microsoft

- million

- des millions

- l'esprit

- ML

- modèle

- numériques jumeaux (digital twin models)

- Module

- Mois

- mensuel

- PLUS

- (en fait, presque toutes)

- plusieurs

- indigène

- nécessaire

- Besoin

- nécessaire

- Besoins

- Nouveauté

- next

- nlp

- déclaration

- numéros

- Oakland

- oauth

- of

- Offres Speciales

- souvent

- Huile

- on

- Onboarding

- une fois

- ONE

- en cours

- uniquement

- ouvert

- fonctionner

- d'exploitation

- opérationnel

- Opportunités

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- Option

- Options

- or

- de commander

- organisations

- original

- Autre

- nos

- ande

- contour

- au contrôle

- plus de

- paradigme

- partie

- les pièces

- passé

- passionné

- patientforward

- Payer

- Personnes

- /

- performant

- autorisations

- personnel

- données à caractère personnel

- Personnellement

- Pharmaceutique

- Pilier

- plan

- Platon

- Intelligence des données Platon

- PlatonDonnées

- veuillez cliquer

- Point

- des notes bonus

- politiques

- Piscines

- Portail

- portraits

- possibilités

- possibilité

- Post

- alimenté

- pratiques

- représentent

- empêcher

- précédent

- précédemment

- établissement des prix

- Modèle de prix

- Avant

- priorité

- la confidentialité

- d'ouvrabilité

- procédures

- procéder

- processus

- Traité

- les process

- traitement

- Vidéo

- productivité

- Produits

- professionels

- ,une équipe de professionnels qualifiés

- propriété

- fournir

- à condition de

- fournisseurs

- aportando

- publié

- acheté

- Questions et réponses

- qualifier

- qualificatif

- requêtes

- question

- fréquemment posées

- Rapide

- vite.

- gamme

- Tarif

- Lire

- en cours

- en temps réel

- récent

- récemment

- réduire

- réduit

- reportez-vous

- référencement

- en ce qui concerne

- régulièrement

- règlements

- relation amoureuse

- pertinence

- pertinent

- compter

- reste

- rappeler

- supprimez

- nécessaire

- demandes

- exigent

- conditions

- Exigences

- un article

- chercheurs

- Résolution

- résoudre

- Resources

- réponse

- réponses

- responsabilité

- REST

- résultat

- retour

- examiné

- bon

- risques

- robuste

- Itinéraire

- pour le running

- s

- sagemaker

- vente

- San

- San José

- client

- Épargnez

- évolutive

- Escaliers intérieurs

- scénario

- Sciences

- But

- scripts

- Rechercher

- recherche

- Seattle

- Deuxièmement

- secondes

- Section

- sécurisé

- en toute sécurité

- sécurité

- Disponible

- envoyer

- supérieur

- sensible

- envoyé

- Sans serveur

- sert

- service

- Services

- set

- Sets

- Paramétres

- plusieurs

- elle

- décalage

- lacunes

- devrait

- présenté

- montré

- montré

- silos

- similaires

- étapes

- simplifier

- depuis

- unique

- taille

- faibles

- So

- Réseaux sociaux

- Logiciels

- développement de logiciels

- génie logiciel

- sur mesure

- Solutions

- quelques

- Identifier

- Sources

- spécialisation

- groupe de neurones

- spécifiquement

- passer

- Dépenses

- Standard

- Région

- Statut

- rester

- étapes

- Étapes

- Encore

- storage

- Boutique

- stockée

- stockage

- stress

- rembourrage

- Ces

- tel

- suggérer

- résumé

- Support

- combustion propre

- Système

- table

- prend

- tâches

- impôt

- équipe

- équipes

- Technologie

- conditions

- Texas

- texte

- textuel

- qui

- Le

- les informations

- leur

- se

- puis

- Là.

- Ces

- l'ont

- des tiers.

- this

- Avec

- billet

- ticketing

- étage

- fiable

- long

- opportun

- fois

- horodatage

- Titan

- à

- aujourd'hui

- Tokens

- outil

- les outils

- Traçabilité

- traditionnellement

- qualifié

- Formation

- transformateur

- Transparence

- traitement

- procès

- essais cliniques

- tutoriel

- types

- incapable

- comprendre

- compréhension

- expérience unique et authentique

- Universités

- université

- Université de Chicago

- mise à jour

- a actualisé

- la mise à jour

- utilisé

- cas d'utilisation

- d'utiliser

- Utilisateur

- utilisateurs

- Usages

- en utilisant

- utiliser

- utilisé

- Utilisant

- Plus-value

- divers

- Vérification

- vérifier

- verticales

- via

- Vidéo

- Vidéos

- Voix

- attendez

- Attendre

- était

- Washington

- façons

- we

- web

- application Web

- Applications Web

- services Web

- WELL

- ont été

- Quoi

- quand

- que

- qui

- tout en

- WHO

- large

- Large gamme

- comprenant

- dans les

- activités principales

- workflow

- de travail

- pourra

- code écrit

- années

- Vous n'avez

- Votre

- zéphyrnet