Oui .. Je parle des applications d'IA - nos myriades d'applications d'IA et celles à venir chuchotant aux humains ce qu'il faut faire…. comment le faire… mais pas sur les chuchoteurs qui interagissent avec les chatbots IA.

Selon IDC Selon les prévisions, le marché mondial de l'IA pourrait atteindre plus de 500 milliards de dollars d'ici 2024, soit une augmentation de plus de 50 % par rapport à 2021. Cela indique que nous sommes passés des expériences commerciales à l'acceptation qu'il fait partie intégrante de la stratégie d'entreprise pour toutes les tailles. C'est un outil nécessaire pour transformer les données en informations afin de déclencher une action basée sur de meilleures décisions. Personne ne débat des avantages de l'IA pour réduire les risques commerciaux et amplifier le retour sur investissement grâce à l'innovation. Mais, comme toujours, il y a un… MAIS… l'IA impartiale est plus facile à dire qu'à faire.

Critiques pour l'entreprise, ces modèles d'IA doivent fonctionner de manière fiable avec visibilité et responsabilité. Sinon, l'échec, dans ce cas, a des conséquences désastreuses qui ont un impact sur les flux de trésorerie de toute entreprise et pourraient même entraîner des problèmes juridiques. La seule façon d'éviter cela est l'automatisation et la transparence pour répondre à une question "Pouvez-vous prouver que cette application/charge de travail d'IA est construite de manière éthique". Aka… comment gouvernez-vous ? Et pouvez-vous prouver qu'il est gouverné en permanence ?

C'est là que les entreprises aiment IBM ont investi dans la gouvernance de l'IA pour orchestrer le processus global de direction, de gestion et de surveillance des activités d'IA de l'organisation. La tâche principale consiste à s'assurer que toutes les unités commerciales restent proactives et à intégrer le cadre de gouvernance dans les initiatives visant à renforcer la capacité à respecter les principes et réglementations éthiques. En particulier, les industries réglementées telles que la banque et les services financiers sont légalement tenues de fournir des preuves pour satisfaire les régulateurs.

L'influence de l'IA croît de manière exponentielle dans le secteur des services financiers en raison de la pression énorme de la transformation numérique. Comme dit, c'est plus facile à dire qu'à faire car :

1. Opérationnalisez en toute confiance les applications d'IA :

Dans certains cas, les modèles sont construits sans clarté ni catalogage ; Inutile de dire que la surveillance se glisse au milieu de tout pour suivre le cycle de vie de bout en bout. Alors que les banques sont aux prises avec des applications héritées, l'automatisation des processus pour créer de la transparence et de l'explicabilité est devenue plus difficile et, à son tour, une boîte noire. Personne ne sait pourquoi/comment les décisions ont été prises. Les nouvelles applications enchevêtrées avec des applications héritées ne voient jamais la lumière du jour bien qu'un énorme retour sur investissement y soit associé en raison de la qualité et des risques non perçus.

Cela nous amène à notre deuxième point - gérer le risque de réputation

2. Gérer le risque de réputation en même temps que le risque global

j'ai demandé #chatGPT et les #Barde – qui est Padma Chukka. #ChatGPT a refusé de répondre même si j'ai changé la question de plusieurs façons. Pourtant, Bard m'a donné une réponse détaillée, y compris mon profil LinkedIn… mais les données proviennent de divers sites où mon ancien profil existe toujours dans le cadre des biographies des conférenciers. À partir de ce moment, je n'ai pas encore ouvert le barde. Très vite, j'ai été éteint, alias - risque de réputation. Supposons que je puisse désactiver un simple chatbot lorsque je réalise que les données peuvent être incohérentes. Comment pourrais-je ne pas m'en assurer avant de décider d'acheter une application infusée d'IA pour mener des activités critiques ? Le risque de réputation est un facteur essentiel que les entreprises oublient parfois. Si vous quantifiez le risque de réputation, on peut voir l'énorme impact sur l'entreprise si l'on n'est pas proactif.

Pour ajouter à la complexité, le troisième est…

3. Comment une entreprise peut-elle répondre à l'évolution de la réglementation en matière d'IA ?

Pour éviter le risque de réputation, une équipe d'IA performante et responsable doit être au courant de toutes les réglementations locales et mondiales, et tomber comme une vidéo tic-tac avec un préavis d'un instant. Et la non-conformité peut finalement coûter à une organisation des millions de dollars en amendes pour des travaux comme la proposition de loi sur l'IA de l'UE. Cela peut représenter jusqu'à 30 millions d'euros ou 6 % du chiffre d'affaires mondial de l'entreprise – OUCH.

Eh bien, tout ne doit pas être rose au départ… tant que nous savons comment transformer une situation effrayante en une situation rose.

Sans surprise… ce sont toujours les gens, les processus et la technologie. Donc, tout d'abord, créez un organe directeur interfonctionnel pour éduquer, diriger et surveiller les initiatives en fonction des objectifs. Comparez ensuite la technologie et les processus d'IA actuels, comprenez les lacunes, puis remédiez à l'épreuve du temps. Recourez ensuite à un ensemble de workflows de gouvernance automatisés conformes aux exigences de conformité. Enfin, mettez en place un système de surveillance pour alerter les propriétaires si le seuil acceptable se rapproche. Du côté de la technologie, une IA bien architecturée, bien exécutée et bien connectée nécessite plusieurs éléments de base. Et assurez-vous qu'il dispose de certaines ou de toutes les fonctionnalités :

· Intégrité des données dans divers déploiements

· Utiliser des outils existants ouverts et flexibles qui adhèrent à la gouvernance de l'IA

· Assurez-vous d'offrir un accès en libre-service avec des contrôles de confidentialité - un moyen de suivre

· Concevoir avec l'automatisation et la gouvernance de l'IA à l'esprit

· Peut se connecter et être personnalisable pour plusieurs parties prenantes grâce à un flux de travail personnalisable

Une fois que nous avons relooké l'application d'effrayant à Rosy… alors la question suivante est de savoir comment prouver…

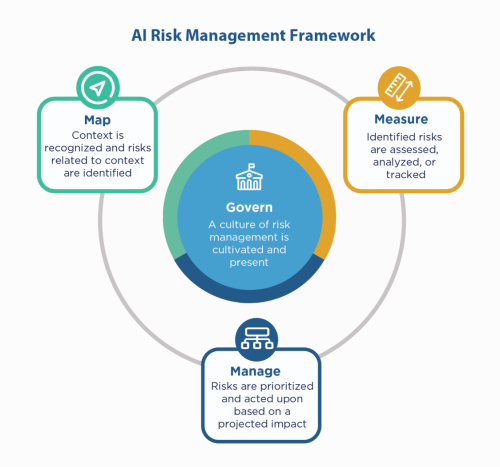

Tout d'abord, revenez aux principes de l'IA de l'entreprise - construisez avec eux, et pourtant vous devez toujours «montrer» que vous êtes conforme, en particulier dans des environnements réglementés comme les services financiers. Étant donné que les services financiers doivent se plaindre auprès du NIST 800-53, ils pourraient examiner le Cadre de gestion des risques NIST AI (AI RMF). Le NIST a suggéré les contrôles en quatre familles - Gouverner, Mapper, Mesurer et Gérer. Utilisez cela comme facteur directeur et testez les applications pour identifier les lacunes à corriger et à surveiller.

IBM peut valider vos modèles avant de les mettre en production et peut être surveillé pour l'équité, la qualité et la dérive. Il peut également fournir une documentation expliquant le comportement et les prévisions du modèle pour satisfaire aux exigences des régulateurs et des auditeurs. Ces explications peuvent apporter de la visibilité et alléger la tâche de l'audit, et accroître la transparence et la capacité à déterminer les risques éventuels.

Écoutez ces chuchotements de l'IA en toute confiance !

#Services financiers #responsableai #éthiqueai #NISTAIRMF

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- Frapper l'avenir avec Adryenn Ashley. Accéder ici.

- La source: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :est

- $UP

- 2021

- 2024

- 7

- a

- capacité

- A Propos

- acceptable

- accès

- la reddition de comptes

- à travers

- Agis

- Action

- d'activités

- adhérer

- AI

- Loi sur l'IA

- Gouvernance de l'IA

- aka

- Alerte

- Tous

- toujours

- et les

- répondre

- appli

- Application

- applications

- applications

- SONT

- autour

- AS

- associé

- At

- audit

- vérificateurs

- Automatisation

- automatiser

- Automation

- RETOUR

- Services bancaires

- Banks

- basé

- BE

- car

- before

- va

- référence

- avantages.

- Améliorée

- Milliards

- Noir

- Blocs

- corps

- Box

- Apportez le

- construire

- Développement

- construit

- la performance des entreprises

- acheter

- by

- CAN

- capacités

- maisons

- cas

- Argent liquide

- cash-flow

- en changeant

- Chatbot

- Chatbots

- clarté

- fermeture

- Sociétés

- Société

- complexité

- conformité

- Conduire

- avec confiance

- NOUS CONTACTER

- Conséquences

- continuellement

- contrôles

- Prix

- pourriez

- engendrent

- critique

- Courant

- personnalisables

- cycle

- données

- débattre

- Décider

- décisions

- diminuer

- Conception

- détaillé

- Déterminer

- numérique

- Transformation numérique

- terrible

- direction

- plusieurs

- Documentation

- dollars

- Goutte

- plus facilement

- éduquer

- end-to-end

- assurer

- Entreprise

- environnements

- notamment

- essential

- éthique

- EU

- euros

- Pourtant, la

- Chaque

- peut

- preuve

- existant

- existe

- expliquant

- exponentielle

- Échec

- justice

- Automne

- familles

- finalement

- la traduction de documents financiers

- services financiers

- extrémités

- Finextra

- Prénom

- flexible

- flux

- Pour

- Framework

- De

- À partir de 2021 ans

- avenir

- Donner

- Global

- gouvernance

- Croissance

- Vous avez

- Comment

- How To

- HTTPS

- majeur

- Les êtres humains

- i

- identifier

- Impact

- in

- Y compris

- Améliore

- indique

- secteurs

- influencer

- les initiatives

- Innovation

- idées.

- intégrale

- intégrité

- interagir

- investi

- IT

- SES

- Emploi

- Savoir

- Legacy

- Légal

- affaires légales

- VIE

- comme

- Gamme

- locales

- Location

- Style

- LES PLANTES

- a prendre une

- gérer

- gestion

- les gérer

- Localisation

- Marché

- compte

- Mai..

- mesurer

- Découvrez

- pourrait

- million

- des millions

- modèle

- numériques jumeaux (digital twin models)

- moment

- Surveiller

- surveillé

- Stack monitoring

- PLUS

- plusieurs

- nécessaire

- Besoin

- Inutile

- Nouveauté

- next

- nist

- objectifs

- of

- code

- Vieux

- on

- ONE

- ouvert

- fonctionner

- organisation

- autrement

- global

- propriétaires

- Pain

- partie

- Personnes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- possible

- Prédictions

- la parfaite pression

- primaire

- principes

- la confidentialité

- Cybersécurité

- processus

- les process

- Vidéo

- Profil

- preuve

- proposé

- Prouver

- fournir

- mettre

- qualité

- question

- vite.

- nous joindre

- réaliser

- réglementé

- industries réglementées

- Règlement

- règlements

- Régulateurs

- réputation

- conditions

- Exigences

- a besoin

- Réagir

- responsables

- résultat

- de revenus

- Analyse

- la gestion des risques

- risques

- ROI

- rosé

- s

- Saïd

- Deuxièmement

- secteur

- En libre service

- Services

- set

- devrait

- montrer

- côté

- étapes

- depuis

- Sites

- situation

- tailles

- So

- quelques

- Spark

- Speaker

- parties prenantes

- rester

- Encore

- de Marketing

- Renforcer

- stress

- Luttant

- réussi

- combustion propre

- parlant

- équipe

- Technologie

- tester

- qui

- Le

- Les

- Ces

- Troisièmement

- порог

- Avec

- à

- outil

- les outils

- suivre

- De La Carrosserie

- Transparence

- énorme

- TOUR

- Tourné

- En fin de compte

- comprendre

- unités

- prochain

- us

- utilisé

- VALIDER

- divers

- Vidéo

- définition

- Façon..

- façons

- Quoi

- tout en

- WHO

- comprenant

- sans

- activités principales

- workflows

- Vous n'avez

- Votre

- zéphyrnet