चैटजीपीटी के लॉन्च और जेनरेटिव एआई की लोकप्रियता में वृद्धि ने उन ग्राहकों की कल्पना पर कब्जा कर लिया है जो इस बात को लेकर उत्सुक हैं कि वे इस तकनीक का उपयोग एडब्ल्यूएस पर नए उत्पाद और सेवाएं बनाने के लिए कैसे कर सकते हैं, जैसे एंटरप्राइज़ चैटबॉट, जो अधिक संवादी हैं। यह पोस्ट आपको दिखाती है कि आप एक वेब यूआई कैसे बना सकते हैं, जिसे हम चैट स्टूडियो कहते हैं, बातचीत शुरू करने और इसमें उपलब्ध फाउंडेशन मॉडल के साथ बातचीत करने के लिए अमेज़न SageMaker जम्पस्टार्ट जैसे कि लामा 2, स्टेबल डिफ्यूजन, और अन्य मॉडल उपलब्ध हैं अमेज़न SageMaker. इस समाधान को तैनात करने के बाद, उपयोगकर्ता जल्दी से आरंभ कर सकते हैं और एक वेब इंटरफ़ेस के माध्यम से संवादी एआई में कई फाउंडेशन मॉडल की क्षमताओं का अनुभव कर सकते हैं।

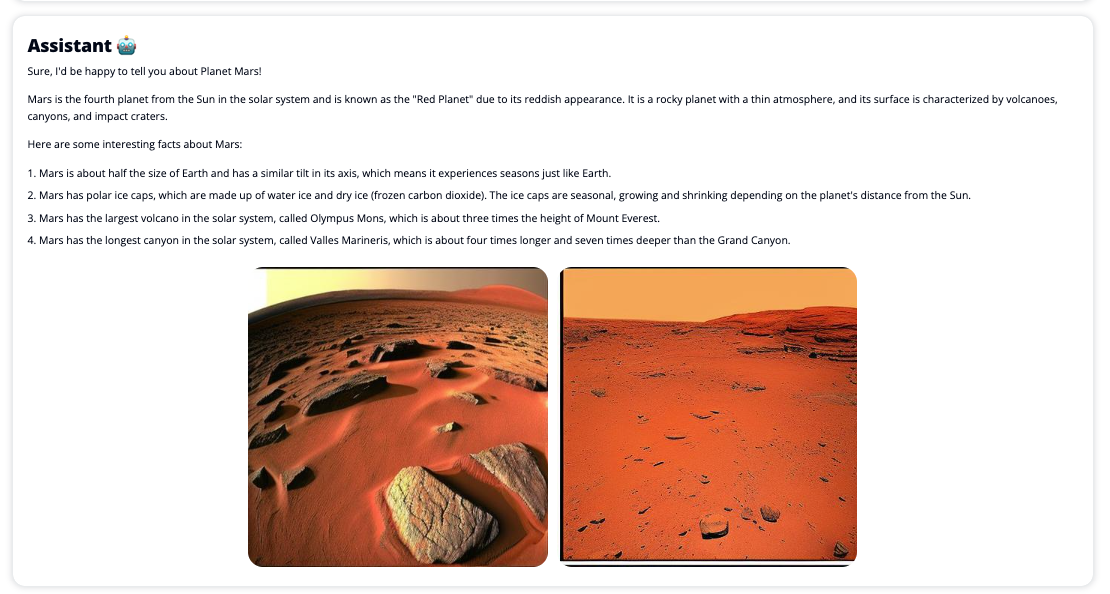

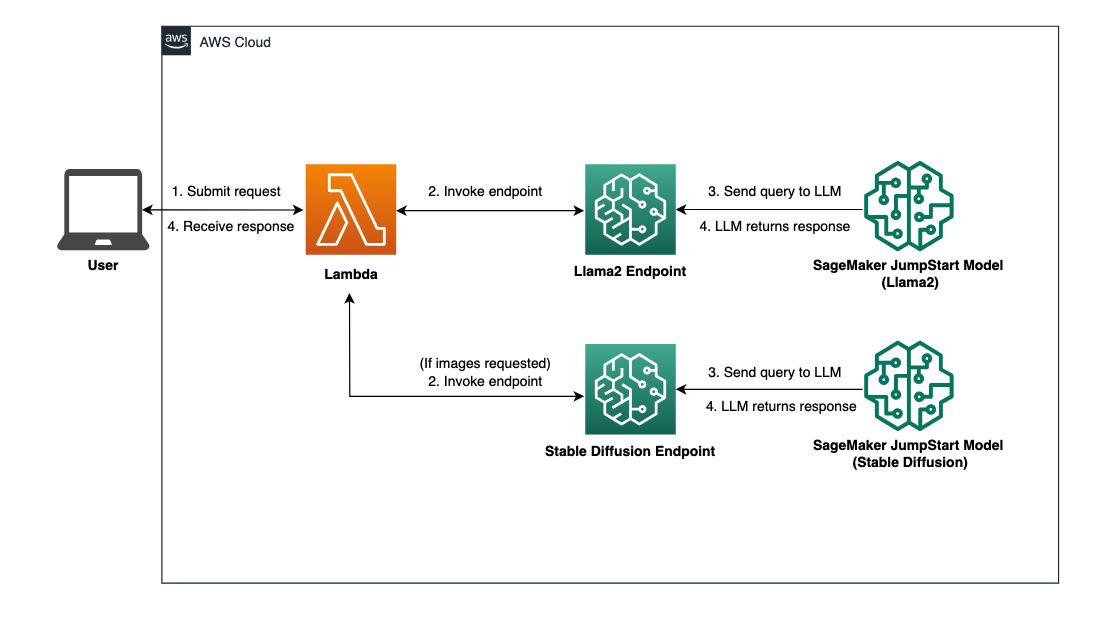

यदि उपयोगकर्ता मीडिया प्रदर्शित करने का अनुरोध करता है तो चैट स्टूडियो प्रासंगिक छवियों और वीडियो का कोलाज वापस करने के लिए वैकल्पिक रूप से स्टेबल डिफ्यूजन मॉडल एंडपॉइंट को भी लागू कर सकता है। यह सुविधा प्रतिक्रिया के साथ-साथ मीडिया के उपयोग के साथ उपयोगकर्ता अनुभव को बढ़ाने में मदद कर सकती है। यह सिर्फ एक उदाहरण है कि आप अपने लक्ष्यों को पूरा करने के लिए अतिरिक्त एकीकरण के साथ चैट स्टूडियो को कैसे समृद्ध कर सकते हैं।

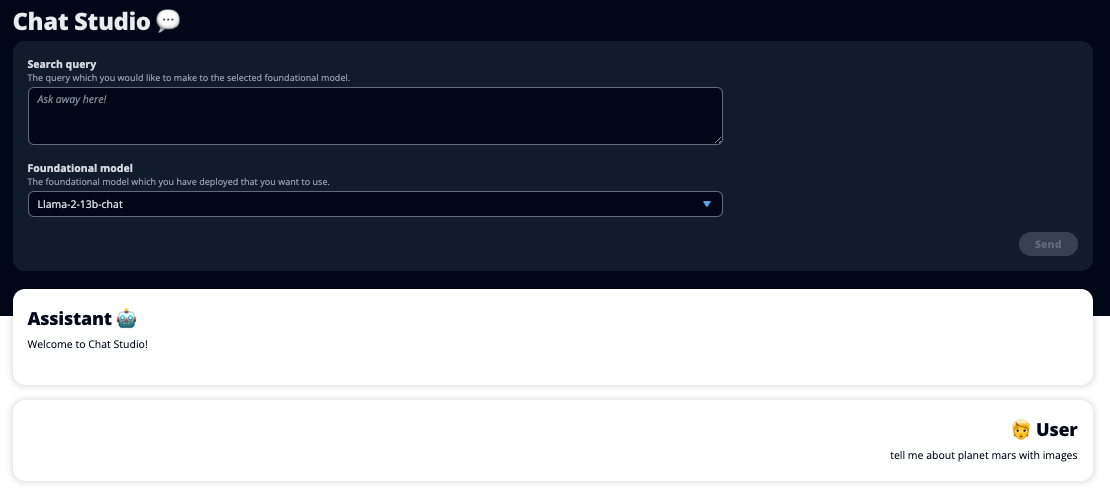

निम्नलिखित स्क्रीनशॉट उदाहरण दिखाते हैं कि उपयोगकर्ता की क्वेरी और प्रतिक्रिया कैसी दिखती है।

बड़े भाषा मॉडल

चैटजीपीटी जैसे जेनरेटिव एआई चैटबॉट बड़े भाषा मॉडल (एलएलएम) द्वारा संचालित होते हैं, जो एक गहन शिक्षण तंत्रिका नेटवर्क पर आधारित होते हैं जिन्हें बड़ी मात्रा में बिना लेबल वाले टेक्स्ट पर प्रशिक्षित किया जा सकता है। एलएलएम का उपयोग एक बेहतर वार्तालाप अनुभव की अनुमति देता है जो वास्तविक मनुष्यों के साथ बातचीत के समान होता है, कनेक्शन की भावना को बढ़ावा देता है और उपयोगकर्ता की संतुष्टि में सुधार करता है।

सेजमेकर फाउंडेशन मॉडल

2021 में, स्टैनफोर्ड इंस्टीट्यूट फॉर ह्यूमन-सेंटर्ड आर्टिफिशियल इंटेलिजेंस ने कुछ एलएलएम को नाम दिया नींव मॉडल. फाउंडेशन मॉडल सामान्य डेटा के एक बड़े और व्यापक सेट पर पूर्व-प्रशिक्षित होते हैं और डिजिटल कला उत्पन्न करने से लेकर बहुभाषी पाठ वर्गीकरण तक, उपयोग के मामलों की एक विस्तृत श्रृंखला में आगे के अनुकूलन के लिए आधार के रूप में काम करने के लिए होते हैं। ये फाउंडेशन मॉडल ग्राहकों के बीच लोकप्रिय हैं क्योंकि नए मॉडल को शुरू से प्रशिक्षित करने में समय लगता है और यह महंगा हो सकता है। सेजमेकर जम्पस्टार्ट तीसरे पक्ष के ओपन सोर्स और मालिकाना प्रदाताओं से बनाए गए सैकड़ों फाउंडेशन मॉडल तक पहुंच प्रदान करता है।

समाधान अवलोकन

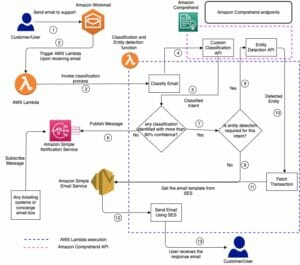

यह पोस्ट सेजमेकर के माध्यम से पूर्व-प्रशिक्षित और कस्टम एलएलएम को तैनात करने और तैनात किए गए मॉडल के साथ इंटरफेस करने के लिए एक वेब यूआई बनाने के लिए कम-कोड वर्कफ़्लो के माध्यम से चलता है। हम निम्नलिखित चरणों को कवर करते हैं:

- सेजमेकर फाउंडेशन मॉडल तैनात करें।

- तैनाती AWS लाम्बा और AWS पहचान और अभिगम प्रबंधन (IAM) अनुमतियों का उपयोग कर रहा हूँ एडब्ल्यूएस CloudFormation.

- उपयोगकर्ता इंटरफ़ेस सेट करें और चलाएं।

- वैकल्पिक रूप से, अन्य सेजमेकर फाउंडेशन मॉडल जोड़ें। यह कदम अतिरिक्त फाउंडेशन मॉडल के साथ बातचीत करने के लिए चैट स्टूडियो की क्षमता को बढ़ाता है।

- वैकल्पिक रूप से, एप्लिकेशन का उपयोग करके परिनियोजित करें AWS प्रवर्धित करें. यह चरण चैट स्टूडियो को वेब पर तैनात करता है।

समाधान आर्किटेक्चर के अवलोकन के लिए निम्नलिखित चित्र देखें।

.. पूर्वापेक्षाएँ

समाधान के माध्यम से चलने के लिए, आपके पास निम्नलिखित पूर्वापेक्षाएँ होनी चाहिए:

- An AWS खाता पर्याप्त IAM उपयोगकर्ता विशेषाधिकारों के साथ।

npmआपके स्थानीय परिवेश में स्थापित. इंस्टाल करने के तरीके पर निर्देशों के लिएnpm, को देखें Node.js और npm को डाउनलोड और इंस्टॉल करना.- संबंधित सेजमेकर एंडपॉइंट के लिए 1 का सेवा कोटा। लामा 2 13बी चैट के लिए, हम ml.g5.48xlarge इंस्टेंस का उपयोग करते हैं और स्टेबल डिफ्यूजन 2.1 के लिए, हम ml.p3.2xlarge इंस्टेंस का उपयोग करते हैं।

सेवा कोटा बढ़ाने का अनुरोध करने के लिए, पर AWS सेवा कोटा कंसोल, पर जाए AWS सेवाएं, SageMaker, और एंडपॉइंट उपयोग के लिए ml.g1xlarge और एंडपॉइंट उपयोग के लिए ml.p5.48xlarge के लिए सेवा कोटा को 3.2 के मान तक बढ़ाने का अनुरोध करें।

उदाहरण प्रकार की उपलब्धता के आधार पर सेवा कोटा अनुरोध को स्वीकृत होने में कुछ घंटे लग सकते हैं।

सेजमेकर फाउंडेशन मॉडल तैनात करें

सेजमेकर डेवलपर्स के लिए आसानी से एमएल मॉडल बनाने और प्रशिक्षित करने के लिए एक पूरी तरह से प्रबंधित मशीन लर्निंग (एमएल) सेवा है। लामा 2 13बी चैट और स्टेबल डिफ्यूजन 2.1 फाउंडेशन मॉडल को तैनात करने के लिए निम्नलिखित चरणों को पूरा करें अमेज़ॅन सैजमेकर स्टूडियो:

- एक सेजमेकर डोमेन बनाएं. निर्देशों के लिए, देखें त्वरित सेटअप का उपयोग करके Amazon SageMaker डोमेन पर ऑनबोर्ड करें.

एक डोमेन सभी स्टोरेज सेट करता है और आपको सेजमेकर तक पहुंचने के लिए उपयोगकर्ताओं को जोड़ने की अनुमति देता है।

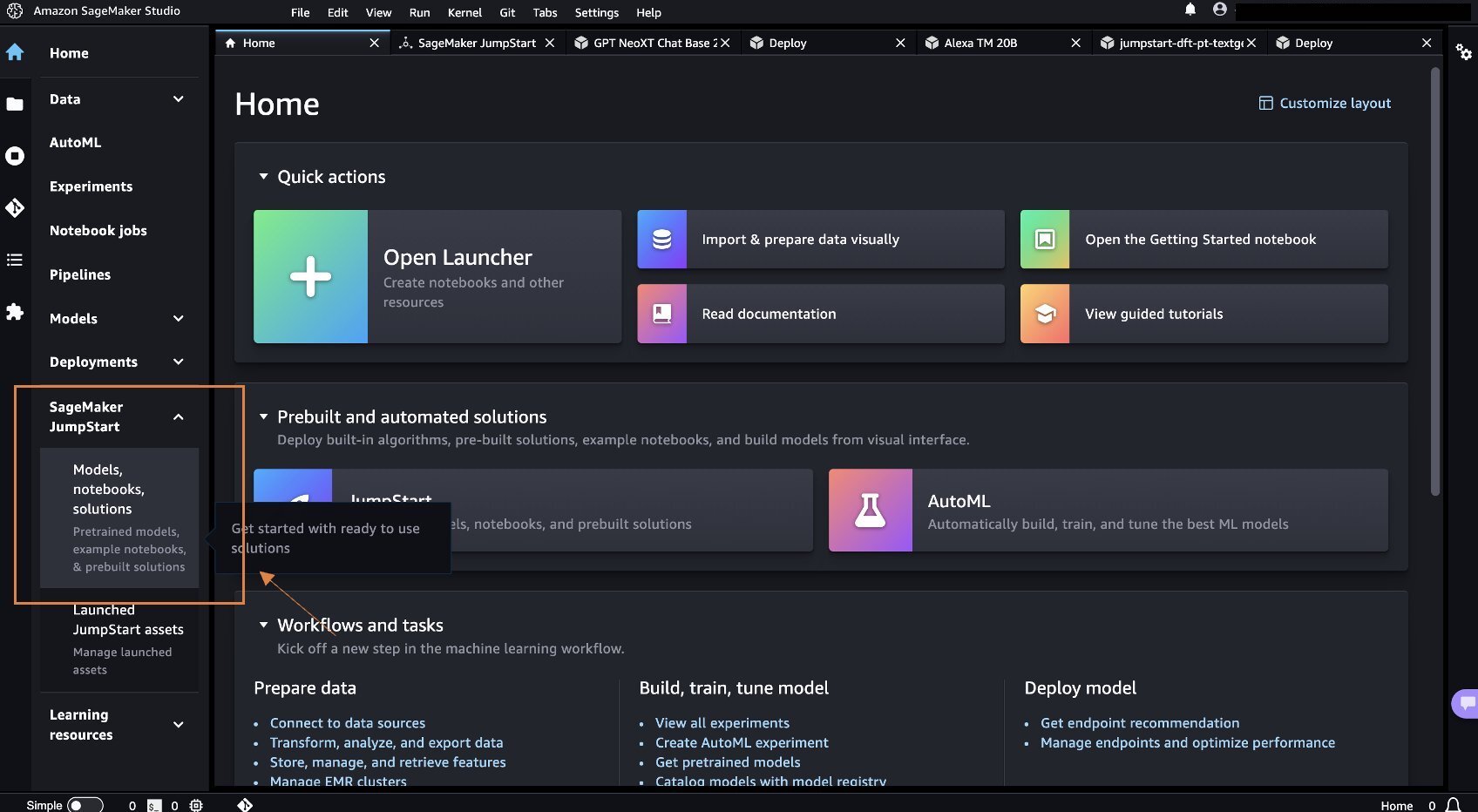

- SageMaker कंसोल पर, चुनें स्टूडियो नेविगेशन फलक में, फिर चुनें स्टूडियो खोलें.

- स्टूडियो लॉन्च करने पर, के अंतर्गत सेजमेकर जम्पस्टार्ट नेविगेशन फलक में, चुनें मॉडल, नोटबुक, समाधान.

- खोज बार में, लामा 2 13बी चैट खोजें।

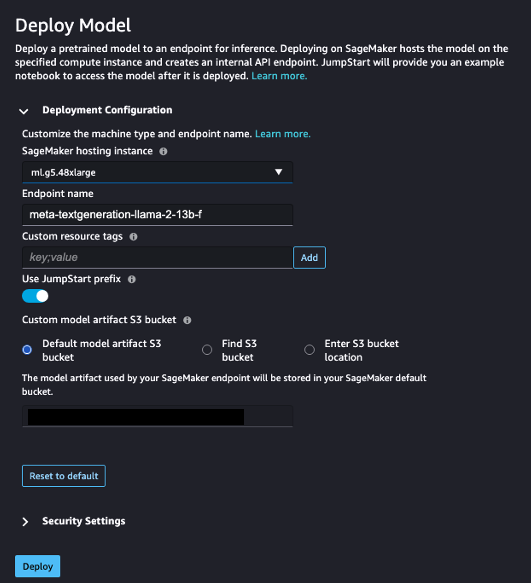

- के अंतर्गत परिनियोजन विन्यासके लिए, SageMaker होस्टिंग उदाहरण, चुनें एमएल.g5.48xबड़ा है और सीएएए की समापन बिंदु नाम, दर्ज

meta-textgeneration-llama-2-13b-f. - चुनें फैल जाते हैं।

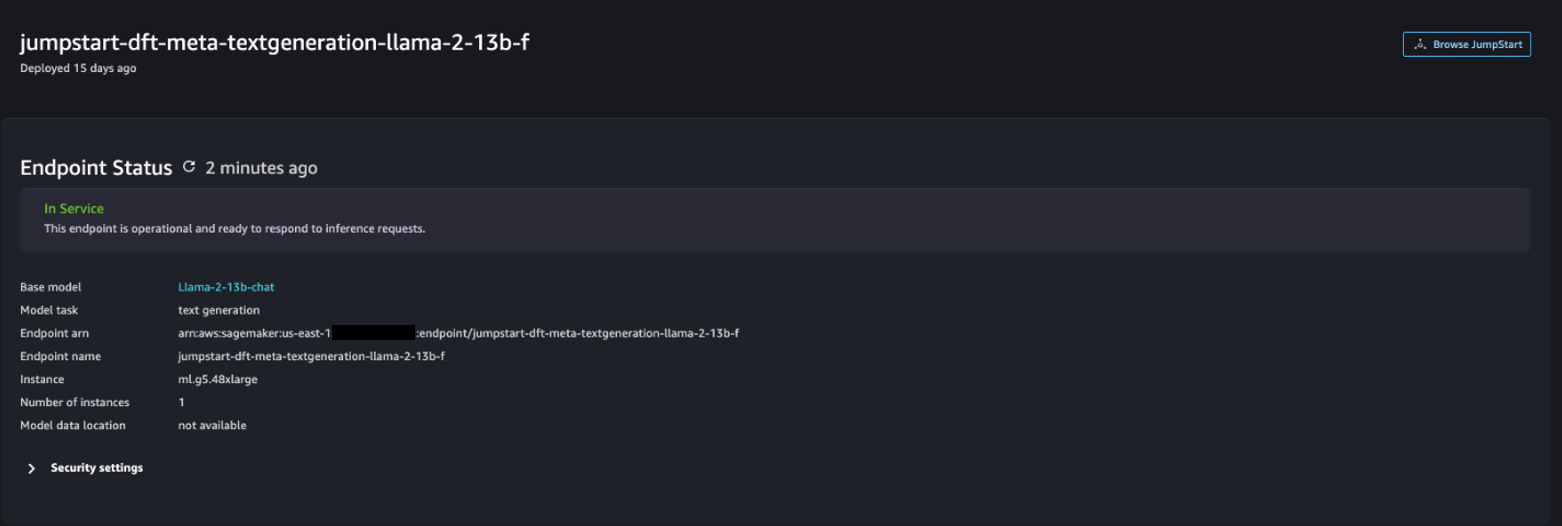

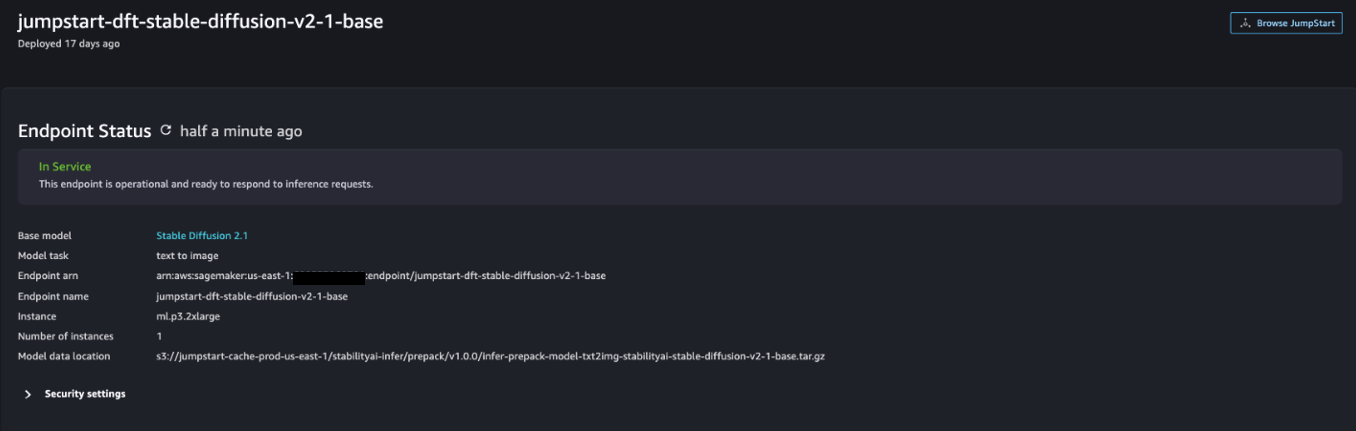

परिनियोजन सफल होने के बाद, आपको इसे देखने में सक्षम होना चाहिए In Service स्थिति।

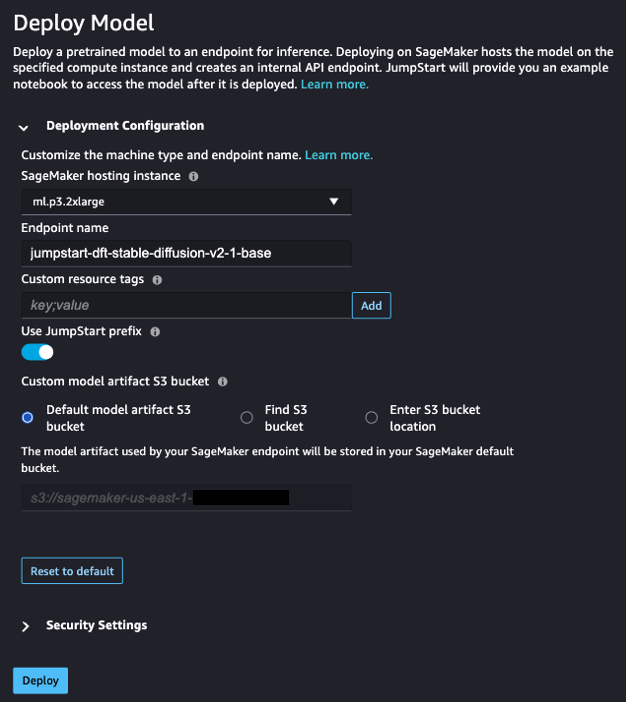

- पर मॉडल, नोटबुक, समाधान पृष्ठ, स्थिर प्रसार 2.1 खोजें।

- के अंतर्गत परिनियोजन विन्यासके लिए, SageMaker होस्टिंग उदाहरण, चुनें एमएल.पी3.2xबड़ा है और सीएएए की समापन बिंदु नाम, दर्ज

jumpstart-dft-stable-diffusion-v2-1-base. - चुनें तैनाती.

परिनियोजन सफल होने के बाद, आपको इसे देखने में सक्षम होना चाहिए In Service स्थिति।

AWS CloudFormation का उपयोग करके लैम्ब्डा और IAM अनुमतियाँ परिनियोजित करें

यह अनुभाग वर्णन करता है कि आप एक क्लाउडफ़ॉर्मेशन स्टैक कैसे लॉन्च कर सकते हैं जो एक लैम्ब्डा फ़ंक्शन को तैनात करता है जो आपके उपयोगकर्ता अनुरोध को संसाधित करता है और आपके द्वारा तैनात किए गए सेजमेकर एंडपॉइंट को कॉल करता है, और सभी आवश्यक आईएएम अनुमतियों को तैनात करता है। निम्नलिखित चरणों को पूरा करें:

- पर नेविगेट करें गिटहब भंडार और क्लाउडफॉर्मेशन टेम्पलेट डाउनलोड करें (

lambda.cfn.yaml) आपकी स्थानीय मशीन पर। - क्लाउडफॉर्मेशन कंसोल पर, चुनें स्टैक बनाएँ ड्रॉप-डाउन मेनू और चुनें नए संसाधनों के साथ (मानक).

- पर टेम्पलेट निर्दिष्ट करें पेज, का चयन करें टेम्पलेट फ़ाइल अपलोड करें और फ़ाइल का चयन.

- चुनना

lambda.cfn.yamlवह फ़ाइल जिसे आपने डाउनलोड किया है, फिर चुनें अगला. - पर स्टैक विवरण निर्दिष्ट करें पेज, स्टैक नाम और एपीआई कुंजी दर्ज करें जो आपने पूर्वापेक्षाओं में प्राप्त की थी, फिर चुनें अगला.

- पर स्टैक विकल्प कॉन्फ़िगर करें पृष्ठ, चुनें अगला.

- परिवर्तनों की समीक्षा करें और उन्हें स्वीकार करें तथा चुनें सब्मिट.

वेब यूआई सेट करें

यह अनुभाग वेब यूआई (का उपयोग करके बनाया गया) चलाने के चरणों का वर्णन करता है क्लाउडस्केप डिजाइन सिस्टम) आपकी स्थानीय मशीन पर:

- IAM कंसोल पर, उपयोगकर्ता पर नेविगेट करें

functionUrl. - पर सुरक्षा क्रेडेंशियल टैब चुनें पहुंच कुंजी बनाएं.

- पर मुख्य सर्वोत्तम प्रथाओं और विकल्पों तक पहुंचें पेज, का चयन करें कमांड लाइन इंटरफ़ेस (सीएलआई) और चुनें अगला.

- पर विवरण टैग सेट करें पृष्ठ, चुनें पहुंच कुंजी बनाएं.

- एक्सेस कुंजी और गुप्त एक्सेस कुंजी की प्रतिलिपि बनाएँ।

- चुनें करेंकिया गया.

- पर नेविगेट करें गिटहब भंडार और डाउनलोड करें

react-llm-chat-studioकोड। - अपनी पसंदीदा आईडीई में फ़ोल्डर लॉन्च करें और एक टर्मिनल खोलें।

- पर जाए

src/configs/aws.jsonऔर आपके द्वारा प्राप्त एक्सेस कुंजी और गुप्त एक्सेस कुंजी इनपुट करें। - टर्मिनल में निम्नलिखित कमांड दर्ज करें:

- प्रारंभिक http://localhost:3000 अपने ब्राउज़र में और अपने मॉडलों के साथ इंटरैक्ट करना शुरू करें!

चैट स्टूडियो का उपयोग करने के लिए, ड्रॉप-डाउन मेनू पर एक मूलभूत मॉडल चुनें और टेक्स्ट बॉक्स में अपनी क्वेरी दर्ज करें। प्रतिक्रिया के साथ एआई-जनित छवियां प्राप्त करने के लिए, अपनी क्वेरी के अंत में "छवियों के साथ" वाक्यांश जोड़ें।

अन्य सेजमेकर फाउंडेशन मॉडल जोड़ें

आप अतिरिक्त सेजमेकर फाउंडेशन मॉडल को शामिल करने के लिए इस समाधान की क्षमता को और बढ़ा सकते हैं। क्योंकि प्रत्येक मॉडल अपने सेजमेकर एंडपॉइंट को लागू करते समय अलग-अलग इनपुट और आउटपुट प्रारूपों की अपेक्षा करता है, आपको मॉडल के साथ इंटरफेस करने के लिए कॉलसेजमेकरएंडपॉइंट्स लैम्ब्डा फ़ंक्शन में कुछ परिवर्तन कोड लिखने की आवश्यकता होगी।

यह अनुभाग आपकी पसंद के अतिरिक्त मॉडल को लागू करने के लिए आवश्यक सामान्य चरणों और कोड परिवर्तनों का वर्णन करता है। ध्यान दें कि चरण 6-8 के लिए पायथन भाषा का बुनियादी ज्ञान आवश्यक है।

- सेजमेकर स्टूडियो में, अपनी पसंद का सेजमेकर फाउंडेशन मॉडल तैनात करें।

- चुनें सेजमेकर जम्पस्टार्ट और जम्पस्टार्ट संपत्तियां लॉन्च करें.

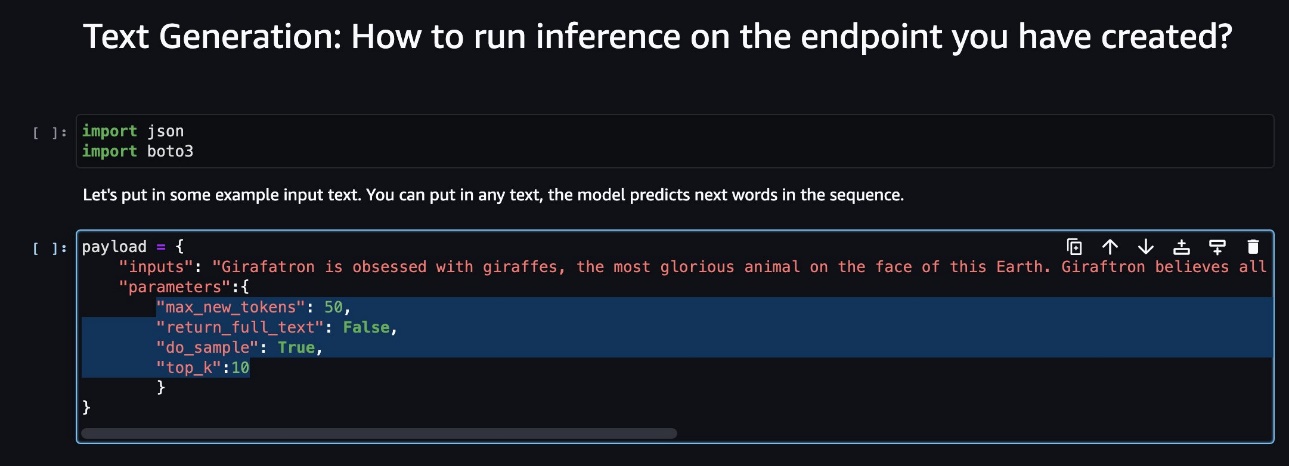

- अपना नया तैनात मॉडल एंडपॉइंट चुनें और चुनें नोटबुक खोलें.

- नोटबुक कंसोल पर, पेलोड पैरामीटर ढूंढें।

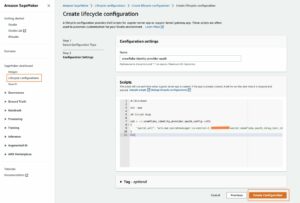

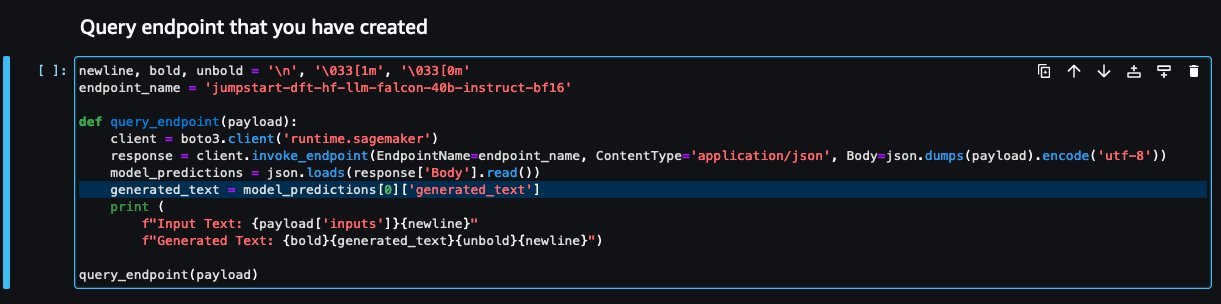

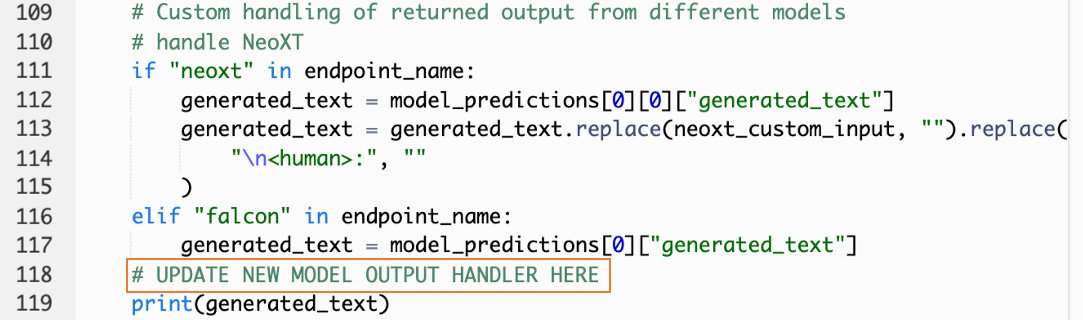

ये वे क्षेत्र हैं जिनकी अपेक्षा नया मॉडल अपने सेजमेकर एंडपॉइंट को लागू करते समय करता है। निम्नलिखित स्क्रीनशॉट एक उदाहरण दिखाता है.

- लैम्ब्डा कंसोल पर, नेविगेट करें

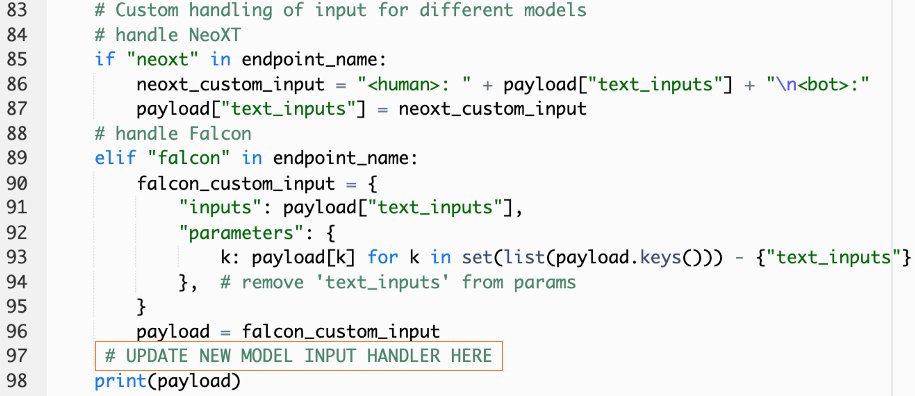

callSageMakerEndpoints. - अपने नए मॉडल के लिए एक कस्टम इनपुट हैंडलर जोड़ें।

निम्नलिखित स्क्रीनशॉट में, हमने फाल्कन 40बी इंस्ट्रक्ट बीएफ16 और जीपीटी नियोएक्सटी चैट बेस 20बी एफपी16 के लिए इनपुट को बदल दिया। आप अपने द्वारा कॉपी किए गए पेलोड पैरामीटर के संदर्भ में इनपुट ट्रांसफ़ॉर्मेशन लॉजिक जोड़ने के लिए संकेत के अनुसार अपना कस्टम पैरामीटर लॉजिक डाल सकते हैं।

- नोटबुक कंसोल पर लौटें और पता लगाएं

query_endpoint.

यह फ़ंक्शन आपको एक विचार देता है कि अंतिम टेक्स्ट प्रतिक्रिया निकालने के लिए मॉडल के आउटपुट को कैसे बदला जाए।

- में कोड के संदर्भ में

query_endpoint, अपने नए मॉडल के लिए एक कस्टम आउटपुट हैंडलर जोड़ें।

- चुनें फैल जाते हैं।

- अपना आईडीई खोलें, लॉन्च करें

react-llm-chat-studioकोड, और नेविगेट करेंsrc/configs/models.json. - अपना मॉडल नाम और मॉडल समापन बिंदु जोड़ें, और चरण 4 से पेलोड पैरामीटर दर्ज करें

payloadनिम्नलिखित प्रारूप का उपयोग करना: - अपने नए मॉडल के साथ इंटरैक्ट करना शुरू करने के लिए अपने ब्राउज़र को रीफ़्रेश करें!

एम्प्लिफाई का उपयोग करके एप्लिकेशन को तैनात करें

एम्प्लीफाई एक संपूर्ण समाधान है जो आपको अपने एप्लिकेशन को त्वरित और कुशलतापूर्वक तैनात करने की अनुमति देता है। यह अनुभाग चैट स्टूडियो को तैनात करने के चरणों का वर्णन करता है अमेज़न CloudFront यदि आप अपने एप्लिकेशन को अन्य उपयोगकर्ताओं के साथ साझा करना चाहते हैं तो एम्प्लीफाई का उपयोग करके वितरण करें।

- पर नेविगेट करें

react-llm-chat-studioकोड फ़ोल्डर जो आपने पहले बनाया था। - टर्मिनल में निम्नलिखित कमांड दर्ज करें और सेटअप निर्देशों का पालन करें:

- निम्नलिखित कमांड का उपयोग करके एक नया एम्प्लीफाई प्रोजेक्ट प्रारंभ करें। प्रोजेक्ट नाम प्रदान करें, डिफ़ॉल्ट कॉन्फ़िगरेशन स्वीकार करें और चुनें AWS एक्सेस कुंजियाँ जब प्रमाणीकरण विधि का चयन करने के लिए कहा जाए।

- निम्नलिखित कमांड का उपयोग करके एम्प्लीफाई प्रोजेक्ट को होस्ट करें। चुनना अमेज़न क्लाउडफ्रंट और S3 जब प्लगइन मोड का चयन करने के लिए कहा जाए।

- अंत में, निम्नलिखित कमांड के साथ प्रोजेक्ट बनाएं और तैनात करें:

- परिनियोजन सफल होने के बाद, अपने ब्राउज़र में दिए गए URL को खोलें और अपने मॉडलों के साथ इंटरैक्ट करना शुरू करें!

क्लीन अप

भविष्य के शुल्कों से बचने के लिए, निम्नलिखित चरणों को पूरा करें:

- CloudFormation स्टैक को हटाएं। निर्देशों के लिए, देखें AWS CloudFormation कंसोल पर एक स्टैक हटाना.

- सेजमेकर जंपस्टार्ट एंडपॉइंट को हटाएं। निर्देशों के लिए, देखें समापनबिंदु और संसाधन हटाएँ.

- सेजमेकर डोमेन हटाएं. निर्देशों के लिए, देखें एक अमेज़ॅन सेजमेकर डोमेन हटाएं.

निष्कर्ष

इस पोस्ट में, हमने बताया कि एडब्ल्यूएस पर तैनात एलएलएम के साथ इंटरफेसिंग के लिए वेब यूआई कैसे बनाया जाए।

इस समाधान के साथ, आप अपने एलएलएम के साथ बातचीत कर सकते हैं और एलएलएम प्रश्नों का परीक्षण करने या पूछने के लिए उपयोगकर्ता के अनुकूल तरीके से बातचीत कर सकते हैं, और यदि आवश्यक हो तो छवियों और वीडियो का कोलाज प्राप्त कर सकते हैं।

आप इस समाधान को विभिन्न तरीकों से विस्तारित कर सकते हैं, जैसे अतिरिक्त फाउंडेशन मॉडल को एकीकृत करना, अमेज़ॅन केंद्र के साथ एकीकृत करें एंटरप्राइज़ सामग्री आदि को समझने के लिए एमएल-संचालित बुद्धिमान खोज को सक्षम करने के लिए!

हम आपको प्रयोग करने के लिए आमंत्रित करते हैं AWS पर विभिन्न पूर्व-प्रशिक्षित एलएलएम उपलब्ध हैं, या उसके शीर्ष पर निर्माण करें या यहां तक कि सेजमेकर में अपना स्वयं का एलएलएम भी बनाएं। हमें अपने प्रश्न और निष्कर्ष टिप्पणियों में बताएं और आनंद लें!

लेखक के बारे में

जैरेट येओ शान वेई AWS व्यावसायिक सेवाओं में एक एसोसिएट क्लाउड आर्किटेक्ट है जो आसियान भर में सार्वजनिक क्षेत्र को कवर करता है और ग्राहकों को आधुनिकीकरण और क्लाउड में स्थानांतरित करने में मदद करने के लिए एक वकील है। उन्होंने पांच एडब्ल्यूएस प्रमाणन प्राप्त किए हैं, और एआई पर 8वें अंतर्राष्ट्रीय सम्मेलन में ग्रेडिएंट बूस्टिंग मशीन एनसेंबल पर एक शोध पत्र भी प्रकाशित किया है। अपने खाली समय में, जैरेट AWS में जेनरेटिव AI दृश्य पर ध्यान केंद्रित करते हैं और उसमें योगदान देते हैं।

जैरेट येओ शान वेई AWS व्यावसायिक सेवाओं में एक एसोसिएट क्लाउड आर्किटेक्ट है जो आसियान भर में सार्वजनिक क्षेत्र को कवर करता है और ग्राहकों को आधुनिकीकरण और क्लाउड में स्थानांतरित करने में मदद करने के लिए एक वकील है। उन्होंने पांच एडब्ल्यूएस प्रमाणन प्राप्त किए हैं, और एआई पर 8वें अंतर्राष्ट्रीय सम्मेलन में ग्रेडिएंट बूस्टिंग मशीन एनसेंबल पर एक शोध पत्र भी प्रकाशित किया है। अपने खाली समय में, जैरेट AWS में जेनरेटिव AI दृश्य पर ध्यान केंद्रित करते हैं और उसमें योगदान देते हैं।

टैमी लिम ली शिन AWS में एसोसिएट क्लाउड आर्किटेक्ट हैं। वह ग्राहकों को उनकी क्लाउड अपनाने की यात्रा में वांछित परिणाम देने में मदद करने के लिए प्रौद्योगिकी का उपयोग करती है और एआई/एमएल के बारे में भावुक है। काम के अलावा उसे यात्रा करना, लंबी पैदल यात्रा करना और परिवार और दोस्तों के साथ समय बिताना पसंद है।

टैमी लिम ली शिन AWS में एसोसिएट क्लाउड आर्किटेक्ट हैं। वह ग्राहकों को उनकी क्लाउड अपनाने की यात्रा में वांछित परिणाम देने में मदद करने के लिए प्रौद्योगिकी का उपयोग करती है और एआई/एमएल के बारे में भावुक है। काम के अलावा उसे यात्रा करना, लंबी पैदल यात्रा करना और परिवार और दोस्तों के साथ समय बिताना पसंद है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/create-a-web-ui-to-interact-with-llms-using-amazon-sagemaker-jumpstart/

- :हैस

- :है

- $यूपी

- 1

- 10

- 120

- 160

- 2021

- 3000

- 320

- 7

- 8

- 8th

- a

- योग्य

- About

- स्वीकार करें

- पहुँच

- स्वीकार करना

- के पार

- जोड़ना

- अतिरिक्त

- दत्तक ग्रहण

- वकील

- बाद

- AI

- ऐ / एमएल

- सब

- की अनुमति देता है

- साथ में

- भी

- वीरांगना

- अमेज़न SageMaker

- अमेज़न SageMaker जम्पस्टार्ट

- अमेज़ॅन वेब सेवा

- बढ़ाना

- an

- और

- एपीआई

- आवेदन

- अनुमोदित

- स्थापत्य

- हैं

- कला

- कृत्रिम

- कृत्रिम बुद्धिमत्ता

- AS

- आसियान

- पूछना

- संपत्ति

- सहयोगी

- At

- प्राप्त

- प्रमाणीकरण

- उपलब्धता

- उपलब्ध

- से बचने

- एडब्ल्यूएस

- एडब्ल्यूएस CloudFormation

- AWS व्यावसायिक सेवाएँ

- बार

- आधार

- आधारित

- बुनियादी

- BE

- क्योंकि

- BEST

- सर्वोत्तम प्रथाओं

- बेहतर

- बढ़ाने

- मुक्केबाज़ी

- विस्तृत

- ब्राउज़र

- निर्माण

- by

- कॉल

- कॉल

- कर सकते हैं

- पा सकते हैं

- क्षमताओं

- क्षमता

- पर कब्जा कर लिया

- मामलों

- प्रमाणपत्र

- परिवर्तन

- प्रभार

- chatbots

- ChatGPT

- चुनाव

- चुनें

- वर्गीकरण

- निकट से

- बादल

- बादल को गोद लेना

- कोड

- टिप्पणियाँ

- पूरा

- सम्मेलन

- विन्यास

- संबंध

- कंसोल

- सामग्री

- योगदान

- कन्वर्सेशन (Conversation)

- संवादी

- संवादी ऐ

- इसी

- आवरण

- कवर

- बनाना

- बनाया

- बनाना

- जिज्ञासु

- रिवाज

- ग्राहक

- तिथि

- गहरा

- ध्यान लगा के पढ़ना या सीखना

- चूक

- उद्धार

- निर्भर करता है

- तैनात

- तैनात

- तैनाती

- तैनाती

- तैनात

- विवरण

- डिज़ाइन

- वांछित

- विवरण

- डेवलपर्स

- विभिन्न

- प्रसार

- डिजिटल

- डिजिटल कला

- दिखाया गया है

- वितरण

- डोमेन

- डाउनलोड

- पूर्व

- आराम

- कुशलता

- सक्षम

- समाप्त

- endpoint

- बढ़ाना

- समृद्ध

- दर्ज

- उद्यम

- वातावरण

- और भी

- प्रत्येक

- उदाहरण

- उदाहरण

- उम्मीद

- महंगा

- अनुभव

- प्रयोग

- समझाया

- विस्तार

- फैली

- उद्धरण

- परिवार

- Feature

- कुछ

- फ़ील्ड

- पट्टिका

- अंतिम

- खोज

- निष्कर्ष

- पांच

- केंद्रित

- का पालन करें

- निम्नलिखित

- के लिए

- प्रारूप

- को बढ़ावा देने

- बुनियाद

- मूलभूत

- मुक्त

- मित्रों

- से

- पूरी तरह से

- समारोह

- आगे

- भविष्य

- सामान्य जानकारी

- सामान्य आंकड़ा

- सृजन

- उत्पादक

- जनरेटिव एआई

- मिल

- देता है

- लक्ष्यों

- है

- he

- मदद

- मदद

- उसके

- पकड़

- होस्टिंग

- घंटे

- कैसे

- How To

- एचटीएमएल

- http

- HTTPS

- मनुष्य

- सैकड़ों

- विचार

- पहचान

- if

- छवियों

- कल्पना

- लागू करने के

- उन्नत

- in

- शामिल

- बढ़ना

- संकेत दिया

- निवेश

- स्थापित

- installed

- स्थापित कर रहा है

- उदाहरण

- संस्थान

- निर्देश

- एकीकृत

- एकीकरण

- बुद्धि

- बुद्धिमान

- बातचीत

- बातचीत

- बातचीत

- इंटरफेस

- अंतरराष्ट्रीय स्तर पर

- में

- आमंत्रित करना

- आईटी इस

- यात्रा

- जेपीजी

- केवल

- सिर्फ एक

- कुंजी

- जानना

- ज्ञान

- भाषा

- बड़ा

- लांच

- शुरू करने

- सीख रहा हूँ

- ली

- चलो

- पसंद

- लाइन

- लामा

- एलएलएम

- स्थानीय

- तर्क

- देखिए

- हमशक्ल

- प्यार करता है

- मशीन

- यंत्र अधिगम

- कामयाब

- ढंग

- मई..

- मतलब

- मीडिया

- मिलना

- मेन्यू

- तरीका

- विस्थापित

- ML

- मोड

- आदर्श

- मॉडल

- आधुनिकीकरण

- अधिक

- विभिन्न

- चाहिए

- नाम

- नेविगेट करें

- पथ प्रदर्शन

- आवश्यक

- आवश्यकता

- नेटवर्क

- तंत्रिका

- तंत्रिका नेटवर्क

- नया

- नए उत्पादों

- नए नए

- नोड

- Node.js

- नोट

- नोटबुक

- प्राप्त

- of

- on

- ONE

- खुला

- खुला स्रोत

- ऑप्शंस

- or

- अन्य

- परिणामों

- उत्पादन

- बाहर

- सिंहावलोकन

- अपना

- पृष्ठ

- फलक

- काग़ज़

- प्राचल

- पैरामीटर

- आवेशपूर्ण

- अनुमतियाँ

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- लगाना

- लोकप्रिय

- लोकप्रियता

- पद

- संचालित

- प्रथाओं

- वरीय

- आवश्यक शर्तें

- विशेषाधिकारों

- प्रक्रियाओं

- उत्पाद

- पेशेवर

- परियोजना

- मालिकाना

- प्रदान करना

- बशर्ते

- प्रदाताओं

- प्रदान करता है

- सार्वजनिक

- प्रकाशित

- अजगर

- प्रशन

- त्वरित

- जल्दी से

- उठाना

- रेंज

- वास्तविक

- उल्लेख

- संदर्भ

- प्रासंगिक

- का अनुरोध

- अनुरोधों

- अपेक्षित

- अनुसंधान

- जैसा दिखता है

- उपयुक्त संसाधन चुनें

- प्रतिक्रिया

- वापसी

- वृद्धि

- रन

- sagemaker

- संतोष

- दृश्य

- खरोंच

- स्क्रीनशॉट

- Search

- गुप्त

- अनुभाग

- सेक्टर

- देखना

- चयन

- भावना

- सेवा

- सेवा

- सेवाएँ

- सेट

- सेट

- व्यवस्था

- Share

- वह

- चाहिए

- दिखाना

- दिखाता है

- टुकड़ा

- समाधान

- कुछ

- स्रोत

- खर्च

- स्थिर

- धुआँरा

- मानक

- स्टैनफोर्ड

- प्रारंभ

- शुरू

- स्थिति

- कदम

- कदम

- भंडारण

- स्टूडियो

- ऐसा

- पर्याप्त

- लेना

- लेता है

- टेक्नोलॉजी

- टेम्पलेट

- अंतिम

- परीक्षण

- टेक्स्ट

- पाठ वर्गीकरण

- कि

- RSI

- लेकिन हाल ही

- फिर

- इन

- वे

- तीसरे दल

- इसका

- हालांकि?

- यहाँ

- पहर

- सेवा मेरे

- ऊपर का

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- बदालना

- परिवर्तन

- तब्दील

- टाइप

- ui

- के अंतर्गत

- समझ

- यूआरएल

- us

- प्रयोग

- उपयोग

- उपयोगकर्ता

- उपयोगकर्ता अनुभव

- यूजर इंटरफेस

- उपयोगकर्ता के अनुकूल

- उपयोगकर्ताओं

- का उपयोग करता है

- का उपयोग

- मूल्य

- विभिन्न

- वीडियो

- चलना

- सैर

- तरीके

- we

- वेब

- वेब सेवाओं

- क्या

- कब

- कौन कौन से

- कौन

- चौड़ा

- विस्तृत श्रृंखला

- मर्जी

- इच्छा

- साथ में

- काम

- वर्कफ़्लो

- लिखना

- यीओ

- आप

- आपका

- जेफिरनेट