वीडियो गेमिंग उद्योग का दुनिया भर में अनुमानित उपयोगकर्ता आधार 3 बिलियन से अधिक है1. इसमें बड़ी संख्या में खिलाड़ी हर दिन वस्तुतः एक-दूसरे के साथ बातचीत करते हैं। दुर्भाग्य से, वास्तविक दुनिया की तरह, सभी खिलाड़ी उचित और सम्मानपूर्वक संवाद नहीं करते हैं। सामाजिक रूप से जिम्मेदार गेमिंग वातावरण बनाने और बनाए रखने के प्रयास में, AWS प्रोफेशनल सर्विसेज को एक ऐसा तंत्र बनाने के लिए कहा गया था जो ऑनलाइन गेमिंग प्लेयर इंटरैक्शन के भीतर अनुचित भाषा (विषाक्त भाषण) का पता लगाता है। समग्र व्यावसायिक परिणाम मौजूदा मैन्युअल प्रक्रिया को स्वचालित करके संगठन के संचालन में सुधार करना और खिलाड़ियों के बीच अनुचित बातचीत का पता लगाने में गति और गुणवत्ता बढ़ाकर उपयोगकर्ता अनुभव में सुधार करना था, अंततः एक स्वच्छ और स्वस्थ गेमिंग वातावरण को बढ़ावा देना था।

ग्राहक का अनुरोध एक अंग्रेजी भाषा डिटेक्टर बनाने का था जो आवाज और पाठ अंशों को उनकी अपनी कस्टम परिभाषित विषाक्त भाषा श्रेणियों में वर्गीकृत करता है। वे पहले यह निर्धारित करना चाहते थे कि क्या दिया गया भाषा अंश विषाक्त है, और फिर अंश को विषाक्तता की एक विशिष्ट ग्राहक-परिभाषित श्रेणी जैसे अपवित्रता या अपमानजनक भाषा में वर्गीकृत करें।

AWS ProServe ने जेनरेटिव AI इनोवेशन सेंटर (GAIIC) और ProServe ML डिलीवरी टीम (MLDT) के बीच संयुक्त प्रयास के माध्यम से इस उपयोग के मामले को हल किया। AWS GAIIC AWS ProServe के भीतर एक समूह है जो प्रूफ़ ऑफ़ कॉन्सेप्ट (PoC) बिल्ड का उपयोग करके व्यावसायिक उपयोग के मामलों की एक विस्तृत श्रृंखला के लिए जेनेरिक AI समाधान विकसित करने के लिए ग्राहकों को विशेषज्ञों के साथ जोड़ता है। AWS ProServe MLDT फिर ग्राहक के लिए समाधान को स्केलिंग, सख्त और एकीकृत करके उत्पादन के माध्यम से PoC लेता है।

इस ग्राहक उपयोग के मामले को दो अलग-अलग पोस्ट में प्रदर्शित किया जाएगा। यह पोस्ट (भाग 1) वैज्ञानिक पद्धति में गहराई से उतरने का काम करती है। यह मॉडल प्रशिक्षण और विकास प्रक्रिया सहित समाधान के पीछे की विचार प्रक्रिया और प्रयोग की व्याख्या करेगा। भाग 2 डिज़ाइन निर्णयों, डेटा प्रवाह और मॉडल प्रशिक्षण और परिनियोजन वास्तुकला के चित्रण को समझाते हुए, उत्पादन समाधान पर प्रकाश डालेगा।

यह पोस्ट निम्नलिखित विषयों को शामिल करती है:

- इस उपयोग के मामले में AWS ProServe को जिन चुनौतियों का समाधान करना था

- बड़े भाषा मॉडल (एलएलएम) के बारे में ऐतिहासिक संदर्भ और यह तकनीक इस उपयोग के मामले के लिए बिल्कुल उपयुक्त क्यों है

- AWS GAIIC का PoC और AWS ProServe MLDT का समाधान डेटा साइंस और मशीन लर्निंग (ML) परिप्रेक्ष्य से

डेटा चुनौती

एक विषैली भाषा क्लासिफायरियर को प्रशिक्षित करने में AWS प्रोसर्व के सामने मुख्य चुनौती एक सटीक मॉडल को शुरू से प्रशिक्षित करने के लिए ग्राहक से पर्याप्त लेबल डेटा प्राप्त करना था। AWS को ग्राहक से लेबल किए गए डेटा के लगभग 100 नमूने प्राप्त हुए, जो डेटा विज्ञान समुदाय में एलएलएम को बेहतर बनाने के लिए अनुशंसित 1,000 नमूनों से बहुत कम है।

एक अतिरिक्त अंतर्निहित चुनौती के रूप में, प्राकृतिक भाषा प्रसंस्करण (एनएलपी) क्लासिफायर को ऐतिहासिक रूप से प्रशिक्षित करना बहुत महंगा माना जाता है और इसके लिए शब्दावली के एक बड़े सेट की आवश्यकता होती है, जिसे ए के रूप में जाना जाता है। देह, सटीक भविष्यवाणियां करने के लिए। एक कठोर और प्रभावी एनएलपी समाधान, यदि पर्याप्त मात्रा में लेबल किया गया डेटा प्रदान किया जाता है, तो ग्राहक के लेबल किए गए डेटा का उपयोग करके एक कस्टम भाषा मॉडल को प्रशिक्षित करना होगा। मॉडल को पूरी तरह से खिलाड़ियों की खेल शब्दावली के साथ प्रशिक्षित किया जाएगा, जिससे इसे खेलों में देखी जाने वाली भाषा के अनुरूप बनाया जाएगा। ग्राहक के पास लागत और समय दोनों की कमी थी जिसने इस समाधान को अव्यवहार्य बना दिया। AWS ProServe को अपेक्षाकृत छोटे लेबल वाले डेटासेट के साथ एक सटीक भाषा विषाक्तता क्लासिफायरियर को प्रशिक्षित करने के लिए एक समाधान खोजने के लिए मजबूर होना पड़ा। समाधान उसी में निहित है जिसे इस नाम से जाना जाता है सीखने का स्थानांतरण.

ट्रांसफर लर्निंग के पीछे का विचार पूर्व-प्रशिक्षित मॉडल के ज्ञान का उपयोग करना और इसे एक अलग लेकिन अपेक्षाकृत समान समस्या पर लागू करना है। उदाहरण के लिए, यदि एक छवि वर्गीकरणकर्ता को यह अनुमान लगाने के लिए प्रशिक्षित किया गया था कि क्या किसी छवि में एक बिल्ली है, तो आप उस ज्ञान का उपयोग कर सकते हैं जो मॉडल ने बाघ जैसे अन्य जानवरों को पहचानने के लिए प्रशिक्षण के दौरान प्राप्त किया था। इस भाषा उपयोग के मामले के लिए, AWS प्रोसर्व को पहले से प्रशिक्षित भाषा क्लासिफायरियर खोजने की आवश्यकता थी जिसे ग्राहक के लेबल किए गए डेटा का उपयोग करके विषाक्त भाषा का पता लगाने और इसे ठीक करने के लिए प्रशिक्षित किया गया था।

समाधान विषाक्त भाषा को वर्गीकृत करने के लिए एलएलएम को ढूंढना और उसे बेहतर बनाना था। एलएलएम तंत्रिका नेटवर्क हैं जिन्हें बिना लेबल वाले डेटा का उपयोग करके, आमतौर पर अरबों के क्रम में, बड़ी संख्या में मापदंडों का उपयोग करके प्रशिक्षित किया गया है। एडब्ल्यूएस समाधान में जाने से पहले, निम्नलिखित अनुभाग एलएलएम के इतिहास और उनके ऐतिहासिक उपयोग के मामलों का एक सिंहावलोकन प्रदान करता है।

एलएलएम की शक्ति का दोहन

एलएलएम हाल ही में एमएल के नए अनुप्रयोगों की तलाश कर रहे व्यवसायों के लिए केंद्र बिंदु बन गया है, जब से चैटजीपीटी ने इतिहास में सबसे तेजी से बढ़ते उपभोक्ता एप्लिकेशन के रूप में सार्वजनिक दिमाग पर कब्जा कर लिया है।2, रिलीज़ होने के केवल 100 महीने बाद, जनवरी 2023 तक 2 मिलियन सक्रिय उपयोगकर्ताओं तक पहुँचना। हालाँकि, एमएल क्षेत्र में एलएलएम कोई नई तकनीक नहीं है। इनका उपयोग एनएलपी कार्यों को करने के लिए बड़े पैमाने पर किया गया है जैसे भावनाओं का विश्लेषण करना, कॉर्पस को सारांशित करना, कीवर्ड निकालना, भाषण का अनुवाद करना और पाठ को वर्गीकृत करना।

पाठ की अनुक्रमिक प्रकृति के कारण, एनएलपी मॉडलिंग के लिए आवर्तक तंत्रिका नेटवर्क (आरएनएन) अत्याधुनिक रहा है। विशेष रूप से, एनकोडर-विकोडक नेटवर्क आर्किटेक्चर तैयार किया गया था क्योंकि इसने एक आरएनएन संरचना बनाई थी जो मनमानी लंबाई का इनपुट लेने और मनमानी लंबाई का आउटपुट उत्पन्न करने में सक्षम थी। यह अनुवाद जैसे एनएलपी कार्यों के लिए आदर्श था जहां एक भाषा के आउटपुट वाक्यांश का अनुमान दूसरी भाषा के इनपुट वाक्यांश से लगाया जा सकता था, आमतौर पर इनपुट और आउटपुट के बीच शब्दों की अलग-अलग संख्या के साथ। ट्रांसफार्मर वास्तुकला3 (वासवानी, 2017) एनकोडर-डिकोडर पर एक महत्वपूर्ण सुधार था; इसने की अवधारणा पेश की आत्म-ध्यान, जिसने मॉडल को इनपुट और आउटपुट वाक्यांशों पर विभिन्न शब्दों पर अपना ध्यान केंद्रित करने की अनुमति दी। एक विशिष्ट एनकोडर-डिकोडर में, प्रत्येक शब्द की व्याख्या मॉडल द्वारा समान तरीके से की जाती है। चूंकि मॉडल इनपुट वाक्यांश में प्रत्येक शब्द को क्रमिक रूप से संसाधित करता है, शुरुआत में अर्थ संबंधी जानकारी वाक्यांश के अंत तक खो सकती है। आत्म-ध्यान तंत्र ने एनकोडर और डिकोडर ब्लॉक दोनों में एक ध्यान परत जोड़कर इसे बदल दिया, ताकि आउटपुट वाक्यांश में एक निश्चित शब्द उत्पन्न करते समय मॉडल इनपुट वाक्यांश से कुछ शब्दों पर अलग-अलग भार डाल सके। इस प्रकार ट्रांसफार्मर मॉडल का आधार पैदा हुआ।

ट्रांसफॉर्मर आर्किटेक्चर आज उपयोग में आने वाले दो सबसे प्रसिद्ध और लोकप्रिय एलएलएम, ट्रांसफॉर्मर्स से द्विदिश एनकोडर रिप्रेजेंटेशन (बीईआरटी) की नींव थी।4 (रेडफोर्ड, 2018) और जेनरेटिव प्रीट्रेन्ड ट्रांसफार्मर (जीपीटी)5 (डेवलिन 2018)। GPT मॉडल के बाद के संस्करण, अर्थात् GPT3 और GPT4, वह इंजन हैं जो ChatGPT एप्लिकेशन को शक्ति प्रदान करते हैं। नुस्खा का अंतिम भाग जो एलएलएम को इतना शक्तिशाली बनाता है, वह ULMFiT नामक प्रक्रिया के माध्यम से व्यापक लेबलिंग या प्रीप्रोसेसिंग के बिना विशाल टेक्स्ट कॉर्पस से जानकारी को डिस्टिल करने की क्षमता है। इस पद्धति में एक पूर्व-प्रशिक्षण चरण होता है जहां सामान्य पाठ एकत्र किया जा सकता है और मॉडल को पिछले शब्दों के आधार पर अगले शब्द की भविष्यवाणी करने के कार्य पर प्रशिक्षित किया जाता है; यहां लाभ यह है कि प्रशिक्षण के लिए उपयोग किया जाने वाला कोई भी इनपुट पाठ पाठ के क्रम के आधार पर स्वाभाविक रूप से पूर्व-लेबल किया जाता है। एलएलएम वास्तव में इंटरनेट-स्केल डेटा से सीखने में सक्षम हैं। उदाहरण के लिए, मूल BERT मॉडल को बुककॉर्पस और संपूर्ण अंग्रेजी विकिपीडिया पाठ डेटासेट पर पूर्व-प्रशिक्षित किया गया था।

इस नए मॉडलिंग प्रतिमान ने दो नई अवधारणाओं को जन्म दिया है: फाउंडेशन मॉडल (एफएम) और जेनरेटिव एआई। कार्य-विशिष्ट डेटा के साथ एक मॉडल को शुरू से प्रशिक्षित करने के विपरीत, जो कि शास्त्रीय पर्यवेक्षित शिक्षण के लिए सामान्य मामला है, एलएलएम को विशिष्ट कार्यों या बहुत छोटे डोमेन के साथ अनुकूलित होने से पहले एक व्यापक पाठ डेटासेट से सामान्य ज्ञान निकालने के लिए पूर्व-प्रशिक्षित किया जाता है। डेटासेट (आमतौर पर सैकड़ों नमूनों के क्रम पर)। नया एमएल वर्कफ़्लो अब एक पूर्व-प्रशिक्षित मॉडल के साथ शुरू होता है जिसे फाउंडेशन मॉडल कहा जाता है। सही नींव पर निर्माण करना महत्वपूर्ण है, और नए जैसे विकल्पों की संख्या बढ़ती जा रही है अमेज़ॅन टाइटन एफएम, के भाग के रूप में AWS द्वारा जारी किया जाएगा अमेज़ॅन बेडरॉक. इन नए मॉडलों को जेनरेटिव भी माना जाता है क्योंकि उनके आउटपुट मानव व्याख्या योग्य होते हैं और इनपुट डेटा के समान डेटा प्रकार में होते हैं। जबकि पिछले एमएल मॉडल वर्णनात्मक थे, जैसे बिल्लियों बनाम कुत्तों की छवियों को वर्गीकृत करना, एलएलएम जेनरेटिव हैं क्योंकि उनका आउटपुट इनपुट शब्दों के आधार पर शब्दों का अगला सेट है। यह उन्हें चैटजीपीटी जैसे इंटरैक्टिव अनुप्रयोगों को सशक्त बनाने की अनुमति देता है जो उनके द्वारा उत्पन्न सामग्री में अभिव्यंजक हो सकते हैं।

हगिंग फेस ने AWS के साथ साझेदारी की है एफएम को लोकतांत्रिक बनाना और उन तक पहुंच और निर्माण को आसान बनाना। हगिंग फेस ने एक बनाया है ट्रांसफॉर्मर एपीआई जो विभिन्न एमएल फ्रेमवर्क पर 50 से अधिक विभिन्न ट्रांसफार्मर आर्किटेक्चर को एकीकृत करता है, जिसमें उनके पूर्व-प्रशिक्षित मॉडल वजन तक पहुंच भी शामिल है मॉडल हब, जो इस पोस्ट को लिखने तक 200,000 से अधिक मॉडल हो गए हैं। अगले अनुभागों में, हम अवधारणा के प्रमाण, समाधान और एफएम का पता लगाते हैं जिनका परीक्षण किया गया और ग्राहक के लिए इस विषाक्त भाषण वर्गीकरण उपयोग मामले को हल करने के आधार के रूप में चुना गया।

AWS GAIIC अवधारणा का प्रमाण

AWS GAIIC ने टॉक्सिक लैंग्वेज क्लासिफायर को बेहतर बनाने के लिए BERT आर्किटेक्चर के साथ LLM फाउंडेशन मॉडल के साथ प्रयोग करना चुना। हगिंग फेस के मॉडल हब से कुल तीन मॉडलों का परीक्षण किया गया:

सभी तीन मॉडल आर्किटेक्चर पर आधारित हैं बर्टट्वीट वास्तुकला। BERTweet को इसके आधार पर प्रशिक्षित किया जाता है RoberTa पूर्व प्रशिक्षण प्रक्रिया. RoBERTa पूर्व-प्रशिक्षण प्रक्रिया BERT पूर्व-प्रशिक्षण के एक प्रतिकृति अध्ययन का परिणाम है जिसने BERT मॉडल के प्रशिक्षण के लिए नुस्खा में सुधार करने के लिए हाइपरपैरामीटर ट्यूनिंग और प्रशिक्षण सेट आकार के प्रभावों का मूल्यांकन किया।6 (लियू 2019)। प्रयोग में एक पूर्व-प्रशिक्षण विधि खोजने की कोशिश की गई जिसने अंतर्निहित वास्तुकला को बदले बिना BERT के प्रदर्शन परिणामों में सुधार किया। अध्ययन के निष्कर्ष में पाया गया कि निम्नलिखित पूर्व-प्रशिक्षण संशोधनों से BERT के प्रदर्शन में काफी सुधार हुआ:

- अधिक डेटा पर बड़े बैचों के साथ मॉडल को प्रशिक्षित करना

- अगले वाक्य का पूर्वानुमान उद्देश्य हटाया जा रहा है

- लंबे अनुक्रमों पर प्रशिक्षण

- प्रशिक्षण डेटा पर लागू मास्किंग पैटर्न को गतिशील रूप से बदलना

बर्टवेट-बेस मॉडल 850 मिलियन अंग्रेजी ट्वीट्स का उपयोग करके मूल BERT वास्तुकला को पूर्व-प्रशिक्षित करने के लिए RoBERTa अध्ययन से पूर्ववर्ती पूर्व-प्रशिक्षण प्रक्रिया का उपयोग करता है। यह अंग्रेजी ट्वीट्स के लिए पूर्व-प्रशिक्षित पहला सार्वजनिक बड़े पैमाने का भाषा मॉडल है।

ट्वीट्स का उपयोग करने वाले पूर्व-प्रशिक्षित एफएम को दो मुख्य सैद्धांतिक कारणों से उपयोग के मामले में फिट माना जाता था:

- एक ट्वीट की लंबाई ऑनलाइन गेम चैट में पाए जाने वाले अनुचित या जहरीले वाक्यांश की लंबाई के समान होती है

- ट्वीट विभिन्न प्रकार के विभिन्न उपयोगकर्ताओं वाली आबादी से आते हैं, जो गेमिंग प्लेटफ़ॉर्म में पाई जाने वाली आबादी के समान है

AWS ने बेसलाइन प्राप्त करने के लिए पहले ग्राहक के लेबल किए गए डेटा के साथ BERTweet को बेहतर बनाने का निर्णय लिया। फिर दो अन्य एफएम को बर्टवेट-बेस-ऑफेंसिव और बर्टवेट-बेस-हेट में फाइन-ट्यून करने के लिए चुना गया, जिन्हें संभावित रूप से उच्च सटीकता प्राप्त करने के लिए अधिक प्रासंगिक विषाक्त ट्वीट्स पर विशेष रूप से पूर्व-प्रशिक्षित किया गया था। बर्टट्वीट-बेस-आक्रामक मॉडल बेस बर्टट्वीट एफएम का उपयोग करता है और इसे 14,100 एनोटेटेड ट्वीट्स पर पूर्व-प्रशिक्षित किया गया है जिन्हें आक्रामक माना गया था।7 (जम्पिएरी 2019)। बर्टट्वीट-बेस-हेट मॉडल भी बेस बर्टट्वीट एफएम का उपयोग करता है, लेकिन 19,600 ट्वीट्स पर पूर्व-प्रशिक्षित किया गया है जिन्हें घृणास्पद भाषण माना गया था।8 (बेसिल 2019)।

PoC मॉडल के प्रदर्शन को और बेहतर बनाने के लिए, AWS GAIIC ने दो डिज़ाइन निर्णय लिए:

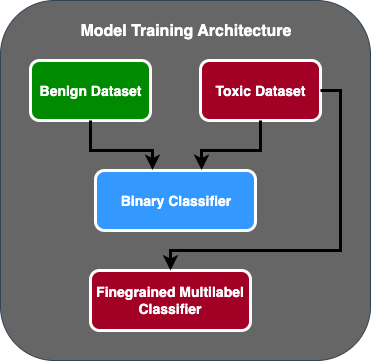

- दो-चरणीय भविष्यवाणी प्रवाह बनाया गया जहां पहला मॉडल एक बाइनरी क्लासिफायरियर के रूप में कार्य करता है जो वर्गीकृत करता है कि पाठ का एक टुकड़ा विषाक्त है या विषाक्त नहीं है। दूसरा मॉडल एक सुक्ष्म मॉडल है जो ग्राहक के परिभाषित विषाक्त प्रकारों के आधार पर पाठ को वर्गीकृत करता है। केवल अगर पहला मॉडल पाठ को विषाक्त होने की भविष्यवाणी करता है, तो यह दूसरे मॉडल में पारित हो जाता है।

- प्रशिक्षण डेटा को संवर्धित किया और सार्वजनिक कागल प्रतियोगिता से तीसरे पक्ष-लेबल वाले विषाक्त पाठ डेटासेट का एक सबसेट जोड़ा (आरा विषाक्तता) ग्राहक से प्राप्त मूल 100 नमूनों के लिए। उन्होंने जिग्सॉ लेबल को संबंधित ग्राहक-परिभाषित विषाक्तता लेबल पर मैप किया और मॉडल को मान्य करने के लिए प्रशिक्षण डेटा के रूप में 80% विभाजन और परीक्षण डेटा के रूप में 20% विभाजन किया।

AWS GAIIC का उपयोग किया गया अमेज़न SageMaker नोटबुक्स ने अपने फाइन-ट्यूनिंग प्रयोगों को चलाने के लिए और पाया कि बर्टवेट-बेस-आक्रामक मॉडल ने सत्यापन सेट पर सर्वोत्तम स्कोर हासिल किया। निम्नलिखित तालिका देखे गए मीट्रिक स्कोर का सारांश प्रस्तुत करती है।

| आदर्श | शुद्धता | वापस बुलाना | F1 | एयूसी |

| द्विचर | 92. | 90. | 91. | 92. |

| सुक्ष्म | 81. | 80. | 81. | 89. |

इस बिंदु से, GAIIC ने PoC का उत्पादन करने के लिए AWS प्रोसर्व एमएल डिलीवरी टीम को PoC सौंप दिया।

एडब्ल्यूएस प्रोसर्व एमएल डिलीवरी टीम समाधान

मॉडल आर्किटेक्चर का उत्पादन करने के लिए, AWS प्रोसर्व एमएल डिलीवरी टीम (MLDT) को ग्राहक द्वारा एक ऐसा समाधान बनाने के लिए कहा गया था जो स्केलेबल हो और बनाए रखने में आसान हो। दो-चरण मॉडल दृष्टिकोण की कुछ रखरखाव चुनौतियाँ थीं:

- मॉडलों को दोगुनी मात्रा में मॉडल निगरानी की आवश्यकता होगी, जो पुनर्प्रशिक्षण समय को असंगत बनाता है। कई बार ऐसा हो सकता है कि एक मॉडल को दूसरे की तुलना में अधिक बार पुनः प्रशिक्षित करना पड़े।

- एक के बजाय दो मॉडल चलाने की लागत में वृद्धि।

- अनुमान की गति धीमी हो जाती है क्योंकि अनुमान दो मॉडलों से होकर गुजरता है।

इन चुनौतियों का समाधान करने के लिए, AWS प्रोसर्व एमएलडीटी को यह पता लगाना था कि दो-चरण मॉडल आर्किटेक्चर को एकल मॉडल आर्किटेक्चर में कैसे बदला जाए, जबकि अभी भी दो-चरण आर्किटेक्चर की सटीकता को बनाए रखने में सक्षम किया जा सके।

समाधान यह था कि पहले ग्राहक से अधिक प्रशिक्षण डेटा मांगा जाए, फिर गैर विषैले नमूनों सहित सभी लेबलों पर बर्टवेट-बेस-आक्रामक मॉडल को एक मॉडल में ठीक किया जाए। विचार यह था कि अधिक डेटा के साथ एक मॉडल को फाइन-ट्यूनिंग करने से कम डेटा पर दो-चरण मॉडल आर्किटेक्चर को फाइन-ट्यून करने के समान परिणाम मिलेंगे। दो-चरण मॉडल आर्किटेक्चर को ठीक करने के लिए, एडब्ल्यूएस प्रोसर्व एमएलडीटी ने गैर-विषैले वर्ग का प्रतिनिधित्व करने के लिए एक अतिरिक्त नोड को शामिल करने के लिए पूर्व-प्रशिक्षित मॉडल मल्टी-लेबल वर्गीकरण हेड को अपडेट किया।

निम्नलिखित एक कोड नमूना है कि आप हगिंग फेस मॉडल हब से उनके ट्रांसफार्मर प्लेटफ़ॉर्म का उपयोग करके पूर्व-प्रशिक्षित मॉडल को कैसे ठीक करेंगे और कक्षाओं की वांछित संख्या की भविष्यवाणी करने के लिए मॉडल के मल्टी-लेबल वर्गीकरण हेड को बदल देंगे। AWS ProServe MLDT ने फाइन-ट्यूनिंग के लिए इस ब्लूप्रिंट को अपने आधार के रूप में उपयोग किया। यह मानता है कि आपका ट्रेन डेटा और सत्यापन डेटा तैयार है और सही इनपुट प्रारूप में है।

सबसे पहले, पायथन मॉड्यूल के साथ-साथ हगिंग फेस मॉडल हब से वांछित पूर्व-प्रशिक्षित मॉडल भी आयात किया जाता है:

फिर पूर्व-प्रशिक्षित मॉडल को लोड किया जाता है और फाइन-ट्यूनिंग के लिए तैयार किया जाता है। यह वह चरण है जहां विषाक्त श्रेणियों की संख्या और सभी मॉडल पैरामीटर परिभाषित होते हैं:

मॉडल फ़ाइन-ट्यूनिंग प्रशिक्षण और सत्यापन डेटासेट में इनपुट पथ के साथ शुरू होती है:

AWS ProServe MLDT को लगभग 5,000 अधिक लेबल वाले डेटा नमूने प्राप्त हुए, जिनमें से 3,000 गैर विषैले थे और 2,000 विषैले थे, और सभी तीन बर्टवेट-बेस मॉडल को ठीक किया, सभी लेबलों को एक मॉडल में संयोजित किया। उन्होंने उसी 5,000% ट्रेन सेट, 80% परीक्षण सेट विधि का उपयोग करके नए वन-स्टेज मॉडल को ठीक करने के लिए पीओसी से 20 नमूनों के अलावा इस डेटा का उपयोग किया। निम्न तालिका से पता चलता है कि प्रदर्शन स्कोर दो-चरण मॉडल के बराबर थे।

| आदर्श | शुद्धता | वापस बुलाना | F1 | एयूसी |

| बर्टवेट-बेस (1-स्टेज) | 76. | 72. | 74. | 83. |

| बर्टवेट-बेस-नफरत (1-चरण) | 85. | 82. | 84. | 87. |

| बर्टवेट-बेस-आक्रामक (1-चरण) | 88. | 83. | 86. | 89. |

| बर्टवेट-बेस-आक्रामक (2-चरण) | 91. | 90. | 90. | 92. |

एक-चरण मॉडल दृष्टिकोण ने लागत और रखरखाव में सुधार प्रदान किया जबकि सटीकता में केवल 3% की कमी आई। ट्रेड-ऑफ़ का वजन करने के बाद, ग्राहक ने वन-स्टेज मॉडल का उत्पादन करने के लिए AWS प्रोसर्व एमएलडीटी को चुना।

अधिक लेबल वाले डेटा के साथ एक मॉडल को फाइन-ट्यून करके, AWS प्रोसर्व एमएलडीटी एक ऐसा समाधान देने में सक्षम था जो मॉडल सटीकता के लिए ग्राहक की सीमा को पूरा करता था, साथ ही लागत कम करने और मजबूती बढ़ाने के साथ-साथ रखरखाव में आसानी के लिए उनके अनुरोध को पूरा करता था।

निष्कर्ष

एक बड़ा गेमिंग ग्राहक सामाजिक रूप से जिम्मेदार गेमिंग वातावरण को बढ़ावा देने के लिए अपने संचार चैनलों के भीतर जहरीली भाषा का पता लगाने का तरीका ढूंढ रहा था। AWS GAIIC ने विषाक्त भाषा का पता लगाने के लिए LLM को ठीक करके एक विषाक्त भाषा डिटेक्टर का PoC बनाया। एडब्ल्यूएस प्रोसर्व एमएलडीटी ने फिर मॉडल प्रशिक्षण प्रवाह को दो-चरण दृष्टिकोण से एक-चरण दृष्टिकोण में अद्यतन किया और ग्राहक के लिए बड़े पैमाने पर उपयोग करने के लिए एलएलएम का उत्पादन किया।

इस पोस्ट में, एडब्ल्यूएस इस ग्राहक उपयोग के मामले को हल करने के लिए एलएलएम को ठीक करने की प्रभावशीलता और व्यावहारिकता को प्रदर्शित करता है, फाउंडेशन मॉडल और एलएलएम के इतिहास पर संदर्भ साझा करता है, और एडब्ल्यूएस जेनरेटिव एआई इनोवेशन सेंटर और एडब्ल्यूएस प्रोसर्व एमएल के बीच वर्कफ़्लो का परिचय देता है। डिलिवरी टीम. इस श्रृंखला की अगली पोस्ट में, हम गहराई से जानेंगे कि कैसे AWS प्रोसर्व एमएलडीटी ने सेजमेकर का उपयोग करके परिणामी वन-स्टेज मॉडल का उत्पादन किया।

यदि आप जेनरेटिव एआई समाधान बनाने के लिए एडब्ल्यूएस के साथ काम करने में रुचि रखते हैं, तो कृपया संपर्क करें GAIIC. वे आपके उपयोग के मामले का आकलन करेंगे, एक जेनरेटिव-एआई-आधारित अवधारणा का प्रमाण तैयार करेंगे, और परिणामी पीओसी को उत्पादन में लागू करने के लिए एडब्ल्यूएस के साथ सहयोग बढ़ाने के विकल्प होंगे।

संदर्भ

- गेमर जनसांख्यिकी: दुनिया में सबसे लोकप्रिय शौक के बारे में तथ्य और आँकड़े

- चैटजीपीटी ने सबसे तेजी से बढ़ते उपयोगकर्ता आधार के लिए रिकॉर्ड बनाया - विश्लेषक नोट

- वासवानी एट अल., "आपको केवल ध्यान देने की आवश्यकता है"

- रैडफोर्ड एट अल., "जनरेटिव प्री-ट्रेनिंग द्वारा भाषा की समझ में सुधार"

- डेवलिन एट अल., "बीईआरटी: भाषा समझ के लिए गहरे द्विदिश ट्रांसफार्मर का पूर्व-प्रशिक्षण"

- यिनहान लियू एट अल।, "रॉबर्टा: एक मजबूत रूप से अनुकूलित बीईआरटी प्रीट्रेनिंग दृष्टिकोण"

- मार्कोस ज़म्पिएरी एट अल।, "सेमइवल-2019 टास्क 6: सोशल मीडिया में आपत्तिजनक भाषा की पहचान और वर्गीकरण (ऑफेंसइवल)"

- वेलेरियो बेसिल एट अल।, "सेमइवल-2019 टास्क 5: ट्विटर में अप्रवासियों और महिलाओं के खिलाफ नफरत भरे भाषण का बहुभाषी पता लगाना"

लेखक के बारे में

जेम्स पॉक्विज़ ऑरेंज काउंटी, कैलिफ़ोर्निया में स्थित AWS प्रोफेशनल सर्विसेज के साथ एक डेटा साइंटिस्ट है। उनके पास कैलिफोर्निया विश्वविद्यालय, इरविन से कंप्यूटर साइंस में बीएस है और उनके पास डेटा डोमेन में काम करने का कई वर्षों का अनुभव है और उन्होंने कई अलग-अलग भूमिकाएँ निभाई हैं। आज वह एडब्ल्यूएस ग्राहकों के लिए व्यावसायिक परिणाम प्राप्त करने के लिए स्केलेबल एमएल समाधानों को लागू करने और तैनात करने पर काम करता है।

जेम्स पॉक्विज़ ऑरेंज काउंटी, कैलिफ़ोर्निया में स्थित AWS प्रोफेशनल सर्विसेज के साथ एक डेटा साइंटिस्ट है। उनके पास कैलिफोर्निया विश्वविद्यालय, इरविन से कंप्यूटर साइंस में बीएस है और उनके पास डेटा डोमेन में काम करने का कई वर्षों का अनुभव है और उन्होंने कई अलग-अलग भूमिकाएँ निभाई हैं। आज वह एडब्ल्यूएस ग्राहकों के लिए व्यावसायिक परिणाम प्राप्त करने के लिए स्केलेबल एमएल समाधानों को लागू करने और तैनात करने पर काम करता है।

हान यार सैन डिएगो, सीए स्थित AWS प्रोफेशनल सर्विसेज में एक वरिष्ठ डेटा साइंस और मशीन लर्निंग मैनेजर हैं। उन्होंने नॉर्थवेस्टर्न यूनिवर्सिटी से इंजीनियरिंग में पीएचडी की है और विनिर्माण, वित्तीय सेवाओं और ऊर्जा में ग्राहकों को सलाह देने वाले प्रबंधन सलाहकार के रूप में उनके पास कई वर्षों का अनुभव है। आज, वह AWS पर ML और GenAI समाधान विकसित करने और लागू करने के लिए विभिन्न उद्योग क्षेत्रों के प्रमुख ग्राहकों के साथ लगन से काम कर रहे हैं।

हान यार सैन डिएगो, सीए स्थित AWS प्रोफेशनल सर्विसेज में एक वरिष्ठ डेटा साइंस और मशीन लर्निंग मैनेजर हैं। उन्होंने नॉर्थवेस्टर्न यूनिवर्सिटी से इंजीनियरिंग में पीएचडी की है और विनिर्माण, वित्तीय सेवाओं और ऊर्जा में ग्राहकों को सलाह देने वाले प्रबंधन सलाहकार के रूप में उनके पास कई वर्षों का अनुभव है। आज, वह AWS पर ML और GenAI समाधान विकसित करने और लागू करने के लिए विभिन्न उद्योग क्षेत्रों के प्रमुख ग्राहकों के साथ लगन से काम कर रहे हैं।

सफ़ा तिनज़तेपे AWS प्रोफेशनल सर्विसेज के साथ एक पूर्ण-स्टैक डेटा वैज्ञानिक है। उन्होंने एमोरी यूनिवर्सिटी से कंप्यूटर विज्ञान में बीएस किया है और एमएलओपीएस, वितरित सिस्टम और वेब3 में उनकी रुचि है।

सफ़ा तिनज़तेपे AWS प्रोफेशनल सर्विसेज के साथ एक पूर्ण-स्टैक डेटा वैज्ञानिक है। उन्होंने एमोरी यूनिवर्सिटी से कंप्यूटर विज्ञान में बीएस किया है और एमएलओपीएस, वितरित सिस्टम और वेब3 में उनकी रुचि है।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. ऑटोमोटिव/ईवीएस, कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- BlockOffsets. पर्यावरणीय ऑफसेट स्वामित्व का आधुनिकीकरण। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :हैस

- :है

- :नहीं

- :कहाँ

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- क्षमता

- योग्य

- About

- पहुँच

- शुद्धता

- सही

- पाना

- हासिल

- सक्रिय

- कार्य करता है

- जोड़ा

- जोड़ने

- इसके अलावा

- पता

- सलाह दे

- बाद

- के खिलाफ

- AI

- AL

- सब

- की अनुमति दी

- की अनुमति देता है

- भी

- वीरांगना

- अमेज़ॅन वेब सेवा

- राशि

- राशियाँ

- an

- विश्लेषक

- का विश्लेषण

- और

- जानवरों

- अन्य

- कोई

- आवेदन

- अनुप्रयोगों

- लागू

- लागू करें

- दृष्टिकोण

- उचित रूप से

- लगभग

- स्थापत्य

- हैं

- तर्क

- कला

- AS

- आकलन

- जुड़े

- मान लिया गया है

- At

- ध्यान

- स्वचालित

- एडब्ल्यूएस

- AWS व्यावसायिक सेवाएँ

- आधार

- आधारित

- आधारभूत

- आधार

- BE

- क्योंकि

- बन

- किया गया

- से पहले

- शुरू

- पीछे

- जा रहा है

- नीचे

- लाभ

- BEST

- के बीच

- बड़ा

- बिलियन

- अरबों

- खंड

- जन्म

- के छात्रों

- सफलता

- विस्तृत

- निर्माण

- बनाता है

- व्यापार

- व्यवसायों

- लेकिन

- by

- CA

- कैलिफ़ोर्निया

- बुलाया

- कर सकते हैं

- सक्षम

- पर कब्जा कर लिया

- मामला

- मामलों

- कैट

- श्रेणियाँ

- वर्गीकरण

- वर्ग

- बिल्ली की

- केंद्र

- कुछ

- चुनौती

- चुनौतियों

- बदल

- बदलना

- चैनलों

- ChatGPT

- चुना

- करने के लिए चुना

- कक्षा

- कक्षाएं

- वर्गीकरण

- वर्गीकृत

- ग्राहकों

- कोड

- सहयोग

- संयोजन

- कैसे

- आता है

- संवाद

- संचार

- समुदाय

- कंपनी

- तुलनीय

- प्रतियोगिता

- कंप्यूटर

- कम्प्यूटर साइंस

- संकल्पना

- अवधारणाओं

- निष्कर्ष

- माना

- होते हैं

- की कमी

- सलाहकार

- उपभोक्ता

- शामिल हैं

- सामग्री

- प्रसंग

- सही

- लागत

- महंगा

- लागत

- सका

- काउंटी

- कवर

- बनाना

- बनाया

- रिवाज

- ग्राहक

- ग्राहक

- तिथि

- डेटा विज्ञान

- आँकड़े वाला वैज्ञानिक

- डेटासेट

- दिन

- का फैसला किया

- निर्णय

- समझा

- गहरा

- विस्तृत विश्लेषण

- और गहरा

- परिभाषित

- परिभाषित

- उद्धार

- दिया गया

- प्रसव

- गड्ढा

- प्रजातंत्रीय बनाना

- जनसांख्यिकी

- दर्शाता

- तैनाती

- तैनाती

- डिज़ाइन

- वांछित

- पता लगाना

- खोज

- निर्धारित करना

- विकसित करना

- विकास

- डीआईडी

- डिएगो

- विभिन्न

- भिन्न

- वितरित

- वितरित प्रणाली

- कर देता है

- डोमेन

- डोमेन

- डबल

- करार दिया

- दौरान

- ई एंड टी

- से प्रत्येक

- आराम

- आसान

- प्रभावी

- प्रभावशीलता

- प्रभाव

- प्रयास

- समाप्त

- ऊर्जा

- इंजन

- अभियांत्रिकी

- अंग्रेज़ी

- बढ़ाना

- पर्याप्त

- दर्ज

- संपूर्ण

- वातावरण

- युग

- अनुमानित

- मूल्यांकित

- कभी

- प्रत्येक

- उदाहरण

- मौजूदा

- अनुभव

- प्रयोग

- प्रयोगों

- विशेषज्ञों

- समझाना

- समझा

- का पता लगाने

- अर्थपूर्ण

- विस्तार

- व्यापक

- बड़े पैमाने पर

- अतिरिक्त

- उद्धरण

- चेहरा

- का सामना करना पड़ा

- तथ्यों

- फैशन

- सबसे तेजी से

- सबसे तेजी से बढ़ रही है

- कुछ

- आकृति

- अंतिम

- वित्तीय

- वित्तीय सेवाओं

- खोज

- प्रथम

- फिट

- प्रवाह

- फोकस

- निम्नलिखित

- के लिए

- प्रारूप

- पाया

- बुनियाद

- चौखटे

- से

- आगे

- प्राप्त की

- खेल

- Games

- जुआ

- गेमिंग उद्योग

- इकट्ठा

- सामान्य जानकारी

- उत्पन्न

- सृजन

- उत्पादक

- जनरेटिव एआई

- मिल

- दी

- चला जाता है

- जा

- समूह

- बढ़ रहा है

- वयस्क

- था

- है

- होने

- he

- सिर

- स्वस्थ

- यहाँ उत्पन्न करें

- उच्चतर

- ऐतिहासिक

- ऐतिहासिक दृष्टि से

- इतिहास

- कैसे

- How To

- तथापि

- HTTPS

- हब

- मानव

- सैकड़ों

- हाइपरपरमेटर ट्यूनिंग

- विचार

- आदर्श

- समान

- पहचान

- if

- की छवि

- छवियों

- आप्रवासियों

- लागू करने के

- कार्यान्वयन

- आयात

- महत्वपूर्ण

- आयात

- में सुधार

- उन्नत

- सुधार

- सुधार

- in

- शामिल

- सहित

- बढ़ती

- उद्योग

- करें-

- निहित

- स्वाभाविक

- नवोन्मेष

- निवेश

- घालमेल

- बातचीत

- बातचीत

- इंटरैक्टिव

- रुचि

- रुचियों

- में

- शुरू की

- द्वारा प्रस्तुत

- IT

- आईटी इस

- जनवरी

- आरा

- संयुक्त

- केवल

- कुंजी

- खोजशब्दों

- ज्ञान

- जानने वाला

- लेबलिंग

- लेबल

- भाषा

- बड़ा

- बड़े पैमाने पर

- बाद में

- रखना

- परत

- सीख रहा हूँ

- लंबाई

- कम

- पसंद

- एलएलएम

- भार

- लंबे समय तक

- देख

- खोया

- लॉट

- कम

- मशीन

- यंत्र अधिगम

- बनाया गया

- मुख्य

- बनाए रखना

- रखरखाव

- बनाना

- बनाता है

- निर्माण

- आदमी

- प्रबंध

- प्रबंधक

- गाइड

- विनिर्माण

- बहुत

- विशाल

- मई..

- तंत्र

- मीडिया

- घास का मैदान

- तरीका

- क्रियाविधि

- मीट्रिक

- दस लाख

- ML

- एमएलओपीएस

- आदर्श

- मोडलिंग

- मॉडल

- संशोधनों

- मॉड्यूल

- निगरानी

- महीने

- अधिक

- अधिकांश

- सबसे लोकप्रिय

- बहुत

- यानी

- प्राकृतिक

- प्राकृतिक भाषा संसाधन

- प्रकृति

- जरूरत

- नेटवर्क

- नेटवर्क

- तंत्रिका जाल

- नया

- अगला

- NLP

- नोड

- अभी

- संख्या

- संख्या

- प्राप्त करने के

- of

- बंद

- अपमानजनक

- अक्सर

- on

- ONE

- ऑनलाइन

- ऑनलाइन गेमिंग

- केवल

- संचालन

- विरोधी

- अनुकूलित

- ऑप्शंस

- or

- नारंगी

- आदेश

- मूल

- अन्य

- आउट

- परिणाम

- परिणामों

- उत्पादन

- के ऊपर

- कुल

- सिंहावलोकन

- अपना

- जोड़े

- मिसाल

- प्राचल

- पैरामीटर

- भाग

- भागीदारी

- पारित कर दिया

- अतीत

- पैटर्न

- पीडीएफ

- उत्तम

- निष्पादन

- प्रदर्शन

- प्रदर्शन

- चरण

- पीएचडी

- मुहावरों

- टुकड़ा

- मंच

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- खेला

- खिलाड़ी

- खिलाड़ियों

- कृप्या अ

- PoC

- बिन्दु

- लोकप्रिय

- आबादी

- पद

- पोस्ट

- संभावित

- बिजली

- शक्तिशाली

- शक्तियां

- शुद्धता

- भविष्यवाणी करना

- भविष्यवाणी

- की भविष्यवाणी

- भविष्यवाणी

- भविष्यवाणियों

- भविष्यवाणी

- पिछला

- पहले से

- मुसीबत

- प्रक्रिया

- प्रक्रिया

- प्रक्रियाओं

- प्रसंस्करण

- उत्पादन

- उत्पादन

- गालियां बकने की क्रिया

- पेशेवर

- को बढ़ावा देना

- को बढ़ावा देना

- प्रमाण

- अवधारणा के सुबूत

- बशर्ते

- प्रदान करता है

- सार्वजनिक

- रखना

- अजगर

- गुणवत्ता

- रेंज

- पहुंच

- तक पहुंच गया

- तैयार

- वास्तविक

- असली दुनिया

- कारण

- प्राप्त

- हाल ही में

- नुस्खा

- पहचान

- की सिफारिश की

- रिकॉर्ड

- अपेक्षाकृत

- और

- रिहा

- प्रासंगिक

- प्रतिकृति

- प्रतिनिधित्व

- की आवश्यकता होती है

- जिम्मेदार

- जिम्मेदार गेमिंग

- परिणाम

- जिसके परिणामस्वरूप

- परिणाम

- रायटर

- सही

- कठिन

- वृद्धि

- मजबूती

- भूमिकाओं

- रन

- दौड़ना

- sagemaker

- वही

- सेन

- सैन डिएगो

- स्केलेबल

- स्केल

- स्केलिंग

- विज्ञान

- वैज्ञानिक

- वैज्ञानिक

- खरोंच

- दूसरा

- अनुभाग

- वर्गों

- वरिष्ठ

- वाक्य

- भावुकता

- अलग

- अनुक्रम

- कई

- कार्य करता है

- सेवाएँ

- सेट

- सेट

- कई

- शेयरों

- प्रदर्शन

- दिखाता है

- समान

- के बाद से

- एक

- आकार

- धीमा कर देती है

- छोटा

- छोटे

- So

- सोशल मीडिया

- सोशल मीडिया

- सामाजिक रूप से

- केवल

- समाधान

- समाधान ढूंढे

- हल

- सुलझाने

- कुछ

- मांगा

- अंतरिक्ष

- विशिष्ट

- विशेष रूप से

- भाषण

- गति

- विभाजित

- शुरू होता है

- राज्य

- आँकड़े

- कदम

- फिर भी

- संरचना

- अध्ययन

- काफी हद तक

- ऐसा

- पर्याप्त

- सिस्टम

- तालिका

- अनुरूप

- लेता है

- ले जा

- कार्य

- कार्य

- टीम

- टेक्नोलॉजी

- परीक्षण

- परीक्षण किया

- से

- कि

- RSI

- राज्य

- लेकिन हाल ही

- उन

- फिर

- सैद्धांतिक

- वहाँ।

- इन

- वे

- इसका

- विचार

- तीन

- द्वार

- यहाँ

- इस प्रकार

- पहर

- बार

- समय

- टाइटन

- सेवा मेरे

- आज

- विषय

- कुल

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- स्थानांतरण

- ट्रांसफार्मर

- ट्रान्सफ़ॉर्मर

- अनुवाद करें

- वास्तव में

- मोड़

- कलरव

- tweets

- दो

- टाइप

- प्रकार

- ठेठ

- आम तौर पर

- अंत में

- आधारभूत

- समझ

- दुर्भाग्य से

- विश्वविद्यालय

- यूनिवर्सिटी ऑफ कैलिफोर्निया

- अद्यतन

- उपयोग

- उदाहरण

- प्रयुक्त

- उपयोगकर्ता

- उपयोगकर्ता अनुभव

- उपयोगकर्ताओं

- का उपयोग करता है

- का उपयोग

- सत्यापित करें

- सत्यापन

- विविधता

- व्यापक

- संस्करणों

- कार्यक्षेत्र

- बहुत

- के माध्यम से

- वीडियो

- वीडियो गेमिंग

- वास्तव में

- आवाज़

- vs

- करना चाहते हैं

- जरूरत है

- था

- मार्ग..

- we

- वेब

- वेब सेवाओं

- Web3

- वजन

- कुंआ

- प्रसिद्ध

- थे

- कब

- या

- कौन कौन से

- जब

- क्यों

- चौड़ा

- विस्तृत श्रृंखला

- विकिपीडिया

- मर्जी

- साथ में

- अंदर

- बिना

- महिलाओं

- शब्द

- शब्द

- वर्कफ़्लो

- काम कर रहे

- कार्य

- विश्व

- होगा

- लिख रहे हैं

- साल

- आप

- आपका

- जेफिरनेट