आज, हमें यह घोषणा करते हुए खुशी हो रही है कि मिक्सट्रल-8x7बी मिस्ट्रल एआई द्वारा विकसित लार्ज लैंग्वेज मॉडल (एलएलएम) ग्राहकों के लिए उपलब्ध है अमेज़न SageMaker जम्पस्टार्ट चालू अनुमान के लिए एक क्लिक से तैनात करना। मिक्सट्रल-8x7बी एलएलएम विशेषज्ञ मॉडल का एक पूर्व-प्रशिक्षित विरल मिश्रण है, जो प्रति फ़ीड-फ़ॉरवर्ड परत में आठ विशेषज्ञों के साथ 7-बिलियन पैरामीटर बैकबोन पर आधारित है। आप इस मॉडल को सेजमेकर जंपस्टार्ट, एक मशीन लर्निंग (एमएल) हब के साथ आज़मा सकते हैं जो एल्गोरिदम और मॉडल तक पहुंच प्रदान करता है ताकि आप जल्दी से एमएल के साथ शुरुआत कर सकें। इस पोस्ट में, हम मिक्सट्रल-8x7B मॉडल को खोजने और तैनात करने के तरीके के बारे में जानेंगे।

मिक्सट्राल-8x7बी क्या है?

मिक्सट्रल-8x7बी मिस्ट्रल एआई द्वारा विकसित एक फाउंडेशन मॉडल है, जो कोड जनरेशन क्षमताओं के साथ अंग्रेजी, फ्रेंच, जर्मन, इतालवी और स्पेनिश पाठ का समर्थन करता है। यह विभिन्न प्रकार के उपयोग के मामलों का समर्थन करता है जैसे कि पाठ सारांश, वर्गीकरण, पाठ पूर्णता और कोड पूर्णता। यह चैट मोड में अच्छा व्यवहार करता है। मॉडल की सीधी अनुकूलन क्षमता को प्रदर्शित करने के लिए, मिस्ट्रल एआई ने चैट उपयोग के मामलों के लिए एक मिक्सट्रल-8x7बी-इंस्ट्रक्शन मॉडल भी जारी किया है, जिसे विभिन्न प्रकार के सार्वजनिक रूप से उपलब्ध वार्तालाप डेटासेट का उपयोग करके ठीक किया गया है। मिक्सट्रल मॉडल की बड़ी संदर्भ लंबाई 32,000 टोकन तक होती है।

मिक्सट्राल-8x7बी पिछले अत्याधुनिक मॉडलों की तुलना में महत्वपूर्ण प्रदर्शन सुधार प्रदान करता है। विशेषज्ञों की वास्तुकला का इसका विरल मिश्रण इसे 9 प्राकृतिक भाषा प्रसंस्करण (एनएलपी) बेंचमार्क में से 12 पर बेहतर प्रदर्शन परिणाम प्राप्त करने में सक्षम बनाता है। मिस्ट्रल एआई. मिक्सट्राल अपने आकार से 10 गुना तक मॉडलों के प्रदर्शन से मेल खाता है या उससे अधिक है। केवल प्रति टोकन मापदंडों के एक अंश का उपयोग करके, यह समतुल्य आकार के घने मॉडल की तुलना में तेज अनुमान गति और कम कम्प्यूटेशनल लागत प्राप्त करता है - उदाहरण के लिए, कुल 46.7 बिलियन पैरामीटर के साथ, लेकिन प्रति टोकन केवल 12.9 बिलियन का उपयोग किया जाता है। उच्च प्रदर्शन, बहुभाषी समर्थन और कम्प्यूटेशनल दक्षता का यह संयोजन मिक्सट्राल-8x7B को एनएलपी अनुप्रयोगों के लिए एक आकर्षक विकल्प बनाता है।

मॉडल को बिना किसी प्रतिबंध के उपयोग के लिए अनुमेय अपाचे 2.0 लाइसेंस के तहत उपलब्ध कराया गया है।

सेजमेकर जम्पस्टार्ट क्या है?

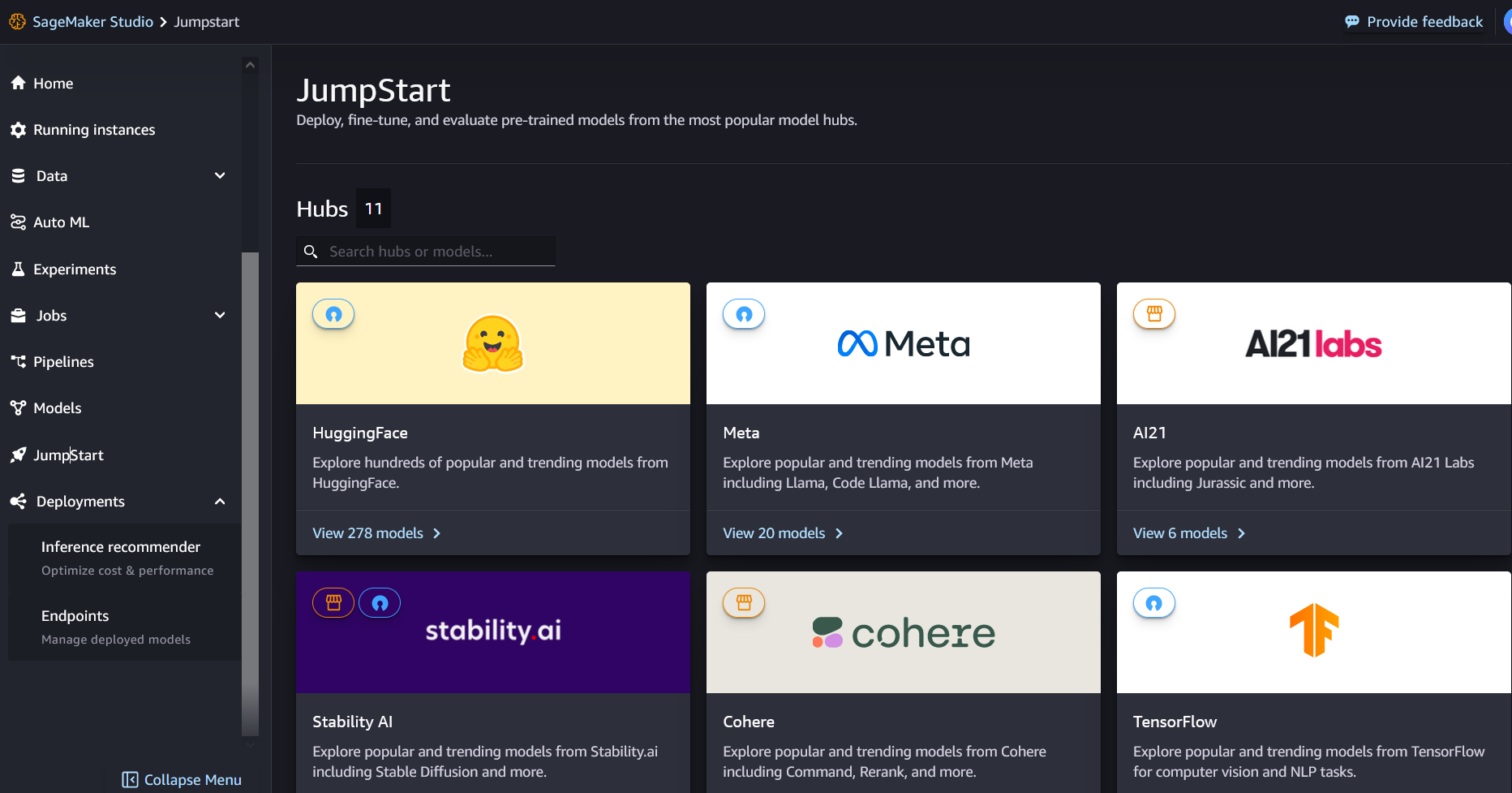

सेजमेकर जम्पस्टार्ट के साथ, एमएल व्यवसायी सर्वश्रेष्ठ प्रदर्शन करने वाले फाउंडेशन मॉडल की बढ़ती सूची में से चुन सकते हैं। एमएल प्रैक्टिशनर फाउंडेशन मॉडल को समर्पित करने के लिए तैनात कर सकते हैं अमेज़न SageMaker एक नेटवर्क पृथक वातावरण के भीतर उदाहरण, और मॉडल प्रशिक्षण और तैनाती के लिए सेजमेकर का उपयोग करके मॉडल को अनुकूलित करें।

अब आप कुछ ही क्लिक में मिक्सट्राल-8x7बी को खोज और तैनात कर सकते हैं अमेज़ॅन सैजमेकर स्टूडियो या सेजमेकर पायथन एसडीके के माध्यम से प्रोग्रामेटिक रूप से, आपको सेजमेकर सुविधाओं के साथ मॉडल प्रदर्शन और एमएलओपीएस नियंत्रण प्राप्त करने में सक्षम बनाता है जैसे अमेज़न SageMaker पाइपलाइन, अमेज़न SageMaker डिबगर, या कंटेनर लॉग। मॉडल को AWS सुरक्षित वातावरण में और आपके VPC नियंत्रण में तैनात किया गया है, जिससे डेटा सुरक्षा सुनिश्चित करने में मदद मिलती है।

मॉडल खोजें

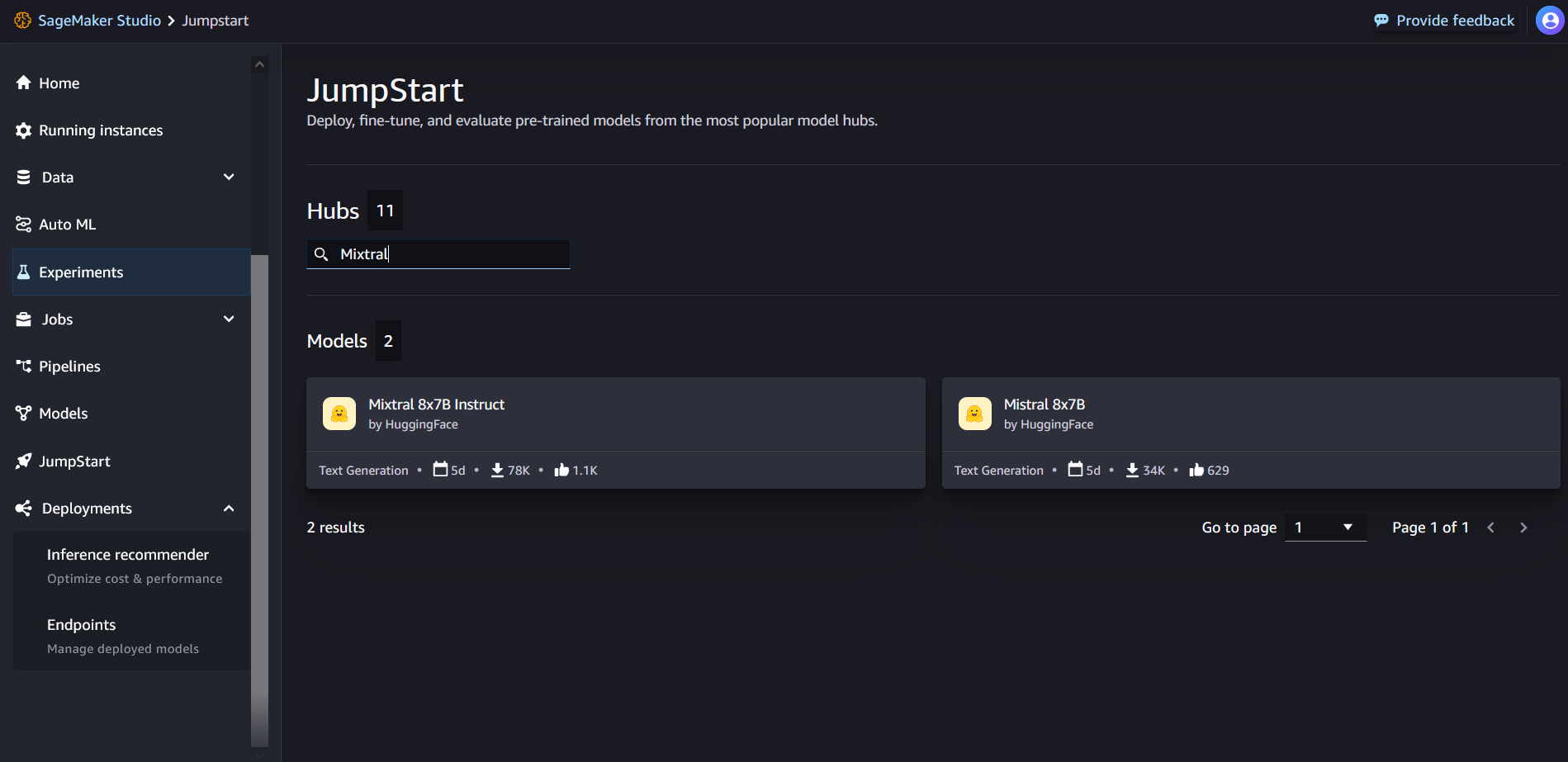

आप सेजमेकर स्टूडियो यूआई और सेजमेकर पायथन एसडीके में सेजमेकर जम्पस्टार्ट के माध्यम से मिक्सट्राल-8x7बी फाउंडेशन मॉडल तक पहुंच सकते हैं। इस अनुभाग में, हम सेजमेकर स्टूडियो में मॉडलों की खोज कैसे करें, इसके बारे में जानेंगे।

सेजमेकर स्टूडियो एक एकीकृत विकास वातावरण (आईडीई) है जो एकल वेब-आधारित विज़ुअल इंटरफ़ेस प्रदान करता है जहां आप डेटा तैयार करने से लेकर निर्माण, प्रशिक्षण और अपने एमएल मॉडल को तैनात करने तक सभी एमएल विकास चरणों को करने के लिए उद्देश्य-निर्मित टूल तक पहुंच सकते हैं। सेजमेकर स्टूडियो कैसे शुरू करें और स्थापित करें, इसके बारे में अधिक जानकारी के लिए देखें अमेज़ॅन सैजमेकर स्टूडियो.

सेजमेकर स्टूडियो में, आप चुनकर सेजमेकर जम्पस्टार्ट तक पहुंच सकते हैं कूदना शुरू करो नेविगेशन फलक में

सेजमेकर जम्पस्टार्ट लैंडिंग पृष्ठ से, आप खोज बॉक्स में "मिक्सट्रल" खोज सकते हैं। आपको मिक्सट्रल 8x7बी और मिक्सट्रल 8x7बी इंस्ट्रक्शन दिखाते हुए खोज परिणाम दिखाई देंगे।

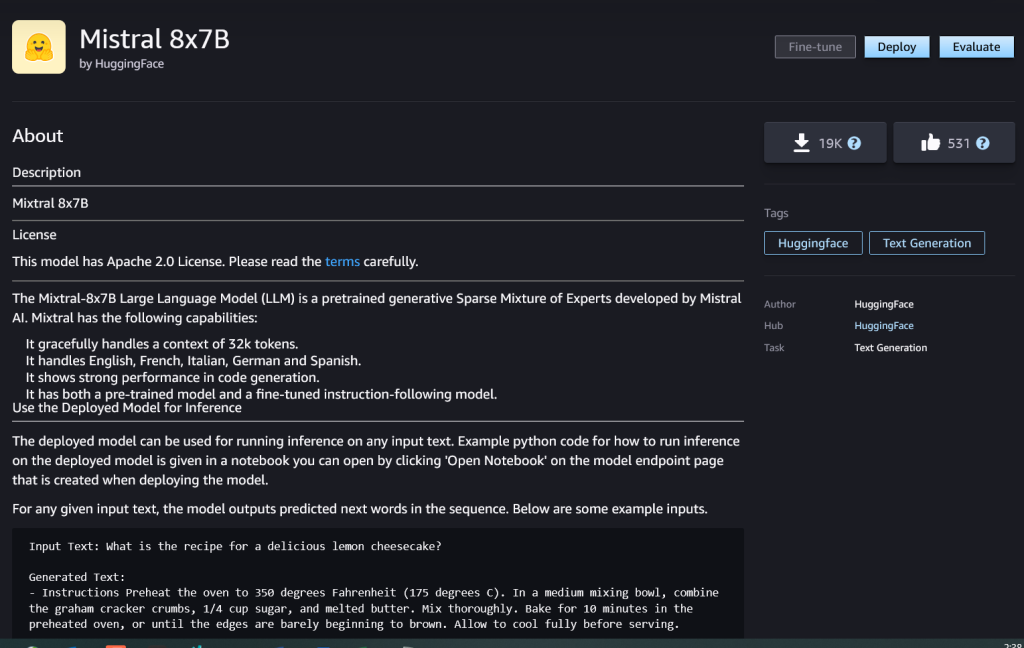

आप मॉडल के बारे में विवरण देखने के लिए मॉडल कार्ड चुन सकते हैं जैसे लाइसेंस, प्रशिक्षण के लिए उपयोग किया गया डेटा और उपयोग कैसे करें। आपको यह भी मिलेगा तैनाती बटन, जिसका उपयोग आप मॉडल को तैनात करने और एक समापन बिंदु बनाने के लिए कर सकते हैं।

एक मॉडल तैनात करें

जब आप चुनते हैं तो परिनियोजन प्रारंभ हो जाता है तैनाती. परिनियोजन समाप्त होने के बाद, आपके लिए एक समापन बिंदु बनाया गया है। आप नमूना अनुमान अनुरोध पेलोड पास करके या एसडीके का उपयोग करके अपने परीक्षण विकल्प का चयन करके समापन बिंदु का परीक्षण कर सकते हैं। जब आप एसडीके का उपयोग करने का विकल्प चुनते हैं, तो आपको उदाहरण कोड दिखाई देगा जिसे आप सेजमेकर स्टूडियो में अपने पसंदीदा नोटबुक संपादक में उपयोग कर सकते हैं।

एसडीके का उपयोग करके तैनात करने के लिए, हम द्वारा निर्दिष्ट मिक्सट्रल-8x7बी मॉडल का चयन करके शुरुआत करते हैं model_id with value huggingface-llm-mixtral-8x7b. आप निम्नलिखित कोड के साथ सेजमेकर पर किसी भी चयनित मॉडल को तैनात कर सकते हैं। इसी प्रकार, आप Mixtral-8x7B निर्देश को उसके स्वयं के मॉडल आईडी का उपयोग करके तैनात कर सकते हैं:

यह मॉडल को सेजमेकर पर डिफ़ॉल्ट कॉन्फ़िगरेशन के साथ तैनात करता है, जिसमें डिफ़ॉल्ट इंस्टेंस प्रकार और डिफ़ॉल्ट वीपीसी कॉन्फ़िगरेशन शामिल हैं। आप गैर-डिफ़ॉल्ट मान निर्दिष्ट करके इन कॉन्फ़िगरेशन को बदल सकते हैं जम्पस्टार्टमॉडल.

इसे तैनात करने के बाद, आप सेजमेकर भविष्यवक्ता के माध्यम से तैनात समापन बिंदु के खिलाफ अनुमान चला सकते हैं:

उदाहरण संकेत देता है

आप किसी भी मानक टेक्स्ट जेनरेशन मॉडल की तरह मिक्सट्रल-8x7B मॉडल के साथ इंटरैक्ट कर सकते हैं, जहां मॉडल एक इनपुट अनुक्रम को संसाधित करता है और अनुक्रम में अगले शब्दों की भविष्यवाणी करता है। इस अनुभाग में, हम उदाहरण संकेत प्रदान करते हैं।

कोड पीढ़ी

पिछले उदाहरण का उपयोग करते हुए, हम निम्नलिखित की तरह कोड जनरेशन संकेतों का उपयोग कर सकते हैं:

आपको निम्न आउटपुट मिलते हैं:

भावना विश्लेषण संकेत

आप मिक्सट्रल 8x7बी के साथ निम्नलिखित संकेत का उपयोग करके भावना विश्लेषण कर सकते हैं:

आपको निम्न आउटपुट मिलते हैं:

प्रश्न उत्तर संकेत

आप Mixtral-8x7B के साथ निम्नलिखित जैसे प्रश्न उत्तर संकेत का उपयोग कर सकते हैं:

आपको निम्न आउटपुट मिलते हैं:

मिक्सट्रल-8x7बी निर्देश

मिक्सट्रल-8x7बी का निर्देश-ट्यून किया गया संस्करण स्वरूपित निर्देशों को स्वीकार करता है जहां वार्तालाप भूमिकाएं उपयोगकर्ता के संकेत से शुरू होनी चाहिए और उपयोगकर्ता निर्देश और सहायक (मॉडल उत्तर) के बीच वैकल्पिक होनी चाहिए। निर्देश प्रारूप का कड़ाई से सम्मान किया जाना चाहिए, अन्यथा मॉडल उप-इष्टतम आउटपुट उत्पन्न करेगा। इंस्ट्रक्शन मॉडल के लिए प्रॉम्प्ट बनाने के लिए उपयोग किए जाने वाले टेम्पलेट को इस प्रकार परिभाषित किया गया है:

ध्यान दें कि <s> और </s> स्ट्रिंग की शुरुआत (बीओएस) और स्ट्रिंग के अंत (ईओएस) के लिए विशेष टोकन हैं, जबकि [INST] और [/INST] नियमित तार हैं.

निम्नलिखित कोड दिखाता है कि आप प्रॉम्प्ट को निर्देश प्रारूप में कैसे प्रारूपित कर सकते हैं:

ज्ञान पुनर्प्राप्ति

आप ज्ञान पुनर्प्राप्ति संकेत के लिए निम्नलिखित कोड का उपयोग कर सकते हैं:

आपको निम्न आउटपुट मिलते हैं:

कोडन

मिक्सट्रल मॉडल कोडिंग कार्यों के लिए बेंचमार्क की गई ताकत प्रदर्शित कर सकते हैं, जैसा कि निम्नलिखित कोड में दिखाया गया है:

गणित और तर्क

मिक्सट्रल मॉडल गणित की सटीकता में ताकत की भी रिपोर्ट करते हैं:

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :हैस

- :है

- :नहीं

- :कहाँ

- $यूपी

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15% तक

- 16

- 17

- 1M

- 200

- 25

- 26% तक

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- क्षमताओं

- About

- ऊपर

- तेज

- स्वीकार करता है

- पहुँच

- अकौन्टस(लेखा)

- शुद्धता

- पाना

- प्राप्त

- के पार

- सक्रिय

- जोड़ा

- जोड़ने

- बाद

- के खिलाफ

- AI

- ऐ / एमएल

- एल्गोरिदम

- सब

- भी

- वीरांगना

- अमेज़न SageMaker

- अमेज़न SageMaker जम्पस्टार्ट

- अमेज़ॅन वेब सेवा

- राशि

- an

- विश्लेषण

- और

- और बुनियादी ढांचे

- की घोषणा

- जवाब

- कोई

- अपाचे

- आकर्षक

- अनुप्रयोगों

- लागू

- लागू

- स्थापत्य

- हैं

- तर्क

- लेख

- AS

- सहायक

- At

- उपलब्ध

- एडब्ल्यूएस

- वापस

- आधार

- आधारित

- खूब जोर से पीटना

- बैटरी

- बायेसियन

- BE

- क्योंकि

- किया गया

- से पहले

- शुरू

- का मानना है कि

- घंटी

- बेंचमार्क

- मानक

- बेहतर

- के बीच

- बिल

- बिलिंग

- बिलियन

- पिन

- खरीदा

- मुक्केबाज़ी

- टूटना

- लाना

- निर्माण

- इमारत

- में निर्मित

- व्यापार

- लेकिन

- by

- गणना

- कॉल

- बुलाया

- कॉल

- कर सकते हैं

- कार्ड

- मामला

- मामलों

- परिवर्तन

- बातचीत

- चुनाव

- चुनें

- चुनने

- क्रिस

- वर्गीकरण

- क्लिक करें

- कोड

- कोडन

- संयोजन

- तुलना

- संकलित

- समापन

- कम्प्यूटेशनल

- गणना करना

- कंप्यूटर

- Computer Vision

- सम्मेलनों

- निरंतर

- कंटेनर

- सामग्री

- प्रसंग

- जारी

- लगातार

- नियंत्रण

- कन्वर्सेशन (Conversation)

- लागत

- लागत

- सका

- बनाना

- बनाया

- महत्वपूर्ण

- कप

- वर्तमान

- ग्राहक

- अनुकूलन

- अनुकूलित

- तिथि

- डाटा सुरक्षा

- डेटासेट

- दिन

- दिन

- समर्पित

- चूक

- परिभाषित

- लोकतंत्रीकरण

- दिखाना

- तैनात

- तैनात

- तैनाती

- तैनाती

- तैनात

- निकाले जाते हैं

- विवरण

- विकसित करना

- विकसित

- डेवलपर

- विकास

- dict

- डीआईडी

- अन्य वायरल पोस्ट से

- do

- कर देता है

- डॉलर

- डोमेन

- किया

- नीचे

- बूंद

- ड्यूक

- ड्यूक विश्वविद्यालय

- से प्रत्येक

- आर्थिक

- संपादक

- दक्षता

- अंडे

- अन्य

- सक्षम

- सक्षम बनाता है

- समर्थकारी

- समाप्त

- endpoint

- अभियांत्रिकी

- अंग्रेज़ी

- सुनिश्चित

- वातावरण

- EOS

- बराबर

- बराबर

- नैतिक

- उदाहरण

- से अधिक

- उत्तेजित

- के सिवा

- विशेषज्ञ

- विशेषज्ञों

- समझाना

- स्पष्टीकरण

- विस्तार

- परिवार

- और तेज

- विशेषताएं

- कुछ

- फ़ाइलें

- फ़िल्टर

- खोज

- प्रथम

- निम्नलिखित

- इस प्रकार है

- के लिए

- प्रारूप

- बुनियाद

- अंश

- फ्रेंच

- से

- समारोह

- भविष्य

- सामान्य उद्देश्य

- उत्पन्न

- उत्पन्न

- पीढ़ी

- उत्पादक

- जनरेटिव एआई

- जर्मन

- मिल

- Go

- अच्छा

- मिला

- बढ़ रहा है

- नफरत

- है

- he

- मदद

- मदद

- मदद करता है

- उसे

- यहाँ उत्पन्न करें

- हाई

- हिल्स

- उसके

- कैसे

- How To

- एचटीएमएल

- HTTPS

- हब

- i

- बर्फ

- आइसक्रीम

- ID

- if

- इलेनॉइस

- बीमारी

- आयात

- महत्वपूर्ण

- में सुधार

- सुधार

- in

- शामिल

- सहित

- निगमित

- इंफ्रास्ट्रक्चर

- निवेश

- निविष्टियां

- उदाहरण

- निर्देश

- एकीकृत

- एकीकृत

- बातचीत

- रुचियों

- इंटरफेस

- आविष्कार

- पृथक

- IT

- इतालवी

- आईटी इस

- खुद

- जेपीजी

- बच्चे

- ज्ञान

- काइल

- लैब्स

- अवतरण

- भाषा

- बड़ा

- पिछली बार

- परत

- बिक्रीसूत्र

- सीख रहा हूँ

- लंबाई

- चलो

- लाइसेंस

- पसंद

- को यह पसंद है

- सीमाएं

- LINK

- सूची

- सुनना

- थोड़ा

- एलएलएम

- तर्क

- देख

- कम

- मशीन

- यंत्र अधिगम

- बनाया गया

- बनाता है

- निर्माण

- प्रबंधक

- बहुत

- मैच

- गणित

- गणित

- me

- मध्यम

- मिश्रण

- ML

- एमएलओपीएस

- मोड

- आदर्श

- मॉडल

- संशोधित

- महीना

- अधिक

- मोटरसाइकिल

- बहुत

- गुणा

- संगीत

- चाहिए

- my

- प्राकृतिक

- प्राकृतिक भाषा संसाधन

- पथ प्रदर्शन

- नकारात्मक

- नेटवर्क

- तटस्थ

- नया

- अगला

- NLP

- कोई नहीं

- नोट

- नोटबुक

- अभी

- संख्या

- of

- तेल

- on

- एक बार

- ONE

- केवल

- परिचालन

- ऑपरेटिंग सिस्टम

- विकल्प

- or

- अन्य

- अन्यथा

- आउट

- उत्पादन

- outputs के

- बाहर

- के ऊपर

- अपना

- पृष्ठ

- प्रदत्त

- फलक

- कागजात

- प्राचल

- पैरामीटर

- पासिंग

- जुनून

- आवेशपूर्ण

- पथ

- प्रति

- निष्पादन

- प्रदर्शन

- पीएचडी

- फ़ोन

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- बिन्दु

- पोर्टेबल

- सकारात्मक

- पद

- पूर्ववर्ती

- भविष्यवाणी

- Predictor

- वरीय

- तैयारी

- पिछला

- प्रिंसिपल

- छाप

- प्रक्रियात्मक

- प्रक्रिया

- प्रक्रियाओं

- प्रसंस्करण

- एस्ट्रो मॉल

- कार्यक्रम

- प्रोग्रामिंग

- संकेतों

- समृद्धि

- प्रदान करना

- प्रदाताओं

- प्रदान करता है

- सार्वजनिक रूप से

- प्रकाशित

- अजगर

- तिमाही

- प्रश्न

- जल्दी से

- RE

- पढ़ना

- नुस्खा

- पुनरावर्ती

- को कम करने

- उल्लेख

- नियमित

- रिहा

- रिपोर्ट

- का अनुरोध

- अनुसंधान

- शोधकर्ता

- उपयुक्त संसाधन चुनें

- आदरणीय

- प्रतिक्रिया

- जिम्मेदार

- प्रतिबंध

- परिणाम

- परिणाम

- वापसी

- रिटर्न

- घुड़सवारी

- जोखिम

- भूमिका

- भूमिकाओं

- कक्ष

- रन

- दौड़ना

- s

- SA

- sagemaker

- नमक

- स्केलेबल

- स्केल

- विज्ञान

- वैज्ञानिक

- एसडीके

- Search

- अनुभाग

- सुरक्षित

- सुरक्षा

- देखना

- चयन

- चयनित

- का चयन

- चयन

- वरिष्ठ

- भावुकता

- अलग

- अनुक्रम

- कई

- सेवाएँ

- सेट

- पता चला

- दिखाया

- दिखाता है

- महत्वपूर्ण

- उसी प्रकार

- सरल

- के बाद से

- एक

- आकार

- So

- सोशल मीडिया

- समाज

- सॉफ्टवेयर

- समाधान

- स्पेनिश

- विशेष

- विशेषज्ञ

- विनिर्दिष्ट

- गति

- खर्च

- मानक

- प्रारंभ

- शुरू

- शुरू होता है

- राज्य के-the-कला

- सांख्यिकीय

- कदम

- कदम

- फिर भी

- रोक

- की दुकान

- सरल

- सामरिक

- धारा

- ताकत

- तार

- संरचित

- स्टूडियो

- ऐसा

- समर्थन

- सहायक

- समर्थन करता है

- प्रणाली

- लेता है

- कार्य

- स्वाद

- टीम

- टेक्नोलॉजी

- टेम्पलेट

- परीक्षण

- परीक्षण किया

- परीक्षण

- टेक्स्ट

- कि

- RSI

- भविष्य

- फिर

- इन

- वे

- इसका

- यहाँ

- पहर

- समय श्रृंखला

- बार

- सेवा मेरे

- एक साथ

- टोकन

- टोकन

- भी

- उपकरण

- कुल

- रेलगाड़ी

- प्रशिक्षण

- <strong>उद्देश्य</strong>

- कोशिश

- कलरव

- टाइप

- ui

- के अंतर्गत

- विश्वविद्यालय

- यूनिक्स

- अनलॉक

- जब तक

- उपयोग

- उदाहरण

- प्रयुक्त

- उपयोगकर्ता

- का उपयोग करता है

- का उपयोग

- उपयोग

- घाटी

- मूल्य

- मान

- विविधता

- संस्करण

- वीडियो

- देखें

- दृष्टि

- भेंट

- दृश्य

- चलना

- था

- पानी

- we

- वेब

- वेब सेवाओं

- वेब आधारित

- कुंआ

- क्या

- एचएमबी क्या है?

- कब

- जहाँ तक

- कौन कौन से

- सफेद

- कौन

- मर्जी

- साथ में

- अंदर

- बिना

- शब्द

- काम

- होगा

- लिखना

- लिखा हुआ

- आप

- आपका

- जेफिरनेट

रचना चड्ढा एडब्ल्यूएस में सामरिक खातों में प्रधान समाधान वास्तुकार एआई/एमएल है। रचना एक आशावादी है जो मानती है कि एआई का नैतिक और जिम्मेदार उपयोग भविष्य में समाज को बेहतर बना सकता है और आर्थिक और सामाजिक समृद्धि ला सकता है। अपने खाली समय में, रचना को अपने परिवार के साथ समय बिताना, लंबी पैदल यात्रा करना और संगीत सुनना पसंद है।

रचना चड्ढा एडब्ल्यूएस में सामरिक खातों में प्रधान समाधान वास्तुकार एआई/एमएल है। रचना एक आशावादी है जो मानती है कि एआई का नैतिक और जिम्मेदार उपयोग भविष्य में समाज को बेहतर बना सकता है और आर्थिक और सामाजिक समृद्धि ला सकता है। अपने खाली समय में, रचना को अपने परिवार के साथ समय बिताना, लंबी पैदल यात्रा करना और संगीत सुनना पसंद है। डॉ काइल उलरिच के साथ एक अनुप्रयुक्त वैज्ञानिक है

डॉ काइल उलरिच के साथ एक अनुप्रयुक्त वैज्ञानिक है  क्रिस्टोफर व्हिटेन जम्पस्टार्ट टीम में एक सॉफ्टवेयर डेवलपर है। वह मॉडल चयन को स्केल करने और अन्य सेजमेकर सेवाओं के साथ मॉडल को एकीकृत करने में मदद करता है। क्रिस को विभिन्न व्यावसायिक क्षेत्रों में एआई की सर्वव्यापकता में तेजी लाने का शौक है।

क्रिस्टोफर व्हिटेन जम्पस्टार्ट टीम में एक सॉफ्टवेयर डेवलपर है। वह मॉडल चयन को स्केल करने और अन्य सेजमेकर सेवाओं के साथ मॉडल को एकीकृत करने में मदद करता है। क्रिस को विभिन्न व्यावसायिक क्षेत्रों में एआई की सर्वव्यापकता में तेजी लाने का शौक है। डॉ. फैबियो नोनाटो डी पाउला एक वरिष्ठ प्रबंधक, विशेषज्ञ जेनएआई एसए हैं, जो मॉडल प्रदाताओं और ग्राहकों को एडब्ल्यूएस में जेनरेटर एआई बढ़ाने में मदद करते हैं। फैबियो को जेनरेटिव एआई तकनीक तक पहुंच को लोकतांत्रिक बनाने का जुनून है। काम के अलावा, आप फैबियो को सोनोमा घाटी की पहाड़ियों में अपनी मोटरसाइकिल चलाते या कॉमिक्सोलॉजी पढ़ते हुए पा सकते हैं।

डॉ. फैबियो नोनाटो डी पाउला एक वरिष्ठ प्रबंधक, विशेषज्ञ जेनएआई एसए हैं, जो मॉडल प्रदाताओं और ग्राहकों को एडब्ल्यूएस में जेनरेटर एआई बढ़ाने में मदद करते हैं। फैबियो को जेनरेटिव एआई तकनीक तक पहुंच को लोकतांत्रिक बनाने का जुनून है। काम के अलावा, आप फैबियो को सोनोमा घाटी की पहाड़ियों में अपनी मोटरसाइकिल चलाते या कॉमिक्सोलॉजी पढ़ते हुए पा सकते हैं। डॉ आशीष खेतानी Amazon SageMaker बिल्ट-इन एल्गोरिदम के साथ एक वरिष्ठ एप्लाइड साइंटिस्ट हैं और मशीन लर्निंग एल्गोरिदम विकसित करने में मदद करते हैं। उन्होंने इलिनोइस विश्वविद्यालय उरबाना-शैंपेन से पीएचडी की उपाधि प्राप्त की। वह मशीन लर्निंग और सांख्यिकीय अनुमान में एक सक्रिय शोधकर्ता हैं, और उन्होंने NeurIPS, ICML, ICLR, JMLR, ACL और EMNLP सम्मेलनों में कई पत्र प्रकाशित किए हैं।

डॉ आशीष खेतानी Amazon SageMaker बिल्ट-इन एल्गोरिदम के साथ एक वरिष्ठ एप्लाइड साइंटिस्ट हैं और मशीन लर्निंग एल्गोरिदम विकसित करने में मदद करते हैं। उन्होंने इलिनोइस विश्वविद्यालय उरबाना-शैंपेन से पीएचडी की उपाधि प्राप्त की। वह मशीन लर्निंग और सांख्यिकीय अनुमान में एक सक्रिय शोधकर्ता हैं, और उन्होंने NeurIPS, ICML, ICLR, JMLR, ACL और EMNLP सम्मेलनों में कई पत्र प्रकाशित किए हैं। कार्ल अल्बर्टसन अमेज़ॅन सेजमेकर एल्गोरिदम और जम्पस्टार्ट, सेजमेकर के मशीन लर्निंग हब के लिए उत्पाद, इंजीनियरिंग और विज्ञान का नेतृत्व करता है। उन्हें व्यावसायिक मूल्य को अनलॉक करने के लिए मशीन लर्निंग लागू करने का शौक है।

कार्ल अल्बर्टसन अमेज़ॅन सेजमेकर एल्गोरिदम और जम्पस्टार्ट, सेजमेकर के मशीन लर्निंग हब के लिए उत्पाद, इंजीनियरिंग और विज्ञान का नेतृत्व करता है। उन्हें व्यावसायिक मूल्य को अनलॉक करने के लिए मशीन लर्निंग लागू करने का शौक है।