गहन सुदृढीकरण सीखने (DRL) पर आधारित एक नव निर्मित कृत्रिम बुद्धिमत्ता (AI) प्रणाली नकली वातावरण में हमलावरों पर प्रतिक्रिया कर सकती है और 95% साइबर हमलों को बढ़ने से पहले ही रोक सकती है।

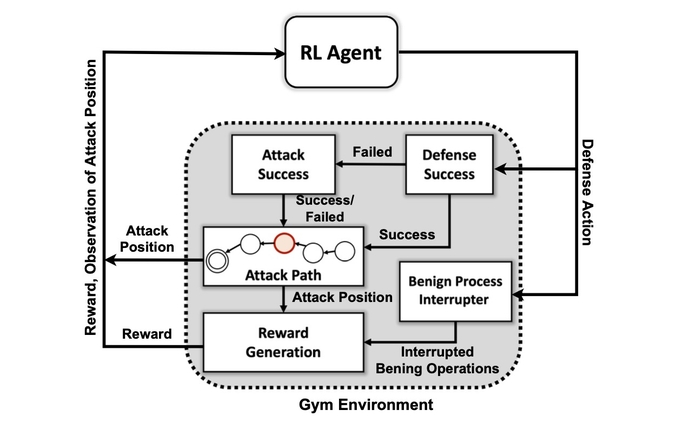

यह ऊर्जा विभाग के पैसिफ़िक नॉर्थवेस्ट नेशनल लेबोरेटरी के शोधकर्ताओं के अनुसार है, जिन्होंने एक नेटवर्क में हमलावरों और रक्षकों के बीच डिजिटल संघर्ष का एक सार सिमुलेशन बनाया और चार अलग-अलग डीआरएल न्यूरल नेटवर्क को प्रशिक्षित किया ताकि समझौते को रोकने और नेटवर्क व्यवधान को कम करने के आधार पर पुरस्कारों को अधिकतम किया जा सके।

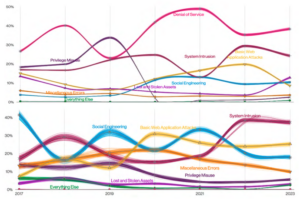

सिम्युलेटेड हमलावरों ने MITER ATT और CK प्रारंभिक पहुंच और टोही चरण से दूसरे हमले के चरणों में स्थानांतरित करने के लिए रूपरेखा का वर्गीकरण जब तक कि वे अपने लक्ष्य तक नहीं पहुंच जाते: प्रभाव और छनन चरण।

सरलीकृत हमले के माहौल पर एआई प्रणाली का सफल प्रशिक्षण दर्शाता है कि वास्तविक समय में हमलों की रक्षात्मक प्रतिक्रिया को एआई मॉडल द्वारा नियंत्रित किया जा सकता है, डेटा वैज्ञानिक सम्राट चटर्जी कहते हैं, जिन्होंने एसोसिएशन के लिए वार्षिक बैठक में टीम के काम को प्रस्तुत किया। 14 फरवरी को वाशिंगटन, डीसी में आर्टिफिशियल इंटेलिजेंस की उन्नति।

"यदि आप इन तकनीकों का वादा भी नहीं दिखा सकते हैं, तो आप अधिक जटिल आर्किटेक्चर में नहीं जाना चाहते हैं," वे कहते हैं। "हम पहले प्रदर्शित करना चाहते थे कि हम वास्तव में एक डीआरएल को सफलतापूर्वक प्रशिक्षित कर सकते हैं और आगे बढ़ने से पहले कुछ अच्छे परीक्षण परिणाम दिखा सकते हैं।"

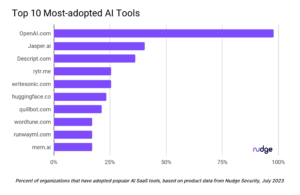

ईमेल सुरक्षा गेटवे में मशीन लर्निंग के शुरुआती एकीकरण से, साइबर सुरक्षा के भीतर विभिन्न क्षेत्रों में मशीन लर्निंग और आर्टिफिशियल इंटेलिजेंस तकनीकों का अनुप्रयोग पिछले एक दशक में एक गर्म प्रवृत्ति बन गया है। शुरुआती 2010s में अधिक हाल के प्रयासों के लिए कोड का विश्लेषण करने के लिए चैटजीपीटी का उपयोग करें या फोरेंसिक विश्लेषण करें। अब, अधिकांश सुरक्षा उत्पादों में है - या होने का दावा - बड़े डेटासेट पर प्रशिक्षित मशीन लर्निंग एल्गोरिदम द्वारा संचालित कुछ सुविधाएँ।

फिर भी सक्रिय रक्षा में सक्षम एआई प्रणाली का निर्माण व्यावहारिक होने के बजाय आकांक्षी बना हुआ है। जबकि शोधकर्ताओं के लिए कई तरह की बाधाएं हैं, पीएनएनएल के शोध से पता चलता है कि भविष्य में एआई डिफेंडर संभव हो सकता है।

पीएनएनएल शोध दल ने कहा, "विभिन्न प्रतिकूल सेटिंग्स के तहत प्रशिक्षित कई डीआरएल एल्गोरिदम का मूल्यांकन व्यावहारिक स्वायत्त साइबर रक्षा समाधान की दिशा में एक महत्वपूर्ण कदम है।" उनके पेपर में कहा गया है. "हमारे प्रयोगों से पता चलता है कि मॉडल-मुक्त डीआरएल एल्गोरिदम को अलग-अलग कौशल और दृढ़ता के स्तर के साथ मल्टी-स्टेज अटैक प्रोफाइल के तहत प्रभावी रूप से प्रशिक्षित किया जा सकता है, जो प्रतिस्पर्धी सेटिंग्स में अनुकूल रक्षा परिणाम प्रदान करता है।"

सिस्टम MITER ATT&CK का उपयोग कैसे करता है

अनुसंधान दल का पहला लक्ष्य एक ओपन सोर्स टूलकिट के आधार पर एक कस्टम सिमुलेशन वातावरण बनाना था जिसे एआई जिम खोलें. उस वातावरण का उपयोग करते हुए, शोधकर्ताओं ने MITER ATT&CK ढांचे से 7 युक्तियों और 15 तकनीकों के एक सबसेट का उपयोग करने की क्षमता के साथ विभिन्न कौशल और दृढ़ता स्तरों की हमलावर संस्थाओं का निर्माण किया।

हमलावर एजेंटों का लक्ष्य हमले की श्रृंखला के सात चरणों के माध्यम से आगे बढ़ना है, प्रारंभिक पहुंच से निष्पादन तक, दृढ़ता से आदेश और नियंत्रण तक, और संग्रह से प्रभाव तक।

पीएनएनएल के चटर्जी कहते हैं, हमलावर के लिए, पर्यावरण की स्थिति और डिफेंडर की मौजूदा कार्रवाइयों के लिए अपनी रणनीति को अपनाना जटिल हो सकता है।

वे कहते हैं, "प्रतिकूलता को एक शुरुआती पुनर्गठन राज्य से कुछ घुसपैठ या प्रभाव राज्य के रास्ते पर अपना रास्ता नेविगेट करना पड़ता है।" "हम पर्यावरण के अंदर आने से पहले एक विरोधी को रोकने के लिए एक प्रकार का मॉडल बनाने की कोशिश नहीं कर रहे हैं - हम मानते हैं कि सिस्टम पहले से ही समझौता कर चुका है।"

शोधकर्ताओं ने सुदृढीकरण सीखने के आधार पर तंत्रिका नेटवर्क के लिए चार दृष्टिकोणों का उपयोग किया। रीइन्फोर्समेंट लर्निंग (आरएल) एक मशीन लर्निंग दृष्टिकोण है जो मानव मस्तिष्क की इनाम प्रणाली का अनुकरण करता है। एक तंत्रिका नेटवर्क बेहतर समाधानों को पुरस्कृत करने के लिए व्यक्तिगत न्यूरॉन्स के लिए कुछ मापदंडों को मजबूत या कमजोर करके सीखता है, जैसा कि स्कोर द्वारा मापा जाता है जो दर्शाता है कि सिस्टम कितना अच्छा प्रदर्शन करता है।

पीएनएनएल के शोधकर्ता और पेपर के लेखक महंतेश हलप्पनवर कहते हैं, सुदृढीकरण सीखने से अनिवार्य रूप से कंप्यूटर को एक अच्छा, लेकिन सही नहीं, हाथ में समस्या का दृष्टिकोण बनाने की अनुमति मिलती है।

"किसी भी सुदृढ़ीकरण सीखने का उपयोग किए बिना, हम अभी भी इसे कर सकते हैं, लेकिन यह वास्तव में एक बड़ी समस्या होगी जिसके पास वास्तव में किसी भी अच्छे तंत्र के साथ आने के लिए पर्याप्त समय नहीं होगा," वे कहते हैं। "हमारा शोध ... हमें यह तंत्र प्रदान करता है जहां गहन सुदृढीकरण सीखना कुछ हद तक मानव व्यवहार की नकल करने जैसा है, और यह बहुत ही विशाल स्थान को बहुत कुशलता से खोज सकता है।"

प्राइम टाइम के लिए तैयार नहीं

प्रयोगों में पाया गया कि एक विशिष्ट सुदृढीकरण सीखने की विधि, जिसे डीप क्यू नेटवर्क के रूप में जाना जाता है, ने रक्षात्मक समस्या का एक मजबूत समाधान तैयार किया, 97% हमलावरों को पकड़ना परीक्षण डेटा सेट में। फिर भी शोध केवल शुरुआत है। सुरक्षा पेशेवरों को जल्द ही घटना प्रतिक्रिया और फोरेंसिक करने में मदद करने के लिए एआई साथी की तलाश नहीं करनी चाहिए।

हल की जाने वाली कई समस्याओं में सुदृढीकरण सीखने और गहरे तंत्रिका नेटवर्क को उन कारकों की व्याख्या करने के लिए मिल रहा है जो उनके निर्णयों को प्रभावित करते हैं, अनुसंधान के एक क्षेत्र को व्याख्यात्मक सुदृढीकरण सीखने (एक्सआरएल) कहा जाता है।

पीएनएनएल के चटर्जी कहते हैं, इसके अलावा, एआई एल्गोरिदम की मजबूती और तंत्रिका नेटवर्क को प्रशिक्षित करने के कुशल तरीके खोजना दोनों समस्याएं हैं जिन्हें हल करने की आवश्यकता है।

"एक उत्पाद बनाना- जो इस शोध के लिए मुख्य प्रेरणा नहीं था," वे कहते हैं। "यह वैज्ञानिक प्रयोग और एल्गोरिथम खोज के बारे में अधिक था।"

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोब्लॉकचैन। Web3 मेटावर्स इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- स्रोत: https://www.darkreading.com/emerging-tech/researchers-create-ai-cyber-defender-that-reacts-to-attackers

- 7

- 95% तक

- a

- क्षमता

- About

- अमूर्त

- पहुँच

- अनुसार

- कार्रवाई

- वास्तव में

- इसके अलावा

- उन्नति

- विरोधात्मक

- एजेंटों

- AI

- ऐ संचालित

- एल्गोरिथम

- एल्गोरिदम

- सब

- की अनुमति देता है

- पहले ही

- विश्लेषण

- विश्लेषण करें

- और

- वार्षिक

- आवेदन

- दृष्टिकोण

- दृष्टिकोण

- क्षेत्र

- कृत्रिम

- कृत्रिम बुद्धिमत्ता

- कृत्रिम बुद्धिमत्ता (AI)

- संघ

- आक्रमण

- आक्रमण

- लेखक

- स्वायत्त

- आधारित

- बन

- से पहले

- बेहतर

- के बीच

- बड़ा

- खंड

- दिमाग

- बनाया गया

- बुलाया

- नही सकता

- सक्षम

- कुछ

- श्रृंखला

- ChatGPT

- दावा

- वर्गीकरण

- संग्रह

- कैसे

- जटिल

- छेड़छाड़ की गई

- कंप्यूटर

- आचरण

- संघर्ष

- जारी

- नियंत्रण

- सका

- बनाना

- बनाया

- बनाना

- वर्तमान

- रिवाज

- साइबर

- साइबर हमले

- साइबर सुरक्षा

- तिथि

- आँकड़े वाला वैज्ञानिक

- डेटा सेट

- डेटासेट

- dc

- दशक

- निर्णय

- निर्णय

- गहरा

- प्रतिरक्षक

- रक्षा

- बचाव

- दिखाना

- दर्शाता

- विभाग

- विभिन्न

- डिजिटल

- खोज

- विघटन

- कई

- शीघ्र

- प्रभावी रूप से

- कुशल

- कुशलता

- प्रयासों

- ईमेल

- ईमेल सुरक्षा

- ऊर्जा

- पर्याप्त

- संस्थाओं

- वातावरण

- अनिवार्य

- का मूल्यांकन

- और भी

- निष्पादन

- एक्सफ़िलिएशन

- समझाना

- का पता लगाने

- कारकों

- विशेषताएं

- कुछ

- फ़ील्ड

- खोज

- प्रथम

- प्रवाह

- फोरेंसिक

- फोरेंसिक

- आगे

- पाया

- ढांचा

- से

- भविष्य

- मिल

- मिल रहा

- देता है

- लक्ष्य

- लक्ष्यों

- अच्छा

- हाथ

- मदद

- गरम

- कैसे

- HTTPS

- मानव

- टट्टी कुदने की घुड़ौड़

- प्रभाव

- महत्वपूर्ण

- in

- घटना

- घटना की प्रतिक्रिया

- व्यक्ति

- प्रभावित

- प्रारंभिक

- एकीकरण

- बुद्धि

- IT

- खुद

- बच्चा

- जानने वाला

- प्रयोगशाला

- बड़ा

- सीख रहा हूँ

- स्तर

- देखिए

- मशीन

- यंत्र अधिगम

- मुख्य

- बहुत

- अधिकतम-चौड़ाई

- अधिकतम करने के लिए

- तंत्र

- बैठक

- तरीका

- कम से कम

- आदर्श

- अधिक

- अभिप्रेरण

- चाल

- चलती

- विभिन्न

- राष्ट्रीय

- नेविगेट करें

- आवश्यकता

- नेटवर्क

- नेटवर्क

- तंत्रिका नेटवर्क

- तंत्रिका जाल

- न्यूरॉन्स

- खुला

- खुला स्रोत

- अन्य

- पसिफ़िक

- काग़ज़

- पैरामीटर

- अतीत

- उत्तम

- प्रदर्शन

- हठ

- चरण

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- संभव

- संचालित

- व्यावहारिक

- प्रस्तुत

- रोकने

- मुख्य

- प्रोएक्टिव

- मुसीबत

- समस्याओं

- उत्पाद

- पेशेवरों

- प्रोफाइल

- वादा

- RE

- पहुँचे

- प्रतिक्रिया

- प्रतिक्रिया करते हैं

- तैयार

- वास्तविक

- वास्तविक समय

- हाल

- रहना

- अनुसंधान

- शोधकर्ता

- शोधकर्ताओं

- प्रतिक्रिया

- इनाम

- पुरस्कार

- मजबूती

- कहते हैं

- वैज्ञानिक

- वैज्ञानिक

- सुरक्षा

- कई

- सेट

- सेटिंग्स

- सात

- चाहिए

- दिखाना

- दिखाता है

- सरलीकृत

- अनुकार

- कौशल

- समाधान

- समाधान ढूंढे

- कुछ

- स्रोत

- अंतरिक्ष

- विशिष्ट

- प्रारंभ

- राज्य

- कदम

- कदम

- फिर भी

- रुकें

- मजबूत बनाने

- मजबूत

- सफल

- सफलतापूर्वक

- प्रणाली

- युक्ति

- टीम

- तकनीक

- परीक्षण

- RSI

- राज्य

- लेकिन हाल ही

- यहाँ

- पहर

- सेवा मेरे

- टूलकिट

- की ओर

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- प्रवृत्ति

- के अंतर्गत

- us

- उपयोग

- विविधता

- व्यापक

- जरूरत है

- वाशिंगटन

- तरीके

- जब

- कौन

- मर्जी

- अंदर

- बिना

- काम

- होगा

- नर्म

- आप

- जेफिरनेट