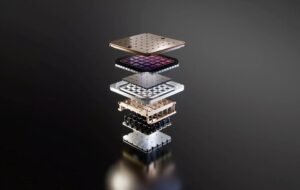

कृत्रिम बुद्धिमत्ता की विनाशकारी क्षमता को सीमित करने की हमारी खोज में, कैम्ब्रिज विश्वविद्यालय के एक नए पेपर में परमाणु हथियारों के अनधिकृत प्रक्षेपण को रोकने के लिए विकसित किए गए रिमोट किल स्विच और लॉकआउट को उस हार्डवेयर में बेक करने का सुझाव दिया गया है जो इसे शक्ति प्रदान करता है।

कागज़ [पीडीएफ], जिसमें कई शैक्षणिक संस्थानों और कई ओपनएआई की आवाजें शामिल हैं, यह मामला बनाता है कि जिस हार्डवेयर पर ये मॉडल भरोसा करते हैं उसे विनियमित करना इसके दुरुपयोग को रोकने का सबसे अच्छा तरीका हो सकता है।

शोधकर्ताओं का तर्क है, "एआई-प्रासंगिक गणना हस्तक्षेप का एक विशेष रूप से प्रभावी बिंदु है: यह पता लगाने योग्य, बहिष्कृत और मात्रात्मक है, और एक बेहद केंद्रित आपूर्ति श्रृंखला के माध्यम से उत्पादित किया जाता है।"

सबसे विपुल मॉडलों को प्रशिक्षित करने के लिए, जो कि एक ट्रिलियन मापदंडों से अधिक माना जाता है, विशाल भौतिक बुनियादी ढांचे की आवश्यकता होती है: हजारों जीपीयू या त्वरक और प्रसंस्करण समय के सप्ताह या यहां तक कि महीने। शोधकर्ताओं का कहना है कि इससे इन संसाधनों के अस्तित्व और सापेक्ष प्रदर्शन को छिपाना मुश्किल हो जाता है।

इसके अलावा, इन मॉडलों को प्रशिक्षित करने के लिए उपयोग किए जाने वाले सबसे उन्नत चिप्स एनवीडिया, एएमडी और इंटेल जैसी अपेक्षाकृत कम संख्या में कंपनियों द्वारा उत्पादित किए जाते हैं, जिससे नीति निर्माताओं को इन सामानों की बिक्री को संबंधित व्यक्तियों या देशों तक सीमित करने की अनुमति मिलती है।

पेपर में तर्क दिया गया है कि ये कारक, सेमीकंडक्टर विनिर्माण पर आपूर्ति श्रृंखला बाधाओं जैसे अन्य कारकों के साथ, नीति निर्माताओं को बेहतर ढंग से समझने का साधन प्रदान करते हैं कि एआई बुनियादी ढांचे को कैसे और कहां तैनात किया जाता है, किसे इसकी पहुंच है और किसे इसकी अनुमति नहीं है, और इसके दुरुपयोग के लिए दंड लागू करते हैं। .

बुनियादी ढांचे को नियंत्रित करना

यह पेपर ऐसे कई तरीकों पर प्रकाश डालता है जिनसे नीति निर्माता एआई हार्डवेयर विनियमन के लिए संपर्क कर सकते हैं। कई सुझाव - जिनमें दृश्यता में सुधार और एआई एक्सेलेरेटर की बिक्री को सीमित करने के लिए डिज़ाइन किए गए सुझाव शामिल हैं - पहले से ही राष्ट्रीय स्तर पर चल रहे हैं।

पिछले साल अमेरिकी राष्ट्रपति जो बिडेन ने एक प्रस्ताव रखा था कार्यकारी आदेश इसका उद्देश्य बड़े दोहरे उपयोग वाले एआई मॉडल विकसित करने वाली कंपनियों के साथ-साथ सक्षम बुनियादी ढांचा विक्रेताओं की पहचान करना है उन्हें प्रशिक्षण दे रहे हैं. यदि आप परिचित नहीं हैं, तो "दोहरा उपयोग" उन तकनीकों को संदर्भित करता है जो नागरिक और सैन्य अनुप्रयोगों में दोहरी भूमिका निभा सकती हैं।

हाल ही में, अमेरिकी वाणिज्य विभाग प्रस्तावित विनियमन जिसके लिए अमेरिकी क्लाउड प्रदाताओं को अधिक कठोर "अपने ग्राहक को जानें" नीतियों को लागू करने की आवश्यकता होगी ताकि संबंधित व्यक्तियों या देशों को निर्यात प्रतिबंधों से बचाया जा सके।

शोधकर्ताओं का कहना है कि इस तरह की दृश्यता मूल्यवान है, क्योंकि यह हथियारों की एक और दौड़ से बचने में मदद कर सकती है, जैसे कि मिसाइल गैप विवाद से शुरू हुआ विवाद, जहां गलत रिपोर्टों के कारण बड़े पैमाने पर बैलिस्टिक मिसाइलों का निर्माण हुआ। मूल्यवान होते हुए भी, वे चेतावनी देते हैं कि इन रिपोर्टिंग आवश्यकताओं पर अमल करने से ग्राहक की गोपनीयता पर हमला होने का जोखिम होता है और यहां तक कि संवेदनशील डेटा भी लीक हो जाता है।

इस बीच, व्यापार के मोर्चे पर, वाणिज्य विभाग ने जारी रखा है आगे आना प्रतिबंध, चीन को बेचे गए त्वरक के प्रदर्शन को सीमित करना। लेकिन, जैसा कि हमने पहले बताया है, जबकि इन प्रयासों ने चीन जैसे देशों के लिए अमेरिकी चिप्स पर हाथ डालना कठिन बना दिया है, वे परिपूर्ण से बहुत दूर हैं।

इन सीमाओं को संबोधित करने के लिए, शोधकर्ताओं ने एआई चिप बिक्री के लिए एक वैश्विक रजिस्ट्री को लागू करने का प्रस्ताव दिया है जो उन्हें अपने मूल देश छोड़ने के बाद भी, उनके जीवनचक्र के दौरान ट्रैक करेगा। उनका सुझाव है कि ऐसी रजिस्ट्री प्रत्येक चिप में एक विशिष्ट पहचानकर्ता को शामिल कर सकती है, जो मुकाबला करने में मदद कर सकती है तस्करी करना घटकों के।

स्पेक्ट्रम के अधिक चरम छोर पर, शोधकर्ताओं ने सुझाव दिया है कि दुर्भावनापूर्ण अनुप्रयोगों में उनके उपयोग को रोकने के लिए किल स्विच को सिलिकॉन में बेक किया जा सकता है।

सिद्धांत रूप में, यह नियामकों को दूर से चिप्स तक पहुंच में कटौती करके संवेदनशील प्रौद्योगिकियों के दुरुपयोग पर तेजी से प्रतिक्रिया करने की अनुमति दे सकता है, लेकिन लेखकों ने चेतावनी दी है कि ऐसा करना जोखिम के बिना नहीं है। यदि गलत तरीके से लागू किया गया तो निहितार्थ यह है कि ऐसा किल स्विच साइबर अपराधियों का लक्ष्य बन सकता है।

एक अन्य प्रस्ताव के लिए कई पक्षों को संभावित जोखिम भरे एआई प्रशिक्षण कार्यों पर हस्ताक्षर करने की आवश्यकता होगी, इससे पहले कि उन्हें बड़े पैमाने पर तैनात किया जा सके। "परमाणु हथियार समान तंत्र का उपयोग करते हैं जिन्हें अनुमेय कार्रवाई लिंक कहा जाता है," उन्होंने लिखा।

परमाणु हथियारों के लिए, ये सुरक्षा ताले एक व्यक्ति को दुष्ट बनने और पहला हमला करने से रोकने के लिए डिज़ाइन किए गए हैं। हालाँकि, AI के लिए, विचार यह है कि यदि कोई व्यक्ति या कंपनी क्लाउड में एक निश्चित सीमा से अधिक मॉडल को प्रशिक्षित करना चाहता है, तो उन्हें ऐसा करने के लिए पहले प्राधिकरण प्राप्त करने की आवश्यकता होगी।

हालांकि एक शक्तिशाली उपकरण, शोधकर्ताओं का मानना है कि यह वांछनीय एआई के विकास को रोककर उल्टा असर डाल सकता है। ऐसा प्रतीत होता है कि तर्क यह है कि यद्यपि परमाणु हथियारों के उपयोग का परिणाम बहुत स्पष्ट होता है, एआई हमेशा इतना काला और सफेद नहीं होता है।

लेकिन अगर यह आपकी पसंद के हिसाब से कुछ ज्यादा ही मनहूस लगता है, तो यह पेपर समग्र रूप से समाज की भलाई के लिए एआई संसाधनों को पुनः आवंटित करने के लिए एक संपूर्ण अनुभाग समर्पित करता है। विचार यह है कि नीति निर्माता एआई गणना को उन समूहों के लिए अधिक सुलभ बनाने के लिए एक साथ आ सकते हैं जो इसे बुराई के लिए उपयोग करने की संभावना नहीं रखते हैं, इस अवधारणा को "आवंटन" के रूप में वर्णित किया गया है।

एआई विकास को विनियमित करने में क्या गलत है?

यह सब झंझट क्यों मोल लें? खैर, पेपर के लेखकों का मानना है कि भौतिक हार्डवेयर को नियंत्रित करना स्वाभाविक रूप से आसान है।

हार्डवेयर की तुलना में, "एआई विकास के अन्य इनपुट और आउटपुट - डेटा, एल्गोरिदम और प्रशिक्षित मॉडल - आसानी से साझा करने योग्य, गैर-प्रतिद्वंद्वी अमूर्त सामान हैं, जिससे उन्हें नियंत्रित करना स्वाभाविक रूप से मुश्किल हो जाता है," पेपर में लिखा है।

तर्क यह है कि एक बार जब कोई मॉडल प्रकाशित हो जाता है, या तो खुले में या लीक हो जाता है, तो जिन्न को वापस बोतल में बंद नहीं किया जा सकता है और न ही पूरे नेट पर इसके प्रसार को रोका जा सकता है।

शोधकर्ताओं ने इस बात पर भी प्रकाश डाला कि मॉडलों के दुरुपयोग को रोकने के प्रयास अविश्वसनीय साबित हुए हैं। एक उदाहरण में, लेखकों ने उस आसानी पर प्रकाश डाला जिसके साथ शोधकर्ता मेटा के लामा 2 में सुरक्षा उपायों को नष्ट करने में सक्षम थे, जिसका उद्देश्य मॉडल को आक्रामक भाषा उत्पन्न करने से रोकना था।

चरम सीमा पर, यह आशंका है कि तेजी लाने के लिए पर्याप्त रूप से उन्नत दोहरे उपयोग वाले मॉडल को नियोजित किया जा सकता है विकास रासायनिक या जैविक हथियारों का.

पेपर मानता है कि एआई हार्डवेयर विनियमन कोई चांदी की गोली नहीं है और उद्योग के अन्य पहलुओं में विनियमन की आवश्यकता को समाप्त नहीं करता है।

हालाँकि, सीईओ सैम ऑल्टमैन को ध्यान में रखते हुए कई ओपनएआई शोधकर्ताओं की भागीदारी को नजरअंदाज करना कठिन है प्रयास एआई विनियमन के इर्द-गिर्द कथा को नियंत्रित करने के लिए। ®

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://go.theregister.com/feed/www.theregister.com/2024/02/16/boffins_propose_regulating_ai_hardware/

- :हैस

- :है

- :नहीं

- :कहाँ

- $यूपी

- 7

- a

- योग्य

- गालियाँ

- AC

- शैक्षिक

- में तेजी लाने के

- त्वरक

- पहुँच

- सुलभ

- के पार

- कार्य

- पता

- उन्नत

- बाद

- AI

- एआई मॉडल

- एआई प्रशिक्षण

- उद्देश्य से

- एल्गोरिदम

- सब

- आवंटन

- अनुमति देना

- की अनुमति दी

- की अनुमति दे

- साथ में

- पहले ही

- भी

- हमेशा

- एएमडी

- अमेरिकन

- an

- और

- अन्य

- अनुप्रयोगों

- दृष्टिकोण

- हैं

- बहस

- तर्क

- हथियार

- चारों ओर

- कृत्रिम

- कृत्रिम बुद्धिमत्ता

- AS

- पहलुओं

- At

- प्राधिकरण

- लेखकों

- से बचने

- वापस

- BE

- बन

- से पहले

- जा रहा है

- माना

- BEST

- बेहतर

- सुधार

- बिडेन

- काली

- निर्माण

- लेकिन

- by

- बुलाया

- कैंब्रिज

- कर सकते हैं

- सक्षम

- मामला

- मुख्य कार्यपालक अधिकारी

- कुछ

- श्रृंखला

- रासायनिक

- चीन

- टुकड़ा

- चिप्स

- नागरिक

- बादल

- CO

- का मुकाबला

- कैसे

- कॉमर्स

- कंपनियों

- कंपनी

- घटकों

- गणना करना

- सांद्र

- संकल्पना

- चिंता

- पर विचार

- की कमी

- निरंतर

- नियंत्रण

- विवाद

- सका

- देशों

- देश

- कोर्स

- ग्राहक

- कटाई

- साइबर अपराधी

- तिथि

- विभाग

- तैनात

- वर्णित

- बनाया गया

- विकसित

- विकासशील

- विकास

- मुश्किल

- do

- नहीं करता है

- कर

- डबल

- dystopian

- से प्रत्येक

- आराम

- आसान

- आसानी

- प्रभावी

- प्रयासों

- भी

- को खत्म करने

- कार्यरत

- समाप्त

- लागू करना

- संपूर्ण

- और भी

- उदाहरण

- से अधिक

- को क्रियान्वित

- अस्तित्व

- निर्यात

- चरम

- अत्यंत

- कारकों

- परिचित

- दूर

- और तेज

- आशंका

- लगता है

- प्रथम

- के लिए

- आगे

- से

- सामने

- अन्तर

- सृजन

- जिन्न

- मिल

- मिल रहा

- वैश्विक

- Go

- जा

- माल

- GPUs

- समूह की

- हाथ

- कठिन

- और जोर से

- हार्डवेयर

- है

- मदद

- छिपाना

- हाइलाइट

- हाइलाइट

- कैसे

- तथापि

- HTTPS

- विचार

- पहचानकर्ता

- पहचान

- if

- उपेक्षा

- अत्यधिक

- लागू करने के

- कार्यान्वित

- कार्यान्वयन

- में सुधार

- in

- अन्य में

- शामिल

- सहित

- सम्मिलित

- गलत रूप से

- व्यक्ति

- उद्योग

- इंफ्रास्ट्रक्चर

- स्वाभाविक

- निविष्टियां

- संस्थानों

- अमूर्त

- इंटेल

- बुद्धि

- हस्तक्षेप

- में

- प्रतिसाद नहीं

- IT

- आईटी इस

- JOE

- जो Biden

- जेपीजी

- हत्या

- बच्चा

- भाषा

- बड़ा

- लांच

- शुरू करने

- नेतृत्व

- नेतृत्व

- बाएं

- स्तर

- जीवन चक्र

- पसंद

- सीमा

- सीमाओं

- सीमित

- लिंक

- थोड़ा

- लामा

- ताले

- बनाया गया

- बनाना

- बनाता है

- निर्माण

- दुर्भावनापूर्ण

- विनिर्माण

- बहुत

- विशाल

- मई..

- साधन

- मतलब

- तंत्र

- मेटा

- हो सकता है

- सैन्य

- सैन्य अनुप्रयोग

- मिसाइलों

- गलत इस्तेमाल

- आदर्श

- मॉडल

- महीने

- अधिक

- अधिकांश

- विभिन्न

- कथा

- राष्ट्रीय

- आवश्यकता

- जाल

- नया

- नहीं

- नोट

- नाभिकीय

- संख्या

- अनेक

- Nvidia

- निरीक्षण

- of

- बंद

- अपमानजनक

- प्रस्ताव

- on

- एक बार

- ONE

- खुला

- OpenAI

- or

- मूल

- अन्य

- अन्य

- हमारी

- आउट

- परिणाम

- outputs के

- के ऊपर

- काग़ज़

- पैरामीटर

- सहभागिता

- विशेष रूप से

- पार्टियों

- पीडीएफ

- दंड

- उत्तम

- प्रदर्शन

- व्यक्ति

- व्यक्तियों

- भौतिक

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- खेल

- बिन्दु

- नीतियाँ

- नीति

- प्रबल

- संभावित

- संभावित

- शक्तियां

- अध्यक्ष

- अध्यक्ष जो बोली

- सुंदर

- को रोकने के

- रोकने

- पहले से

- एकांत

- प्रसंस्करण

- प्रस्तुत

- उर्वर

- प्रस्ताव

- प्रस्तावित

- साबित

- प्रदाताओं

- प्रकाशित

- रखना

- लाना

- मात्रात्मक

- खोज

- दौड़

- RE

- हाल ही में

- संदर्भित करता है

- रजिस्ट्री

- विनियमित

- विनियमन

- विनियमन

- विनियामक

- सापेक्ष

- अपेक्षाकृत

- भरोसा करना

- दूरस्थ

- दूर से

- की सूचना दी

- रिपोर्टिंग

- रिपोर्ट

- की आवश्यकता होती है

- आवश्यकताएँ

- की आवश्यकता होती है

- शोधकर्ताओं

- उपयुक्त संसाधन चुनें

- प्रतिक्रिया

- रोकना

- प्रतिबंध

- जोखिम

- जोखिम

- जोखिम भरा

- s

- सुरक्षा उपायों

- बिक्री

- विक्रय

- सैम

- सैम ऑल्टमैन

- कहना

- स्केल

- अनुभाग

- सुरक्षा

- लगता है

- अर्धचालक

- संवेदनशील

- सेवा

- कई

- हस्ताक्षर

- सिलिकॉन

- चांदी

- समान

- छोटा

- So

- समाज

- बेचा

- स्पेक्ट्रम

- विस्तार

- प्रारंभ

- रुकें

- रोक

- हड़ताल

- कड़ी से कड़ी

- ऐसा

- सुझाव

- आपूर्ति

- आपूर्ति श्रृंखला

- स्विच

- लक्ष्य

- कार्य

- स्वाद

- टेक्नोलॉजीज

- है

- कि

- RSI

- लेकिन हाल ही

- उन

- सिद्धांत

- वहाँ।

- इन

- वे

- इसका

- उन

- हजारों

- द्वार

- पहर

- सेवा मेरे

- एक साथ

- भी

- साधन

- ट्रैक

- व्यापार

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- शुरू हो रहा

- खरब

- मुसीबत

- अनधिकृत

- समझना

- अद्वितीय

- विश्वविद्यालय

- कैम्ब्रिज विश्वविद्यालय

- संभावना नहीं

- us

- अमेरिकी राष्ट्रपति

- उपयोग

- प्रयुक्त

- मूल्यवान

- Ve

- विक्रेताओं

- के माध्यम से

- दृश्यता

- आवाज

- जरूरत है

- मार्ग..

- तरीके

- we

- हथियार

- सप्ताह

- कुंआ

- थे

- कौन कौन से

- जब

- सफेद

- कौन

- पूरा का पूरा

- साथ में

- बिना

- होगा

- गलत

- लिखा था

- वर्ष

- आप

- आपका

- जेफिरनेट