A Google és az Intel kedden piacra dobta saját mesterségesintelligencia-chipjeit, hogy kihívást jelentsen az Nvidiának, miközben fokozódik a verseny a fejlett félvezetők gyártásával az olyan generatív mesterséges intelligencia modellek energiaellátására, mint a ChatGPT vagy a Gemini.

Google kiadta Cloud TPU v5p-jét, az Intel pedig Gaudi 3 AI processzorát. A chipeket úgy tervezték, hogy fokozzák a teljesítményt az AI-rendszerek betanításában, valamint a „kész szoftver futtatásában”.

LLM-ek képzése nagyobb sebességgel

A Google először decemberben jelentette be új TPU-ját, vagyis tenzor feldolgozó egységét, a Gemini mellett. Azt mondta, hogy a TPU v5p, amely már elérhető a fejlesztők számára, az eddigi legerősebb és skálázhatóbb AI processzora.

A cég azt állítja, hogy frissített chipje képes nagy nyelvi modelleket (LLM-eket) tanítani, az AI chatbotok mögött meghúzódó technológiát, mint pl. Gemini és a ChatGPT, háromszor gyorsabb, mint elődje, a Google TPU v4. Azt mondta, hogy az AI chip 12-szer nagyobb átviteli sebességet biztosít, mint a régi verzió.

„A Google TPU-inak fejlesztései immár ötödik generációjukban segítettek az ügyfeleknek a legmodernebb nyelvi modellek képzésében és kiszolgálásában” – mondta Sundar Pichai, a Google vezérigazgatója egy Las Vegas-i rendezvényen. szerint az ipari médiának.

[Beágyazott tartalmat]

Míg a cél az Nvidia, az amerikai vállalat, amely a grafikus feldolgozóegységként vagy GPU-ként ismert mesterséges intelligencia chipek 90%-át szállítja, kihívást jelent, a Google megmutatta, hogy továbbra is az Nvidiától függ.

Ugyanabban a blogbejegyzés A Google bejelentette legújabb TPU-ját, és bejelentette, hogy frissíti az A3-as szuperszámítógépét, amelyet Nvidia H100 grafikus feldolgozó egységek. A cég azt is elárulta, hogy az Nvidia legújabb GPU-ját, a Blackwell, az AI Hypercomputerben.

A Google emellett kiadta az Axiont, egy új egyedi központi feldolgozó egységet (CPU) az Egyesült Királyság Arm cég technológiájával épített adatközpontokhoz. Azt mondta, hogy az Axion, amely a Microsoft, az Amazon és a Meta CPU-ival vetekszik, különféle feladatokat tud kezelni, beleértve a Google-kereséseket és az AI-műveleteket.

A Google szerint az Axion „30%-kal jobb teljesítményt nyújt, mint a felhőben jelenleg elérhető leggyorsabb, általános célú Arm-alapú példányok”, és „akár 50%-kal jobb teljesítményt és akár 60%-kal jobb energiahatékonyságot” biztosít, mint a többi általános célú Arm. hasábburgonya.

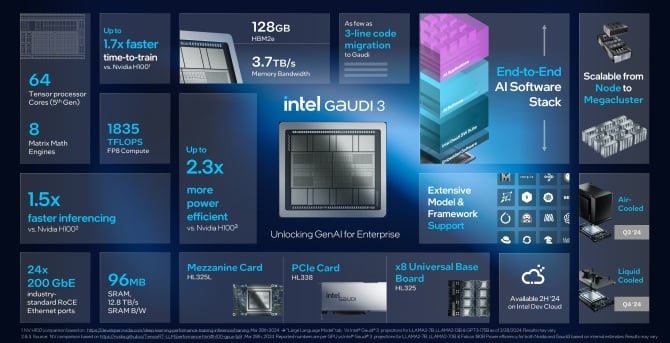

Intel: AI mindenhol

Kedden az Intel bejelentette mesterséges intelligencia processzorának új verziójának, a Gaudi 3-nak a piacra dobását is. A vállalat szerint a Gaudi 3 chip több mint kétszer olyan energiahatékonyabb, mint az Nvidia H100 GPU-ja, és az AI modelleket egyenként futtathatja. félszer gyorsabban.

„Az innováció példátlan ütemben halad előre, mindezt a szilícium lehetővé teszi – és minden vállalat gyorsan mesterséges intelligenciával foglalkozó vállalattá válik” – mondta Pat Gelsinger, az Intel vezérigazgatója. nyilatkozat. „Az Intel a mesterséges intelligenciát mindenhol elhozza a vállalaton belül, a PC-től az adatközponton át egészen a peremig.

????

_🔥🔥🔥_

****🤖****- Mundia Brian (@Mundia_Brian_) April 9, 2024

Gelsinger nem közölte, mennyibe kerülne a Gaudi 3, a Bloomberg jelentések, de azt mondta, hogy cége úgynevezett accelerator chipjei „sokkal alatta maradnak” az Nvidia jelenlegi és jövőbeli chipjeinek. „Rendkívül jó” teljes birtoklási költséget kínálnak majd – tette hozzá.

Az Intel azt állítja, hogy legújabb chipje „jelentős ugrást” fog hozni a mesterséges intelligencia képzésében és a következtetések levonásában a generatív AI-n dolgozó entitások számára. Az AI-rendszereket oktató cégeknek szükségük van rájuk, hogy valós kérdésekre válaszul jóslatokat tudjanak készíteni – ez az úgynevezett következtetés.

Az Intel szerint a Gaudi 3 gyorsabb és energiahatékonyabb lesz, mint a H100, és az összes olyan GPU-val kiképzett nagy nyelvi modell, mint a Meta's Llama vagy az Abu Dhabì többnyelvű Falcon. Azt mondták, hogy a chip segíthet beszédfelismerésre olyan modelleket tanítani, mint a Stable Diffusion vagy az OpenAI Whisper.

A cég szerint az ilyen típusú tréningeken a Gaudi 3 1.7-szer gyorsabb és 1.5-szer jobb a szoftver futtatásában. Az Intel szerint az AI chip teljesítménye összevethető az Nvidia új B200-asával, bizonyos területeken kiváló, máshol pedig lemarad.

Az Intel szerint az új Gaudi 3 chipek a harmadik negyedévben lesznek elérhetők az ügyfelek számára, és olyan cégek, mint a Supermicro, a Dell és a HP, az AI-gyorsítóval fognak rendszereket kiépíteni.

Kihívás Nvidia

A generatív mesterségesintelligencia-rendszereket építő cégek úgy próbálják csökkenteni a költségeket, hogy leszoktatják magukat az Nvidia drága grafikus processzoraira támaszkodva.

James Hamilton szoftvermérnök szerint 2023-ban az Amazon körülbelül 65 millió dollárt költött egyetlen edzésre. Arra számít, hogy ez a szám hamarosan meghaladja az 1 milliárd dollárt.

Egy héttel ezelőtt OpenAI és Microsoft kiderült azt tervezi, hogy 100 milliárd dolláros adatközpontot épít a mesterséges intelligencia képzéséhez, „Stargate” néven. Januárban pedig Mark Zuckerberg, a Meta vezérigazgatója azt mondta, hogy cége 9 milliárd dollárt tervez csak az Nvidia GPU-kra költeni.

Minden nagyobb technológiai cég vásárol chipeket az Nvidiától, de elkezdték építeni a sajátjukat, vagy vásárolnak az AMD-től, amely tavaly bemutatta az új adatközponti GPU-t, az MI300X nevet. Az AMD azt tervezi, hogy ebben az évben terjeszkedik és több mesterséges intelligencia chipet ad el a szervereknek.

A Google versenytársai, a Microsoft, a Meta [mindketten AMD-ügyfelek] és az Amazon szintén kifejlesztették saját mesterségesintelligencia-chipeiket. Ez azonban nem lesz könnyű. Az év elején az Nvidia kiadta B100 és B200 GPU-it, a H100 utódjait, teljesítménynövekedést ígérve. A chipek szállítása várhatóan 2024-ben kezdődik.

A mesterséges intelligencia fellendülése és a H100 megduplázódott Az Nvidia bevételei és több mint 2 billió dollárra emelte piaci értékét, így a Wall Street egyik legsikeresebb vállalata lett.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://metanews.com/google-and-intel-launch-own-ai-chips-as-nvidia-rivalry-heats-up/

- :is

- :nem

- 1 milliárd $

- 65 millió $

- $ 9 milliárd

- $ UP

- 1

- 12

- 2023

- 2024

- 7

- 800

- 9

- a

- Képes

- gázpedál

- Szerint

- át

- hozzáadott

- fejlett

- fejlesztések

- továbbjutó

- Augusztus

- AI

- AI modellek

- AI rendszerek

- AI képzés

- cél

- Minden termék

- kizárólag

- mellett

- Is

- amazon

- AMD

- an

- és a

- bejelentés

- Bemutatjuk

- VANNAK

- területek

- ARM

- körül

- mesterséges

- mesterséges intelligencia

- AS

- At

- elérhető

- BE

- egyre

- mögött

- a színfalak mögött

- Jobb

- Billió

- Bloomberg

- bumm

- fellendítésére

- mindkét

- Brian

- hoz

- Bringing

- épít

- Épület

- épült

- de

- megvesz

- by

- hívott

- TUD

- Központ

- Centers

- központi

- vezérigazgató

- kihívás

- chatbots

- ChatGPT

- csip

- játékpénz

- követelések

- felhő

- Companies

- vállalat

- Társaságé

- hasonló

- versenytársak

- tartalom

- Költség

- kiadások

- Jelenlegi

- szokás

- Ügyfelek

- vágás

- dátum

- Adatközpont

- adatközpontok

- Datacenter

- december

- szállít

- szállít

- DELL

- függő

- tervezett

- fejlett

- fejlesztők

- DID

- Diffusion

- széttöredezik

- kétszeresére

- le-

- szinkronizált

- Korábban

- könnyű

- él

- beágyazott

- engedélyezve

- mérnök

- Vállalkozás

- Szervezetek

- esemény

- Minden

- mindenhol

- Bontsa

- várható

- elvárja

- drága

- gyorsabb

- leggyorsabb

- Ábra

- Cég

- cégek

- vezetéknév

- A

- ból ből

- jövő

- Nyereség

- Gemini

- általános

- Általános rendeltetésű

- generáció

- nemző

- Generatív AI

- Globális

- megy

- A Google Cloud

- GPU

- GPU

- grafika

- Hamilton

- fogantyú

- Legyen

- he

- segít

- segített

- Magas

- övé

- Hogyan

- azonban

- HTTPS

- Kerékagy

- in

- Beleértve

- ipar

- Intel

- Intelligencia

- fokozódik

- Bevezetett

- IT

- ITS

- james

- január

- jpg

- éppen

- ismert

- nyelv

- nagy

- LAS

- Las Vegas

- keresztnév

- Tavaly

- a későbbiekben

- legutolsó

- indít

- indított

- mint

- Láma

- keres

- Sok

- fontos

- csinál

- Gyártás

- jel

- Mark Zuckerberg

- piacára

- max-width

- Média

- meta

- microsoft

- millió

- modellek

- több

- a legtöbb

- sok

- Szükség

- Új

- Most

- Nvidia

- of

- ajánlat

- Régi

- on

- ONE

- OpenAI

- Művelet

- or

- Más

- Egyéb

- felett

- saját

- tulajdon

- Béke

- PC

- teljesítmény

- tervek

- Plató

- Platón adatintelligencia

- PlatoData

- hatalom

- powered

- előző

- Tippek

- feldolgozás

- Processzor

- biztató

- biztosít

- cél

- remeg

- Negyed

- Kérdések

- gyorsan

- Futam

- el

- Olvass

- igazi

- elismerés

- felszabaduló

- támaszkodva

- válasz

- Revealed

- versengés

- rivális

- futás

- futás

- Mondott

- azonos

- azt mondja,

- jelenetek

- keresések

- elad

- Félvezetők

- szolgál

- Szerverek

- Szállítás

- kimutatta,

- jelentős

- Szilícium

- egyetlen

- szoftver

- Software Engineer

- néhány

- nemsokára

- beszéd

- Speech Recognition

- költ

- költött

- stabil

- kezdet

- kezdődött

- Állami

- Még mindig

- utca

- sikeres

- ilyen

- Sundar Pichai

- szuperszámítógép

- készletek

- Systems

- feladatok

- tech

- Technológia

- mint

- hogy

- A

- azok

- Őket

- maguk

- Ezek

- ők

- Harmadik

- ezt

- idén

- három

- áteresztőképesség

- alkalommal

- nak nek

- Végösszeg

- Vonat

- kiképzett

- Képzések

- tréningek

- Trillió

- igaz

- Kedd

- Kétszer

- típus

- Uk

- egység

- egységek

- példátlan

- bemutatta

- frissítve

- us

- segítségével

- Értékelés

- különféle

- VEGAS

- változat

- Fal

- Wall Street

- hét

- JÓL

- ami

- Suttogás

- lesz

- val vel

- dolgozó

- lenne

- év

- még

- youtube

- zephyrnet

- Zuckerberg