Jóval azelőtt, hogy 2023 vége lett volna, ezt már a generatív mesterséges intelligencia évének koronázták. Az olyan modellek megjelenése által, mint a ChatGPT, amelyek részletes, döbbenetesen emberi válaszokat adtak a felhasználói kérésekre, a szakértők és a kezdők egyaránt töprengeni kezdtek a technológia munkára, oktatásra és kreativitásra gyakorolt lehetséges hatásain.

De bár a mai nagy nyelvi modellek (LLM-ek) elképesztően alkalmasak, megdöbbentően sebezhetőek is – mondja Alina Oprea, a Khoury professzora. Több mint egy évtizede tanulmányozza a mesterséges intelligencia kiberbiztonsági összefüggéseit, és nemrégiben társszerzője volt egy olyan jelentésnek, amely az AI elleni támadásokkal foglalkozik – hogyan működnek, hogyan osztályozzák őket, és hogyan lehet (és nem) mérsékelve.

„Nagyon nehéz a generatív AI-t biztonságban tartani” – mondja Oprea. „A modellek mérete és a képzési adataik idővel növekedni fognak, ami csak megkönnyíti ezeket a támadásokat. És amint elkezdünk beszélni a generatív AI-ról, amely túlmutat a szövegen, hanem a képeken és a beszéden, a biztonság nagyon nyitott kérdéssé válik.”

A Kereskedelmi Minisztérium Nemzeti Szabványügyi és Technológiai Intézete (NIST) által közzétett jelentés annak a jelentésnek a frissítése, amelyet Oprea a NIST Apostol Vassilev-vel közösen készített tavaly. Az eredeti jelentés a hagyományosabb prediktív mesterséges intelligenciával foglalkozott, de a generatív mesterséges intelligencia azóta robbanásszerű népszerűsége miatt az Opera és Vassilev üdvözölte a Robust Intelligence generatív AI-szakértőit, Alie Fordyce-t és Hyrum Andersont, hogy kiterjesszék a projekt hatáskörét.

„Most az akadémikusok, a kormány és az ipar együtt dolgoznak – jegyezte meg Oprea –, amely a jelentés célközönsége.

A jelentés szerint a generatív AI-modellek számos tényezőnek köszönhetik sebezhetőségüket. Egyrészt megjegyzi Oprea, hogy a legtöbb támadás „meglehetősen könnyen felszerelhető, és minimális tudást igényel az AI-rendszerről”. Másrészt a modellek hatalmas képzési adatkészletei túl nagyok ahhoz, hogy az emberek ellenőrizzék és validálják. A modelleket alátámasztó kód pedig nem automatizált; az emberi mértéktartásra támaszkodik, és ki van téve a rosszindulatú emberi beavatkozásnak.

A kutatók kvartettje szerint a végeredmény a támadások négy fő típusa, amelyek összezavarják az AI-rendszereket és hibás működést okoznak: az adócsalási támadások, amelyek megváltoztatják a modell bemeneteit a válaszok megváltoztatása érdekében, a mérgező támadások, amelyek megrongálják a modell mögöttes algoritmusait vagy képzési adatait, valamint a magánélet védelmét. olyan támadások, amelyek arra késztetik a modellt, hogy érzékeny képzési adatokat, például orvosi információkat tárjanak fel, és visszaélésszerű támadások, amelyek helytelen információkat táplálnak be legitim forrásokba, amelyekből a modell tanul. A modell bemeneteinek manipulálásával a támadók előre kiválaszthatják a modell kimeneteit.

„Ez felhasználható kereskedelmi célokra, reklámozásra, rosszindulatú spam vagy gyűlöletbeszéd generálására – olyan dolgokra, amelyeket a modell általában nem generál” – magyarázza Oprea.

A rosszindulatú szereplők anélkül, hogy túlterhelnék magukat, irányíthatják a webes adatokat, amelyeken az AI-modell edz, bevezethetnek egy hátsó ajtót, majd onnan lopva irányíthatják a modell viselkedését. Tekintettel ezeknek a modelleknek a rohamosan növekvő népszerűségére, az ilyen hátsó ajtók önmagukban is eléggé aggasztóak lennének. De a kár nem ér véget.

„Most már megvannak ezek az integrált alkalmazásaink, amelyek LLM-eket használnak. Például egy vállalat létrehoz egy e-mail ügynököt, amely integrálódik egy LLM-be a háttérben, és most már képes elolvasni az Ön e-mailjeit és e-maileket küldeni az Ön nevében” – mondja Oprea. „De a támadók ugyanazt az eszközt használhatják rosszindulatú programok és spamek küldésére több ezer embernek. A támadási felület megnövekedett, mert az LLM-eket integráljuk ezekbe az alkalmazásokba.”

Bármilyen pusztító és veszélyes is a gyűlöletbeszéd és a tömeges spam, még nagyobb biztonsági aggályok vannak a láthatáron.

„Egyes alkalmazások biztonsági szempontból kritikusak, például az önvezető autók” – mondja Oprea. "Ha ezek a modellek helytelen jóslatokat adnak, nem használhatók."

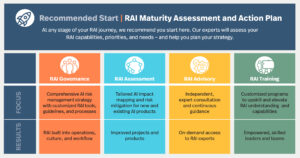

Szóval mit lehet tenni? A csapat elkészítette a jelentést, amelyet évente frissítenek, néhány közönség számára – politikai döntéshozók, mesterséges intelligencia-fejlesztők és akadémikusok számára, akik a jelentés taxonómiáját alapként vagy kontextusként használhatják saját munkájukhoz. Oprea szerint ezeknek a csoportoknak mindannyian tenniük kell azért, hogy az AI-modellek igazodjanak az emberi értékekhez, megőrizzék a magánéletet, és a felhasználók érdekeit szolgálják. De elismeri, hogy a jelentésben felvetett valamennyi probléma megoldása kihívást jelent, és hogy aki inkább megoldásokat keres, mintsem enyhítéseket, az súlyosan téved.

"Sokkal több a támadás, mint a mérséklés, és minden általunk említett mérséklésnél kompromisszum vagy teljesítménybeli többletköltség van, beleértve a modell pontosságának csökkenését" - figyelmeztet Oprea. "A mérséklések nem járnak ingyen, és az AI biztosítása valóban nagy kihívást jelent, de reméljük, hogy a jelentés hasznos kiindulópontot ad a támadások megértéséhez."

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://www.mtlc.co/in-the-age-of-chatgpt-ai-models-are-massively-popular-and-easily-compromised/

- :van

- :is

- 2023

- a

- Rólunk

- visszaélés

- tudósok

- pontosság

- szereplők

- címzés

- előre

- megérkezés

- Hirdetés

- kor

- Ügynök

- AI

- AI modellek

- AI rendszerek

- algoritmusok

- összehangolása

- hasonló

- Minden termék

- már

- Is

- változtat

- an

- és a

- Anderson

- Évente

- Másik

- bárki

- alkalmazások

- VANNAK

- AS

- támadás

- Támadások

- közönség

- közönség

- Automatizált

- hátsó ajtó

- Hátsóajtó

- háttér

- BE

- mert

- válik

- óta

- előtt

- kezdődött

- nevében

- viselkedés

- BEST

- Túl

- nagyobb

- épít

- de

- by

- TUD

- képes

- autók

- Okoz

- figyelmeztet

- kihívást

- változik

- ChatGPT

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- osztályozott

- kód

- hogyan

- kereskedelmi

- vállalat

- Veszélyeztetett

- vonatkozó

- aggodalmak

- kontextus

- ellenőrzés

- megvesztegethető

- tudott

- Tanács

- kreativitás

- Kiberbiztonság

- kár

- Veszélyes

- dátum

- adatkészletek

- foglalkozott

- évtized

- elmélyül

- osztály

- részletes

- fejlesztők

- nehéz

- do

- Nem

- csinált

- ne

- könnyebb

- könnyen

- könnyű

- Oktatás

- e-mailek

- törekvés

- véget ért

- hatalmas

- elég

- biztosítására

- adócsalás

- Még

- Minden

- példa

- Bontsa

- szakértők

- Elmagyarázza

- kitett

- tényezők

- kevés

- A

- Alapítvány

- négy

- Ingyenes

- ból ből

- generál

- generáló

- nemző

- Generatív AI

- adott

- Goes

- Kormány

- Csoportok

- Nő

- kellett

- gyűlölet

- Legyen

- remény

- horizont

- Hogyan

- HTTPS

- emberi

- Az emberek

- képek

- Hatások

- in

- Beleértve

- hibás

- <p></p>

- ipar

- információ

- kezdetben

- bemenet

- Intézet

- integrált

- integrál

- integrálása

- Intelligencia

- szándékolt

- kamat

- bele

- bevezet

- kérdés

- IT

- ITS

- Tart

- tudás

- nyelv

- nagy

- keresztnév

- Tavaly

- Vezetés

- tanul

- jogos

- mint

- LLM

- fontos

- csinál

- KÉSZÍT

- rosszindulatú

- malware

- manipuláló

- sok

- Tömeg

- masszívan

- orvosi

- említ

- minimális

- enyhítés

- modell

- modellek

- mérséklet

- monitor

- több

- a legtöbb

- SZERELJÜK

- nemzeti

- nst

- neves

- Megjegyzések

- kezdők

- Most

- of

- on

- egyszer

- ONE

- csak

- nyitva

- Opera

- működik

- or

- kimenetek

- felett

- felső

- saját

- Emberek (People)

- teljesítmény

- terv

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- mérgezés

- politikusok

- Népszerű

- népszerűség

- potenciális

- Tippek

- előkészített

- magánélet

- Készült

- Egyetemi tanár

- projektek

- utasításokat

- biztosít

- közzétett

- célokra

- kérdés

- emelt

- Inkább

- Olvass

- tényleg

- nemrég

- támaszkodik

- jelentést

- szükség

- kutatók

- válaszok

- felfedve

- erős

- azonos

- azt mondják

- azt mondja,

- Skála

- biztonság

- biztosítása

- biztonság

- self-vezetés

- küld

- érzékeny

- Szettek

- ő

- óta

- Megoldások

- Források

- spam

- beszéd

- szabványok

- kezdet

- Kezdve

- tinó

- megáll

- Tanul

- ilyen

- felületi

- rendszer

- Systems

- beszéd

- taxonómia

- csapat

- tech

- Technológia

- szöveg

- mint

- hogy

- A

- azok

- Őket

- maguk

- akkor

- Ott.

- Ezek

- ők

- dolgok

- azok

- ezer

- idő

- nak nek

- mai

- együtt

- is

- szerszám

- hagyományos

- Képzések

- vonatok

- típusok

- mögöttes

- alátámasztó

- megértés

- Frissítések

- használ

- használt

- hasznos

- használó

- Felhasználók

- rendszerint

- ÉRVÉNYESÍT

- Értékek

- fajta

- nagyon

- sebezhetőség

- Sebezhető

- we

- háló

- üdvözölte

- Mit

- ami

- míg

- WHO

- lesz

- val vel

- Munka

- dolgozó

- lenne

- év

- te

- A te

- zephyrnet