A mesterséges intelligencia könnyben van. A gépek beszélhetnek, írhatnak, játszhatnak, és eredeti képeket, videókat és zenét generálhatnak. De ahogy az AI képességei nőttek, úgy nőttek az algoritmusai is.

Egy évtizeddel ezelőtt gépi tanulási algoritmusok több tízmillió belső kapcsolatra támaszkodott, vagy paramétereket. A mai algoritmusok rendszeresen elérik a százmilliárdokat és akár több billió paramétert. A kutatók szerint a méretnövelés továbbra is teljesítménynövekedést eredményez, és rövid időn belül megérkezhetnek a több tíz billió paraméterrel rendelkező modellek.

Ekkora modellek betanításához nagy teljesítményű számítógépekre van szükség. Míg a 2010-es évek elején a mesterséges intelligencia néhány grafikus feldolgozó egységen futott – olyan számítógépes chipeken, amelyek kiválóan teljesítenek a mesterséges intelligencia szempontjából kulcsfontosságú párhuzamos feldolgozásban –, számítástechnikai igények kielégítésére. exponenciálisan nőttek, és a csúcsmodellek ma már több százat vagy ezret igényelnek. OpenAI, microsoft, meta, mások pedig dedikált szuperszámítógépeket építenek a feladat elvégzésére, és azt mondják, hogy ezek az AI-gépek a bolygó leggyorsabbjai közé tartoznak.

Ám annak ellenére, hogy a GPU-k kulcsfontosságúak az AI-skálázásban – például az Nvidia A100-a még mindig az egyik leggyorsabb, leggyakrabban használt chip az AI-fürtökben –, az elmúlt években furcsább, kifejezetten mesterséges intelligencia számára tervezett alternatívák bukkantak fel.

A Cerebras egy ilyen alternatívát kínál.

MI étel elkészítése

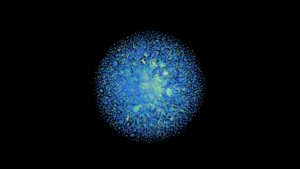

Egy tányér méretű – körülbelül 8.5 hüvelyk oldalra – a cég Wafer Scale Engine a legnagyobb szilícium chip a világon2.6 billió tranzisztorral és 850,000 2 maggal, egyetlen szilícium lapkára marva. Mindegyik Wafer Scale Engine a vállalat CS-XNUMX számítógépének szíve.

Egyedül a CS-2 egy vadállat, de tavaly Cerebras bemutatott egy tervet a CS-2-ket összekapcsolni a MemoryX nevű külső memóriarendszerrel és a SwarmX nevű CS-2-ket összekötő rendszerrel. A cég szerint az új technológia akár 192 chipet is összekapcsolhat, és két nagyságrenddel nagyobb modelleket képezhet, mint a mai legnagyobb, legfejlettebb mesterséges intelligencia.

"Az iparág túllép az 1 billió paraméteres modelleken, és ezt a határt két nagyságrenddel kiterjesztjük, lehetővé téve az agyi léptékű neurális hálózatok létrehozását 120 billió paraméterrel" - mondta Andrew Feldman, a Cerebras vezérigazgatója és társalapítója.

Akkoriban mindez elméleti volt. De a múlt héten a cég bejelentette 16 CS-2-t kapcsoltak össze egy világszínvonalú AI szuperszámítógéppé.

Ismerje meg Andromedát

Az Andromeda nevű új gép 13.5 millió maggal rendelkezik, amelyek egy exaflop (másodpercenként egy kvintimillió művelet) sebességre képesek 16 bites fél pontossággal. A magjában lévő egyedi chip miatt az Andromeda nem hasonlítható össze a hagyományosabb CPU-kon és GPU-kon futó szuperszámítógépekkel, de Feldman elmondta HPC vezeték Az Andromeda nagyjából egyenértékű az Argonne National Laboratory Polaris szuperszámítógépével, amely A 17. leggyorsabb a világon, a legújabb Top500-as lista szerint.

A teljesítmény mellett figyelemre méltó az Andromeda gyors felépítési ideje, költsége és lábnyoma. Argonne megkezdte a Polaris telepítését 2021 nyarán, és a szuperszámítógép körülbelül egy évvel később élesben indult. 40 állványt foglal el, az iratszekrény-szerű házakban szuperszámítógép-alkatrészek helyezkednek el. Összehasonlításképpen, az Andromeda 35 millió dollárba került – ez szerény ár egy ilyen erejű gépért – csak három nap az összeszerelésig, és mindössze 16 állványt használ.

A Cerebras az OpenAI nagy nyelvi modelljének, a GPT-3-nak, valamint az Eleuther AI nyílt forráskódú GPT-J-nek és a GPT-NeoX-nek öt változatának betanításával tesztelte a rendszert. Cerebras szerint pedig a legfontosabb felfedezés az, hogy az Andromeda bemutatta az AI-munkaterhelések „közel tökéletes lineáris skálázását” nagy nyelvi modelleknél. Röviden, ez azt jelenti, hogy ahogy további CS-2-ket adnak hozzá, az edzési idők arányosan csökkennek.

A vállalat azt mondta, hogy a teljesítménynövekedés csökken, ha több zsetont ad hozzá. A Cerebras WSE chipje viszont hatékonyabbnak bizonyulhat, mert 850,000 XNUMX magja ugyanazon a szilíciumdarabon kapcsolódik egymáshoz. Ráadásul minden magnak van egy memóriamodulja a szomszédban. Összességében a chip csökkenti a magok és a memória közötti adatátvitelre fordított időt.

„A lineáris skálázás azt jelenti, hogy amikor egy rendszerről két rendszerre vált, feleannyi ideig tart a munka befejezése. Ez egy nagyon szokatlan tulajdonság a számítástechnikában” – mondta Feldman HPC vezeték. És azt mondta, hogy 16 összekapcsolt rendszeren túl is skálázható.

A Cerebras saját tesztelésein túlmenően a lineáris skálázási eredményeket az Argonne National Laboratory-ban végzett munka során is bemutatták, ahol a kutatók Andromeda segítségével betanították a GPT-3-XL nagynyelvi algoritmust a Covid-19 genom hosszú szekvenciáin.

Természetesen, bár a rendszer 16 CS-2-nél tovább is skálázható, a lineáris skálázás mértéke továbbra is meglátszik. Ezenkívül még nem tudjuk, hogy a Cerebras hogyan teljesít egymás mellett más AI chipekkel szemben. Az AI chipgyártók, például az Nvidia és az Intel megkezdték rendszeres harmadik fél teljesítményértékelésében való részvétel olyanok, mint az MLperf. A Cerebrák még nem vettek részt.

Hely tartalék

Still, the approach does appear to be carving out its own niche in the world of supercomputing, and continued scaling in large language AI is a prime use case. Indeed, Feldman mondta Vezetékes tavaly hogy a vállalat már a nagy nyelvi modellek piacán vezető OpenAI mérnökeivel beszélgetett. (Az OpenAI alapítója, Sam Altman szintén a Cerebras befektetője.)

A 2020-as kiadáskor az OpenAI nagy nyelvi modellje, a GPT-3 megváltoztatta a játékot mind a teljesítmény, mind a méret tekintetében. 175 milliárd paraméterével ez volt a legnagyobb mesterséges intelligencia modell akkoriban, és meglepte a kutatókat képességeivel. Azóta a nyelvi modellek a paraméterek billióit értek el, és nagyobb modellek is megjelenhetnek. Vannak pletykák– egyelőre csak annyit –, hogy az OpenAI a nem túl távoli jövőben kiadja a GPT-4-et, és ez újabb ugrás lesz a GPT-3-hoz képest. (Várnunk kell, és meglátjuk ezt a számot.)

That said, despite their capabilities, large language models are neither perfect nor universally adored. Their flaws include output that can be false, biased, and offensive. Meta’s Galactica, trained on scientific texts, is a recent example. Despite a dataset one might assume is less prone to toxicity than training on the open internet, the model was easily provoked into generating harmful and inaccurate text and pulled down in just three days. Whether researchers can solve language AI’s shortcomings remains uncertain.

But it seems likely that scaling up will continue until diminishing returns kick in. The next leap could be just around the corner—and we may already have the hardware to make it happen.

Kép: Cerebrák