Az OpenAI az iparági vezetők, köztük az Amazon, az Anthropic, a Civitai, a Google, a Meta, a Metaphysic, a Microsoft, a Mistral AI és a Stability AI mellett elkötelezte magát amellett, hogy robusztus gyermekbiztonsági intézkedéseket hajt végre a generatív mesterséges intelligencia-technológiák fejlesztése, telepítése és karbantartása során, ahogyan azt a dokumentumban megfogalmazták. a tervezési biztonság elveit. Ez a kezdeményezés, melynek élén Tüske, egy nonprofit szervezet, amely a gyermekek szexuális visszaélésekkel szembeni védelmével foglalkozik, és Minden Tech EmberA technológia és a társadalom összetett problémáival foglalkozó szervezet célja, hogy csökkentse a generatív mesterséges intelligencia gyermekekre jelentett kockázatait. Az átfogó Safety by Design elvek elfogadásával az OpenAI és társaink biztosítják, hogy a gyermekek biztonsága prioritást élvezzen az AI fejlesztésének minden szakaszában. A mai napig jelentős erőfeszítéseket tettünk annak érdekében, hogy minimálisra csökkentsük modelljeink lehetőségét, hogy gyermekeket károsító tartalmat állítsanak elő, korhatárokat állítsunk be a ChatGPT számára, és aktívan együttműködjünk az Eltűnt és Kizsákmányolt Gyermekek Nemzeti Központjával (NCMEC), a Tech Coalition-tal és más kormányzattal. és az iparág érdekelt felei a gyermekvédelmi kérdésekről és a jelentési mechanizmusok továbbfejlesztéséről.

A Safety by Design erőfeszítés részeként kötelezettséget vállalunk a következőkre:

-

Fejleszteni: Generatív AI-modellek fejlesztése, építése és betanítása

amelyek proaktívan kezelik a gyermekbiztonsági kockázatokat.-

Felelősségteljesen szerezze be képzési adatkészleteinket, észlelje és távolítsa el a gyermekek szexualitását

bántalmazási anyagok (CSAM) és gyermekek szexuális kizsákmányolása (CSEM) származó anyagok

a képzési adatokat, és jelentse a megerősített CSAM-ot az illetékesnek

hatóság. -

Szereljen be visszacsatolási hurkokat és iteratív stressz-tesztelési stratégiákat

fejlesztési folyamatunkat. - Vezessen be megoldásokat az ellenséges visszaélések kezelésére.

-

Felelősségteljesen szerezze be képzési adatkészleteinket, észlelje és távolítsa el a gyermekek szexualitását

-

Telepítés: A generatív AI modellek kiadása és terjesztése után

a gyermekek biztonsága érdekében kiképezték és értékelték őket, biztosítva a védelmet

az egész folyamat során.-

Harcolj és reagálj visszaélésszerű tartalomra és magatartásra, és építs be

megelőző erőfeszítéseket. - Ösztönözze a fejlesztők tulajdonjogát a tervezési biztonság terén.

-

Harcolj és reagálj visszaélésszerű tartalomra és magatartásra, és építs be

-

Karbantartás: Folytassa a modell és a platform biztonságának megőrzését

a gyermekbiztonsági kockázatok aktív megértése és reagálása.-

Elkötelezettek vagyunk amellett, hogy eltávolítsuk a rossz szereplők által generált új AIG-CSAM-ot a mi kínálatunkból

platform. - Fektessen be a kutatásba és a jövőbeli technológiai megoldásokba.

- Küzdj a CSAM, AIG-CSAM és CSEM ellen platformjainkon.

-

Elkötelezettek vagyunk amellett, hogy eltávolítsuk a rossz szereplők által generált új AIG-CSAM-ot a mi kínálatunkból

Ez az elkötelezettség fontos lépést jelent a mesterséges intelligencia technológiákkal való visszaélések megelőzésében a gyermekek szexuális zaklatását tartalmazó anyagok (AIG-CSAM) és a gyermekek elleni szexuális bántalmazás egyéb formáinak létrehozására vagy terjesztésére. A munkacsoport részeként megállapodtunk abban is, hogy minden évben közzétesszük az előrehaladásról szóló frissítéseket.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://openai.com/blog/child-safety-adopting-sbd-principles

- :van

- :is

- 39

- 40

- a

- visszaélés

- aktívan

- szereplők

- cím

- Elfogadása

- ellenséges

- Után

- ellen

- kor

- egyeztetett

- AI

- AI modellek

- célok

- mellett

- Is

- amazon

- an

- és a

- Antropikus

- bármilyen

- VANNAK

- AS

- At

- Hatóság

- Rossz

- óta

- épít

- by

- Központ

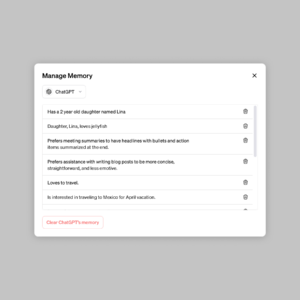

- ChatGPT

- gyermek

- Gyermekvédelem

- Gyerekek

- koalíció

- elleni küzdelem

- elkövetni

- elkötelezettség

- elkötelezett

- bonyolult

- átfogó

- Magatartás

- MEGERŐSÍTETT

- tartalom

- folyamatos

- teremt

- dátum

- adatkészletek

- találka

- elszánt

- Védekezés

- bevetés

- Design

- tervezési elvek

- kimutatására

- Fejleszt

- Fejlesztő

- Fejlesztés

- terjeszteni

- erőfeszítés

- erőfeszítések

- vegyenek

- fejlesztések

- biztosítása

- értékelték

- Minden

- kizsákmányolás

- Hasznosított

- Visszacsatolás

- A

- formák

- ból ből

- jövő

- Jövő technológiája

- generál

- generált

- nemző

- Generatív AI

- Kormány

- Csoport

- kárt

- ártalmak

- Legyen

- http

- HTTPS

- végrehajtási

- fontos

- in

- Beleértve

- bele

- ipar

- Kezdeményezés

- kérdések

- vezetők

- Led

- készült

- karbantartás

- anyag

- intézkedések

- mechanizmusok

- meta

- microsoft

- minimalizálása

- hiányzó

- visszaélés

- Enyhít

- modell

- modellek

- nemzeti

- Új

- nonprofit

- of

- on

- OpenAI

- or

- szervezet

- Más

- mi

- tulajdon

- rész

- társaik

- emelvény

- Platformok

- Plató

- Platón adatintelligencia

- PlatoData

- pózok

- potenciális

- megakadályozása

- Megelőzés

- elvek

- fontossági sorrendbe

- problémák

- folyamat

- Haladás

- védelem

- amely

- engedje

- eltávolítása

- eltávolítása

- jelentést

- Jelentő

- kutatás

- Reagálni

- felelősségteljesen

- korlátozások

- kockázatok

- erős

- s

- Biztonság

- készlet

- Szexuális

- jelentős

- Társadalom

- Megoldások

- forrás

- terjedése

- Stabilitás

- Színpad

- érdekeltek

- Lépés

- stratégiák

- szerelések

- tech

- Technologies

- Technológia

- hogy

- A

- ők

- ezt

- egész

- nak nek

- Vonat

- kiképzett

- Képzések

- megért

- Frissítés

- we

- val vel

- dolgozó

- Munkacsoport

- év

- zephyrnet