Ez AK Roy vendégbejegyzése a Qualcomm AI-tól.

Amazon Elastic Compute Cloud (Amazon EC2) A Qualcomm AI 2 Standard gyorsítókkal működő DL100q-példányok költséghatékonyan használhatók a mélytanulási (DL) munkaterhelések felhőben történő telepítésére. Használhatók a Qualcomm eszközökön telepített DL-munkaterhelések teljesítményének és pontosságának fejlesztésére és ellenőrzésére is. A DL2q példányok az első olyan példányok, amelyek a Qualcomm mesterséges intelligens (AI) technológiáját a felhőbe juttatják.

A nyolc Qualcomm AI 100 Standard gyorsítóval és a 128 GiB teljes gyorsítómemóriával az ügyfelek a DL2q-példányokat is használhatják olyan népszerű generatív mesterségesintelligencia-alkalmazások futtatására, mint a tartalomgenerálás, szövegösszegzés és virtuális asszisztensek, valamint a klasszikus mesterséges intelligencia-alkalmazások természetes nyelvi feldolgozásra. és a számítógépes látás. Ezenkívül a Qualcomm AI 100 gyorsítók ugyanazt a mesterséges intelligencia technológiát tartalmazzák, amelyet az okostelefonokon, autonóm vezetésen, személyi számítógépeken és kiterjesztett valóságú fejhallgatókon is alkalmaznak, így a DL2q példányok felhasználhatók ezen AI-munkaterhelések fejlesztésére és érvényesítésére a telepítés előtt.

Új DL2q-példányok

Minden DL2q példány nyolc Qualcomm Cloud AI100 gyorsítót tartalmaz, amelyek összesített teljesítménye több mint 2.8 PetaOps Int8 következtetési teljesítmény és 1.4 PetaFlops FP16 következtetési teljesítmény. A példány összesen 112 AI maggal, 128 GB-os gyorsítómemóriakapacitással és 1.1 TB/s memória sávszélességgel rendelkezik.

Minden DL2q példány 96 vCPU-val, 768 GB rendszermemória kapacitással és 100 Gbps hálózati sávszélességgel rendelkezik, valamint Amazon Elastic Block Store (Amazon EBS) 19 Gbps tárhely.

| Példány neve | vCPU-k | Cloud AI100 gyorsítók | Gyorsító memória | Gyorsító memória BW (összesített) | Példány memória | Példányhálózat | Tárolási (Amazon EBS) sávszélesség |

| DL2q.24xnagy | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100 gyorsító innováció

A Cloud AI100 gyorsító rendszer-chip (SoC) egy erre a célra épített, méretezhető többmagos architektúra, amely az adatközponttól a szélekig terjedő mélytanulási felhasználási esetek széles skáláját támogatja. Az SoC skalár-, vektor- és tenzorszámítási magokat alkalmaz, 126 MB-os, iparágvezető on-die SRAM-kapacitással. A magok nagy sávszélességű, alacsony késleltetésű hálózaton-chip (NoC) hálóval vannak összekapcsolva.

Az AI100 gyorsító a modellek és használati esetek széles és átfogó skáláját támogatja. Az alábbi táblázat kiemeli a modelltámogatás tartományát.

| Modell kategória | Modellek száma | Példák |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z-kódos MOE |

| Generatív AI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Generatív AI – Kép | 3 | Stabil diffúzió v1.5 és v2.1, OpenAI CLIP |

| CV – Képosztályozás | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Tárgyérzékelés | 23 | YOLO v2, v3, v4, v5 és v7, SSD-ResNet, RetinaNet |

| CV – Egyéb | 15 | LPRNet, szuperfelbontású/SRGAN, ByteTrack |

| Autóipari hálózatok* | 53 | Érzékelés és LIDAR, gyalogos, sáv és közlekedési lámpa érzékelés |

| Teljes | > 300 . | . |

* A legtöbb autóipari hálózat összetett hálózat, amely egyedi hálózatok fúziójából áll.

A DL2q gyorsítón található nagyméretű SRAM lehetővé teszi olyan fejlett teljesítménytechnikák hatékony megvalósítását, mint az MX6-os mikro-exponens pontosság a súlyok tárolására és az MX9-es mikro-kitevő pontosság a gyorsító-gyorsító közötti kommunikációhoz. A mikroexponens technológiát az Open Compute Project (OCP) következő iparági közleménye ismerteti: Az AMD, az Arm, az Intel, a Meta, a Microsoft, az NVIDIA és a Qualcomm szabványosítja a következő generációs szűk precíziós adatformátumokat a mesterséges intelligencia számára » Open Compute Project.

A példány felhasználója a következő stratégiát használhatja a költségenkénti teljesítmény maximalizálására:

- Tárolja a súlyokat az MX6 mikrokitevő pontossággal a gyorsító DDR memóriájában. Az MX6 precizitás használata maximalizálja a rendelkezésre álló memóriakapacitás és a memória sávszélesség kihasználását, hogy kategóriájában a legjobb átviteli sebességet és késleltetést biztosítsa.

- Számítson az FP16-ban a szükséges használati eset pontosságának elérése érdekében, miközben a kiváló chipen lévő SRAM-ot és a kártya tartalék TOP-jait használja a nagy teljesítményű, alacsony késleltetésű MX6-FP16 kernelek megvalósításához.

- Használjon optimalizált kötegelési stratégiát és nagyobb kötegméretet a rendelkezésre álló nagyméretű chipen lévő SRAM használatával, hogy maximalizálja a súlyok újrafelhasználását, miközben a lehető legnagyobb mértékben megőrzi az aktiválásokat a chipen.

DL2q AI Stack és szerszámlánc

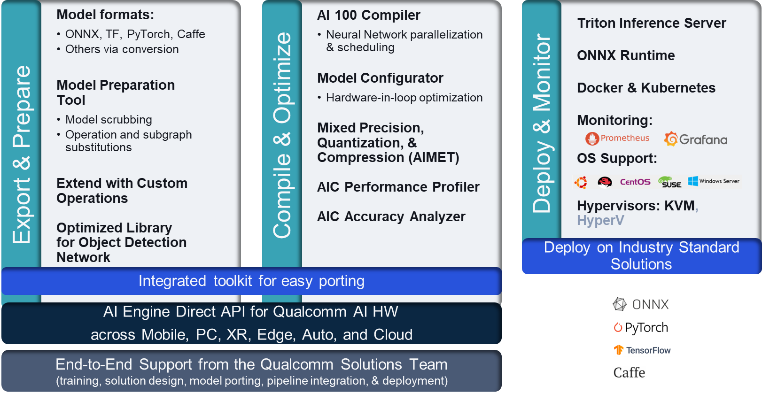

A DL2q példányt a Qualcomm AI Stack kíséri, amely egységes fejlesztői élményt biztosít a Qualcomm AI felhőben és más Qualcomm termékekben. Ugyanaz a Qualcomm AI stack és alap AI technológia fut a DL2q példányokon és a Qualcomm edge eszközökön, egységes fejlesztői élményt biztosítva az ügyfeleknek, egységes API-val a felhőben, az autóiparban, a személyi számítógépekben, a kiterjesztett valóságban és az okostelefonos fejlesztői környezetekben.

Az eszközlánc lehetővé teszi a példány felhasználójának, hogy gyorsan beépítsen egy korábban betanított modellt, lefordítsa és optimalizálja a modellt a példány képességeihez, majd a következő ábrán látható három lépésben üzembe helyezze a lefordított modelleket a termelési következtetés használati eseteihez.

Ha többet szeretne megtudni a modell teljesítményének hangolásáról, tekintse meg a A Cloud AI 100 kulcsfontosságú teljesítményparaméterei Dokumentáció.

Kezdje el a DL2q példányokat

Ebben a példában egy előre betanított verziót fordít le és telepít BERT modell ból ből Átölelő arc egy EC2 DL2q példányon egy előre beépített DL2q AMI használatával, négy lépésben.

Használhat akár előre elkészített Qualcomm DLAMI a példányon, vagy kezdjen egy Amazon Linux2 AMI-vel, és készítse el saját DL2q AMI-jét az itt elérhető Cloud AI 100 Platform és Apps SDK segítségével Amazon Simple Storage Service (Amazon S3) vödör: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

A következő lépések az előre beépített DL2q AMI-t használják, Qualcomm Base AL2 DLAMI.

Használja az SSH-t a DL2q-példány eléréséhez a Qualcomm Base AL2 DLAMI AMI segítségével, és kövesse az 1–4. lépéseket.

1. lépés Állítsa be a környezetet és telepítse a szükséges csomagokat

- Telepítse a Python 3.8-et.

- Állítsa be a Python 3.8 virtuális környezetet.

- Aktiválja a Python 3.8 virtuális környezetet.

- Telepítse a szükséges csomagokat, az ábrán látható módon követelmények.txt dokumentumot elérhető a Qualcomm nyilvános Github webhelyén.

- Importálja a szükséges könyvtárakat.

2. lépés Importálja a modellt

- Importálja és tokenizálja a modellt.

- Határozzon meg egy minta bemenetet, és vegye ki a

inputIdsés aattentionMask. - Alakítsa át a modellt ONNX-re, amelyet ezután átadhat a fordítónak.

- A modellt FP16 pontossággal futtatja. Tehát ellenőriznie kell, hogy a modell tartalmaz-e az FP16 tartományon kívüli konstansokat. Adja át a modellt a

fix_onnx_fp16funkciót az új ONNX fájl létrehozásához a szükséges javításokkal.

3. lépés: Állítsa össze a modellt

A qaic-exec parancssori felület (CLI) fordítóeszközt használnak a modell fordításához. A fordító bemenete a 2. lépésben generált ONNX fájl. A fordító egy bináris fájlt (ún. QPC, A Qualcomm programtároló) által meghatározott útvonalon -aic-binary-dir érv.

Az alábbi fordítási parancsban négy AI számítási magot és egy kötegméretet használ a modell összeállításához.

A QPC a bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc mappát.

4. lépés Futtassa a modellt

Állítson be egy munkamenetet a következtetés futtatásához a Cloud AI100 Qualcomm gyorsítón a DL2q példányban.

A Qualcomm qaic Python könyvtár olyan API-készlet, amely támogatja a következtetések futtatását a Cloud AI100 gyorsítón.

- Használja a Session API-hívást a munkamenet példányának létrehozásához. A Session API-hívás a belépési pont a qaic Python-könyvtár használatához.

- Strukturálja át az adatokat a kimeneti pufferből a következővel:

output_shapeés aoutput_type. - Dekódolja az előállított kimenetet.

Itt vannak a „The dog [MASK] on the mat” bemeneti mondat kimenetei.

Ez az. Néhány lépéssel összeállított és futtatott egy PyTorch-modellt egy Amazon EC2 DL2q példányon. Ha többet szeretne megtudni a modellek beépítéséről és fordításáról a DL2q példányon, lásd a Cloud AI100 oktatóanyag.

Ha többet szeretne megtudni arról, hogy mely DL-modellarchitektúrák illenek jól az AWS DL2q-példányokhoz és a jelenlegi modelltámogatási mátrixhoz, tekintse meg a Qualcomm Cloud AI100 dokumentáció.

Most elérhető

Ma elindíthatja a DL2q példányokat az Egyesült Államok nyugati (Oregon) és európai (Frankfurt) AWS régióiban, mint Igény szerint, Fenntartottés Helyszínpéldányok, vagy részeként a Megtakarítási terv. Az Amazon EC2-nél megszokott módon csak azért fizet, amit használ. További információkért lásd Amazon EC2 árazás.

A DL2q példányok a segítségével telepíthetők AWS Deep Learning AMI (DLAMI), és a tárolóképek olyan felügyelt szolgáltatásokon keresztül érhetők el, mint pl Amazon SageMaker, Amazon Elastic Kubernetes Service (Amazon EKS), Amazon Elastic Container Service (Amazon ECS)és AWS ParallelCluster.

További információért látogasson el a Amazon EC2 DL2q példány oldalon, és küldjön visszajelzést a címre AWS re:Post for EC2 vagy a szokásos AWS ügyfélszolgálati elérhetőségein keresztül.

A szerzőkről

AK Roy a Qualcomm termékmenedzsmentért felelős igazgatója a felhő- és adatközponti mesterséges intelligencia termékekért és megoldásokért. Több mint 20 éves tapasztalattal rendelkezik a termékstratégia és -fejlesztés terén, amelynek középpontjában jelenleg a legjobb teljesítmény és teljesítmény/$ end-to-end megoldások állnak az AI következtetésekhez a felhőben, a felhasználási esetek széles körében. beleértve a GenAI-t, az LLM-eket, az automatikus és hibrid AI-t.

AK Roy a Qualcomm termékmenedzsmentért felelős igazgatója a felhő- és adatközponti mesterséges intelligencia termékekért és megoldásokért. Több mint 20 éves tapasztalattal rendelkezik a termékstratégia és -fejlesztés terén, amelynek középpontjában jelenleg a legjobb teljesítmény és teljesítmény/$ end-to-end megoldások állnak az AI következtetésekhez a felhőben, a felhasználási esetek széles körében. beleértve a GenAI-t, az LLM-eket, az automatikus és hibrid AI-t.

Jianying Lang az AWS Worldwide Specialist Organization (WWSO) vezető megoldási építésze. Több mint 15 éves tapasztalattal rendelkezik a HPC és az AI területén. Az AWS-nél arra összpontosít, hogy segítse az ügyfeleket az AI/ML munkaterhelésük gyorsított számítási példányokon történő üzembe helyezésében, optimalizálásában és méretezésében. Szenvedélyesen ötvözi a HPC és az AI technikáit. Jianying a Boulder-i Colorado Egyetemen szerzett PhD fokozatot számítógépes fizikából.

Jianying Lang az AWS Worldwide Specialist Organization (WWSO) vezető megoldási építésze. Több mint 15 éves tapasztalattal rendelkezik a HPC és az AI területén. Az AWS-nél arra összpontosít, hogy segítse az ügyfeleket az AI/ML munkaterhelésük gyorsított számítási példányokon történő üzembe helyezésében, optimalizálásában és méretezésében. Szenvedélyesen ötvözi a HPC és az AI technikáit. Jianying a Boulder-i Colorado Egyetemen szerzett PhD fokozatot számítógépes fizikából.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :van

- :is

- $ UP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 év

- 15%

- 17

- 19

- 20

- 20 év

- 22

- 23

- 7

- 75

- 8

- 84

- a

- Rólunk

- felett

- felgyorsult

- gázpedál

- gyorsítók

- hozzáférés

- kísért

- pontosság

- át

- aktiválások

- Ezen kívül

- fejlett

- adalékanyag

- AI

- AI / ML

- Minden termék

- Is

- amazon

- Amazon EC2

- Az Amazon Web Services

- an

- és a

- Közlemény

- bármilyen

- api

- API-k

- alkalmazások

- alkalmazások

- építészet

- VANNAK

- érv

- ARM

- mesterséges

- AS

- asszisztensek

- At

- auto

- autóipari

- autonóm

- elérhető

- AWS

- TENGELYEK

- Sávszélesség

- bázis

- BE

- előtt

- lent

- Túl

- BIN

- Blokk

- Virágzik

- hoz

- széles

- ütköző

- épít

- by

- hívás

- hívott

- TUD

- képességek

- Kapacitás

- kártya

- eset

- ellenőrizze

- klasszikus

- felhő

- Colorado

- kombinálása

- közlés

- átfogó

- számítási

- Kiszámít

- számítógép

- Számítógépes látás

- számítógépek

- számítástechnika

- következetes

- Összeáll

- Kapcsolatok

- Konténer

- tartalmaz

- tartalom

- Tartalomgenerálás

- teremt

- Jelenlegi

- Ügyfelek

- dátum

- Datacenter

- mély

- mély tanulás

- meghatározott

- Fok

- szállít

- szállít

- telepíteni

- telepített

- bevetés

- leírt

- Fejleszt

- Fejlesztő

- Fejlesztés

- eszköz

- Eszközök

- Diffusion

- Igazgató

- dokumentáció

- Kutya

- vezetés

- dinamikus

- él

- hatékony

- bármelyik

- alkalmaz

- lehetővé teszi

- végtől végig

- belépés

- Környezet

- környezetek

- Európa

- példa

- tapasztalat

- kiterjesztett valóság

- kivonat

- hamis

- Funkció

- Visszacsatolás

- kevés

- mező

- Fields

- Ábra

- filé

- vezetéknév

- megfelelő

- Összpontosít

- koncentrál

- következik

- következő

- A

- talált

- négy

- Frankfurt

- ból ből

- funkció

- magfúzió

- általában

- generál

- generált

- generáció

- nemző

- Generatív AI

- GitHub

- adott

- jó

- Vendég

- Vendég bejegyzés

- he

- fülhallgatók

- segít

- itt

- nagy teljesítményű

- <p></p>

- kiemeli

- tart

- hpc

- HTML

- HTTPS

- hibrid

- i

- IDX

- if

- kép

- képek

- végre

- végrehajtás

- importál

- in

- Beleértve

- magában

- egyéni

- ipar

- iparágvezető

- információ

- bemenet

- telepíteni

- példa

- Intel

- Intelligens

- összekapcsolt

- Felület

- IT

- jpg

- éppen

- Kulcs

- Ösvény

- nyelv

- nagy

- Késleltetés

- indít

- TANUL

- tanulás

- könyvtárak

- könyvtár

- fény

- vonal

- terhelések

- sikerült

- vezetés

- maszk

- Mátrix

- max

- Maximize

- maximalizálásával

- maximális

- Memory design

- háló

- meta

- microsoft

- perc

- modell

- modellek

- módosított

- több

- a legtöbb

- név

- keskeny

- Természetes

- Természetes nyelvi feldolgozás

- elengedhetetlen

- Szükség

- hálózat

- hálózatba

- hálózatok

- Új

- következő generációs

- Most

- számtalan

- Nvidia

- tárgy

- of

- on

- Fedélzeti

- Beszállás

- ONE

- csak

- nyitva

- OpenAI

- Optimalizálja

- optimalizált

- or

- Oregon

- szervezet

- OS

- Más

- ki

- teljesítmény

- kimenetek

- felett

- saját

- csomagok

- oldal

- rész

- elhalad

- Elmúlt

- szenvedélyes

- ösvény

- Fizet

- mert

- teljesítmény

- személyes

- phd

- Fizika

- emelvény

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- Népszerű

- lehetséges

- állás

- powered

- Pontosság

- korábban

- Fő

- feldolgozás

- Készült

- termel

- Termékek

- termékmenedzsment

- Termelés

- Termékek

- Program

- program

- biztosít

- amely

- nyilvános

- Piton

- pytorch

- Qualcomm

- gyorsan

- hatótávolság

- RE

- Olvasás

- Valóság

- régiók

- kötelező

- követelmények

- visszatartó

- visszatérés

- újra

- roy

- futás

- futás

- fut

- azonos

- Megtakarítás

- megtakarítás

- skálázható

- Skála

- sdk

- Második

- lát

- küld

- mondat

- Sorozat

- szolgáltatás

- Szolgáltatások

- ülés

- készlet

- ő

- mutatott

- Egyszerű

- egyszerűsítése

- weboldal

- Méret

- okostelefon

- okostelefonok

- So

- Megoldások

- feszültség

- szakember

- verem

- standard

- kezdet

- kezdődött

- Lépés

- Lépései

- tárolás

- tárolni

- tárolása

- Stratégia

- Később

- ilyen

- felettes

- támogatás

- Támogató

- Támogatja

- SYS

- rendszer

- táblázat

- technikák

- Technológia

- szöveg

- hogy

- A

- azok

- akkor

- Ezek

- ők

- ezt

- három

- Keresztül

- áteresztőképesség

- átmenő

- nak nek

- Ma

- tokenizálni

- szerszám

- Felsők

- fáklya

- Végösszeg

- forgalom

- kiképzett

- transzformerek

- igaz

- hangolás

- oktatói

- egységes

- egyetemi

- us

- használ

- használati eset

- felhasználási esetek

- használt

- használó

- segítségével

- szokásos

- v1

- ÉRVÉNYESÍT

- érték

- Tényleges

- látomás

- Látogat

- we

- háló

- webes szolgáltatások

- JÓL

- Nyugati

- Mit

- ami

- míg

- széles

- Széleskörű

- lesz

- val vel

- szó

- dolgozó

- világszerte

- év

- te

- A te

- zephyrnet