A generatív nyelvi modellek rendkívül ügyesnek bizonyultak a logikai és analitikus természetes nyelvi feldolgozási (NLP) feladatok megoldásában. Továbbá a használata gyors tervezés jelentősen javíthatják teljesítményüket. Például, gondolati láncolat (CoT) köztudottan javítja a modell kapacitását összetett többlépcsős problémák megoldására. Az érvelést igénylő feladatok pontosságának további növelése érdekében a önkonzisztencia ösztönző megközelítést javasoltak, amely a mohót sztochasztikus dekódolással helyettesíti a nyelvgenerálás során.

Amazon alapkőzet egy teljesen felügyelt szolgáltatás, amely a vezető mesterséges intelligencia-cégek és az Amazon nagy teljesítményű alapmodelljeit kínálja egyetlen API-n keresztül, valamint az építhető képességek széles készletét. generatív AI biztonságot, adatvédelmet és felelős AI-t biztosító alkalmazások. A ... val kötegelt következtetés API, az Amazon Bedrock segítségével kötegekben lefuttathatja az alapmodelleket, és hatékonyabban kaphat válaszokat. Ez a bejegyzés bemutatja, hogyan valósíthat meg önkonzisztencia-kérdést kötegelt következtetésen keresztül az Amazon Bedrock-on, hogy javítsa a modell teljesítményét aritmetikai és feleletválasztós érvelési feladatokban.

A megoldás áttekintése

A nyelvi modellek önkonzisztenciájának ösztönzése több válasz generálására támaszkodik, amelyeket a végső válaszba aggregálnak. Az olyan egygenerációs megközelítésekkel szemben, mint a CoT, az önkonzisztencia mintavételi és marginalizálási eljárás egy sor modellkiegészítést hoz létre, amelyek következetesebb megoldáshoz vezetnek. Különböző válaszok generálása egy adott prompt esetén lehetséges egy sztochasztikus, nem pedig mohó dekódolási stratégia alkalmazása miatt.

A következő ábra bemutatja, hogy az önkonzisztencia miben különbözik a mohó CoT-tól abban, hogy sokféle érvelési útvonalat generál, és ezeket összesíti a végső válasz elkészítéséhez.

Dekódolási stratégiák szöveggeneráláshoz

A csak dekódoló nyelvi modellek által generált szöveg szóról szóra bontakozik ki, a következő tokent pedig az előző kontextus alapján jósolják meg. Egy adott prompt esetén a modell kiszámít egy valószínűségi eloszlást, amely jelzi annak valószínűségét, hogy az egyes tokenek a sorozat következő helyén jelennek meg. A dekódolás során ezeket a valószínűségi eloszlásokat tényleges szöveggé fordítjuk. A szöveggenerálást egy halmaz közvetíti következtetési paraméterek amelyek gyakran magának a dekódolási módszernek a hiperparaméterei. Az egyik példa a hőmérséklet, amely modulálja a következő token valószínűségi eloszlását, és befolyásolja a modell kimenetének véletlenszerűségét.

Mohó dekódolás egy determinisztikus dekódolási stratégia, amely minden lépésben a legnagyobb valószínűséggel választja ki a tokent. Bár egyszerű és hatékony, a megközelítés fennáll annak a veszélye, hogy ismétlődő mintákba esik, mert figyelmen kívül hagyja a tágabb valószínűségi teret. A hőmérsékleti paraméter 0-ra állítása a következtetési időben lényegében egyenértékű a mohó dekódolás megvalósításával.

Mintavétel bevezeti a sztochaszticitást a dekódolási folyamatba azáltal, hogy véletlenszerűen választ ki minden következő tokent a megjósolt valószínűségi eloszlás alapján. Ez a véletlenszerűség nagyobb kimeneti változékonyságot eredményez. A sztochasztikus dekódolás ügyesebbnek bizonyul a lehetséges kimenetek sokféleségének megragadására, és gyakran fantáziadúsabb válaszokat ad. A magasabb hőmérsékleti értékek több ingadozást okoznak, és növelik a modell reakciójának kreativitását.

Felszólítási technikák: CoT és önkonzisztencia

A nyelvi modellek érvelési képessége azonnali tervezéssel bővíthető. Különösen a CoT bizonyítottan érvelést vált ki összetett NLP feladatokban. A megvalósítás egyik módja a nulla lövés A CoT azonnali kiegészítéssel történik, a „gondolkozz lépésről lépésre” utasítással. A másik az, hogy a modellt a köztes érvelési lépések példáinak tárják fel néhány lövésű felszólítás divat. Mindkét forgatókönyv általában mohó dekódolást használ. A CoT jelentős teljesítménynövekedést eredményez az aritmetikai, a józan ész és a szimbolikus érvelési feladatok egyszerű utasításaihoz képest.

Önkonzisztencia ösztönzése azon a feltételezésen alapul, hogy a sokféleség bevezetése az érvelési folyamatba előnyös lehet a modellek konvergálásához a helyes válaszhoz. A technika sztochasztikus dekódolást használ a cél elérése érdekében, három lépésben:

- A nyelvi modell ösztönzése CoT-példákkal az érvelés kiváltására.

- Cserélje le a mohó dekódolást mintavételi stratégiával, hogy sokféle érvelési útvonalat generáljon.

- Az eredményeket összesítse, hogy megtalálja a legkonzisztensebb választ a válaszhalmazban.

Kimutatták, hogy az önkonzisztencia felülmúlja a CoT felszólítást a népszerű aritmetikai és józan ész benchmarkokon. A megközelítés korlátja a nagyobb számítási költség.

Ez a bejegyzés bemutatja, hogy az önkonzisztencia-felhívás hogyan javítja a generatív nyelvi modellek teljesítményét két NLP-gondolkodási feladatban: az aritmetikai problémamegoldásban és a feleletválasztós tartományspecifikus kérdések megválaszolásában. A megközelítést batch következtetéssel mutatjuk be az Amazon Bedrock-on:

- Hozzáférünk az Amazon Bedrock Python SDK-hoz a JupyterLabban egy Amazon SageMaker notebook példány.

- Az aritmetikai érveléshez felszólítjuk Cohere Command az általános iskolai matematikai feladatok GSM8K adatkészletén.

- A feleletválasztós érveléshez felszólítjuk AI21 Labs Jurassic-2 Mid az AWS Certified Solutions Architect – Associate vizsga kérdéseinek kis mintáján.

Előfeltételek

Ez az áttekintés a következő előfeltételeket feltételezi:

Az ebben a bejegyzésben látható kód futtatásának becsült költsége 100 USD, feltételezve, hogy egyszer futtatja az önkonzisztencia-kérdést 30 érvelési útvonallal, egy értéket használva a hőmérséklet-alapú mintavételhez.

Adatkészlet az aritmetikai gondolkodási képességek vizsgálatához

GSM8K az ember által összeállított általános iskolai matematikai feladatok adatkészlete, amely nagy nyelvi sokszínűséget mutat. Minden feladat megoldása 2–8 lépésből áll, és alapvető számtani műveletekkel egy sor elemi számítást kell végrehajtani. Ezeket az adatokat általában a generatív nyelvi modellek többlépcsős aritmetikai gondolkodási képességeinek összehasonlítására használják. A GSM8K vonatkészlet 7,473 rekordot tartalmaz. A következő egy példa:

{"question": "Natalia sold clips to 48 of her friends in April, and then she sold half as many clips in May. How many clips did Natalia sell altogether in April and May?", "answer": "Natalia sold 48/2 = <<48/2=24>>24 clips in May.nNatalia sold 48+24 = <<48+24=72>>72 clips altogether in April and May.n#### 72"}

Beállítás kötegelt következtetés futtatására az Amazon Bedrock segítségével

A kötegelt következtetés lehetővé teszi több következtetési hívás futtatását az Amazon Bedrock felé aszinkron módon, és javítja a modellkövetkeztetés teljesítményét nagy adatkészleteken. A szolgáltatás az írás pillanatában előzetes verzióban van, és csak az API-n keresztül érhető el. Hivatkozni Futtasson kötegelt következtetést kötegelt következtetési API-k eléréséhez egyéni SDK-kon keresztül.

Miután letöltötte és kicsomagolta a Python SDK egy SageMaker notebook példányban telepítheti a következő kód futtatásával egy Jupyter notebook cellában:

Formázza és töltse fel a bemeneti adatokat az Amazon S3-ba

A kötegkövetkeztetés bemeneti adatait JSONL formátumban kell elkészíteni a következővel recordId és a modelInput kulcsok. Ez utóbbinak meg kell egyeznie az Amazon Bedrockon meghívandó modell testmezőjével. Különösen egyesek támogatott következtetési paraméterek a Cohere Command számára faliórái temperature a véletlenszerűségért, max_tokens a kimeneti hosszra, és num_generations több válasz generálásához, amelyek mindegyike a következővel együtt kerül átadásra prompt as modelInput:

Lát Következtetési paraméterek alapozási modellekhez további részletekért, beleértve más modellszolgáltatókat is.

Az aritmetikai érveléssel kapcsolatos kísérleteinket néhány felvételes beállításban végezzük a Cohere Command testreszabása vagy finomhangolása nélkül. Ugyanazt a nyolc néhány pillanatnyi példából álló készletet használjuk a gondolati láncból (Táblázat 20) és önkonzisztencia (Táblázat 17) papírokat. A promptokat úgy hozza létre, hogy összefűzi a példákat a GSM8K vonatkészlet minden kérdésével.

Állítottuk max_tokens az 512 és num_generations 5-re, a Cohere Command által megengedett maximumra. A mohó dekódoláshoz beállítottuk temperature 0-ra, és az önkonzisztencia érdekében három kísérletet futtatunk 0.5, 0.7 és 1 hőmérsékleten. Mindegyik beállítás különböző bemeneti adatokat ad a megfelelő hőmérsékleti értékeknek megfelelően. Az adatok JSONL formátumban vannak formázva, és az Amazon S3-ban tárolódnak.

Hozzon létre és futtasson kötegelt következtetési feladatokat az Amazon Bedrock alkalmazásban

A kötegelt következtetési feladat létrehozásához Amazon Bedrock kliens szükséges. Megadjuk az S3 bemeneti és kimeneti útvonalait, és minden meghívási feladatnak egyedi nevet adunk:

A munkák vannak készítette az IAM-szerep, a modellazonosító, a feladatnév és a bemeneti/kimeneti konfiguráció átadásával paraméterként az Amazon Bedrock API-nak:

felsorolás, ellenőrzésés megállítás kötegelt következtetési feladatokat a megfelelő API-hívások támogatják. Létrehozáskor a munkahelyek először mint Submitted, majd mint InProgress, végül mint Stopped, Failedvagy Completed.

Ha a feladatok sikeresen befejeződtek, a generált tartalom lekérhető az Amazon S3-ról az egyedi kimeneti hely használatával.

[Out]: 'Natalia sold 48 * 1/2 = 24 clips less in May. This means she sold 48 + 24 = 72 clips in April and May. The answer is 72.'

Az önkonzisztencia növeli a modell pontosságát az aritmetikai feladatoknál

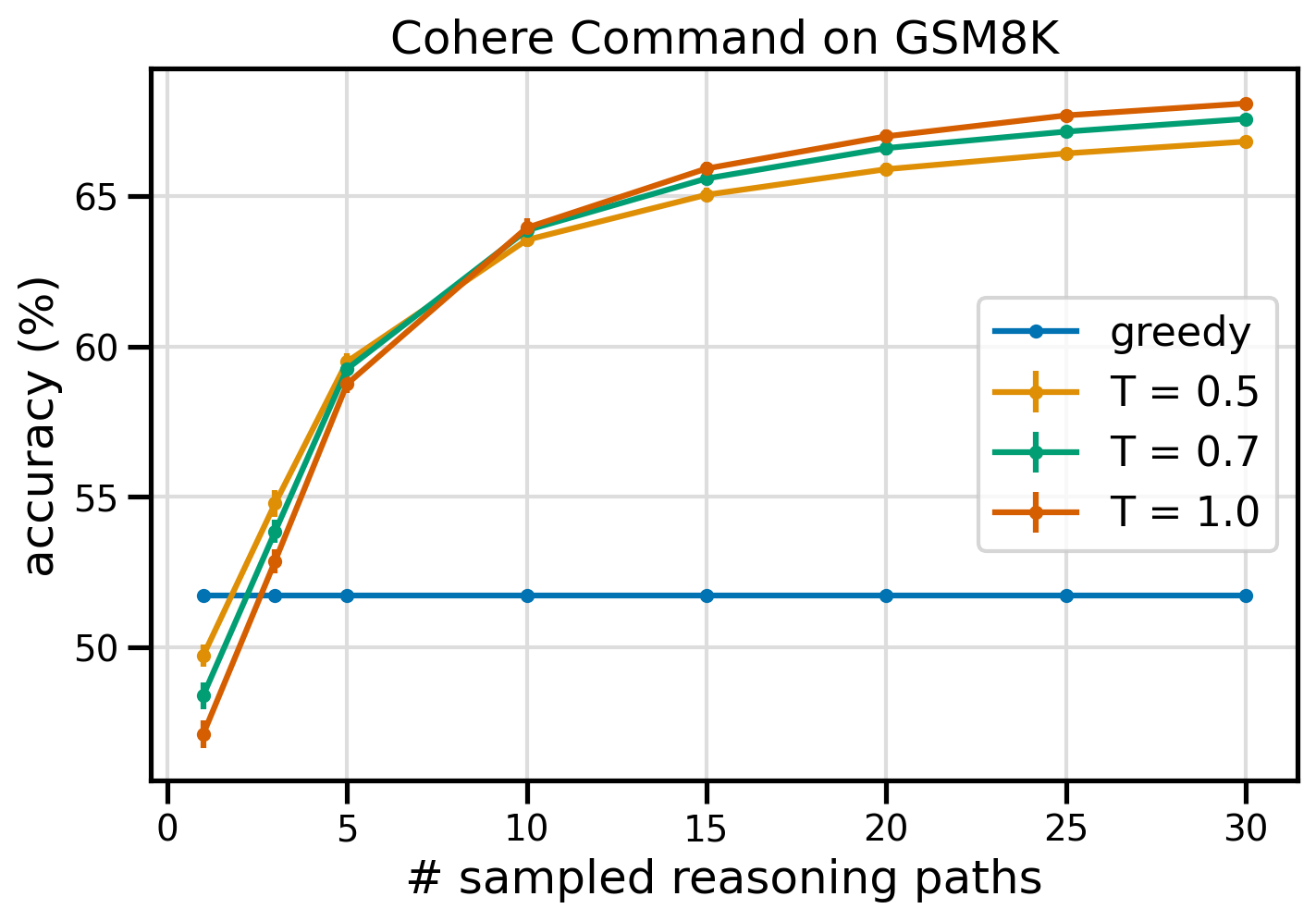

A Cohere Command önkonzisztenciájú felszólítása a GSM8K adatkészlet pontossága szempontjából felülmúlja a mohó CoT alapvonalat. Az önkonzisztencia érdekében 30 független gondolkodási útvonalat veszünk mintát három különböző hőmérsékleten, együtt topP és a topK nekik állítva alapértelmezett értékek. A végső megoldásokat többségi szavazással a legkonzisztensebb előfordulás kiválasztásával összesítik. Egyenlőség esetén véletlenszerűen választunk egyet a többségi válaszok közül. A pontosság és a szórás értékeket 100 futtatás alatt átlagoljuk.

A következő ábra a Cohere Command GSM8K adatkészletének pontosságát mutatja mohó CoT-vel (kék) és önkonzisztenciával 0.5 (sárga), 0.7 (zöld) és 1.0 (narancssárga) hőmérsékleti értékeknél a mintavételek számának függvényében. érvelési utak.

Az előző ábra azt mutatja, hogy az önkonzisztencia növeli az aritmetikai pontosságot a mohó CoT-hoz képest, ha a mintavételezett útvonalak száma mindössze három. A teljesítmény a további érvelési utakkal következetesen növekszik, megerősítve a sokszínűség bevezetésének fontosságát a gondolatgenerációban. A Cohere Command 8%-os pontossággal oldja meg a GSM51.7K kérdéskészletet CoT-val, szemben a 68%-kal, 30 önkonzisztens érvelési útvonallal T=1.0 értéknél. Mindhárom vizsgált hőmérsékleti érték hasonló eredményeket ad, az alacsonyabb hőmérsékletek pedig viszonylag jobban teljesítenek kevesebb mintavételű útvonalon.

Gyakorlati szempontok a hatékonyságról és a költségekről

Az önkonzisztenciát korlátozza a megnövekedett válaszidő és a promptonként több kimenet generálásakor felmerülő költségek. Gyakorlati példaként: kötegelt következtetés a mohó generáláshoz a Cohere Command segítségével 7,473 GSM8K rekordon kevesebb, mint 20 perc alatt. A feladat 5.5 millió tokent vett fel bemenetként, és 630,000 XNUMX kimeneti tokent generált. A jelenleginél Amazon Bedrock következtetési árak, a teljes felmerült költség körülbelül 9.50 USD volt.

A Cohere Commanddal való önkonzisztencia érdekében következtetési paramétert használunk num_generations több befejezés létrehozásához promptonként. Jelen pillanatban az Amazon Bedrock legfeljebb öt generációt és három egyidejűleg engedélyez Submitted kötegelt következtetési feladatok. Jobs folytassa a InProgress státusz szekvenciális, ezért ötnél több útvonal mintavételéhez többszöri meghívás szükséges.

A következő ábra a Cohere Command futási idejét mutatja a GSM8K adatkészleten. A teljes futási idő az x tengelyen, a futásidő pedig mintavételezett gondolkodási útvonalonként az y tengelyen látható. A mohó generálás a legrövidebb idő alatt fut le, de magasabb időköltséggel jár a mintavételezett útvonalonként.

A mohó generálás kevesebb, mint 20 perc alatt elkészül a teljes GSM8K készlettel, és egyedi érvelési útvonalat vesz mintát. Az öt mintával való önkonzisztencia körülbelül 50%-kal hosszabb időt igényel, és körülbelül 14.50 dollárba kerül, de öt útvonalat (több mint 500%-ot) hoz létre ennyi idő alatt. A teljes futási idő és a költség lépésről lépésre nő minden további öt mintavételi útvonallal. Egy költség-haszon elemzés azt sugallja, hogy az önkonzisztencia gyakorlati megvalósításához 1–2 kötegelt következtetési feladat 5–10 mintaútvonallal az ajánlott beállítás. Ez javítja a modell teljesítményét, miközben távol tartja a költségeket és a késleltetést.

Az önkonzisztencia az aritmetikai gondolkodáson túl javítja a modell teljesítményét

Az önkonzisztencia-felhívás alkalmasságának bizonyításához döntő kérdés, hogy a módszer sikeres-e további NLP-feladatok és nyelvi modellek között. Az Amazonhoz kapcsolódó használati eset kiterjesztéseként egy kis méretű elemzést végzünk a mintakérdéseken a AWS Solutions Architect Associate minősítés. Ez egy feleletválasztós vizsga az AWS-technológiáról és -szolgáltatásokról, amelyhez tartományi ismeretek, valamint több lehetőség közötti érvelési és döntési képesség szükséges.

Adatkészletet készítünk belőle SAA-C01 és a SAA-C03 minta vizsgakérdések. A 20 rendelkezésre álló kérdés közül az első 4-et használjuk néhány példaként, és felszólítjuk a modellt, hogy válaszoljon a maradék 16-ra. Ezúttal az AI21 Labs Jurassic-2 Mid modellel futtatunk le következtetést, és legfeljebb 10 érvelési útvonalat generálunk hőmérséklet 0.7. Az eredmények azt mutatják, hogy az önkonzisztencia javítja a teljesítményt: bár a mohó CoT 11 helyes választ ad, az önkonzisztencia még 2-vel sikerül.

A következő táblázat az 5 és 10 mintavételi útvonal pontossági eredményeit mutatja 100 futtatás átlagában.

| . | Mohó dekódolás | T = 0.7 |

| # mintaútvonal: 5 | 68.6 | 74.1 ± 0.7 |

| # mintaútvonal: 10 | 68.6 | 78.9 ± 0.3 |

A következő táblázatban két olyan vizsgakérdést mutatunk be, amelyekre a mohó CoT helytelenül válaszol, miközben az önkonzisztencia sikeres, minden esetben kiemelve azokat a helyes (zöld) vagy helytelen (piros) érvelési nyomokat, amelyek a modellt helyes vagy helytelen válaszadásra késztették. Bár nem minden önkonzisztencia által generált mintaútvonal helyes, a többség az igaz válaszhoz konvergál, ahogy a mintavételezett utak száma növekszik. Megfigyeltük, hogy 5–10 út jellemzően elegendő a mohó eredmények javításához, és a hatékonyság szempontjából csökkenő hozamok ezeken az értékeken túl.

| Kérdés |

Egy webalkalmazás lehetővé teszi az ügyfelek számára, hogy rendeléseiket S3 vödörbe töltsék fel. Az eredményül kapott Amazon S3 események egy Lambda függvényt váltanak ki, amely üzenetet szúr be egy SQS-sorba. Egyetlen EC2-példány beolvassa az üzeneteket a sorból, feldolgozza azokat, és egy egyedi rendelésazonosítóval particionált DynamoDB táblában tárolja. A jövő hónapban a forgalom várhatóan 10-szeresére nő, és a Solutions Architect felülvizsgálja az architektúrát a lehetséges méretezési problémák miatt. Melyik komponenst kell a LEGJOBBAN újratervezni, hogy képes legyen az új forgalom befogadására? A. Lambda funkció |

Egy AWS-en futó alkalmazás Amazon Aurora Multi-AZ DB-fürttelepítést használ adatbázisához. A teljesítménymutatók értékelésekor egy megoldástervező felfedezte, hogy az adatbázis-olvasások magas I/O-t okoznak, és növelik az adatbázis írási kérelmeinek késleltetését. Mit kell tennie a megoldástervezőnek, hogy elkülönítse az olvasási kéréseket az írási kérésektől? V. Engedélyezze az átolvasási gyorsítótárazást az Aurora adatbázisban. |

| Helyes válasz | C – Egyetlen EC2-példány nem skálázódik, és egyetlen hibapont az architektúrában. Sokkal jobb megoldás az lenne, ha az EC2-példányok egy automatikus méretezési csoportban 2 rendelkezésre állási zónán keresztül olvasnák be az üzeneteket a várakozási sorból. A többi válasz az összes felügyelt szolgáltatás, amely konfigurálható méretezésre, vagy automatikusan skálázódik. | C – Az Aurora replikák lehetőséget biztosítanak az olvasási forgalom tehermentesítésére. Az Aurora replikák ugyanazt a mögöttes tárolót osztják meg, mint a fő adatbázis, így a késleltetési idő általában nagyon alacsony. Az Aurora replikáknak saját végpontjaik vannak, ezért az alkalmazást úgy kell konfigurálni, hogy az olvasási forgalmat az új végpontokra irányítsa. |

| Mohó dekódolás | Előfordulhat, hogy az EC2 példány közvetlen méretezése nem lehetséges, mivel előfordulhat, hogy nem lehet átméretezni a példányt. Előfordulhat, hogy a lambda funkció skálázása nem elegendő, mivel a Lambda funkciók 6 GB memóriafoglalási korláttal rendelkeznek. Előfordulhat, hogy az SQS-sor méretezése nem elegendő, mivel az SQS-nek 10,000 XNUMX üzenetkorlátja van. A DynamoDB táblák méretezhetők több kapacitásegység kiépítésével. A helyes válasz D. | Az alkalmazás módosítása a Multi-AZ készenléti példányból való olvasáshoz (B lehetőség) a legjobb megközelítés. A készenléti példány aszinkron módon replikálódik az elsődleges példánytól, így az olvasási műveletek nem zavarják az írási műveleteket. Átolvasási gyorsítótárazás engedélyezése (A lehetőség) ill egy Aurora replika létrehozása (C opció) nem oldja meg az I/O versengés problémáját. Egy második Aurora-adatbázis létrehozása és olvasási replikaként való összekapcsolása (D lehetőség) sem oldja meg az I/O-verseny problémáját. A helyes válasz a B. |

| 1. mintaútvonal | Előfordulhat, hogy az EC2-példány jelenlegi méretének tízszeresére skálázása nem kivitelezhető sem költség, sem teljesítmény szempontjából. Nagyobb példányra lenne szükség, ami drága lehet. Költséghatékonyabb megoldás lehet kisebb példányok raj (pl. Auto Scaling Group) használata a terhelés megosztására. Ebben az esetben az EC2 példányt valószínűleg újra kell építeni. A helyes válasz C. | Az alkalmazás módosítása a megfelelő végpontok használatára nem praktikus megoldás, mivel az alkalmazás kódjának módosítását igényelné. A helyes válasz C: Hozzon létre egy Aurora replikát, és módosítsa az alkalmazást a megfelelő végpontok használatához. |

| 2. mintaútvonal | Egyetlen EC2-példány méretezése nehezebb és problémásabb, mint a többi szolgáltatásösszetevő méretezése. Az Amazon SQS, a Lambda és a DynamoDB mindegyike automatikusan skálázható megbirkózni a megnövekedett terheléssel. A helyes válasz C. |

(C) Hozzon létre egy Aurora-replikát, és módosítsa az alkalmazást a megfelelő végpontok használatához. Az Aurora replika konfigurálásával elkülönítheti az olvasási forgalmat az írási forgalomtól. Az Aurora replikák különböző végpont URL-eket használnak, amely lehetővé teszi, hogy az olvasási forgalmat a replikára irányítsa az elsődleges adatbázis helyett. A replika az olvasási kérelmeket az elsődleges adatbázisba irányuló írási kérelmekkel párhuzamosan tudja feldolgozni, csökkentve az I/O-t és a késleltetést. |

Tisztítsuk meg

A kötegelt következtetések futtatása az Amazon Bedrockban az Amazon Bedrock árképzése szerint díjköteles. Az áttekintés befejezése után törölje a SageMaker jegyzetfüzet példányát, és távolítsa el az összes adatot az S3 tárolókból, hogy elkerülje a jövőbeni költségeket.

Szempontok

Bár a bemutatott megoldás a nyelvi modellek jobb teljesítményét mutatja, ha önkonzisztencia kéri, fontos megjegyezni, hogy az áttekintés nem gyártásra kész. Az éles üzembe helyezés előtt ezt az elméleti bizonyítványt a saját megvalósításához kell igazítania, szem előtt tartva a következő követelményeket:

- Hozzáférés korlátozása az API-khoz és adatbázisokhoz a jogosulatlan használat megelőzése érdekében.

- Az AWS biztonsági bevált gyakorlatainak betartása az IAM-szerepkör-hozzáféréssel és a biztonsági csoportokkal kapcsolatban.

- A felhasználói bevitel érvényesítése és megtisztítása az azonnali injekciós támadások megelőzése érdekében.

- Az elindított folyamatok figyelése és naplózása a tesztelés és auditálás lehetővé tétele érdekében.

Következtetés

Ez a bejegyzés azt mutatja, hogy az önkonzisztens felszólítás javítja a generatív nyelvi modellek teljesítményét olyan összetett NLP-feladatokban, amelyek számtani és feleletválasztós logikai készségeket igényelnek. Az önkonzisztencia hőmérséklet-alapú sztochasztikus dekódolást használ különféle érvelési utak létrehozására. Ez növeli a modell azon képességét, hogy változatos és hasznos gondolatokat váltson ki a helyes válaszok meghozatalához.

Az Amazon Bedrock kötegelt következtetésével a Cohere Command nyelvi modellnek önkonzisztens válaszokat kell generálnia egy sor aritmetikai feladatra. A pontosság 51.7%-ról mohó dekódolással 68%-ra nő önkonzisztencia-mintavételezéssel, 30 érvelési útvonal T=1.0 mellett. Öt útvonal mintavétele már 7.5 százalékponttal növeli a pontosságot. A megközelítés átvihető más nyelvi modellekre és érvelési feladatokra, amint azt az AI21 Labs Jurassic-2 Mid modell AWS tanúsítási vizsgán elért eredményei mutatják. Egy kis méretű kérdéskészletben az öt mintaútvonallal való önkonzisztencia 5 százalékponttal növeli a pontosságot a mohó CoT-hoz képest.

Javasoljuk, hogy saját alkalmazásaiban a generatív nyelvi modellekkel valósítsa meg az önkonzisztencia-felhívást a nagyobb teljesítmény érdekében. Tudj meg többet Cohere Command és a AI21 Labs Jurassic az Amazon Bedrock-on elérhető modellek. A kötegkövetkeztetéssel kapcsolatos további információkért lásd: Futtasson kötegelt következtetést.

Köszönetnyilvánítás

A szerző köszönetet mond Amin Tajgardoonnak és Patrick McSweeney-nek a műszaki lektoroknak a hasznos visszajelzésekért.

A szerzőről

Lucía Santamaría Sr. Applied Scientist az Amazon's ML University-n, ahol az ML kompetencia szintjének emelésére összpontosít a vállalaton belül gyakorlati oktatás révén. Lucía PhD fokozatot szerzett asztrofizikából, és szenvedélyesen törekszik a technológiai tudáshoz és eszközökhöz való hozzáférés demokratizálása iránt.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/enhance-performance-of-generative-language-models-with-self-consistency-prompting-on-amazon-bedrock/

- :van

- :is

- :nem

- :ahol

- $ UP

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 15%

- 150

- 16

- 19

- 20

- 24

- 25

- 30

- 33

- 50

- 51

- 7

- 72

- 8

- a

- képesség

- Képes

- Rólunk

- hozzáférés

- elhelyezésére

- Szerint

- pontosság

- Elérése

- ér

- át

- tényleges

- alkalmazkodni

- hozzáadásával

- Ezen kívül

- ügyes

- ellen

- összesítve

- aggregátumok

- AI

- Minden termék

- kiosztás

- megengedett

- lehetővé téve

- lehetővé teszi, hogy

- mentén

- már

- Bár

- teljesen

- amazon

- Az Amazon Web Services

- között

- an

- elemzés

- Analitikai

- és a

- Másik

- válasz

- üzenetrögzítő

- válaszok

- api

- API-k

- megjelenik

- Alkalmazás

- alkalmazások

- alkalmazott

- megközelítés

- megközelít

- megfelelő

- április

- építészet

- VANNAK

- körül

- AS

- Társult

- feltételezi

- feltevés

- At

- Támadások

- könyvvizsgálat

- bővített

- Sárgásvörös

- szerző

- auto

- automatikusan

- elérhetőség

- elérhető

- elkerülése érdekében

- AWS

- Tengely

- alapján

- kiindulási

- alapvető

- alap

- öböl

- BE

- mert

- óta

- előtt

- hogy

- benchmark

- referenciaértékek

- előnyös

- BEST

- legjobb gyakorlatok

- Jobb

- között

- Túl

- Kék

- test

- fellendítésére

- mindkét

- széles

- tágabb

- épít

- de

- by

- caching

- számítások

- kéri

- TUD

- képességek

- Kapacitás

- Rögzítése

- eset

- okozó

- sejt

- Tanúsítvány

- Vizsgázott

- Változások

- díjak

- választás

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választja

- vásárló

- klipek

- Fürt

- kód

- általában

- Companies

- vállalat

- viszonylag

- képest

- teljes

- Befejezi

- bonyolult

- összetevő

- alkatrészek

- tartalmaz

- számítási

- Kiszámít

- koncepció

- egyidejű

- Configuration

- konfigurálva

- konfigurálása

- megfontolások

- következetes

- következetesen

- tartalom

- kontextus

- kontraszt

- konvergálni

- kijavítására

- Költség

- költséghatékony

- kiadások

- teremt

- készítette

- teremt

- létrehozása

- teremtés

- kreativitás

- kritikus

- Jelenlegi

- szokás

- Ügyfelek

- dátum

- adatbázis

- adatbázisok

- adatkészletek

- dönt

- Dekódolás

- demokratizálásának

- bizonyítani

- igazolták

- telepíteni

- bevetés

- részletek

- eltérés

- DID

- különbségek

- különböző

- nehéz

- csökkenő

- közvetlen

- közvetlenül

- felfedezett

- terjesztés

- disztribúció

- számos

- Sokféleség

- do

- domain

- letöltve

- két

- alatt

- e

- minden

- Oktatás

- hatékonyság

- hatékony

- eredményesen

- nyolc

- bármelyik

- lehetővé

- lehetővé téve

- ösztönzése

- Endpoint

- Mérnöki

- növelése

- fokozott

- Javítja

- elég

- megegyezik

- lényegében

- becsült

- értékelő

- események

- Minden

- vizsgálat

- példa

- várható

- drága

- kísérletek

- kiterjesztés

- külön-

- tényező

- Kudarc

- Eső

- Divat

- megvalósítható

- Featuring

- Visszacsatolás

- mező

- Ábra

- filé

- utolsó

- Végül

- Találjon

- vezetéknév

- öt

- ingadozások

- összpontosított

- következő

- A

- formátum

- Alapítvány

- barátok

- ból ből

- Tele

- teljesen

- funkció

- funkciók

- további

- Továbbá

- jövő

- Nyereség

- általában

- generál

- generált

- generál

- generáló

- generáció

- generációk

- nemző

- kap

- GitHub

- Ad

- adott

- cél

- fokozat

- nagyobb

- Kapzsi

- Zöld

- Csoport

- Csoportok

- fél

- hands-on

- Legyen

- fej

- segít

- hasznos

- neki

- Magas

- nagy teljesítményű

- <p></p>

- legnagyobb

- kiemelve

- Hogyan

- How To

- HTML

- HTTPS

- ID

- végre

- végrehajtás

- végrehajtási

- fontosság

- fontos

- javul

- javított

- javítja

- in

- Beleértve

- hibás

- tévesen

- Növelje

- <p></p>

- Növeli

- felmerült

- független

- jelezve

- információ

- bemenet

- Betétek

- telepíteni

- példa

- helyette

- zavarja

- bele

- bevezet

- Bemutatja

- bevezetéséről

- hivatkozni

- vonja

- jár

- kérdés

- IT

- ITS

- maga

- Munka

- Állások

- json

- tartás

- Kulcs

- kulcsok

- tudás

- ismert

- Labs

- nyelv

- nagy

- nagyobb

- Késleltetés

- vezet

- vezető

- vezetékek

- TANUL

- Led

- Hossz

- kevesebb

- szint

- mint

- valószínűség

- Valószínű

- LIMIT

- korlátozás

- Korlátozott

- vonalak

- LINK

- Összekapcsolása

- kiszámításának

- elhelyezkedés

- fakitermelés

- logikus

- hosszabb

- Elő/Utó

- alacsonyabb

- Fő

- Többség

- kezelése

- sikerült

- sok

- Mérkőzés

- matematikai

- maximális

- Lehet..

- eszközök

- Memory design

- üzenet

- üzenetek

- módszer

- Metrics

- Középső

- esetleg

- millió

- bánja

- Perc

- ML

- modell

- modellek

- módosítása

- Hónap

- több

- a legtöbb

- sok

- többszörös

- név

- Természetes

- Természetes nyelvi feldolgozás

- Szükség

- igények

- Új

- következő

- NLP

- nevezetesen

- megjegyezni

- jegyzetfüzet

- szám

- megfigyelni

- esemény

- of

- Ajánlatok

- gyakran

- on

- ONE

- csak

- Művelet

- opció

- Opciók

- or

- narancs

- érdekében

- rendelés

- Más

- ki

- teljesítményben felülmúl

- felülmúlja

- teljesítmény

- kimenetek

- felett

- saját

- csomagok

- papírok

- Párhuzamos

- paraméter

- paraméterek

- különös

- megosztjuk

- Elmúlt

- Múló

- szenvedélyes

- múlt

- ösvény

- utak

- patrick

- minták

- mert

- százalék

- Teljesít

- teljesítmény

- teljesített

- előadó

- perspektíva

- phd

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- pont

- Népszerű

- lehetséges

- állás

- potenciális

- Gyakorlati

- gyakorlat

- megelőző

- jósolt

- Készít

- előkészített

- előfeltételek

- be

- megakadályozása

- Preview

- árazás

- elsődleges

- magánélet

- szonda

- Probléma

- problémamegoldás

- problematikus

- problémák

- eljárás

- folytassa

- folyamat

- Folyamatok

- feldolgozás

- gyárt

- termel

- Termelés

- utasításokat

- bizonyíték

- bizonyíték a koncepcióra

- Bizonyít

- igazolt

- bizonyul

- ad

- szolgáltatók

- Piton

- kérdés

- Kérdések

- emelés

- véletlenszerűség

- hatótávolság

- Inkább

- Olvass

- ok

- ajánlott

- nyilvántartások

- Piros

- csökkentő

- utal

- tekintettel

- támaszkodik

- megmaradó

- eltávolítása

- ismétlő

- válasz

- többszörözött

- kéri

- szükség

- követelmények

- megköveteli,

- azok

- válasz

- válaszok

- felelős

- korlátozás

- kapott

- Eredmények

- Visszatér

- felülvizsgálata

- kockázatok

- Szerep

- SOR

- futás

- futás

- fut

- futásidejű

- sagemaker

- azonos

- minta

- Skála

- pikkelyes

- skálázás

- forgatókönyvek

- Iskola

- Tudós

- sdk

- sdks

- Második

- biztonság

- kiválasztása

- elad

- különálló

- Sorozat

- szolgáltatás

- Szolgáltatások

- ülés

- készlet

- beállítás

- számos

- Megosztás

- ő

- legrövidebb

- kellene

- előadás

- mutatott

- Műsorok

- jelentős

- hasonló

- Egyszerű

- egyetlen

- Méret

- készségek

- kicsi

- kisebb

- So

- eladott

- megoldások

- Megoldások

- SOLVE

- Megoldja

- Megoldása

- néhány

- Hely

- standard

- Állapot

- Lépés

- Lépései

- tárolás

- tárolni

- memorizált

- árnyékolók

- egyértelmű

- stratégiák

- Stratégia

- tárgy

- későbbi

- sikeresen

- javasolja,

- alkalmasság

- Támogatott

- megkérdezett

- raj

- szimbolikus

- táblázat

- tart

- feladatok

- tech

- Műszaki

- technika

- technikák

- Technológia

- feltételek

- Tesztelés

- szöveg

- mint

- Kösz

- hogy

- A

- azok

- Őket

- akkor

- ebből adódóan

- Ezek

- ezt

- azok

- gondoltam

- három

- Keresztül

- NYAKKENDŐ

- idő

- alkalommal

- nak nek

- együtt

- jelképes

- tokenek

- vett

- szerszámok

- Végösszeg

- forgalom

- Vonat

- átruházható

- kiváltó

- váltott

- igaz

- kettő

- jellemzően

- jogtalan

- mögöttes

- egyedi

- egységek

- egyetemi

- Frissítések

- Használat

- használ

- használati eset

- használt

- hasznos

- használó

- használ

- segítségével

- érték

- Értékek

- különféle

- nagyon

- keresztül

- Szavazás

- vs

- végigjátszás

- volt

- Út..

- we

- háló

- webalkalmazás

- webes szolgáltatások

- amikor

- vajon

- ami

- míg

- WHL

- lesz

- val vel

- nélkül

- szó

- lenne

- ír

- írás

- X

- Hozam

- hozamok

- te

- A te

- zephyrnet

- Postai irányítószám

- zónák