A prediktív bizonytalanság megfelelő becslése alapvető fontosságú a kritikus döntéseket jelentő alkalmazásokban. A bizonytalanság felhasználható a modell-előrejelzések megbízhatóságának felmérésére, emberi beavatkozás kiváltására, vagy annak eldöntésére, hogy egy modell biztonságosan alkalmazható-e a vadonban.

bemutatjuk Fortuna, egy nyílt forráskódú könyvtár a bizonytalanság számszerűsítésére. A Fortuna olyan kalibrációs módszereket biztosít, mint például a konform előrejelzés, amely bármely képzett neurális hálózaton alkalmazható kalibrált bizonytalansági becslések készítéséhez. A könyvtár emellett számos Bayes-féle következtetési módszert támogat, amelyek alkalmazhatók a beírt mély neurális hálózatokra Len. A könyvtár megkönnyíti a benchmarkok futtatását, és lehetővé teszi a szakemberek számára, hogy robusztus és megbízható mesterségesintelligencia-megoldásokat építsenek ki a fejlett bizonytalanság-számítási technikák kihasználásával.

A túlzott önbizalom problémája a mély tanulásban

Ha valaha is megnézte egy betanított mély neurális hálózati osztályozó által visszaadott osztályvalószínűségeket, akkor megfigyelhette, hogy az egyik osztály valószínűsége sokkal nagyobb, mint a többi. Valami ilyesmi, például:

p = [0.0001, 0.0002, …, 0.9991, 0.0003, …, 0.0001]

Ha az előrejelzések többsége esetében ez a helyzet, akkor a modellje túlságosan magabiztos lehet. Az osztályozó által visszaadott valószínűségek érvényességének értékeléséhez összevethetjük azokat egy holdout adatsoron elért tényleges pontossággal. Valójában természetes azt feltételezni, hogy a helyesen osztályozott adatpontok arányának megközelítőleg meg kell egyeznie az előre jelzett osztály becsült valószínűségével. Ez a koncepció az úgynevezett kalibráció [Guo C. et al., 2017].

Sajnos sok betanított mély neurális hálózat rosszul van kalibrálva, ami azt jelenti, hogy a megjósolt osztály becsült valószínűsége sokkal nagyobb, mint a helyesen osztályozott bemeneti adatpontok aránya. Más szóval, az osztályozó túlságosan magabiztos.

A túlzott magabiztosság problémát jelenthet a gyakorlatban. Az orvos nem rendelhet el releváns további vizsgálatokat egy mesterséges intelligencia által felállított túlságosan magabiztos, egészséges diagnózis eredményeként. Egy önvezető autó dönthet úgy, hogy nem fékez, mert magabiztosan értékelte, hogy az előtte haladó tárgy nem személy. A kormányzó dönthet úgy, hogy kiürít egy várost, mert a mesterséges intelligencia becslése szerint túl nagy a valószínűsége egy kiemelkedő természeti katasztrófának. Ezekben és sok más alkalmazásban a kalibrált bizonytalansági becslések kritikus fontosságúak a modell-előrejelzések megbízhatóságának értékeléséhez, az emberi döntéshozóhoz tartoznak, vagy annak eldöntéséhez, hogy egy modell biztonságosan alkalmazható-e.

Fortuna: Könyvtár a bizonytalanság számszerűsítésére

Számos publikált technika létezik az előrejelzések bizonytalanságának becslésére vagy kalibrálására, pl. Bayes-i következtetés [Wilson AG, 2020], hőmérséklet-skálázás [Guo C. et al., 2017]és konform előrejelzés [Angelopoulos AN et al., 2022] mód. A bizonytalanság számszerűsítésére szolgáló meglévő eszközök és könyvtárak azonban szűk hatókörrel rendelkeznek, és nem kínálnak egyetlen helyen technikák széles skáláját. Ez jelentős többletköltséget eredményez, ami gátolja a bizonytalanság átvételét a termelési rendszerekbe.

Ennek a hiánynak a pótlása érdekében elindítjuk a Fortunát, a bizonytalanság számszerűsítésére szolgáló könyvtárat, amely egyesíti a szakirodalom kiemelkedő módszereit, és szabványosított és intuitív felülettel teszi elérhetővé a felhasználók számára.

Példaként tegyük fel, hogy oktatási, kalibrációs és tesztadat-betöltőket használ tensorflow.Tensor formátumban, nevezetesen train_data_loader, calib_data_loader és a test_data_loader. Ezenkívül be van írva egy mély tanulási modell Len, nevezetesen modell. Ezután a Fortuna segítségével:

- illeszkedjen egy hátsó eloszláshoz;

- kalibrálja a modell kimeneteit;

- kalibrált előrejelzéseket készíteni;

- bizonytalansági becslések becslése;

- kiértékelési mérőszámok kiszámítása.

A következő kód mindezt elvégzi Ön helyett.

A fenti kód számos alapértelmezett beállítást használ, beleértve a SWAG-ot [Maddox WJ et al., 2019] utólagos következtetési módszerként a hőmérséklet-skálázás [Guo C. et al., 2017] a modellkimenetek kalibrálásához és egy szabványos Gauss-előzetes eloszláshoz, valamint a hátsó illesztési és kalibrációs folyamatok konfigurációjához. Könnyedén konfigurálhatja ezeket az összetevőket, és ezt erősen javasoljuk, ha egy adott konfigurációt keres, vagy ha több komponenst szeretne összehasonlítani.

Felhasználási módok

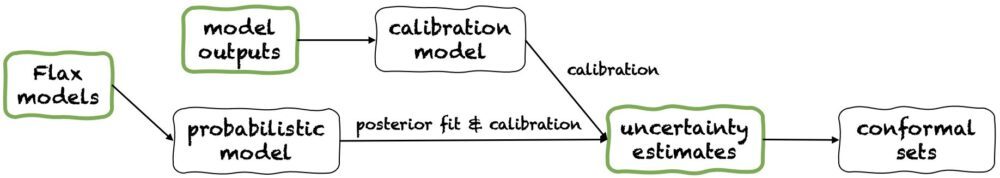

A Fortuna három használati módot kínál: 1/ Len modellektől kezdve, 2 / A modell kimeneteitől kezdveés 3/ A bizonytalansági becslésekből kiindulva. Csővezetékeiket a következő ábra mutatja, mindegyik a zöld panelek egyikéből indul ki. A fenti kódrészlet egy példa a Fortuna használatára, amely a Flax modellekből indul ki, ami lehetővé teszi a modell oktatását Bayes-féle következtetési eljárásokkal. Alternatív megoldásként kiindulhat a modell kimeneteiből vagy közvetlenül a saját bizonytalansági becsléseiből. Mindkét utóbbi mód az keretfüggetlen és segít a kalibrált bizonytalansági becslések megszerzésében a képzett modell.

1/ A bizonytalansági becslésekből kiindulva

A bizonytalansági becslésekből kiindulva minimális kompatibilitási követelmények vannak, és ez a leggyorsabb interakció szintje a könyvtárral. Ez a használati mód konform előrejelzési módszereket kínál mind az osztályozáshoz, mind a regresszióhoz. Ezek bizonytalansági becsléseket vesznek fel numpy.ndarray formátumban, és szigorú előrejelzéskészleteket ad vissza, amelyek megtartják a felhasználó által megadott valószínűségi szintet. Az egydimenziós regressziós feladatokban a konform halmazok a megbízhatóság vagy a hiteles intervallumok kalibrált változatainak tekinthetők.

Ne feledje, hogy ha a bemenetekben megadott bizonytalansági becslések pontatlanok, akkor a konform halmazok nagyok és használhatatlanok lehetnek. Emiatt, ha pályázata ezt lehetővé teszi, vegye figyelembe a A modell kimeneteitől kezdve és a Len modellektől kezdve az alábbiakban részletezett használati módok.

2/ A modell kimeneteitől kezdve

Ez a mód azt feltételezi, hogy már betanított egy modellt valamilyen keretrendszerben, és megérkezik a Fortunához a modell kimenetekkel numpy.ndarray formátumot minden bemeneti adatponthoz. Ez a használati mód lehetővé teszi a modellkimenetek kalibrálását, a bizonytalanság becslését, a metrikák kiszámítását és a konform halmazok beszerzését.

Összehasonlítva a A bizonytalansági becslésekből kiindulva használati mód, A modell kimeneteitől kezdve jobb vezérlést biztosít, mivel megbizonyosodhat arról, hogy a bizonytalansági becslések megfelelően lettek kalibrálva. Ha azonban a modellt klasszikus módszerekkel képezték volna, akkor a modell (más néven episztemikus) bizonytalanság számszerűsítése gyenge lehet. A probléma enyhítése érdekében vegye figyelembe a Len modellektől kezdve használati mód.

3/ Len modellektől kezdve

A Len modellektől kezdve magasabb kompatibilitási követelmények vannak, mint a A bizonytalansági becslésekből kiindulva és a A modell kimeneteitől kezdve használati módok, mivel ehhez beírt mély tanulási modellekre van szükség Len. Lehetővé teszi azonban, hogy a szabványos modellképzést skálázható Bayes-féle következtetési eljárásokkal helyettesítse, ami jelentősen javíthatja a prediktív bizonytalanság számszerűsítését.

A Bayes-féle módszerek úgy működnek, hogy a bizonytalanságot a modell paraméterei feletti bizonytalanságon keresztül reprezentálják, hogy melyik megoldás a helyes, korlátozott információ mellett. Az ilyen típusú bizonytalanságot episztemikus bizonytalanságnak nevezik. Mivel a neurális hálózatok sokféle megoldást képviselhetnek, paramétereik különböző beállításainak megfelelően, a Bayes-módszerek különösen hatásosak lehetnek a mély tanulásban. Számos méretezhető Bayes-következtetési eljárást biztosítunk, amelyek gyakran felhasználhatók bizonytalansági becslések, valamint jobb pontosság és kalibrálás készítésére, gyakorlatilag oktatási idő többletköltsége nélkül.

Következtetés

Bejelentettük a Fortuna, a mélytanulási bizonytalanság számszerűsítésére szolgáló könyvtár általános elérhetőségét. A Fortuna egyesíti a szakirodalom kiemelkedő módszereit, például a konform módszereket, a hőmérséklet-skálázást és a Bayes-i következtetést, és szabványos és intuitív felülettel teszi elérhetővé a felhasználók számára. A Fortuna használatának megkezdéséhez tekintse meg a következő forrásokat:

Próbálja ki a Fortunát, és ossza meg velünk véleményét! Arra bátorítjuk, hogy járuljon hozzá a könyvtárhoz, vagy hagyja meg javaslatait és hozzájárulásait – csak hozzon létre egy kérdés vagy nyissa meg a húzza meg a kérést. A mi oldalunkon továbbra is fejlesztjük a Fortunat, növeljük a bizonytalanság számszerűsítési módszereinek lefedettségét, és további példákat adunk hozzá, amelyek számos forgatókönyvben bemutatják annak hasznosságát.

A szerzőkről

Gianluca Detommaso az AWS alkalmazott tudósa. Jelenleg a bizonytalanság számszerűsítésén dolgozik a mély tanulásban. Szabadidejében Gianluca szeret sportolni, finomat enni és új készségeket tanulni.

Alberto Gasparin 2021 júliusa óta az Amazon Community Shopping alkalmazott tudósa. Érdeklődési köre a természetes nyelvi feldolgozás, az információkeresés és a bizonytalanság számszerűsítése. Élelmiszer- és borrajongó.

Alberto Gasparin 2021 júliusa óta az Amazon Community Shopping alkalmazott tudósa. Érdeklődési köre a természetes nyelvi feldolgozás, az információkeresés és a bizonytalanság számszerűsítése. Élelmiszer- és borrajongó.

Michele Donini az AWS Sr alkalmazott tudósa. Egy felelős AI-n dolgozó tudóscsoportot vezet, kutatási területe pedig az Algorithmic Fairness és az Explainable Machine Learning.

Michele Donini az AWS Sr alkalmazott tudósa. Egy felelős AI-n dolgozó tudóscsoportot vezet, kutatási területe pedig az Algorithmic Fairness és az Explainable Machine Learning.

Seeger Mátyás az AWS vezető alkalmazott tudósa.

Seeger Mátyás az AWS vezető alkalmazott tudósa.

Cedric Archambeau az AWS vezető alkalmazottja, valamint az Európai Tanulási és Intelligens Rendszerek Laboratóriumának munkatársa.

Cedric Archambeau az AWS vezető alkalmazottja, valamint az Európai Tanulási és Intelligens Rendszerek Laboratóriumának munkatársa.

Andrew Gordon Wilson a Courant Institute of Mathematical Sciences és a New York-i Egyetem Adattudományi Központjának docense, valamint az AWS Amazon látogató akadémikusa. Különösen foglalkozik a Bayes-féle és valószínűségi mélytanulás módszereinek kidolgozásával, a méretezhető Gauss-folyamatokkal, a Bayes-i optimalizálással és a fizika által inspirált gépi tanulással.

Andrew Gordon Wilson a Courant Institute of Mathematical Sciences és a New York-i Egyetem Adattudományi Központjának docense, valamint az AWS Amazon látogató akadémikusa. Különösen foglalkozik a Bayes-féle és valószínűségi mélytanulás módszereinek kidolgozásával, a méretezhető Gauss-folyamatokkal, a Bayes-i optimalizálással és a fizika által inspirált gépi tanulással.

- AI

- ai művészet

- ai art generátor

- van egy robotod

- Amazon gépi tanulás

- mesterséges intelligencia

- mesterséges intelligencia tanúsítás

- mesterséges intelligencia a bankszektorban

- mesterséges intelligencia robot

- mesterséges intelligencia robotok

- mesterséges intelligencia szoftver

- AWS gépi tanulás

- blockchain

- blokklánc konferencia ai

- coingenius

- társalgási mesterséges intelligencia

- kriptokonferencia ai

- dall's

- mély tanulás

- Alapozó (100)

- google azt

- gépi tanulás

- Plató

- plato ai

- Platón adatintelligencia

- Platón játék

- PlatoData

- platogaming

- skála ai

- szintaxis

- zephyrnet