QuOne Lab, Phanous Kutatási és Innovációs Központ, Teherán, Irán

Érdekesnek találja ezt a cikket, vagy szeretne megvitatni? Scite vagy hagyjon megjegyzést a SciRate-en.

Absztrakt

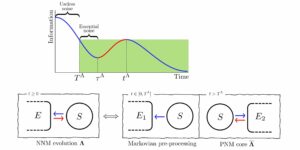

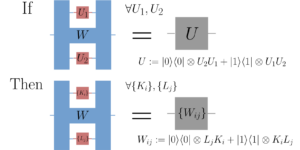

A túlparaméterezett modellfüggvények gradiens süllyedés útján történő betanítása során előfordul, hogy a paraméterek nem változnak jelentősen, és közel maradnak a kezdeti értékükhöz. Ezt a jelenséget $textit{lusta képzés}$-nak hívják, és a modellfüggvény lineáris közelítésének figyelembevételét motiválja a kezdeti paraméterek körül. A lusta rendszerben ez a lineáris közelítés annak a paraméterezett függvénynek a viselkedését imitálja, amelyhez társított kernel, a $textit{tangent kernel}$ határozza meg a modell betanítási teljesítményét. A nagy szélességű (klasszikus) neurális hálózatok esetében ismert a lusta képzés. Ebben a cikkben megmutatjuk, hogy a $textit{geometrikusan lokális}$ paraméterezett kvantumáramkörök betanítása nagyszámú qubit esetén a lusta rezsimbe lép. Pontosabban, határokat bizonyítunk egy ilyen geometriailag lokális paraméterezett kvantumáramkör paramétereinek változási sebességére a betanítási folyamatban, és a kapcsolódó kvantummodell-függvény lineáris közelítésének pontosságára; a qubitek számának növekedésével mindkét korlát nullára irányul. Analitikai eredményeinket numerikus szimulációkkal támasztjuk alá.

► BibTeX adatok

► Referenciák

[1] John Preskill. Kvantumszámítástechnika a NISQ-korszakban és azon túl. Quantum, 2:79, 2018. doi: 10.22331/q-2018-08-06-79.

https://doi.org/10.22331/q-2018-08-06-79

[2] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio és mások. Variációs kvantum algoritmusok. Nature Reviews Physics, 3(9):625–644, 2021. doi:10.1038/s42254-021-00348-9.

https://doi.org/10.1038/s42254-021-00348-9

[3] Jarrod R McClean, Sergio Boixo, Vadim N Smelyanskiy, Ryan Babbush és Hartmut Neven. Kopár fennsíkok kvantum-neurális hálózatok képzési tájain. Nature Communications, 9(1):1–6, 2018. doi:10.1038/s41467-018-07090-4.

https://doi.org/10.1038/s41467-018-07090-4

[4] Samson Wang, Enrico Fontana, Marco Cerezo, Kunal Sharma, Akira Sone, Lukasz Cincio és Patrick J Coles. Zaj-indukált kopár fennsíkok variációs kvantum algoritmusokban. Nature Communications, 12(1):1–11, 2021. doi:10.1038/s41467-021-27045-6.

https://doi.org/10.1038/s41467-021-27045-6

[5] Francis Bach. Könnyed optimalizálás a gradiens folyamokon keresztül. https:///francisbach.com/gradient-flows.

https:///francisbach.com/gradient-flows

[6] Arthur Jacot, Franck Gabriel és Clément Hongler. Neurális érintő kernel: Konvergencia és általánosítás neurális hálózatokban. Fejlődés a neurális információfeldolgozó rendszerekben (NeurIPS 2018), 31:8571–8580, 2018. doi:10.1145/3406325.3465355.

https:///doi.org/10.1145/3406325.3465355

[7] Lenaic Chizat, Edouard Oyallon és Francis Bach. A differenciálható programozás lusta képzéséről. A neurális információfeldolgozási rendszerek fejlődése, 32. 2019.

[8] Kouhei Nakaji, Hiroyuki Tezuka és Naoki Yamamoto. Kvantumnövelt neurális hálózatok a neurális tangens kernel keretrendszerben. 2021. arXiv:2109.03786.

arXiv: 2109.03786

[9] Norihito Shirai, Kenji Kubo, Kosuke Mitarai és Keisuke Fujii. Kvantum tangens kernel. 2021. arXiv:2111.02951.

arXiv: 2111.02951

[10] Maria Schuld és Nathan Killoran. Kvantumgépi tanulás jellemző hilbert terekben. Phys. Rev. Lett., 122:040504, 2019. február. doi:10.1103/PhysRevLett.122.040504.

https:///doi.org/10.1103/PhysRevLett.122.040504

[11] Vojtěch Havlíček, Antonio D. Córcoles, Kristan Temme, Aram W. Harrow, Abhinav Kandala, Jerry M. Chow és Jay M. Gambetta. Felügyelt tanulás kvantum-bővített funkcióterekkel. Nature, 567(7747):209–212, 2019. március. doi:10.1038/s41586-019-0980-2.

https://doi.org/10.1038/s41586-019-0980-2

[12] Junyu Liu, Francesco Tacchino, Jennifer R. Glick, Liang Jiang és Antonio Mezzacapo. Ábrázolástanulás kvantum-neurális tangens kerneleken keresztül. PRX Quantum, 3:030323, 2022. doi:10.1103/PRXQuantum.3.030323.

https:///doi.org/10.1103/PRXQuantum.3.030323

[13] Di Luo és James Halverson. Végtelen neurális hálózat kvantumállapotai. 2021. arXiv:2112.00723.

arXiv: 2112.00723

[14] Junyu Liu, Khadijeh Najafi, Kunal Sharma, Francesco Tacchino, Liang Jiang és Antonio Mezzacapo. Analitikus elmélet széles kvantum-neurális hálózatok dinamikájára. Phys. Rev. Lett., 130(15):150601, 2023. doi:10.1103/PhysRevLett.130.150601.

https:///doi.org/10.1103/PhysRevLett.130.150601

[15] Junyu Liu, Zexi Lin és Liang Jiang. Lustaság, kopár fennsík és zaj a gépi tanulásban, 2022. doi:10.48550/arXiv.2206.09313.

https:///doi.org/10.48550/arXiv.2206.09313

[16] Edward Farhi és Hartmut Neven. Osztályozás kvantumneurális hálózatokkal rövid távú processzorokon. 2018. arXiv:1802.06002.

arXiv: 1802.06002

[17] M. Cerezo, Akira Sone, Tyler Volkoff, Lukasz Cincio és Patrick J. Coles. Költségfüggvénytől függő kopár platók sekély parametrizált kvantumáramkörökben. Nature Communications, 12(1):1791, 2021. doi:10.1038/s41467-021-21728-w.

https:///doi.org/10.1038/s41467-021-21728-w

[18] Adrián Pérez-Salinas, Alba Cervera-Lierta, Elies Gil-Fuster és José I. Latorre. Adatok újrafeltöltése egy univerzális kvantumosztályozóhoz. Quantum, 4:226, 2020. doi: 10.22331/q-2020-02-06-226.

https://doi.org/10.22331/q-2020-02-06-226

[19] Maria Schuld, Ryan Sweke és Johannes Jakob Meyer. Az adatkódolás hatása a variációs kvantum-gépi tanulási modellek kifejező erejére. Phys. Rev. A, 103:032430, 2021. március doi:10.1103/PhysRevA.103.032430.

https:///doi.org/10.1103/PhysRevA.103.032430

[20] Colin McDiarmid. A korlátos különbségek módszeréről. In Surveys in kombinatorics, 1989 (Norwich, 1989), London Math, 141. kötet. Soc. Előadási jegyzet szer., 148–188. Cambridge Univ. Press, Cambridge, 1989. doi: 10.1017/cbo9781107359949.008.

https:///doi.org/10.1017/cbo9781107359949.008

[21] Ville Bergholm, Josh Izaac, Maria Schuld, Christian Gogolin, M Sohaib Alam, Shahnawaz Ahmed, Juan Miguel Arrazola, Carsten Blank, Alain Delgado, Soran Jahangiri és mások. Pennylane: Hibrid kvantum-klasszikus számítások automatikus differenciálása. 2018. arXiv:1811.04968.

arXiv: 1811.04968

[22] Kerstin Beer, Dmytro Bondarenko, Terry Farrelly, Tobias J Osborne, Robert Salzmann, Daniel Scheiermann és Ramona Wolf. Mélykvantum neurális hálózatok képzése. Nature Communications, 11(1):1–6, 2020. doi:10.1038/s41467-020-14454-2.

https://doi.org/10.1038/s41467-020-14454-2

Idézi

[1] Junyu Liu, Zexi Lin és Liang Jiang, „Laziness, Barren Plateau, and Noise in Machine Learning”, arXiv: 2206.09313, (2022).

[2] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu, Shan You és Dacheng Tao, „Erratum: Learnability of Quantum Neural Networks [PRX QUANTUM 2, 040337 (2021)]”, PRX Quantum 3 3, 030901 (2022).

A fenti idézetek innen származnak SAO/NASA HIRDETÉSEK (utolsó sikeres frissítés: 2023-04-27 12:25:17). Előfordulhat, hogy a lista hiányos, mivel nem minden kiadó ad megfelelő és teljes hivatkozási adatokat.

Nem sikerült lekérni Az adatok által hivatkozott kereszthivatkozás utolsó próbálkozáskor 2023-04-27 12:25:15: Nem sikerült lekérni a 10.22331/q-2023-04-27-989 hivatkozás által hivatkozott adatokat a Crossref-től. Ez normális, ha a DOI-t nemrég regisztrálták.

Ez a tanulmány a Quantumban jelent meg Creative Commons Nevezd meg 4.0 International (CC BY 4.0) engedély. A szerzői jog az eredeti szerzői jog tulajdonosainál marad, például a szerzőknél vagy intézményeiknél.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoAiStream. Web3 adatintelligencia. Felerősített tudás. Hozzáférés itt.

- A jövő pénzverése – Adryenn Ashley. Hozzáférés itt.

- Forrás: https://quantum-journal.org/papers/q-2023-04-27-989/

- :is

- :nem

- 1

- 10

- 11

- 12

- 13

- 14

- 20

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 22

- 7

- 8

- 9

- a

- felett

- KIVONAT

- hozzáférés

- előlegek

- hovatartozás

- AL

- algoritmusok

- Minden termék

- an

- Analitikus

- és a

- Andrew

- április

- VANNAK

- körül

- Arthur

- AS

- társult

- szerző

- szerzők

- Automatikus

- BE

- sör

- Benjámin

- Túl

- mindkét

- szünet

- by

- hívott

- Cambridge

- eset

- központ

- változik

- Változások

- besorolás

- közel

- megjegyzés

- köznép

- távközlés

- teljes

- számítások

- számítástechnika

- megfontolás

- Konvergencia

- copyright

- Költség

- tudott

- Daniel

- dátum

- mély

- függő

- különbségek

- Megkülönböztetés

- megvitatni

- do

- alatt

- dinamika

- E&T

- Edward

- hatás

- belép

- Ez volt

- kifejező

- Funkció

- Február

- flow

- A

- Keretrendszer

- Francis

- ból ből

- funkció

- funkciók

- növekszik

- Harvard

- tartók

- HTTPS

- hibrid

- hibrid kvantum-klasszikus

- i

- if

- in

- Végtelen

- információ

- kezdetben

- Innováció

- intézmények

- érdekes

- Nemzetközi

- JavaScript

- Jennifer

- János

- folyóirat

- ismert

- labor

- nagy

- keresztnév

- tanulás

- Szabadság

- Előadás

- Engedély

- Lista

- helyi

- London

- gép

- gépi tanulás

- Marco

- matematikai

- Lehet..

- módszer

- Meyer

- modell

- modellek

- Hónap

- több

- Természet

- Közel

- hálózat

- hálózatok

- neurális hálózat

- neurális hálózatok

- Zaj

- normális

- szám

- számok

- of

- on

- nyitva

- optimalizálás

- or

- eredeti

- mi

- Papír

- paraméterek

- teljesítmény

- jelenség

- Fizika

- Plató

- Platón adatintelligencia

- PlatoData

- hatalom

- pontosan

- Pontosság

- nyomja meg a

- folyamat

- feldolgozás

- processzorok

- Programozás

- Bizonyít

- ad

- közzétett

- kiadó

- kiadók

- Kvantum

- kvantum algoritmusok

- kvantumszámítás

- kvantum gépi tanulás

- qubit

- Arány

- nemrég

- referenciák

- rezsim

- nyilvántartott

- marad

- maradványok

- képviselet

- kutatás

- Eredmények

- Vélemények

- ROBERT

- Ryan

- sekély

- Sharma

- előadás

- jelentősen

- Simon

- terek

- Államok

- sikeresen

- ilyen

- megfelelő

- támogatás

- Systems

- tehran

- tezuka

- hogy

- A

- azok

- Ezek

- ezt

- Keresztül

- Cím

- nak nek

- Képzések

- alatt

- Egyetemes

- frissítve

- URL

- Értékek

- keresztül

- kötet

- W

- akar

- volt

- we

- széles

- val vel

- Farkas

- év

- te

- Yuan

- zephyrnet

- nulla