Ez a bejegyzés végigvezeti Önt azokon a leggyakoribb kihívásokon, amelyekkel az ügyfelek szembesülnek a belső dokumentumok keresése során, és konkrét útmutatást ad ahhoz, hogy az AWS-szolgáltatások hogyan használhatók fel generatív mesterséges intelligencia-beszélgetési robot létrehozására, amely hasznosabbá teszi a belső információkat.

A strukturálatlan adatok az összes adat 80%-át teszik ki szervezeteken belül található, amely kézikönyveket, PDF-eket, GYIK-eket, e-maileket és egyéb dokumentumokat tartalmaz, amelyek naponta bővülnek. A vállalkozások manapság a belső információk folyamatosan növekvő tárházára támaszkodnak, és problémák merülnek fel, amikor a strukturálatlan adatok mennyisége kezelhetetlenné válik. A felhasználók gyakran azon kapják magukat, hogy különféle belső forrásokat olvasnak és ellenőriznek, hogy megtalálják a szükséges válaszokat.

A belső kérdések és válaszok fórumai segíthetnek a felhasználóknak nagyon konkrét válaszokat kapni, de hosszabb várakozási időt is igényelnek. A vállalatspecifikus belső GYIK-ek esetében a hosszú várakozási idő az alkalmazottak termelékenységének csökkenését eredményezi. A kérdések és válaszok fórumait nehéz skálázni, mivel manuálisan megírt válaszokra támaszkodnak. A generatív mesterséges intelligencia révén jelenleg paradigmaváltás zajlik a felhasználók információkeresésében és megtalálásában. A következő logikus lépés a generatív mesterséges intelligencia használata a nagy dokumentumok kisebb méretű információvá sűrítésére a könnyebb felhasználói fogyasztás érdekében. Ahelyett, hogy hosszú időt töltenének a szöveg olvasásával vagy a válaszokra várva, a felhasználók valós időben készíthetnek összefoglalókat a belső információ több meglévő tárháza alapján.

Megoldás áttekintése

A megoldás lehetővé teszi az ügyfelek számára, hogy a belső dokumentumokkal kapcsolatban feltett kérdésekre válogatott válaszokat kérjenek le egy transzformátormodell segítségével, amely válaszokat generál azokra az adatokra vonatkozó kérdésekre, amelyekre nem képezték ki őket. Ezt a technikát zero-shot prompting néven ismerik. A megoldás elfogadásával az ügyfelek a következő előnyöket élvezhetik:

- Pontos válaszokat találhat a kérdésekre a meglévő belső dokumentumok forrásai alapján

- Csökkentse azt az időt, amelyet a felhasználók a válaszok keresésével töltenek a nagy nyelvi modellek (LLM) használatával, hogy a legfrissebb információkat tartalmazó dokumentumok segítségével szinte azonnali válaszokat adhassanak összetett lekérdezésekre.

- Keressen a korábban megválaszolt kérdésekre egy központi irányítópulton keresztül

- Csökkentse a stresszt, amelyet az információ manuális olvasásával okozott, hogy válaszokat keressen

Retrieval Augmented Generation (RAG)

A Retrieval Augmented Generation (RAG) csökkenti az LLM-alapú lekérdezések néhány hiányosságát azáltal, hogy a tudásbázisból megkeresi a válaszokat, és az LLM segítségével tömör válaszokká foglalja össze a dokumentumokat. Kérlek olvasd el ezt Hozzászólás hogy megtanulják, hogyan kell megvalósítani a RAG-megközelítést Amazon Kendra. A következő kockázatok és korlátozások kapcsolódnak az LLM-alapú lekérdezésekhez, amelyekkel az Amazon Kendra RAG-megközelítése foglalkozik:

- Hallucinációk és nyomon követhetőség – Az LLMS-eket nagy adathalmazokra képezik ki, és válaszokat generálnak a valószínűségekre. Ez pontatlan válaszokhoz vezethet, amelyeket hallucinációnak neveznek.

- Több adatsiló – Ahhoz, hogy a válaszában több forrásból származó adatokra hivatkozhasson, be kell állítani egy összekötő ökoszisztémát az adatok összesítéséhez. A több adattárhoz való hozzáférés manuális és időigényes.

- Biztonság – A biztonság és az adatvédelem kritikus szempontok a RAG és LLM-ek által üzemeltetett társalgási robotok telepítésekor. A használat ellenére Amazon Comprehend a felhasználói lekérdezéseken keresztül esetlegesen megadott személyes adatok kiszűrése érdekében továbbra is fennáll annak a lehetősége, hogy a bevitt adatoktól függően véletlenül személyes vagy érzékeny információk kerüljenek a felszínre. Ez azt jelenti, hogy a chatbothoz való hozzáférés szabályozása kulcsfontosságú az érzékeny információkhoz való véletlen hozzáférés elkerülése érdekében.

- Adatok relevanciája – Az LLMS-eket bizonyos dátumig képezik ki az adatokra, ami azt jelenti, hogy az információ gyakran nem aktuális. A legújabb adatokon alapuló képzési modellekkel kapcsolatos költségek magasak. A pontos és naprakész válaszok biztosítása érdekében a szervezetek felelősek az indexelt dokumentumok tartalmának rendszeres frissítéséért és gazdagításáért.

- Költség – A megoldás bevezetésével kapcsolatos költségeket figyelembe kell venni a vállalkozások számára. A megoldás alkalmazásakor a vállalkozásoknak gondosan fel kell mérniük költségvetési és teljesítményigényeiket. Az LLM-ek működtetése jelentős számítási erőforrásokat igényelhet, ami növelheti a működési költségeket. Ezek a költségek korlátozhatják azokat az alkalmazásokat, amelyeknek nagy léptékben kell működniük. Azonban az egyik előnye a AWS felhő az a rugalmasság, hogy csak azért fizessen, amit használ. Az AWS egy egyszerű, konzisztens, felosztó-kirovó árképzési modellt kínál, így csak a felhasznált erőforrások után kell fizetnie.

Az Amazon SageMaker JumpStart használata

A transzformátor alapú nyelvi modellek esetében a szervezetek számára előnyös lehet Amazon SageMaker JumpStart, amely előre elkészített gépi tanulási modellek gyűjteményét kínálja. Az Amazon SageMaker JumpStart a szöveggenerálási és kérdés-válaszolási (Q&A) alapmodellek széles skáláját kínálja, amelyek könnyen telepíthetők és felhasználhatók. Ez a megoldás egy FLAN T5-XL Amazon SageMaker JumpStart modellt integrál, de különböző szempontokat kell szem előtt tartani, amikor alapozó modell kiválasztása.

A biztonság integrálása munkafolyamatunkba

A biztonsági pillér legjobb gyakorlatait követve Jól megtervezett keret, Amazon Cognito hitelesítésre használják. Az Amazon Cognito User Pools integrálható harmadik féltől származó identitásszolgáltatókkal, amelyek számos hozzáférés-vezérlési keretrendszert támogatnak, beleértve a nyílt engedélyezést (OAuth), az OpenID Connect (OIDC) vagy a Security Assertion Markup Language (SAML) nyelvet. A felhasználók és tevékenységeik azonosítása lehetővé teszi a megoldásnak a nyomon követhetőség fenntartását. A megoldás is használja a Az Amazon Comprehend személyazonosításra alkalmas információk (PII) észlelése funkció automatikusan azonosítja és eltávolítja a személyazonosításra alkalmas adatokat. A módosított személyazonosításra alkalmas adatok címeket, társadalombiztosítási számokat, e-mail-címeket és egyéb bizalmas információkat tartalmaznak. Ez a kialakítás biztosítja, hogy a felhasználó által a beviteli lekérdezésen keresztül megadott személyazonosításra alkalmas adatok törlésre kerüljenek. A személyazonosításra alkalmas adatokat nem tárolja, nem használja az Amazon Kendra, és nem továbbítja az LLM-nek.

Megoldás áttekintése

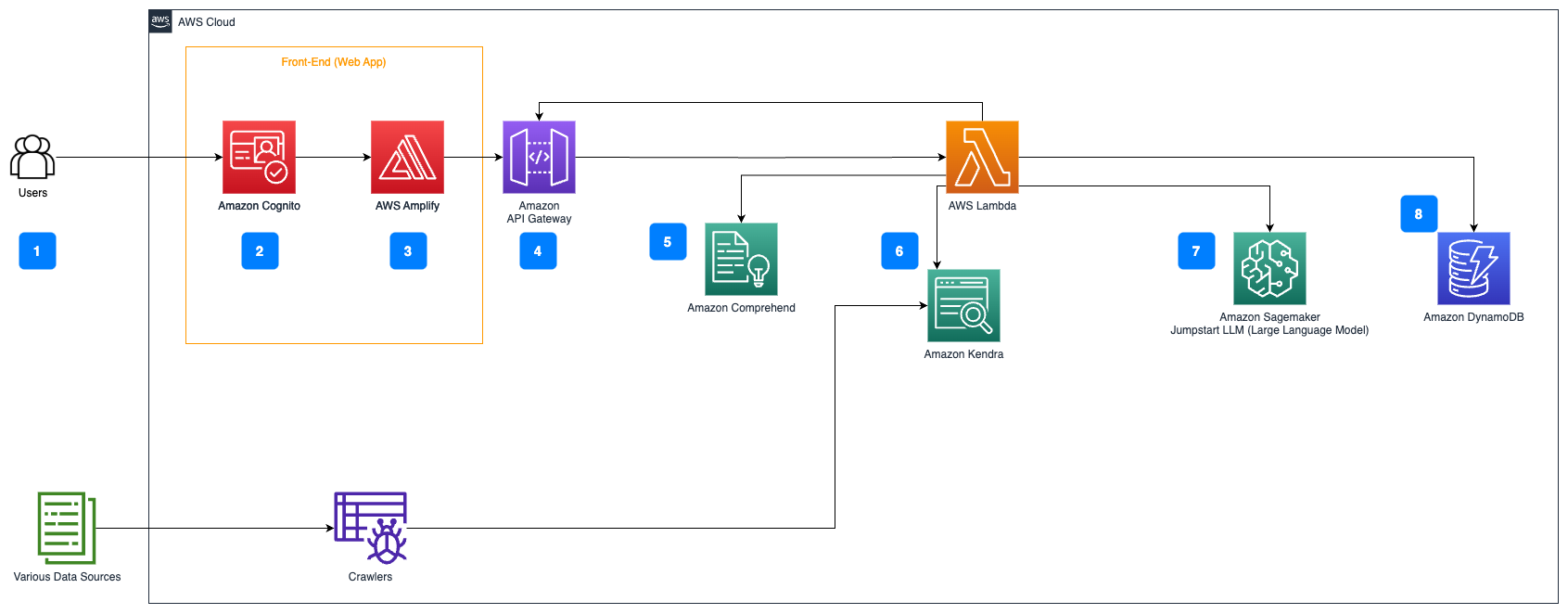

A következő lépések leírják a Kérdések megválaszolása a dokumentumok folyamatán keresztül:

- A felhasználók webes felületen keresztül küldenek lekérdezést.

- Amazon Cognito hitelesítésre szolgál, biztosítva a webalkalmazáshoz való biztonságos hozzáférést.

- A webalkalmazás kezelőfelülete a következő helyen található AWS erősítés.

- Amazon API átjáró különböző végpontokkal rendelkező REST API-t biztosít az Amazon Cognito használatával hitelesített felhasználói kérések kezelésére.

- Személyazonosításra alkalmas adatok szerkesztése Amazon Comprehend:

- Felhasználói lekérdezés feldolgozása: Amikor a felhasználó elküld egy lekérdezést vagy bevitelt, először az Amazon Comprehenden keresztül jut el. A szolgáltatás elemzi a szöveget, és azonosítja a lekérdezésben található összes személyazonosításra alkalmas entitást.

- Személyazonosításra alkalmas adatok kivonása: Az Amazon Comprehend kivonja az észlelt személyazonosításra alkalmas entitásokat a felhasználói lekérdezésből.

- Releváns információk visszakeresése a Amazon Kendra:

- Az Amazon Kendra olyan dokumentumindex kezelésére szolgál, amely tartalmazza a felhasználói kérdésekre adott válaszok generálásához használt információkat.

- A LangChain minőségbiztosítási visszakeresés A modul egy olyan beszélgetési lánc felépítésére szolgál, amely releváns információkat tartalmaz a felhasználói lekérdezésekről.

- Integráció a Amazon SageMaker JumpStart:

- Az AWS Lambda függvény a LangChain könyvtárat használja, és egy kontextussal kitöltött lekérdezéssel csatlakozik az Amazon SageMaker JumpStart végponthoz. Az Amazon SageMaker JumpStart végpont a következtetésekhez használt LLM interfészeként szolgál.

- A válaszok tárolása és visszaküldése a felhasználónak:

- Az LLM válaszát a rendszer tárolja Amazon DynamoDB a felhasználó lekérdezésével, az időbélyeggel, az egyedi azonosítóval és az elem egyéb tetszőleges azonosítóival, például a kérdéskategóriával együtt. A kérdés és a válasz különálló elemként való tárolása lehetővé teszi az AWS Lambda funkciónak, hogy könnyen újra létrehozza a felhasználó beszélgetési előzményeit a kérdések feltevésének időpontja alapján.

- Végül a választ HTTPs-kéréssel küldik vissza a felhasználónak az Amazon API Gateway REST API integrációs válaszán keresztül.

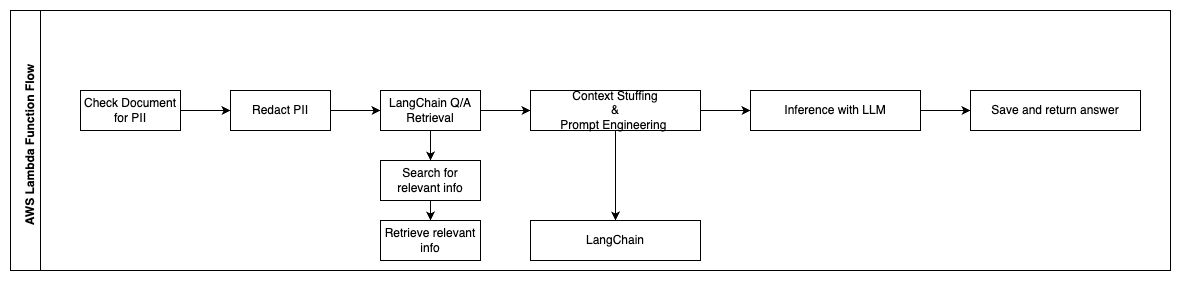

A következő lépések leírják az AWS Lambda funkcióit és azok áramlását a folyamaton keresztül:

- Ellenőrizze és törölje az összes személyazonosításra alkalmas információt/érzékeny információt

- LangChain QA visszakeresési lánc

- Keressen és szerezzen be releváns információkat

- Kontextus töltelék és azonnali tervezés

- Következtetés az LLM-ből

- Válasz visszaküldése és mentése

Használati esetek

Számos üzleti felhasználási eset létezik, ahol az ügyfelek használhatják ezt a munkafolyamatot. A következő szakasz elmagyarázza, hogyan használható a munkafolyamat különböző iparágakban és vertikumokban.

Munkavállalói Segítségnyújtás

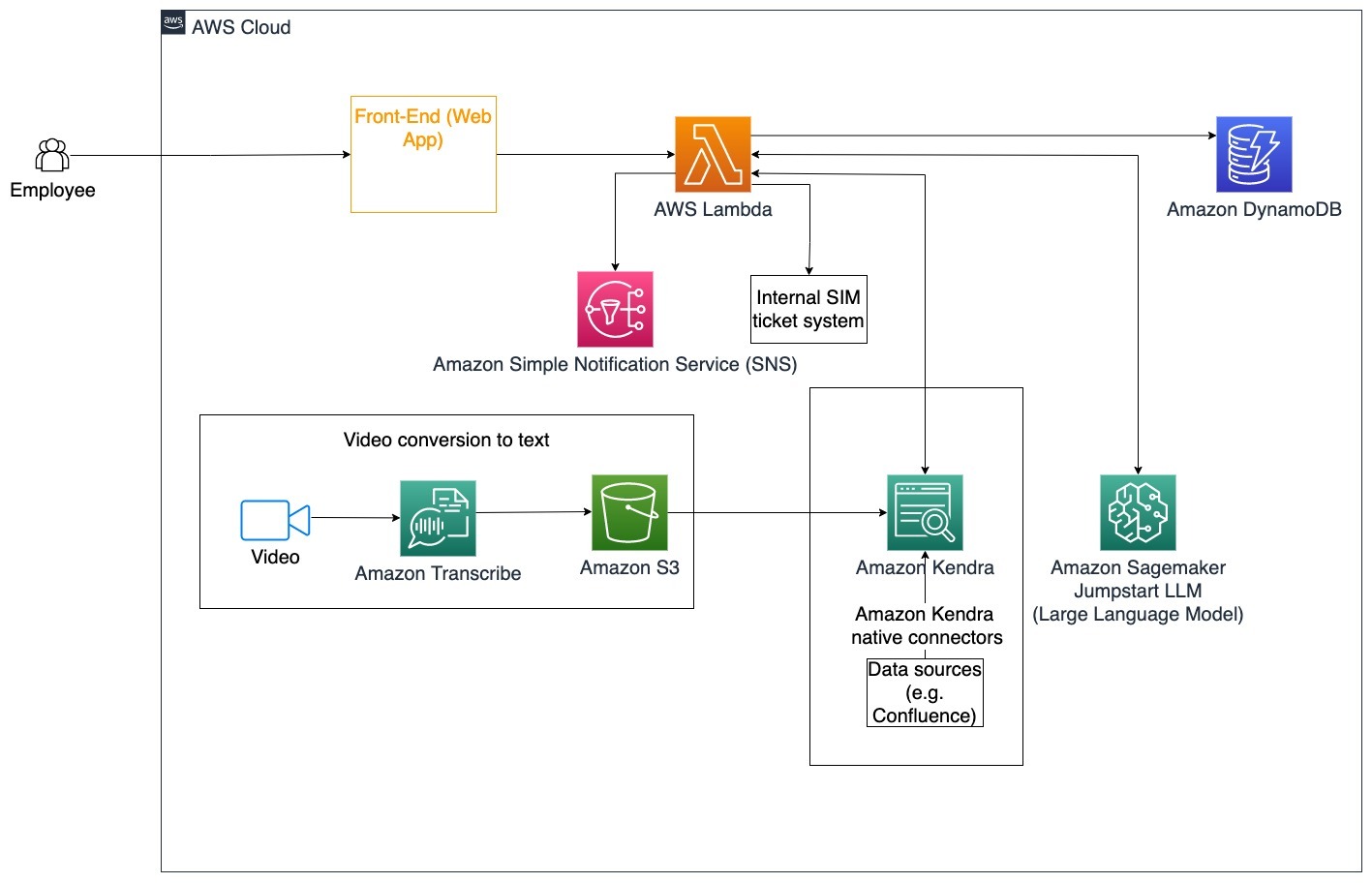

A jól megtervezett vállalati képzés javíthatja az alkalmazottak elégedettségét, és csökkentheti az új alkalmazottak felvételéhez szükséges időt. A szervezetek növekedésével és a komplexitás növekedésével az alkalmazottak nehezen értik meg a belső dokumentumok sokféle forrását. Ebben az összefüggésben a belső dokumentumok közé tartoznak a vállalati irányelvek, irányelvek és a szabványos működési eljárások. Ebben a forgatókönyvben az alkalmazottnak kérdése van, hogyan kell eljárni és szerkeszteni egy belső problémajegy-jegyet. Az alkalmazott hozzáférhet és használhatja a generatív mesterséges intelligencia (AI) társalgási botját, hogy lekérdezze és végrehajtsa a következő lépéseket egy adott jegyhez.

Konkrét felhasználási eset: Automatizálja az alkalmazottak problémamegoldását a vállalati irányelvek alapján.

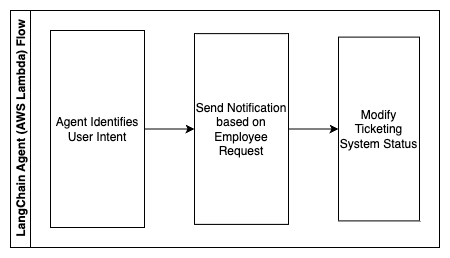

A következő lépések leírják az AWS Lambda funkcióit és azok áramlását a folyamaton keresztül:

- LangChain ügynök a szándék azonosításához

- Értesítés küldése munkavállalói kérés alapján

- Jegy állapotának módosítása

Ezen az architektúradiagramon a vállalati oktatóvideókat is be lehet tölteni Amazon átirat hogy naplót gyűjtsünk ezekről a videoszkriptekről. Ezenkívül a különféle forrásokban (pl. Confluence, Microsoft SharePoint, Google Drive, Jira stb.) tárolt vállalati képzési tartalmak felhasználhatók indexek létrehozására az Amazon Kendra csatlakozókon keresztül. Olvassa el ezt a cikket, ha többet szeretne megtudni a natív gyűjteményről csatlakozók forráspontként használhatja az Amazon Kendrát. Az Amazon Kendra bejáró ezután mind a vállalati képzési videó szkripteket, mind pedig az ezekben a forrásokban tárolt dokumentációkat tudja használni, hogy segítse a társalgási botot a vállalati képzési irányelvekre vonatkozó kérdések megválaszolásában. A LangChain ügynök ellenőrzi az engedélyeket, módosítja a jegyek állapotát, és értesíti a megfelelő személyeket az Amazon Simple Notification Service segítségével (Amazon SNS).

Ügyfélszolgálati csapatok

Az ügyfelek kérdéseinek gyors megoldása javítja a vásárlói élményt és ösztönzi a márkahűséget. A hűséges ügyfélbázis segít növelni az eladásokat, ami hozzájárul az eredményhez és növeli az ügyfelek elkötelezettségét. Az ügyfélszolgálati csapatok sok energiát fordítanak arra, hogy számos belső dokumentumra és ügyfélkapcsolat-kezelő szoftverre hivatkozzanak, hogy megválaszolják az ügyfelek termékeivel és szolgáltatásaival kapcsolatos kérdéseit. Ebben az összefüggésben a belső dokumentumok tartalmazhatnak általános ügyfélszolgálati hívásszkripteket, játékkönyveket, eszkalációs irányelveket és üzleti információkat. A generatív mesterséges intelligencia bot segít a költségoptimalizálásban, mivel az ügyfélszolgálati csapat nevében kezeli a lekérdezéseket.

Konkrét felhasználási eset: Olajcsere kérés kezelése a szervizelőzmények és a megvásárolt ügyfélszolgálati terv alapján.

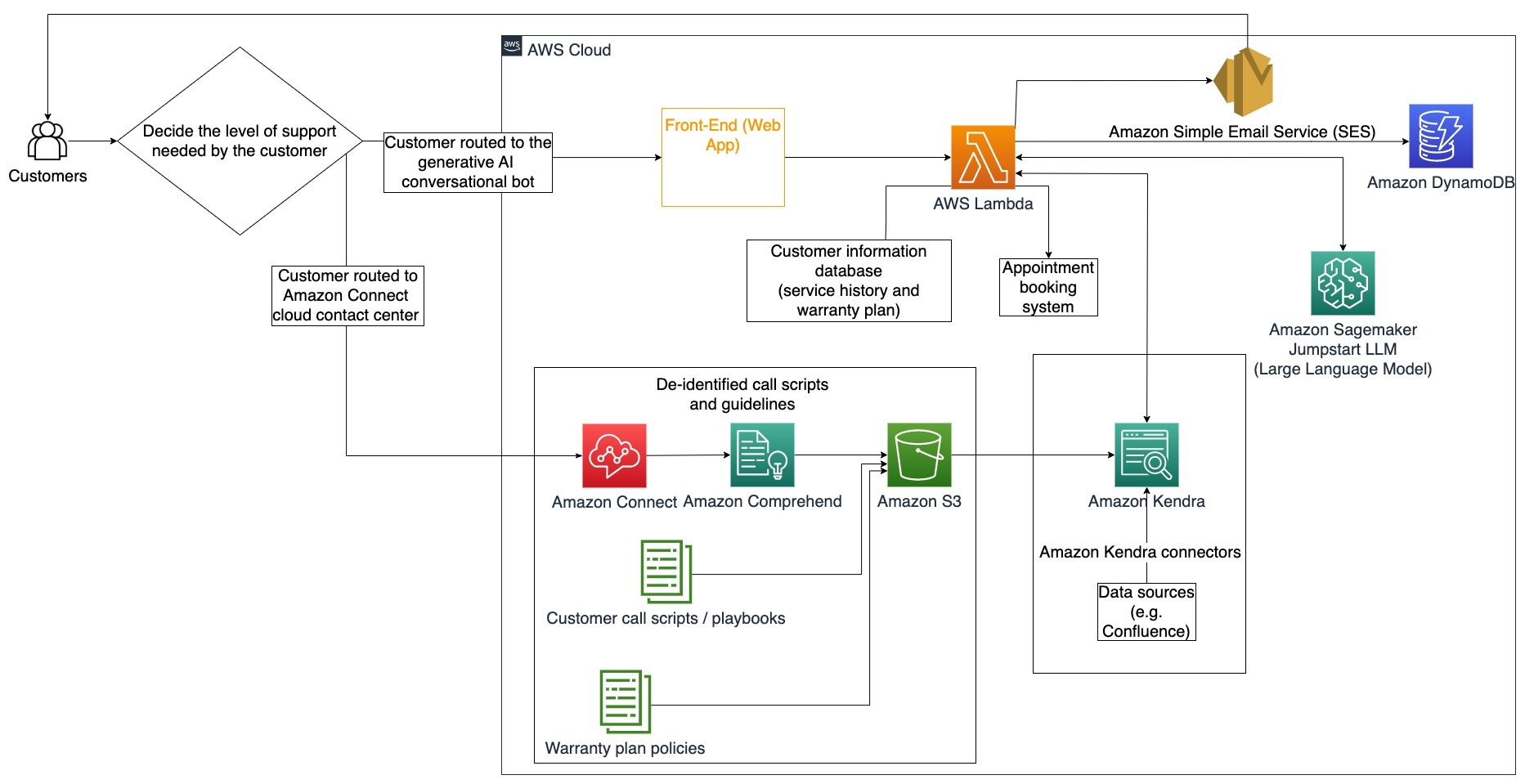

Ezen az architektúra diagramon az ügyfelet vagy a generatív mesterséges intelligencia társalgási botjához vagy a Amazon Connect kapcsolattartó központ. Ez a döntés a szükséges támogatás szintjén vagy az ügyfélszolgálati ügynökök elérhetőségén alapulhat. A LangChain ügynök azonosítja az ügyfél szándékát és ellenőrzi a személyazonosságát. A LangChain ügynök a szervizelőzményeket és a megvásárolt támogatási tervet is ellenőrzi.

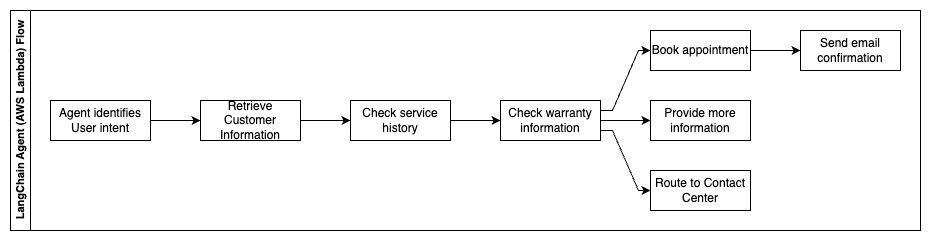

A következő lépések leírják az AWS Lambda funkcióit és azok áramlását a folyamaton keresztül:

- A LangChain ügynök azonosítja a szándékot

- Ügyféladatok lekérése

- Ellenőrizze az ügyfélszolgálati előzményeket és a garanciális információkat

- Foglaljon időpontot, adjon meg további információkat, vagy irányítsa a kapcsolattartó központba

- Megerősítő e-mail küldése

Az Amazon Connect a hang- és csevegésnaplók gyűjtésére szolgál, az Amazon Comprehend pedig a személyazonosításra alkalmas információk (PII) eltávolítására szolgál ezekből a naplókból. Az Amazon Kendra bejáró ezután képes használni a szerkesztett hang- és csevegési naplókat, az ügyfélhívási szkripteket és az ügyfélszolgálati támogatási terv szabályzatát az index létrehozásához. A döntés meghozatala után a generatív mesterséges intelligencia bot eldönti, hogy időpontot foglal-e, további információkat ad-e meg, vagy az ügyfelet a kapcsolattartó központba irányítja további segítségért. A költségek optimalizálása érdekében a LangChain ügynök válaszokat is generálhat kevesebb token és egy olcsóbb nagy nyelvi modell használatával az alacsonyabb prioritású ügyféllekérdezésekhez.

Pénzügyi szolgáltatások

A pénzügyi szolgáltató vállalatok az információk időben történő felhasználására támaszkodnak, hogy versenyképesek maradjanak és megfeleljenek a pénzügyi előírásoknak. A generatív mesterséges intelligencia társalgási bot használatával a pénzügyi elemzők és tanácsadók párbeszédes módon kommunikálhatnak a szöveges információkkal, és csökkentik a megalapozottabb döntések meghozatalához szükséges időt és erőfeszítést. A befektetésen és a piackutatáson kívül a generatív mesterséges intelligencia-bot az emberi képességeket is növelheti azáltal, hogy olyan feladatokat kezel, amelyek hagyományosan több emberi erőfeszítést és időt igényelnek. Például egy személyi kölcsönökre szakosodott pénzintézet növelheti a hitelek feldolgozásának ütemét, miközben jobb átláthatóságot biztosít az ügyfelek számára.

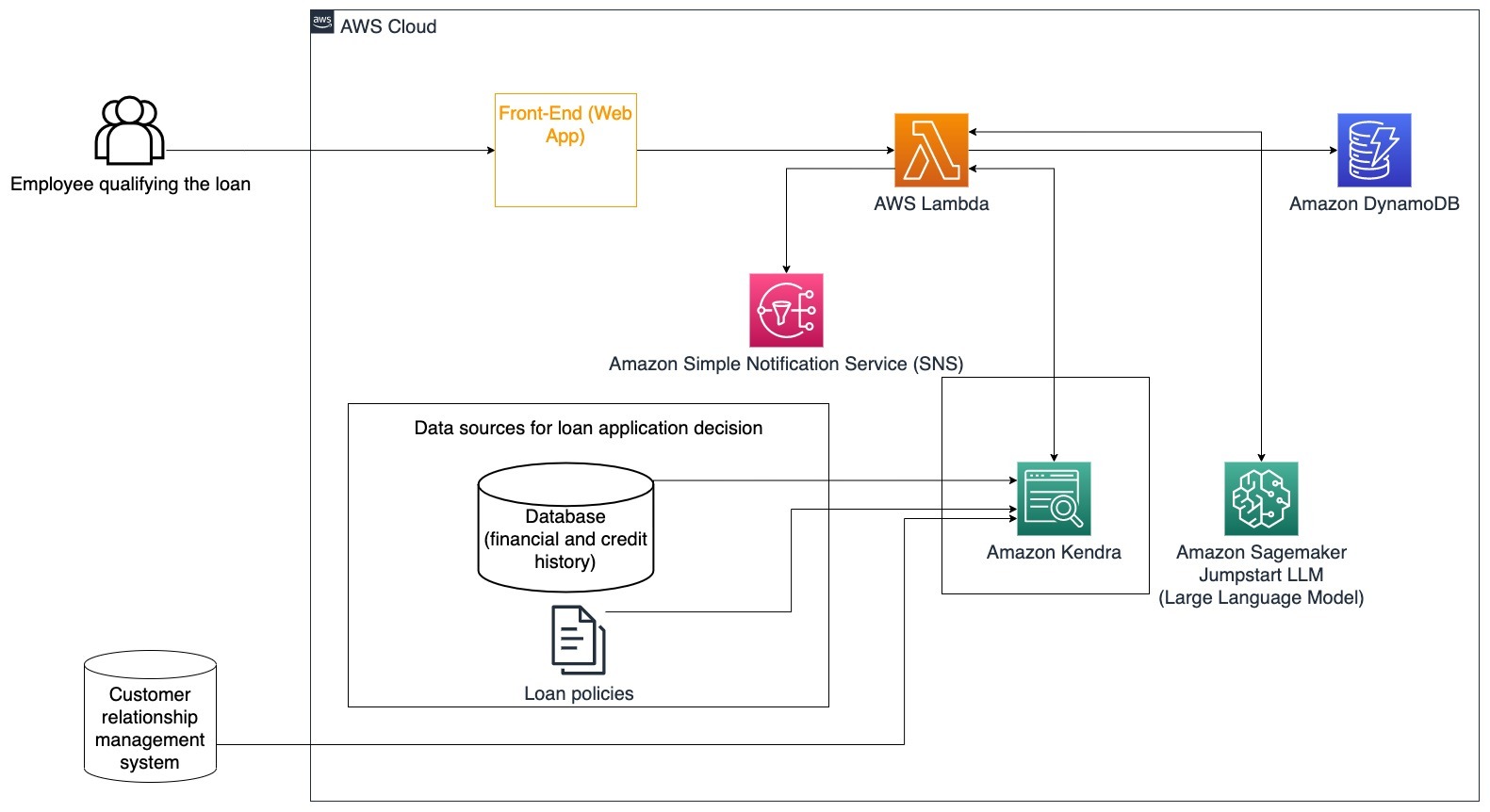

Konkrét felhasználási eset: Használja az ügyfelek pénzügyi előzményeit és korábbi hitelkérelmeit a kölcsön döntéséhez és magyarázatához.

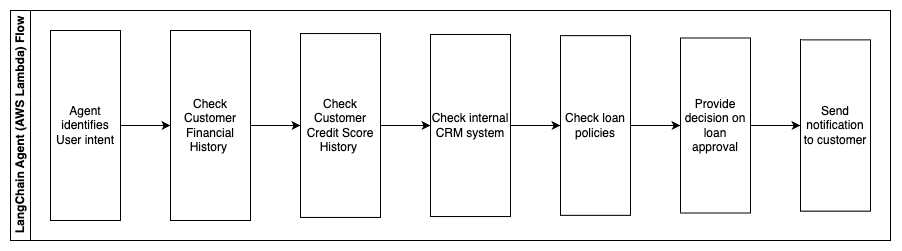

A következő lépések leírják az AWS Lambda funkcióit és azok áramlását a folyamaton keresztül:

- LangChain ügynök a szándék azonosításához

- Ellenőrizze az ügyfelek pénzügyi és hitelképességi előzményeit

- Ellenőrizze a belső ügyfélkapcsolat-kezelő rendszert

- Tekintse meg a szokásos hitelpolitikákat, és javasoljon döntést a kölcsönt feljogosító alkalmazott számára

- Értesítés küldése az ügyfélnek

Ez az architektúra magában foglalja egy adatbázisban tárolt ügyfelek pénzügyi adatait és az ügyfélkapcsolat-kezelő (CRM) eszközben tárolt adatokat. Ezeket az adatpontokat a vállalat belső hitelpolitikáján alapuló döntések meghozatalára használják. Az ügyfél tisztázó kérdéseket tehet fel annak érdekében, hogy megértse, milyen kölcsönökre jogosult, és milyen hitelfeltételeket fogadhat el. Ha a generatív mesterséges intelligencia bot nem tud jóváhagyni egy hitelkérelmet, a felhasználó továbbra is kérdéseket tehet fel a hitelpontszám javításával vagy az alternatív finanszírozási lehetőségekkel kapcsolatban.

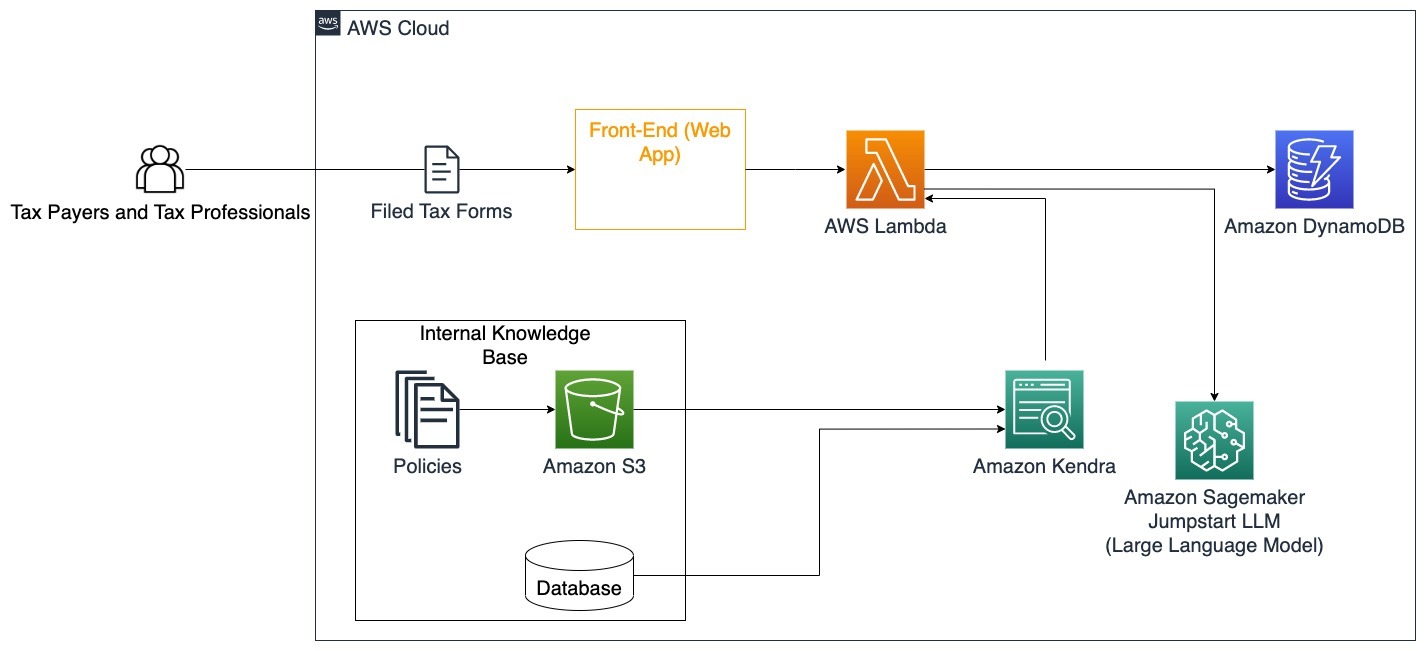

Kormány

A generatív mesterséges intelligencia társalgási botok nagy hasznát vehetik a kormányzati intézményeknek, mivel felgyorsítják a kommunikációt, a hatékonyságot és a döntéshozatali folyamatokat. A generatív mesterséges intelligencia társalgási botok azonnali hozzáférést biztosíthatnak a belső tudásbázisokhoz, amelyek segítségével a kormányzati alkalmazottak gyorsan lekérhetik az információkat, irányelveket és eljárásokat (azaz jogosultsági feltételeket, jelentkezési folyamatokat, valamint állampolgári szolgáltatásokat és támogatást). Az egyik megoldás egy interaktív rendszer, amely lehetővé teszi az adózók és az adószakértők számára, hogy könnyen megtalálják az adózással kapcsolatos részleteket és kedvezményeket. Használható a felhasználói kérdések megértésére, az adózási dokumentumok összegzésére, és interaktív beszélgetéseken keresztül egyértelmű válaszok adására.

A felhasználók kérdéseket tehetnek fel, például:

- Hogyan működik az örökösödési illeték és mik az adóküszöbök?

- Elmagyaráznád a jövedelemadó fogalmát?

- Milyen adóvonzatokkal jár egy második ingatlan eladása?

Ezenkívül a felhasználók kényelmét adó űrlapokat küldhetnek be egy rendszerbe, amely segíthet ellenőrizni a megadott információk helyességét.

Ez az architektúra azt szemlélteti, hogyan tölthetik fel a felhasználók kitöltött adóűrlapokat a megoldásba, és hogyan használhatják fel interaktív ellenőrzésre és útmutatásra a szükséges információk pontos kitöltéséhez.

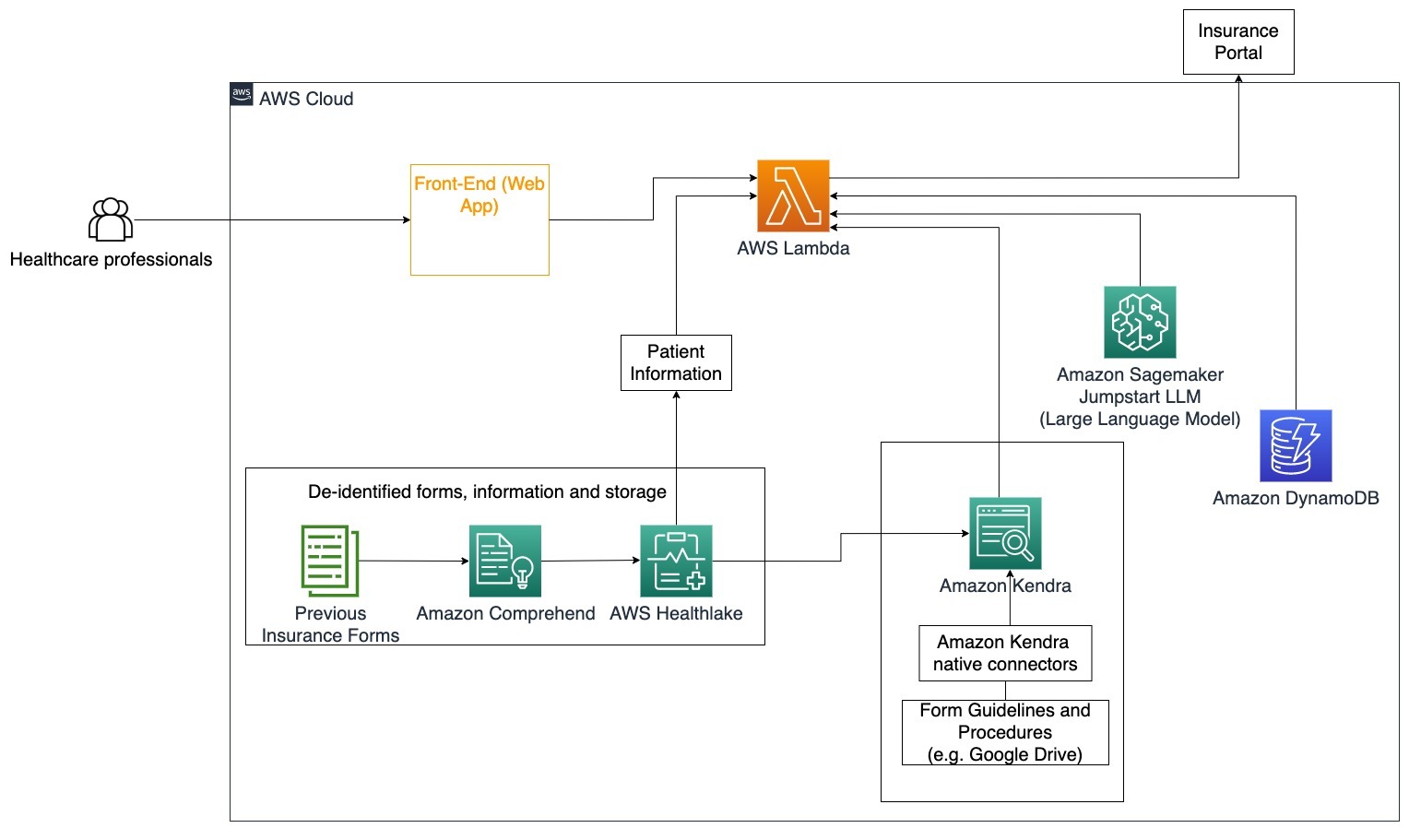

Egészségügy

Az egészségügyi vállalkozásoknak lehetőségük van automatizálni a nagy mennyiségű belső beteginformáció felhasználását, miközben megválaszolják a felhasználási esetekkel kapcsolatos gyakori kérdéseket, például a kezelési lehetőségeket, a biztosítási igényeket, a klinikai vizsgálatokat és a gyógyszerkutatást. A generatív mesterséges intelligencia-bot használata lehetővé teszi az egészségügyi információkkal kapcsolatos válaszok gyors és pontos generálását a rendelkezésre álló tudásbázisból. Például egyes egészségügyi szakemberek sok időt töltenek a biztosítási igények benyújtásához szükséges űrlapok kitöltésével.

Hasonló körülmények között a klinikai vizsgálatok adminisztrátorainak és a kutatóknak információkat kell találniuk a kezelési lehetőségekről. Egy generatív mesterséges intelligencia bot az Amazon Kendra előre beépített csatlakozóival képes lekérni a legrelevánsabb információkat a gyógyszergyárak és egyetemek által folyó kutatások során közzétett több millió dokumentumból.

Konkrét felhasználási eset: Csökkentse a hibákat és a biztosítási űrlapok kitöltéséhez és elküldéséhez szükséges időt.

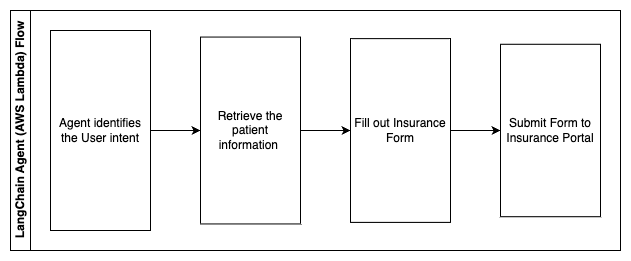

Ezen az architektúra diagramon az egészségügyi szakember képes a generatív mesterséges intelligencia beszélgető robot segítségével kitalálni, milyen űrlapokat kell kitölteni a biztosításhoz. A LangChain ügynök ezután képes lekérni a megfelelő űrlapokat és hozzáadni a szükséges információkat a pácienshez, valamint válaszokat adni az űrlapok leíró részeire a biztosítási kötvények és a korábbi űrlapok alapján. Az egészségügyi szakember szerkesztheti az LLM által adott válaszokat az űrlap jóváhagyása és a biztosítási portálra való eljuttatása előtt.

A következő lépések leírják az AWS Lambda funkcióit és azok áramlását a folyamaton keresztül:

- LangChain ügynök a szándék azonosításához

- Kérje le a szükséges betegadatokat

- Töltse ki a biztosítási űrlapot a betegtájékoztató és formai útmutató alapján

- A felhasználói jóváhagyást követően küldje el az űrlapot a biztosítási portálnak

AWS HealthLake az egészségügyi adatok biztonságos tárolására szolgál, beleértve a korábbi biztosítási űrlapokat és a betegadatokat, az Amazon Comprehend pedig a személyazonosításra alkalmas adatok (PII) eltávolítására szolgál a korábbi biztosítási űrlapokról. Az Amazon Kendra bejáró ezután a biztosítási űrlapok és irányelvek készletét tudja használni az index létrehozásához. Miután a generatív mesterséges intelligencia kitöltötte az űrlapo(ka)t, az orvos által átvizsgált űrlap(ok) elküldhetők a biztosítási portálnak.

Költségbecslés

Az alapmegoldás koncepcionális bizonyítékként való bevezetésének költségeit a következő táblázat mutatja. Mivel az alapmegoldást a koncepció bizonyítékának tekintik, az Amazon Kendra Developer Edition-t alacsony költségű lehetőségként használták, mivel a munkaterhelés nem lenne termelésben. Feltételezésünk az Amazon Kendra Developer Edition esetében 730 aktív óra volt a hónapban.

Az Amazon SageMaker esetében azt feltételeztük, hogy az ügyfél az ml.g4dn.2xlarge példányt fogja használni valós idejű következtetésekhez, példányonként egyetlen következtetési végponttal. További információt találhat az Amazon SageMaker árképzéséről és az elérhető következtetési példánytípusokról itt.

| szolgáltatás | Felhasznált erőforrások | Havi költségbecslés USD-ben |

| AWS erősítés | 150 építési perc 1 GB kiszolgált adat 500,000 kérelem |

15.71 |

| Amazon API átjáró | 1M REST API hívások | 3.5 |

| AWS Lambda | 1 millió kérés 5 másodperc időtartam kérésenként 2 GB memória lefoglalva |

160.23 |

| Amazon DynamoDB | 1 millió olvasottság 1 millióan írnak 100 GB tárhely |

26.38 |

| Amazon Sagemaker | Valós idejű következtetés az ml.g4dn.2xlarge segítségével | 676.8 |

| Amazon Kendra | Fejlesztői kiadás, 730 óra/hó 10,000 XNUMX szkennelt dokumentum 5,000 lekérdezés/nap |

821.25 |

| . | . | Összköltség: 1703.87 |

* Az Amazon Cognito ingyenes szintje 50,000 50 havi aktív felhasználó, akik Cognito felhasználói csoportokat használnak, vagy 2.0 havi aktív felhasználó, akik SAML XNUMX identitásszolgáltatókat használnak.

Clean Up

A költségek megtakarítása érdekében törölje az oktatóanyag részeként telepített összes erőforrást. A SageMaker konzolon keresztül esetleg létrehozott SageMaker végpontokat törölheti. Ne feledje, hogy az Amazon Kendra index törlése nem távolítja el az eredeti dokumentumokat a tárhelyről.

Következtetés

Ebben a bejegyzésben megmutattuk, hogyan lehet leegyszerűsíteni a belső információkhoz való hozzáférést azáltal, hogy több adattárból valós idejű összegzést készít. A kereskedelemben kapható LLM-ek legújabb fejlesztései után a generatív mesterséges intelligencia lehetőségei nyilvánvalóbbá váltak. Ebben a bejegyzésben bemutattuk, hogyan használhatja az AWS-szolgáltatásokat egy kiszolgáló nélküli chatbot létrehozására, amely generatív mesterséges intelligencia segítségével válaszol kérdésekre. Ez a megközelítés magában foglal egy hitelesítési réteget és az Amazon Comprehend személyazonosításra alkalmas azonosítását, hogy kiszűrje a felhasználó lekérdezésében megadott érzékeny információkat. Legyen szó akár az egészségügyben dolgozó egyénekről, akik tisztában vannak a biztosítási igények benyújtásának árnyalataival, vagy a HR-esekkel, akik ismerik az adott vállalati szintű szabályozást, számos iparág és vertikum profitálhat ebből a megközelítésből. A chatbot mögött egy Amazon SageMaker JumpStart alapmodell áll, míg a RAG technikát alkalmazó kontextus-kitöltési megközelítést alkalmaznak annak biztosítására, hogy a válaszok pontosabban hivatkozzanak a belső dokumentumokra.

Ha többet szeretne megtudni a generatív mesterséges intelligencia AWS-en való használatáról, tekintse meg a következőt: Új eszközök bejelentése a generatív AI-val való építéshez az AWS-en. Ha részletesebb útmutatást szeretne kapni a RAG-technika AWS-szolgáltatásokkal való használatáról, lásd: Gyorsan építhet nagy pontosságú generatív mesterséges intelligencia alkalmazásokat vállalati adatokra az Amazon Kendra, a LangChain és a nagy nyelvi modellek segítségével. Mivel ebben a blogban a megközelítés LLM agnosztikus, bármely LLM felhasználható következtetésekre. Következő bejegyzésünkben felvázoljuk a megoldás megvalósításának módjait az Amazon Bedrock és az Amazon Titan LLM segítségével.

A szerzőkről

Abhishek Maligehalli Shivalingaiah az AWS vezető mesterséges intelligencia-szolgáltatási építésze. Szenvedélye a Generative AI, az Amazon Kendra és az NLP segítségével történő alkalmazások készítése. Körülbelül 10 éves tapasztalattal rendelkezik az ügyfelek és a vállalkozások számára értéket teremtő Data & AI megoldások építésében. Még egy (személyes) chatbotot is készített szórakozásból, hogy megválaszolja a karrierjével és szakmai útjával kapcsolatos kérdéseket. A munkán kívül szeret portrékat készíteni családjáról és barátairól, és szeret műalkotásokat készíteni.

Abhishek Maligehalli Shivalingaiah az AWS vezető mesterséges intelligencia-szolgáltatási építésze. Szenvedélye a Generative AI, az Amazon Kendra és az NLP segítségével történő alkalmazások készítése. Körülbelül 10 éves tapasztalattal rendelkezik az ügyfelek és a vállalkozások számára értéket teremtő Data & AI megoldások építésében. Még egy (személyes) chatbotot is készített szórakozásból, hogy megválaszolja a karrierjével és szakmai útjával kapcsolatos kérdéseket. A munkán kívül szeret portrékat készíteni családjáról és barátairól, és szeret műalkotásokat készíteni.

Medha Aiyah az AWS-nél, a texasi austini székhelyű megoldások építésztársa. Nemrég szerzett diplomát a dallasi Texasi Egyetemen, 2022 decemberében számítástechnikai mesterképzésben, intelligens rendszerekre specializálódott, és az AI/ML-re összpontosít. Érdekli, hogy többet tudjon meg az AI/ML-ről és az AWS-szolgáltatások felhasználásáról, hogy olyan megoldásokat fedezzen fel, amelyekből az ügyfelek profitálhatnak.

Medha Aiyah az AWS-nél, a texasi austini székhelyű megoldások építésztársa. Nemrég szerzett diplomát a dallasi Texasi Egyetemen, 2022 decemberében számítástechnikai mesterképzésben, intelligens rendszerekre specializálódott, és az AI/ML-re összpontosít. Érdekli, hogy többet tudjon meg az AI/ML-ről és az AWS-szolgáltatások felhasználásáról, hogy olyan megoldásokat fedezzen fel, amelyekből az ügyfelek profitálhatnak.

Hugo Tse az AWS-nél, a washingtoni Seattle-ben székhelyű AWS megoldások építésztársa. Az Arizonai Állami Egyetemen szerzett informatikai mesterfokozatot, a Chicagói Egyetemen pedig közgazdaságtanból szerzett bachelor fokozatot. Tagja az Information Systems Audit and Control Association (ISACA) és a Nemzetközi Információs Rendszerbiztonsági Tanúsító Konzorciumnak (ISC)2. Élvezi, hogy ügyfelei hasznot húzzanak a technológia előnyeiből.

Hugo Tse az AWS-nél, a washingtoni Seattle-ben székhelyű AWS megoldások építésztársa. Az Arizonai Állami Egyetemen szerzett informatikai mesterfokozatot, a Chicagói Egyetemen pedig közgazdaságtanból szerzett bachelor fokozatot. Tagja az Information Systems Audit and Control Association (ISACA) és a Nemzetközi Információs Rendszerbiztonsági Tanúsító Konzorciumnak (ISC)2. Élvezi, hogy ügyfelei hasznot húzzanak a technológia előnyeiből.

Ayman Ishimwe az AWS-nél, a washingtoni Seattle-ben székhelyű AWS megoldások építésztársa. Az Oakland Egyetemen szerzett mesterfokozatot szoftvermérnöki és informatikai szakon. Korábbi tapasztalata van szoftverfejlesztésben, konkrétan elosztott webalkalmazásokhoz való mikroszolgáltatások kiépítésében. Szenvedélyesen segíti ügyfeleit robusztus és méretezhető megoldások kidolgozásában az AWS felhőszolgáltatásokon a legjobb gyakorlatokat követve.

Ayman Ishimwe az AWS-nél, a washingtoni Seattle-ben székhelyű AWS megoldások építésztársa. Az Oakland Egyetemen szerzett mesterfokozatot szoftvermérnöki és informatikai szakon. Korábbi tapasztalata van szoftverfejlesztésben, konkrétan elosztott webalkalmazásokhoz való mikroszolgáltatások kiépítésében. Szenvedélyesen segíti ügyfeleit robusztus és méretezhető megoldások kidolgozásában az AWS felhőszolgáltatásokon a legjobb gyakorlatokat követve.

Shervin Suresh az AWS-nél, a texasi austini székhelyű megoldások építésztársa. A San Jose Állami Egyetemen szerzett mesterdiplomát szoftvermérnöki szakon felhőalapú számítástechnika és virtualizáció területén, valamint számítástechnikai mérnöki diplomát. Szenvedélyesen használja a technológiát, hogy javítsa a különböző hátterű emberek életét.

Shervin Suresh az AWS-nél, a texasi austini székhelyű megoldások építésztársa. A San Jose Állami Egyetemen szerzett mesterdiplomát szoftvermérnöki szakon felhőalapú számítástechnika és virtualizáció területén, valamint számítástechnikai mérnöki diplomát. Szenvedélyesen használja a technológiát, hogy javítsa a különböző hátterű emberek életét.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Autóipar / elektromos járművek, Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- ChartPrime. Emelje fel kereskedési játékát a ChartPrime segítségével. Hozzáférés itt.

- BlockOffsets. A környezetvédelmi ellentételezési tulajdon korszerűsítése. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :van

- :is

- :nem

- :ahol

- $ UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Képes

- Rólunk

- Elfogad!

- hozzáférés

- Hozzáférés

- Fiókok

- pontos

- pontosan

- cselekvések

- aktív

- hozzá

- Ezen kívül

- címek

- címzés

- adminisztrátorok

- Elfogadása

- tanácsadók

- Után

- Ügynök

- szerek

- adalékanyag

- AI

- AI szolgáltatások

- AI / ML

- Minden termék

- lehetővé teszi, hogy

- mentén

- Is

- alternatív

- amazon

- Amazon API átjáró

- Amazon Cognito

- Amazon Comprehend

- Amazon Kendra

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Az Amazon Web Services

- összeg

- Összegek

- an

- Az elemzők

- elemzések

- és a

- válasz

- válaszok

- bármilyen

- api

- látszólagos

- Alkalmazás

- alkalmazások

- időpont egyeztetés

- megközelítés

- jóváhagy

- építészet

- VANNAK

- felmerülhet

- arizona

- körül

- cikkben

- mesterséges

- mesterséges intelligencia

- Mesterséges intelligencia (AI)

- műalkotások

- AS

- kérdez

- szempontok

- értékeli

- segít

- Támogatás

- Társult

- társult

- Egyesület

- feltevés

- At

- könyvvizsgálat

- bővített

- Austin

- hitelesített

- Hitelesítés

- meghatalmazás

- automatizált

- automatikusan

- elérhetőség

- elérhető

- AWS

- AWS Lambda

- vissza

- háttérrel

- bázis

- alapján

- BE

- Viselik

- mert

- válik

- válik

- óta

- előtt

- nevében

- mögött

- haszon

- Előnyök

- BEST

- legjobb gyakorlatok

- Jobb

- Blog

- könyv

- Bot

- mindkét

- botok

- Alsó

- márka

- költségvetés

- épít

- Épület

- épült

- üzleti

- vállalkozások

- de

- by

- hívás

- TUD

- képességek

- Karrier

- gondosan

- eset

- esetek

- Kategória

- okozott

- Központ

- központosított

- bizonyos

- Tanúsítvány

- lánc

- kihívások

- változik

- töltött

- chatbot

- ellenőrzése

- Ellenőrzések

- Chicago

- követelések

- világos

- Klinikai

- klinikai vizsgálatok

- felhő

- cloud computing

- felhő szolgáltatások

- gyűjt

- gyűjtemény

- kereskedelemben

- Közös

- közlés

- Companies

- vállalat

- Társaságé

- versenyképes

- Befejezett

- kitöltésével

- bonyolult

- bonyolultság

- megfelelnek

- megért

- számítógép

- Informatika

- Computer Science

- számítástechnika

- koncentráció

- koncepció

- tömör

- lefolytatott

- összefolyás

- Csatlakozás

- összeköt

- megfontolás

- megfontolások

- figyelembe vett

- következetes

- Összeáll

- Konzol

- konzorcium

- fogyaszt

- fogyasztás

- kapcsolat

- kapcsolatközpont

- tartalmaz

- tartalom

- kontextus

- folyamatosan

- hozzájárul

- ellenőrzés

- kontrolling

- kényelem

- Beszélgetés

- társalgó

- beszélgetések

- Társasági

- kijavítására

- Költség

- kiadások

- lánctalpas

- teremt

- Érték létrehozása

- készítette

- létrehozása

- hitel

- kritériumok

- kritikai

- CRM

- kritikus

- a válogatott

- Jelenlegi

- Jelenleg

- vevő

- Ügyfél-elkötelezettség

- Vásárlói élmény

- Vevőszolgálat

- Vevőszolgálat

- Ügyfelek

- napi

- Dallas

- dátum

- adat pontok

- adatkészletek

- adatbázis

- találka

- december

- dönt

- döntés

- Döntéshozatal

- határozatok

- Fok

- szállított

- attól

- telepített

- bevezetéséhez

- leírni

- Design

- Ellenére

- részletek

- észlelt

- Érzékelés

- Fejlesztő

- Fejlesztés

- fejlesztések

- különböző

- nehéz

- felfedez

- megosztott

- dokumentáció

- dokumentumok

- nem

- Nem

- hajtás

- időtartama

- e

- könnyebb

- könnyen

- Közgazdaságtan

- ökoszisztéma

- kiadás

- hatékonyság

- erőfeszítés

- bármelyik

- jogosultság

- e-mailek

- munkavállaló

- alkalmazottak

- lehetővé teszi

- ösztönzi

- Endpoint

- energia

- eljegyzés

- Motor

- Mérnöki

- gazdagító

- biztosítására

- biztosítja

- biztosítása

- Vállalkozás

- Vállalatok

- Szervezetek

- hibák

- eszkaláció

- becslés

- stb.

- Még

- példa

- kivégez

- létező

- drága

- tapasztalat

- Magyarázza

- Elmagyarázza

- kitermelés

- kivonatok

- Arc

- család

- Funkció

- Fed

- kevesebb

- Ábra

- filé

- kitöltése

- megtöltött

- töltő

- szűrő

- pénzügyi

- pénzügyi adat

- pénzügyi történelem

- pénzintézet

- finanszírozás

- Találjon

- megtalálása

- vezetéknév

- Rugalmasság

- áramlási

- összpontosítás

- következő

- A

- forma

- formák

- fórumok

- talált

- Alapítvány

- keretek

- Ingyenes

- barátok

- ból ből

- móka

- funkció

- funkciók

- további

- Nyereség

- gateway

- generál

- generáció

- nemző

- Generatív AI

- kap

- adott

- ad

- Giving

- Kormány

- nagymértékben

- Nő

- Növekvő

- növekszik

- útmutatást

- irányelvek

- fogantyú

- Fogantyúk

- Kezelés

- Legyen

- tekintettel

- he

- Egészség

- egészségügyi információ

- egészségügyi

- segít

- segít

- segít

- neki

- Magas

- nagyon

- övé

- történelem

- tart

- házigazdája

- hosts

- NYITVATARTÁS

- Hogyan

- How To

- azonban

- hr

- HTML

- HTTPS

- emberi

- i

- azonosító

- azonosítók

- azonosítja

- azonosítani

- azonosító

- Identitás

- if

- illusztrálja

- végre

- végrehajtási

- következményei

- javul

- javítja

- javuló

- in

- mélyreható

- pontatlan

- tartalmaz

- magában foglalja a

- Beleértve

- Jövedelem

- jövedelemadó

- Növelje

- Növeli

- index

- indexelt

- indexek

- egyének

- iparágak

- tájékoztat

- információ

- Információs Rendszerek

- információs technológia

- tájékoztatták

- öröklés

- bemenet

- példa

- azonnali

- helyette

- Intézmény

- intézmények

- biztosítás

- integrált

- integrál

- integráció

- Intelligencia

- Intelligens

- A szándék

- kölcsönhatásba

- interaktív

- érdekelt

- Felület

- belső

- Nemzetközi

- bele

- beruházás

- kérdés

- IT

- tételek

- utazás

- jpg

- Tart

- tudás

- ismert

- nyelv

- nagy

- réteg

- vezet

- TANUL

- tanulás

- kevesebb

- szint

- erőfölény

- könyvtár

- korlátozás

- korlátozások

- vonal

- életek

- LLM

- hitel

- Hitelek

- log

- logikus

- Hosszú

- hosszú idő

- hosszabb

- néz

- Sok

- szeret

- olcsó

- alacsonyabb

- hűséges

- Hűség

- gép

- gépi tanulás

- készült

- fenntartása

- csinál

- KÉSZÍT

- Gyártás

- kezelése

- vezetés

- mód

- kézikönyv

- kézzel

- sok

- piacára

- piackutatás

- mester

- Lehet..

- eszközök

- orvosi

- tag

- Memory design

- microservices

- microsoft

- millió

- Több millió

- bánja

- ML

- modell

- modellek

- Modulok

- Hónap

- havi

- több

- a legtöbb

- többszörös

- bennszülött

- elengedhetetlen

- Szükség

- szükséges

- igények

- Új

- következő

- NLP

- bejelentés

- számok

- Oakland

- auth

- of

- Ajánlatok

- gyakran

- Olaj

- on

- Beszállás

- egyszer

- ONE

- folyamatban lévő

- csak

- nyitva

- működik

- üzemeltetési

- operatív

- Alkalom

- optimalizálás

- opció

- Opciók

- or

- érdekében

- szervezetek

- eredeti

- Más

- mi

- ki

- vázlat

- kívül

- felett

- paradigma

- rész

- alkatrészek

- Elmúlt

- szenvedélyes

- beteg

- Fizet

- Emberek (People)

- mert

- teljesítmény

- engedélyek

- személyes

- személyes adat

- Személyesen

- Gyógyszeripari

- Pillér

- terv

- Plató

- Platón adatintelligencia

- PlatoData

- kérem

- pont

- pont

- Politikák

- medencék

- Portál

- portrék

- lehetőségek

- lehetőség

- állás

- powered

- gyakorlat

- be

- megakadályozása

- előző

- korábban

- árazás

- árazási modell

- Előzetes

- prioritás

- magánélet

- problémák

- eljárások

- folytassa

- folyamat

- Feldolgozott

- Folyamatok

- feldolgozás

- Termelés

- termelékenység

- Termékek

- szakmai

- tehetséges alkalmazottal

- ingatlan

- ad

- feltéve,

- szolgáltatók

- amely

- közzétett

- vásárolt

- Kérdések és válaszok

- jogosultak

- képesítő

- lekérdezések

- kérdés

- Kérdések

- Quick

- gyorsan

- hatótávolság

- Arány

- Olvass

- Olvasás

- real-time

- új

- nemrég

- csökkenteni

- csökkenti

- utal

- referenciái

- tekintettel

- rendszeresen

- előírások

- kapcsolat

- relevancia

- támaszkodnak

- maradványok

- eszébe jut

- eltávolítása

- kérni

- kéri

- szükség

- kötelező

- követelmények

- kutatás

- kutatók

- Felbontás

- megoldása

- Tudástár

- válasz

- válaszok

- felelősség

- REST

- eredményez

- visszatérő

- felül

- jobb

- kockázatok

- erős

- Útvonal

- futás

- s

- sagemaker

- értékesítés

- San

- San Jose

- elégedettség

- Megtakarítás

- skálázható

- Skála

- forgatókönyv

- Tudomány

- pontszám

- szkriptek

- Keresés

- keres

- Seattle

- Második

- másodperc

- Rész

- biztonság

- biztosan

- biztonság

- Eladási

- küld

- idősebb

- érzékeny

- küldött

- vagy szerver

- szolgálja

- szolgáltatás

- Szolgáltatások

- készlet

- Szettek

- beállítások

- számos

- ő

- váltás

- hiányosságokat

- kellene

- bemutatásra

- kimutatta,

- mutatott

- silók

- hasonló

- Egyszerű

- egyszerűsítése

- óta

- egyetlen

- méretű

- kisebb

- So

- Közösség

- szoftver

- szoftverfejlesztés

- szoftverfejlesztés

- megoldások

- Megoldások

- néhány

- forrás

- Források

- szakosodott

- különleges

- kifejezetten

- költ

- Költési

- standard

- Állami

- Állapot

- tartózkodás

- Lépés

- Lépései

- Még mindig

- tárolás

- tárolni

- memorizált

- tárolása

- feszültség

- töltelék

- lényeges

- ilyen

- javasol

- összegez

- támogatás

- rendszer

- Systems

- táblázat

- tart

- feladatok

- adó

- csapat

- csapat

- Technológia

- feltételek

- Texas

- szöveg

- szövegi

- hogy

- A

- az információ

- azok

- maguk

- akkor

- Ott.

- Ezek

- ők

- harmadik fél

- ezt

- Keresztül

- jegy

- jegykiadó

- tier

- idő

- időigényes

- időszerű

- alkalommal

- időbélyeg

- titán-

- nak nek

- Ma

- tokenek

- szerszám

- szerszámok

- Nyomon követhetőség

- hagyományosan

- kiképzett

- Képzések

- transzformátor

- Átláthatóság

- kezelés

- próba

- vizsgálatok

- oktatói

- típusok

- képtelen

- megért

- megértés

- egyedi

- Egyetemek

- egyetemi

- University of Chicago

- up-to-date

- frissítve

- frissítése

- használ

- használati eset

- használt

- használó

- Felhasználók

- használ

- segítségével

- hasznosít

- hasznosított

- kihasználva

- érték

- különféle

- Igazolás

- ellenőrzése

- függőlegesek

- keresztül

- videó

- Videók

- Hang

- várjon

- Várakozás

- volt

- washington

- módon

- we

- háló

- webalkalmazás

- webes alkalmazások

- webes szolgáltatások

- JÓL

- voltak

- Mit

- amikor

- vajon

- ami

- míg

- WHO

- széles

- Széleskörű

- val vel

- belül

- Munka

- munkafolyamat

- dolgozó

- lenne

- írott

- év

- te

- A te

- zephyrnet