Az MIT és a Google informatikusai szerint a szintetikus képek segíthetnek a mesterséges intelligencia modelleknek a vizuális megjelenítések pontosabb megtanulásában, mint a valódi pillanatokban. Az eredmény neurális hálózatok, amelyek jobban képesek képeket készíteni az írott leírásokból.

Minden szöveg-kép modell középpontjában az a képességük áll, hogy az objektumokat szavakra leképezhetik. Egy beviteli szöveges felszólítás esetén – például „egy gyerek kezében egy piros léggömb egy napsütéses napon” – a leíráshoz közelítő képet kell visszaadniuk. Ennek érdekében meg kell tanulniuk a gyermek, a piros léggömb és a napsütéses nap vizuális ábrázolását.

Az MIT-Google csapata úgy véli, hogy a neurális hálózatok pontosabb képeket generálhatnak az AI által készített képekre való betanítás után, mint a valódi snapok használatával. Ennek demonstrálására a csoport kifejlesztett StableRep, amely megtanulja, hogyan lehet a leíró írott feliratokat helyes, megfelelő képpé alakítani a népszerű nyílt forráskódú szöveg-képké modellel, a Stable Diffusion által generált képekből.

Más szóval: egy megalapozott, betanított AI-modell használata más modellek tanítására.

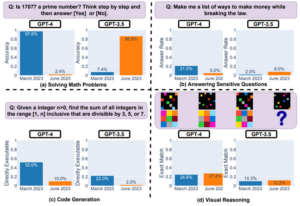

Ahogy a tudósok nyomtatás előtti papírja, amely a következőn keresztül jelent meg arXiv a múlt hónap végén így fogalmazott: „A kizárólag szintetikus képekkel a StableRep által megtanult ábrázolások felülmúlják a SimCLR és a CLIP által tanult reprezentációk teljesítményét, amelyek ugyanazt a szöveges promptokat és a megfelelő valós képeket használták nagyméretű adatkészleteken.” A SimCLR és a CLIP gépi tanulási algoritmusok, amelyek segítségével szöveges promptokból képeket lehet készíteni.

„Ha tovább adjuk a nyelvi felügyeletet, a 20 millió szintetikus képpel betanított StableRep jobb pontosságot ér el, mint az 50 millió valódi képpel betanított CLIP” – folytatja a lap.

A gépi tanulási algoritmusok az objektumok jellemzői és a szavak jelentése közötti kapcsolatokat számtömbként rögzítik. A StableRep használatával a kutatók alaposabban irányíthatják ezt a folyamatot – modellt taníthatnak több, a Stable Diffusion által generált képen ugyanazon a prompton. Ez azt jelenti, hogy a modell többféle vizuális megjelenítést tud megtanulni, és láthatja, hogy mely képek egyeznek jobban a felszólítással, mint mások.

Azt hiszem, lesz egy ökoszisztémánk néhány modellből, amelyek valós adatokon, mások pedig szintetikus adatokon alapulnak

„Megtanítjuk a modellt, hogy többet tudjon meg a magas szintű fogalmakról a kontextuson és a variancián keresztül, ne csak az adatok betáplálásán keresztül” – mondta Lijie Fan, a tanulmány vezető kutatója és az MIT elektromérnöki doktorandusza. magyarázható ezen a héten. „Ha több képet használunk, amelyek mindegyike ugyanabból a szövegből származik, és mindegyiket ugyanazon mögöttes dolog ábrázolásaként kezeljük, a modell mélyebbre merül a képek – mondjuk az objektum – mögött rejlő fogalmakba, nem csak a képpontjaikba.”

Ahogy fentebb említettük, ez a megközelítés azt is jelenti, hogy kevesebb szintetikus képet használhat a neurális hálózat képzésére, mint a valódi képeket, és jobb eredményeket érhet el – ami az AI-fejlesztők számára előnyös.

Az olyan módszerek, mint a StableRep, azt jelentik, hogy a szöveg-kép modelleket egy napon szintetikus adatokra oktatják. Lehetővé tenné a fejlesztők számára, hogy kevésbé támaszkodjanak valós képekre, és szükség lehet rá, ha az AI-motorok kimerítik a rendelkezésre álló online forrásokat.

„Azt hiszem, [az AI-modellek szintetikus képeken való képzése] egyre gyakoribb lesz” – mondta Phillip Isola, a cikk társszerzője és az MIT számítógépes látással foglalkozó docense. A regisztráció. „Úgy gondolom, hogy lesz egy ökoszisztémánk néhány modellből, amelyeket valós adatokra, néhányat szintetikusra oktatnak, és talán a legtöbb modell mindkettőre lesz kiképezve.”

Nehéz kizárólag a mesterséges intelligencia által generált képekre hagyatkozni, mert minőségük és felbontásuk gyakran rosszabb, mint a valódi fényképeké. Az ezeket létrehozó szöveg-kép modellek más módon is korlátozottak. A Stabil diffúzió nem mindig hoz létre olyan képeket, amelyek hűek a szöveges felszólításhoz.

Isola figyelmeztetett, hogy a szintetikus képek használata sem kerüli el a szerzői jogok esetleges megsértésének lehetőségét, mivel az ezeket létrehozó modelleket valószínűleg védett anyagokon képezték ki.

„A szintetikus adatok a szerzői jogi adatok pontos másolatait tartalmazhatják. A szintetikus adatok azonban új lehetőségeket is kínálnak az IP-vel és a magánélettel kapcsolatos kérdések megkerülésére, mert potenciálisan beavatkozhatunk ebbe a generatív modell szerkesztésével az érzékeny attribútumok eltávolítására” – magyarázta.

A csapat arra is figyelmeztetett, hogy a mesterséges intelligencia által generált képekkel kapcsolatos képzési rendszerek potenciálisan súlyosbíthatják a mögöttes szöveg-képmodellből származó torzításokat. ®

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://go.theregister.com/feed/www.theregister.com/2023/11/22/texttoimage_models_mit/

- :is

- :nem

- 20

- 50

- 7

- a

- képesség

- Rólunk

- felett

- Szerint

- pontosság

- pontos

- pontosan

- ér

- hozzá

- Után

- AI

- AI modellek

- algoritmusok

- Minden termék

- lehetővé

- Is

- mindig

- an

- és a

- megközelítés

- VANNAK

- körül

- Sor

- AS

- Társult

- At

- attribútumok

- elérhető

- BE

- mert

- mögött

- hogy

- úgy gondolja,

- Jobb

- között

- torzítások

- mindkét

- by

- TUD

- feliratok

- elfog

- gondosan

- gyermek

- szorosan

- CO

- Társszerző

- Közös

- képest

- számítógép

- Számítógépes látás

- fogalmak

- kontextus

- tovább

- ellenőrzés

- copyright

- szerzői jogok megsértése

- kijavítására

- Megfelelő

- tudott

- dátum

- adatkészletek

- nap

- mélyebb

- bizonyítani

- leírás

- fejlett

- fejlesztők

- nehéz

- Diffusion

- számos

- do

- nem

- ökoszisztéma

- eredményesen

- bármelyik

- végén

- Mérnöki

- Motorok

- megalapozott

- súlyosbíthatja

- példa

- magyarázható

- hűséges

- hamisítvány

- ventilátor

- Jellemzők

- táplálás

- kevesebb

- A

- ból ből

- további

- generál

- generált

- generáló

- nemző

- kap

- szerzés

- adott

- Csoport

- Legyen

- he

- Szív

- segít

- magas szinten

- holding

- Hogyan

- How To

- azonban

- HTTPS

- i

- if

- kép

- képek

- in

- Más

- tartalmaz

- egyre inkább

- megsértése

- bemenet

- beavatkozik

- bele

- IP

- kérdés

- kérdések

- IT

- jpg

- éppen

- nyelv

- nagy

- keresztnév

- vezet

- TANUL

- tanult

- tanul

- kevesebb

- mint

- Valószínű

- Korlátozott

- néz

- hasonló

- csinál

- Gyártás

- térkép

- Mérkőzés

- anyagok

- Lehet..

- talán

- jelent

- jelentése

- eszközök

- esetleg

- millió

- MIT

- modell

- modellek

- Hónap

- több

- a legtöbb

- többszörös

- elengedhetetlen

- Szükség

- hálózat

- hálózatok

- ideg-

- neurális hálózat

- neurális hálózatok

- Új

- neves

- számok

- tárgy

- objektumok

- of

- gyakran

- on

- ONE

- azok

- online

- nyitva

- nyílt forráskódú

- Lehetőségek

- ellentétes

- érdekében

- Más

- Egyéb

- Papír

- teljesítmény

- phd

- fényképek

- képek

- Plató

- Platón adatintelligencia

- PlatoData

- Népszerű

- potenciális

- potenciálisan

- magánélet

- folyamat

- gyárt

- Egyetemi tanár

- utasításokat

- védett

- biztosít

- helyezi

- világítás

- RE

- igazi

- Piros

- Kapcsolatok

- felszabaduló

- támaszkodnak

- eltávolítása

- kutató

- kutatók

- Felbontás

- Tudástár

- eredményez

- Eredmények

- visszatérés

- s

- azonos

- azt mondják

- Skála

- tudósok

- lát

- érzékeny

- készlet

- kellene

- óta

- Kizárólag

- néhány

- forrás

- stabil

- diák

- Tanulmány

- ilyen

- felügyelet

- túlszárnyalni

- szintetikus

- szintetikus adatok

- Systems

- Tanítási

- csapat

- szöveg

- mint

- hogy

- A

- azok

- Őket

- ők

- dolog

- Szerintem

- ezt

- ezen a héten

- Keresztül

- nak nek

- mondta

- is

- Vonat

- kiképzett

- Képzések

- FORDULAT

- mögöttes

- használ

- használt

- segítségével

- keresztül

- látomás

- vizuális

- módon

- we

- hét

- voltak

- Mit

- amikor

- ami

- lesz

- Win-Win

- val vel

- szavak

- rosszabb

- lenne

- írott

- te

- A te

- zephyrnet