Mivel a nagyobb teljesítményű nagynyelvi modelleket (LLM-eket) különféle feladatok nagyobb pontosságú végrehajtására használják, egyre több alkalmazás és szolgáltatás épül. generatív mesterséges intelligencia (AI) is növekszik. A nagy hatalommal együtt jár a felelősség is, és a szervezetek meg akarnak bizonyosodni arról, hogy ezek az LLM-ek olyan válaszokat adnak, amelyek összhangban vannak szervezeti értékeivel, és ugyanazt az egyedi élményt nyújtják, amelyet végfelhasználóiknak szántak.

Az AI által generált válaszok értékelése kihívásokat jelent. Ez a bejegyzés azokat a technikákat tárgyalja, amelyekkel összhangba lehet hozni ezeket a vállalati értékekkel, és egyéni jutalmazási modellt lehet felépíteni Amazon SageMaker. Ezzel személyre szabott ügyfélélményt biztosíthat, amely egyedileg tükrözi szervezete márkaidentitását és szellemiségét.

Kihívások a kész LLM-ekkel

A kész LLM-ek nagy pontosságot biztosítanak, de gyakran nem testreszabhatók a szervezet egyedi igényeihez és végfelhasználóihoz. Az emberi visszajelzések szubjektivitása eltérő a szervezetek és az ügyfélszegmensek között. A változatos, szubjektív emberi visszajelzések gyűjtése az LLM-ek finomítása érdekében időigényes és skálázhatatlan.

Ez a bejegyzés egy jutalommodellezési technikát mutat be, amellyel hatékonyan testreszabhatja az LLM-eket egy szervezet számára azáltal, hogy programozottan definiálja a jutalmazási funkciókat, amelyek rögzítik a modell viselkedésének preferenciáit. Olyan megközelítést mutatunk be, amellyel egy szervezetre szabott LLM-eredményeket biztosítunk intenzív, folyamatos emberi megítélés nélkül. A technikák célja a testreszabási és skálázhatósági kihívások leküzdése azáltal, hogy a szervezet szubjektív minőségi standardjait olyan jutalmazási modellbe kódolják, amely az LLM-et előnyös kimenetek létrehozására irányítja.

Objektív vs. szubjektív emberi visszajelzés

Nem minden emberi visszajelzés egyforma. Az emberi visszajelzéseket két típusba sorolhatjuk: objektív és szubjektív.

Bármely emberi lény, akit felkérnek az alábbi négyzetek színének megítélésére, megerősíti, hogy a bal oldali egy fehér, a jobb pedig egy fekete doboz. Ez objektív, és ezen semmi változás nincs.

Annak meghatározása, hogy egy AI-modell eredménye „nagyszerű-e”, eleve szubjektív. Vegye figyelembe a következő színspektrumot. Ha arra kérik őket, hogy írják le a színeket a végeken, az emberek változatos, szubjektív válaszokat adnának észleléseik alapján. Lehet, hogy az egyik ember fehérje a másiknak szürke.

Ez a szubjektivitás kihívást jelent a mesterséges intelligencia emberi visszajelzéseken keresztüli fejlesztésében. Az objektív helyes/rossz visszajelzésekkel ellentétben a szubjektív preferenciák árnyaltak és személyre szabottak. Ugyanaz a teljesítmény dicséretet válthat ki egyik személyből, és kritikát a másikból. A kulcs az emberi preferenciák alapvető szubjektivitásának elismerése és számonkérése az AI-képzésben. A megfoghatatlan objektív igazságok keresése helyett olyan modelleket kell kínálnunk, amelyek az emberi szubjektív ítélőképesség színes sokféleségére mutatnak rá.

Ellentétben a hagyományos modellfeladatokkal, például az osztályozással, amely jól összehasonlítható a tesztadatkészletekkel, a szerteágazó társalgási ágens minőségének értékelése nagyon szubjektív. Az egyik ember lebilincselő prózája a másiknak céltalan lökdösődése. Hogyan finomíthatnánk tehát ezeket a kiterjedt nyelvi modelleket, amikor az emberek alapvetően nem értenek egyet a „jó” válasz jellemzőivel kapcsolatban?

A kulcs az, hogy visszajelzéseket gyűjtsünk a sokszínű tömegtől. Elegendő szubjektív nézőponttal a vonzó diskurzus, a logikai koherencia és az ártalmatlan tartalom mintái rajzolódnak ki. A modellek ezután szélesebb körű emberi preferenciák alapján hangolhatók. Általános az a felfogás, hogy a jutalmazási modelleket gyakran csak az emberi visszajelzésből való tanulás megerősítésével (RLHF) társítják. A jutalommodellezés valójában túlmutat az RLHF-en, és hatékony eszköz lehet az AI által generált válaszok összehangolására a szervezet sajátos értékeivel és márkaidentitásával.

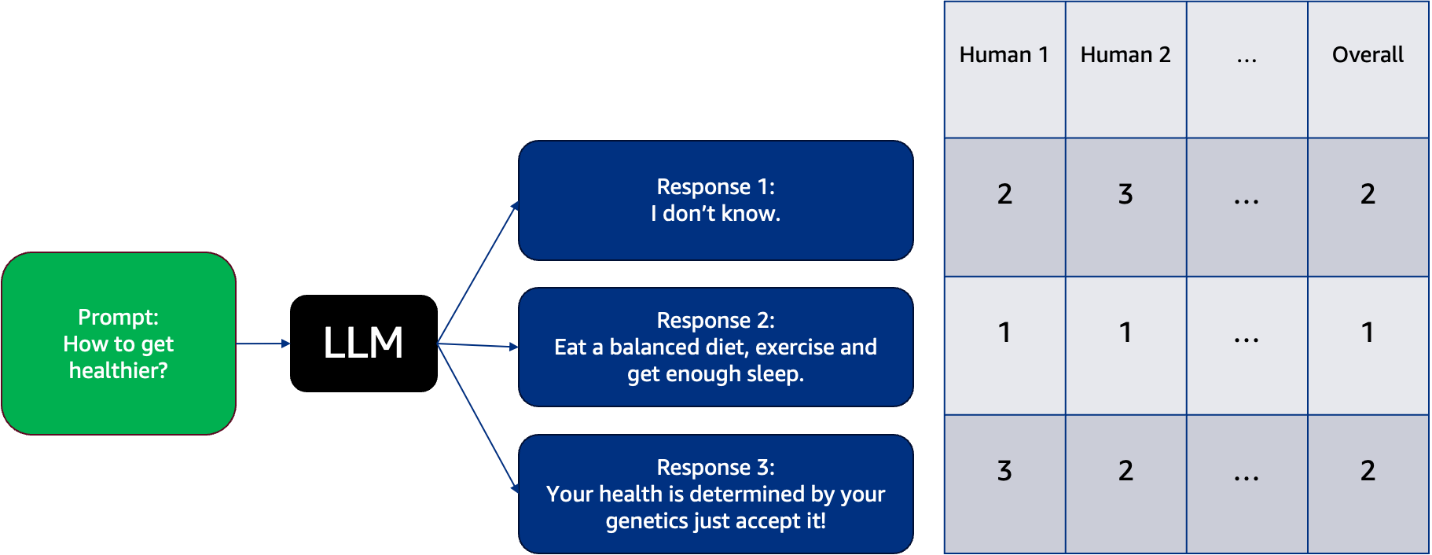

Jutalommodellezés

Kiválaszthat egy LLM-et, és számos választ generálhat a különféle felszólításokra, majd az emberi címkézők rangsorolják ezeket a válaszokat. Fontos, hogy az emberi címkézők változatosak legyenek. A világos címkézési irányelvek kritikusak. Kifejezett kritériumok nélkül az ítéletek önkényessé válhatnak. A hasznos dimenziók közé tartozik a koherencia, a relevancia, a kreativitás, a tényszerűség, a logikai következetesség stb. Az emberi címkézők ezeket a válaszokat kategóriákba sorolják, és kedvencként a legkevésbé kedveltnek jelölik meg őket, ahogy az a következő példában is látható. Ez a példa bemutatja, hogy a különböző emberek hogyan érzékelik ezeket a lehetséges válaszokat az LLM-től a legkedvesebb (ebben az esetben 1-es jelöléssel) és a legkevésbé kedvencük (ebben az esetben 3-as jelöléssel). Minden oszlop 1-es, 2-es vagy 3-as címkével van ellátva minden embertől, hogy jelezze az LLM által leginkább preferált és legkevésbé preferált választ.

E szubjektív értékelések összeállításával minták rajzolódnak ki arra vonatkozóan, hogy mi visszhangzik az olvasókban. Az összesített emberi visszajelzések lényegében egy külön jutalmazási modellt képeznek az emberek számára vonzó írási tulajdonságok tekintetében. Ezt a technikát, amellyel a tömeg perspektíváit mesterséges intelligencia jutalmazó funkcióvá alakítják, az úgynevezett jutalommodellezés. Módszert biztosít az LLM kimeneti minőségének javítására különböző szubjektív nézőpontok alapján.

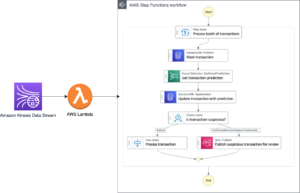

Megoldás áttekintése

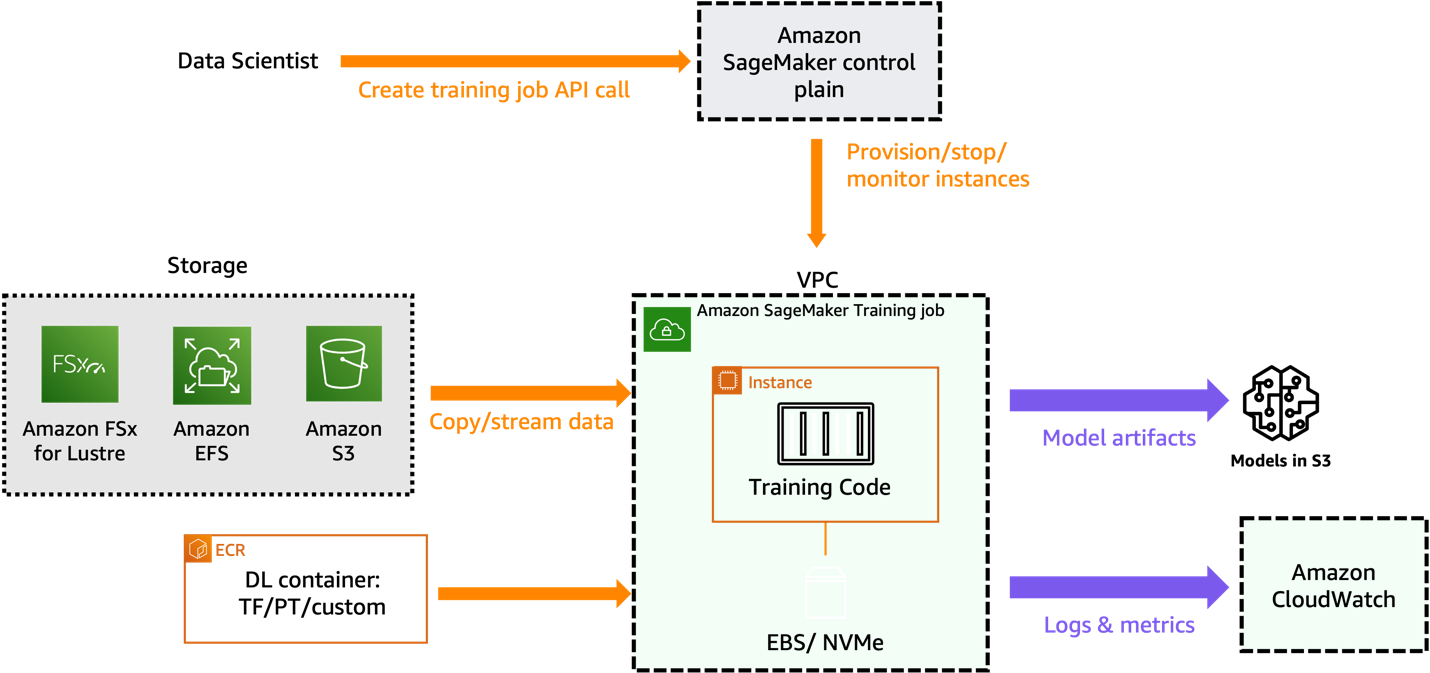

Ebben a bejegyzésben részletezzük, hogyan képezhet ki jutalmazási modellt a szervezet-specifikus emberi címkézési visszajelzések alapján, amelyeket az alap FM-en tesztelt különféle felszólításokhoz gyűjtöttek össze. A következő ábra a megoldás architektúráját szemlélteti.

További részletekért lásd a mellékelt jegyzetfüzet.

Előfeltételek

A jutalommodell sikeres betanításához a következőkre van szüksége:

Indítsa el a SageMaker Studio programot

Hajtsa végre a következő lépéseket a SageMaker Studio elindításához:

- A SageMaker konzolon válassza a lehetőséget tanulmány a navigációs ablaktáblában.

- A Studio nyitóoldalán válassza ki a tartományt és a felhasználói profilt a Studio indításához.

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a OpenStudio.

- A SageMaker Studio elindításához válassza a lehetőséget Indítsa el a személyes Stúdiót.

Nézzük meg, hogyan hozhatunk létre jutalommodellt helyileg egy SageMaker Studio notebook-környezetben a Hugging Face modellközpont egy már meglévő modelljének használatával.

Készítsen egy emberi címkével ellátott adatkészletet, és képezzen ki egy jutalommodellt

A jutalommodellezés során az emberektől származó visszacsatolási adatok beszerzése költséges lehet. Ennek az az oka, hogy a jutalmazási modellezéshez visszajelzésre van szükség a többi embertől, ahelyett, hogy csak a rendszeres rendszerhasználat során gyűjtött adatokat használnák fel. Az, hogy a jutalommodell milyen jól viselkedik, az emberektől érkező visszajelzések minőségétől és mennyiségétől függ.

Javasoljuk az AWS által felügyelt ajánlatok használatát, mint pl Amazon SageMaker Ground Truth. A humán-in-the-loop képességek legátfogóbb készletét kínálja, lehetővé téve az emberi visszajelzések erejének kihasználását a gépi tanulás (ML) életciklusa során a modellek pontosságának és relevanciájának javítása érdekében. A SageMaker Ground Truth segítségével különféle humán-in-the-loop feladatokat hajthat végre, az adatgenerálástól és a kommentároktól a modell áttekintéséig, testreszabásáig és értékeléséig, akár önkiszolgáló, akár AWS által felügyelt ajánlaton keresztül.

Ebben a bejegyzésben az IMDB adatkészletet használjuk egy olyan jutalmazási modell képzésére, amely magasabb pontszámot ad az emberek által pozitívnak nevezett szövegekre, és alacsonyabb pontszámot a negatív szövegekre.

Az adatkészletet a következő kóddal készítjük el:

A következő példa egy mintarekordot mutat be az előkészített adatkészletből, amely hivatkozásokat tartalmaz az elutasított és kiválasztott válaszokra. A kiválasztott és elutasított válaszokhoz beágyaztuk a bemeneti azonosítót és a figyelemmaszkot is.

Töltse be az előre betanított modellt

Ebben az esetben a OPT-1.3b (Open Pre-train Transformer Language Model) modell in Amazon SageMaker JumpStart a Hugging Face-től. Ha az elosztott képzés helyett az összes képzést helyben szeretné elvégezni a notebookon, akkor elegendő gyorsítómemóriával rendelkező példányt kell használnia. A következő képzést egy ml.g4dn.xlarge példánytípuson futó notebookon futtatjuk:

Határozza meg az egyéni tréner funkciót

A következő kódrészletben létrehozunk egy egyéni trénert, amely kiszámítja, hogy egy modell mennyire teljesít egy feladaton:

Összehasonlítja a modell eredményeit két bemeneti adathalmazra: az egyik kiválasztott és a másik elutasított halmazra. Az oktató ezután ezeket az eredményeket használja annak kiderítésére, hogy a modell mennyire képes megkülönböztetni a kiválasztott és az elutasított adatokat. Ez segít az oktatónak beállítani a modellt a feladat teljesítményének javítása érdekében. A CustomTrainer osztályt egy speciális tréner létrehozására használják, amely kiszámítja a veszteségfüggvényt egy adott feladathoz, amely kiválasztott és elutasított bemeneti szekvenciákat tartalmaz. Ez az egyéni tréner kibővíti a transzformátorok könyvtára által biztosított szabványos Trainer osztály funkcionalitását, lehetővé téve a modellkimenetek kezelésének és a veszteségszámításnak a feladat speciális követelményei alapján történő testreszabott megközelítését. Lásd a következő kódot:

A TrainingArguments a megadott kódrészletben az ML-modell betanítási folyamatának különféle szempontjainak konfigurálására szolgál. Nézzük meg az egyes paraméterek célját, és azt, hogy ezek hogyan befolyásolhatják az edzés eredményét:

- output_dir – Meghatározza azt a könyvtárat, ahová a betanított modell és a kapcsolódó fájlok mentésre kerülnek. Ez a paraméter segít megszervezni és tárolni a betanított modellt későbbi használatra.

- overwrite_output_dir – Meghatározza, hogy felül kell-e írni a kimeneti könyvtárat, ha már létezik. Ha ezt True értékre állítja, akkor manuális törlés nélkül újra felhasználhatja ugyanazt a könyvtárat.

- do_train – Azt jelzi, hogy kell-e edzést végezni. Ha True értékre van állítva, a modell betanítása a megadott betanítási adatkészlet használatával történik.

- do_eval és do_predict – Szabályozza, hogy végre kell-e hajtani az értékelési és előrejelzési feladatokat. Ebben az esetben mindkettő False értékre van állítva, ami azt jelenti, hogy csak a képzés kerül lebonyolításra.

- értékelési_stratégia – Meghatározza, hogy az edzés során mikor kell értékelést végezni. Ha „nem”-re állítja, az értékelés nem történik meg az edzés során.

- tanulási_ráta – Meghatározza az optimalizáló tanulási sebességét, ami befolyásolja, hogy a modell milyen gyorsan vagy lassan tanul az adatokból.

- vonat_korszakok száma – Beállítja, hogy a modell hányszor menjen végig a teljes képzési adatkészleten az edzés során. Egy korszak egy teljes áthaladást jelent az összes képzési mintán.

- per_device_train_batch_size – Meghatározza, hogy az egyes eszközökön (például GPU-n) végzett betanítás során hány mintát dolgozzanak fel minden kötegben. A kisebb adagméret lassabb, de stabilabb edzéshez vezethet.

- gradiens_accumulation_steps – Szabályozza, hogy a modell paramétereinek frissítése előtt milyen gyakran halmozódnak fel a színátmenetek. Ez segíthet stabilizálni az edzést nagy adagméretekkel.

- a_unused_columns eltávolítása – Meghatározza, hogy az adatkészlet nem használt oszlopait el kell-e távolítani a feldolgozás előtt, optimalizálva a memóriahasználatot.

Ezen paraméterek konfigurálásával a TrainingArguments, befolyásolhatja a képzési folyamat különböző aspektusait, például a modell teljesítményét, a konvergencia sebességét, a memóriahasználatot és az általános edzési eredményt az Ön speciális követelményei és korlátai alapján.

Amikor ezt a kódot futtatja, az emberi címkézőktől gyűjtött szubjektív visszajelzések számszerű megjelenítése alapján betanítja a jutalmazási modellt. Egy képzett jutalmazási modell magasabb pontszámot ad az LLM-válaszokra, amelyeket az emberek nagyobb valószínűséggel részesítenek előnyben.

Használja a jutalmazási modellt az alap LLM értékeléséhez

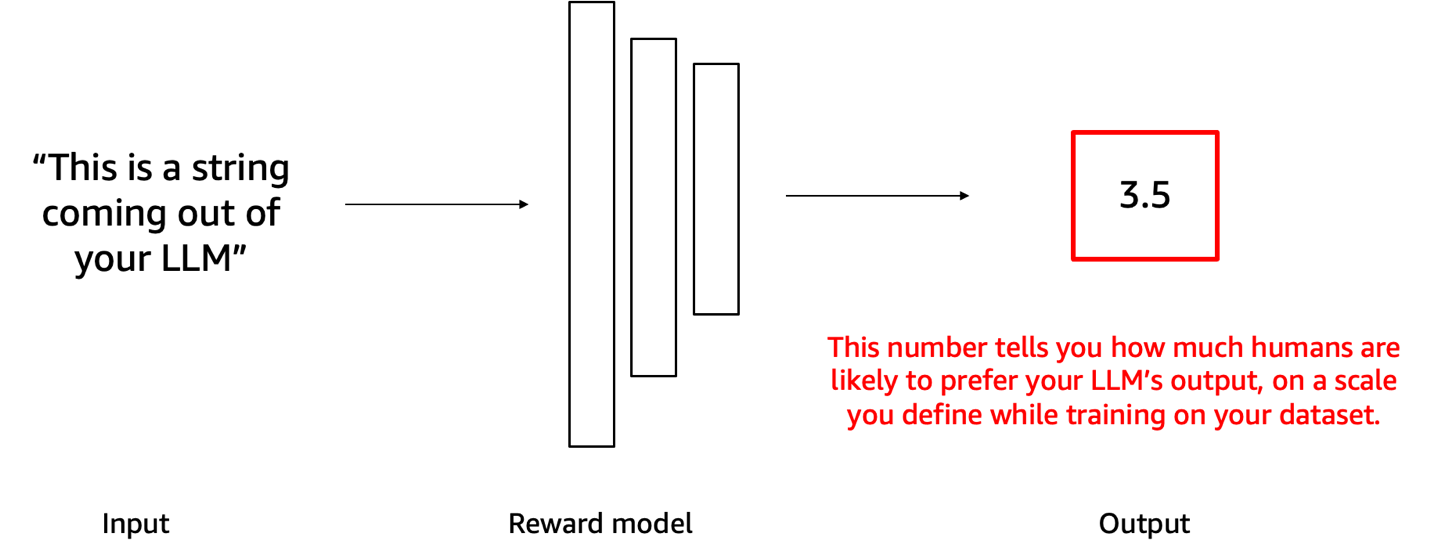

Mostantól betáplálhatja az LLM-től kapott választ ehhez a jutalmazási modellhez, és a kimenetként kapott numerikus pontszám tájékoztatja Önt arról, hogy az LLM válasza mennyire igazodik a jutalmazási modellbe beágyazott szubjektív szervezeti preferenciákhoz. A következő diagram ezt a folyamatot szemlélteti. Ezt a számot használhatja küszöbértékként annak eldöntésére, hogy az LLM-től kapott válasz megosztható-e a végfelhasználóval.

Tegyük fel például, hogy létrehoztunk egy jutalmazási modellt a mérgező, káros vagy nem megfelelő tartalom elkerülésére. Ha egy LLM által üzemeltetett chatbot választ ad, akkor a jutalommodell pontozhatja a chatbot válaszait. Az előre meghatározott küszöbérték feletti pontszámot elérő válaszok elfogadhatónak tekinthetők a felhasználókkal való megosztásra. A küszöb alatti pontszámok azt jelentik, hogy a tartalmat le kell tiltani. Ez lehetővé teszi, hogy automatikusan kiszűrjük azokat a chatbot-tartalmakat, amelyek nem felelnek meg az általunk érvényesíteni kívánt szabványoknak. Ha többet szeretne megtudni, tekintse meg a mellékelt részt jegyzetfüzet.

Tisztítsuk meg

A jövőbeni költségek elkerülése érdekében törölje az összes létrehozott erőforrást. Törölje a telepített SageMaker modelleket, ha van ilyen, és állítsa le a SageMaker Studio notebookot, amelyet ehhez a gyakorlathoz indított.

Következtetés

Ebben a bejegyzésben bemutattuk, hogyan lehet kiképezni egy olyan jutalmazási modellt, amely előrejelzi az emberi preferencia pontszámát az LLM válaszából. Ez úgy történik, hogy minden egyes prompthoz több kimenetet generál az LLM segítségével, majd megkéri az emberi annotátorokat, hogy rangsorolják vagy pontozzák az egyes promptokra adott válaszokat. A jutalmazási modellt ezután arra tanítják, hogy megjósolja az emberi preferencia pontszámát az LLM válaszából. A jutalmazási modell betanítása után a jutalommodell segítségével értékelheti az LLM válaszait az Ön szubjektív szervezeti standardjaihoz képest.

Ahogy a szervezet fejlődik, a jutalmazási funkcióknak a változó szervezeti értékek és felhasználói elvárások mellett kell fejlődniük. Mi határozza meg a „nagyszerű” AI-kimenetet, az szubjektív és átalakító. A szervezeteknek rugalmas ML-folyamatokra van szükségük, amelyek folyamatosan átképezik a jutalmazási modelleket a legújabb prioritásokat és igényeket tükröző, frissített jutalmakkal. Ez a tér folyamatosan fejlődik: közvetlen preferencián alapuló politika optimalizálás, eszközzel kiegészített jutalommodellezésés példa alapú vezérlés Más népszerű alternatív technikák az AI-rendszerek emberi értékekkel és célokkal való összehangolására.

Meghívjuk Önt, hogy tegye meg a következő lépést mesterségesintelligencia-megoldásai testreszabása felé az emberi visszajelzések sokszínű és szubjektív szempontjainak figyelembevételével. Használja ki a jutalommodellezés erejét, hogy AI-rendszerei rezonáljanak a márkaidentitással, és olyan kivételes élményeket nyújtsanak, amelyeket ügyfelei megérdemelnek. Kezdje el mesterséges intelligencia modelljei finomítását még ma az Amazon SageMaker segítségével, és csatlakozzon a vállalkozások élcsapatához, amelyek új mércét állítanak fel a személyre szabott ügyfélkapcsolatok terén. Ha bármilyen kérdése vagy visszajelzése van, kérjük, hagyja azokat a megjegyzések részben.

A szerzőről

Dinesh Kumar Subramani Senior Solutions Architect Edinburgh-ban, Skóciában. Mesterséges intelligenciára és gépi tanulásra specializálódott, és tagja az Amazon műszaki területi közösségének. A Dinesh szorosan együttműködik az Egyesült Királyság központi kormányzatának ügyfeleivel, hogy megoldják problémáikat az AWS-szolgáltatások használatával. A munkán kívül Dinesh szívesen tölt minőségi időt a családjával, sakkozik, és sokféle zenét fedez fel.

Dinesh Kumar Subramani Senior Solutions Architect Edinburgh-ban, Skóciában. Mesterséges intelligenciára és gépi tanulásra specializálódott, és tagja az Amazon műszaki területi közösségének. A Dinesh szorosan együttműködik az Egyesült Királyság központi kormányzatának ügyfeleivel, hogy megoldják problémáikat az AWS-szolgáltatások használatával. A munkán kívül Dinesh szívesen tölt minőségi időt a családjával, sakkozik, és sokféle zenét fedez fel.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/revolutionize-customer-satisfaction-with-tailored-reward-models-for-your-business-on-amazon-sagemaker/

- :van

- :is

- :nem

- :ahol

- $ UP

- 1

- 10

- 100

- 16

- 17

- 202

- 212

- 22

- 7

- a

- felett

- gázpedál

- elfogadható

- számvitel

- Felgyülemlett

- pontosság

- át

- ható

- Akció

- állítsa

- Után

- újra

- ellen

- Ügynök

- összesítve

- AI

- AI modellek

- AI rendszerek

- AI képzés

- cél

- összehangolása

- igazítás

- Minden termék

- lehetővé téve

- lehetővé teszi, hogy

- mellett

- már

- Is

- alternatív

- mindig

- amazon

- Amazon SageMaker

- Az Amazon Web Services

- összeg

- an

- és a

- Másik

- bármilyen

- fellebbezés

- alkalmazások

- megközelítés

- önkényes

- építészet

- VANNAK

- mesterséges

- mesterséges intelligencia

- Mesterséges intelligencia és gépi tanulás

- AS

- kér

- szempontok

- értékelése

- társult

- At

- figyelem

- auto

- automatikusan

- elkerülése érdekében

- elkerülve

- el

- AWS

- bázis

- alapján

- BE

- mert

- válik

- óta

- előtt

- viselkedés

- hogy

- lent

- am

- összehasonlított

- Jobb

- között

- Túl

- Fekete

- zárolt

- mindkét

- Doboz

- dobozok

- márka

- szünet

- tágabb

- épít

- épült

- üzleti

- vállalkozások

- de

- by

- kiszámítja

- hívott

- TUD

- Kaphat

- képességek

- elfog

- eset

- kategóriák

- kategorizál

- központi

- kihívás

- kihívások

- Változások

- változó

- díjak

- chatbot

- sakk

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választott

- osztály

- besorolás

- világos

- szorosan

- kód

- Gyűjtő

- szín

- színes

- Oszlop

- Oszlopok

- jön

- Hozzászólások

- közösség

- vállalat

- teljes

- átfogó

- számítás

- lefolytatott

- konfigurálása

- megerősít

- Fontolja

- következetesen

- Konzol

- korlátok

- tartalom

- folyamatosan

- folyamatosan

- ellenőrzés

- ellenőrzések

- Konvergencia

- társalgó

- tudott

- teremt

- készítette

- Kreatív

- kreativitás

- kritériumok

- kritikai

- kritika

- tömeg

- szokás

- vevő

- Vevői elégedettség

- Ügyfelek

- testreszabás

- testre

- szabott

- dátum

- adatkészletek

- Döntés

- tekinteni

- Annak meghatározása,

- meghatározó

- szállít

- bizonyítani

- függ

- telepített

- leírni

- megérdemel

- részlet

- részletek

- meghatározza

- fejleszt

- eszköz

- diagram

- különböző

- méretek

- közvetlenül

- könyvtár

- társalgás

- tárgyalja

- megosztott

- elosztott képzés

- számos

- Sokféleség

- do

- nem

- Nem

- Ennek

- domain

- uralkodó

- csinált

- le-

- alatt

- minden

- eredményesen

- bármelyik

- más

- beágyazott

- ölelés

- felmerül

- kódolt

- kódolás

- végén

- vége

- érvényesíteni

- vonzó

- élvezi

- elég

- biztosítására

- Egész

- Környezet

- korszak

- lényegében

- étosz

- értékelni

- értékelés

- fejlődik

- fejlődik

- fejlődik

- példa

- kivételes

- Gyakorol

- létezik

- kiterjedt

- várakozások

- drága

- tapasztalat

- Tapasztalatok

- kísérlet

- feltárása

- Feltárása

- Exponálás

- nyúlik

- Arc

- tény

- hamis

- család

- Kedvenc

- Visszacsatolás

- érez

- mező

- Ábra

- Fájlok

- Film

- szűrő

- vezetéknév

- első

- rugalmas

- következő

- A

- ból ből

- funkció

- funkcionális

- funkcionalitás

- funkciók

- alapvető

- jövő

- összegyűjtött

- gyűjtése

- általános

- generál

- generáló

- generáció

- kap

- szerzés

- Ad

- Go

- Célok

- Goes

- jó

- Kormány

- GPU

- színátmenetek

- szürke

- nagy

- hatalmas erő

- nagyobb

- Földi

- Növekvő

- irányelvek

- Útmutatók

- Kezelés

- káros

- hám

- Legyen

- kikötő

- he

- segít

- segít

- Magas

- <p></p>

- nagyon

- övé

- motorháztető

- Hogyan

- How To

- HTML

- HTTPS

- Kerékagy

- emberi

- Az emberek

- i

- ID

- Identitás

- if

- illusztrálja

- importál

- fontos

- javul

- javuló

- in

- tartalmaz

- magában foglalja a

- jelzi

- befolyás

- befolyásoló

- tájékoztatja

- eredendően

- bemenet

- bemenet

- példa

- helyette

- sértetlenség

- Intelligencia

- szándékolt

- kölcsönhatások

- érdekes

- bele

- önmagában

- változatlanul

- meghívni

- bevonásával

- kérdések

- IT

- ITS

- csatlakozik

- jpg

- bíró

- értékelések

- Kulcs

- csók

- Ismer

- Kumar

- Címke

- címkézés

- hiány

- leszállási

- nyelv

- nagy

- legutolsó

- indít

- indított

- indítás

- vezet

- tanulás

- tanul

- legkevésbé

- Szabadság

- balra

- Lets

- könyvtár

- életciklus

- Valószínű

- LLM

- helyileg

- logikus

- le

- szerelem

- alacsonyabb

- gép

- gépi tanulás

- csinál

- Gyártás

- kézikönyv

- sok

- maszk

- Lehet..

- jelent

- jelenti

- eszközök

- Találkozik

- tag

- Memory design

- Férfi

- módszer

- esetleg

- bánja

- ML

- modell

- modellezés

- modellek

- több

- a legtöbb

- indíték

- film

- sok

- zene

- kell

- Rejtély

- Navigáció

- Szükség

- igények

- negatív

- Új

- hír

- következő

- nem

- jegyzetfüzet

- Most

- árnyalt

- szám

- számos

- célkitűzés

- of

- felajánlás

- Ajánlat

- Ajánlatok

- gyakran

- on

- egyszer

- ONE

- csak

- nyitva

- optimalizálása

- or

- szervezet

- szervezeti

- szervezetek

- Más

- ki

- Eredmény

- teljesítmény

- kimenetek

- kívül

- átfogó

- Overcome

- oldal

- üvegtábla

- paraméter

- paraméterek

- elhalad

- minták

- Paul

- Emberek (People)

- észlelés

- tökéletes

- Teljesít

- teljesítmény

- teljesített

- előadó

- person

- személyes

- Személyre

- perspektívák

- Hangmagasság

- Plató

- Platón adatintelligencia

- PlatoData

- játék

- kérem

- öröm

- értelmetlen

- politika

- Népszerű

- pózok

- pozitív

- lehetséges

- állás

- hatalom

- powered

- erős

- előre

- előrejelzés

- jósolja

- jobban szeret

- előnyös

- preferenciák

- előnyben részesített

- Készít

- előkészített

- ajándékot

- szép

- prioritások

- problémák

- folyamat

- Feldolgozott

- feldolgozás

- gyárt

- Készült

- termel

- profil

- utasításokat

- ad

- feltéve,

- biztosít

- cél

- tesz

- tulajdonságok

- világítás

- Kérdések

- gyorsan

- hatótávolság

- rangsorban

- Arány

- Inkább

- értékelés

- olvasók

- ajánl

- rekord

- referenciák

- finomítani

- finomítás

- tükröznie

- tükrözve

- szabályos

- Elutasítva..

- relevancia

- eltávolított

- jelentést

- képviselet

- követelmények

- rezonátor

- rezonál

- Tudástár

- illetőleg

- válasz

- válaszok

- felelősség

- Eredmények

- visszatérés

- Kritika

- forradalmasítani

- Jutalom

- Jutalmak

- jobb

- rlhf

- futás

- futás

- rohanás

- s

- sagemaker

- azonos

- minta

- elégedettség

- mentett

- azt mondják

- azt mondja,

- skálázhatóság

- színhely

- pontszám

- pontszámok

- Rész

- lát

- keres

- látott

- szegmensek

- válasszuk

- MAGA

- Önkiszolgáló

- idősebb

- különálló

- Komolyan

- Szolgáltatások

- készlet

- Szettek

- beállítás

- számos

- Megosztás

- megosztott

- kellene

- vitrinek

- kimutatta,

- mutatott

- Műsorok

- keverés

- jelent

- Ülés

- Méret

- méretek

- Lassan

- kisebb

- töredék

- So

- megoldások

- Megoldások

- SOLVE

- Hely

- specializált

- specializálódott

- különleges

- Spektrum

- sebesség

- költ

- Költési

- terpeszkedés

- stabilizálni

- stabil

- standard

- szabványok

- kezdet

- kezdődött

- Lépés

- Lépései

- megáll

- tárolni

- Történet

- stúdió

- szubjektív

- sikeresen

- ilyen

- biztos

- rendszer

- Systems

- szabott

- Vesz

- Feladat

- feladatok

- Műszaki

- technika

- technikák

- megmondja

- feltételek

- teszt

- kipróbált

- szöveg

- mint

- hogy

- A

- A jövő

- azok

- Őket

- akkor

- Ott.

- Ezek

- ők

- ezt

- azok

- küszöb

- Keresztül

- átmenő

- idő

- időigényes

- alkalommal

- nak nek

- Ma

- Tomi

- is

- szerszám

- fáklya

- érintések

- hagyományos

- Vonat

- kiképzett

- Képzések

- vonatok

- transzformátor

- transzformerek

- transzformáló

- fa

- igaz

- igazság

- hangolt

- kettő

- típus

- típusok

- Uk

- egyedi

- egyedileg

- hacsak nem

- nem úgy mint

- -ig

- felhasználatlan

- frissítve

- frissítése

- us

- Használat

- használ

- használt

- hasznos

- használó

- Felhasználók

- használ

- segítségével

- Értékek

- élcsapat

- változatos

- fajta

- különféle

- Ve

- néző

- nézőpontok

- vs

- várakozik

- vándorol

- akar

- volt

- Nézz

- órák

- őrzés

- we

- háló

- webes szolgáltatások

- JÓL

- voltak

- Mit

- akármi

- amikor

- vajon

- ami

- míg

- fehér

- WHO

- lesz

- william

- ablak

- val vel

- nélkül

- Munka

- dolgozók

- művek

- lenne

- írás

- te

- A te

- zephyrnet