A nagy nyelvi modellek (LLM) forradalmasították a természetes nyelvi feldolgozás (NLP) területét, javítva az olyan feladatokat, mint a nyelvi fordítás, a szövegösszegzés és a hangulatelemzés. Mivel azonban ezek a modellek mérete és összetettsége folyamatosan nő, teljesítményük és viselkedésük nyomon követése egyre nagyobb kihívást jelent.

Az LLM-ek teljesítményének és viselkedésének nyomon követése kritikus feladat biztonságuk és hatékonyságuk biztosítása szempontjából. Javasolt architektúránk méretezhető és testreszabható megoldást kínál az online LLM-felügyelethez, lehetővé téve a csapatok számára, hogy a megfigyelési megoldást az Ön konkrét használati eseteihez és követelményeihez szabják. Az AWS-szolgáltatások használatával architektúránk valós idejű rálátást biztosít az LLM viselkedésére, és lehetővé teszi a csapatok számára, hogy gyorsan azonosítsák és kezeljék a problémákat vagy anomáliákat.

Ebben a bejegyzésben bemutatunk néhány mérőszámot az online LLM-figyeléshez és azok megfelelő architektúráját az AWS-szolgáltatások használatával, például amazonfelhőóra és a AWS Lambda. Ez testreszabható megoldást kínál a lehetségesen túl modellértékelés munkák Amazon alapkőzet.

A megoldás áttekintése

Az első dolog, amit figyelembe kell venni, hogy a különböző metrikák eltérő számítási szempontokat igényelnek. Szükség van egy moduláris architektúrára, amelyben minden modul modellkövetkeztetési adatokat fogadhat be, és saját metrikákat állíthat elő.

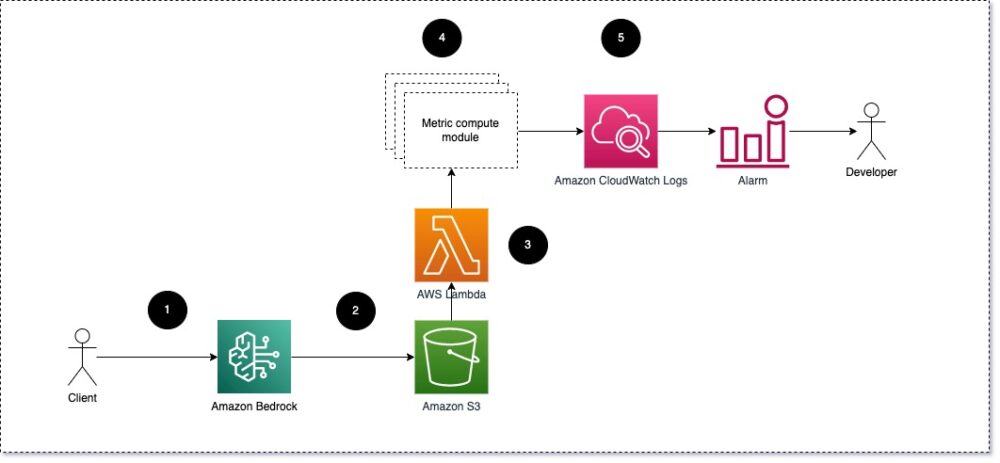

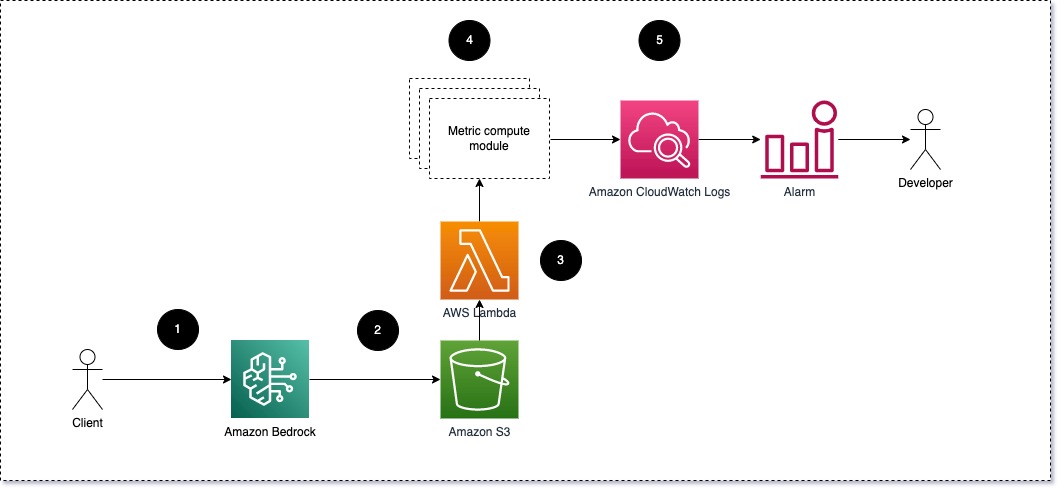

Javasoljuk, hogy minden modul fogadja el a bejövő következtetési kéréseket az LLM-hez, és adja át a prompt és a befejezés (válasz) párokat a metrikus számítási moduloknak. Minden modul felelős a saját metrikáinak kiszámításáért a beviteli prompt és a befejezés (válasz) tekintetében. Ezeket a mutatókat a CloudWatch továbbítja, amely összesítheti őket, és a CloudWatch riasztásaival együttműködve értesítéseket küldhet meghatározott feltételekről. A következő diagram ezt az architektúrát szemlélteti.

1. ábra: Metrikus számítási modul – megoldás áttekintése

A munkafolyamat a következő lépéseket tartalmazza:

- A felhasználó egy alkalmazás vagy felhasználói felület részeként kérelmet nyújt be az Amazon Bedrock felé.

- Az Amazon Bedrock elmenti a kérést és a kitöltést (választ). Amazon egyszerű tárolási szolgáltatás (Amazon S3) konfigurációja szerint hívásnaplózás.

- Az Amazon S3-ra mentett fájl olyan eseményt hoz létre, amely váltja egy lambda funkció. A függvény meghívja a modulokat.

- A modulok a megfelelő mérőszámaikat a következő címre küldik el CloudWatch mérőszámai.

- Riasztások értesítheti a fejlesztőcsapatot a váratlan metrikaértékekről.

A második dolog, amit figyelembe kell venni az LLM-figyelés megvalósítása során, a megfelelő mérőszámok kiválasztása a követéshez. Bár számos lehetséges mérőszám használható az LLM teljesítményének nyomon követésére, ebben a bejegyzésben a legtágabb mérőszámokat ismertetjük.

A következő szakaszokban kiemelünk néhány releváns modulmetrikát és a hozzájuk tartozó metrika számítási modul architektúráját.

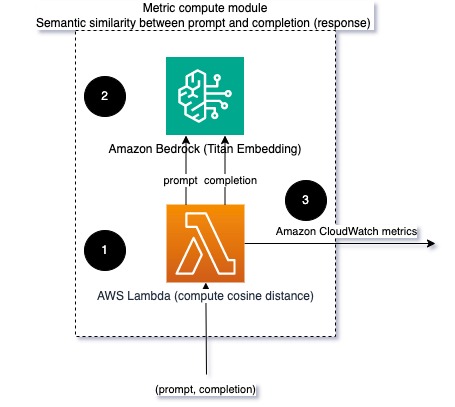

Szemantikai hasonlóság a felszólítás és a befejezés között (válasz)

LLM-ek futtatásakor elfoghatja az egyes kérések promptját és befejezését (válaszát), és beágyazási modell segítségével alakíthatja át őket beágyazásokká. A beágyazások nagy dimenziójú vektorok, amelyek a szöveg szemantikai jelentését képviselik. Amazon Titan ilyen modelleket biztosít a Titan Embeddings révén. Ha e két vektor között olyan távolságot vesz fel, mint a koszinusz, akkor számszerűsítheti, hogy szemantikailag mennyire hasonló a prompt és a befejezés (válasz). Te tudod használni SciPy or scikit elsajátítható a vektorok közötti koszinusz távolság kiszámításához. A következő diagram a metrika számítási modul architektúráját mutatja be.

2. ábra: Metrikus számítási modul – szemantikai hasonlóság

Ez a munkafolyamat a következő kulcsfontosságú lépéseket tartalmazza:

- A Lambda funkció streamelt üzenetet fogad ezen keresztül Amazon kinezis felszólítás és befejezés (válasz) párost tartalmaz.

- A függvény beágyazást kap mind a prompt, mind a befejezés (válasz) számára, és kiszámítja a két vektor közötti koszinusz távolságot.

- A funkció elküldi ezt az információt a CloudWatch mérőszámainak.

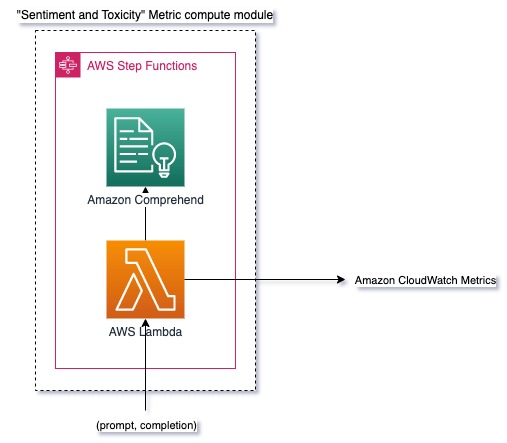

Érzelem és toxicitás

A hangulatfigyelés lehetővé teszi a válaszok általános hangnemének és érzelmi hatásának felmérését, míg a toxicitáselemzés fontos mércéje a sértő, tiszteletlen vagy káros nyelvezet az LLM-kimenetekben. A hangulatban vagy a toxicitásban bekövetkező bármilyen változást szorosan figyelemmel kell kísérni, hogy megbizonyosodjon arról, hogy a modell az elvárásoknak megfelelően viselkedik. A következő diagram a metrikus számítási modult mutatja be.

3. ábra: Metrikus számítási modul – hangulat és toxicitás

A munkafolyamat a következő lépéseket tartalmazza:

- A Lambda-függvény az Amazon Kinesisen keresztül kap egy prompt és befejező (válasz) párt.

- Az AWS Step Functions hangszerelésén keresztül a függvény meghívja Amazon Comprehend hogy észlelje a érzés és a toxicitás.

- A funkció elmenti az információkat a CloudWatch mérőszámaiba.

A hangulat és a toxicitás Amazon Comprehend segítségével történő észlelésével kapcsolatos további információkért lásd: Hozzon létre egy robusztus, szöveges toxicitás-előrejelzőt és a Jelölje meg a káros tartalmat az Amazon Comprehend toxicitás-észlelés segítségével.

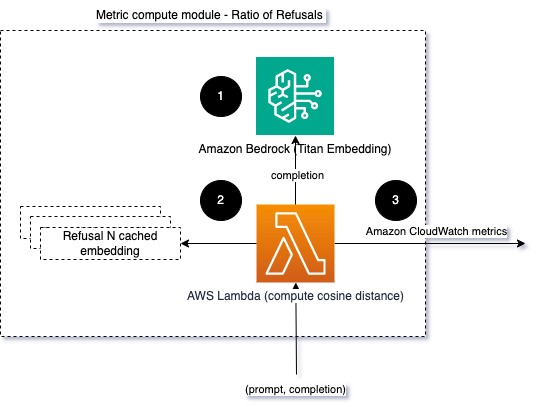

Az elutasítások aránya

Az elutasítások számának növekedése, például amikor egy LLM információhiány miatt megtagadja a befejezést, azt jelentheti, hogy vagy rosszindulatú felhasználók próbálják az LLM-et olyan módon használni, amely a jailbreakre irányul, vagy hogy a felhasználók elvárásai nem teljesülnek, és alacsony értékű válaszokat kapnak. Az egyik módja annak, hogy felmérjük, milyen gyakran fordul elő ez, ha összehasonlítjuk a használt LLM-modell szokásos visszautasításait az LLM tényleges válaszaival. Például a következőkben néhány az Anthropic Claude v2 LLM általános elutasító kifejezései közül említjük meg:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

Rögzített felszólítások esetén az elutasítások számának növekedése azt jelezheti, hogy a modell túlságosan óvatos vagy érzékeny lett. A fordított esetet is értékelni kell. Ez annak a jele lehet, hogy a modell hajlamosabb a mérgező vagy káros beszélgetésekre.

Az integritás és az elutasítási arány modellezésének elősegítése érdekében összehasonlíthatjuk a választ az LLM ismert elutasító kifejezéseivel. Ez egy tényleges osztályozó lehet, amely megmagyarázhatja, hogy a modell miért utasította el a kérést. A válasz és az ismert elutasító válaszok közötti koszinusz távolságot veheti át a megfigyelt modellből. A következő diagram szemlélteti ezt a metrikus számítási modult.

4. ábra: Metrikus számítási modul – az elutasítások aránya

A munkafolyamat a következő lépésekből áll:

- A Lambda függvény felszólítást és befejezést (választ) kap, és beágyazást kap a válaszból az Amazon Titan használatával.

- A függvény kiszámítja a koszinusz vagy euklideszi távolságot a válasz és a memóriában tárolt, meglévő elutasító promptok között.

- A függvény ezt az átlagot elküldi a CloudWatch mérőszámainak.

Egy másik lehetőség az, hogy használni homályos egyezés egy egyszerű, de kevésbé hatékony megközelítés az ismert elutasítások és az LLM-kimenetek összehasonlítására. Utal Python dokumentáció egy példa.

Összegzésként

Az LLM-megfigyelhetőség kritikus gyakorlat az LLM-ek megbízható és megbízható használatának biztosításához. Az LLM-ek felügyelete, megértése és pontosságának és megbízhatóságának biztosítása segíthet csökkenteni az AI-modellekkel kapcsolatos kockázatokat. A hallucinációk, a rossz befejezések (válaszok) és a felszólítások figyelésével megbizonyosodhat arról, hogy LLM-je a pályán marad, és azt az értéket adja, amelyet Ön és felhasználói keresnek. Ebben a bejegyzésben néhány mérőszámot tárgyaltunk, hogy példákat mutassunk be.

Az alapozási modellek értékelésével kapcsolatos további információkért lásd: A SageMaker Clarify segítségével értékelje az alapozó modelleket, és böngésszen a továbbiak között példafüzetek elérhető a GitHub adattárunkban. Felfedezheti az LLM-kiértékelések nagy léptékű operacionalizálásának módjait is Működtesse az LLM-értékelést a Scale-ban az Amazon SageMaker Clarify és MLOps szolgáltatások segítségével. Végül javasoljuk a hivatkozást Értékelje a nagy nyelvi modelleket a minőség és a felelősség szempontjából hogy többet megtudjon az LLM-ek értékeléséről.

A szerzőkről

Bruno Klein vezető gépi tanulási mérnök AWS Professional Services Analytics gyakorlattal. Segít ügyfeleinek a big data és analitikai megoldások megvalósításában. A munkán kívül szívesen tölt időt a családjával, utazik és új ételeket próbál ki.

Bruno Klein vezető gépi tanulási mérnök AWS Professional Services Analytics gyakorlattal. Segít ügyfeleinek a big data és analitikai megoldások megvalósításában. A munkán kívül szívesen tölt időt a családjával, utazik és új ételeket próbál ki.

Rushabh Lokhande Senior Data & ML mérnök AWS Professional Services Analytics gyakorlattal. Segít ügyfeleinek a big data, a gépi tanulási és az elemzési megoldások megvalósításában. A munkán kívül szívesen tölt időt a családjával, olvas, fut és golfozik.

Rushabh Lokhande Senior Data & ML mérnök AWS Professional Services Analytics gyakorlattal. Segít ügyfeleinek a big data, a gépi tanulási és az elemzési megoldások megvalósításában. A munkán kívül szívesen tölt időt a családjával, olvas, fut és golfozik.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :van

- :is

- :nem

- :ahol

- 1

- 100

- 143

- 32

- 455

- 7

- a

- Rólunk

- pontosság

- tényleges

- További

- cím

- adalékanyag

- AI

- AI asszisztens

- AI modellek

- lehetővé teszi, hogy

- Is

- Bár

- am

- amazon

- Amazon Comprehend

- Amazon kinezis

- Amazon SageMaker

- Az Amazon Web Services

- an

- elemzés

- analitika

- és a

- anomáliák

- Antropikus

- bármilyen

- Alkalmazás

- megközelítés

- megközelít

- építészet

- VANNAK

- AS

- Helyettes

- társult

- At

- elérhető

- átlagos

- AWS

- AWS professzionális szolgáltatások

- AWS lépésfunkciók

- Rossz

- BE

- válik

- viselkedés

- hogy

- között

- Túl

- Nagy

- Big adatok

- mindkét

- de

- by

- kéri

- TUD

- nem tud

- eset

- esetek

- óvatos

- kihívást

- választja

- osztályozó

- szorosan

- Közös

- összehasonlítani

- összehasonlítva

- befejezés

- bonyolultság

- megért

- számítás

- Kiszámít

- számítástechnika

- Körülmények

- Configuration

- Fontolja

- megfontolások

- áll

- tartalom

- kontextus

- folytatódik

- beszélgetések

- tudott

- készítette

- teremt

- kritikai

- Ügyfelek

- szabható

- dátum

- szállít

- bizonyítani

- kimutatására

- Fejlesztés

- fejlesztői csapat

- diagram

- különböző

- tárgyalt

- távolság

- do

- két

- minden

- hatékonyság

- bármelyik

- beágyazás

- lehetővé teszi

- lehetővé téve

- vegyenek

- mérnök

- elég

- biztosítására

- biztosítása

- értékelni

- értékelték

- értékelő

- értékelés

- értékelések

- esemény

- példa

- példák

- létező

- várakozások

- várható

- Magyarázza

- feltárása

- család

- kevés

- mező

- ábra

- filé

- Végül

- vezetéknév

- rögzített

- következő

- élelmiszer

- A

- Alapítvány

- ból ből

- funkció

- funkciók

- nyomtáv

- jelentkeznek

- szerzés

- GitHub

- golf

- Nő

- Esemény

- káros

- Legyen

- he

- segít

- hasznos

- segít

- Kiemel

- becsületes

- Hogyan

- azonban

- HTML

- http

- HTTPS

- i

- azonosítani

- illusztrálja

- Hatás

- végre

- végrehajtási

- fontos

- javuló

- in

- magában foglalja a

- Bejövő

- Növelje

- egyre inkább

- információ

- bemenet

- sértetlenség

- szándékolt

- Felület

- bele

- fordítottja

- behívja

- kérdések

- IT

- ITS

- jailbreak

- Állások

- jpg

- Kulcs

- ismert

- hiány

- nyelv

- nagy

- TANUL

- tanulás

- kevesebb

- LLM

- keres

- gép

- gépi tanulás

- csinál

- KÉSZÍT

- rosszindulatú

- sok

- jelent

- jelenti

- intézkedés

- Memory design

- üzenet

- találkozott

- metrikus

- Metrics

- Enyhít

- ML

- MLOps

- modell

- modellek

- moduláris

- Modulok

- Modulok

- monitor

- ellenőrizni

- ellenőrzés

- több

- Természetes

- Természetes nyelvi feldolgozás

- elengedhetetlen

- Új

- NLP

- értesítések

- Most

- of

- támadó

- Ajánlatok

- gyakran

- on

- ONE

- azok

- online

- opció

- or

- hangszerelés

- mi

- teljesítmény

- kimenetek

- kívül

- átfogó

- áttekintés

- saját

- pár

- párok

- rész

- Elmúlt

- Múló

- mert

- teljesítmény

- kifejezés

- Plató

- Platón adatintelligencia

- PlatoData

- játék

- lehetséges

- állás

- potenciális

- erős

- gyakorlat

- jelenlét

- feldolgozás

- gyárt

- szakmai

- utasításokat

- javasolt

- ad

- biztosít

- Piton

- világítás

- gyorsan

- hányados

- Olvasás

- real-time

- kap

- ajánl

- utal

- elutasítás

- megtagadta

- megbízhatóság

- megbízható

- raktár

- képvisel

- kérni

- kéri

- szükség

- követelmények

- tisztelet

- azok

- válasz

- válaszok

- felelős

- forradalmasította

- jobb

- kockázatok

- erős

- futás

- Biztonság

- sagemaker

- mentett

- skálázható

- Skála

- Második

- szakaszok

- szemantikus

- küld

- küld

- idősebb

- érzékeny

- érzés

- Szolgáltatások

- készlet

- Műszakok

- kellene

- kirakat

- Jel

- hasonló

- Egyszerű

- Méret

- megoldások

- Megoldások

- néhány

- térbeli

- különleges

- Költési

- standard

- Lépés

- Lépései

- tárolás

- egyértelmű

- áramlott

- ilyen

- javasol

- biztos

- Szabó

- Vesz

- bevétel

- Feladat

- feladatok

- csapat

- csapat

- technikák

- szöveg

- hogy

- A

- az információ

- azok

- Őket

- Ott.

- Ezek

- ők

- dolog

- ezt

- Keresztül

- idő

- titán-

- nak nek

- TONE

- vágány

- Átalakítás

- Fordítás

- Utazó

- megbízható

- próbál

- kettő

- megértés

- Váratlan

- használ

- használt

- használó

- felhasználói felület

- Felhasználók

- segítségével

- érték

- Értékek

- keresztül

- láthatóság

- Út..

- módon

- we

- háló

- webes szolgáltatások

- Mit

- Mi

- amikor

- mivel

- ami

- miért

- Wikipedia

- val vel

- Munka

- munkafolyamat

- te

- A te

- zephyrnet