Industri video game diperkirakan memiliki basis pengguna lebih dari 3 miliar di seluruh dunia1. Ini terdiri dari sejumlah besar pemain yang secara virtual berinteraksi satu sama lain setiap hari. Sayangnya, seperti di dunia nyata, tidak semua pemain berkomunikasi dengan baik dan sopan. Dalam upaya untuk membuat dan memelihara lingkungan game yang bertanggung jawab secara sosial, Layanan Profesional AWS diminta untuk membangun mekanisme yang mendeteksi bahasa yang tidak pantas (ucapan beracun) dalam interaksi pemain game online. Hasil bisnis keseluruhan adalah untuk meningkatkan operasi organisasi dengan mengotomatiskan proses manual yang ada dan untuk meningkatkan pengalaman pengguna dengan meningkatkan kecepatan dan kualitas dalam mendeteksi interaksi yang tidak pantas antara pemain, yang pada akhirnya mempromosikan lingkungan permainan yang lebih bersih dan sehat.

Permintaan pelanggan adalah untuk membuat pendeteksi bahasa Inggris yang mengklasifikasikan kutipan suara dan teks ke dalam kategori bahasa beracun yang ditentukan sendiri. Mereka ingin terlebih dahulu menentukan apakah kutipan bahasa tertentu beracun, lalu mengklasifikasikan kutipan tersebut dalam kategori toksisitas tertentu yang ditentukan pelanggan seperti bahasa tidak senonoh atau kasar.

AWS ProServe memecahkan kasus penggunaan ini melalui upaya bersama antara Pusat Inovasi AI Generatif (GAIIC) dan Tim Pengiriman ML ProServe (MLDT). AWS GAIIC adalah grup dalam AWS ProServe yang memasangkan pelanggan dengan pakar untuk mengembangkan solusi AI generatif untuk berbagai kasus penggunaan bisnis menggunakan pembuatan bukti konsep (PoC). AWS ProServe MLDT kemudian membawa PoC melalui produksi dengan menskalakan, mengeraskan, dan mengintegrasikan solusi untuk pelanggan.

Kasus penggunaan pelanggan ini akan ditampilkan dalam dua postingan terpisah. Posting ini (Bagian 1) berfungsi sebagai penyelaman mendalam ke dalam metodologi ilmiah. Ini akan menjelaskan proses pemikiran dan eksperimen di balik solusi, termasuk pelatihan model dan proses pengembangan. Bagian 2 akan mempelajari solusi produksi, menjelaskan keputusan desain, aliran data, dan ilustrasi pelatihan model dan arsitektur penerapan.

Posting ini mencakup topik-topik berikut:

- Tantangan yang harus diselesaikan oleh AWS ProServe untuk kasus penggunaan ini

- Konteks historis tentang model bahasa besar (LLM) dan mengapa teknologi ini sangat cocok untuk kasus penggunaan ini

- Solusi PoC AWS GAIIC dan AWS ProServe MLDT dari perspektif ilmu data dan pembelajaran mesin (ML)

Tantangan data

Tantangan utama yang dihadapi AWS ProServe saat melatih pengklasifikasi bahasa beracun adalah memperoleh cukup data berlabel dari pelanggan untuk melatih model yang akurat dari awal. AWS menerima sekitar 100 sampel data berlabel dari pelanggan, jauh lebih sedikit dari 1,000 sampel yang direkomendasikan untuk menyempurnakan LLM di komunitas ilmu data.

Sebagai tantangan tambahan yang melekat, pengklasifikasi pemrosesan bahasa alami (NLP) secara historis dikenal sangat mahal untuk dilatih dan membutuhkan banyak kosakata, yang dikenal sebagai badan, untuk menghasilkan prediksi yang akurat. Solusi NLP yang ketat dan efektif, jika menyediakan data berlabel dalam jumlah yang cukup, akan melatih model bahasa khusus menggunakan data berlabel pelanggan. Model akan dilatih hanya dengan kosa kata permainan pemain, membuatnya disesuaikan dengan bahasa yang diamati dalam permainan. Pelanggan memiliki batasan biaya dan waktu yang membuat solusi ini tidak dapat dijalankan. AWS ProServe terpaksa menemukan solusi untuk melatih pengklasifikasi toksisitas bahasa yang akurat dengan set data berlabel yang relatif kecil. Solusinya terletak pada apa yang dikenal sebagai belajar transfer.

Ide di balik pembelajaran transfer adalah menggunakan pengetahuan dari model pra-pelatihan dan menerapkannya pada masalah yang berbeda tetapi relatif sama. Misalnya, jika pengklasifikasi gambar dilatih untuk memprediksi apakah suatu gambar berisi kucing, Anda dapat menggunakan pengetahuan yang diperoleh model selama pelatihannya untuk mengenali hewan lain seperti harimau. Untuk kasus penggunaan bahasa ini, AWS ProServe perlu menemukan pengklasifikasi bahasa yang dilatih sebelumnya yang dilatih untuk mendeteksi bahasa beracun dan menyempurnakannya menggunakan data berlabel pelanggan.

Solusinya adalah menemukan dan menyempurnakan LLM untuk mengklasifikasikan bahasa beracun. LLM adalah jaringan saraf yang telah dilatih menggunakan sejumlah besar parameter, biasanya dalam urutan miliaran, menggunakan data yang tidak berlabel. Sebelum masuk ke solusi AWS, bagian berikut memberikan ikhtisar tentang sejarah LLM dan kasus penggunaan historisnya.

Memanfaatkan kekuatan LLM

LLM baru-baru ini menjadi titik fokus bagi bisnis yang mencari aplikasi ML baru, sejak ChatGPT menangkap mindshare publik dengan menjadi aplikasi konsumen yang paling cepat berkembang dalam sejarah2, mencapai 100 juta pengguna aktif pada Januari 2023, hanya 2 bulan setelah dirilis. Namun, LLM bukanlah teknologi baru di ruang ML. Mereka telah digunakan secara luas untuk melakukan tugas-tugas NLP seperti menganalisis sentimen, meringkas korpus, mengekstraksi kata kunci, menerjemahkan ucapan, dan mengklasifikasikan teks.

Karena sifat teks yang berurutan, jaringan saraf berulang (RNNs) telah menjadi yang paling canggih untuk pemodelan NLP. Secara khusus, encoder-decoder arsitektur jaringan diformulasikan karena menciptakan struktur RNN yang mampu menerima masukan dengan panjang sembarang dan menghasilkan keluaran dengan panjang sembarang. Ini ideal untuk tugas-tugas NLP seperti terjemahan di mana frase keluaran dari satu bahasa dapat diprediksi dari frase masukan bahasa lain, biasanya dengan jumlah kata yang berbeda antara masukan dan keluaran. Arsitektur Transformer3 (Vaswani, 2017) merupakan terobosan perbaikan pada encoder-decoder; itu memperkenalkan konsep perhatian diri, yang memungkinkan model untuk memusatkan perhatiannya pada kata-kata yang berbeda pada frasa input dan output. Dalam encoder-decoder tipikal, setiap kata ditafsirkan oleh model dengan cara yang identik. Karena model secara berurutan memproses setiap kata dalam frasa input, informasi semantik di awal mungkin hilang di akhir frasa. Mekanisme self-attention mengubah ini dengan menambahkan lapisan perhatian ke blok encoder dan decoder, sehingga model dapat memberi bobot yang berbeda pada kata-kata tertentu dari frase input saat menghasilkan kata tertentu dalam frase output. Maka lahirlah dasar dari model transformator.

Arsitektur transformator adalah dasar dari dua LLM paling terkenal dan populer yang digunakan saat ini, Representasi Encoder Bidirectional dari Transformers (BERT)4 (Radford, 2018) dan Generative Pretrained Transformer (GPT)5 (Devlin 2018). Versi terbaru dari model GPT, yaitu GPT3 dan GPT4, adalah mesin yang menggerakkan aplikasi ChatGPT. Bagian terakhir dari resep yang membuat LLM begitu kuat adalah kemampuan untuk menyaring informasi dari kumpulan teks yang luas tanpa pelabelan atau pemrosesan awal yang ekstensif melalui proses yang disebut ULMFiT. Metode ini memiliki fase pra-pelatihan di mana teks umum dapat dikumpulkan dan model dilatih untuk tugas memprediksi kata berikutnya berdasarkan kata-kata sebelumnya; manfaatnya di sini adalah bahwa setiap teks input yang digunakan untuk pelatihan secara inheren diberi label sebelumnya berdasarkan urutan teks. LLM benar-benar mampu belajar dari data berskala internet. Misalnya, model BERT asli telah dilatih sebelumnya di BookCorpus dan seluruh kumpulan data teks Wikipedia bahasa Inggris.

Paradigma pemodelan baru ini telah melahirkan dua konsep baru: model dasar (FM) dan AI Generatif. Berbeda dengan melatih model dari awal dengan data khusus tugas, yang merupakan kasus biasa untuk pembelajaran klasik yang diawasi, LLM dilatih sebelumnya untuk mengekstraksi pengetahuan umum dari kumpulan data teks luas sebelum diadaptasi ke tugas atau domain tertentu dengan jauh lebih kecil dataset (biasanya di urutan ratusan sampel). Alur kerja ML baru kini dimulai dengan model terlatih yang disebut sebagai model dasar. Penting untuk membangun di atas fondasi yang tepat, dan ada semakin banyak opsi, seperti yang baru Amazon Titan FM, akan dirilis oleh AWS sebagai bagian dari Batuan Dasar Amazon. Model baru ini juga dianggap generatif karena keluarannya dapat ditafsirkan oleh manusia dan dalam tipe data yang sama dengan data masukan. Sementara model ML sebelumnya bersifat deskriptif, seperti mengklasifikasikan gambar kucing vs. anjing, LLM bersifat generatif karena keluarannya adalah rangkaian kata berikutnya berdasarkan kata masukan. Itu memungkinkan mereka untuk mendukung aplikasi interaktif seperti ChatGPT yang dapat ekspresif dalam konten yang mereka hasilkan.

Hugging Face telah bermitra dengan AWS untuk mendemokratisasi FM dan membuatnya mudah diakses dan dibangun. Memeluk Wajah telah menciptakan a API Transformer yang menyatukan lebih dari 50 arsitektur transformator yang berbeda pada kerangka kerja ML yang berbeda, termasuk akses ke bobot model terlatih di dalamnya Pusat Model, yang telah berkembang menjadi lebih dari 200,000 model saat menulis posting ini. Di bagian selanjutnya, kami mengeksplorasi bukti konsep, solusi, dan FM yang diuji dan dipilih sebagai dasar untuk menyelesaikan kasus penggunaan klasifikasi ucapan beracun ini untuk pelanggan.

Bukti konsep AWS GAIIC

AWS GAIIC memilih untuk bereksperimen dengan model dasar LLM dengan arsitektur BERT untuk menyempurnakan pengklasifikasi bahasa beracun. Sebanyak tiga model dari hub model Hugging Face telah diuji:

Ketiga model arsitektur didasarkan pada BERTweet Arsitektur. BERTweet dilatih berdasarkan RobertTa prosedur pra-pelatihan. Prosedur pra-pelatihan RoBERTa adalah hasil dari studi replikasi pra-pelatihan BERT yang mengevaluasi efek penyetelan hyperparameter dan ukuran set pelatihan untuk meningkatkan resep pelatihan model BERT6 (Liu 2019). Eksperimen tersebut berusaha menemukan metode pra-pelatihan yang meningkatkan hasil kinerja BERT tanpa mengubah arsitektur yang mendasarinya. Kesimpulan dari penelitian ini menemukan bahwa modifikasi pra-pelatihan berikut secara substansial meningkatkan kinerja BERT:

- Melatih model dengan batch yang lebih besar untuk lebih banyak data

- Menghapus tujuan prediksi kalimat berikutnya

- Pelatihan pada urutan yang lebih panjang

- Secara dinamis mengubah pola masking yang diterapkan pada data pelatihan

Model bertweet-base menggunakan prosedur pra-pelatihan sebelumnya dari studi RoBERTa untuk melatih arsitektur BERT asli menggunakan 850 juta tweet bahasa Inggris. Ini adalah model bahasa skala besar publik pertama yang dilatih sebelumnya untuk tweet berbahasa Inggris.

FM pra-pelatihan yang menggunakan tweet dianggap sesuai dengan kasus penggunaan karena dua alasan teoretis utama:

- Panjang tweet sangat mirip dengan panjang frasa tidak pantas atau beracun yang ditemukan dalam obrolan game online

- Tweet berasal dari populasi dengan beragam pengguna yang berbeda, mirip dengan populasi yang ditemukan di platform game

AWS memutuskan untuk terlebih dahulu menyempurnakan BERTweet dengan data berlabel pelanggan untuk mendapatkan garis dasar. Kemudian memilih untuk menyempurnakan dua FM lainnya dalam bertweet-base-offensive dan bertweet-base-hate yang dilatih lebih lanjut secara khusus pada tweet beracun yang lebih relevan untuk mencapai akurasi yang berpotensi lebih tinggi. Model bertweet-base-offensive menggunakan basis BertTweet FM dan dilatih lebih lanjut pada 14,100 tweet beranotasi yang dianggap ofensif7 (Zampieri 2019). Model bertweet-base-hate juga menggunakan basis BertTweet FM tetapi dilatih lebih lanjut pada 19,600 tweet yang dianggap sebagai ujaran kebencian8 (Basil 2019).

Untuk lebih meningkatkan kinerja model PoC, AWS GAIIC membuat dua keputusan desain:

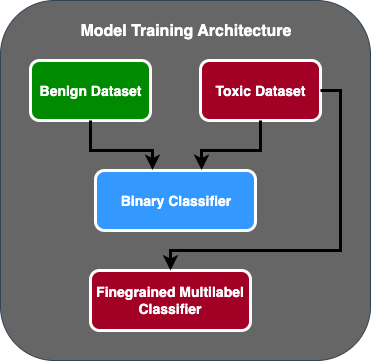

- Membuat alur prediksi dua tahap di mana model pertama bertindak sebagai pengklasifikasi biner yang mengklasifikasikan apakah sebuah teks beracun atau tidak beracun. Model kedua adalah model berbutir halus yang mengklasifikasikan teks berdasarkan jenis racun yang ditentukan pelanggan. Hanya jika model pertama memprediksi teks sebagai racun barulah diteruskan ke model kedua.

- Menambah data pelatihan dan menambahkan subset dari kumpulan data teks beracun berlabel pihak ketiga dari kompetisi Kaggle publik (Toksisitas Jigsaw) ke 100 sampel asli yang diterima dari pelanggan. Mereka memetakan label Jigsaw ke label toksisitas terkait yang ditentukan pelanggan dan melakukan pemisahan 80% sebagai data pelatihan dan pemisahan 20% sebagai data uji untuk memvalidasi model.

AWS GAIIC digunakan Amazon SageMaker notebook untuk menjalankan eksperimen fine-tuning mereka dan menemukan bahwa model bertweet-base-offensive mencapai skor terbaik pada set validasi. Tabel berikut merangkum skor metrik yang diamati.

| Model | Ketelitian | Mengingat kembali | F1 | AUC |

| Biner | . 92 | . 90 | . 91 | . 92 |

| berbutir halus | . 81 | . 80 | . 81 | . 89 |

Mulai saat ini, GAIIC menyerahkan PoC ke Tim Pengiriman ML AWS ProServe untuk memproduksi PoC.

Solusi Tim Pengiriman ML AWS ProServe

Untuk memproduksi arsitektur model, AWS ProServe ML Delivery Team (MLDT) diminta oleh pelanggan untuk membuat solusi yang dapat diskalakan dan mudah dipelihara. Ada beberapa tantangan pemeliharaan dari pendekatan model dua tahap:

- Model akan membutuhkan dua kali lipat jumlah pemantauan model, yang membuat waktu pelatihan ulang tidak konsisten. Mungkin ada saatnya satu model harus dilatih ulang lebih sering daripada yang lain.

- Peningkatan biaya menjalankan dua model sebagai lawan dari satu.

- Kecepatan inferensi melambat karena inferensi melewati dua model.

Untuk mengatasi tantangan ini, AWS ProServe MLDT harus mengetahui cara mengubah arsitektur model dua tahap menjadi arsitektur model tunggal sambil tetap dapat mempertahankan akurasi arsitektur dua tahap.

Solusinya adalah pertama-tama meminta lebih banyak data pelatihan kepada pelanggan, kemudian menyempurnakan model bertweet-base-offensive pada semua label, termasuk sampel tidak beracun, menjadi satu model. Idenya adalah menyempurnakan satu model dengan lebih banyak data akan menghasilkan hasil yang serupa dengan menyempurnakan arsitektur model dua tahap dengan lebih sedikit data. Untuk menyempurnakan arsitektur model dua tahap, AWS ProServe MLDT memperbarui kepala klasifikasi multi-label model yang dilatih sebelumnya untuk menyertakan satu node tambahan untuk mewakili kelas tidak beracun.

Berikut ini adalah contoh kode tentang bagaimana Anda menyempurnakan model terlatih dari hub model Hugging Face menggunakan platform transformer mereka dan mengubah kepala klasifikasi multi-label model untuk memprediksi jumlah kelas yang diinginkan. AWS ProServe MLDT menggunakan cetak biru ini sebagai dasar untuk penyempurnaan. Ini mengasumsikan bahwa Anda telah menyiapkan data pelatihan dan data validasi dan dalam format input yang benar.

Pertama, modul Python diimpor serta model terlatih yang diinginkan dari hub model Hugging Face:

Model pra-pelatihan kemudian dimuat dan disiapkan untuk penyetelan halus. Ini adalah langkah di mana jumlah kategori beracun dan semua parameter model ditentukan:

Penyempurnaan model dimulai dengan memasukkan jalur ke dataset pelatihan dan validasi:

AWS ProServe MLDT menerima sekitar 5,000 lebih sampel data berlabel, 3,000 tidak beracun dan 2,000 beracun, dan menyempurnakan ketiga model bertweet-base, menggabungkan semua label menjadi satu model. Mereka menggunakan data ini selain 5,000 sampel dari PoC untuk menyempurnakan model satu tahap baru menggunakan 80% rangkaian kereta yang sama, metode rangkaian pengujian 20%. Tabel berikut menunjukkan bahwa skor kinerja sebanding dengan model dua tahap.

| Model | Ketelitian | Mengingat kembali | F1 | AUC |

| bertweet-base (1-Tahap) | . 76 | . 72 | . 74 | . 83 |

| bertweet-base-hate (1-Tahap) | . 85 | . 82 | . 84 | . 87 |

| bertweet-base-ofensive (1-Tahap) | . 88 | . 83 | . 86 | . 89 |

| bertweet-base-ofensive (2-Tahap) | . 91 | . 90 | . 90 | . 92 |

Pendekatan model satu tahap memberikan peningkatan biaya dan pemeliharaan sementara hanya menurunkan presisi sebesar 3%. Setelah mempertimbangkan kompromi, pelanggan memilih AWS ProServe MLDT untuk memproduksi model satu tahap.

Dengan menyempurnakan satu model dengan lebih banyak data berlabel, AWS ProServe MLDT mampu memberikan solusi yang memenuhi ambang pelanggan untuk akurasi model, serta memenuhi permintaan mereka untuk kemudahan pemeliharaan, sekaligus menurunkan biaya dan meningkatkan ketahanan.

Kesimpulan

Pelanggan game besar sedang mencari cara untuk mendeteksi bahasa beracun dalam saluran komunikasi mereka untuk mempromosikan lingkungan game yang bertanggung jawab secara sosial. AWS GAIIC membuat PoC pendeteksi bahasa beracun dengan menyempurnakan LLM untuk mendeteksi bahasa beracun. AWS ProServe MLDT kemudian memperbarui alur pelatihan model dari pendekatan dua tahap menjadi pendekatan satu tahap dan memproduksi LLM untuk digunakan pelanggan dalam skala besar.

Dalam postingan ini, AWS menunjukkan keefektifan dan kepraktisan menyempurnakan LLM untuk menyelesaikan kasus penggunaan pelanggan ini, berbagi konteks tentang sejarah model dasar dan LLM, dan memperkenalkan alur kerja antara AWS Generative AI Innovation Center dan AWS ProServe ML Tim Pengiriman. Di postingan berikutnya dalam seri ini, kita akan menyelami lebih dalam tentang bagaimana AWS ProServe MLDT memproduksi model satu tahap yang dihasilkan menggunakan SageMaker.

Jika Anda tertarik bekerja dengan AWS untuk membangun solusi AI Generatif, silakan hubungi GAIIK. Mereka akan menilai kasus penggunaan Anda, membuat bukti konsep berbasis Generatif-AI, dan memiliki opsi untuk memperluas kolaborasi dengan AWS untuk mengimplementasikan PoC yang dihasilkan ke dalam produksi.

Referensi

- Demografi Gamer: Fakta dan Statistik Tentang Hobi Paling Populer di Dunia

- ChatGPT menetapkan rekor untuk basis pengguna yang tumbuh paling cepat – catatan analis

- Vaswani et al., “Perhatian Adalah Yang Anda Butuhkan”

- Radford et al., “Meningkatkan Pemahaman Bahasa dengan Pra-Pelatihan Generatif”

- Devlin et al., “BERT: Pra-Pelatihan Transformator Dua Arah Jauh untuk Pemahaman Bahasa”

- Yinhan Liu et al., “RoBERTa: Pendekatan Prapelatihan BERT yang Dioptimalkan dengan Kuat”

- Marcos Zampieri et al., “SemEval-2019 Tugas 6: Mengidentifikasi dan Mengkategorikan Bahasa yang Menyinggung di Media Sosial (OffensEval)”

- Valerio Basile et al., “Tugas SemEval-2019 5: Deteksi Multibahasa Ujaran Kebencian Terhadap Imigran dan Perempuan di Twitter”

Tentang penulis

James Poquiz adalah Ilmuwan Data dengan Layanan Profesional AWS yang berbasis di Orange County, California. Dia memiliki gelar BS dalam Ilmu Komputer dari University of California, Irvine dan memiliki pengalaman beberapa tahun bekerja di domain data setelah memainkan banyak peran berbeda. Saat ini dia bekerja untuk menerapkan dan menerapkan solusi ML yang dapat diskalakan untuk mencapai hasil bisnis bagi klien AWS.

James Poquiz adalah Ilmuwan Data dengan Layanan Profesional AWS yang berbasis di Orange County, California. Dia memiliki gelar BS dalam Ilmu Komputer dari University of California, Irvine dan memiliki pengalaman beberapa tahun bekerja di domain data setelah memainkan banyak peran berbeda. Saat ini dia bekerja untuk menerapkan dan menerapkan solusi ML yang dapat diskalakan untuk mencapai hasil bisnis bagi klien AWS.

Han Man adalah Manajer Ilmu Data & Pembelajaran Mesin Senior dengan Layanan Profesional AWS yang berbasis di San Diego, CA. Dia memiliki gelar PhD di bidang Teknik dari Northwestern University dan memiliki pengalaman beberapa tahun sebagai konsultan manajemen yang memberi nasihat kepada klien di bidang manufaktur, jasa keuangan, dan energi. Saat ini, dia dengan penuh semangat bekerja dengan pelanggan utama dari berbagai vertikal industri untuk mengembangkan dan menerapkan solusi ML dan GenAI di AWS.

Han Man adalah Manajer Ilmu Data & Pembelajaran Mesin Senior dengan Layanan Profesional AWS yang berbasis di San Diego, CA. Dia memiliki gelar PhD di bidang Teknik dari Northwestern University dan memiliki pengalaman beberapa tahun sebagai konsultan manajemen yang memberi nasihat kepada klien di bidang manufaktur, jasa keuangan, dan energi. Saat ini, dia dengan penuh semangat bekerja dengan pelanggan utama dari berbagai vertikal industri untuk mengembangkan dan menerapkan solusi ML dan GenAI di AWS.

Safa Tinaztepe adalah ilmuwan data full-stack dengan Layanan Profesional AWS. Dia memiliki gelar BS dalam ilmu komputer dari Universitas Emory dan memiliki minat dalam MLOps, sistem terdistribusi, dan web3.

Safa Tinaztepe adalah ilmuwan data full-stack dengan Layanan Profesional AWS. Dia memiliki gelar BS dalam ilmu komputer dari Universitas Emory dan memiliki minat dalam MLOps, sistem terdistribusi, dan web3.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :memiliki

- :adalah

- :bukan

- :Di mana

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- kemampuan

- Sanggup

- Tentang Kami

- mengakses

- ketepatan

- tepat

- Mencapai

- dicapai

- aktif

- tindakan

- menambahkan

- menambahkan

- tambahan

- alamat

- menasihati

- Setelah

- terhadap

- AI

- AL

- Semua

- diizinkan

- memungkinkan

- juga

- Amazon

- Amazon Web Services

- jumlah

- jumlah

- an

- analis

- menganalisis

- dan

- hewan

- Lain

- Apa pun

- Aplikasi

- aplikasi

- terapan

- Mendaftar

- pendekatan

- tepat

- sekitar

- arsitektur

- ADALAH

- argumen

- Seni

- AS

- menilai

- terkait

- mengasumsikan

- At

- perhatian

- mengotomatisasi

- AWS

- Layanan Profesional AWS

- mendasarkan

- berdasarkan

- Dasar

- dasar

- BE

- karena

- menjadi

- menjadi

- sebelum

- Awal

- di belakang

- makhluk

- di bawah

- manfaat

- TERBAIK

- antara

- lebih besar

- Milyar

- miliaran

- Memblokir

- lahir

- kedua

- terobosan

- luas

- membangun

- membangun

- bisnis

- bisnis

- tapi

- by

- CA

- california

- bernama

- CAN

- mampu

- ditangkap

- kasus

- kasus

- KUCING

- kategori

- mengkategorikan

- Kategori

- Kucing

- pusat

- tertentu

- menantang

- tantangan

- berubah

- mengubah

- saluran

- ChatGPT

- memilih

- terpilih

- kelas

- kelas-kelas

- klasifikasi

- Klasifikasi

- klien

- kode

- kolaborasi

- menggabungkan

- bagaimana

- datang

- menyampaikan

- Komunikasi

- masyarakat

- perusahaan

- sebanding

- kompetisi

- komputer

- Komputer Ilmu

- konsep

- konsep

- kesimpulan

- dianggap

- terdiri

- kendala

- konsultan

- konsumen

- mengandung

- Konten

- konteks

- benar

- Biaya

- mahal

- Biaya

- bisa

- daerah

- Meliputi

- membuat

- dibuat

- adat

- pelanggan

- pelanggan

- data

- ilmu data

- ilmuwan data

- kumpulan data

- hari

- memutuskan

- keputusan

- dianggap

- mendalam

- menyelam dalam

- lebih dalam

- menetapkan

- didefinisikan

- menyampaikan

- disampaikan

- pengiriman

- menggali

- mendemokrasikan

- Demografi

- menunjukkan

- penggelaran

- penyebaran

- Mendesain

- diinginkan

- menemukan

- Deteksi

- Menentukan

- mengembangkan

- Pengembangan

- MELAKUKAN

- Diego

- berbeda

- berbeda

- didistribusikan

- sistem terdistribusi

- tidak

- domain

- domain

- dua kali lipat

- dijuluki

- selama

- E&T

- setiap

- memudahkan

- Mudah

- Efektif

- efektivitas

- efek

- usaha

- akhir

- energi

- Mesin

- Teknik

- Inggris

- mempertinggi

- cukup

- Enter

- Seluruh

- Lingkungan Hidup

- masa

- diperkirakan

- dievaluasi

- pERNAH

- Setiap

- contoh

- ada

- pengalaman

- eksperimen

- eksperimen

- ahli

- Menjelaskan

- menjelaskan

- menyelidiki

- ekspresif

- memperpanjang

- luas

- secara ekstensif

- tambahan

- ekstrak

- Menghadapi

- dihadapi

- fakta

- Fashion

- tercepat

- tercepat

- beberapa

- Angka

- terakhir

- keuangan

- jasa keuangan

- Menemukan

- Pertama

- cocok

- aliran

- Fokus

- berikut

- Untuk

- format

- ditemukan

- Prinsip Dasar

- kerangka

- dari

- lebih lanjut

- diperoleh

- permainan

- Games

- game

- Industri game

- dikumpulkan

- Umum

- menghasilkan

- menghasilkan

- generatif

- AI generatif

- mendapatkan

- diberikan

- Pergi

- akan

- Kelompok

- Pertumbuhan

- dewasa

- memiliki

- Memiliki

- memiliki

- he

- kepala

- sehat

- di sini

- lebih tinggi

- historis

- secara historis

- sejarah

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTTPS

- Pusat

- manusia

- Ratusan

- Penyesuaian Hyperparameter

- ide

- ideal

- identik

- mengidentifikasi

- if

- gambar

- gambar

- Imigran

- melaksanakan

- mengimplementasikan

- mengimpor

- penting

- impor

- memperbaiki

- ditingkatkan

- perbaikan

- perbaikan

- in

- memasukkan

- Termasuk

- meningkatkan

- industri

- informasi

- inheren

- secara inheren

- Innovation

- memasukkan

- Mengintegrasikan

- berinteraksi

- interaksi

- interaktif

- tertarik

- kepentingan

- ke

- diperkenalkan

- Memperkenalkan

- IT

- NYA

- Januari

- gergaji ukir

- bersama

- hanya

- kunci

- kata kunci

- pengetahuan

- dikenal

- pelabelan

- Label

- bahasa

- besar

- besar-besaran

- kemudian

- meletakkan

- lapisan

- pengetahuan

- Panjang

- kurang

- 'like'

- LLM

- memuat

- lagi

- mencari

- kalah

- Lot

- Penurunan

- mesin

- Mesin belajar

- terbuat

- Utama

- memelihara

- pemeliharaan

- membuat

- MEMBUAT

- Membuat

- pria

- pengelolaan

- manajer

- panduan

- pabrik

- banyak

- besar-besaran

- Mungkin..

- mekanisme

- Media

- bertemu

- metode

- Metodologi

- metrik

- juta

- ML

- MLOps

- model

- pemodelan

- model

- Modifikasi

- Modul

- pemantauan

- bulan

- lebih

- paling

- Paling Populer

- banyak

- yaitu

- Alam

- Pengolahan Bahasa alami

- Alam

- dibutuhkan

- jaringan

- jaringan

- jaringan saraf

- New

- berikutnya

- nLP

- simpul

- sekarang

- jumlah

- nomor

- mendapatkan

- of

- lepas

- serangan

- sering

- on

- ONE

- secara online

- game online

- hanya

- Operasi

- menentang

- dioptimalkan

- Opsi

- or

- Jeruk

- urutan

- asli

- Lainnya

- di luar

- Hasil

- hasil

- keluaran

- lebih

- secara keseluruhan

- ikhtisar

- sendiri

- pasang

- pola pikir

- parameter

- parameter

- bagian

- bermitra

- Lulus

- lalu

- pola

- sempurna

- Melakukan

- prestasi

- melakukan

- tahap

- phd

- frase

- bagian

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- dimainkan

- pemain

- pemain

- silahkan

- PoC

- Titik

- Populer

- populasi

- Pos

- Posts

- berpotensi

- kekuasaan

- kuat

- kekuatan

- Ketelitian

- meramalkan

- diprediksi

- memprediksi

- ramalan

- Prediksi

- Prediksi

- sebelumnya

- sebelumnya

- Masalah

- Prosedur

- proses

- proses

- pengolahan

- menghasilkan

- Produksi

- kata-kata kotor

- profesional

- mendorong

- mempromosikan

- bukti

- bukti konsep

- disediakan

- menyediakan

- publik

- menempatkan

- Ular sanca

- kualitas

- jarak

- mencapai

- mencapai

- siap

- nyata

- dunia nyata

- alasan

- diterima

- baru-baru ini

- resep

- mengenali

- direkomendasikan

- catatan

- relatif

- melepaskan

- dirilis

- relevan

- replikasi

- mewakili

- membutuhkan

- tanggung jawab

- Gaming bertanggung jawab

- mengakibatkan

- dihasilkan

- Hasil

- Reuters

- benar

- keras

- Naik

- kesegaran

- peran

- Run

- berjalan

- pembuat bijak

- sama

- San

- San Diego

- terukur

- Skala

- skala

- Ilmu

- ilmiah

- ilmuwan

- menggaruk

- Kedua

- Bagian

- bagian

- senior

- putusan pengadilan

- sentimen

- terpisah

- Urutan

- Seri

- melayani

- Layanan

- set

- set

- beberapa

- saham

- dipamerkan

- Pertunjukkan

- mirip

- sejak

- tunggal

- Ukuran

- melambat

- kecil

- lebih kecil

- So

- Sosial

- media sosial

- sosial

- semata-mata

- larutan

- Solusi

- MEMECAHKAN

- Memecahkan

- beberapa

- dicari

- Space

- tertentu

- Secara khusus

- pidato

- kecepatan

- membagi

- dimulai

- Negara

- statistik

- Langkah

- Masih

- struktur

- Belajar

- substansial

- seperti itu

- cukup

- sistem

- tabel

- disesuaikan

- Dibutuhkan

- pengambilan

- tugas

- tugas

- tim

- Teknologi

- uji

- diuji

- dari

- bahwa

- Grafik

- Negara

- mereka

- Mereka

- kemudian

- teoretis

- Sana.

- Ini

- mereka

- ini

- pikir

- tiga

- ambang

- Melalui

- Demikian

- waktu

- kali

- waktu

- titan

- untuk

- hari ini

- Topik

- Total

- Pelatihan VE

- terlatih

- Pelatihan

- transfer

- transformator

- transformer

- Terjemahan

- benar-benar

- MENGHIDUPKAN

- menciak

- tweet

- dua

- mengetik

- jenis

- khas

- khas

- Akhirnya

- pokok

- pemahaman

- sayangnya

- universitas

- University of California

- diperbarui

- menggunakan

- gunakan case

- bekas

- Pengguna

- Pengguna Pengalaman

- Pengguna

- kegunaan

- menggunakan

- MENGESAHKAN

- pengesahan

- variasi

- Luas

- Versi

- vertikal

- sangat

- melalui

- Video

- permainan video

- sebenarnya

- Suara

- vs

- ingin

- ingin

- adalah

- Cara..

- we

- jaringan

- layanan web

- Web3

- berat

- BAIK

- terkenal

- adalah

- ketika

- apakah

- yang

- sementara

- mengapa

- lebar

- Rentang luas

- Wikipedia

- akan

- dengan

- dalam

- tanpa

- Wanita

- Word

- kata

- alur kerja

- kerja

- bekerja

- dunia

- akan

- penulisan

- tahun

- Kamu

- Anda

- zephyrnet.dll