verifikasi adalah mitra platform verifikasi identitas untuk organisasi inovatif yang didorong oleh pertumbuhan, termasuk pionir dalam layanan keuangan, FinTech, kripto, game, mobilitas, dan pasar online. Mereka menyediakan teknologi canggih yang menggabungkan otomatisasi bertenaga AI dengan masukan manusia, wawasan mendalam, dan keahlian.

Veriff memberikan infrastruktur terbukti yang memungkinkan pelanggannya mempercayai identitas dan atribut pribadi penggunanya di semua momen relevan dalam perjalanan pelanggan mereka. Veriff dipercaya oleh pelanggan seperti Bolt, Deel, Monese, Starship, Super Awesome, Trustpilot, dan Wise.

Sebagai solusi yang didukung AI, Veriff perlu membuat dan menjalankan lusinan model pembelajaran mesin (ML) dengan cara yang hemat biaya. Model-model ini berkisar dari model ringan berbasis pohon hingga model visi komputer pembelajaran mendalam, yang perlu dijalankan pada GPU untuk mencapai latensi rendah dan meningkatkan pengalaman pengguna. Veriff juga saat ini menambahkan lebih banyak produk ke dalam penawarannya, menargetkan solusi yang sangat dipersonalisasi untuk pelanggannya. Melayani model yang berbeda untuk pelanggan yang berbeda menambah kebutuhan akan solusi penyajian model yang skalabel.

Dalam postingan ini, kami menunjukkan kepada Anda bagaimana Veriff menstandardisasi alur kerja penerapan model mereka Amazon SageMaker, mengurangi biaya dan waktu pengembangan.

Tantangan infrastruktur dan pembangunan

Arsitektur backend Veriff didasarkan pada pola layanan mikro, dengan layanan yang berjalan pada klaster Kubernetes berbeda yang dihosting di infrastruktur AWS. Pendekatan ini awalnya digunakan untuk semua layanan perusahaan, termasuk layanan mikro yang menjalankan model ML computer vision yang mahal.

Beberapa model ini memerlukan penerapan pada instans GPU. Sadar akan biaya jenis instans yang didukung GPU yang relatif lebih tinggi, Veriff mengembangkan a solusi khusus di Kubernetes untuk berbagi sumber daya GPU tertentu di antara replika layanan yang berbeda. Sebuah GPU biasanya memiliki VRAM yang cukup untuk menampung beberapa model visi komputer Veriff di memori.

Meskipun solusi ini memang meringankan biaya GPU, solusi ini juga memiliki kendala yang mengharuskan para ilmuwan data untuk menunjukkan terlebih dahulu berapa banyak memori GPU yang dibutuhkan model mereka. Selain itu, DevOps dibebani dengan penyediaan instans GPU secara manual sebagai respons terhadap pola permintaan. Hal ini menyebabkan overhead operasional dan penyediaan mesin virtual yang berlebihan, sehingga menghasilkan profil biaya yang kurang optimal.

Selain penyediaan GPU, penyiapan ini juga mengharuskan data scientist untuk membuat wrapper REST API untuk setiap model, yang diperlukan untuk menyediakan antarmuka umum untuk digunakan oleh layanan perusahaan lain, dan untuk merangkum prapemrosesan dan pascapemrosesan data model. API ini memerlukan kode tingkat produksi, sehingga menyulitkan ilmuwan data untuk memproduksi model.

Tim platform ilmu data Veriff mencari cara alternatif untuk pendekatan ini. Tujuan utamanya adalah untuk mendukung ilmuwan data perusahaan dalam transisi yang lebih baik dari penelitian ke produksi dengan menyediakan jalur penerapan yang lebih sederhana. Tujuan kedua adalah mengurangi biaya operasional penyediaan instans GPU.

Ikhtisar solusi

Veriff memerlukan solusi baru yang memecahkan dua masalah:

- Izinkan pembuatan wrapper REST API di sekitar model ML dengan mudah

- Izinkan pengelolaan kapasitas instans GPU yang disediakan secara optimal dan, jika memungkinkan, secara otomatis

Pada akhirnya, tim platform ML sepakat dalam mengambil keputusan untuk menggunakan Titik akhir multi-model Sagemaker (MME). Keputusan ini didorong oleh dukungan MME terhadap NVIDIA Server Inferensi Triton (server yang berfokus pada ML yang memudahkan untuk menggabungkan model sebagai REST API; Veriff juga sudah bereksperimen dengan Triton), serta kemampuannya untuk mengelola penskalaan otomatis instance GPU melalui kebijakan penskalaan otomatis sederhana.

Dua MME dibuat di Veriff, satu untuk pementasan dan satu lagi untuk produksi. Pendekatan ini memungkinkan mereka menjalankan langkah-langkah pengujian di lingkungan pementasan tanpa mempengaruhi model produksi.

MME SageMaker

SageMaker adalah layanan yang terkelola sepenuhnya yang memberi pengembang dan ilmuwan data kemampuan untuk membuat, melatih, dan menerapkan model ML dengan cepat. MME SageMaker memberikan solusi yang dapat diskalakan dan hemat biaya untuk menerapkan sejumlah besar model untuk inferensi real-time. MME menggunakan wadah penyajian bersama dan kumpulan sumber daya yang dapat menggunakan instans yang dipercepat seperti GPU untuk menghosting semua model Anda. Ini mengurangi biaya hosting dengan memaksimalkan pemanfaatan titik akhir dibandingkan dengan menggunakan titik akhir model tunggal. Ini juga mengurangi overhead penerapan karena SageMaker mengelola pemuatan dan pembongkaran model dalam memori dan menskalakannya berdasarkan pola lalu lintas titik akhir. Selain itu, semua titik akhir waktu nyata SageMaker mendapat manfaat dari kemampuan bawaan untuk mengelola dan memantau model, seperti varian bayangan, penskalaan otomatis, dan integrasi asli dengan amazoncloudwatch (untuk informasi lebih lanjut, lihat Metrik CloudWatch untuk Penerapan Titik Akhir Multi-Model).

Model ansambel Triton khusus

Ada beberapa alasan Veriff memutuskan untuk menggunakan Triton Inference Server, yang utama adalah:

- Hal ini memungkinkan ilmuwan data untuk membangun REST API dari model dengan mengatur file artefak model dalam format direktori standar (tanpa solusi kode)

- Ini kompatibel dengan semua kerangka AI utama (PyTorch, Tensorflow, XGBoost, dan banyak lagi)

- Ini menyediakan optimasi server dan tingkat rendah khusus ML seperti pengelompokan dinamis permintaan

Penggunaan Triton memungkinkan data scientist menerapkan model dengan mudah karena mereka hanya perlu membuat repositori model yang diformat, bukan menulis kode untuk membuat REST API (Triton juga mendukung model piton jika logika inferensi khusus diperlukan). Hal ini mengurangi waktu penerapan model dan memberikan lebih banyak waktu bagi data scientist untuk fokus membangun model dibandingkan menerapkannya.

Fitur penting lainnya dari Triton adalah memungkinkan Anda membangun ansambel model, yang merupakan kelompok model yang dirangkai menjadi satu. Ansambel ini dapat dijalankan seolah-olah merupakan satu model Triton. Veriff saat ini menggunakan fitur ini untuk menerapkan logika prapemrosesan dan pascapemrosesan pada setiap model ML menggunakan model Python (seperti yang disebutkan sebelumnya), memastikan bahwa tidak ada ketidakcocokan dalam data masukan atau keluaran model saat model digunakan dalam produksi.

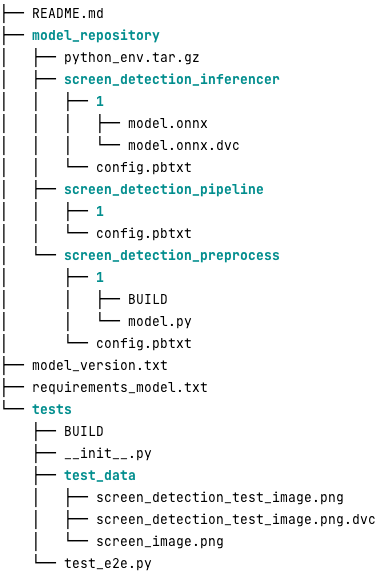

Berikut ini adalah tampilan repositori model Triton pada umumnya untuk beban kerja ini:

Grafik model.py file berisi kode prapemrosesan dan pascapemrosesan. Anak timbangan model yang dilatih ada di screen_detection_inferencer direktori, di bawah versi model 1 (model dalam format ONNX dalam contoh ini, tetapi bisa juga dalam format TensorFlow, PyTorch, atau lainnya). Definisi model ansambel ada di screen_detection_pipeline direktori, tempat input dan output antar langkah dipetakan dalam file konfigurasi.

Dependensi tambahan yang diperlukan untuk menjalankan model Python dirinci dalam a requirements.txt file, dan perlu dikemas conda untuk membangun lingkungan Conda (python_env.tar.gz). Untuk informasi lebih lanjut, lihat Mengelola Runtime dan Perpustakaan Python. Selain itu, file konfigurasi untuk langkah-langkah Python perlu ditunjukkan python_env.tar.gz menggunakan EXECUTION_ENV_PATH Directive.

Folder model kemudian perlu dikompresi TAR dan diganti namanya menggunakan model_version.txt. Akhirnya, hasilnya <model_name>_<model_version>.tar.gz file disalin ke Layanan Penyimpanan Sederhana Amazon Bucket (Amazon S3) terhubung ke MME, memungkinkan SageMaker mendeteksi dan menyajikan model.

Pembuatan versi model dan penerapan berkelanjutan

Seperti yang dijelaskan pada bagian sebelumnya, membangun repositori model Triton sangatlah mudah. Namun, menjalankan semua langkah yang diperlukan untuk menerapkannya akan membosankan dan rawan kesalahan, jika dijalankan secara manual. Untuk mengatasi hal ini, Veriff membangun monorepo yang berisi semua model untuk diterapkan ke MME, tempat para ilmuwan data berkolaborasi dalam pendekatan mirip Gitflow. Monorepo ini memiliki beberapa fitur berikut:

- Itu dikelola menggunakan Celana.

- Alat kualitas kode seperti Black dan MyPy diterapkan menggunakan Pants.

- Pengujian unit ditentukan untuk setiap model, yang memeriksa apakah keluaran model adalah keluaran yang diharapkan untuk masukan model tertentu.

- Bobot model disimpan bersama repositori model. Bobot ini bisa berupa file biner besar DVC digunakan untuk menyinkronkannya dengan Git secara berversi.

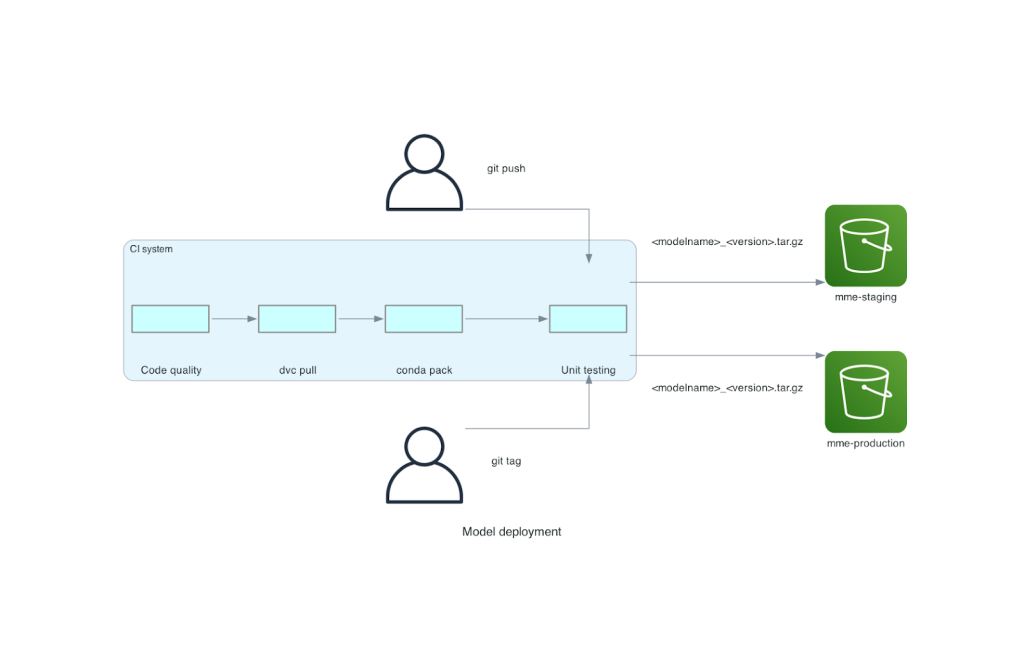

Monorepo ini terintegrasi dengan alat integrasi berkelanjutan (CI). Untuk setiap dorongan baru ke repo atau model baru, langkah-langkah berikut dijalankan:

- Lulus pemeriksaan kualitas kode.

- Unduh bobot model.

- Bangun lingkungan Conda.

- Jalankan server Triton menggunakan lingkungan Conda dan gunakan untuk memproses permintaan yang ditentukan dalam pengujian unit.

- Bangun file TAR model akhir (

<model_name>_<model_version>.tar.gz).

Langkah-langkah ini memastikan bahwa model memiliki kualitas yang diperlukan untuk penerapan, sehingga untuk setiap dorongan ke cabang repo, file TAR yang dihasilkan disalin (dalam langkah CI lainnya) ke bucket S3 penahapan. Ketika dorongan dilakukan di cabang utama, file model disalin ke bucket S3 produksi. Diagram berikut menggambarkan sistem CI/CD ini.

Manfaat biaya dan kecepatan penerapan

Penggunaan MME memungkinkan Veriff menggunakan pendekatan monorepo untuk menerapkan model ke produksi. Singkatnya, alur kerja penerapan model baru Veriff terdiri dari langkah-langkah berikut:

- Buat cabang di monorepo dengan model atau versi model baru.

- Tentukan dan jalankan pengujian unit di mesin pengembangan.

- Dorong cabang saat model siap untuk diuji di lingkungan pementasan.

- Gabungkan cabang ke main ketika model siap digunakan dalam produksi.

Dengan adanya solusi baru ini, penerapan model di Veriff menjadi bagian langsung dari proses pengembangan. Waktu pengembangan model baru berkurang dari 10 hari menjadi rata-rata 2 hari.

Penyediaan infrastruktur terkelola dan fitur penskalaan otomatis SageMaker memberikan manfaat tambahan bagi Veriff. Mereka menggunakan DoaPerInstance Metrik CloudWatch untuk diskalakan berdasarkan pola lalu lintas, menghemat biaya tanpa mengorbankan keandalan. Untuk menentukan nilai ambang batas metrik, mereka melakukan pengujian beban pada titik akhir staging untuk menemukan trade-off terbaik antara latensi dan biaya.

Setelah menerapkan tujuh model produksi ke MME dan menganalisis pembelanjaan, Veriff melaporkan pengurangan biaya sebesar 75% dalam penyajian model GPU dibandingkan dengan solusi asli berbasis Kubernetes. Biaya operasional juga berkurang, karena beban penyediaan instans secara manual dihilangkan dari teknisi DevOps perusahaan.

Kesimpulan

Dalam postingan ini, kami meninjau mengapa Veriff memilih MME Sagemaker daripada penerapan model yang dikelola sendiri di Kubernetes. SageMaker melakukan pekerjaan berat yang tidak dapat dibedakan, memungkinkan Veriff mengurangi waktu pengembangan model, meningkatkan efisiensi teknik, dan secara signifikan menurunkan biaya untuk inferensi real-time sambil mempertahankan kinerja yang diperlukan untuk operasi bisnis penting mereka. Terakhir, kami memamerkan pipeline CI/CD penerapan model Veriff yang sederhana namun efektif dan mekanisme pembuatan versi model, yang dapat digunakan sebagai referensi implementasi dalam menggabungkan praktik terbaik pengembangan perangkat lunak dan MME SageMaker. Anda dapat menemukan contoh kode untuk menghosting beberapa model menggunakan MME SageMaker di GitHub.

Tentang Penulis

Ricard Borras adalah Senior Machine Learning di Veriff, tempat dia memimpin upaya MLOps di perusahaan. Dia membantu ilmuwan data untuk membangun produk AI/ML yang lebih cepat dan lebih baik dengan membangun Platform Sains Data di perusahaan, dan menggabungkan beberapa solusi sumber terbuka dengan layanan AWS.

Ricard Borras adalah Senior Machine Learning di Veriff, tempat dia memimpin upaya MLOps di perusahaan. Dia membantu ilmuwan data untuk membangun produk AI/ML yang lebih cepat dan lebih baik dengan membangun Platform Sains Data di perusahaan, dan menggabungkan beberapa solusi sumber terbuka dengan layanan AWS.

João Moura adalah Arsitek Solusi Spesialis AI/ML di AWS, yang berbasis di Spanyol. Dia membantu pelanggan dengan pelatihan skala besar model pembelajaran mendalam dan pengoptimalan inferensi, dan secara lebih luas membangun platform ML skala besar di AWS.

João Moura adalah Arsitek Solusi Spesialis AI/ML di AWS, yang berbasis di Spanyol. Dia membantu pelanggan dengan pelatihan skala besar model pembelajaran mendalam dan pengoptimalan inferensi, dan secara lebih luas membangun platform ML skala besar di AWS.

Miguel Ferreira bekerja sebagai Sr. Solutions Architect di AWS yang berbasis di Helsinki, Finlandia. AI/ML telah menjadi minatnya sejak lama dan dia telah membantu banyak pelanggan mengintegrasikan Amazon SageMaker ke dalam alur kerja ML mereka.

Miguel Ferreira bekerja sebagai Sr. Solutions Architect di AWS yang berbasis di Helsinki, Finlandia. AI/ML telah menjadi minatnya sejak lama dan dia telah membantu banyak pelanggan mengintegrasikan Amazon SageMaker ke dalam alur kerja ML mereka.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/how-veriff-decreased-deployment-time-by-80-using-amazon-sagemaker-multi-model-endpoints/

- :memiliki

- :adalah

- :Di mana

- $NAIK

- 10

- 100

- 7

- a

- kemampuan

- dipercepat

- Menurut

- Mencapai

- di seluruh

- menambahkan

- menambahkan

- tambahan

- Menambahkan

- maju

- Teknologi Terkini

- mempengaruhi

- AI

- Bertenaga AI

- AI / ML

- Semua

- meringankan

- Membiarkan

- memungkinkan

- di samping

- sudah

- juga

- alternatif

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- menganalisis

- dan

- Lain

- api

- Lebah

- semu

- terapan

- pendekatan

- arsitektur

- ADALAH

- sekitar

- AS

- At

- atribut

- mobil

- Otomatisasi

- rata-rata

- AWS

- Backend

- berdasarkan

- BE

- karena

- menjadi

- makhluk

- manfaat

- Manfaat

- TERBAIK

- Praktik Terbaik

- Lebih baik

- antara

- Black

- Bolt

- Cabang

- secara luas

- Terbawa

- membangun

- Bangunan

- model bangunan

- dibangun di

- built-in

- beban

- tapi

- by

- datang

- CAN

- kemampuan

- kemampuan

- Kapasitas

- disebabkan

- dirantai

- menantang

- memeriksa

- memilih

- kode

- Berkolaborasi

- menggabungkan

- menggabungkan

- perusahaan

- Perusahaan

- relatif

- dibandingkan

- cocok

- komputer

- Visi Komputer

- konfigurasi

- terhubung

- sadar

- terdiri

- memakan

- Wadah

- mengandung

- kontinu

- Biaya

- pengurangan biaya

- hemat biaya

- Biaya

- membuat

- dibuat

- kripto

- Sekarang

- adat

- pelanggan

- Perjalanan Pelanggan

- pelanggan

- data

- ilmu data

- Hari

- memutuskan

- keputusan

- mengurangi

- menurun

- menurun

- mendalam

- belajar mendalam

- menetapkan

- didefinisikan

- definisi

- memberikan

- Permintaan

- ketergantungan

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- terperinci

- menemukan

- dikembangkan

- pengembang

- Pengembangan

- MELAKUKAN

- berbeda

- dilakukan

- puluhan

- secara dramatis

- didorong

- setiap

- Terdahulu

- memudahkan

- Mudah

- Efektif

- efisiensi

- upaya

- mempekerjakan

- memungkinkan

- Titik akhir

- Teknik

- Insinyur

- cukup

- memastikan

- Lingkungan Hidup

- kesalahan

- Setiap

- contoh

- diharapkan

- mahal

- pengalaman

- keahlian

- lebih cepat

- Fitur

- Fitur

- umpan balik

- File

- File

- terakhir

- Akhirnya

- keuangan

- jasa keuangan

- Menemukan

- Finlandia

- fintech

- ARMADA KAPAL

- Fokus

- berikut

- Untuk

- format

- kerangka

- dari

- sepenuhnya

- Selanjutnya

- game

- pergi

- diberikan

- memberikan

- GPU

- GPU

- Grup

- Memiliki

- he

- berat

- angkat berat

- membantu

- membantu

- lebih tinggi

- memegang

- tuan rumah

- host

- tuan

- biaya hosting

- Seterpercayaapakah Olymp Trade? Kesimpulan

- Namun

- HTML

- http

- HTTPS

- manusia

- identitas

- identitas

- Verifikasi Identitas

- if

- implementasi

- penting

- memperbaiki

- in

- Termasuk

- Meningkatkan

- menunjukkan

- informasi

- Infrastruktur

- mulanya

- inovatif

- memasukkan

- input

- wawasan

- contoh

- sebagai gantinya

- mengintegrasikan

- terpadu

- integrasi

- bunga

- Antarmuka

- ke

- IT

- NYA

- perjalanan

- jpg

- besar

- besar-besaran

- Latensi

- terkemuka

- pengetahuan

- Mengangkat

- pengangkatan

- ringan

- 'like'

- memuat

- pemuatan

- logika

- tampak

- TERLIHAT

- Rendah

- menurunkan

- mesin

- Mesin belajar

- terbuat

- Utama

- mempertahankan

- utama

- membuat

- MEMBUAT

- mengelola

- berhasil

- mengelola

- pelaksana

- cara

- manual

- pasar

- memaksimalkan

- mekanisme

- Memori

- tersebut

- metrik

- Metrik

- microservices

- ML

- MLOps

- mobilitas

- model

- model

- Waktu

- Mone

- Memantau

- lebih

- banyak

- Titik Akhir Multi-Model

- beberapa

- asli

- perlu

- Perlu

- dibutuhkan

- kebutuhan

- New

- solusi baru

- tidak

- jumlah

- Nvidia

- tujuan

- of

- menawarkan

- on

- ONE

- yang

- secara online

- hanya

- Buka

- open source

- operasional

- Operasi

- optimasi

- or

- organisasi

- asli

- Lainnya

- Lainnya

- keluaran

- output

- lebih

- Mengatasi

- bagian

- pasangan

- pola

- pola

- prestasi

- dilakukan

- pribadi

- pelopor

- pipa saluran

- Tempat

- Platform

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- Kebijakan

- mungkin

- Pos

- praktek

- sebelumnya

- masalah

- proses

- Produksi

- Produk

- Profil

- terbukti

- memberikan

- menyediakan

- menyediakan

- Dorong

- mendorong

- Ular sanca

- pytorch

- kualitas

- segera

- jarak

- siap

- real-time

- alasan

- menurunkan

- mengurangi

- mengurangi

- mengurangi

- pengurangan

- lihat

- referensi

- relevan

- keandalan

- Dilaporkan

- gudang

- permintaan

- membutuhkan

- wajib

- penelitian

- Sumber

- tanggapan

- ISTIRAHAT

- dihasilkan

- review jurnal

- Run

- berjalan

- berkorban

- pembuat bijak

- penghematan

- terukur

- Skala

- skala

- Ilmu

- ilmuwan

- sekunder

- Bagian

- senior

- melayani

- Server

- layanan

- Layanan

- porsi

- penyiapan

- tujuh

- beberapa

- Share

- berbagi

- Menunjukkan

- dipamerkan

- Sederhana

- lebih sederhana

- tunggal

- So

- Perangkat lunak

- pengembangan perangkat lunak

- larutan

- Solusi

- sumber

- Spanyol

- spesialis

- kecepatan

- menghabiskan

- pementasan

- standar

- kapal luar angkasa

- Langkah

- Tangga

- penyimpanan

- tersimpan

- mudah

- seperti itu

- RINGKASAN

- besar

- mendukung

- Mendukung

- yakin

- sistem

- Dibutuhkan

- penargetan

- tim

- Teknologi

- tensorflow

- diuji

- pengujian

- tes

- bahwa

- Grafik

- mereka

- Mereka

- kemudian

- Sana.

- Ini

- mereka

- ini

- ambang

- waktu

- untuk

- bersama

- alat

- alat

- lalu lintas

- Pelatihan VE

- terlatih

- Pelatihan

- transisi

- Pelaut

- Kepercayaan

- Terpercaya

- dua

- jenis

- khas

- khas

- bawah

- satuan

- menggunakan

- bekas

- Pengguna

- Pengguna Pengalaman

- Pengguna

- menggunakan

- nilai

- Verifikasi

- versi

- melalui

- penglihatan

- adalah

- Cara..

- cara

- we

- jaringan

- layanan web

- BAIK

- adalah

- Apa

- ketika

- yang

- sementara

- mengapa

- BIJAKSANA

- dengan

- tanpa

- alur kerja

- Alur kerja

- bekerja

- akan

- membungkus

- penulisan

- XGBoost

- namun

- Kamu

- Anda

- zephyrnet.dll