AI Generatif telah menjadi alat umum untuk meningkatkan dan mempercepat proses kreatif di berbagai industri, termasuk hiburan, periklanan, dan desain grafis. Hal ini memungkinkan pengalaman yang lebih dipersonalisasi untuk audiens dan meningkatkan kualitas produk akhir secara keseluruhan.

Salah satu manfaat signifikan AI generatif adalah menciptakan pengalaman unik dan personal bagi pengguna. Misalnya, AI generatif digunakan oleh layanan streaming untuk menghasilkan judul dan visual film yang dipersonalisasi guna meningkatkan keterlibatan pemirsa dan membangun visual untuk judul berdasarkan riwayat tontonan dan preferensi pengguna. Sistem kemudian menghasilkan ribuan variasi karya seni suatu judul dan mengujinya untuk menentukan versi mana yang paling menarik perhatian pengguna. Dalam beberapa kasus, karya seni yang dipersonalisasi untuk serial TV secara signifikan meningkatkan rasio klik-tayang dan rasio penayangan dibandingkan dengan acara tanpa karya seni yang dipersonalisasi.

Dalam postingan ini, kami mendemonstrasikan bagaimana Anda dapat menggunakan model AI generatif seperti Difusi Stabil untuk membangun solusi avatar yang dipersonalisasi Amazon SageMaker dan menghemat biaya inferensi dengan titik akhir multi-model (MME) secara bersamaan. Solusinya menunjukkan bagaimana, dengan mengunggah 10–12 gambar diri Anda, Anda dapat menyempurnakan model yang dipersonalisasi yang kemudian dapat menghasilkan avatar berdasarkan perintah teks apa pun, seperti yang ditunjukkan pada tangkapan layar berikut. Meskipun contoh ini menghasilkan avatar yang dipersonalisasi, Anda dapat menerapkan teknik ini pada generasi seni kreatif mana pun dengan menyempurnakan objek atau gaya tertentu.

Ikhtisar solusi

Diagram arsitektur berikut menguraikan solusi end-to-end untuk generator avatar kami.

![]()

Ruang lingkup posting ini dan contohnya Kode GitHub kami memberikan fokus hanya pada pelatihan model dan orkestrasi inferensi (bagian hijau pada diagram sebelumnya). Anda dapat mereferensikan arsitektur solusi lengkap dan membangun berdasarkan contoh yang kami berikan.

Pelatihan model dan inferensi dapat dipecah menjadi empat langkah:

- Unggah gambar ke Layanan Penyimpanan Sederhana Amazon (Amazon S3). Pada langkah ini, kami meminta Anda untuk memberikan minimal 10 gambar diri Anda yang beresolusi tinggi. Semakin banyak gambar, semakin baik hasilnya, tetapi semakin lama waktu yang dibutuhkan untuk melatihnya.

- Menyempurnakan model dasar Difusi Stabil 2.1 menggunakan inferensi asinkron SageMaker. Kami menjelaskan alasan penggunaan titik akhir inferensi untuk pelatihan nanti di postingan ini. Proses penyempurnaan dimulai dengan menyiapkan gambar, termasuk pemotongan wajah, variasi latar belakang, dan pengubahan ukuran model. Kemudian kami menggunakan Adaptasi Tingkat Rendah (LoRA), sebuah teknik penyesuaian parameter yang efisien untuk model bahasa besar (LLM), untuk menyempurnakan model tersebut. Terakhir, dalam pascapemrosesan, kami mengemas bobot LoRA yang telah disempurnakan dengan skrip inferensi dan file konfigurasi (tar.gz) dan mengunggahnya ke lokasi bucket S3 untuk MME SageMaker.

- Host model yang disempurnakan menggunakan MME SageMaker dengan GPU. SageMaker akan secara dinamis memuat dan menyimpan model dalam cache dari lokasi Amazon S3 berdasarkan lalu lintas inferensi ke setiap model.

- Gunakan model yang telah disesuaikan untuk inferensi. Setelah Layanan Pemberitahuan Sederhana Amazon (Amazon SNS) pemberitahuan yang menunjukkan penyesuaian telah dikirim, Anda dapat segera menggunakan model tersebut dengan menyediakan a

target_modelparameter saat memanggil MME untuk membuat avatar Anda.

Kami menjelaskan setiap langkah secara lebih rinci di bagian berikut dan menelusuri beberapa cuplikan kode contoh.

Siapkan gambarnya

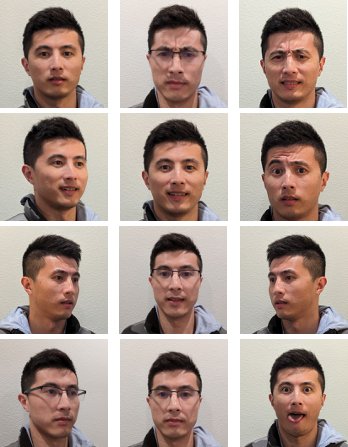

Untuk mencapai hasil terbaik dari menyempurnakan Difusi Stabil untuk menghasilkan gambar diri Anda, Anda biasanya perlu menyediakan foto diri Anda dalam jumlah besar dan beragam dari berbagai sudut, dengan ekspresi berbeda, dan dalam latar belakang berbeda. Namun, dengan penerapan kami, kini Anda dapat memperoleh hasil berkualitas tinggi hanya dengan 10 gambar masukan. Kami juga telah menambahkan pra-pemrosesan otomatis untuk mengekstrak wajah Anda dari setiap foto. Yang Anda butuhkan hanyalah menangkap esensi penampilan Anda dengan jelas dari berbagai perspektif. Sertakan foto menghadap ke depan, foto profil dari setiap sisi, dan foto dari sudut di antaranya. Anda juga harus menyertakan foto dengan ekspresi wajah berbeda seperti tersenyum, mengerutkan kening, dan ekspresi netral. Memiliki perpaduan ekspresi akan memungkinkan model mereproduksi fitur wajah unik Anda dengan lebih baik. Gambar masukan menentukan kualitas avatar yang dapat Anda hasilkan. Untuk memastikan hal ini dilakukan dengan benar, kami merekomendasikan pengalaman UI front-end yang intuitif untuk memandu pengguna melalui proses pengambilan dan pengunggahan gambar.

Berikut ini contoh gambar selfie dengan sudut berbeda dengan ekspresi wajah berbeda.

![]()

Menyempurnakan model Difusi Stabil

Setelah gambar diunggah ke Amazon S3, kita dapat memanggil Inferensi asinkron SageMaker titik akhir untuk memulai proses pelatihan kami. Titik akhir asinkron ditujukan untuk kasus penggunaan inferensi dengan muatan besar (hingga 1 GB) dan waktu pemrosesan yang lama (hingga 1 jam). Ini juga menyediakan mekanisme antrian bawaan untuk mengantri permintaan, dan mekanisme pemberitahuan penyelesaian tugas melalui Amazon SNS, selain fitur asli hosting SageMaker lainnya seperti penskalaan otomatis.

Meskipun penyesuaian bukan merupakan kasus penggunaan inferensi, kami memilih untuk menggunakannya di sini sebagai pengganti tugas pelatihan SageMaker karena mekanisme antrian dan pemberitahuan bawaannya dan penskalaan otomatis terkelola, termasuk kemampuan untuk menurunkan skala ke 0 instans saat layanan tidak digunakan. Hal ini memungkinkan kami dengan mudah menskalakan layanan penyesuaian ke sejumlah besar pengguna secara bersamaan dan menghilangkan kebutuhan untuk mengimplementasikan dan mengelola komponen tambahan. Namun, hal ini memiliki kelemahan yaitu payload 1 GB dan waktu pemrosesan maksimum 1 jam. Dalam pengujian kami, kami menemukan bahwa 20 menit adalah waktu yang cukup untuk mendapatkan hasil yang cukup baik dengan sekitar 10 gambar input pada instance ml.g5.2xlarge. Namun, pelatihan SageMaker akan menjadi pendekatan yang direkomendasikan untuk pekerjaan penyesuaian skala besar.

Untuk menghosting titik akhir asinkron, kita harus menyelesaikan beberapa langkah. Yang pertama adalah mendefinisikan server model kita. Untuk posting ini, kami menggunakan Wadah Inferensi Model Besar (LMI). LMI didukung oleh DJL Serving, yang merupakan solusi penyajian model agnostik bahasa pemrograman berkinerja tinggi. Kami memilih opsi ini karena wadah inferensi terkelola SageMaker sudah memiliki banyak perpustakaan pelatihan yang kami perlukan, seperti Hugging Face Diffuser dan Mempercepat. Hal ini sangat mengurangi jumlah pekerjaan yang diperlukan untuk menyesuaikan kontainer untuk pekerjaan penyesuaian kami.

Cuplikan kode berikut menunjukkan versi container LMI yang kita gunakan dalam contoh kita:

Selain itu, kita perlu memiliki serving.properties file yang mengonfigurasi properti penyajian, termasuk mesin inferensi yang akan digunakan, lokasi artefak model, dan pengelompokan dinamis. Terakhir, kita harus memiliki a model.py file yang memuat model ke dalam mesin inferensi dan menyiapkan input dan output data dari model. Dalam contoh kami, kami menggunakan model.py file untuk menjalankan pekerjaan penyesuaian, yang kami jelaskan secara lebih rinci di bagian selanjutnya. Keduanya serving.properties dan model.py file disediakan di training_service folder.

Langkah berikutnya setelah menentukan server model kita adalah membuat konfigurasi titik akhir yang menentukan bagaimana inferensi asinkron kita akan disajikan. Sebagai contoh, kita hanya menentukan batas pemanggilan serentak maksimum dan lokasi output S3. Dengan ml.g5.2xlarge Misalnya, kami menemukan bahwa kami dapat menyempurnakan hingga dua model secara bersamaan tanpa menemui pengecualian kehabisan memori (OOM), dan oleh karena itu kami menetapkan max_concurrent_invocations_per_instance menjadi 2. Jumlah ini mungkin perlu disesuaikan jika kita menggunakan serangkaian parameter penyetelan yang berbeda atau jenis instans yang lebih kecil. Kami merekomendasikan pengaturan ini ke 1 pada awalnya dan memantau penggunaan memori GPU amazoncloudwatch.

Terakhir, kami membuat model SageMaker yang mengemas informasi kontainer, file model, dan Identitas AWS dan Manajemen Akses (IAM) peran menjadi satu objek. Model ini diterapkan menggunakan konfigurasi titik akhir yang kami tentukan sebelumnya:

Ketika titik akhir sudah siap, kami menggunakan kode contoh berikut untuk memanggil titik akhir asinkron dan memulai proses penyesuaian:

Untuk detail lebih lanjut tentang LMI di SageMaker, lihat Terapkan model besar di Amazon SageMaker menggunakan inferensi paralel model DJLServing dan DeepSpeed.

Setelah pemanggilan, titik akhir asinkron mulai mengantri pekerjaan penyesuaian kami. Setiap pekerjaan berjalan melalui langkah-langkah berikut: menyiapkan gambar, melakukan penyempurnaan Dreambooth dan LoRA, dan menyiapkan artefak model. Mari selami lebih dalam proses penyesuaiannya.

Siapkan gambarnya

Seperti yang kami sebutkan sebelumnya, kualitas gambar masukan berdampak langsung pada kualitas model yang disempurnakan. Untuk kasus penggunaan avatar, kami ingin model fokus pada fitur wajah. Daripada mengharuskan pengguna untuk memberikan gambar yang dikurasi secara cermat dengan ukuran dan konten yang tepat, kami menerapkan langkah pra-pemrosesan menggunakan teknik visi komputer untuk meringankan beban ini. Pada langkah preprocessing, pertama-tama kita menggunakan model deteksi wajah untuk mengisolasi wajah terbesar di setiap gambar. Kemudian kami memotong dan memasukkan gambar ke ukuran yang diperlukan yaitu 512 x 512 piksel untuk model kami. Terakhir, kami mengelompokkan wajah dari latar belakang dan menambahkan variasi latar belakang secara acak. Ini membantu menyorot fitur wajah, memungkinkan model kita belajar dari wajah itu sendiri, bukan dari latar belakang. Gambar berikut mengilustrasikan tiga langkah dalam proses ini.

| Langkah 1: Deteksi wajah menggunakan computer vision | Langkah 2: Pangkas dan padukan gambar menjadi 512 x 512 piksel | Langkah 3 (Opsional): Segmentasikan dan tambahkan variasi latar belakang |

Penyempurnaan Dreambooth dan LoRA

Untuk menyempurnakannya, kami menggabungkan teknik Dreambooth dan LoRA. Dreambooth memungkinkan Anda mempersonalisasi model Difusi Stabil, menyematkan subjek ke dalam domain keluaran model menggunakan pengidentifikasi unik dan memperluas kamus visi bahasa model. Ini menggunakan metode yang disebut pelestarian sebelumnya untuk melestarikan pengetahuan semantik model tentang kelas subjek, dalam hal ini seseorang, dan menggunakan objek lain di kelas tersebut untuk meningkatkan keluaran gambar akhir. Beginilah cara Dreambooth mencapai hasil berkualitas tinggi hanya dengan beberapa gambar input subjek.

Cuplikan kode berikut menunjukkan masukan ke file kami trainer.py kelas untuk solusi avatar kami. Perhatikan kami memilih <<TOK>> sebagai pengidentifikasi unik. Hal ini sengaja dilakukan untuk menghindari pemilihan nama yang mungkin sudah ada dalam kamus model. Jika nama tersebut sudah ada, model harus melupakan dan kemudian mempelajari kembali subjeknya, yang dapat menyebabkan hasil penyesuaian yang buruk. Kelas mata pelajaran diatur ke “a photo of person”, yang memungkinkan pelestarian sebelumnya dengan terlebih dahulu membuat foto orang untuk dimasukkan sebagai masukan tambahan selama proses penyesuaian. Hal ini akan membantu mengurangi overfitting saat model mencoba melestarikan pengetahuan sebelumnya dari seseorang menggunakan metode pelestarian sebelumnya.

Sejumlah opsi penghemat memori telah diaktifkan dalam konfigurasi, termasuk fp16, use_8bit_adam, dan akumulasi gradien. Hal ini mengurangi jejak memori hingga di bawah 12 GB, yang memungkinkan penyesuaian hingga dua model secara bersamaan pada satu perangkat. ml.g5.2xlarge contoh.

LoRA adalah teknik penyesuaian yang efisien untuk LLM yang membekukan sebagian besar bobot dan menyambungkan jaringan adaptor kecil ke lapisan tertentu dari LLM yang telah dilatih sebelumnya, memungkinkan pelatihan lebih cepat dan penyimpanan yang dioptimalkan. Untuk Difusi Stabil, adaptor dipasang ke encoder teks dan komponen U-Net dari pipa inferensi. Encoder teks mengubah prompt masukan menjadi ruang laten yang dipahami oleh model U-Net, dan model U-Net menggunakan makna laten untuk menghasilkan gambar dalam proses difusi berikutnya. Output dari penyempurnaan hanyalah text_encoder dan bobot adaptor U-Net. Pada saat inferensi, bobot ini dapat dipasang kembali ke model Difusi Stabil dasar untuk mereproduksi hasil penyesuaian.

Gambar di bawah ini adalah diagram detail penyempurnaan LoRA yang disediakan oleh penulis asli: Cheng-Han Chiang, Yung-Sung Chuang, Hung-yi Lee, “AACL_2022_tutorial_PLMs,” 2022

Dengan menggabungkan kedua metode, kami dapat menghasilkan model yang dipersonalisasi sambil menyetel parameter dengan urutan besarnya lebih sedikit. Hal ini menghasilkan waktu pelatihan yang jauh lebih cepat dan mengurangi penggunaan GPU. Selain itu, penyimpanan dioptimalkan dengan bobot adaptor yang hanya 70 MB, dibandingkan dengan 6 GB untuk model Difusi Stabil penuh, yang berarti pengurangan ukuran sebesar 99%.

Siapkan artefak model

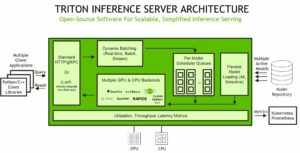

Setelah penyesuaian selesai, langkah pascapemrosesan akan TAR bobot LoRA dengan model lainnya yang menyajikan file untuk NVIDIA Triton. Kami menggunakan backend Python, yang berarti file konfigurasi Triton dan skrip Python yang digunakan untuk inferensi diperlukan. Perhatikan bahwa skrip Python harus diberi nama model.py. File TAR model akhir harus memiliki struktur file berikut:

Host model yang disempurnakan menggunakan MME SageMaker dengan GPU

Setelah model disempurnakan, kami menghosting model Difusi Stabil yang dipersonalisasi menggunakan SageMaker MME. MME SageMaker adalah fitur penerapan canggih yang memungkinkan hosting beberapa model dalam satu kontainer di belakang satu titik akhir. Ini secara otomatis mengelola lalu lintas dan perutean ke model Anda untuk mengoptimalkan pemanfaatan sumber daya, menghemat biaya, dan meminimalkan beban operasional dalam mengelola ribuan titik akhir. Dalam contoh kami, kami menjalankan instans GPU, dan MME SageMaker mendukung GPU menggunakan Server Triton. Hal ini memungkinkan Anda menjalankan beberapa model pada satu perangkat GPU dan memanfaatkan komputasi yang dipercepat. Untuk detail lebih lanjut tentang cara menghosting Difusi Stabil pada MME SageMaker, lihat Buat gambar berkualitas tinggi dengan model Difusi Stabil dan terapkan secara hemat biaya dengan Amazon SageMaker.

Sebagai contoh, kami melakukan pengoptimalan tambahan untuk memuat model yang telah disetel dengan lebih cepat selama situasi start dingin. Hal ini dimungkinkan karena desain adaptor LoRA. Karena bobot model dasar dan lingkungan Conda sama untuk semua model yang disempurnakan, kami dapat berbagi sumber daya umum ini dengan memuatnya terlebih dahulu ke dalam wadah hosting. Ini hanya menyisakan file konfigurasi Triton, backend Python (model.py), dan bobot adaptor LoRA yang akan dimuat secara dinamis dari Amazon S3 setelah pemanggilan pertama. Diagram berikut memberikan perbandingan berdampingan.

![]()

Hal ini secara signifikan mengurangi file model TAR dari sekitar 6 GB menjadi 70 MB, sehingga jauh lebih cepat untuk memuat dan membongkar. Untuk melakukan pramuat dalam contoh kita, kita membuat model backend utilitas Python models/model_setup. Skrip ini cukup menyalin model Difusi Stabil dasar dan lingkungan Conda dari Amazon S3 ke lokasi umum untuk dibagikan ke semua model yang telah disesuaikan. Berikut ini cuplikan kode yang melakukan tugas tersebut:

Kemudian setiap model yang disempurnakan akan menunjuk ke lokasi bersama di container. Lingkungan Conda direferensikan dalam config.pbtxt.

Model dasar Difusi Stabil diambil dari initialize() fungsi masing-masing model.py mengajukan. Kami kemudian menerapkan bobot LoRA yang dipersonalisasi ke unet dan text_encoder model untuk mereproduksi setiap model yang disempurnakan:

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/build-a-personalized-avatar-with-generative-ai-using-amazon-sagemaker/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- 10

- 100

- 12

- 13

- 15%

- 17

- 20

- 32

- 7

- 70

- 700

- 8

- 9

- a

- kemampuan

- Sanggup

- Tentang Kami

- dipercepat

- mempercepat

- mengakses

- dapat diakses

- akumulasi

- Mencapai

- di seluruh

- adaptasi

- menambahkan

- menambahkan

- tambahan

- Tambahan

- Selain itu

- Disesuaikan

- Keuntungan

- pengiklanan

- Setelah

- AI

- Model AI

- Layanan AI

- AI / ML

- Semua

- meringankan

- mengizinkan

- Membiarkan

- memungkinkan

- sudah

- juga

- Meskipun

- amatir

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Ambient

- jumlah

- an

- anatomi

- dan

- Apa pun

- aplikasi

- Mendaftar

- pendekatan

- sekitar

- arsitektur

- ADALAH

- Seni

- karya seni

- AS

- Aktiva

- membantu

- At

- perhatian

- Menarik

- dengar pendapat

- penulis

- mobil

- Otomatis

- secara otomatis

- tersedia

- avatar

- Avatar

- menghindari

- AWS

- Backend

- latar belakang

- latar belakang

- Buruk

- mendasarkan

- berdasarkan

- dasar

- BE

- karena

- menjadi

- menjadi

- di belakang

- makhluk

- di bawah

- manfaat

- TERBAIK

- Lebih baik

- antara

- tubuh

- kedua

- Rusak

- membangun

- built-in

- beban

- bisnis

- tapi

- by

- Cache

- bernama

- CAN

- kemampuan

- menangkap

- hati-hati

- kasus

- kasus

- tertangkap

- tantangan

- beban

- memilih

- sinematik

- Cityscape

- kelas

- Jelas

- kode

- dingin

- bergabung

- menggabungkan

- bagaimana

- Umum

- dibandingkan

- perbandingan

- lengkap

- penyelesaian

- kompleks

- komponen

- komposisi

- menghitung

- komputer

- Visi Komputer

- konsep

- bersamaan

- konfigurasi

- Wadah

- Konten

- mengubah

- Core

- Biaya

- Biaya

- Meliputi

- membuat

- dibuat

- membuat

- kreasi

- Kreatif

- tanaman

- dikuratori

- Sekarang

- pelanggan

- menyesuaikan

- disesuaikan

- Memotong

- data

- hari

- dedicated

- mendalam

- belajar mendalam

- lebih dalam

- menetapkan

- didefinisikan

- Mendefinisikan

- mendefinisikan

- Demokratisasi

- mendemonstrasikan

- menunjukkan

- menunjukkan

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- Mendesain

- rinci

- terperinci

- rincian

- Deteksi

- Menentukan

- Pengembang

- alat

- berbeda

- Difusi

- langsung

- beberapa

- DIY

- do

- tidak

- domain

- dilakukan

- turun

- draf

- ditarik

- dua

- selama

- dinamis

- dinamis

- e

- e-commerce

- setiap

- Terdahulu

- mudah

- efisien

- menghilangkan

- embedding

- diaktifkan

- memungkinkan

- bertemu

- mendorong

- ujung ke ujung

- Tak berujung

- Titik akhir

- interaksi

- Mesin

- Teknik

- mempertinggi

- meningkatkan

- Enterprise

- Menghibur

- Lingkungan Hidup

- lingkungan

- EPIC

- esensi

- contoh

- contoh

- Kecuali

- pengecualian

- ada

- memperluas

- pengalaman

- Pengalaman

- eksperimen

- keahlian

- Menjelaskan

- menyelidiki

- terkena

- ekspresi

- ekspresi

- tambahan

- ekstrak

- Menghadapi

- wajah

- Kegagalan

- keluarga

- lebih cepat

- Fitur

- Fitur

- kaki

- beberapa

- sedikit

- angka-angka

- File

- File

- terakhir

- Akhirnya

- keuangan

- Pertama

- Fokus

- terfokus

- berfokus

- berikut

- Tapak

- Untuk

- ditemukan

- empat

- FRAME

- dari

- penuh

- fungsi

- Games

- game

- menghasilkan

- menghasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- generator

- mendapatkan

- gif

- GitHub

- tujuan

- akan

- baik

- GPU

- Grafis

- lebih besar

- sangat

- Hijau

- bruto

- membimbing

- tangan

- Memiliki

- memiliki

- he

- membantu

- membantu

- membantu

- dia

- di sini

- kinerja tinggi

- berkualitas tinggi

- resolusi tinggi

- Menyoroti

- sangat

- -nya

- sejarah

- berharap

- tuan rumah

- tuan

- jam

- Rumah

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTML

- http

- HTTPS

- identifier

- identitas

- if

- gambar

- gambar

- segera

- dampak

- melaksanakan

- implementasi

- memperbaiki

- in

- memasukkan

- Termasuk

- Meningkatkan

- Pada meningkat

- individualitas

- industri

- industri

- informasi

- informatif

- mulanya

- inovatif

- teknologi inovatif

- memasukkan

- input

- menginspirasi

- contoh

- sebagai gantinya

- instruksi

- asuransi

- dimaksudkan

- bunga

- ke

- intuitif

- IT

- NYA

- Diri

- james

- Pekerjaan

- Jobs

- bergabung

- jpg

- json

- hanya

- hanya satu

- kunci

- pengetahuan

- label

- bahasa

- besar

- terbesar

- kemudian

- lapisan

- memimpin

- pemimpin

- Kepemimpinan

- BELAJAR

- pengetahuan

- Lee

- perpustakaan

- Penerangan

- 'like'

- MEMBATASI

- LLM

- memuat

- beban

- tempat

- Panjang

- lagi

- melihat

- cinta

- Rendah

- mesin

- Mesin belajar

- terbuat

- Utama

- membuat

- Membuat

- mengelola

- berhasil

- manajer

- mengelola

- pelaksana

- banyak

- Marketing

- Pemasaran & Periklanan

- maksimum

- Mungkin..

- makna

- cara

- mekanisme

- mekanisme

- Media

- Memori

- tersebut

- pesan

- metode

- metode

- minimum

- menit

- mencampur

- ML

- model

- model

- moderasi

- pemantauan

- lebih

- paling

- termotivasi

- film

- banyak

- beberapa

- harus

- nama

- Bernama

- asli

- Alam

- Pengolahan Bahasa alami

- Perlu

- jaringan

- Netral

- berikutnya

- None

- buku catatan

- Melihat..

- pemberitahuan

- sekarang

- jumlah

- Nvidia

- obyek

- objek

- of

- lepas

- Minyak

- on

- ONE

- hanya

- ke

- operasional

- optimasi

- Optimize

- dioptimalkan

- pilihan

- Opsi

- or

- teknik mengatur musik

- asli

- OS

- Lainnya

- kami

- di luar

- menguraikan

- keluaran

- lebih

- secara keseluruhan

- paket

- paket

- bantalan

- Paralel

- parameter

- parameter

- bagian

- Lulus

- bergairah

- path

- Konsultan Ahli

- sempurna

- Melakukan

- melakukan

- orang

- Kepribadian

- Personalisasi

- Personalized

- perspektif

- foto

- Foto

- gambar

- pipa

- pipa saluran

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Titik

- miskin

- potret

- kemungkinan

- mungkin

- Pos

- potensi

- didukung

- kuat

- Predictor

- preferensi

- Mempersiapkan

- Mempersiapkan

- mempersiapkan

- pengawetan

- sebelumnya

- primer

- Mencetak

- Sebelumnya

- proses

- pengolahan

- Produk

- manajer produk

- Produk

- Profil

- Pemrograman

- memprojeksikan

- mempromosikan

- tepat

- properties

- memberikan

- disediakan

- menyediakan

- Ular sanca

- kualitas

- kuantitas

- acak

- jarak

- Tarif

- agak

- alasan

- Bacaan

- siap

- sarankan

- direkomendasikan

- menurunkan

- mengurangi

- mengurangi

- pengurangan

- mencerminkan

- mengenai

- terkait

- mewakili

- permintaan

- permintaan

- wajib

- sumber

- Sumber

- tanggapan

- tanggung jawab

- ISTIRAHAT

- mengakibatkan

- Hasil

- Rockstar

- Peran

- kira-kira

- rute

- Run

- berjalan

- pembuat bijak

- Inferensi SageMaker

- sama

- Save

- Skala

- skala

- sci-fi

- cakupan

- screenshot

- Bagian

- bagian

- melihat

- benih

- ruas

- DIRI

- Selfie

- senior

- mengirim

- Seri

- layanan

- Layanan

- porsi

- set

- pengaturan

- penyiapan

- beberapa

- Bentuknya

- Share

- berbagi

- tajam

- dia

- tembakan

- harus

- ditunjukkan

- Pertunjukkan

- sisi

- penting

- signifikan

- Simon

- Sederhana

- hanya

- tunggal

- situasi

- Ukuran

- kecil

- lebih kecil

- potongan

- Sosial

- media sosial

- platform sosial

- larutan

- Solusi

- beberapa

- Space

- spesialis

- mengkhususkan diri

- tertentu

- Pengeluaran

- Berputar

- stabil

- awal

- mulai

- dimulai

- Langkah

- Tangga

- penyimpanan

- tersimpan

- Streaming

- Layanan streaming

- Tali

- struktur

- subyek

- selanjutnya

- sukses

- seperti itu

- cukup

- memasok

- mendukung

- yakin

- sistem

- Mengambil

- tugas

- tim

- TechCrunch

- teknik

- Teknologi

- Teknologi

- pengujian

- tes

- dari

- bahwa

- Grafik

- mereka

- Mereka

- kemudian

- karena itu

- Ini

- ini

- meskipun?

- pikir

- pemikiran kepemimpinan

- ribuan

- tiga

- Melalui

- waktu

- kali

- judul

- untuk

- alat

- puncak

- lalu lintas

- Pelatihan VE

- Pelatihan

- mengubah

- Perjalanan

- Pelaut

- mencoba

- tv

- dua

- mengetik

- khas

- ui

- bawah

- dipahami

- unik

- tidak perlu

- upload

- Mengunggah

- us

- Amerika Serikat

- menggunakan

- gunakan case

- bekas

- Pengguna

- Pengguna

- kegunaan

- menggunakan

- kegunaan

- Penggunaan

- nilai

- variasi

- berbagai

- versi

- melalui

- View

- melihat

- virginia

- penglihatan

- visual

- ingin

- adalah

- cap air

- we

- jaringan

- layanan web

- berat

- adalah

- Apa

- ketika

- yang

- sementara

- yang

- lebar

- Rentang luas

- akan

- dengan

- tanpa

- Kerja

- kerja

- terburuk

- akan

- X

- tahun

- Kamu

- Anda

- diri

- zephyrnet.dll