Postingan ini akan membawa Anda melewati tantangan paling umum yang dihadapi pelanggan saat mencari dokumen internal, dan memberi Anda panduan konkret tentang bagaimana layanan AWS dapat digunakan untuk membuat bot percakapan AI generatif yang menjadikan informasi internal lebih berguna.

Data tidak terstruktur menyumbang 80% dari seluruh data ditemukan dalam organisasi, terdiri dari repositori manual, PDF, FAQ, email, dan dokumen lain yang berkembang setiap hari. Bisnis saat ini bergantung pada penyimpanan informasi internal yang terus berkembang, dan masalah muncul ketika jumlah data yang tidak terstruktur menjadi tidak dapat dikelola. Seringkali, pengguna membaca dan memeriksa berbagai sumber internal untuk menemukan jawaban yang mereka butuhkan.

Forum tanya jawab internal dapat membantu pengguna mendapatkan jawaban yang sangat spesifik namun juga memerlukan waktu tunggu yang lebih lama. Dalam kasus FAQ internal khusus perusahaan, waktu tunggu yang lama mengakibatkan produktivitas karyawan lebih rendah. Forum tanya jawab sulit untuk diukur karena mengandalkan jawaban yang ditulis secara manual. Dengan AI generatif, saat ini terjadi perubahan paradigma dalam cara pengguna mencari dan menemukan informasi. Langkah logis berikutnya adalah menggunakan AI generatif untuk menyingkat dokumen besar menjadi informasi berukuran lebih kecil untuk memudahkan konsumsi pengguna. Daripada menghabiskan waktu lama membaca teks atau menunggu jawaban, pengguna dapat membuat ringkasan secara real-time berdasarkan beberapa repositori informasi internal yang ada.

Ikhtisar solusi

Solusi ini memungkinkan pelanggan untuk mengambil tanggapan yang dikurasi terhadap pertanyaan yang diajukan tentang dokumen internal dengan menggunakan model transformator untuk menghasilkan jawaban atas pertanyaan tentang data yang belum dilatih, sebuah teknik yang dikenal sebagai zero-shot prompting. Dengan mengadopsi solusi ini, pelanggan dapat memperoleh manfaat berikut:

- Temukan jawaban akurat atas pertanyaan berdasarkan sumber dokumen internal yang ada

- Kurangi waktu yang dihabiskan pengguna untuk mencari jawaban dengan menggunakan Model Bahasa Besar (LLM) untuk memberikan jawaban yang hampir seketika terhadap pertanyaan kompleks menggunakan dokumen dengan informasi terkini

- Cari pertanyaan yang telah dijawab sebelumnya melalui dasbor terpusat

- Mengurangi stres akibat menghabiskan waktu membaca informasi secara manual untuk mencari jawaban

Pengambilan Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) mengurangi beberapa kekurangan kueri berbasis LLM dengan menemukan jawaban dari basis pengetahuan Anda dan menggunakan LLM untuk meringkas dokumen menjadi respons yang ringkas. Tolong baca ini pos untuk mempelajari bagaimana menerapkan pendekatan RAG AmazonKendra. Risiko dan batasan berikut terkait dengan kueri berbasis LLM yang ditangani oleh pendekatan RAG dengan Amazon Kendra:

- Halusinasi dan ketertelusuran – LLMS dilatih pada kumpulan data besar dan menghasilkan respons berdasarkan probabilitas. Hal ini dapat menyebabkan jawaban yang tidak akurat, yang disebut halusinasi.

- Beberapa silo data – Untuk mereferensikan data dari berbagai sumber dalam respons Anda, Anda perlu menyiapkan ekosistem penghubung untuk menggabungkan data. Mengakses banyak repositori bersifat manual dan memakan waktu.

- Keamanan – Keamanan dan privasi merupakan pertimbangan penting saat menerapkan bot percakapan yang didukung oleh RAG dan LLM. Meskipun menggunakan Amazon Comprehend untuk menyaring data pribadi yang mungkin diberikan melalui pertanyaan pengguna, masih ada kemungkinan munculnya informasi pribadi atau sensitif secara tidak sengaja, bergantung pada data yang diserap. Artinya, mengontrol akses ke chatbot sangat penting untuk mencegah akses yang tidak diinginkan ke informasi sensitif.

- Relevansi data – LLMS dilatih tentang data hingga tanggal tertentu, yang berarti informasi sering kali tidak terkini. Biaya yang terkait dengan model pelatihan berdasarkan data terkini cukup tinggi. Untuk memastikan tanggapan yang akurat dan terkini, organisasi mempunyai tanggung jawab untuk memperbarui dan memperkaya konten dokumen yang diindeks secara berkala.

- Biaya – Biaya yang terkait dengan penerapan solusi ini harus menjadi pertimbangan bagi bisnis. Dunia usaha harus hati-hati menilai kebutuhan anggaran dan kinerja mereka saat menerapkan solusi ini. Menjalankan LLM memerlukan sumber daya komputasi yang besar, yang dapat meningkatkan biaya operasional. Biaya ini dapat menjadi batasan bagi aplikasi yang perlu beroperasi dalam skala besar. Namun, salah satu manfaatnya AWS Cloud adalah fleksibilitas untuk hanya membayar untuk apa yang Anda gunakan. AWS menawarkan model penetapan harga bayar sesuai pemakaian yang sederhana, konsisten, sehingga Anda hanya dikenakan biaya untuk sumber daya yang Anda konsumsi.

Penggunaan Amazon SageMaker JumpStart

Untuk model bahasa berbasis transformator, organisasi dapat memperoleh manfaat dari penggunaan Amazon SageMaker JumpStart, yang menawarkan koleksi model pembelajaran mesin yang dibuat sebelumnya. Amazon SageMaker JumpStart menawarkan beragam model dasar pembuatan teks dan menjawab pertanyaan (Q&A) yang dapat dengan mudah diterapkan dan dimanfaatkan. Solusi ini mengintegrasikan model FLAN T5-XL Amazon SageMaker JumpStart, namun ada beberapa aspek berbeda yang perlu diingat saat memilih model pondasi.

Mengintegrasikan keamanan dalam alur kerja kami

Mengikuti praktik terbaik Pilar Keamanan Kerangka Kerja yang Terarsitektur dengan Baik, Amazon Kognito digunakan untuk otentikasi. Kolam Pengguna Amazon Cognito dapat diintegrasikan dengan penyedia identitas pihak ketiga yang mendukung beberapa kerangka kerja yang digunakan untuk kontrol akses, termasuk Open Authorization (OAuth), OpenID Connect (OIDC), atau Security Assertion Markup Language (SAML). Mengidentifikasi pengguna dan tindakan mereka memungkinkan solusi mempertahankan ketertelusuran. Solusinya juga menggunakan Amazon Memahami deteksi informasi pengenal pribadi (PII). fitur untuk secara otomatis mengidentifikasi dan menyunting PII. PII yang disunting mencakup alamat, nomor jaminan sosial, alamat email, dan informasi sensitif lainnya. Desain ini memastikan bahwa setiap PII yang diberikan oleh pengguna melalui kueri masukan akan disunting. PII tidak disimpan, digunakan oleh Amazon Kendra, atau dimasukkan ke LLM.

Panduan Solusi

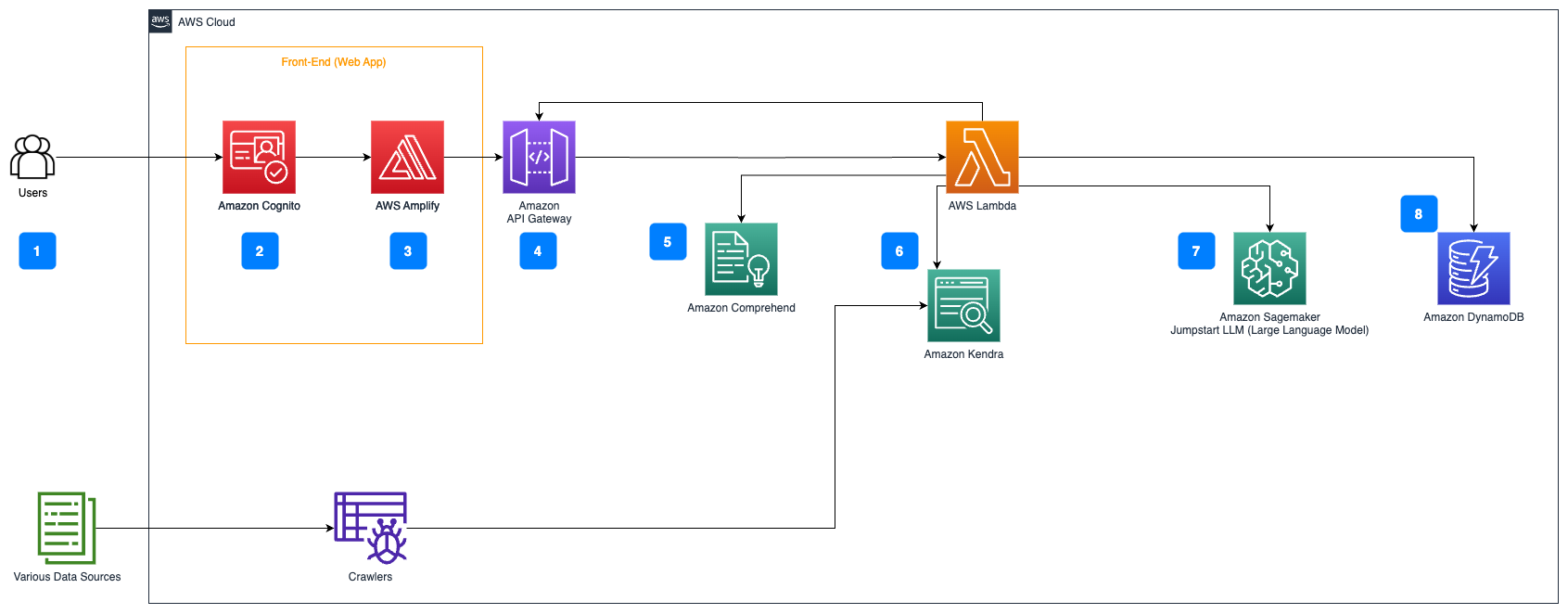

Langkah-langkah berikut menjelaskan alur kerja penjawab Pertanyaan atas aliran dokumen:

- Pengguna mengirim permintaan melalui antarmuka web.

- Amazon Kognito digunakan untuk otentikasi, memastikan akses aman ke aplikasi web.

- Front-end aplikasi web dihosting di Amplifikasi AWS.

- Gerbang API Amazon menghosting REST API dengan berbagai titik akhir untuk menangani permintaan pengguna yang diautentikasi menggunakan Amazon Cognito.

- Redaksi PII dengan Amazon Comprehend:

- Pemrosesan Kueri Pengguna: Saat pengguna mengirimkan kueri atau masukan, kueri atau masukan tersebut terlebih dahulu diteruskan melalui Amazon Comprehend. Layanan menganalisis teks dan mengidentifikasi entitas PII yang ada dalam kueri.

- Ekstraksi PII: Amazon Comprehend mengekstrak entitas PII yang terdeteksi dari kueri pengguna.

- Pengambilan Informasi Relevan dengan AmazonKendra:

- Amazon Kendra digunakan untuk mengelola indeks dokumen yang berisi informasi yang digunakan untuk menghasilkan jawaban atas pertanyaan pengguna.

- Grafik Pengambilan QA LangChain modul digunakan untuk membangun rantai percakapan yang memiliki informasi relevan tentang pertanyaan pengguna.

- Integrasi dengan Mulai Lompatan Amazon SageMaker:

- Fungsi AWS Lambda menggunakan perpustakaan LangChain dan terhubung ke titik akhir Amazon SageMaker JumpStart dengan kueri yang diisi konteks. Titik akhir Amazon SageMaker JumpStart berfungsi sebagai antarmuka LLM yang digunakan untuk inferensi.

- Menyimpan respons dan mengembalikannya ke pengguna:

- Respons dari LLM disimpan di Amazon DynamoDB bersama dengan kueri pengguna, stempel waktu, pengidentifikasi unik, dan pengidentifikasi arbitrer lainnya untuk item seperti kategori pertanyaan. Menyimpan pertanyaan dan jawaban sebagai item terpisah memungkinkan fungsi AWS Lambda dengan mudah membuat ulang riwayat percakapan pengguna berdasarkan waktu ketika pertanyaan diajukan.

- Terakhir, respons dikirim kembali ke pengguna melalui permintaan HTTP melalui respons integrasi Amazon API Gateway REST API.

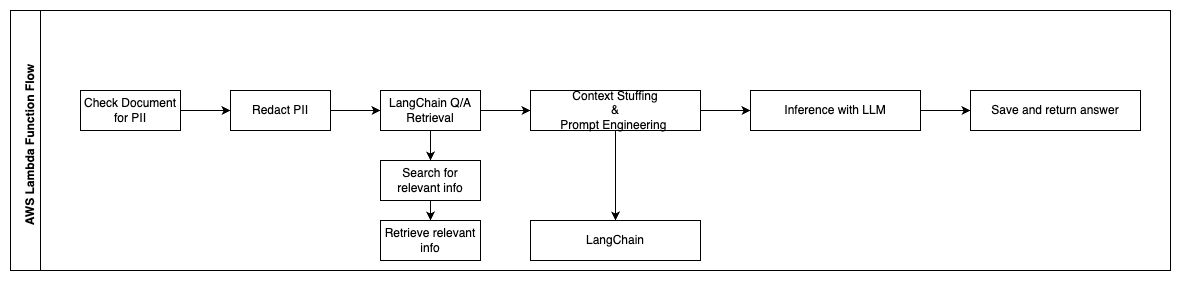

Langkah-langkah berikut menjelaskan fungsi AWS Lambda dan alurnya melalui proses:

- Periksa dan edit informasi PII/Sensitif apa pun

- Rantai Pengambilan QA LangChain

- Cari dan ambil informasi yang relevan

- Isian Konteks & Rekayasa Cepat

- Inferensi dengan LLM

- Kembalikan respons & Simpan

Gunakan kasus

Ada banyak kasus penggunaan bisnis di mana pelanggan dapat menggunakan alur kerja ini. Bagian berikut menjelaskan bagaimana alur kerja dapat digunakan di berbagai industri dan vertikal.

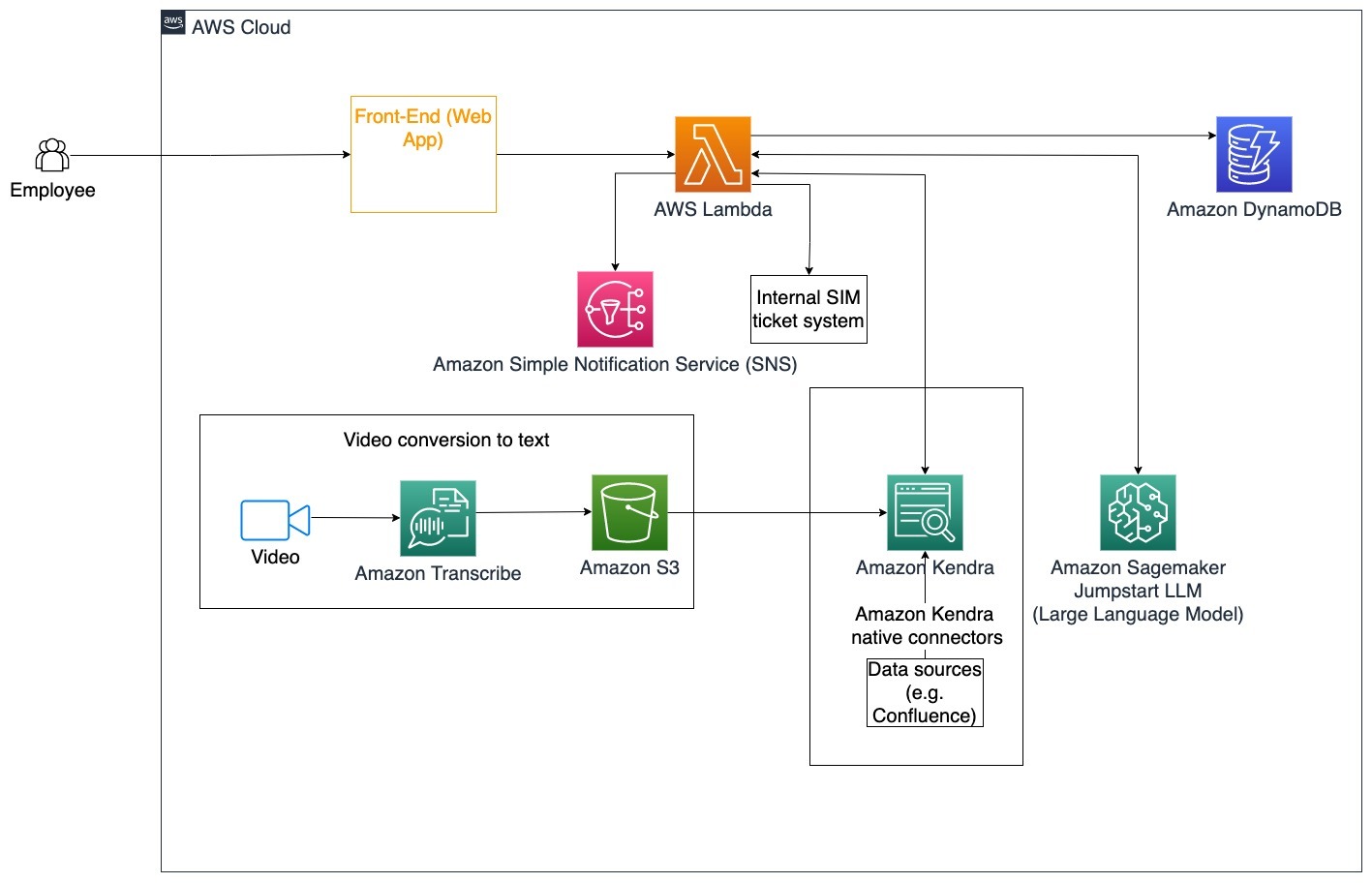

Bantuan Karyawan

Pelatihan perusahaan yang dirancang dengan baik dapat meningkatkan kepuasan karyawan dan mengurangi waktu yang dibutuhkan untuk menerima karyawan baru. Seiring pertumbuhan organisasi dan kompleksitas yang meningkat, karyawan mengalami kesulitan untuk memahami banyaknya sumber dokumen internal. Dokumen internal dalam konteks ini meliputi pedoman, kebijakan, dan Prosedur Operasi Standar perusahaan. Untuk skenario ini, seorang karyawan memiliki pertanyaan tentang cara melanjutkan dan mengedit tiket tiket masalah internal. Karyawan dapat mengakses dan menggunakan bot percakapan kecerdasan buatan generatif (AI) untuk menanyakan dan menjalankan langkah selanjutnya untuk tiket tertentu.

Kasus penggunaan khusus: Otomatiskan penyelesaian masalah untuk karyawan berdasarkan pedoman perusahaan.

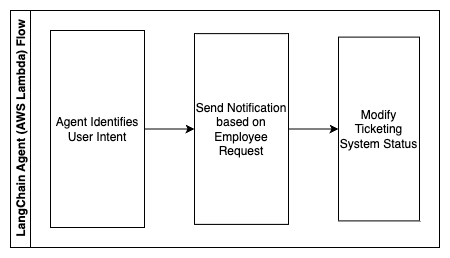

Langkah-langkah berikut menjelaskan fungsi AWS Lambda dan alurnya melalui proses:

- Agen LangChain untuk mengidentifikasi maksudnya

- Kirim pemberitahuan berdasarkan permintaan karyawan

- Ubah status tiket

Dalam diagram arsitektur ini, video pelatihan perusahaan dapat diserap Amazon Transkripsikan untuk mengumpulkan log skrip video ini. Selain itu, konten pelatihan perusahaan yang disimpan di berbagai sumber (yaitu Confluence, Microsoft SharePoint, Google Drive, Jira, dll.) dapat digunakan untuk membuat indeks melalui konektor Amazon Kendra. Baca artikel ini untuk mempelajari lebih lanjut tentang koleksi asli konektor Anda dapat memanfaatkan di Amazon Kendra sebagai titik sumber. Crawler Amazon Kendra kemudian dapat menggunakan skrip video pelatihan perusahaan dan dokumentasi yang disimpan di sumber lain ini untuk membantu bot percakapan dalam menjawab pertanyaan spesifik terhadap pedoman pelatihan perusahaan. Agen LangChain memverifikasi izin, mengubah status tiket, dan memberi tahu individu yang benar menggunakan Amazon Simple Notification Service (Amazon SNS).

Tim Dukungan Pelanggan

Menyelesaikan pertanyaan pelanggan dengan cepat akan meningkatkan pengalaman pelanggan dan mendorong loyalitas merek. Basis pelanggan setia membantu mendorong penjualan, yang berkontribusi terhadap laba dan meningkatkan keterlibatan pelanggan. Tim dukungan pelanggan menghabiskan banyak energi untuk merujuk pada banyak dokumen internal dan perangkat lunak manajemen hubungan pelanggan untuk menjawab pertanyaan pelanggan tentang produk dan layanan. Dokumen internal dalam konteks ini dapat mencakup skrip panggilan dukungan pelanggan umum, pedoman, pedoman eskalasi, dan informasi bisnis. Bot percakapan AI generatif membantu pengoptimalan biaya karena menangani pertanyaan atas nama tim dukungan pelanggan.

Kasus penggunaan khusus: Menangani permintaan penggantian oli berdasarkan riwayat layanan dan paket layanan pelanggan yang dibeli.

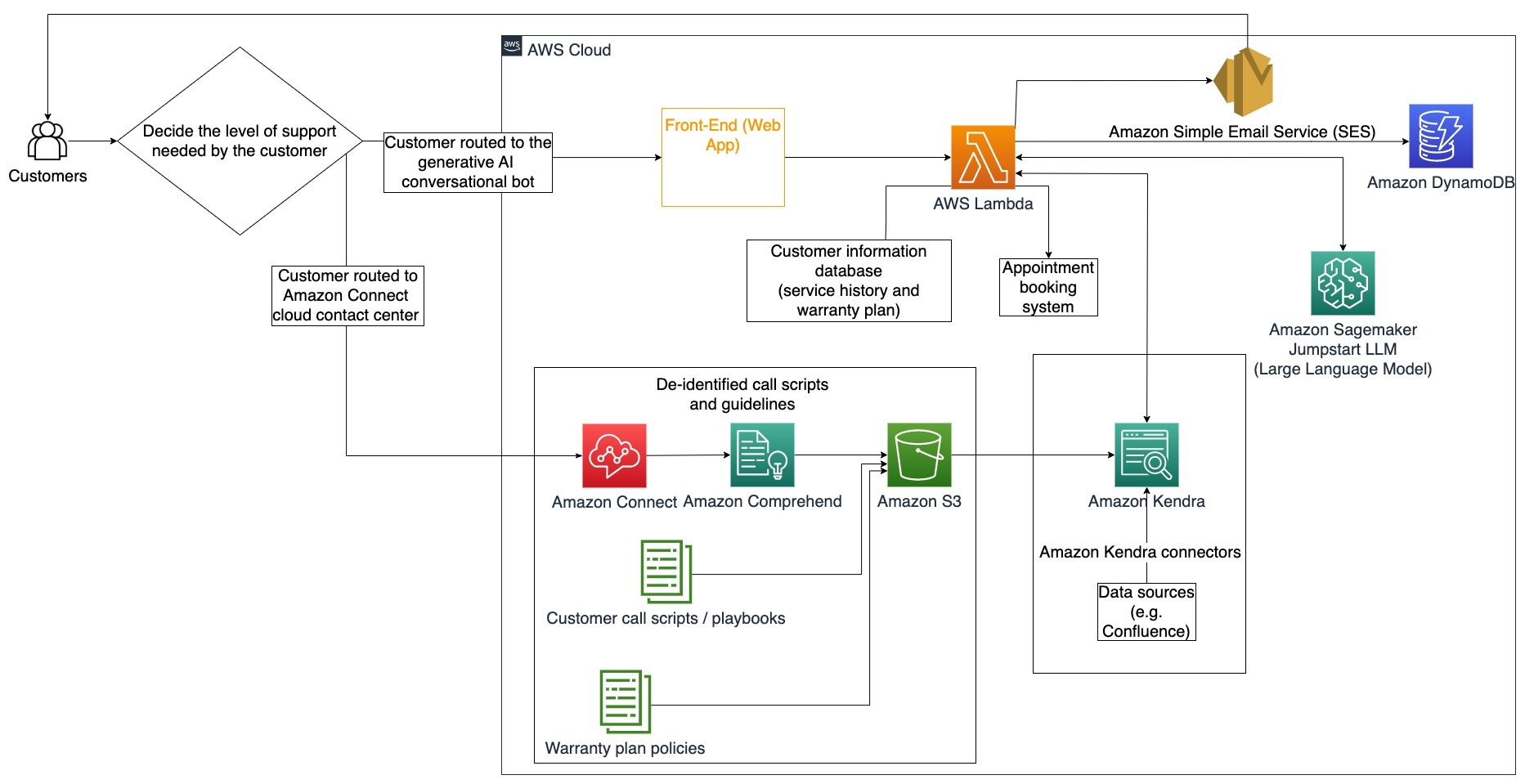

Dalam diagram arsitektur ini, pelanggan diarahkan ke bot percakapan AI generatif atau bot percakapan AI generatif Sambungan Amazon pusat kontak. Keputusan ini dapat didasarkan pada tingkat dukungan yang dibutuhkan atau ketersediaan agen dukungan pelanggan. Agen LangChain mengidentifikasi maksud pelanggan dan memverifikasi identitas. Agen LangChain juga memeriksa riwayat layanan dan paket dukungan yang dibeli.

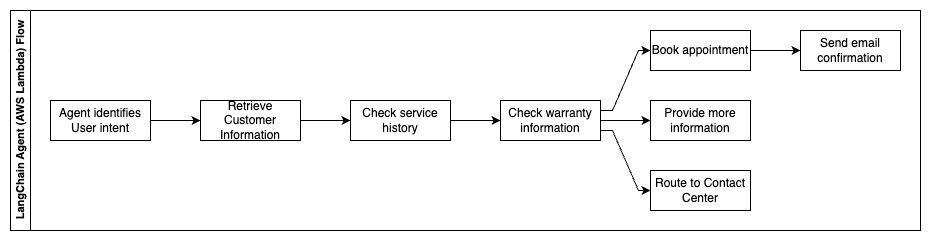

Langkah-langkah berikut menjelaskan fungsi AWS Lambda dan alurnya melalui proses:

- Agen LangChain mengidentifikasi maksudnya

- Ambil Informasi Pelanggan

- Periksa riwayat layanan pelanggan dan informasi garansi

- Buat janji temu, berikan informasi lebih lanjut, atau rute ke pusat kontak

- Kirim konfirmasi email

Amazon Connect digunakan untuk mengumpulkan log suara dan obrolan, dan Amazon Comprehend digunakan untuk menghapus informasi identitas pribadi (PII) dari log ini. Crawler Amazon Kendra kemudian dapat menggunakan log suara dan obrolan yang telah disunting, skrip panggilan pelanggan, dan kebijakan paket dukungan layanan pelanggan untuk membuat indeks. Setelah keputusan dibuat, bot percakapan AI generatif memutuskan apakah akan membuat janji temu, memberikan informasi lebih lanjut, atau mengarahkan pelanggan ke pusat kontak untuk bantuan lebih lanjut. Untuk optimalisasi biaya, agen LangChain juga dapat menghasilkan jawaban menggunakan token yang lebih sedikit dan model bahasa besar yang lebih murah untuk pertanyaan pelanggan dengan prioritas lebih rendah.

Jasa Keuangan

Perusahaan jasa keuangan mengandalkan penggunaan informasi yang tepat waktu agar tetap kompetitif dan mematuhi peraturan keuangan. Dengan menggunakan bot percakapan AI generatif, analis dan penasihat keuangan dapat berinteraksi dengan informasi tekstual dengan cara percakapan dan mengurangi waktu dan upaya yang diperlukan untuk membuat keputusan yang lebih tepat. Di luar investasi dan riset pasar, bot percakapan AI generatif juga dapat meningkatkan kemampuan manusia dengan menangani tugas-tugas yang biasanya membutuhkan lebih banyak tenaga dan waktu manusia. Misalnya, lembaga keuangan yang mengkhususkan diri pada pinjaman pribadi dapat meningkatkan kecepatan pemrosesan pinjaman sekaligus memberikan transparansi yang lebih baik kepada pelanggan.

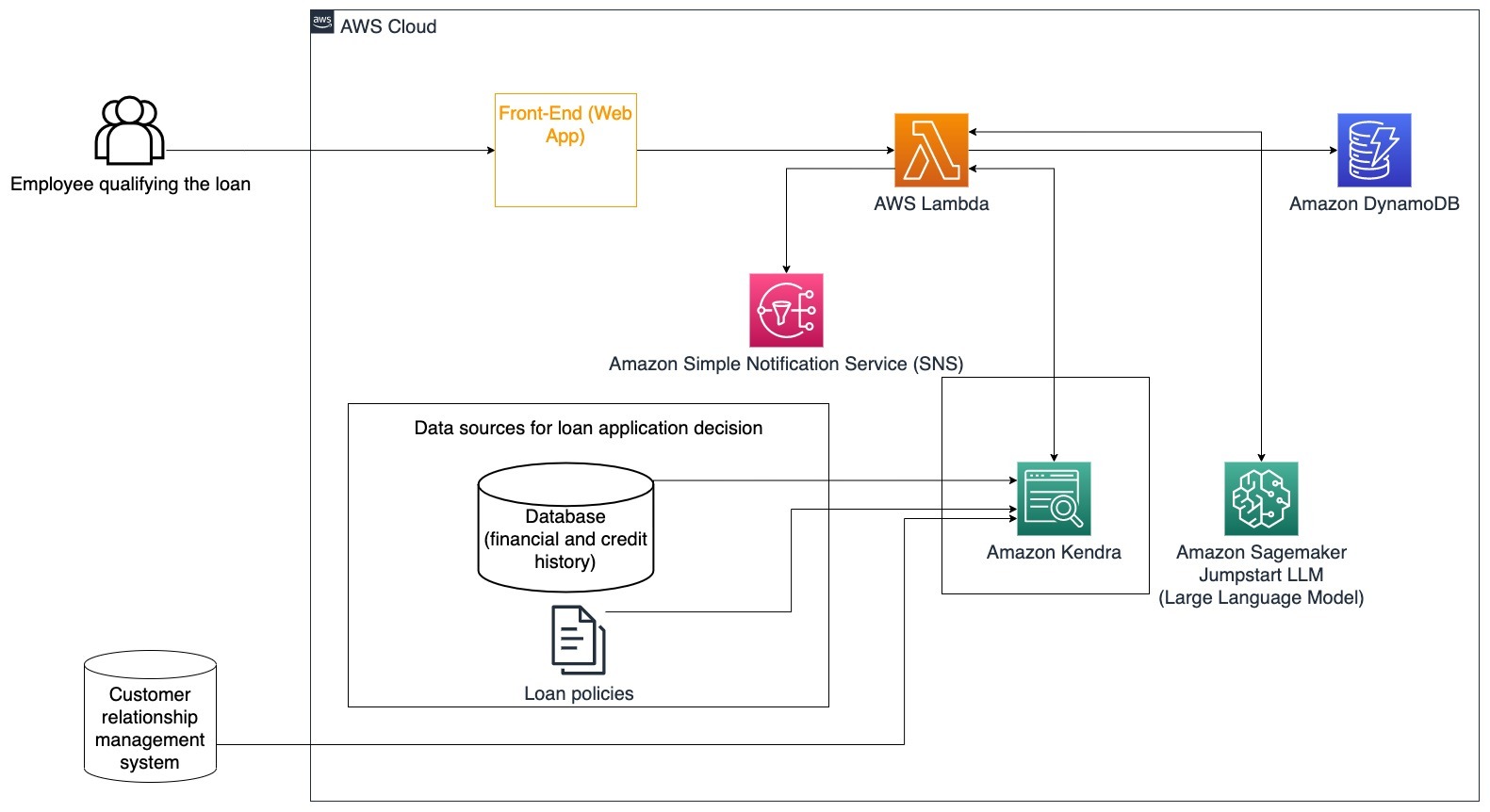

Kasus penggunaan khusus: Gunakan riwayat keuangan pelanggan dan permohonan pinjaman sebelumnya untuk memutuskan dan menjelaskan keputusan pinjaman.

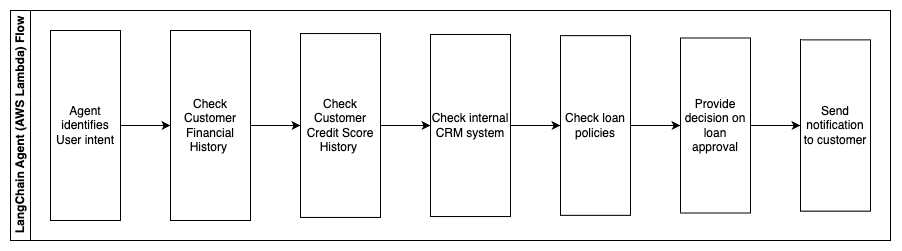

Langkah-langkah berikut menjelaskan fungsi AWS Lambda dan alurnya melalui proses:

- Agen LangChain untuk mengidentifikasi maksudnya

- Periksa riwayat keuangan dan skor kredit pelanggan

- Periksa sistem manajemen hubungan pelanggan internal

- Periksa kebijakan pinjaman standar dan sarankan keputusan bagi karyawan yang memenuhi syarat pinjaman

- Kirim pemberitahuan ke pelanggan

Arsitektur ini menggabungkan data keuangan pelanggan yang disimpan dalam database dan data yang disimpan dalam alat manajemen hubungan pelanggan (CRM). Poin data ini digunakan untuk menginformasikan keputusan berdasarkan kebijakan pinjaman internal perusahaan. Pelanggan dapat mengajukan pertanyaan klarifikasi untuk memahami pinjaman apa yang memenuhi syarat dan persyaratan pinjaman yang dapat mereka terima. Jika bot percakapan AI generatif tidak dapat menyetujui permohonan pinjaman, pengguna masih dapat mengajukan pertanyaan tentang peningkatan skor kredit atau opsi pembiayaan alternatif.

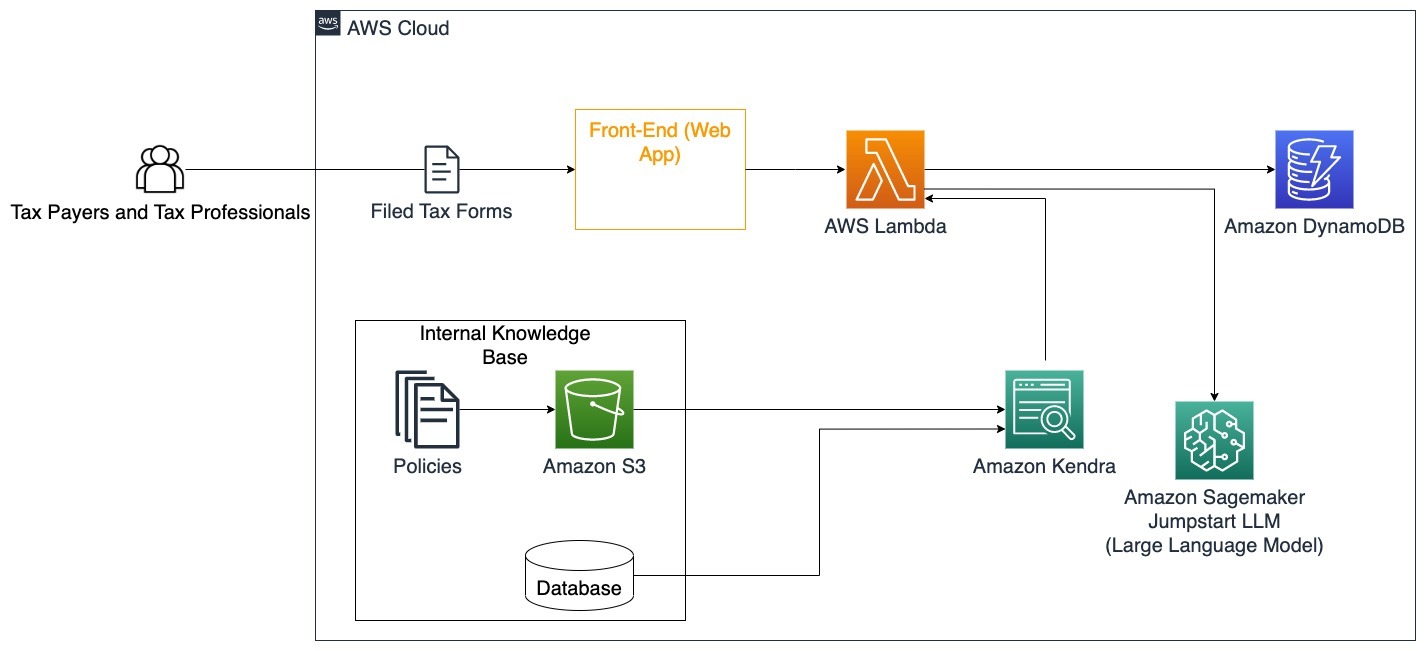

Pemerintah

Bot percakapan AI generatif dapat memberikan manfaat besar bagi institusi pemerintah dengan mempercepat proses komunikasi, efisiensi, dan pengambilan keputusan. Bot percakapan AI generatif juga dapat memberikan akses cepat ke basis pengetahuan internal untuk membantu pegawai pemerintah mengambil informasi, kebijakan, dan prosedur dengan cepat (yaitu, kriteria kelayakan, proses pengajuan, serta layanan dan dukungan masyarakat). Salah satu solusinya adalah sistem interaktif, yang memungkinkan pembayar pajak dan profesional pajak dengan mudah menemukan rincian dan manfaat terkait pajak. Ini dapat digunakan untuk memahami pertanyaan pengguna, merangkum dokumen pajak, dan memberikan jawaban yang jelas melalui percakapan interaktif.

Pengguna dapat mengajukan pertanyaan seperti:

- Bagaimana cara kerja pajak warisan dan berapa ambang batas pajaknya?

- Bisakah Anda menjelaskan konsep pajak penghasilan?

- Apa implikasi pajak saat menjual properti kedua?

Selain itu, pengguna dapat memperoleh kemudahan dalam mengirimkan formulir pajak ke sistem, yang dapat membantu memverifikasi kebenaran informasi yang diberikan.

Arsitektur ini menggambarkan bagaimana pengguna dapat mengunggah formulir pajak yang sudah lengkap ke solusi dan menggunakannya untuk verifikasi interaktif dan panduan tentang cara melengkapi informasi yang diperlukan secara akurat.

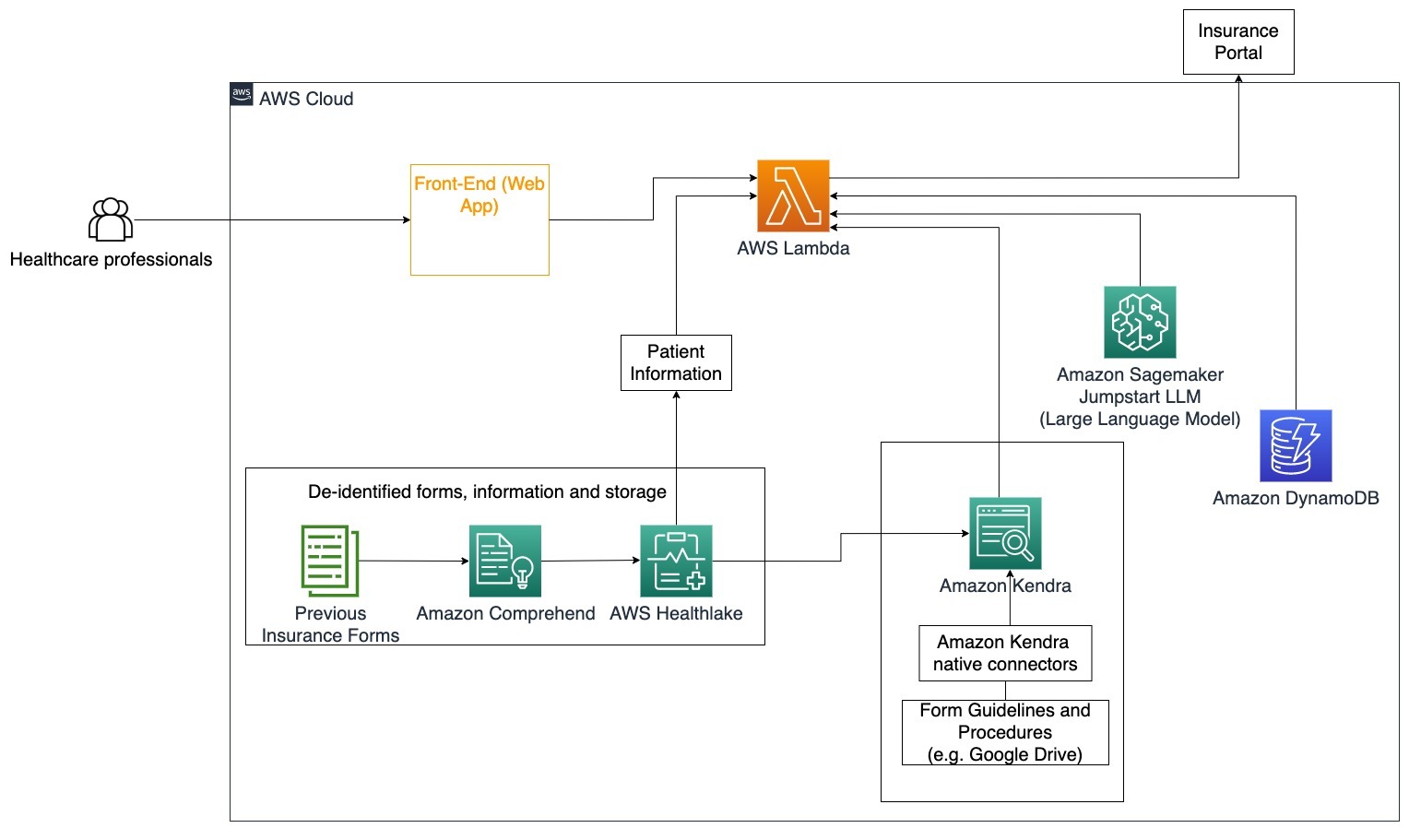

Kesehatan

Bisnis layanan kesehatan memiliki peluang untuk mengotomatiskan penggunaan sejumlah besar informasi internal pasien, sekaligus menjawab pertanyaan umum mengenai kasus penggunaan seperti pilihan pengobatan, klaim asuransi, uji klinis, dan penelitian farmasi. Penggunaan bot percakapan AI generatif memungkinkan pembuatan jawaban yang cepat dan akurat tentang informasi kesehatan dari basis pengetahuan yang disediakan. Misalnya, beberapa profesional kesehatan menghabiskan banyak waktu mengisi formulir untuk mengajukan klaim asuransi.

Dalam situasi serupa, administrator uji klinis dan peneliti perlu mencari informasi tentang pilihan pengobatan. Bot percakapan AI generatif dapat menggunakan konektor bawaan di Amazon Kendra untuk mengambil informasi paling relevan dari jutaan dokumen yang diterbitkan melalui penelitian berkelanjutan yang dilakukan oleh perusahaan farmasi dan universitas.

Kasus penggunaan khusus: Mengurangi kesalahan dan waktu yang diperlukan untuk mengisi dan mengirimkan formulir asuransi.

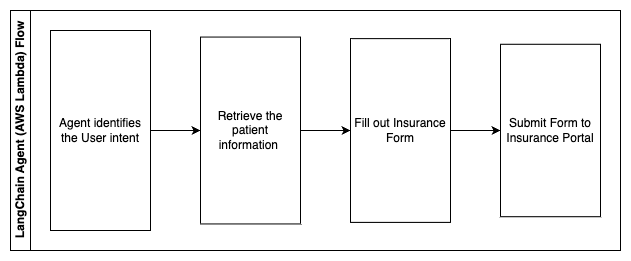

Dalam diagram arsitektur ini, seorang profesional kesehatan dapat menggunakan bot percakapan AI generatif untuk mengetahui formulir apa yang perlu diisi untuk asuransi. Agen LangChain kemudian dapat mengambil formulir yang tepat dan menambahkan informasi yang dibutuhkan pasien serta memberikan tanggapan untuk bagian deskriptif formulir berdasarkan polis asuransi dan formulir sebelumnya. Profesional kesehatan dapat mengedit tanggapan yang diberikan oleh LLM sebelum menyetujui dan mengirimkan formulir ke portal asuransi.

Langkah-langkah berikut menjelaskan fungsi AWS Lambda dan alurnya melalui proses:

- Agen LangChain untuk mengidentifikasi maksudnya

- Ambil informasi pasien yang diperlukan

- Isi formulir asuransi berdasarkan informasi pasien dan pedoman formulir

- Kirimkan formulir ke portal asuransi setelah persetujuan pengguna

AWS HealthLake digunakan untuk menyimpan data kesehatan dengan aman termasuk formulir asuransi sebelumnya dan informasi pasien, dan Amazon Comprehend digunakan untuk menghapus informasi identitas pribadi (PII) dari formulir asuransi sebelumnya. Crawler Amazon Kendra kemudian dapat menggunakan kumpulan formulir dan pedoman asuransi untuk membuat indeks. Setelah formulir diisi oleh AI generatif, formulir yang ditinjau oleh profesional medis dapat dikirim ke portal asuransi.

Estimasi biaya

Biaya penerapan solusi dasar sebagai pembuktian konsep ditunjukkan pada tabel berikut. Karena solusi dasar dianggap sebagai bukti konsep, Amazon Kendra Developer Edition digunakan sebagai opsi berbiaya rendah karena beban kerja tidak akan diproduksi. Asumsi kami untuk Amazon Kendra Developer Edition adalah 730 jam aktif dalam sebulan.

Untuk Amazon SageMaker, kami membuat asumsi bahwa pelanggan akan menggunakan instans ml.g4dn.2xlarge untuk inferensi real-time, dengan satu titik akhir inferensi per instans. Anda dapat menemukan informasi selengkapnya tentang harga Amazon SageMaker dan jenis instans inferensi yang tersedia di sini.

| Pelayanan | Sumber Daya yang Dikonsumsi | Estimasi Biaya Per Bulan dalam USD |

| Amplifikasi AWS | 150 menit pembuatan 1 GB Data disajikan 500,000 permintaan |

15.71 |

| Gerbang API Amazon | 1 Juta Panggilan REST API | 3.5 |

| AWS Lambda | 1 Juta permintaan Durasi 5 detik per permintaan Memori 2 GB dialokasikan |

160.23 |

| Amazon DynamoDB | 1 juta dibaca 1 juta menulis Penyimpanan 100 GB |

26.38 |

| Pembuat Sage Amazon | Inferensi waktu nyata dengan ml.g4dn.2xlarge | 676.8 |

| AmazonKendra | Edisi Pengembang dengan 730 jam/bulan 10,000 Dokumen dipindai 5,000 kueri/hari |

821.25 |

| . | . | Total Biaya: 1703.87 |

* Amazon Cognito memiliki tingkat gratis 50,000 Pengguna Aktif Bulanan yang menggunakan Kolam Pengguna Cognito atau 50 Pengguna Aktif Bulanan yang menggunakan penyedia identitas SAML 2.0

Membersihkan

Untuk menghemat biaya, hapus semua sumber daya yang Anda sebarkan sebagai bagian dari tutorial. Anda dapat menghapus titik akhir SageMaker apa pun yang mungkin Anda buat melalui konsol SageMaker. Ingat, menghapus indeks Amazon Kendra tidak menghapus dokumen asli dari penyimpanan Anda.

Kesimpulan

Dalam postingan ini, kami menunjukkan kepada Anda cara menyederhanakan akses ke informasi internal dengan meringkas dari beberapa repositori secara real-time. Setelah perkembangan LLM yang tersedia secara komersial baru-baru ini, kemungkinan AI generatif menjadi lebih jelas. Dalam postingan ini, kami menunjukkan cara menggunakan layanan AWS untuk membuat chatbot tanpa server yang menggunakan AI generatif untuk menjawab pertanyaan. Pendekatan ini menggabungkan lapisan autentikasi dan deteksi PII Amazon Comprehend untuk menyaring informasi sensitif apa pun yang diberikan dalam kueri pengguna. Baik individu di bidang layanan kesehatan yang memahami perbedaan dalam mengajukan klaim asuransi atau SDM yang memahami peraturan spesifik perusahaan, ada banyak industri dan vertikal yang dapat mengambil manfaat dari pendekatan ini. Model fondasi Amazon SageMaker JumpStart adalah mesin di belakang chatbot, sementara pendekatan penjejalan konteks menggunakan teknik RAG digunakan untuk memastikan bahwa respons merujuk pada dokumen internal dengan lebih akurat.

Untuk mempelajari lebih lanjut tentang bekerja dengan AI generatif di AWS, lihat Mengumumkan Alat Baru untuk Membangun dengan AI Generatif di AWS. Untuk panduan lebih mendalam tentang penggunaan teknik RAG dengan layanan AWS, lihat Dengan cepat membuat aplikasi Generatif AI dengan akurasi tinggi pada data perusahaan menggunakan Amazon Kendra, LangChain, dan model bahasa besar. Karena pendekatan dalam blog ini adalah LLM agnostik, LLM apa pun dapat digunakan untuk inferensi. Dalam postingan berikutnya, kami akan menjelaskan cara mengimplementasikan solusi ini menggunakan Amazon Bedrock dan Amazon Titan LLM.

Tentang Penulis

Abhishek Maligehalli Shivalingaiah adalah Arsitek Solusi Layanan AI Senior di AWS. Dia bersemangat membangun aplikasi menggunakan AI Generatif, Amazon Kendra, dan NLP. Beliau memiliki pengalaman sekitar 10 tahun dalam membangun solusi Data & AI untuk menciptakan nilai bagi pelanggan dan perusahaan. Dia bahkan telah membangun chatbot (pribadi) untuk bersenang-senang menjawab pertanyaan tentang karier dan perjalanan profesionalnya. Di luar pekerjaan, dia senang membuat potret keluarga & teman, serta suka membuat karya seni.

Abhishek Maligehalli Shivalingaiah adalah Arsitek Solusi Layanan AI Senior di AWS. Dia bersemangat membangun aplikasi menggunakan AI Generatif, Amazon Kendra, dan NLP. Beliau memiliki pengalaman sekitar 10 tahun dalam membangun solusi Data & AI untuk menciptakan nilai bagi pelanggan dan perusahaan. Dia bahkan telah membangun chatbot (pribadi) untuk bersenang-senang menjawab pertanyaan tentang karier dan perjalanan profesionalnya. Di luar pekerjaan, dia senang membuat potret keluarga & teman, serta suka membuat karya seni.

Madha Aiyah adalah Associate Solutions Architect di AWS, yang berbasis di Austin, Texas. Dia baru saja lulus dari University of Texas di Dallas pada bulan Desember 2022 dengan gelar Master of Science di bidang Ilmu Komputer dengan spesialisasi Sistem Cerdas yang berfokus pada AI/ML. Dia tertarik untuk mempelajari lebih lanjut tentang AI/ML dan memanfaatkan layanan AWS untuk menemukan solusi yang dapat dimanfaatkan oleh pelanggan.

Madha Aiyah adalah Associate Solutions Architect di AWS, yang berbasis di Austin, Texas. Dia baru saja lulus dari University of Texas di Dallas pada bulan Desember 2022 dengan gelar Master of Science di bidang Ilmu Komputer dengan spesialisasi Sistem Cerdas yang berfokus pada AI/ML. Dia tertarik untuk mempelajari lebih lanjut tentang AI/ML dan memanfaatkan layanan AWS untuk menemukan solusi yang dapat dimanfaatkan oleh pelanggan.

Hugo Tse adalah Associate Solutions Architect di AWS yang berbasis di Seattle, Washington. Beliau meraih gelar Master di bidang Teknologi Informasi dari Arizona State University dan gelar sarjana Ekonomi dari University of Chicago. Beliau adalah anggota Asosiasi Audit dan Pengendalian Sistem Informasi (ISACA) dan Konsorsium Sertifikasi Keamanan Sistem Informasi Internasional (ISC)2. Dia senang membantu pelanggan mendapatkan manfaat dari teknologi.

Hugo Tse adalah Associate Solutions Architect di AWS yang berbasis di Seattle, Washington. Beliau meraih gelar Master di bidang Teknologi Informasi dari Arizona State University dan gelar sarjana Ekonomi dari University of Chicago. Beliau adalah anggota Asosiasi Audit dan Pengendalian Sistem Informasi (ISACA) dan Konsorsium Sertifikasi Keamanan Sistem Informasi Internasional (ISC)2. Dia senang membantu pelanggan mendapatkan manfaat dari teknologi.

Ayman Ishimwe adalah Associate Solutions Architect di AWS yang berbasis di Seattle, Washington. Beliau meraih gelar Master di bidang Rekayasa Perangkat Lunak dan IT dari Oakland University. Dia memiliki pengalaman sebelumnya dalam pengembangan perangkat lunak, khususnya dalam membangun layanan mikro untuk aplikasi web terdistribusi. Dia bersemangat membantu pelanggan membangun solusi yang kuat dan terukur pada layanan cloud AWS dengan mengikuti praktik terbaik.

Ayman Ishimwe adalah Associate Solutions Architect di AWS yang berbasis di Seattle, Washington. Beliau meraih gelar Master di bidang Rekayasa Perangkat Lunak dan IT dari Oakland University. Dia memiliki pengalaman sebelumnya dalam pengembangan perangkat lunak, khususnya dalam membangun layanan mikro untuk aplikasi web terdistribusi. Dia bersemangat membantu pelanggan membangun solusi yang kuat dan terukur pada layanan cloud AWS dengan mengikuti praktik terbaik.

Shervin Suresh adalah Associate Solutions Architect di AWS yang berbasis di Austin, Texas. Beliau telah lulus dengan gelar Magister Rekayasa Perangkat Lunak dengan Konsentrasi Cloud Computing dan Virtualisasi dan Sarjana Teknik Komputer dari San Jose State University. Dia bersemangat memanfaatkan teknologi untuk membantu meningkatkan kehidupan orang-orang dari semua latar belakang.

Shervin Suresh adalah Associate Solutions Architect di AWS yang berbasis di Austin, Texas. Beliau telah lulus dengan gelar Magister Rekayasa Perangkat Lunak dengan Konsentrasi Cloud Computing dan Virtualisasi dan Sarjana Teknik Komputer dari San Jose State University. Dia bersemangat memanfaatkan teknologi untuk membantu meningkatkan kehidupan orang-orang dari semua latar belakang.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- ChartPrime. Tingkatkan Game Trading Anda dengan ChartPrime. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Sanggup

- Tentang Kami

- Setuju

- mengakses

- mengakses

- Akun

- tepat

- akurat

- tindakan

- aktif

- menambahkan

- Selain itu

- alamat

- menangani

- administrator

- Mengadopsi

- penasehat

- Setelah

- Agen

- agen

- agregat

- AI

- Layanan AI

- AI / ML

- Semua

- memungkinkan

- sepanjang

- juga

- alternatif

- Amazon

- Gerbang API Amazon

- Amazon Kognito

- Amazon Comprehend

- AmazonKendra

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Amazon Web Services

- jumlah

- jumlah

- an

- Analis

- analisis

- dan

- menjawab

- jawaban

- Apa pun

- api

- semu

- Aplikasi

- aplikasi

- penunjukan

- pendekatan

- menyetujui

- arsitektur

- ADALAH

- timbul

- arizona

- sekitar

- artikel

- buatan

- kecerdasan buatan

- Kecerdasan buatan (AI)

- karya seni

- AS

- meminta

- aspek

- menilai

- membantu

- Bantuan

- Menghubungkan

- terkait

- Asosiasi

- anggapan

- At

- Audit

- ditambah

- austin

- dikonfirmasi

- Otentikasi

- otorisasi

- mengotomatisasikan

- secara otomatis

- tersedianya

- tersedia

- AWS

- AWS Lambda

- kembali

- latar belakang

- mendasarkan

- berdasarkan

- BE

- Beruang

- karena

- menjadi

- menjadi

- menjadi

- sebelum

- nama

- di belakang

- manfaat

- Manfaat

- TERBAIK

- Praktik Terbaik

- Lebih baik

- Blog

- Book

- Bot

- kedua

- bot

- Bawah

- merek

- anggaran belanja

- membangun

- Bangunan

- dibangun di

- bisnis

- bisnis

- tapi

- by

- panggilan

- CAN

- kemampuan

- Lowongan Kerja

- hati-hati

- kasus

- kasus

- Kategori

- disebabkan

- pusat

- terpusat

- tertentu

- Sertifikasi

- rantai

- tantangan

- perubahan

- dibebankan

- ChatBot

- memeriksa

- Cek

- Chicago

- klaim

- jelas

- Klinis

- uji klinis

- awan

- komputasi awan

- layanan cloud

- mengumpulkan

- koleksi

- secara komersial

- Umum

- Komunikasi

- Perusahaan

- perusahaan

- Perusahaan

- kompetitif

- Lengkap

- menyelesaikan

- kompleks

- kompleksitas

- memenuhi

- memahami

- komputer

- Teknik Komputer

- Komputer Ilmu

- komputasi

- konsentrasi

- konsep

- ringkas

- dilakukan

- pertemuan

- Terhubung

- menghubungkan

- pertimbangan

- pertimbangan

- dianggap

- konsisten

- Terdiri dari

- konsul

- konsorsium

- memakan

- konsumsi

- kontak

- contact center

- mengandung

- Konten

- konteks

- terus menerus

- berkontribusi

- kontrol

- mengendalikan

- kenyamanan

- Percakapan

- percakapan

- percakapan

- Timeline

- benar

- Biaya

- Biaya

- crawler

- membuat

- Ciptakan Nilai

- dibuat

- membuat

- kredit

- kriteria

- kritis

- CRM

- sangat penting

- dikuratori

- terbaru

- Sekarang

- pelanggan

- Keterlibatan pelanggan

- pengalaman pelanggan

- Layanan Pelanggan

- Customer Support

- pelanggan

- harian

- Dallas

- data

- titik data

- set data

- Basis Data

- Tanggal

- Desember

- memutuskan

- keputusan

- Pengambilan Keputusan

- keputusan

- Derajat

- disampaikan

- Tergantung

- dikerahkan

- penggelaran

- menggambarkan

- Mendesain

- Meskipun

- rincian

- terdeteksi

- Deteksi

- Pengembang

- Pengembangan

- Perkembangan

- berbeda

- sulit

- menemukan

- didistribusikan

- dokumentasi

- dokumen

- tidak

- Tidak

- mendorong

- lamanya

- e

- mudah

- mudah

- Ekonomi

- ekosistem

- edisi

- efisiensi

- usaha

- antara

- kelayakan

- Karyawan

- karyawan

- memungkinkan

- mendorong

- Titik akhir

- energi

- interaksi

- Mesin

- Teknik

- memperkaya

- memastikan

- Memastikan

- memastikan

- Enterprise

- perusahaan

- entitas

- kesalahan

- eskalasi

- memperkirakan

- dll

- Bahkan

- contoh

- menjalankan

- ada

- mahal

- pengalaman

- Menjelaskan

- Menjelaskan

- ekstraksi

- Ekstrak

- Menghadapi

- keluarga

- Fitur

- Fed

- sedikit

- Angka

- File

- mengisi

- terisi

- pengisian

- menyaring

- keuangan

- data keuangan

- sejarah keuangan

- lembaga keuangan

- pembiayaan

- Menemukan

- temuan

- Pertama

- keluwesan

- aliran

- berfokus

- berikut

- Untuk

- bentuk

- bentuk

- forum

- ditemukan

- Prinsip Dasar

- kerangka

- Gratis

- teman

- dari

- kesenangan

- fungsi

- fungsi

- lebih lanjut

- Mendapatkan

- pintu gerbang

- menghasilkan

- generasi

- generatif

- AI generatif

- mendapatkan

- diberikan

- memberikan

- Pemberian

- Pemerintah

- sangat

- Tumbuh

- Pertumbuhan

- tumbuh

- bimbingan

- pedoman

- menangani

- Menangani

- Penanganan

- Memiliki

- memiliki

- he

- Kesehatan

- Informasi kesehatan

- kesehatan

- membantu

- membantu

- membantu

- dia

- High

- sangat

- -nya

- sejarah

- memegang

- host

- host

- JAM

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- hr

- HTML

- HTTPS

- manusia

- i

- identifier

- pengidentifikasi

- mengidentifikasi

- mengenali

- mengidentifikasi

- identitas

- if

- menggambarkan

- melaksanakan

- mengimplementasikan

- implikasi

- memperbaiki

- meningkatkan

- meningkatkan

- in

- secara mendalam

- tidak akurat

- memasukkan

- termasuk

- Termasuk

- Pendapatan

- pajak penghasilan

- Meningkatkan

- Meningkatkan

- indeks

- diindeks

- indeks

- individu

- industri

- memberitahu

- informasi

- Sistem Informasi

- teknologi informasi

- informasi

- warisan

- memasukkan

- contoh

- saat

- sebagai gantinya

- Lembaga

- lembaga

- asuransi

- terpadu

- Terintegrasi

- integrasi

- Intelijen

- Cerdas

- maksud

- berinteraksi

- interaktif

- tertarik

- Antarmuka

- intern

- Internasional

- ke

- investasi

- isu

- IT

- item

- perjalanan

- jpg

- Menjaga

- pengetahuan

- dikenal

- bahasa

- besar

- lapisan

- memimpin

- BELAJAR

- pengetahuan

- kurang

- Tingkat

- leveraging

- Perpustakaan

- pembatasan

- keterbatasan

- baris

- hidup

- LLM

- pinjaman

- Pinjaman

- mencatat

- logis

- Panjang

- lama

- lagi

- melihat

- Lot

- mencintai

- murah

- menurunkan

- setia

- Loyalitas

- mesin

- Mesin belajar

- terbuat

- memelihara

- membuat

- MEMBUAT

- Membuat

- mengelola

- pengelolaan

- cara

- panduan

- manual

- banyak

- Pasar

- riset pasar

- tuan

- Mungkin..

- cara

- medis

- anggota

- Memori

- microservices

- Microsoft

- juta

- jutaan

- keberatan

- ML

- model

- model

- Modul

- Bulan

- bulanan

- lebih

- paling

- beberapa

- asli

- perlu

- Perlu

- dibutuhkan

- kebutuhan

- New

- berikutnya

- nLP

- pemberitahuan

- nomor

- Oakland

- sumpah

- of

- Penawaran

- sering

- Minyak

- on

- Onboarding

- sekali

- ONE

- terus-menerus

- hanya

- Buka

- beroperasi

- operasi

- operasional

- Kesempatan

- optimasi

- pilihan

- Opsi

- or

- urutan

- organisasi

- asli

- Lainnya

- kami

- di luar

- garis besar

- di luar

- lebih

- pola pikir

- bagian

- bagian

- Lulus

- bergairah

- pasien

- Membayar

- Konsultan Ahli

- untuk

- prestasi

- Izin

- pribadi

- data pribadi

- Sendiri

- farmasi

- Pilar

- rencana

- plato

- Kecerdasan Data Plato

- Data Plato

- silahkan

- Titik

- poin

- Kebijakan

- Kolam renang

- Portal

- potret

- kemungkinan

- kemungkinan

- Pos

- didukung

- praktek

- menyajikan

- mencegah

- sebelumnya

- sebelumnya

- di harga

- model penetapan harga

- Sebelumnya

- prioritas

- pribadi

- masalah

- Prosedur

- memproses

- proses

- Diproses

- proses

- pengolahan

- Produksi

- produktifitas

- Produk

- profesional

- profesional

- milik

- memberikan

- disediakan

- penyedia

- menyediakan

- diterbitkan

- dibeli

- Q & A

- memenuhi syarat

- memenuhi syarat

- query

- pertanyaan

- Pertanyaan

- Cepat

- segera

- jarak

- Penilaian

- Baca

- Bacaan

- real-time

- baru

- baru-baru ini

- menurunkan

- mengurangi

- lihat

- referensi

- mengenai

- secara teratur

- peraturan

- hubungan

- relevansi

- relevan

- mengandalkan

- sisa

- ingat

- menghapus

- permintaan

- permintaan

- membutuhkan

- wajib

- Persyaratan

- penelitian

- peneliti

- Resolusi

- menyelesaikan

- Sumber

- tanggapan

- tanggapan

- tanggung jawab

- ISTIRAHAT

- mengakibatkan

- kembali

- review jurnal

- benar

- risiko

- kuat

- Rute

- berjalan

- s

- pembuat bijak

- penjualan

- San

- San Jose

- kepuasan

- Save

- terukur

- Skala

- skenario

- Ilmu

- skor

- script

- Pencarian

- mencari

- Seattle

- Kedua

- detik

- Bagian

- aman

- aman

- keamanan

- Penjualan

- mengirim

- senior

- peka

- mengirim

- Tanpa Server

- melayani

- layanan

- Layanan

- set

- set

- pengaturan

- beberapa

- dia

- bergeser

- kekurangan

- harus

- dipamerkan

- menunjukkan

- ditunjukkan

- silo

- mirip

- Sederhana

- menyederhanakan

- sejak

- tunggal

- berukuran

- lebih kecil

- So

- Sosial

- Perangkat lunak

- pengembangan perangkat lunak

- rekayasa Perangkat Lunak

- larutan

- Solusi

- beberapa

- sumber

- sumber

- mengkhususkan diri

- tertentu

- Secara khusus

- menghabiskan

- Pengeluaran

- standar

- Negara

- Status

- tinggal

- Langkah

- Tangga

- Masih

- penyimpanan

- menyimpan

- tersimpan

- menyimpan

- tekanan

- isian

- besar

- seperti itu

- menyarankan

- meringkaskan

- mendukung

- sistem

- sistem

- tabel

- Dibutuhkan

- tugas

- pajak

- tim

- tim

- Teknologi

- istilah

- texas

- teks

- tekstual

- bahwa

- Grafik

- informasi

- mereka

- diri

- kemudian

- Sana.

- Ini

- mereka

- pihak ketiga

- ini

- Melalui

- tiket

- tiket

- tingkat

- waktu

- membuang-buang waktu

- tepat waktu

- kali

- timestamp

- titan

- untuk

- hari ini

- Token

- alat

- alat

- Lacak

- secara tradisional

- terlatih

- Pelatihan

- transformator

- Transparansi

- pengobatan

- percobaan

- uji

- tutorial

- jenis

- tidak mampu

- memahami

- pemahaman

- unik

- Universitas

- universitas

- University of Chicago

- mutakhir

- diperbarui

- memperbarui

- menggunakan

- gunakan case

- bekas

- Pengguna

- Pengguna

- kegunaan

- menggunakan

- Penggunaan

- dimanfaatkan

- Memanfaatkan

- nilai

- berbagai

- Verifikasi

- memeriksa

- vertikal

- melalui

- Video

- Video

- Suara

- menunggu

- Menunggu

- adalah

- Washington

- cara

- we

- jaringan

- aplikasi web

- aplikasi web

- layanan web

- BAIK

- adalah

- Apa

- ketika

- apakah

- yang

- sementara

- SIAPA

- lebar

- Rentang luas

- dengan

- dalam

- Kerja

- alur kerja

- kerja

- akan

- tertulis

- tahun

- Kamu

- Anda

- zephyrnet.dll