Deteksi bias dalam data dan hasil model merupakan persyaratan mendasar untuk membangun model kecerdasan buatan (AI) dan pembelajaran mesin (ML) yang bertanggung jawab. Sayangnya, mendeteksi bias bukanlah tugas yang mudah bagi sebagian besar praktisi karena banyaknya cara yang dapat diukur dan berbagai faktor yang dapat berkontribusi pada hasil yang bias. Misalnya, pengambilan sampel yang tidak seimbang dari data pelatihan dapat menghasilkan model yang kurang akurat untuk subset data tertentu. Bias juga dapat diperkenalkan oleh algoritme ML itu sendiri—bahkan dengan set data pelatihan yang seimbang, hasilnya mungkin mendukung subset data tertentu dibandingkan dengan yang lain.

Untuk mendeteksi bias, Anda harus memiliki pemahaman menyeluruh tentang berbagai jenis bias dan yang sesuai metrik bias. Misalnya, pada saat penulisan ini, Memperjelas Amazon SageMaker menawarkan 21 metrik berbeda untuk dipilih.

Dalam posting ini, kami menggunakan kasus penggunaan prediksi pendapatan (memprediksi pendapatan pengguna dari fitur input seperti pendidikan dan jumlah jam kerja per minggu) untuk menunjukkan berbagai jenis bias dan metrik yang sesuai di SageMaker Clarify. Kami juga mengembangkan kerangka kerja untuk membantu Anda memutuskan metrik mana yang penting untuk aplikasi Anda.

Pengantar Klarifikasi SageMaker

Model ML semakin banyak digunakan untuk membantu membuat keputusan di berbagai domain, seperti layanan keuangan, perawatan kesehatan, pendidikan, dan sumber daya manusia. Dalam banyak situasi, penting untuk memahami mengapa model ML membuat prediksi tertentu dan juga apakah prediksi tersebut dipengaruhi oleh bias.

SageMaker Clarify menyediakan alat untuk kedua kebutuhan ini, tetapi dalam posting ini kami hanya fokus pada fungsi deteksi bias. Untuk mempelajari lebih lanjut tentang kemampuan menjelaskan, lihat Menjelaskan Fakta Pertandingan Bundesliga xGoals menggunakan Amazon SageMaker Clarify.

SageMaker Klarifikasi adalah bagian dari Amazon SageMaker, yang merupakan layanan terkelola sepenuhnya untuk membuat, melatih, dan menerapkan model ML.

Contoh pertanyaan tentang bias

Untuk mengawali diskusi, berikut adalah beberapa contoh pertanyaan yang mungkin dimiliki oleh pembuat ML dan pemangku kepentingannya terkait bias. Daftar tersebut terdiri dari beberapa pertanyaan umum yang mungkin relevan untuk beberapa aplikasi ML, serta pertanyaan tentang aplikasi tertentu seperti pengambilan dokumen.

Anda mungkin bertanya, berdasarkan kelompok minat dalam data pelatihan (misalnya, pria vs. wanita) metrik mana yang harus saya gunakan untuk menjawab pertanyaan berikut:

- Apakah representasi kelompok dalam data pelatihan mencerminkan dunia nyata?

- Apakah label target dalam data pelatihan mendukung satu kelompok di atas yang lain dengan memberinya label yang lebih positif?

- Apakah model memiliki akurasi yang berbeda untuk kelompok yang berbeda?

- Dalam model yang tujuannya adalah untuk mengidentifikasi kandidat yang memenuhi syarat untuk perekrutan, apakah model tersebut memiliki presisi yang sama untuk kelompok yang berbeda?

- Dalam model yang tujuannya adalah untuk mengambil dokumen yang relevan dengan permintaan input, apakah model tersebut mengambil dokumen yang relevan dari kelompok yang berbeda dalam proporsi yang sama?

Di sisa pos ini, kami mengembangkan kerangka kerja tentang cara mempertimbangkan untuk menjawab pertanyaan ini dan lainnya melalui metrik yang tersedia di SageMaker Clarify.

Gunakan kasus dan konteks

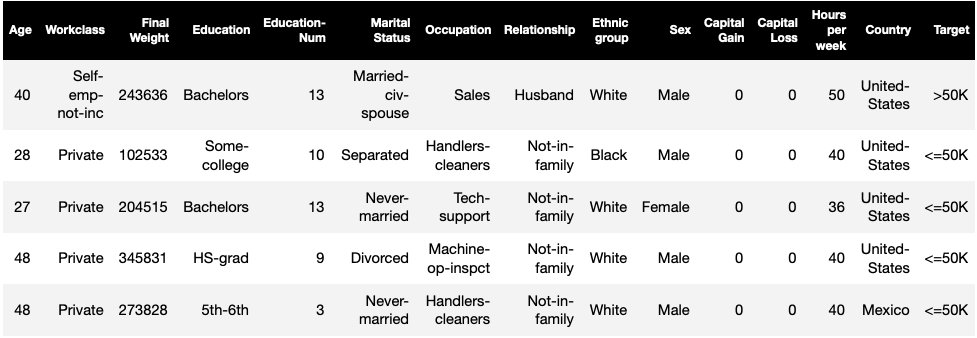

Posting ini menggunakan contoh pekerjaan SageMaker Clarify yang sudah ada dari Keadilan dan Penjelasan dengan notebook SageMaker Clarify dan menjelaskan nilai metrik bias yang dihasilkan. Notebook ini melatih model XGBoost di Kumpulan data UCI Dewasa (Dua, D. dan Graff, C. (2019). Repositori Pembelajaran Mesin UCI. Irvine, CA: Universitas California, Sekolah Informasi dan Ilmu Komputer).

Tugas ML dalam kumpulan data ini adalah untuk memprediksi apakah seseorang memiliki pendapatan tahunan lebih atau kurang dari $50,000. Tabel berikut menunjukkan beberapa instance beserta fitur-fiturnya. Mengukur bias dalam prediksi pendapatan adalah penting karena kita dapat menggunakan prediksi ini untuk menginformasikan keputusan seperti penawaran diskon dan pemasaran yang ditargetkan.

Terminologi bias

Sebelum menyelam lebih dalam, mari kita tinjau beberapa terminologi penting. Untuk daftar lengkap istilah, lihat Amazon SageMaker Klarifikasi Ketentuan untuk Bias dan Keadilan.

- label – Fitur target yang dilatih untuk diprediksi oleh model ML. Sebuah label yang diamati mengacu pada nilai label yang diamati dalam data yang digunakan untuk melatih atau menguji model. SEBUAH label yang diprediksi adalah nilai yang diprediksi oleh model ML. Label dapat berupa biner, dan sering kali dikodekan sebagai 0 dan 1. Kami menganggap 1 untuk mewakili label yang menguntungkan atau positif (misalnya, pendapatan lebih dari atau sama dengan $50,000), dan 0 untuk mewakili label yang tidak menguntungkan atau negatif. Label juga dapat terdiri dari lebih dari dua nilai. Bahkan dalam kasus ini, satu atau lebih nilai merupakan label yang menguntungkan. Demi kesederhanaan, posting ini hanya mempertimbangkan label biner. Untuk detail tentang penanganan label dengan lebih dari dua nilai dan label dengan nilai kontinu (misalnya, dalam regresi), lihat Buku Putih Keadilan dan Penjelasan Amazon AI.

- Segi – Kolom atau fitur yang bias diukur. Dalam contoh kita, seginya adalah

sexdan mengambil dua nilai:womandanman, dikodekan sebagaifemaledanmaledalam data (data ini diambil dari Sensus 1994 dan menerapkan opsi biner). Meskipun pos menganggap satu segi dengan hanya dua nilai, untuk kasus yang lebih kompleks yang melibatkan banyak segi atau segi dengan lebih dari dua nilai, lihat Buku Putih Keadilan dan Penjelasan Amazon AI. - Prasangka – Ketidakseimbangan yang signifikan dalam data input atau prediksi model di seluruh nilai aspek yang berbeda. Apa yang dimaksud dengan "signifikan" tergantung pada aplikasi Anda. Untuk sebagian besar metrik, nilai 0 menyiratkan tidak ada ketidakseimbangan. Metrik bias di SageMaker Clarify dibagi menjadi dua kategori:

- Prapelatihan – Jika ada, bias prapelatihan menunjukkan ketidakseimbangan dalam data saja.

- Pasca pelatihan – Bias pasca pelatihan juga mempertimbangkan prediksi model.

Mari kita periksa setiap kategori secara terpisah.

Bias pra-pelatihan

Metrik bias prapelatihan di SageMaker Clarify menjawab pertanyaan berikut: Apakah semua nilai segi memiliki representasi yang sama (atau serupa) dalam data? Sangat penting untuk memeriksa data untuk bias prapelatihan karena dapat diterjemahkan ke dalam bias pascapelatihan dalam prediksi model. Misalnya, model yang dilatih pada data yang tidak seimbang di mana satu nilai segi muncul sangat jarang dapat menunjukkan akurasi yang jauh lebih buruk untuk nilai segi itu. Representasi yang setara dapat dihitung sebagai berikut:

- Seluruh data pelatihan terlepas dari labelnya

- Subset dari data pelatihan dengan label positif saja

- Setiap label secara terpisah

Gambar berikut memberikan ringkasan tentang bagaimana setiap metrik cocok dengan masing-masing dari tiga kategori.

Beberapa kategori terdiri dari lebih dari satu metrik. Metrik dasar (kotak abu-abu) menjawab pertanyaan tentang bias dalam kategori tersebut dalam bentuk yang paling sederhana. Metrik dalam kotak putih juga mencakup kasus khusus (misalnya, paradoks Simpson) dan preferensi pengguna (misalnya, berfokus pada bagian tertentu dari populasi saat menghitung kinerja prediktif).

Representasi nilai segi terlepas dari labelnya

Satu-satunya metrik dalam kategori ini adalah Class Imbalance (CI). Tujuan dari metrik ini adalah untuk mengukur apakah semua nilai segi memiliki representasi yang sama dalam data.

CI adalah perbedaan dalam fraksi data yang dibentuk oleh dua nilai segi. Dalam contoh dataset kami, untuk facet sex, rincian (ditunjukkan dalam diagram lingkaran) menunjukkan bahwa perempuan merupakan 32.4% dari data pelatihan, sedangkan laki-laki merupakan 67.6%. Hasil dari:

CI = 0.676 - 0.324 = 0.352

Ketidakseimbangan kelas yang sangat tinggi dapat menyebabkan kinerja prediksi yang lebih buruk untuk nilai segi dengan representasi yang lebih kecil.

Representasi nilai segi pada tingkat label positif saja

Cara lain untuk mengukur representasi yang sama adalah dengan memeriksa apakah semua nilai segi mengandung fraksi sampel yang serupa dengan label pengamatan positif. Label positif terdiri dari hasil yang menguntungkan (misalnya, pinjaman diberikan, dipilih untuk pekerjaan itu), jadi menganalisis label positif secara terpisah membantu menilai apakah keputusan yang menguntungkan didistribusikan secara merata.

Dalam contoh dataset kami, label yang diamati dipecah menjadi nilai positif dan negatif, seperti yang ditunjukkan pada gambar berikut.

11.4% dari semua wanita dan 31.4% dari semua pria memiliki label positif (wilayah berbayang gelap di bilah kiri dan kanan). Perbedaan dalam Proporsi Positif dalam Label (DPL) mengukur perbedaan ini.

DPL = 0.314 - 0.114 = 0.20

Metrik lanjutan dalam kategori ini, Conditional Demographic Disparity in Labels (CDDL), mengukur perbedaan dalam label positif, tetapi mengelompokkannya terhadap variabel lain. Metrik ini membantu mengontrol Paradoks Simpson, kasus di mana perhitungan atas seluruh data menunjukkan bias, tetapi bias menghilang ketika mengelompokkan data sehubungan dengan beberapa informasi sampingan.

Grafik Studi Penerimaan UC Berkeley 1973 memberikan contoh. Menurut data, pria diterima pada tingkat yang lebih tinggi daripada wanita. Namun, ketika diperiksa di tingkat masing-masing departemen universitas, perempuan diterima pada tingkat yang sama atau lebih tinggi di setiap departemen. Pengamatan ini dapat dijelaskan oleh paradoks Simpson, yang muncul di sini karena perempuan mendaftar ke sekolah yang lebih kompetitif. Akibatnya, lebih sedikit perempuan yang diterima secara keseluruhan dibandingkan dengan laki-laki, meskipun sekolah demi sekolah mereka diterima pada tingkat yang sama atau lebih tinggi.

Untuk detail lebih lanjut tentang bagaimana CDDL dihitung, lihat Buku Putih Keadilan dan Penjelasan Amazon AI.

Representasi nilai segi pada tingkat setiap label secara terpisah

Kesetaraan dalam representasi juga dapat diukur untuk setiap label individu, bukan hanya label positif.

Metrik dalam kategori ini menghitung perbedaan dalam distribusi label dari nilai faset yang berbeda. Distribusi label untuk nilai faset berisi semua nilai label yang diamati, bersama dengan fraksi sampel dengan nilai label tersebut. Misalnya, pada gambar yang menunjukkan distribusi label, 88.6% wanita memiliki label pengamatan negatif dan 11.4% memiliki label pengamatan positif. Jadi distribusi label untuk perempuan adalah [0.886, 0.114] dan untuk laki-laki adalah [0.686, 0.314].

Metrik dasar dalam kategori ini, Kullback-Leibler divergence (KL), mengukur perbedaan ini sebagai:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Metrik lanjutan dalam kategori ini, Jensen-Shannon divergence (JS), Lp-norm (LP), Total Variation Distance (TVD), dan Kolmogorov-Smirnov (KS), juga mengukur perbedaan antara distribusi tetapi memiliki sifat matematika yang berbeda. Kecuali kasus khusus, mereka akan memberikan wawasan yang mirip dengan KL. Misalnya, meskipun nilai KL dapat menjadi tak terhingga ketika nilai segi tidak mengandung sampel dengan label tertentu (misalnya, tidak ada pria dengan label negatif), JS menghindari nilai tak terhingga ini. Untuk detail lebih lanjut tentang perbedaan ini, lihat Buku Putih Keadilan dan Penjelasan Amazon AI.

Hubungan antara DPL (Kategori 2) dan metrik berbasis distribusi KL/JS/LP/TVD/KS (Kategori 3)

Metrik berbasis distribusi lebih dapat diterapkan secara alami untuk label non-biner. Untuk label biner, karena fakta bahwa ketidakseimbangan dalam label positif dapat digunakan untuk menghitung ketidakseimbangan dalam label negatif, metrik distribusi memberikan wawasan yang sama dengan DPL. Karena itu, Anda bisa menggunakan DPL dalam kasus seperti itu.

Bias pasca pelatihan

Metrik bias pascapelatihan di SageMaker Clarify membantu kami menjawab dua pertanyaan kunci:

- Apakah semua nilai segi diwakili pada tingkat yang sama dalam prediksi model positif (menguntungkan)?

- Apakah model memiliki kinerja prediktif yang serupa untuk semua nilai segi?

Gambar berikut menunjukkan bagaimana metrik dipetakan ke masing-masing pertanyaan ini. Pertanyaan kedua dapat dipecah lebih lanjut tergantung pada label mana kinerja diukur sehubungan dengan.

Representasi yang sama dalam prediksi model positif

Metrik dalam kategori ini memeriksa apakah semua nilai faset berisi fraksi sampel yang serupa dengan label prediksi positif oleh model. Kelas metrik ini sangat mirip dengan metrik prapelatihan DPL dan CDDL—satu-satunya perbedaan adalah bahwa kategori ini mempertimbangkan label yang diprediksi, bukan label yang diamati.

Dalam contoh dataset kami, 4.5% dari semua wanita diberi label positif oleh model, dan 13.7% dari semua pria diberi label positif.

Metrik dasar dalam kategori ini, Selisih Proporsi Positif dalam Label yang Diprediksi (DPPL), mengukur perbedaan dalam penugasan kelas positif.

DPPL = 0.137 - 0.045 = 0.092

Perhatikan bagaimana dalam data pelatihan, sebagian besar pria memiliki label pengamatan positif. Dengan cara yang sama, sebagian besar pria diberi label prediksi positif.

Pindah ke metrik lanjutan dalam kategori ini, Disparate Impact (DI) mengukur perbedaan yang sama dalam tugas kelas positif, tetapi alih-alih perbedaannya, ini menghitung rasio:

DI = 0.045 / 0.137 = 0.328

Baik DI maupun DPPL menyampaikan wawasan yang serupa secara kualitatif tetapi berbeda pada beberapa kasus sudut. Misalnya, rasio cenderung meledak menjadi angka yang sangat besar jika penyebutnya kecil. Ambil contoh angka 0.1 dan 0.0001. Rasionya adalah 0.1/0.0001 = 10,000 sedangkan selisihnya adalah 0.1 – 0.0001 0.1. Berbeda dengan metrik lain di mana nilai 0 menyiratkan tidak ada bias, untuk DI, tidak ada bias yang sesuai dengan nilai 1.

Disparitas Demografi Bersyarat dalam Label yang Diprediksi (CDDPL) mengukur perbedaan dalam representasi nilai segi dalam label positif, tetapi seperti metrik prapelatihan CDDL, ini juga mengontrol paradoks Simpson.

Counterfactual Fliptest (FT) mengukur jika sampel serupa dari dua nilai segi menerima keputusan serupa dari model. Sebuah model yang menetapkan keputusan yang berbeda untuk dua sampel yang serupa satu sama lain tetapi berbeda dalam nilai segi dapat dianggap bias terhadap nilai segi yang diberi label tidak menguntungkan (negatif). Mengingat nilai segi pertama (perempuan), menilai apakah anggota yang sama dengan nilai segi lainnya (laki-laki) memiliki model prediksi yang berbeda. Anggota yang serupa dipilih berdasarkan algoritma k-nearest neighbor.

Performa setara

Prediksi model mungkin memiliki representasi serupa dalam label positif dari nilai segi yang berbeda, namun kinerja model pada kelompok ini mungkin berbeda secara signifikan. Dalam banyak aplikasi, memiliki kinerja prediktif serupa di berbagai nilai aspek dapat diinginkan. Metrik dalam kategori ini mengukur perbedaan kinerja prediktif di seluruh nilai segi.

Karena data dapat diiris dengan berbagai cara berdasarkan label yang diamati atau diprediksi, ada banyak cara berbeda untuk mengukur kinerja prediktif.

Performa prediktif yang setara terlepas dari labelnya

Anda dapat mempertimbangkan kinerja model pada seluruh data, terlepas dari label yang diamati atau diprediksi – yaitu, akurasi keseluruhan.

Gambar berikut menunjukkan bagaimana model mengklasifikasikan input dari dua nilai segi dalam contoh dataset kita. Negatif sejati (TN) adalah kasus di mana label yang diamati dan diprediksi adalah 0. Positif palsu (FP) adalah kesalahan klasifikasi di mana label yang diamati adalah 0 tetapi label yang diprediksi adalah 1. Positif sejati (TP) dan negatif palsu (FN) didefinisikan demikian pula.

|

|

Untuk setiap nilai segi, kinerja model keseluruhan, yaitu akurasi untuk nilai segi itu, adalah:

Ketepatan = (TN + TP🇧🇷TN + FP + FN + TP)

Dengan rumus ini, akurasi untuk wanita adalah 0.930 dan untuk pria adalah 0.815. Ini mengarah ke satu-satunya metrik dalam kategori ini, Perbedaan Akurasi (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 berarti akurasi untuk kedua kelompok sama. Nilai yang lebih besar (positif atau negatif) menunjukkan perbedaan akurasi yang lebih besar.

Performa setara hanya pada label positif

Anda dapat membatasi analisis kinerja model hanya pada label positif. Misalnya, jika aplikasinya adalah tentang mendeteksi cacat pada jalur perakitan, mungkin diinginkan untuk memeriksa bahwa bagian yang tidak cacat (label positif) dari jenis yang berbeda (nilai segi) diklasifikasikan sebagai tidak cacat pada tingkat yang sama. Kuantitas ini disebut sebagai recall, atau true positive rate:

Mengingat kembali = TP / (TP + FN)

Dalam kumpulan data contoh kami, ingatan untuk wanita adalah 0.389, dan ingatan untuk pria adalah 0.425. Ini mengarah ke metrik dasar dalam kategori ini, Recall Difference (RD):

RD = 0.425 - 0.389 = 0.036

Sekarang mari kita pertimbangkan tiga metrik lanjutan dalam kategori ini, lihat preferensi pengguna mana yang dikodekan, dan perbedaannya dari metrik dasar RD.

Pertama, alih-alih mengukur kinerja pada label positif yang diamati, Anda dapat mengukurnya pada label prediksi positif. Mengingat nilai segi, seperti wanita, dan semua sampel dengan nilai segi itu yang diprediksi positif oleh model, berapa banyak yang benar-benar diklasifikasikan sebagai positif? Kuantitas ini disebut sebagai tingkat penerimaan (AR), atau presisi:

AR = TP / (TP + FP)

Dalam contoh kita, AR untuk wanita adalah 0.977, dan AR untuk pria adalah 0.970. Ini mengarah ke Selisih Tingkat Penerimaan (DAR):

DAR = 0.970 - 0.977 = -0.007

Cara lain untuk mengukur bias adalah dengan menggabungkan dua metrik sebelumnya dan mengukur berapa banyak lagi prediksi positif yang diberikan model ke nilai segi dibandingkan dengan label positif yang diamati. SageMaker Clarify mengukur keunggulan ini dengan model sebagai rasio antara jumlah label positif yang diamati untuk nilai segi itu, dan jumlah label positif yang diprediksi, dan menyebutnya sebagai penerimaan bersyarat (CA):

CA = (TP + FN🇧🇷TP + FP)

Dalam contoh kami, CA untuk wanita adalah 2.510 dan untuk pria adalah 2.283. Perbedaan CA mengarah ke metrik terakhir dalam kategori ini, Selisih Penerimaan Bersyarat (DCA):

DCA = 2.283 - 2.510 = -0.227

Performa setara hanya pada label negatif

Dengan cara yang mirip dengan label positif, bias juga dapat dihitung sebagai perbedaan kinerja pada label negatif. Mempertimbangkan label negatif secara terpisah dapat menjadi penting dalam aplikasi tertentu. Misalnya, dalam contoh deteksi cacat, kita mungkin ingin mendeteksi bagian yang cacat (label negatif) dari berbagai jenis (nilai segi) pada tingkat yang sama.

Metrik dasar dalam kategori ini, spesifisitas, analog dengan metrik recall (tingkat positif benar). Spesifisitas menghitung keakuratan model pada sampel dengan nilai segi ini yang memiliki label negatif yang diamati:

Kekhususan = TN / (TN + FP)

Dalam contoh kita (lihat tabel kebingungan), spesifisitas untuk wanita dan pria masing-masing adalah 0.999 dan 0.994. Akibatnya, Perbedaan Spesifisitas (SD) adalah:

SD = 0.994 - 0.999 = -0.005

Selanjutnya, seperti metrik tingkat penerimaan, kuantitas analog untuk label negatif—tingkat penolakan (RR)—adalah:

RR = TN / (TN + FN)

RR untuk wanita adalah 0.927 dan untuk pria adalah 0.791, yang mengarah ke metrik Selisih Tingkat Penolakan (DRR):

DRR = 0.927 - 0.791 = -0.136

Akhirnya, analog label negatif dari penerimaan bersyarat, penolakan bersyarat (CR), adalah rasio antara jumlah label negatif yang diamati untuk nilai segi itu, dan jumlah label negatif yang diprediksi:

CR = (TN + FP🇧🇷TN + FN)

CR untuk wanita adalah 0.928 dan untuk pria adalah 0.796. Metrik terakhir dalam kategori ini adalah Selisih Penolakan Bersyarat (DCR):

DCR = 0.796 - 0.928 = 0.132

Performa setara pada label positif vs. negatif

SageMaker Clarify menggabungkan dua kategori sebelumnya dengan mempertimbangkan rasio kinerja model pada label positif dan negatif. Secara khusus, untuk setiap nilai segi, SageMaker Clarify menghitung rasio antara negatif palsu (FN) dan positif palsu (FP). Dalam contoh kita, rasio FN/FP untuk wanita adalah 679/10 = 67.9 dan untuk pria adalah 3678/84 = 43.786. Ini mengarah ke metrik Kesetaraan Perawatan (TE), yang mengukur perbedaan antara rasio FP/FN:

TE = 67.9 - 43.786 = 24.114

Tangkapan layar berikut menunjukkan bagaimana Anda dapat menggunakan SageMaker Clarify dengan Studio Amazon SageMaker untuk menunjukkan nilai serta rentang dan deskripsi singkat dari berbagai metrik bias.

Pertanyaan tentang bias: Metrik mana yang harus digunakan?

Ingat contoh pertanyaan tentang bias di awal posting ini. Setelah melalui metrik dari kategori yang berbeda, pertimbangkan pertanyaan lagi. Untuk menjawab pertanyaan pertama, yang menyangkut representasi kelompok yang berbeda dalam data pelatihan, Anda bisa mulai dengan metrik Ketidakseimbangan Kelas (CI). Demikian pula, untuk pertanyaan lainnya, Anda dapat mulai dengan melihat masing-masing Selisih dalam Proporsi Positif dalam Label (DPL), Selisih Akurasi (AD), Selisih Tingkat Penerimaan (DAR), dan Selisih Ingatan (RD).

Bias tanpa nilai segi

Untuk kemudahan eksposisi, deskripsi metrik pasca pelatihan ini mengecualikan metrik Generalized Entropy Index (GE). Metrik ini mengukur bias tanpa mempertimbangkan nilai segi, dan dapat membantu dalam menilai bagaimana kesalahan model didistribusikan. Untuk detailnya, lihat Entropi umum (GE).

Kesimpulan

Dalam postingan ini, Anda melihat bagaimana 21 metrik berbeda di SageMaker Clarify mengukur bias pada berbagai tahapan pipeline ML. Anda mempelajari berbagai metrik melalui kasus penggunaan prediksi pendapatan, cara memilih metrik untuk kasus penggunaan Anda, dan metrik mana yang dapat Anda mulai.

Mulailah perjalanan AI Anda yang bertanggung jawab dengan menilai bias dalam model ML Anda menggunakan notebook demo Keadilan dan Penjelasan dengan SageMaker Clarify. Anda dapat menemukan dokumentasi mendetail untuk SageMaker Clarify, termasuk definisi formal metrik, di Apa Keadilan dan Penjelasan Model untuk Prediksi Machine Learning. Untuk implementasi sumber terbuka dari metrik bias, lihat: aws-sagemaker-clarify repositori GitHub. Untuk diskusi terperinci termasuk batasan, lihat Buku Putih Keadilan dan Penjelasan Amazon AI.

Tentang penulis

Bilal Zafar adalah Ilmuwan Terapan di AWS, yang mengerjakan Keadilan, Keterjelasan, dan Keamanan dalam Pembelajaran Mesin.

Bilal Zafar adalah Ilmuwan Terapan di AWS, yang mengerjakan Keadilan, Keterjelasan, dan Keamanan dalam Pembelajaran Mesin.

Denis V. Batalov adalah Arsitek Solusi untuk AWS, yang berspesialisasi dalam Pembelajaran Mesin. Dia bergabung dengan Amazon sejak 2005. Denis memiliki gelar PhD di bidang AI. Ikuti dia di Twitter: @dbatalov.

Michele Donini adalah Ilmuwan Terapan Senior di AWS. Dia memimpin tim ilmuwan yang bekerja pada AI yang Bertanggung Jawab dan minat penelitiannya adalah Keadilan Algoritmik dan Pembelajaran Mesin yang Dapat Dijelaskan.

Michele Donini adalah Ilmuwan Terapan Senior di AWS. Dia memimpin tim ilmuwan yang bekerja pada AI yang Bertanggung Jawab dan minat penelitiannya adalah Keadilan Algoritmik dan Pembelajaran Mesin yang Dapat Dijelaskan.

- AI

- ai seni

- generator seni ai

- punya robot

- Amazon SageMaker

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll