Tahun lalu, kami mengumumkan ketersediaan umum RStudio di Amazon SageMaker, lingkungan pengembangan terintegrasi (IDE) RStudio Workbench pertama yang dikelola sepenuhnya di industri di cloud. Anda dapat dengan cepat meluncurkan RStudio IDE yang sudah dikenal, dan memanggil sumber daya komputasi yang mendasarinya tanpa mengganggu pekerjaan Anda, membuatnya mudah untuk membangun pembelajaran mesin (ML) dan solusi analitik dalam skala R.

Dengan semakin banyaknya volume data yang dihasilkan, kumpulan data yang digunakan untuk ML dan analisis statistik berkembang bersama-sama. Dengan ini membawa tantangan peningkatan waktu pengembangan dan manajemen infrastruktur komputasi. Untuk mengatasi tantangan ini, para ilmuwan data telah berupaya menerapkan teknik pemrosesan data paralel. Pemrosesan data paralel, atau paralelisasi data, mengambil kumpulan data besar yang ada dan mendistribusikannya ke beberapa pemroses atau node untuk beroperasi pada data secara bersamaan. Hal ini dapat memungkinkan waktu pemrosesan yang lebih cepat untuk kumpulan data yang lebih besar, bersama dengan penggunaan yang dioptimalkan pada komputasi. Ini dapat membantu praktisi ML membuat pola yang dapat digunakan kembali untuk pembuatan kumpulan data, dan juga membantu mengurangi beban dan biaya infrastruktur komputasi.

Ikhtisar solusi

Dalam Amazon SageMaker, banyak pelanggan menggunakan Pengolahan SageMaker untuk membantu mengimplementasikan pemrosesan data paralel. Dengan Pemrosesan SageMaker, Anda dapat menggunakan pengalaman terkelola yang disederhanakan di SageMaker untuk menjalankan beban kerja pemrosesan data Anda, seperti rekayasa fitur, validasi data, evaluasi model, dan interpretasi model. Ini membawa banyak manfaat karena tidak ada infrastruktur yang berjalan lama untuk dikelola—instance pemrosesan akan berkurang saat pekerjaan selesai, lingkungan dapat distandarisasi melalui container, data di dalamnya Layanan Penyimpanan Sederhana Amazon (Amazon S3) didistribusikan secara asli di seluruh instans, dan pengaturan infrastruktur fleksibel dalam hal memori, komputasi, dan penyimpanan.

SageMaker Processing menawarkan opsi tentang cara mendistribusikan data. Untuk pemrosesan data paralel, Anda harus menggunakan: Opsi ShardedByS3Key untuk S3DataDistributionType. Saat parameter ini dipilih, Pemrosesan SageMaker mengambil yang disediakan n instance dan mendistribusikan objek 1/n objek dari sumber data input di seluruh instance. Misalnya, jika dua instance disediakan dengan empat objek data, setiap instance menerima dua objek.

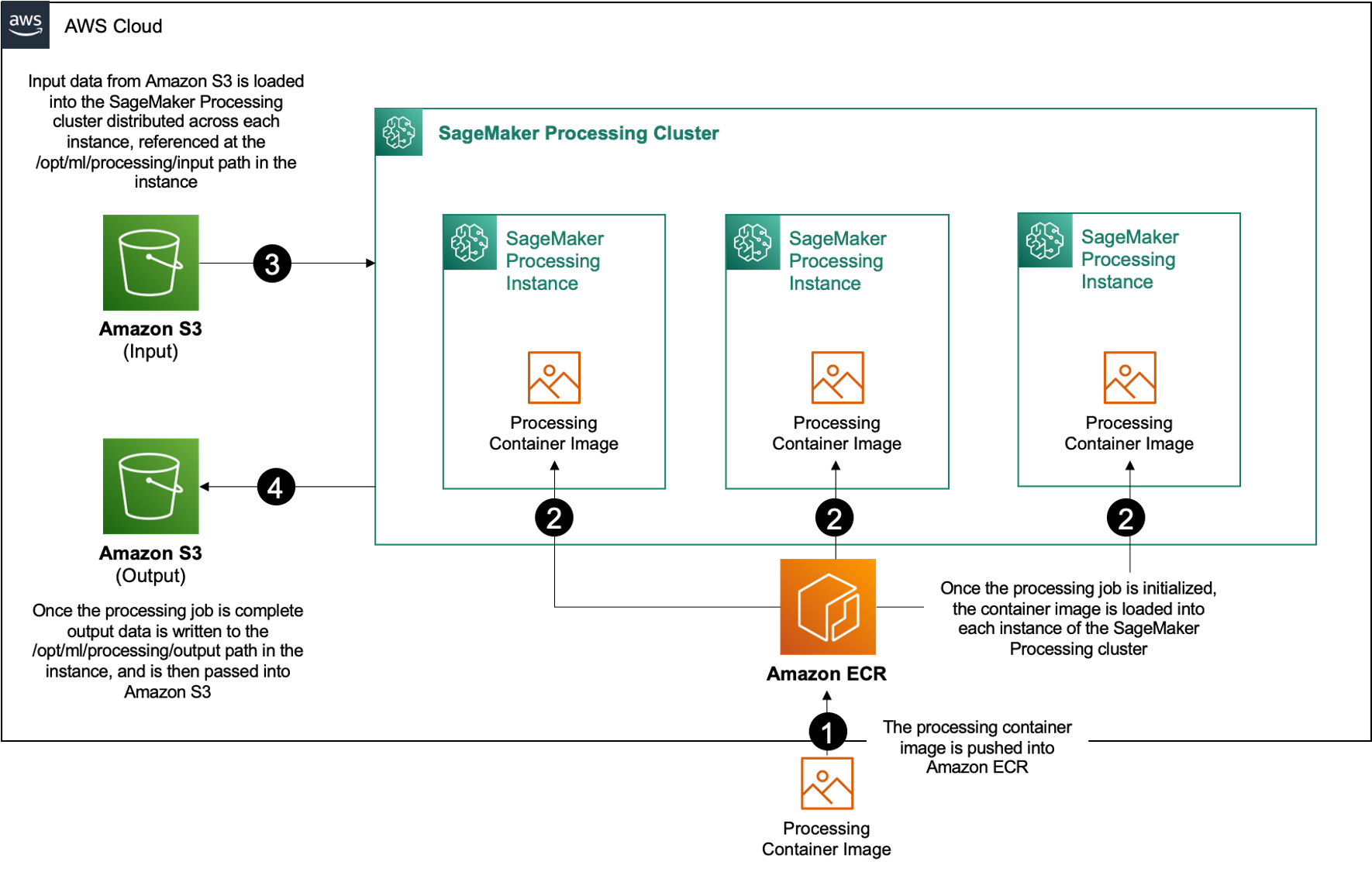

Pemrosesan SageMaker memerlukan tiga komponen untuk menjalankan tugas pemrosesan:

- Gambar kontainer yang memiliki kode dan dependensi Anda untuk menjalankan beban kerja pemrosesan data Anda

- Jalur ke sumber data input dalam Amazon S3

- Jalur ke sumber data keluaran dalam Amazon S3

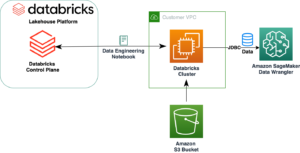

Prosesnya digambarkan dalam diagram berikut.

Dalam posting ini, kami menunjukkan cara menggunakan RStudio di SageMaker untuk berinteraksi dengan serangkaian pekerjaan Pemrosesan SageMaker untuk membuat jalur pemrosesan data paralel menggunakan bahasa pemrograman R.

Solusinya terdiri dari langkah-langkah berikut:

- Siapkan proyek RStudio.

- Bangun dan daftarkan gambar wadah pemrosesan.

- Jalankan pipa pemrosesan dua langkah:

- Langkah pertama mengambil beberapa file data dan memprosesnya di serangkaian pekerjaan pemrosesan.

- Langkah kedua menggabungkan file output dan membaginya menjadi set data pelatihan, pengujian, dan validasi.

Prasyarat

Lengkapi prasyarat berikut:

- Siapkan RStudio di SageMaker Workbench. Untuk informasi lebih lanjut, lihat Mengumumkan RStudio Terkelola Sepenuhnya di Amazon SageMaker untuk Ilmuwan Data.

- Buat pengguna dengan RStudio di SageMaker dengan izin akses yang sesuai.

Siapkan proyek RStudio

Untuk menyiapkan proyek RStudio, selesaikan langkah-langkah berikut:

- Arahkan ke Anda Studio Amazon SageMaker panel kontrol di konsol SageMaker.

- Luncurkan aplikasi Anda di lingkungan RStudio.

- Mulai sesi RStudio baru.

- Untuk Nama Sesi, masukkan nama.

- Untuk Jenis Mesin Virtual dan Gambar, gunakan pengaturan default.

- Pilih Mulai Sesi.

- Navigasikan ke sesi.

- Pilih Proyek Baru, Kontrol versi, Dan kemudian Pilih Git.

- Untuk URL repositori, Masuk

https://github.com/aws-samples/aws-parallel-data-processing-r.git - Biarkan opsi yang tersisa sebagai default dan pilih Buat Proyek.

Anda dapat menavigasi ke menu aws-parallel-data-processing-R direktori di File tab untuk melihat repositori. Repositori berisi file-file berikut:

Container_Build.rmd/datasetbank-additional-full-data1.csvbank-additional-full-data2.csvbank-additional-full-data3.csvbank-additional-full-data4.csv

/dockerDockerfile-ProcessingParallel_Data_Processing.rmd/preprocessingfilter.Rprocess.R

Bangun wadah

Pada langkah ini, kami membuat gambar wadah pemrosesan kami dan mendorongnya ke Registry Kontainer Elastis Amazon (Amazon ECR). Selesaikan langkah-langkah berikut:

- Arahkan ke folder

Container_Build.rmdfile. - Instal SageMaker Studio Pembuatan Gambar CLI dengan menjalankan sel berikut. Pastikan Anda memiliki izin yang diperlukan sebelum menyelesaikan langkah ini, ini adalah CLI yang dirancang untuk mendorong dan mendaftarkan gambar kontainer di dalam Studio.

- Jalankan sel berikutnya untuk membangun dan mendaftarkan wadah pemrosesan kami:

Setelah pekerjaan berhasil dijalankan, Anda menerima output yang terlihat seperti berikut ini:

Jalankan pipa pemrosesan

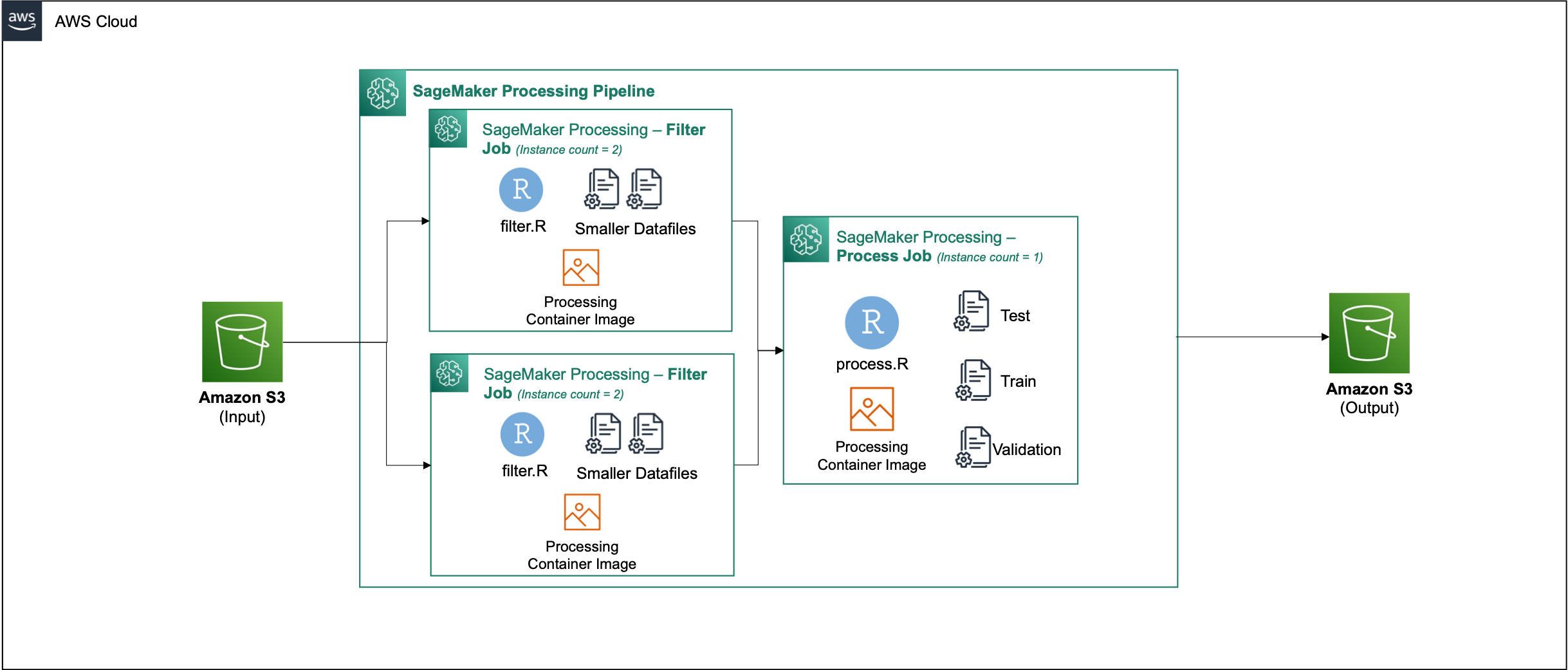

Setelah Anda membuat wadah, navigasikan ke Parallel_Data_Processing.rmd mengajukan. File ini berisi serangkaian langkah yang membantu kami membuat saluran pemrosesan data paralel menggunakan Pemrosesan SageMaker. Diagram berikut menggambarkan langkah-langkah dari pipa yang kami selesaikan.

Mulailah dengan menjalankan langkah impor paket. Impor paket RStudio yang diperlukan bersama dengan SageMaker SDK:

Sekarang atur peran eksekusi SageMaker dan detail lingkungan Anda:

Inisialisasi container yang kita buat dan daftarkan pada langkah sebelumnya:

Dari sini kita menyelami setiap langkah pemrosesan secara lebih rinci.

Unggah kumpulan data

Untuk contoh kami, kami menggunakan Kumpulan data Pemasaran Bank dari UCI. Kami telah membagi dataset menjadi beberapa file yang lebih kecil. Jalankan kode berikut untuk mengunggah file ke Amazon S3:

Setelah file diunggah, lanjutkan ke langkah berikutnya.

Lakukan pemrosesan data paralel

Pada langkah ini, kami mengambil file data dan melakukan rekayasa fitur untuk menyaring kolom tertentu. Pekerjaan ini didistribusikan di serangkaian instance pemrosesan (misalnya, kami menggunakan dua).

Kami menggunakan filter.R file untuk memproses data, dan mengkonfigurasi pekerjaan sebagai berikut:

Seperti yang disebutkan sebelumnya, saat menjalankan pekerjaan pemrosesan data paralel, Anda harus menyesuaikan parameter input dengan cara data akan di-sharding, dan jenis datanya. Oleh karena itu, kami menyediakan metode sharding dengan S3Prefix:

Setelah Anda memasukkan parameter ini, Pemrosesan SageMaker akan mendistribusikan data secara merata ke seluruh jumlah instans yang dipilih.

Sesuaikan parameter seperlunya, lalu jalankan sel untuk membuat instance pekerjaan.

Buat set data pelatihan, pengujian, dan validasi

Pada langkah ini, kami mengambil file data yang diproses, menggabungkannya, dan membaginya menjadi kumpulan data pengujian, pelatihan, dan validasi. Ini memungkinkan kita untuk menggunakan data untuk membangun model kita.

Kami menggunakan process.R file untuk memproses data, dan mengkonfigurasi pekerjaan sebagai berikut:

Sesuaikan parameter yang diperlukan, lalu jalankan sel untuk membuat instance pekerjaan.

Jalankan pipa

Setelah semua langkah dipakai, mulai pipa pemrosesan untuk menjalankan setiap langkah dengan menjalankan sel berikut:

Waktu yang dibutuhkan setiap pekerjaan ini akan bervariasi berdasarkan ukuran instans dan jumlah yang dipilih.

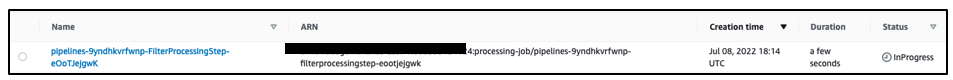

Navigasikan ke konsol SageMaker untuk melihat semua pekerjaan pemrosesan Anda.

Kami mulai dengan pekerjaan penyaringan, seperti yang ditunjukkan pada tangkapan layar berikut.

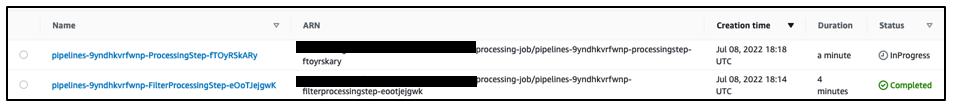

Setelah selesai, pipeline berpindah ke pekerjaan pemrosesan data.

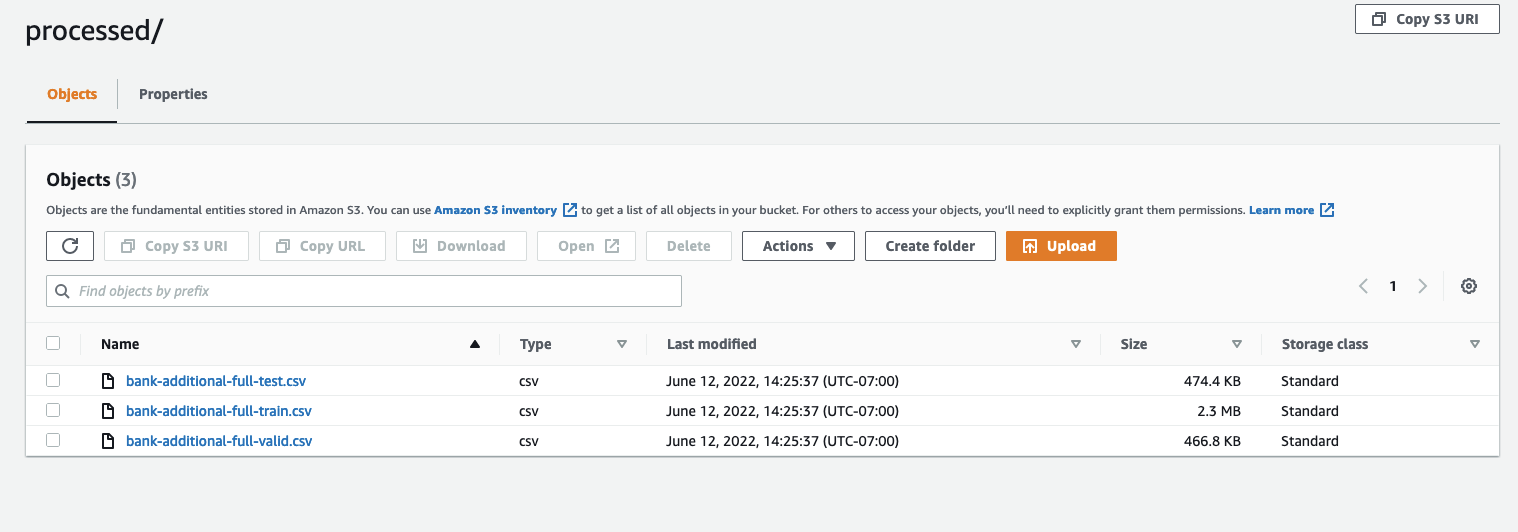

Saat kedua pekerjaan selesai, navigasikan ke bucket S3 Anda. Lihat di dalam sagemaker-rstudio-example folder, di bawah processed. Anda dapat melihat file untuk set data pelatihan, pengujian, dan validasi.

Kesimpulan

Dengan bertambahnya jumlah data yang akan dibutuhkan untuk membangun model yang semakin canggih, kami perlu mengubah pendekatan kami terhadap cara kami memproses data. Pemrosesan data paralel adalah metode yang efisien dalam mempercepat pembuatan kumpulan data, dan jika digabungkan dengan lingkungan dan peralatan cloud modern seperti RStudio pada SageMaker dan Pemrosesan SageMaker, dapat menghilangkan banyak beban berat yang tidak terdiferensiasi dari manajemen infrastruktur, pembuatan kode boilerplate, dan manajemen lingkungan. Dalam posting ini, kami membahas bagaimana Anda dapat menerapkan pemrosesan data paralel dalam RStudio di SageMaker. Kami mendorong Anda untuk mencobanya dengan mengkloning repositori GitHub, dan jika Anda memiliki saran tentang cara membuat pengalaman menjadi lebih baik, silakan kirimkan masalah atau pull request.

Untuk mempelajari lebih lanjut tentang fitur dan layanan yang digunakan dalam solusi ini, lihat RStudio di Amazon SageMaker dan Pemrosesan SageMaker Amazon.

Tentang penulis

Raja Pathak adalah Arsitek Solusi dan penasihat Teknis untuk pelanggan Fortune 50 dan FSI (Perbankan, Asuransi, Pasar Modal) Menengah di Kanada dan Amerika Serikat. Raj berspesialisasi dalam Pembelajaran Mesin dengan aplikasi dalam Ekstraksi Dokumen, Transformasi Pusat Kontak, dan Visi Komputer.

Raja Pathak adalah Arsitek Solusi dan penasihat Teknis untuk pelanggan Fortune 50 dan FSI (Perbankan, Asuransi, Pasar Modal) Menengah di Kanada dan Amerika Serikat. Raj berspesialisasi dalam Pembelajaran Mesin dengan aplikasi dalam Ekstraksi Dokumen, Transformasi Pusat Kontak, dan Visi Komputer.

Jaka Wen adalah Arsitek Solusi di AWS dengan hasrat untuk pelatihan ML dan Pemrosesan Bahasa Alami. Jake membantu pelanggan Small Medium Business dengan desain dan kepemimpinan pemikiran untuk membangun dan menerapkan aplikasi dalam skala besar. Di luar pekerjaan, ia menikmati hiking.

Jaka Wen adalah Arsitek Solusi di AWS dengan hasrat untuk pelatihan ML dan Pemrosesan Bahasa Alami. Jake membantu pelanggan Small Medium Business dengan desain dan kepemimpinan pemikiran untuk membangun dan menerapkan aplikasi dalam skala besar. Di luar pekerjaan, ia menikmati hiking.

Aditi Rajnish adalah mahasiswa rekayasa perangkat lunak tahun pertama di University of Waterloo. Minatnya meliputi visi komputer, pemrosesan bahasa alami, dan komputasi tepi. Dia juga bersemangat tentang penjangkauan dan advokasi STEM berbasis komunitas. Di waktu luangnya, ia dapat ditemukan panjat tebing, bermain piano, atau belajar cara membuat scone yang sempurna.

Aditi Rajnish adalah mahasiswa rekayasa perangkat lunak tahun pertama di University of Waterloo. Minatnya meliputi visi komputer, pemrosesan bahasa alami, dan komputasi tepi. Dia juga bersemangat tentang penjangkauan dan advokasi STEM berbasis komunitas. Di waktu luangnya, ia dapat ditemukan panjat tebing, bermain piano, atau belajar cara membuat scone yang sempurna.

Sean Morgan adalah Arsitek Solusi AI/ML di AWS. Dia memiliki pengalaman di bidang penelitian semikonduktor dan akademik, dan menggunakan pengalamannya untuk membantu pelanggan mencapai tujuan mereka di AWS. Di waktu luangnya, Sean adalah kontributor dan pengelola open-source aktif, dan merupakan pemimpin kelompok minat khusus untuk Add-on TensorFlow.

Sean Morgan adalah Arsitek Solusi AI/ML di AWS. Dia memiliki pengalaman di bidang penelitian semikonduktor dan akademik, dan menggunakan pengalamannya untuk membantu pelanggan mencapai tujuan mereka di AWS. Di waktu luangnya, Sean adalah kontributor dan pengelola open-source aktif, dan merupakan pemimpin kelompok minat khusus untuk Add-on TensorFlow.

Paul Wu adalah Arsitek Solusi yang bekerja di AWS Greenfield Business di Texas. Bidang keahliannya meliputi kontainer dan migrasi.

Paul Wu adalah Arsitek Solusi yang bekerja di AWS Greenfield Business di Texas. Bidang keahliannya meliputi kontainer dan migrasi.

- AI

- ai seni

- generator seni ai

- punya robot

- Amazon SageMaker

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll