Fotografi palsu bukanlah hal baru. Pada tahun 1910-an, penulis Inggris Arthur Conan Doyle terkenal ditipu oleh dua saudara perempuan usia sekolah yang telah menghasilkan foto-foto peri anggun yang berkeliaran di kebun mereka.

Hari ini sulit untuk percaya bahwa foto-foto ini bisa menipu siapa pun, tetapi baru pada tahun 1980-an seorang ahli bernama Geoffrey Crawley memiliki keberanian untuk secara langsung menerapkan pengetahuannya tentang fotografi film dan menyimpulkan yang sudah jelas.

Foto-foto itu palsu, seperti yang kemudian diakui oleh salah satu saudari itu sendiri.

Berburu Artefak dan Akal Sehat

Fotografi digital telah membuka banyak teknik untuk pemalsu dan detektif.

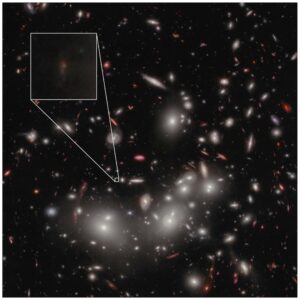

Pemeriksaan forensik gambar tersangka saat ini melibatkan perburuan kualitas yang melekat pada fotografi digital, seperti pemeriksaan metadata tertanam di foto, menggunakan perangkat lunak seperti Adobe Photoshop untuk memperbaiki distorsi pada gambar, dan mencari tanda-tanda manipulasi, seperti wilayah yang diduplikasi untuk mengaburkan fitur asli.

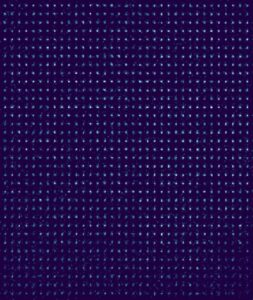

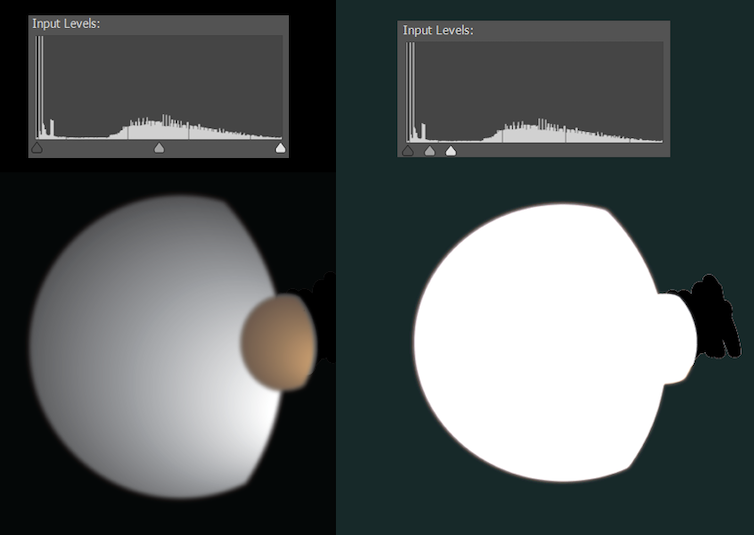

Terkadang pengeditan digital terlalu halus untuk dideteksi, tetapi langsung terlihat saat kami menyesuaikan cara piksel terang dan gelap didistribusikan. Misalnya, pada tahun 2010 NASA merilis foto bulan Saturnus Dione dan Titan. Itu sama sekali tidak palsu, tetapi telah dibersihkan untuk menghilangkan artefak yang tersesat — yang didapat perhatian para ahli teori konspirasi.

Penasaran, saya memasukkan gambar ke dalam Photoshop. Ilustrasi di bawah ini menggambarkan secara kasar bagaimana tampilannya.

Sebagian besar foto digital dalam format terkompresi seperti JPEG, diperkecil dengan menghapus banyak informasi yang ditangkap oleh kamera. Algoritme standar memastikan informasi yang dihapus memiliki dampak minimal yang terlihat—tetapi tetap meninggalkan jejak.

Kompresi wilayah mana pun pada gambar akan bergantung pada apa yang terjadi pada gambar dan pengaturan kamera saat ini; ketika gambar palsu menggabungkan banyak sumber, seringkali mungkin untuk mendeteksi ini dengan analisis yang cermat dari artefak kompresi.

Beberapa metodologi forensik tidak ada hubungannya dengan format gambar, tetapi pada dasarnya pekerjaan detektif visual. Apakah semua orang di foto menyala dengan cara yang sama? Apakah bayangan dan pantulan masuk akal? Apakah telinga dan tangan menunjukkan cahaya dan bayangan di tempat yang tepat? Apa yang tercermin di mata orang? Apakah semua garis dan sudut ruangan akan bertambah jika kita memodelkan pemandangan dalam 3D?

Arthur Conan Doyle mungkin telah tertipu oleh foto peri, tapi saya pikir ciptaannya Sherlock Holmes akan cocok di dunia analisis foto forensik.

Era Baru Kecerdasan Buatan

Grafik ledakan gambar saat ini dibuat oleh teks-ke-gambar kecerdasan buatan alat dalam banyak hal lebih radikal daripada pergeseran dari film ke fotografi digital.

Kita sekarang dapat menyulap gambar apa pun yang kita inginkan, hanya dengan mengetik. Gambar-gambar ini bukan foto franken yang dibuat dengan menggabungkan gumpalan piksel yang sudah ada sebelumnya. Mereka adalah gambar yang sama sekali baru dengan konten, kualitas, dan gaya yang ditentukan.

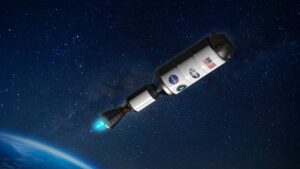

Sampai saat ini, jaringan saraf kompleks yang digunakan untuk menghasilkan gambar-gambar ini memiliki ketersediaan terbatas untuk umum. Ini berubah pada 23 Agustus 2022, dengan rilis ke publik dari Difusi Stabil sumber terbuka. Sekarang siapa pun dengan kartu grafis Nvidia tingkat permainan di komputer mereka dapat membuat konten gambar AI tanpa lab penelitian atau penjaga gerbang bisnis aktivitas mereka.

Hal ini membuat banyak orang bertanya, “bisakah kita percaya apa yang kita lihat online lagi?”. Itu tergantung.

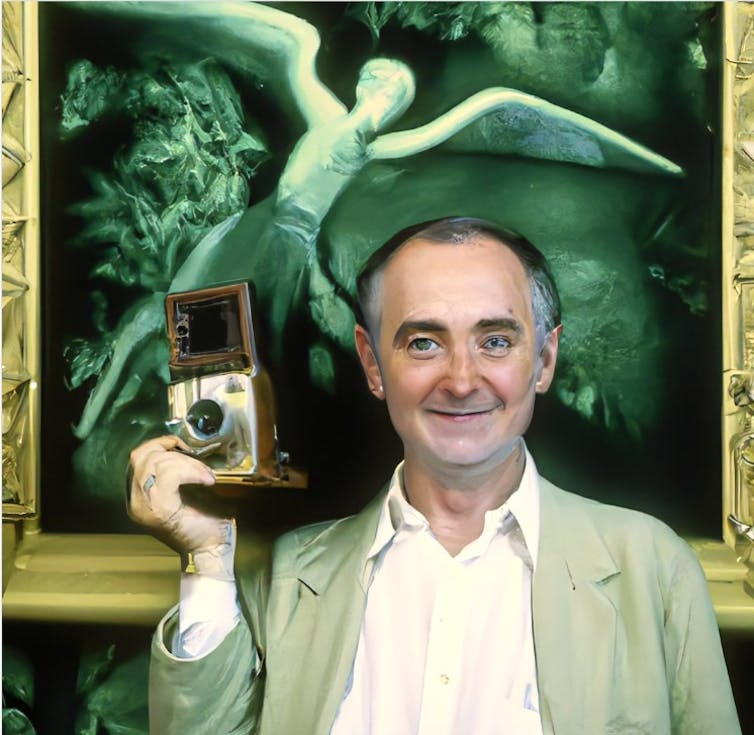

AI teks-ke-gambar mendapatkan kecerdasannya dari pelatihan—analisis sejumlah besar pasangan gambar/teks. Kekuatan dan kelemahan masing-masing sistem sebagian berasal dari gambar apa yang telah dilatih. Berikut ini contohnya: beginilah cara Stable Diffusion melihat George Clooney menyetrika.

Ini jauh dari realistis. Semua Difusi Stabil harus melanjutkan adalah informasi yang telah dipelajari, dan sementara jelas telah melihat George Clooney dan dapat menghubungkan string huruf ke fitur aktor, itu bukan ahli Clooney.

Namun, itu akan melihat dan mencerna lebih banyak foto pria paruh baya pada umumnya, jadi mari kita lihat apa yang terjadi ketika kita meminta pria paruh baya generik dalam skenario yang sama.

Ini adalah peningkatan yang jelas, tetapi masih belum cukup realistis. Seperti yang selalu terjadi, geometri tangan dan telinga yang rumit adalah tempat yang baik untuk mencari tanda-tanda kepalsuan—walaupun dalam media ini kita melihat geometri spasial daripada menceritakan tentang pencahayaan yang mustahil.

Mungkin ada petunjuk lain. Jika kita dengan hati-hati merekonstruksi ruangan, apakah sudut-sudutnya akan berbentuk persegi? Apakah rak itu masuk akal? Seorang ahli forensik yang biasa memeriksa foto-foto digital mungkin bisa membuat panggilan itu.

Kami Tidak Bisa Lagi Mempercayai Mata Kami

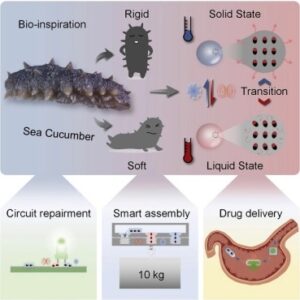

Jika kita memperluas pengetahuan sistem teks-ke-gambar, itu bisa menjadi lebih baik. Anda dapat menambahkan foto-foto Anda sendiri yang dijelaskan untuk melengkapi pelatihan yang ada. Proses ini dikenal sebagai inversi tekstual.

Baru-baru ini, Google telah merilis stan impian, metode alternatif yang lebih canggih untuk memasukkan orang, objek, atau bahkan gaya seni tertentu ke dalam sistem AI teks-ke-gambar.

Proses ini membutuhkan perangkat keras tugas berat, tetapi hasilnya mengejutkan. Beberapa pekerjaan hebat telah mulai dibagikan di Reddit. Lihat foto-fotonya pada postingan dibawah yang menunjukkan gambar yang dimasukkan ke dalam DreamBooth dan gambar palsu realistis dari Difusi Stabil.

Kita tidak bisa lagi mempercayai mata kita, tetapi kita mungkin masih bisa mempercayai mata para ahli forensik, setidaknya untuk saat ini. Sangat mungkin bahwa sistem masa depan dapat dengan sengaja dilatih untuk menipu mereka juga.

Kami dengan cepat bergerak ke era di mana fotografi dan bahkan video yang sempurna akan menjadi hal biasa. Waktu akan memberi tahu betapa pentingnya hal ini, tetapi sementara itu perlu diingat pelajaran dari foto-foto Peri Cottingley—terkadang orang hanya ingin percaya, bahkan dalam kepalsuan yang nyata.![]()

Artikel ini diterbitkan kembali dari Percakapan di bawah lisensi Creative Commons. Membaca Artikel asli.

Gambar Kredit: Brendan Murphy / author disediakan