Hari ini, kami sangat gembira mengumumkan kemampuan untuk menyempurnakan model Code Llama dengan menggunakan Meta Mulai Lompatan Amazon SageMaker. Keluarga model bahasa besar (LLM) Code Llama adalah kumpulan model pembuatan kode yang telah dilatih dan disempurnakan dengan skala mulai dari 7 miliar hingga 70 miliar parameter. Model Code Llama yang disempurnakan memberikan akurasi dan penjelasan yang lebih baik dibandingkan model Code Llama dasar, sebagaimana terbukti dalam pengujiannya terhadap Evaluasi Manusia dan kumpulan data MBPP. Anda dapat menyempurnakan dan menerapkan model Code Llama dengan SageMaker JumpStart menggunakan Studio Amazon SageMaker UI dengan beberapa klik atau menggunakan SageMaker Python SDK. Penyempurnaan model Llama didasarkan pada skrip yang disediakan di repo GitHub resep llama dari Meta menggunakan teknik kuantisasi PyTorch FSDP, PEFT/LoRA, dan Int8.

Dalam postingan ini, kita akan mempelajari cara menyempurnakan model terlatih Code Llama melalui SageMaker JumpStart melalui pengalaman UI dan SDK sekali klik yang tersedia berikut ini Repositori GitHub.

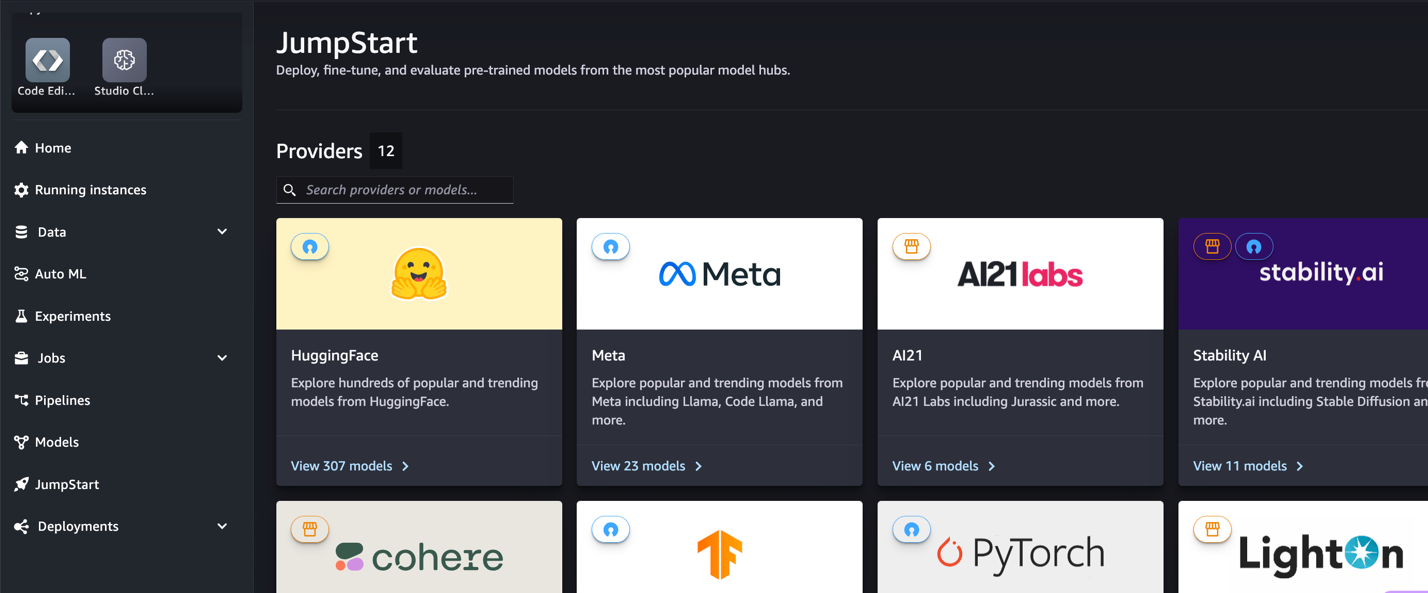

Apa itu SageMaker JumpStart

Dengan SageMaker JumpStart, praktisi pembelajaran mesin (ML) dapat memilih dari beragam pilihan model dasar yang tersedia untuk umum. Praktisi ML dapat menerapkan model dasar ke model khusus Amazon SageMaker instans dari lingkungan yang terisolasi jaringan dan sesuaikan model menggunakan SageMaker untuk pelatihan dan penerapan model.

Apa itu Kode Llama

Code Llama adalah versi khusus kode Lama 2 yang dibuat dengan melatih lebih lanjut Llama 2 pada kumpulan data khusus kode dan mengambil sampel lebih banyak data dari kumpulan data yang sama dalam jangka waktu yang lebih lama. Code Llama menampilkan kemampuan pengkodean yang ditingkatkan. Ini dapat menghasilkan kode dan bahasa alami tentang kode, baik dari kode maupun perintah bahasa alami (misalnya, “Tuliskan saya fungsi yang menghasilkan deret Fibonacci”). Anda juga dapat menggunakannya untuk penyelesaian kode dan debugging. Ini mendukung banyak bahasa pemrograman paling populer yang digunakan saat ini, termasuk Python, C++, Java, PHP, TypeScript (JavaScript), C#, Bash, dan banyak lagi.

Mengapa menyempurnakan model Code Llama

Meta menerbitkan tolok ukur kinerja Code Llama pada HumanEval dan MBPP untuk bahasa pengkodean umum seperti Python, Java, dan JavaScript. Performa model Code Llama Python di HumanEval menunjukkan performa yang bervariasi di berbagai bahasa pengkodean dan tugas mulai dari 38% pada model Python 7B hingga 57% pada model Python 70B. Selain itu, model Code Llama yang disempurnakan pada bahasa pemrograman SQL telah menunjukkan hasil yang lebih baik, sebagaimana terlihat dalam tolok ukur evaluasi SQL. Tolok ukur yang dipublikasikan ini menyoroti manfaat potensial dari penyempurnaan model Code Llama, memungkinkan kinerja, penyesuaian, dan adaptasi yang lebih baik terhadap domain dan tugas pengkodean tertentu.

Penyempurnaan tanpa kode melalui UI SageMaker Studio

Untuk mulai menyempurnakan model Llama Anda menggunakan SageMaker Studio, selesaikan langkah-langkah berikut:

- Di konsol SageMaker Studio, pilih Tingkatkan di panel navigasi.

Anda akan menemukan daftar lebih dari 350 model mulai dari model open source dan proprietary.

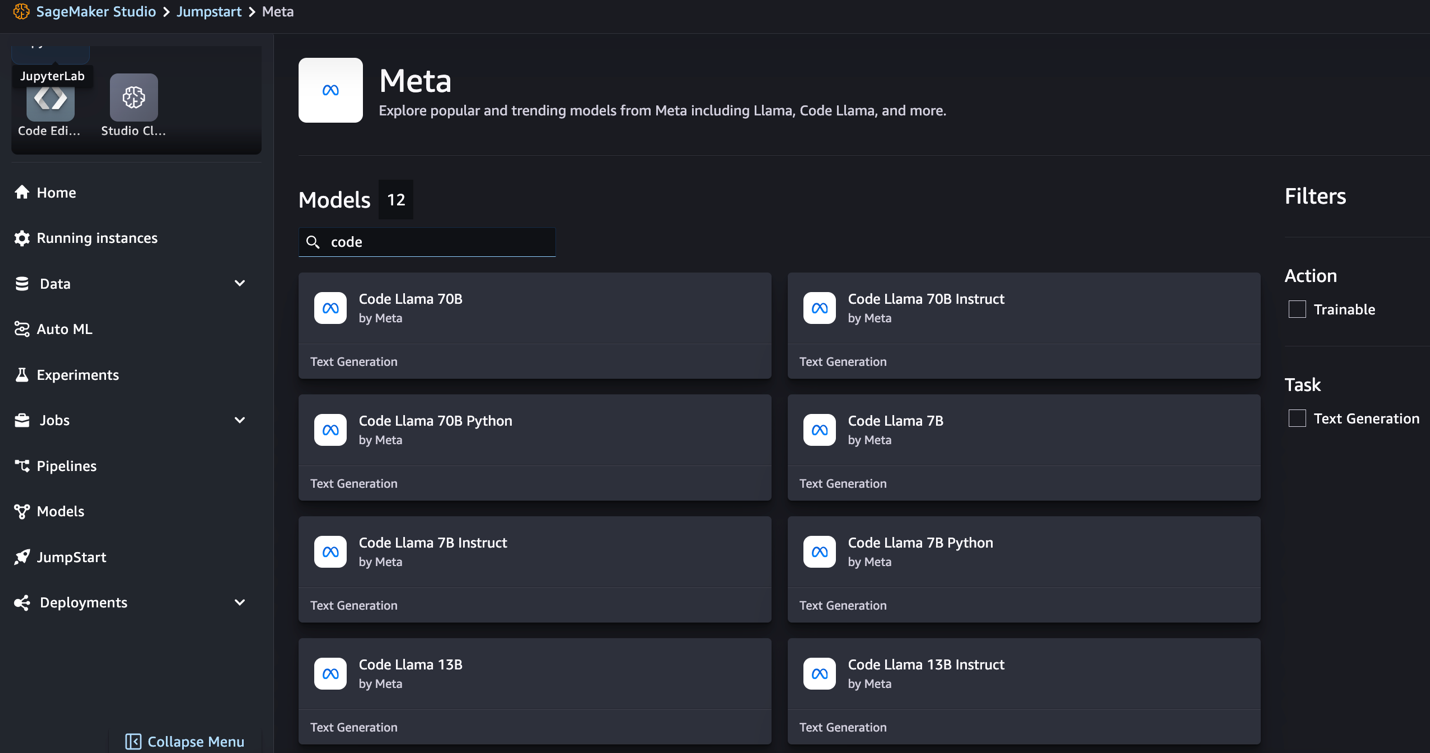

- Cari model Kode Llama.

Jika Anda tidak melihat model Code Llama, Anda dapat memperbarui versi SageMaker Studio dengan mematikan dan memulai ulang. Untuk informasi lebih lanjut tentang pembaruan versi, lihat Matikan dan Perbarui Aplikasi Studio. Anda juga dapat menemukan varian model lainnya dengan memilih Jelajahi semua Model Pembuatan Kode atau mencari Kode Llama di kotak pencarian.

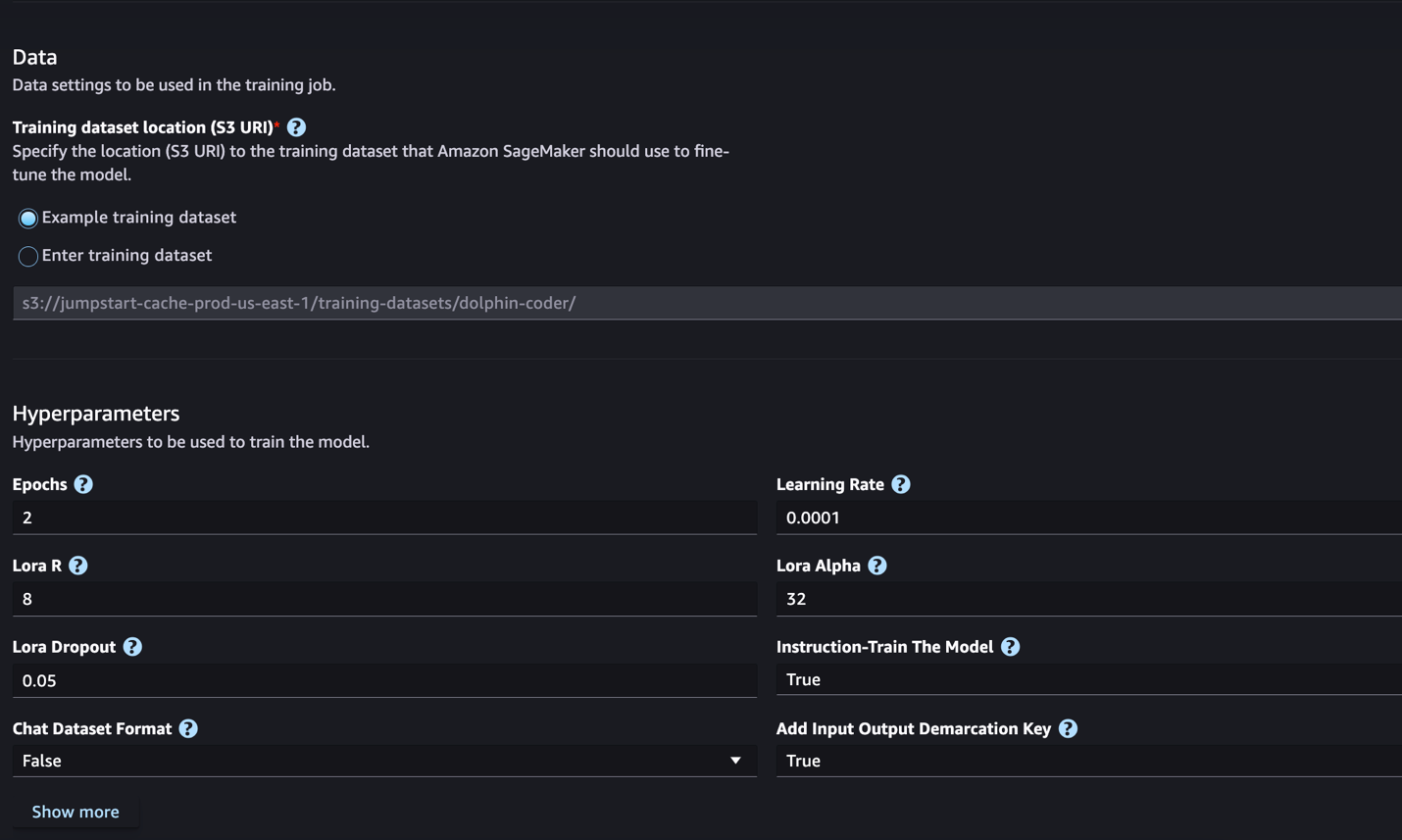

SageMaker JumpStart saat ini mendukung penyempurnaan instruksi untuk model Code Llama. Tangkapan layar berikut menunjukkan halaman penyesuaian untuk model Code Llama 2 70B.

- Untuk Lokasi set data pelatihan, Anda dapat menunjuk ke Layanan Penyimpanan Sederhana Amazon (Amazon S3) yang berisi kumpulan data pelatihan dan validasi untuk penyesuaian.

- Tetapkan konfigurasi penerapan, hyperparameter, dan pengaturan keamanan Anda untuk penyesuaian.

- Pilih Pelatihan VE untuk memulai pekerjaan penyesuaian pada instans SageMaker ML.

Kami membahas format kumpulan data yang perlu Anda persiapkan untuk penyesuaian instruksi di bagian berikutnya.

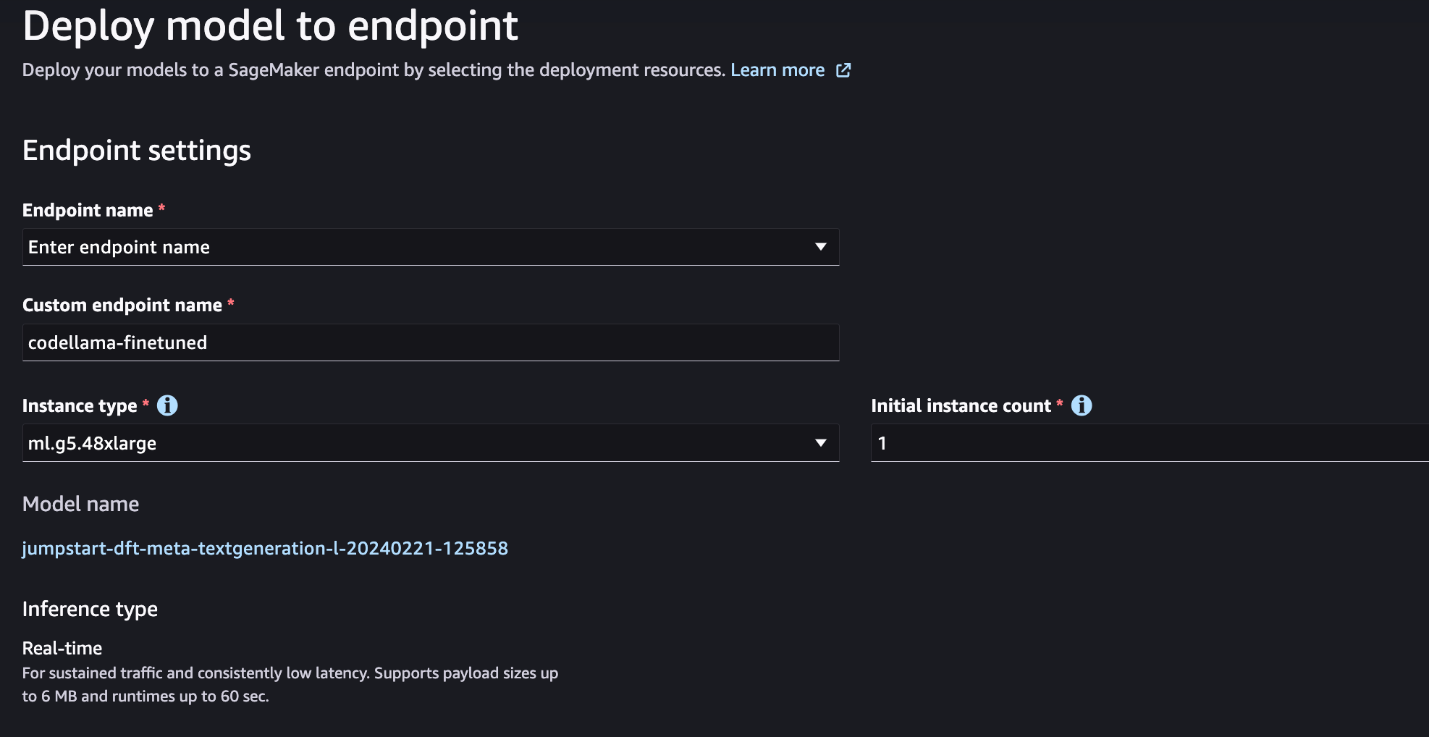

- Setelah model disetel dengan baik, Anda dapat menerapkannya menggunakan halaman model di SageMaker JumpStart.

Opsi untuk menyebarkan model yang telah disempurnakan akan muncul setelah penyesuaian selesai, seperti yang ditunjukkan pada gambar layar berikut.

Sempurnakan melalui SageMaker Python SDK

Di bagian ini, kami mendemonstrasikan cara menyempurnakan model Code LIama menggunakan SageMaker Python SDK pada kumpulan data berformat instruksi. Secara khusus, model ini disesuaikan untuk serangkaian tugas pemrosesan bahasa alami (NLP) yang dijelaskan menggunakan instruksi. Hal ini membantu meningkatkan performa model untuk tugas yang tidak terlihat dengan perintah zero-shot.

Selesaikan langkah-langkah berikut untuk menyelesaikan pekerjaan penyesuaian Anda. Anda bisa mendapatkan seluruh kode penyesuaian dari Repositori GitHub.

Pertama, mari kita lihat format kumpulan data yang diperlukan untuk penyesuaian instruksi. Data pelatihan harus diformat dalam format baris JSON (.jsonl), dengan setiap baris merupakan kamus yang mewakili sampel data. Semua data pelatihan harus berada dalam satu folder. Namun, itu dapat disimpan dalam beberapa file .jsonl. Berikut ini contoh format baris JSON:

Folder pelatihan dapat berisi a template.json file yang menjelaskan format input dan output. Berikut contoh templatnya:

Untuk mencocokkan templat, setiap sampel dalam file baris JSON harus disertakan system_prompt, question, dan response bidang. Dalam demonstrasi ini, kami menggunakan Kumpulan data Dolphin Coder dari Memeluk Wajah.

Setelah Anda menyiapkan himpunan data dan mengunggahnya ke bucket S3, Anda dapat mulai melakukan penyesuaian menggunakan kode berikut:

Anda dapat menerapkan model yang telah disempurnakan langsung dari estimator, seperti yang ditunjukkan dalam kode berikut. Untuk lebih jelasnya lihat buku catatan di Repositori GitHub.

Teknik penyempurnaan

Model bahasa seperti Llama berukuran lebih dari 10 GB atau bahkan 100 GB. Menyempurnakan model besar seperti itu memerlukan instans dengan memori CUDA yang sangat tinggi. Selain itu, pelatihan model ini bisa sangat lambat karena ukuran modelnya. Oleh karena itu, untuk penyesuaian yang efisien, kami menggunakan pengoptimalan berikut:

- Adaptasi Tingkat Rendah (LoRA) – Ini adalah jenis penyempurnaan efisien parameter (PEFT) untuk penyempurnaan efisien pada model besar. Dengan metode ini, Anda membekukan keseluruhan model dan hanya menambahkan sekumpulan kecil parameter atau lapisan yang dapat disesuaikan ke dalam model. Misalnya, daripada melatih seluruh 7 miliar parameter untuk Llama 2 7B, Anda dapat menyempurnakan kurang dari 1% parameter. Hal ini membantu mengurangi kebutuhan memori secara signifikan karena Anda hanya perlu menyimpan gradien, status pengoptimal, dan informasi terkait pelatihan lainnya hanya untuk 1% parameter. Selain itu, ini membantu mengurangi waktu pelatihan serta biaya. Untuk rincian lebih lanjut tentang metode ini, lihat LoRA: Adaptasi Peringkat Rendah dari Model Bahasa Besar.

- kuantisasi Int8 – Bahkan dengan optimasi seperti LoRA, model seperti Llama 70B masih terlalu besar untuk dilatih. Untuk mengurangi jejak memori selama pelatihan, Anda dapat menggunakan kuantisasi Int8 selama pelatihan. Kuantisasi biasanya mengurangi ketepatan tipe data floating point. Meskipun hal ini mengurangi memori yang diperlukan untuk menyimpan bobot model, hal ini menurunkan kinerja karena hilangnya informasi. Kuantisasi Int8 hanya menggunakan presisi seperempat tetapi tidak menyebabkan penurunan kinerja karena tidak menghilangkan sedikit pun. Ini membulatkan data dari satu tipe ke tipe lainnya. Untuk mempelajari tentang kuantisasi Int8, lihat LLM.int8(): Perkalian Matriks 8-bit untuk Transformer dalam Skala Besar.

- Paralel Data Terpecah Sepenuhnya (FSDP) – Ini adalah jenis algoritme pelatihan paralel data yang membagi parameter model ke seluruh pekerja paralel data dan secara opsional dapat memindahkan sebagian komputasi pelatihan ke CPU. Meskipun parameternya dibagi ke beberapa GPU yang berbeda, komputasi setiap microbatch bersifat lokal bagi pekerja GPU. Ini memecah parameter secara lebih seragam dan mencapai performa optimal melalui komunikasi dan komputasi yang tumpang tindih selama pelatihan.

Tabel berikut merangkum detail masing-masing model dengan pengaturan berbeda.

| Model | Setingan awal | LORA + FSDP | LORA + Tanpa FSDP | Kuantisasi Int8 + LORA + Tanpa FSDP |

| Kode Llama 2 7B | LORA + FSDP | Yes | Yes | Yes |

| Kode Llama 2 13B | LORA + FSDP | Yes | Yes | Yes |

| Kode Llama 2 34B | INT8 + LORA + TANPA FSDP | Tidak | Tidak | Yes |

| Kode Llama 2 70B | INT8 + LORA + TANPA FSDP | Tidak | Tidak | Yes |

Penyempurnaan model Llama didasarkan pada skrip yang disediakan berikut ini GitHub repo.

Hyperparameter yang didukung untuk pelatihan

Penyempurnaan kode Llama 2 mendukung sejumlah hyperparameter, yang masing-masing dapat memengaruhi kebutuhan memori, kecepatan pelatihan, dan performa model yang disempurnakan:

- masa – Jumlah lintasan yang dilakukan algoritme penyesuaian melalui kumpulan data pelatihan. Harus berupa bilangan bulat yang lebih besar dari 1. Standarnya adalah 5.

- tingkat_belajar – Kecepatan pembaruan bobot model setelah mengerjakan setiap batch contoh pelatihan. Harus berupa float positif yang lebih besar dari 0. Defaultnya adalah 1e-4.

- instruksi_disetel – Apakah akan melatih model secara instruksi atau tidak. Harus

TrueorFalse. Default-nya adalahFalse. - per_device_train_batch_size – Ukuran batch per inti GPU/CPU untuk pelatihan. Harus berupa bilangan bulat positif. Standarnya adalah 4.

- per_device_eval_batch_size – Ukuran batch per inti GPU/CPU untuk evaluasi. Harus berupa bilangan bulat positif. Standarnya adalah 1.

- max_train_samples – Untuk tujuan debugging atau pelatihan yang lebih cepat, potong jumlah contoh pelatihan ke nilai ini. Nilai -1 berarti menggunakan semua sampel pelatihan. Harus berupa bilangan bulat positif atau -1. Standarnya adalah -1.

- max_val_samples – Untuk tujuan debugging atau pelatihan yang lebih cepat, potong jumlah contoh validasi ke nilai ini. Nilai -1 berarti menggunakan seluruh sampel validasi. Harus berupa bilangan bulat positif atau -1. Standarnya adalah -1.

- max_input_length – Total panjang urutan input maksimum setelah tokenisasi. Urutan yang lebih panjang dari ini akan terpotong. Jika -1,

max_input_lengthdiatur ke minimum 1024 dan panjang model maksimum yang ditentukan oleh tokenizer. Jika disetel ke nilai positif,max_input_lengthdiatur ke nilai minimum yang diberikan danmodel_max_lengthditentukan oleh tokenizer. Harus berupa bilangan bulat positif atau -1. Standarnya adalah -1. - validasi_split_ratio – Jika saluran validasi adalah

none, rasio pemisahan validasi kereta dari data kereta harus antara 0–1. Standarnya adalah 0.2. - train_data_split_seed – Jika data validasi tidak ada, tindakan ini akan memperbaiki pemisahan acak data pelatihan masukan menjadi data pelatihan dan validasi yang digunakan oleh algoritme. Harus bilangan bulat. Standarnya adalah 0.

- preprocessing_num_workers – Jumlah proses yang digunakan untuk prapemrosesan. Jika

None, proses utama digunakan untuk preprocessing. Standarnya adalahNone. - lora_r – Lora R. Harus bilangan bulat positif. Standarnya adalah 8.

- lora_alpha – Lora Alfa. Harus berupa bilangan bulat positif. Standarnya adalah 32

- lora_putus sekolah – Lora Putus Sekolah. harus berupa float positif antara 0 dan 1. Standarnya adalah 0.05.

- int8_quantisasi - Jika

True, model dimuat dengan presisi 8-bit untuk pelatihan. Default untuk 7B dan 13B adalahFalse. Default untuk 70B adalahTrue. - aktifkan_fsdp – Jika Benar, pelatihan menggunakan FSDP. Default untuk 7B dan 13B adalah Benar. Default untuk 70B adalah False. Perhatikan itu

int8_quantizationtidak didukung dengan FSDP.

Saat memilih hyperparameter, pertimbangkan hal berikut:

- Pengaturan

int8_quantization=Truemengurangi kebutuhan memori dan menghasilkan pelatihan yang lebih cepat. - Penurunan

per_device_train_batch_sizedanmax_input_lengthmengurangi kebutuhan memori dan oleh karena itu dapat dijalankan pada instance yang lebih kecil. Namun, menetapkan nilai yang sangat rendah dapat menambah waktu pelatihan. - Jika Anda tidak menggunakan kuantisasi Int8 (

int8_quantization=False), gunakan FSDP (enable_fsdp=True) untuk pelatihan yang lebih cepat dan efisien.

Jenis instans yang didukung untuk pelatihan

Tabel berikut merangkum jenis instans yang didukung untuk melatih berbagai model.

| Model | Jenis Instans Default | Jenis Instans yang Didukung |

| Kode Llama 2 7B | ml.g5.12xbesar |

ml.g5.12xbesar, ml.g5.24xbesar, ml.g5.48xbesar, ml.p3dn.24xbesar, ml.g4dn.12xlarge |

| Kode Llama 2 13B | ml.g5.12xbesar |

ml.g5.24xbesar, ml.g5.48xbesar, ml.p3dn.24xbesar, ml.g4dn.12xlarge |

| Kode Llama 2 70B | ml.g5.48xbesar |

ml.g5.48xbesar ml.p4d.24xbesar |

Saat memilih jenis instans, pertimbangkan hal berikut:

- Instans G5 memberikan pelatihan paling efisien di antara jenis instans yang didukung. Oleh karena itu, jika Anda memiliki instans G5, Anda harus menggunakannya.

- Waktu pelatihan sangat bergantung pada jumlah GPU dan memori CUDA yang tersedia. Oleh karena itu, pelatihan pada instans dengan jumlah GPU yang sama (misalnya, ml.g5.2xlarge dan ml.g5.4xlarge) kurang lebih sama. Oleh karena itu, Anda dapat menggunakan instance yang lebih murah untuk pelatihan (ml.g5.2xlarge).

- Saat menggunakan instans p3, pelatihan akan dilakukan dengan presisi 32-bit karena bfloat16 tidak didukung pada instans ini. Oleh karena itu, tugas pelatihan akan mengonsumsi dua kali lipat jumlah memori CUDA saat pelatihan pada instans p3 dibandingkan dengan instans g5.

Untuk mempelajari tentang biaya pelatihan per instans, lihat Contoh Amazon EC2 G5.

Evaluasi

Evaluasi adalah langkah penting untuk menilai kinerja model yang telah disesuaikan. Kami menyajikan evaluasi kualitatif dan kuantitatif untuk menunjukkan peningkatan model yang telah disesuaikan dibandingkan model yang tidak telah disesuaikan. Dalam evaluasi kualitatif, kami menunjukkan contoh tanggapan dari model yang telah disesuaikan dan yang belum disesuaikan. Dalam evaluasi kuantitatif, kami menggunakan Evaluasi Manusia, rangkaian pengujian yang dikembangkan oleh OpenAI untuk menghasilkan kode Python guna menguji kemampuan dalam menghasilkan hasil yang benar dan akurat. Repositori HumanEval berada di bawah lisensi MIT. Kami menyempurnakan varian Python dari semua model Kode LIama dengan ukuran berbeda (Kode LIama Python 7B, 13B, 34B, dan 70B di Kumpulan data Dolphin Coder), dan sajikan hasil evaluasi pada bagian berikut.

Evaluasi secara kualitatif

Dengan penerapan model yang telah disesuaikan, Anda dapat mulai menggunakan titik akhir untuk menghasilkan kode. Dalam contoh berikut, kami menyajikan respons dari varian Python Code LIama 34B dasar dan yang telah disempurnakan pada sampel pengujian di Kumpulan data Dolphin Coder:

Model Code Llama yang disempurnakan, selain menyediakan kode untuk kueri sebelumnya, menghasilkan penjelasan mendetail tentang pendekatan dan kode semu.

Kode Llama 34b Respons Python yang Tidak Diselesaikan:

Kode Llama 34B Respons Python yang Disempurnakan

Kebenaran dasar

Menariknya, versi Code Llama 34B Python kami yang telah disempurnakan memberikan solusi berbasis pemrograman dinamis untuk substring palindromik terpanjang, yang berbeda dari solusi yang diberikan dalam kebenaran dasar dari contoh pengujian yang dipilih. Model kami yang telah disempurnakan menjelaskan dan menjelaskan solusi berbasis pemrograman dinamis secara mendetail. Di sisi lain, model yang tidak disesuaikan akan berhalusinasi tentang keluaran potensial tepat setelahnya print pernyataan (ditampilkan di sel kiri) karena output axyzzyx bukan palindrom terpanjang dalam string tertentu. Dalam hal kompleksitas waktu, solusi pemrograman dinamis umumnya lebih baik daripada pendekatan awal. Solusi pemrograman dinamis memiliki kompleksitas waktu O(n^2), di mana n adalah panjang string masukan. Hal ini lebih efisien dibandingkan solusi awal dari model yang tidak disempurnakan, yang juga memiliki kompleksitas waktu kuadrat O(n^2) namun dengan pendekatan yang kurang optimal.

Ini terlihat menjanjikan! Ingat, kami hanya menyempurnakan varian Code LIama Python dengan 10% dari varian tersebut Kumpulan data Dolphin Coder. Masih banyak lagi yang bisa dijelajahi!

Meskipun ada instruksi menyeluruh dalam responsnya, kami masih perlu memeriksa kebenaran kode Python yang disediakan dalam solusi. Selanjutnya, kita menggunakan kerangka evaluasi yang disebut Evaluasi Manusia untuk menjalankan pengujian integrasi pada respons yang dihasilkan dari Kode LIama untuk memeriksa kualitasnya secara sistematis.

Evaluasi kuantitatif dengan HumanEval

HumanEval adalah alat evaluasi untuk mengevaluasi kemampuan pemecahan masalah LLM pada masalah pengkodean berbasis Python, seperti yang dijelaskan dalam makalah Mengevaluasi Model Bahasa Besar yang Dilatih tentang Kode. Secara khusus, ini terdiri dari 164 masalah pemrograman asli berbasis Python yang menilai kemampuan model bahasa untuk menghasilkan kode berdasarkan informasi yang diberikan seperti tanda tangan fungsi, docstring, body, dan pengujian unit.

Untuk setiap pertanyaan pemrograman berbasis Python, kami mengirimkannya ke model Code LIama yang diterapkan pada titik akhir SageMaker untuk mendapatkan k respons. Selanjutnya, kami menjalankan setiap respons k pada pengujian integrasi di repositori HumanEval. Jika ada respons dari k respons yang lolos uji integrasi, kami menghitung kasus uji tersebut berhasil; jika tidak, gagal. Kemudian kami ulangi proses untuk menghitung rasio kasus yang berhasil sebagai nama skor evaluasi akhir pass@k. Mengikuti praktik standar, kami menetapkan k sebagai 1 dalam evaluasi kami, untuk hanya menghasilkan satu respons per pertanyaan dan menguji apakah respons tersebut lolos uji integrasi.

Berikut ini adalah contoh kode untuk menggunakan repositori HumanEval. Anda dapat mengakses himpunan data dan menghasilkan respons tunggal menggunakan titik akhir SageMaker. Untuk lebih jelasnya lihat buku catatan di Repositori GitHub.

Tabel berikut menunjukkan peningkatan model Code LIama Python yang telah disempurnakan dibandingkan model yang tidak disempurnakan pada berbagai ukuran model. Untuk memastikan kebenarannya, kami juga menerapkan model Code LIama yang tidak disempurnakan di titik akhir SageMaker dan menjalankannya melalui evaluasi Human Eval. Itu lulus@1 nomor (baris pertama pada tabel berikut) cocok dengan nomor yang dilaporkan di Makalah penelitian Kode Llama. Parameter inferensi secara konsisten ditetapkan sebagai "parameters": {"max_new_tokens": 384, "temperature": 0.2}.

Seperti yang dapat kita lihat dari hasilnya, semua varian Code LIama Python yang telah disempurnakan menunjukkan peningkatan yang signifikan dibandingkan model yang tidak disempurnakan. Secara khusus, Code LIama Python 70B mengungguli model yang tidak disempurnakan sekitar 12%.

| . | 7B Piton | 13B Piton | 34B | 34B Piton | 70B Piton |

| Performa model terlatih (lulus@1) | 38.4 | 43.3 | 48.8 | 53.7 | 57.3 |

| Performa model yang disempurnakan (pass@1) | 45.12 | 45.12 | 59.1 | 61.5 | 69.5 |

Sekarang Anda dapat mencoba menyempurnakan model Code LIama pada kumpulan data Anda sendiri.

Membersihkan

Jika Anda memutuskan tidak ingin lagi menjalankan titik akhir SageMaker, Anda dapat menghapusnya menggunakan AWS SDK untuk Python (Boto3), Antarmuka Baris Perintah AWS (AWS CLI), atau konsol SageMaker. Untuk informasi lebih lanjut, lihat Hapus Titik Akhir dan Sumber Daya. Selain itu, Anda bisa matikan sumber daya SageMaker Studio yang tidak diperlukan lagi.

Kesimpulan

Dalam postingan ini, kita membahas menyempurnakan model Code Llama 2 Meta menggunakan SageMaker JumpStart. Kami menunjukkan bahwa Anda dapat menggunakan konsol SageMaker JumpStart di SageMaker Studio atau SageMaker Python SDK untuk menyempurnakan dan menerapkan model ini. Kami juga membahas teknik penyesuaian, jenis instans, dan hyperparameter yang didukung. Selain itu, kami menguraikan rekomendasi untuk pelatihan yang dioptimalkan berdasarkan berbagai tes yang kami lakukan. Seperti yang dapat kita lihat dari hasil penyesuaian tiga model pada dua kumpulan data, penyesuaian meningkatkan peringkasan dibandingkan dengan model yang tidak disempurnakan. Sebagai langkah selanjutnya, Anda dapat mencoba menyempurnakan model ini pada kumpulan data Anda sendiri menggunakan kode yang disediakan di repositori GitHub untuk menguji dan membuat tolok ukur hasil untuk kasus penggunaan Anda.

Tentang Penulis

Dr Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Dr Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Vishaal Yalamanchali adalah Arsitek Solusi Startup yang bekerja dengan perusahaan AI generatif, robotika, dan kendaraan otonom tahap awal. Vishaal bekerja dengan pelanggannya untuk memberikan solusi ML mutakhir dan secara pribadi tertarik pada pembelajaran penguatan, evaluasi LLM, dan pembuatan kode. Sebelum bekerja di AWS, Vishaal adalah seorang sarjana di UCI, dengan fokus pada bioinformatika dan sistem cerdas.

Vishaal Yalamanchali adalah Arsitek Solusi Startup yang bekerja dengan perusahaan AI generatif, robotika, dan kendaraan otonom tahap awal. Vishaal bekerja dengan pelanggannya untuk memberikan solusi ML mutakhir dan secara pribadi tertarik pada pembelajaran penguatan, evaluasi LLM, dan pembuatan kode. Sebelum bekerja di AWS, Vishaal adalah seorang sarjana di UCI, dengan fokus pada bioinformatika dan sistem cerdas.

Meenakshisundaram Thandavarayan bekerja untuk AWS sebagai Spesialis AI/ML. Dia memiliki hasrat untuk merancang, membuat, dan mempromosikan pengalaman data dan analitik yang berpusat pada manusia. Meena berfokus pada pengembangan sistem berkelanjutan yang memberikan keunggulan kompetitif dan terukur bagi pelanggan strategis AWS. Meena adalah seorang penghubung dan pemikir desain, dan berupaya mendorong bisnis ke cara kerja baru melalui inovasi, inkubasi, dan demokratisasi.

Meenakshisundaram Thandavarayan bekerja untuk AWS sebagai Spesialis AI/ML. Dia memiliki hasrat untuk merancang, membuat, dan mempromosikan pengalaman data dan analitik yang berpusat pada manusia. Meena berfokus pada pengembangan sistem berkelanjutan yang memberikan keunggulan kompetitif dan terukur bagi pelanggan strategis AWS. Meena adalah seorang penghubung dan pemikir desain, dan berupaya mendorong bisnis ke cara kerja baru melalui inovasi, inkubasi, dan demokratisasi.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

Dr Ashish Khetan adalah Ilmuwan Terapan Senior dengan algoritme bawaan Amazon SageMaker dan membantu mengembangkan algoritme pembelajaran mesin. Ia mendapatkan gelar PhD dari University of Illinois Urbana-Champaign. Dia adalah peneliti aktif dalam pembelajaran mesin dan inferensi statistik, dan telah menerbitkan banyak makalah di konferensi NeurIPS, ICML, ICLR, JMLR, ACL, dan EMNLP.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/fine-tune-code-llama-on-amazon-sagemaker-jumpstart/

- :memiliki

- :adalah

- :bukan

- :Di mana

- 1

- 10

- 100

- 12

- 13

- 14

- 16

- 20

- 27

- 2D

- 350

- 7

- 70

- 8

- a

- kemampuan

- kemampuan

- Tentang Kami

- Setuju

- mengakses

- ketepatan

- tepat

- Mencapai

- di seluruh

- aktif

- adaptasi

- menambahkan

- tambahan

- Selain itu

- disesuaikan

- keuntungan

- Setelah

- terhadap

- AI

- algoritma

- algoritma

- Semua

- alfa

- sudah

- juga

- Meskipun

- Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Amazon Web Services

- antara

- jumlah

- an

- analisis

- analisis

- dan

- Mengumumkan

- Lain

- menjawab

- Apa pun

- muncul

- terapan

- pendekatan

- sekitar

- ADALAH

- DAERAH

- AS

- menilai

- At

- otonom

- tersedia

- AWS

- BAB

- mendasarkan

- berdasarkan

- menampar

- BE

- karena

- menjadi

- di belakang

- patokan

- Benchmark

- Manfaat

- Lebih baik

- antara

- Besar

- Milyar

- bit

- tubuh

- kedua

- Kedua sisi

- Kotak

- Istirahat

- luas

- built-in

- bisnis

- tapi

- by

- C + +

- menghitung

- bernama

- CAN

- Bisa Dapatkan

- kemampuan

- kemampuan

- dilakukan

- kasus

- kasus

- sel

- perubahan

- mengubah

- Saluran

- karakter

- karakter

- mengobrol

- murah

- memeriksa

- memeriksa

- Cek

- Pilih

- memilih

- cli

- kekelompokan

- pembinaan

- kode

- pembuat kode

- Pengkodean

- koleksi

- Umum

- Komunikasi

- Perusahaan

- dibandingkan

- kompetitif

- lengkap

- penyelesaian

- kompleksitas

- komputasi

- konferensi

- konfigurasi

- berturut-turut

- Mempertimbangkan

- secara konsisten

- Terdiri dari

- terdiri

- konsul

- memakan

- mengandung

- benar

- Biaya

- menghitung

- membuat

- dibuat

- terbaru

- Sekarang

- pelanggan

- kustomisasi

- menyesuaikan

- canggih

- data

- kumpulan data

- memutuskan

- mengurangi

- menurun

- dedicated

- mendalam

- belajar mendalam

- Default

- didefinisikan

- menyampaikan

- demokratisasi

- mendemonstrasikan

- menunjukkan

- demonstrasi

- tergantung

- menyebarkan

- dikerahkan

- penyebaran

- Berasal

- dijelaskan

- menggambarkan

- Mendesain

- rinci

- terperinci

- rincian

- mengembangkan

- dikembangkan

- berkembang

- berbeda

- digit

- ukuran

- langsung

- membahas

- dibahas

- Tidak

- domain

- dilakukan

- Dont

- dua kali lipat

- turun

- mendorong

- Menjatuhkan

- dua

- selama

- dinamis

- setiap

- tahap awal

- efisiensi

- efisien

- antara

- memungkinkan

- akhir

- akhir

- Titik akhir

- Inggris

- ditingkatkan

- memastikan

- Seluruh

- Lingkungan Hidup

- sama

- mengevaluasi

- evaluasi

- evaluasi

- Bahkan

- jelas

- memeriksa

- contoh

- contoh

- gembira

- Lihat lebih lanjut

- pengalaman

- Pengalaman

- Menjelaskan

- Menjelaskan

- penjelasan

- Menghadapi

- Gagal

- palsu

- keluarga

- lebih cepat

- FB

- Fitur

- beberapa

- fibonacci

- Fields

- File

- File

- mengisi

- terakhir

- Akhirnya

- Menemukan

- Pertama

- tetap

- Mengapung

- mengambang

- Fokus

- terfokus

- berfokus

- berikut

- Tapak

- Untuk

- format

- Prinsip Dasar

- Kerangka

- Membekukan

- dari

- fungsi

- lebih lanjut

- Selanjutnya

- umumnya

- menghasilkan

- dihasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- mendapatkan

- GitHub

- diberikan

- memberikan

- mendapat

- GPU

- GPU

- gradien

- lebih besar

- Tanah

- memiliki

- tangan

- memanfaatkan

- Memiliki

- he

- membantu

- High

- Menyoroti

- -nya

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTML

- http

- HTTPS

- manusia

- i

- identik

- if

- Illinois

- Dampak

- mengimpor

- penting

- memperbaiki

- perbaikan

- perbaikan

- meningkatkan

- in

- memasukkan

- Termasuk

- Meningkatkan

- kenaikan

- INKUBASI

- indeks

- Indeks

- informasi

- mulanya

- Innovation

- memasukkan

- install

- contoh

- sebagai gantinya

- instruksi

- integrasi

- Cerdas

- tertarik

- kepentingan

- ke

- terpencil

- IT

- iterasi

- perulangan

- NYA

- Jawa

- JavaScript

- Pekerjaan

- jpeg

- jpg

- json

- Menjaga

- terus

- bahasa

- Bahasa

- besar

- sebagian besar

- Terakhir

- lapisan

- Memimpin

- BELAJAR

- pengetahuan

- meninggalkan

- Panjang

- kurang

- Lisensi

- 'like'

- baris

- baris

- Daftar

- Llama

- LLM

- lokal

- lagi

- melihat

- mencari

- TERLIHAT

- lepas

- Lot

- Rendah

- mesin

- Mesin belajar

- Utama

- mempertahankan

- membuat

- banyak

- Cocok

- cocok

- korek api

- Matriks

- maksimum

- Mungkin..

- me

- cara

- Memori

- meta

- metode

- minimum

- MIT

- ML

- model

- model

- lebih

- lebih efisien

- paling

- Paling Populer

- beberapa

- harus

- Bernama

- Alam

- Pengolahan Bahasa alami

- Navigasi

- Perlu

- jaringan

- tak pernah

- New

- berikutnya

- nLP

- tidak

- mencatat

- buku catatan

- jumlah

- nomor

- of

- on

- ONE

- yang

- hanya

- Buka

- open source

- OpenAI

- optimisasi

- dioptimalkan

- pilihan

- or

- urutan

- asli

- Lainnya

- jika tidak

- kami

- di luar

- diuraikan

- Mengungguli

- keluaran

- output

- lebih

- sendiri

- halaman

- pane

- kertas

- dokumen

- Paralel

- parameter

- parameter

- bagian

- tertentu

- melewati

- gairah

- untuk

- prestasi

- Sendiri

- phd

- PHP

- plato

- Kecerdasan Data Plato

- Data Plato

- silahkan

- Titik

- Populer

- positif

- Pos

- potensi

- praktek

- mendahului

- Ketelitian

- Mempersiapkan

- menyajikan

- Sebelumnya

- Masalah

- pemecahan masalah

- masalah

- proses

- proses

- pengolahan

- memproduksi

- Pemrograman

- bahasa pemrograman

- mendorong

- meminta

- hak milik

- memberikan

- disediakan

- menyediakan

- menyediakan

- di depan umum

- diterbitkan

- tujuan

- Ular sanca

- pytorch

- kuadrat

- kualitatif

- kualitas

- kuantitatif

- Perempat

- pertanyaan

- pertanyaan

- lebih cepat

- R

- acak

- mulai

- Penilaian

- perbandingan

- tercapai

- Mencapai

- alasan

- rekomendasi

- mengurangi

- pengurangan

- lihat

- yang tersisa

- ingat

- ulangi

- Dilaporkan

- gudang

- mewakili

- wajib

- kebutuhan

- membutuhkan

- penelitian

- peneliti

- tanggapan

- tanggapan

- mengakibatkan

- Hasil

- kembali

- Pengembalian

- benar

- robotika

- kuat

- kira-kira

- putaran

- BARIS

- kerajaan

- Run

- berjalan

- s

- pembuat bijak

- sama

- mencicipi

- disimpan

- terukur

- Skala

- ilmuwan

- skor

- script

- SDK

- Pencarian

- mencari

- Bagian

- bagian

- keamanan

- melihat

- terpilih

- seleksi

- mengirim

- senior

- Urutan

- Seri

- Seri A

- Layanan

- set

- set

- pengaturan

- pengaturan

- pecah

- harus

- Menunjukkan

- menunjukkan

- ditunjukkan

- Pertunjukkan

- mematikan

- Sisi

- tanda tangan

- penting

- signifikan

- Sederhana

- hanya

- tunggal

- Ukuran

- ukuran

- lambat

- kecil

- lebih kecil

- So

- Masyarakat

- larutan

- Solusi

- beberapa

- sumber

- spesialis

- tertentu

- Secara khusus

- kecepatan

- membagi

- standar

- awal

- Mulai

- startup

- Pernyataan

- Negara

- statistik

- Langkah

- Tangga

- Masih

- Berhenti

- penyimpanan

- menyimpan

- Strategis

- Tali

- berusaha

- studio

- berhasil

- sukses

- seperti itu

- rangkaian

- Didukung

- Mendukung

- berkelanjutan

- sistem

- tabel

- Dibutuhkan

- tugas

- teknik

- teknik

- Template

- istilah

- uji

- pengujian

- tes

- dari

- bahwa

- Grafik

- Daerah

- Mereka

- kemudian

- Sana.

- karena itu

- Ini

- pemikir

- ini

- teliti

- tiga

- Melalui

- waktu

- untuk

- hari ini

- Tokenisasi

- terlalu

- Total

- jalur

- Pelatihan VE

- terlatih

- Pelatihan

- transformer

- benar

- kebenaran

- mencoba

- dua

- mengetik

- jenis

- Naskah

- khas

- ui

- bawah

- satuan

- universitas

- sampai

- Memperbarui

- diperbarui

- Pembaruan

- us

- menggunakan

- bekas

- kegunaan

- menggunakan

- sah

- pengesahan

- nilai

- Nilai - Nilai

- Varian

- berbagai

- bervariasi

- kendaraan

- versi

- sangat

- melalui

- berjalan

- ingin

- adalah

- cara

- we

- jaringan

- layanan web

- BAIK

- ketika

- apakah

- yang

- sementara

- seluruh

- akan

- dengan

- tanpa

- pekerja

- pekerja

- kerja

- bekerja

- Kamu

- Anda

- zephyrnet.dll