Di dunia streaming yang dinamis Amazon Music, setiap penelusuran lagu, podcast, atau playlist menyimpan cerita, suasana hati, atau luapan emosi yang menunggu untuk diungkapkan. Pencarian ini berfungsi sebagai pintu gerbang menuju penemuan baru, pengalaman berharga, dan kenangan abadi. Bilah pencarian bukan hanya tentang menemukan lagu; ini tentang jutaan pengguna aktif yang memulai perjalanan pribadi mereka ke dunia yang kaya dan beragam yang ditawarkan Amazon Music.

Memberikan pengalaman pelanggan yang unggul untuk langsung menemukan musik yang dicari pengguna memerlukan platform yang cerdas dan responsif. Amazon Music menggunakan kekuatan AI untuk mencapai hal ini. Namun, mengoptimalkan pengalaman pelanggan sambil mengelola biaya pelatihan dan inferensi model AI yang mendukung kemampuan bilah pencarian, seperti pemeriksaan ejaan dan pencarian vektor secara real-time, sulit dilakukan pada saat lalu lintas puncak.

Amazon SageMaker menyediakan serangkaian layanan menyeluruh yang memungkinkan Amazon Music membangun, melatih, dan menerapkan di AWS Cloud dengan sedikit usaha. Dengan menangani pekerjaan berat yang tidak dapat dibedakan, SageMaker memungkinkan Anda fokus mengerjakan model pembelajaran mesin (ML), dan tidak mengkhawatirkan hal-hal seperti infrastruktur. Sebagai bagian dari model tanggung jawab bersama, SageMaker memastikan bahwa layanan yang mereka berikan dapat diandalkan, berperforma tinggi, dan terukur, sementara Anda memastikan penerapan model ML memanfaatkan kemampuan yang disediakan SageMaker sebaik-baiknya.

Dalam postingan ini, kami menelusuri perjalanan yang dilakukan Amazon Music untuk mengoptimalkan kinerja dan biaya menggunakan SageMaker dan NVIDIA Triton Inference Server serta TensorRT. Kami menyelami lebih dalam untuk menunjukkan cara kerja bilah pencarian yang tampaknya sederhana namun rumit, memastikan perjalanan tanpa henti ke dunia Amazon Music dengan penundaan kesalahan ketik yang membuat frustrasi dan hasil pencarian real-time yang relevan.

Amazon SageMaker dan NVIDIA: Menghadirkan kemampuan pencarian vektor dan pemeriksaan ejaan yang cepat dan akurat

Amazon Music menawarkan perpustakaan luas yang berisi lebih dari 100 juta lagu dan jutaan episode podcast. Namun, menemukan lagu atau podcast yang tepat bisa jadi sulit, terutama jika Anda tidak mengetahui judul, artis, atau nama album secara pasti, atau kueri penelusurannya sangat luas, seperti “podcast berita”.

Amazon Music telah mengambil pendekatan dua arah untuk meningkatkan proses pencarian dan pengambilan. Langkah pertama adalah memperkenalkan penelusuran vektor (juga dikenal sebagai pengambilan berbasis penyematan), sebuah teknik ML yang dapat membantu pengguna menemukan konten paling relevan yang mereka cari dengan menggunakan semantik konten. Langkah kedua melibatkan pengenalan model Koreksi Ejaan berbasis Transformer di tumpukan pencarian. Hal ini dapat sangat membantu ketika mencari musik, karena pengguna mungkin tidak selalu mengetahui ejaan yang tepat dari judul lagu atau nama artis. Koreksi ejaan dapat membantu pengguna menemukan musik yang mereka cari meskipun mereka membuat kesalahan ejaan dalam kueri penelusurannya.

Memperkenalkan model Transformer dalam alur pencarian dan pengambilan (dalam pembuatan penyematan kueri yang diperlukan untuk pencarian vektor dan model Transformer Seq2Seq generatif dalam Koreksi Ejaan) dapat menyebabkan peningkatan latensi keseluruhan yang signifikan, sehingga berdampak negatif pada pengalaman pelanggan. Oleh karena itu, menjadi prioritas utama bagi kami untuk mengoptimalkan latensi inferensi real-time untuk model penelusuran vektor dan koreksi ejaan.

Amazon Music dan NVIDIA telah bekerja sama untuk menghadirkan pengalaman pelanggan terbaik ke bilah pencarian, menggunakan SageMaker untuk menerapkan kemampuan pemeriksaan ejaan yang cepat dan akurat serta saran pencarian semantik waktu nyata menggunakan teknik berbasis pencarian vektor. Solusinya mencakup penggunaan hosting SageMaker yang didukung oleh instans G5 yang menggunakan GPU NVIDIA A10G Tensor Core, NVIDIA Triton Inference Server Container yang didukung SageMaker, dan NVIDIA TensorRT format model. Dengan mengurangi latensi inferensi model pemeriksaan ejaan menjadi 25 milidetik pada lalu lintas puncak, dan mengurangi latensi pembuatan penyematan kueri penelusuran rata-rata sebesar 63% dan biaya sebesar 73% dibandingkan dengan inferensi berbasis CPU, Amazon Music telah meningkatkan kinerja bilah pencarian.

Selain itu, saat melatih model AI untuk memberikan hasil yang akurat, Amazon Music mencapai akselerasi 12 kali lipat dalam waktu pelatihan untuk model transformator korektor ejaan urutan-ke-urutan BART, sehingga menghemat waktu dan uang, dengan mengoptimalkan penggunaan GPU.

Amazon Music bermitra dengan NVIDIA untuk memprioritaskan pengalaman pencarian pelanggan dan membuat bilah pencarian dengan fungsi pemeriksaan ejaan dan pencarian vektor yang dioptimalkan dengan baik. Di bagian berikut, kami berbagi lebih banyak tentang bagaimana pengoptimalan ini diatur.

Mengoptimalkan pelatihan dengan GPU NVIDIA Tensor Core

Mendapatkan akses ke GPU NVIDIA Tensor Core untuk pelatihan model bahasa besar tidaklah cukup untuk mencapai potensi sebenarnya. Ada langkah-langkah pengoptimalan utama yang harus dilakukan selama pelatihan untuk memaksimalkan pemanfaatan GPU sepenuhnya. Namun, penggunaan GPU yang kurang pasti akan menyebabkan penggunaan sumber daya yang tidak efisien, durasi pelatihan yang berkepanjangan, dan peningkatan biaya operasional.

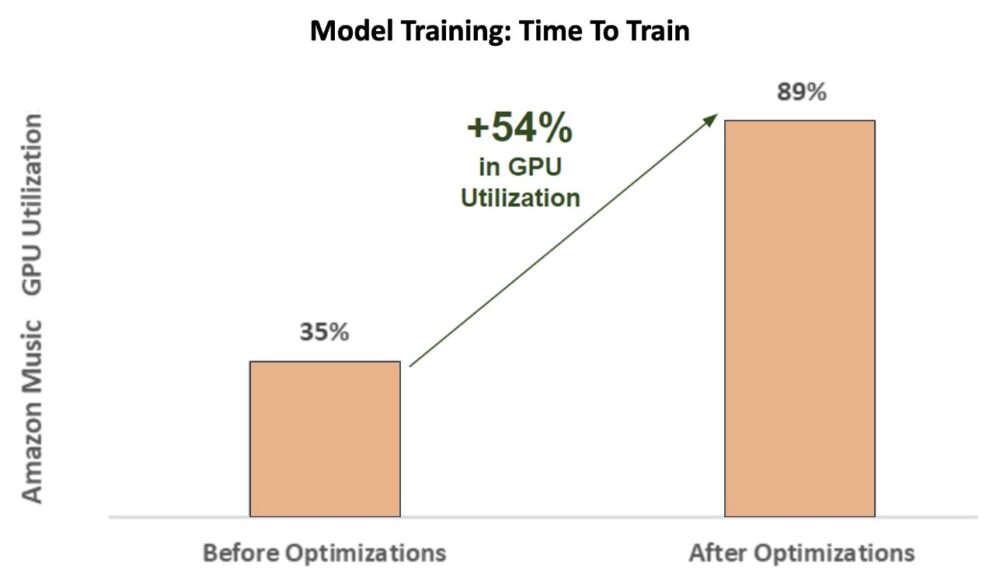

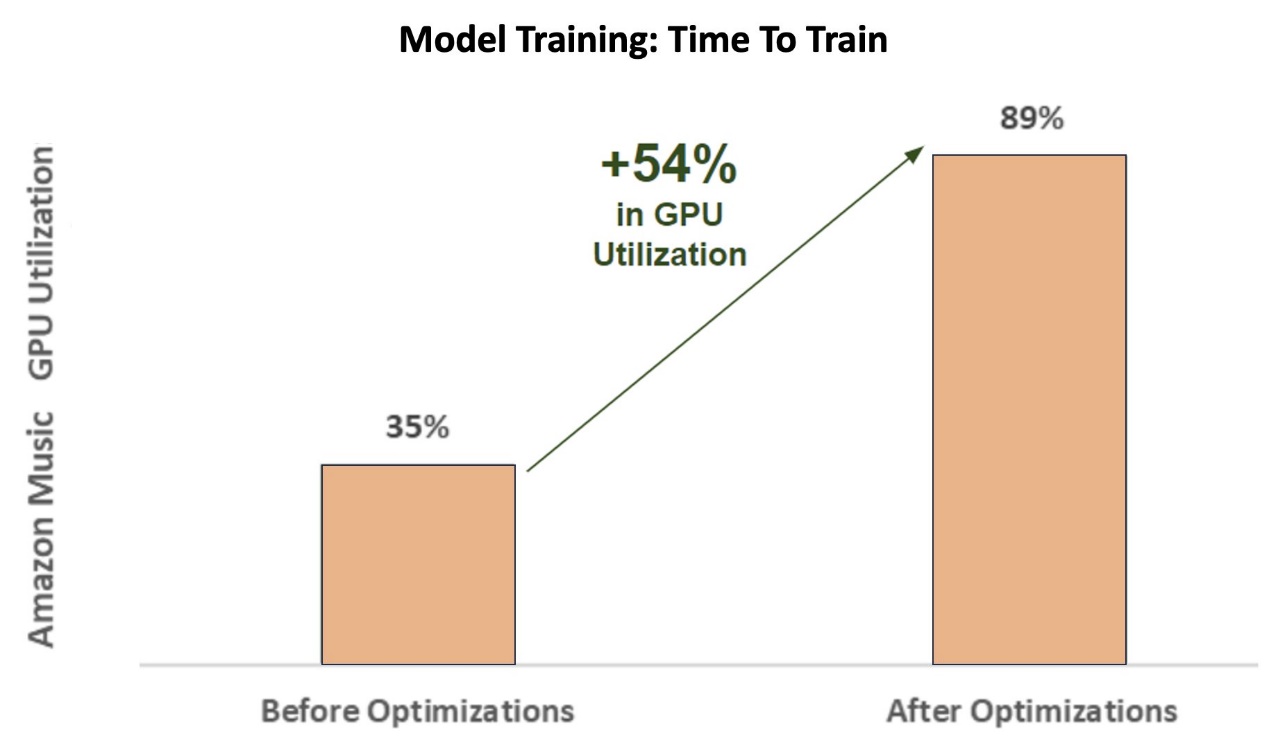

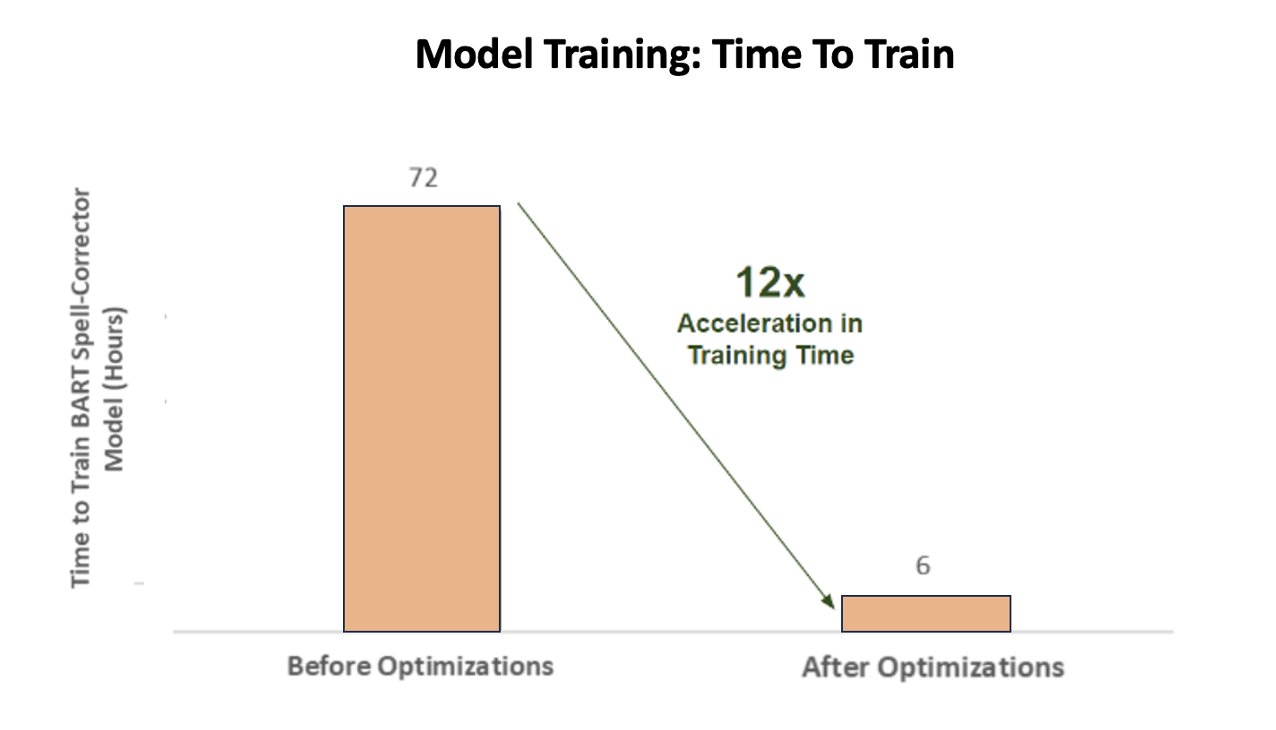

Selama fase awal pelatihan korektor ejaan BART (basis bart) model transformator pada instans SageMaker ml.p3.24xlarge (8 GPU NVIDIA V100 Tensor Core), pemanfaatan GPU Amazon Music sekitar 35%. Untuk memaksimalkan manfaat pelatihan akselerasi GPU NVIDIA, AWS dan arsitek solusi NVIDIA mendukung Amazon Music dalam mengidentifikasi area untuk pengoptimalan, khususnya seputar ukuran batch dan parameter presisi. Kedua parameter penting ini memengaruhi efisiensi, kecepatan, dan akurasi pelatihan model pembelajaran mendalam.

Pengoptimalan yang dihasilkan menghasilkan pemanfaatan GPU V100 yang baru dan lebih baik, stabil di sekitar 89%, sehingga secara drastis mengurangi waktu pelatihan Amazon Music dari 3 hari menjadi 5–6 jam. Dengan mengganti ukuran batch dari 32 menjadi 256 dan menggunakan teknik pengoptimalan seperti berlari pelatihan presisi campuran otomatis alih-alih hanya menggunakan presisi FP32, Amazon Music mampu menghemat waktu dan uang.

Bagan berikut menggambarkan peningkatan 54% poin persentase dalam pemanfaatan GPU setelah pengoptimalan.

Gambar berikut menggambarkan percepatan waktu pelatihan.

Peningkatan ukuran batch ini memungkinkan GPU NVIDIA memproses lebih banyak data secara signifikan secara bersamaan di beberapa Tensor Core, sehingga mempercepat waktu pelatihan. Namun, penting untuk menjaga keseimbangan memori, karena ukuran batch yang lebih besar memerlukan lebih banyak memori. Meningkatkan ukuran batch dan menggunakan presisi campuran merupakan hal yang sangat penting dalam memaksimalkan kekuatan GPU NVIDIA Tensor Core.

Setelah model dilatih untuk melakukan konvergensi, tiba waktunya untuk mengoptimalkan penerapan inferensi di bilah pencarian Amazon Music.

Koreksi Ejaan: inferensi model BART

Dengan bantuan instans SageMaker G5 dan NVIDIA Triton Inference Server (perangkat lunak penyajian inferensi sumber terbuka), serta NVIDIA TensorRT, sebuah SDK untuk inferensi pembelajaran mendalam berkinerja tinggi yang mencakup pengoptimal inferensi dan waktu proses, Amazon Music membatasi BART pemeriksaan ejaan mereka (basis bart) memodelkan latensi inferensi server menjadi hanya 25 milidetik pada lalu lintas puncak. Ini termasuk overhead seperti penyeimbangan beban, prapemrosesan, inferensi model, dan waktu pascapemrosesan.

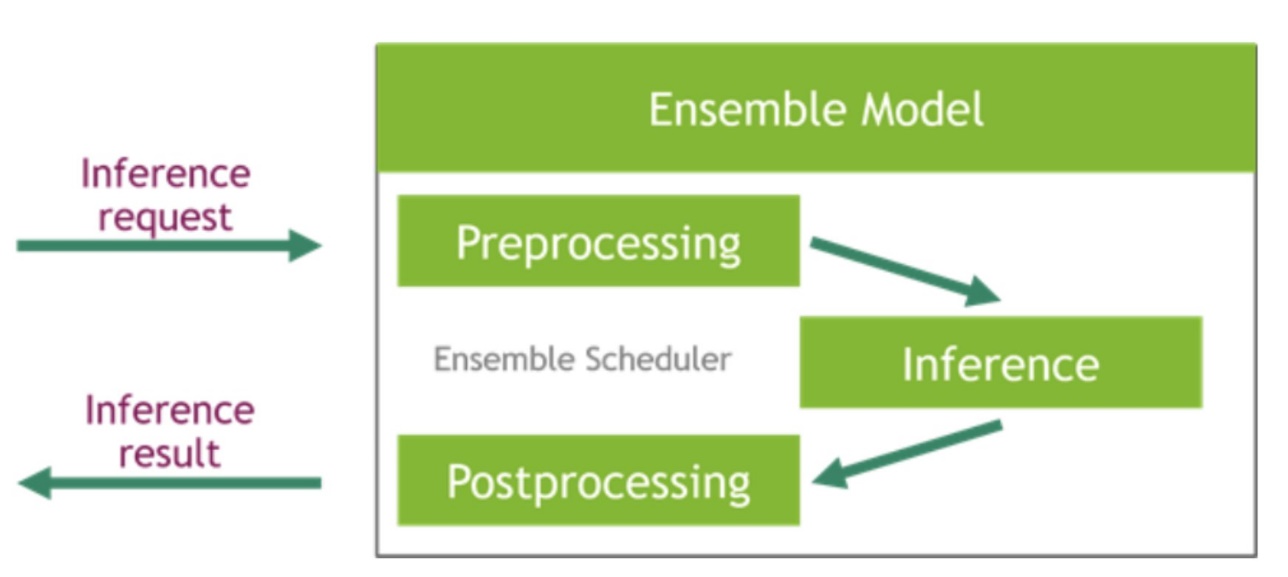

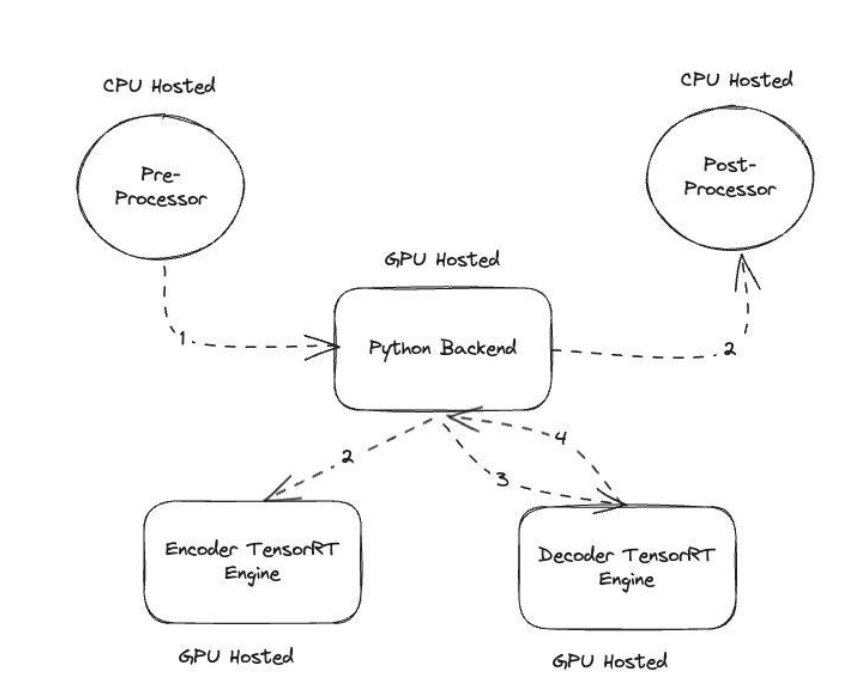

NVIDIA Triton Inference Server menyediakan dua jenis backend yang berbeda: satu untuk model hosting pada GPU, dan backend Python tempat Anda dapat membawa kode khusus Anda sendiri untuk digunakan dalam langkah prapemrosesan dan pascapemrosesan. Gambar berikut menggambarkan skema ansambel model.

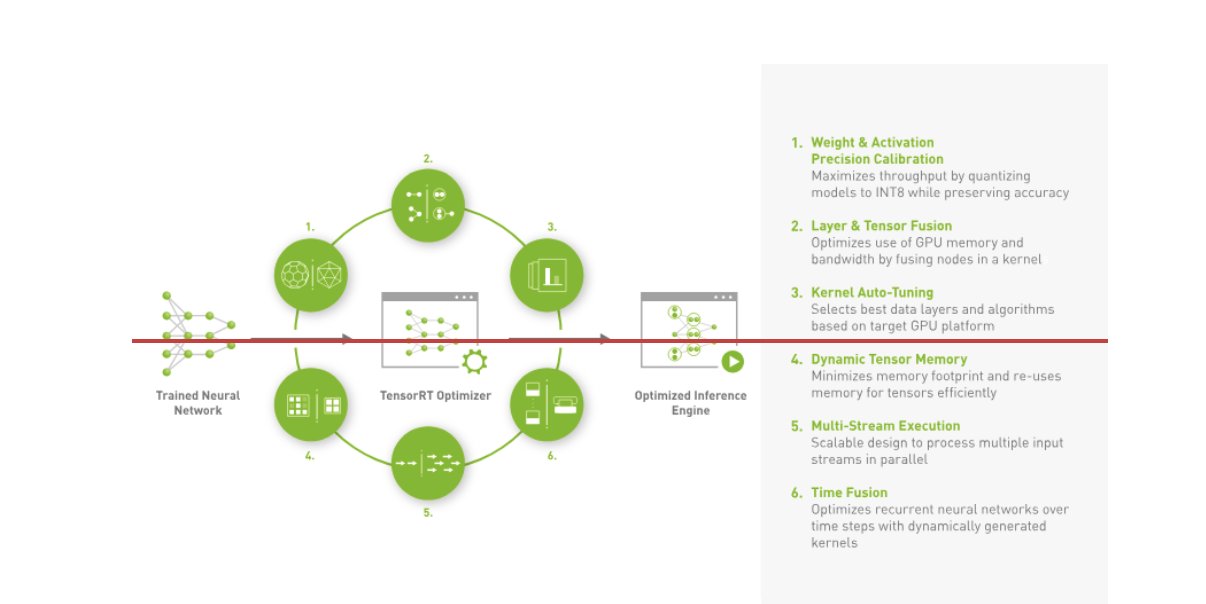

Amazon Music membangun BART-nya pipa inferensi dengan menjalankan langkah prapemrosesan (tokenisasi teks) dan pascapemrosesan (token ke teks) pada CPU, sedangkan langkah eksekusi model berjalan pada GPU Inti Tensor NVIDIA A10G. Backend Python berada di tengah-tengah langkah prapemrosesan dan pascapemrosesan, dan bertanggung jawab untuk berkomunikasi dengan model BART yang dikonversi TensorRT serta jaringan encoder/decoder. TensorRT meningkatkan kinerja inferensi dengan kalibrasi presisi, fusi lapisan dan tensor, penyetelan otomatis kernel, memori tensor dinamis, eksekusi multi-aliran, dan fusi waktu.

Gambar berikut mengilustrasikan desain tingkat tinggi dari modul utama yang membentuk alur inferensi model BART korektor ejaan.

Pencarian vektor: Inferensi model BERT kalimat yang menyematkan kueri

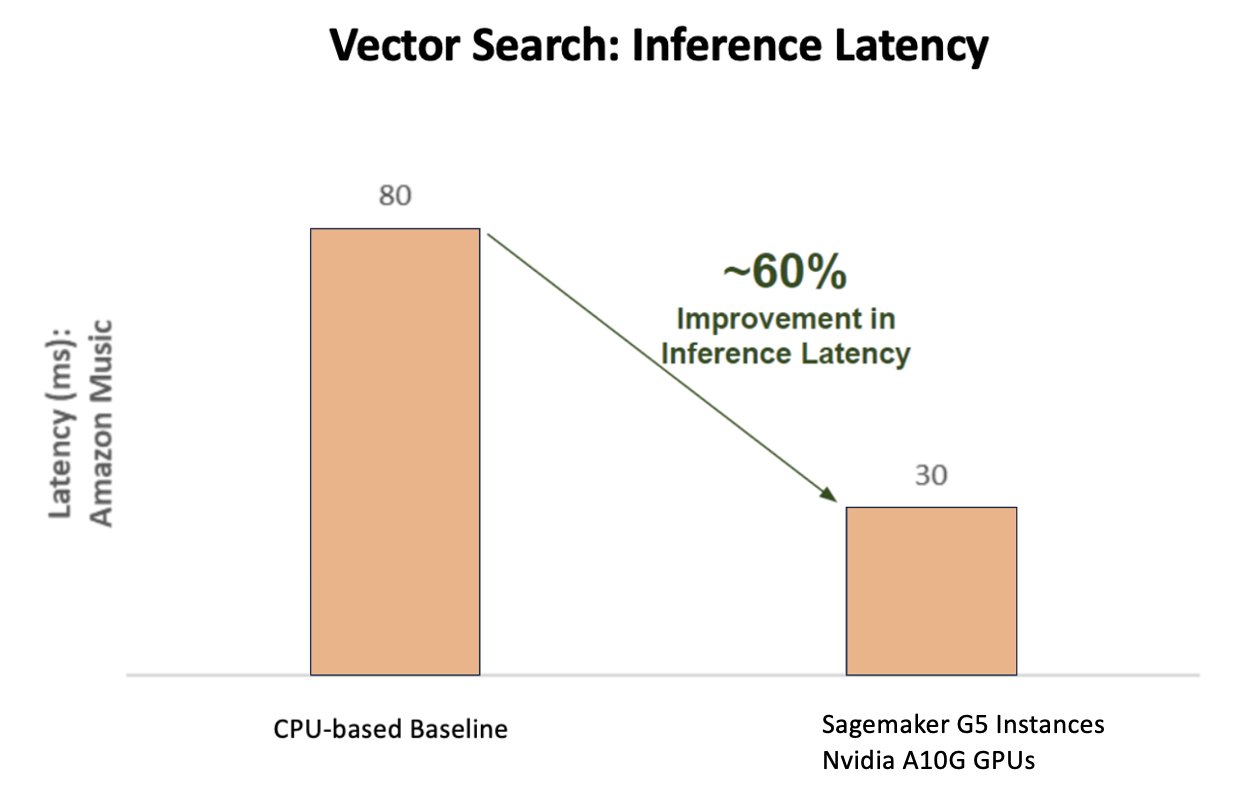

Bagan berikut mengilustrasikan peningkatan latensi sebesar 60% (melayani p90 800–900 TPS) saat menggunakan Platform Inferensi AI NVIDIA dibandingkan dengan garis dasar berbasis CPU.

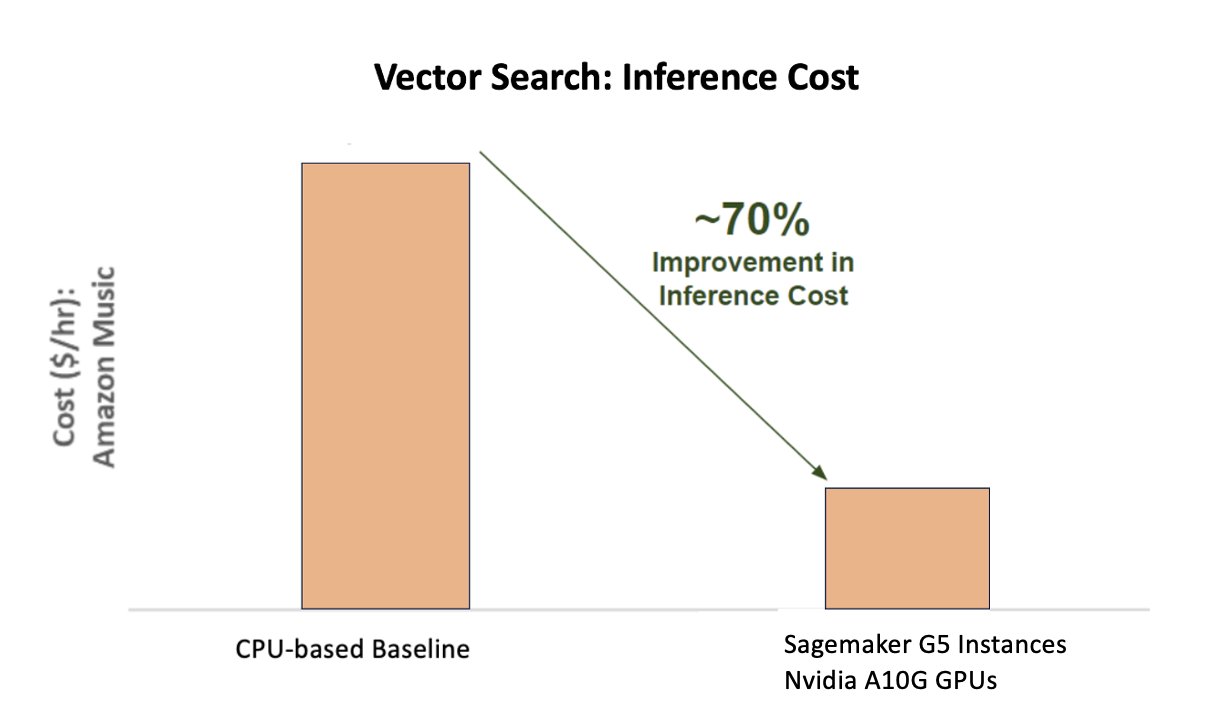

Bagan berikut menunjukkan peningkatan biaya sebesar 70% saat menggunakan Platform Inferensi AI NVIDIA dibandingkan dengan dasar berbasis CPU.

Gambar berikut mengilustrasikan SDK untuk inferensi deep learning berperforma tinggi. Ini mencakup pengoptimal inferensi pembelajaran mendalam dan waktu proses yang memberikan latensi rendah dan throughput tinggi untuk aplikasi inferensi.

Untuk mencapai hasil ini, Amazon Music bereksperimen dengan beberapa parameter penerapan Triton yang berbeda Penganalisis Model Triton, alat yang membantu menemukan konfigurasi model NVIDIA Triton terbaik untuk menerapkan inferensi yang efisien. Untuk mengoptimalkan inferensi model, Triton menawarkan fitur seperti batching dinamis dan eksekusi model bersamaan, serta memiliki dukungan kerangka kerja untuk kemampuan fleksibilitas lainnya. Pengelompokan dinamis mengumpulkan permintaan inferensi, mengelompokkannya secara mulus ke dalam kelompok untuk memaksimalkan throughput, sekaligus memastikan respons real-time untuk pengguna Amazon Music. Kemampuan eksekusi model secara bersamaan semakin meningkatkan performa inferensi dengan menghosting banyak salinan model pada GPU yang sama. Terakhir, dengan memanfaatkan Penganalisis Model Triton, Amazon Music dapat secara hati-hati menyempurnakan parameter hosting inferensi batching dan model konkurensi dinamis untuk menemukan pengaturan optimal yang memaksimalkan kinerja inferensi menggunakan lalu lintas simulasi.

Kesimpulan

Mengoptimalkan konfigurasi dengan Triton Inference Server dan TensorRT di SageMaker memungkinkan Amazon Music mencapai hasil luar biasa untuk pelatihan dan pipeline inferensi. Platform SageMaker adalah platform terbuka menyeluruh untuk AI produksi, memberikan waktu yang cepat untuk menilai dan keserbagunaan untuk mendukung semua kasus penggunaan AI utama baik di perangkat keras maupun perangkat lunak. Dengan mengoptimalkan pemanfaatan GPU V100 untuk pelatihan dan beralih dari CPU ke instans G5 menggunakan GPU NVIDIA A10G Tensor Core, serta dengan menggunakan perangkat lunak NVIDIA yang dioptimalkan seperti Triton Inference Server dan TensorRT, perusahaan seperti Amazon Music dapat menghemat waktu dan uang sekaligus meningkatkan kinerja di keduanya pelatihan dan inferensi, yang secara langsung menghasilkan pengalaman pelanggan yang lebih baik dan biaya pengoperasian yang lebih rendah.

SageMaker menangani tugas berat yang tidak dapat dibedakan untuk pelatihan dan hosting ML, memungkinkan Amazon Music menghadirkan operasi ML yang andal dan dapat diskalakan di perangkat keras dan perangkat lunak.

Kami mendorong Anda untuk memeriksa apakah beban kerja Anda dioptimalkan menggunakan SageMaker dengan selalu mengevaluasi pilihan perangkat keras dan perangkat lunak Anda untuk melihat apakah ada cara agar Anda dapat mencapai kinerja yang lebih baik dengan penurunan biaya.

Untuk mempelajari lebih lanjut tentang NVIDIA AI di AWS, lihat yang berikut:

Tentang penulis

Siddharth Sharma adalah Pimpinan Teknologi Pembelajaran Mesin di tim Sains & Pemodelan di Amazon Music. Ia berspesialisasi dalam masalah pemodelan terkait Pencarian, Pengambilan, Pemeringkatan, dan NLP. Siddharth memiliki latar belakang yang kaya dalam menangani masalah pembelajaran mesin berskala besar yang sensitif terhadap latensi, misalnya Penargetan Iklan, Pengambilan Multi Modal, Pemahaman Kueri Penelusuran, dll. Sebelum bekerja di Amazon Music, Siddharth bekerja di perusahaan seperti Meta, Walmart Labs, Rakuten tentang Masalah ML yang berpusat pada E-Commerce. Siddharth menghabiskan sebagian awal karirnya bekerja dengan startup teknologi iklan di wilayah teluk.

Siddharth Sharma adalah Pimpinan Teknologi Pembelajaran Mesin di tim Sains & Pemodelan di Amazon Music. Ia berspesialisasi dalam masalah pemodelan terkait Pencarian, Pengambilan, Pemeringkatan, dan NLP. Siddharth memiliki latar belakang yang kaya dalam menangani masalah pembelajaran mesin berskala besar yang sensitif terhadap latensi, misalnya Penargetan Iklan, Pengambilan Multi Modal, Pemahaman Kueri Penelusuran, dll. Sebelum bekerja di Amazon Music, Siddharth bekerja di perusahaan seperti Meta, Walmart Labs, Rakuten tentang Masalah ML yang berpusat pada E-Commerce. Siddharth menghabiskan sebagian awal karirnya bekerja dengan startup teknologi iklan di wilayah teluk.

Tarun Sharma adalah Manajer Pengembangan Perangkat Lunak yang memimpin Relevansi Pencarian Musik Amazon. Tim ilmuwan dan insinyur ML-nya bertanggung jawab untuk memberikan hasil pencarian yang relevan secara kontekstual dan dipersonalisasi kepada pelanggan Amazon Music.

Tarun Sharma adalah Manajer Pengembangan Perangkat Lunak yang memimpin Relevansi Pencarian Musik Amazon. Tim ilmuwan dan insinyur ML-nya bertanggung jawab untuk memberikan hasil pencarian yang relevan secara kontekstual dan dipersonalisasi kepada pelanggan Amazon Music.

James Taman adalah Arsitek Solusi di Amazon Web Services. Dia bekerja dengan Amazon.com untuk merancang, membangun, dan menerapkan solusi teknologi di AWS, dan memiliki minat khusus pada AI dan pembelajaran mesin. Di waktu senggangnya, dia senang mencari budaya baru, pengalaman baru, dan tetap up to date dengan tren teknologi terkini. Anda dapat menemukannya di LinkedIn.

James Taman adalah Arsitek Solusi di Amazon Web Services. Dia bekerja dengan Amazon.com untuk merancang, membangun, dan menerapkan solusi teknologi di AWS, dan memiliki minat khusus pada AI dan pembelajaran mesin. Di waktu senggangnya, dia senang mencari budaya baru, pengalaman baru, dan tetap up to date dengan tren teknologi terkini. Anda dapat menemukannya di LinkedIn.

Kshitiz Gupta adalah Arsitek Solusi di NVIDIA. Dia senang mendidik pelanggan cloud tentang teknologi GPU AI yang ditawarkan NVIDIA dan membantu mereka mempercepat pembelajaran mesin dan aplikasi pembelajaran mendalam mereka. Di luar pekerjaan, ia menikmati lari, hiking, dan mengamati satwa liar.

Kshitiz Gupta adalah Arsitek Solusi di NVIDIA. Dia senang mendidik pelanggan cloud tentang teknologi GPU AI yang ditawarkan NVIDIA dan membantu mereka mempercepat pembelajaran mesin dan aplikasi pembelajaran mendalam mereka. Di luar pekerjaan, ia menikmati lari, hiking, dan mengamati satwa liar.

Jia Hong Liu adalah Arsitek Solusi di tim Penyedia Layanan Cloud di NVIDIA. Dia membantu klien dalam mengadopsi pembelajaran mesin dan solusi AI yang memanfaatkan komputasi akselerasi NVIDIA untuk mengatasi tantangan pelatihan dan inferensi mereka. Di waktu senggang, ia menikmati origami, proyek DIY, dan bermain basket.

Jia Hong Liu adalah Arsitek Solusi di tim Penyedia Layanan Cloud di NVIDIA. Dia membantu klien dalam mengadopsi pembelajaran mesin dan solusi AI yang memanfaatkan komputasi akselerasi NVIDIA untuk mengatasi tantangan pelatihan dan inferensi mereka. Di waktu senggang, ia menikmati origami, proyek DIY, dan bermain basket.

Tugrul Konuk adalah Arsitek Solusi Senior di NVIDIA, yang berspesialisasi dalam pelatihan skala besar, pembelajaran mendalam multimodal, dan komputasi ilmiah berkinerja tinggi. Sebelum bergabung dengan NVIDIA, ia bekerja di industri energi, dengan fokus pada pengembangan algoritma untuk pencitraan komputasi. Sebagai bagian dari PhD-nya, ia mengerjakan pembelajaran mendalam berbasis fisika untuk simulasi numerik dalam skala besar. Di waktu senggangnya, ia senang membaca, bermain gitar, dan piano.

Tugrul Konuk adalah Arsitek Solusi Senior di NVIDIA, yang berspesialisasi dalam pelatihan skala besar, pembelajaran mendalam multimodal, dan komputasi ilmiah berkinerja tinggi. Sebelum bergabung dengan NVIDIA, ia bekerja di industri energi, dengan fokus pada pengembangan algoritma untuk pencitraan komputasi. Sebagai bagian dari PhD-nya, ia mengerjakan pembelajaran mendalam berbasis fisika untuk simulasi numerik dalam skala besar. Di waktu senggangnya, ia senang membaca, bermain gitar, dan piano.

Rohil Bhargava adalah Manajer Pemasaran Produk di NVIDIA, yang berfokus pada penerapan kerangka aplikasi dan SDK NVIDIA pada platform CSP tertentu.

Rohil Bhargava adalah Manajer Pemasaran Produk di NVIDIA, yang berfokus pada penerapan kerangka aplikasi dan SDK NVIDIA pada platform CSP tertentu.

Eliuth Triana Isaza adalah Manajer Hubungan Pengembang di NVIDIA yang memberdayakan AI MLOps, DevOps, Ilmuwan, dan pakar teknis AWS dari Amazon untuk menguasai tumpukan komputasi NVIDIA guna mempercepat dan mengoptimalkan model Generative AI Foundation mulai dari kurasi data, pelatihan GPU, inferensi model, dan penerapan produksi pada instans GPU AWS . Selain itu, Eliuth adalah pengendara sepeda gunung, pemain ski, tenis, dan pemain poker yang bersemangat.

Eliuth Triana Isaza adalah Manajer Hubungan Pengembang di NVIDIA yang memberdayakan AI MLOps, DevOps, Ilmuwan, dan pakar teknis AWS dari Amazon untuk menguasai tumpukan komputasi NVIDIA guna mempercepat dan mengoptimalkan model Generative AI Foundation mulai dari kurasi data, pelatihan GPU, inferensi model, dan penerapan produksi pada instans GPU AWS . Selain itu, Eliuth adalah pengendara sepeda gunung, pemain ski, tenis, dan pemain poker yang bersemangat.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Sanggup

- Tentang Kami

- dipercepat

- mempercepat

- percepatan

- mengakses

- menyelesaikan

- ketepatan

- tepat

- Mencapai

- dicapai

- di seluruh

- aktif

- tambahan

- alamat

- Mengadopsi

- iklan

- mempengaruhi

- Setelah

- AI

- Model AI

- saya menggunakan kasus

- Album

- algoritma

- Semua

- mengizinkan

- diizinkan

- Membiarkan

- memungkinkan

- juga

- selalu

- Amazon

- Amazon Web Services

- Amazon.com

- an

- dan

- Aplikasi

- aplikasi

- pendekatan

- arsitek

- ADALAH

- DAERAH

- daerah

- sekitar

- artis

- AS

- membantu

- membantu

- At

- rata-rata

- AWS

- Backend

- Saldo

- balancing

- bar

- berdasarkan

- Dasar

- Bola basket

- Teluk

- BE

- menjadi

- karena

- Manfaat

- TERBAIK

- Lebih baik

- meningkatkan

- meningkatkan

- kedua

- membawa

- luas

- membangun

- dibangun di

- by

- CAN

- kemampuan

- kemampuan

- menangkap

- yang

- Lowongan Kerja

- hati-hati

- kasus

- tantangan

- menantang

- Grafik

- memeriksa

- dihargai

- pilihan

- klien

- awan

- kode

- COM

- bagaimana

- berkomunikasi

- Perusahaan

- dibandingkan

- komputasi

- komputasi

- bersamaan

- konfigurasi

- Wadah

- Konten

- Konvergensi

- Core

- Biaya

- Biaya

- kerajinan

- kritis

- sangat penting

- CSP

- kurasi

- adat

- pelanggan

- pengalaman pelanggan

- pelanggan

- data

- Tanggal

- Hari

- menurun

- mendalam

- belajar mendalam

- keterlambatan

- menyampaikan

- mengantarkan

- memberikan

- Permintaan

- menyebarkan

- penggelaran

- penyebaran

- Mendesain

- Pengembang

- berkembang

- Pengembangan

- berbeda

- sulit

- langsung

- menyelam

- beberapa

- DIY

- Dont

- secara drastis

- selama

- dinamis

- e

- e-commerce

- Awal

- mendidik

- efisiensi

- efisien

- usaha

- tinggi

- embedding

- emosi

- mempekerjakan

- memberdayakan

- diaktifkan

- mendorong

- ujung ke ujung

- energi

- Insinyur

- Meningkatkan

- cukup

- memastikan

- terutama

- dll

- mengevaluasi

- Bahkan

- Setiap

- eksekusi

- pengalaman

- Pengalaman

- ahli

- FAST

- Fitur

- Angka

- Akhirnya

- Menemukan

- temuan

- Pertama

- keluwesan

- banjir

- Fokus

- terfokus

- berfokus

- berikut

- Untuk

- format

- Prinsip Dasar

- Kerangka

- kerangka

- dari

- membuat frustrasi

- sepenuhnya

- fungsionalitas

- lebih lanjut

- fusi

- pintu gerbang

- generasi

- generatif

- AI generatif

- GPU

- GPU

- Menangani

- terjadi

- Perangkat keras

- Memiliki

- he

- berat

- angkat berat

- membantu

- bermanfaat

- membantu

- High

- tingkat tinggi

- kinerja tinggi

- dia

- -nya

- memegang

- tuan

- JAM

- Seterpercayaapakah Olymp Trade? Kesimpulan

- Namun

- HTML

- HTTPS

- mengidentifikasi

- if

- menggambarkan

- Pencitraan

- melaksanakan

- penting

- memperbaiki

- ditingkatkan

- perbaikan

- in

- termasuk

- Meningkatkan

- Pada meningkat

- meningkatkan

- industri

- tidak efisien

- mempengaruhi

- Infrastruktur

- mulanya

- contoh

- segera

- sebagai gantinya

- bunga

- ke

- memperkenalkan

- memperkenalkan

- IT

- NYA

- perjalanan

- jpg

- hanya

- kunci

- Jenis

- Tahu

- dikenal

- Labs

- bahasa

- besar

- besar-besaran

- lebih besar

- abadi

- Latensi

- Terbaru

- lapisan

- memimpin

- terkemuka

- BELAJAR

- pengetahuan

- Leverage

- Perpustakaan

- pengangkatan

- 'like'

- batas

- memuat

- mencari

- Rendah

- menurunkan

- mesin

- Mesin belajar

- memelihara

- utama

- membuat

- MEMBUAT

- manajer

- pelaksana

- Marketing

- menguasai

- Maksimalkan

- Mungkin..

- kenangan

- Memori

- meta

- Tengah

- juta

- jutaan

- milidetik

- minimal

- kesalahan

- campur aduk

- ML

- MLOps

- model

- pemodelan

- model

- Modul

- uang

- lebih

- paling

- Gunung

- multi-

- beberapa

- musik

- harus

- nama

- dibutuhkan

- negatif

- jaringan

- New

- nLP

- Nvidia

- of

- menawarkan

- Penawaran

- on

- ONE

- hanya

- Buka

- open source

- operasi

- operasional

- Operasi

- optimal

- optimasi

- Optimize

- dioptimalkan

- mengoptimalkan

- or

- diatur

- urutan

- Lainnya

- di luar

- di luar

- terkemuka

- lebih

- secara keseluruhan

- sendiri

- parameter

- bagian

- tertentu

- khususnya

- bermitra

- bergairah

- Puncak

- persentase

- prestasi

- pribadi

- Personalized

- phd

- pipa saluran

- Platform

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- pemain

- bermain

- podcast

- Podcast

- Titik

- poker

- mungkin

- Pos

- potensi

- kekuasaan

- didukung

- Ketelitian

- Sebelumnya

- Prioritaskan

- prioritas

- masalah

- proses

- Produk

- Produksi

- memprojeksikan

- memberikan

- pemberi

- menyediakan

- menyediakan

- Ular sanca

- Cepat

- Peringkat

- Bacaan

- real-time

- mengurangi

- lihat

- terkait

- hubungan

- relevansi

- relevan

- dapat diandalkan

- permintaan

- membutuhkan

- Sumber

- tanggapan

- tanggung jawab

- tanggung jawab

- responsif

- dihasilkan

- Hasil

- Kaya

- benar

- berjalan

- berjalan

- runtime

- pembuat bijak

- sama

- Save

- penghematan

- terukur

- Skala

- Ilmu

- ilmiah

- ilmuwan

- SDK

- SDK

- mulus

- Pencarian

- pencarian

- mencari

- Kedua

- bagian

- melihat

- pencarian

- tampaknya

- semantik

- senior

- peka

- putusan pengadilan

- melayani

- Server

- layanan

- Service Provider

- Layanan

- porsi

- set

- pengaturan

- beberapa

- Share

- berbagi

- Pertunjukkan

- penting

- signifikan

- Sederhana

- duduk

- Ukuran

- ukuran

- pintar

- Perangkat lunak

- pengembangan perangkat lunak

- larutan

- Solusi

- lagu

- sumber

- ketegangan

- spesialisasi

- mengkhususkan diri

- tertentu

- kecepatan

- MENGEJA

- ejaan

- menghabiskan

- tumpukan

- Mulai

- Startups

- tinggal

- mantap

- Langkah

- Tangga

- Cerita

- Streaming

- seperti itu

- unggul

- mendukung

- Didukung

- yakin

- diambil

- pengambilan

- penargetan

- tim

- tech

- Teknis

- teknik

- teknik

- Teknologi

- Teknologi

- teks

- bahwa

- Grafik

- mereka

- Mereka

- Sana.

- karena itu

- Ini

- mereka

- hal

- ini

- Melalui

- keluaran

- waktu

- kali

- Judul

- untuk

- bersama

- Tokenisasi

- Token

- mengambil

- alat

- puncak

- terima kasih

- lalu lintas

- Pelatihan VE

- terlatih

- Pelatihan

- transformator

- Tren

- Pelaut

- benar

- dua

- pemahaman

- niscaya

- Alam semesta

- unlocking

- meluncurkan

- us

- menggunakan

- bekas

- Pengguna

- kegunaan

- menggunakan

- Memanfaatkan

- nilai

- Luas

- fleksibilitas

- sangat

- Menunggu

- berjalan

- Walmart

- adalah

- menonton

- cara

- we

- jaringan

- layanan web

- BAIK

- adalah

- ketika

- sedangkan

- sementara

- akan

- dengan

- Kerja

- bekerja

- kerja

- bekerja

- dunia

- kuatir

- namun

- menghasilkan

- Kamu

- Anda

- zephyrnet.dll