Ini adalah postingan tamu yang ditulis bersama oleh Nafi Ahmet Turgut, Hasan Burak Yel, dan Damla Şentürk dari Getir.

Didirikan pada 2015, membawa telah memposisikan dirinya sebagai pelopor dalam bidang pengiriman bahan makanan ultracepat. Perusahaan teknologi inovatif ini telah merevolusi segmen pengiriman jarak jauh dengan penawaran “bahan makanan dalam hitungan menit” yang menarik. Dengan kehadirannya di Turki, Inggris, Belanda, Jerman, dan Amerika Serikat, Getir telah menjadi kekuatan multinasional yang patut diperhitungkan. Saat ini, merek Getir mewakili konglomerat terdiversifikasi yang mencakup sembilan sektor berbeda, semuanya bekerja secara sinergis di bawah satu payung.

Dalam postingan ini, kami menjelaskan bagaimana kami membangun saluran prediksi kategori produk end-to-end untuk membantu tim komersial dalam menggunakannya Amazon SageMaker dan Batch AWS, mengurangi durasi pelatihan model sebesar 90%.

Memahami ragam produk kami saat ini secara mendetail merupakan tantangan penting yang kami, bersama dengan banyak bisnis lainnya, hadapi di pasar yang serba cepat dan kompetitif saat ini. Solusi efektif untuk masalah ini adalah prediksi kategori produk. Sebuah model yang menghasilkan pohon kategori yang komprehensif memungkinkan tim komersial kami untuk membandingkan portofolio produk kami yang ada dengan portofolio produk pesaing kami, sehingga menawarkan keunggulan strategis. Oleh karena itu, tantangan utama kami adalah pembuatan dan penerapan model prediksi kategori produk yang akurat.

Kami memanfaatkan alat canggih yang disediakan oleh AWS untuk mengatasi tantangan ini dan secara efektif menavigasi bidang pembelajaran mesin (ML) dan analisis prediktif yang kompleks. Upaya kami menghasilkan keberhasilan pembuatan jalur prediksi kategori produk end-to-end, yang menggabungkan kekuatan SageMaker dan AWS Batch.

Kemampuan analisis prediktif ini, khususnya perkiraan kategori produk yang akurat, telah terbukti sangat berharga. Hal ini memberi tim kami wawasan penting berbasis data yang mengoptimalkan manajemen inventaris, meningkatkan interaksi pelanggan, dan memperkuat kehadiran pasar kami.

Metodologi yang kami jelaskan dalam postingan ini berkisar dari fase awal pengumpulan kumpulan fitur hingga implementasi akhir dari pipeline prediksi. Aspek penting dari strategi kami adalah penggunaan SageMaker dan AWS Batch untuk menyempurnakan model BERT yang telah dilatih sebelumnya untuk tujuh bahasa berbeda. Selain itu, integrasi kami yang lancar dengan layanan penyimpanan objek AWS Layanan Penyimpanan Sederhana Amazon (Amazon S3) telah menjadi kunci untuk menyimpan dan mengakses model yang disempurnakan ini secara efisien.

SageMaker adalah layanan ML yang dikelola sepenuhnya. Dengan SageMaker, ilmuwan dan pengembang data dapat dengan cepat dan mudah membangun dan melatih model ML, lalu langsung menerapkannya ke lingkungan yang dihosting dan siap produksi.

Sebagai layanan yang terkelola sepenuhnya, AWS Batch membantu Anda menjalankan beban kerja komputasi batch dalam skala apa pun. AWS Batch secara otomatis menyediakan sumber daya komputasi dan mengoptimalkan distribusi beban kerja berdasarkan kuantitas dan skala beban kerja. Dengan AWS Batch, tidak perlu menginstal atau mengelola perangkat lunak komputasi batch, sehingga Anda dapat memfokuskan waktu Anda untuk menganalisis hasil dan memecahkan masalah. Kami menggunakan pekerjaan GPU yang membantu kami menjalankan pekerjaan yang menggunakan GPU suatu instance.

Ikhtisar solusi

Lima orang dari tim ilmu data dan tim infrastruktur Getir bekerja sama dalam proyek ini. Proyek ini selesai dalam waktu satu bulan dan diterapkan ke produksi setelah satu minggu pengujian.

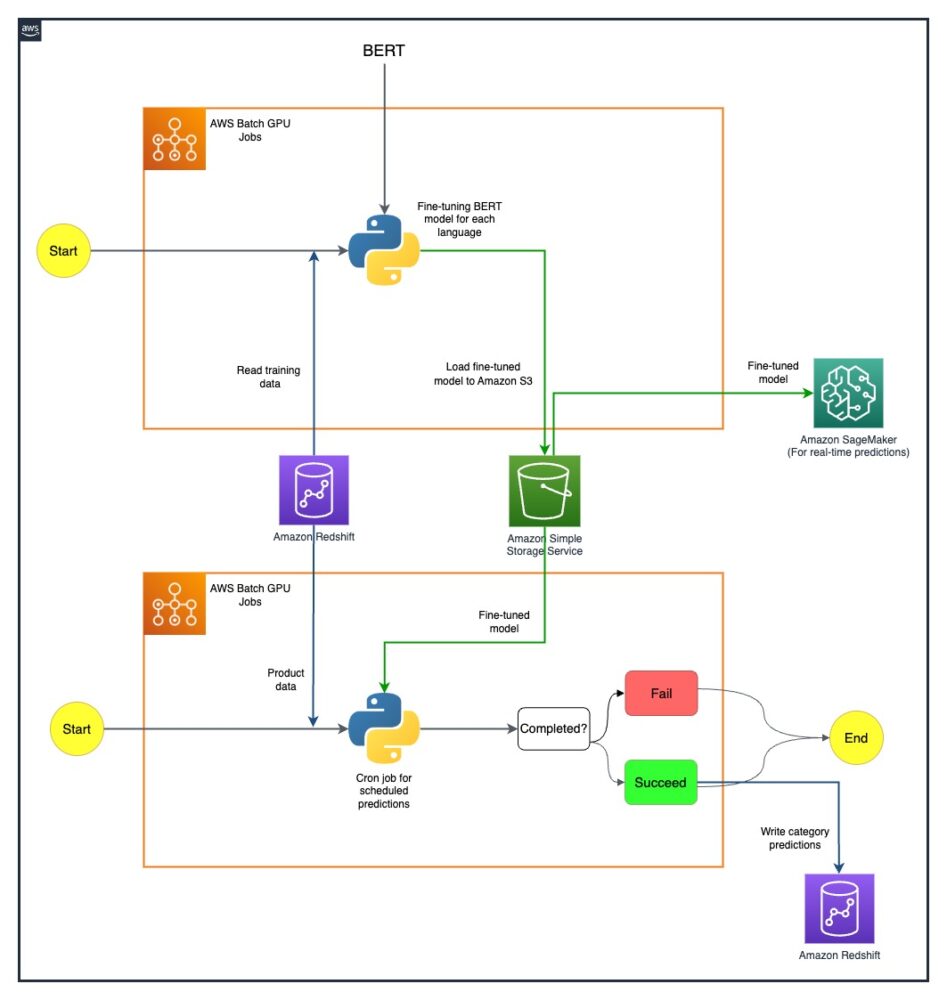

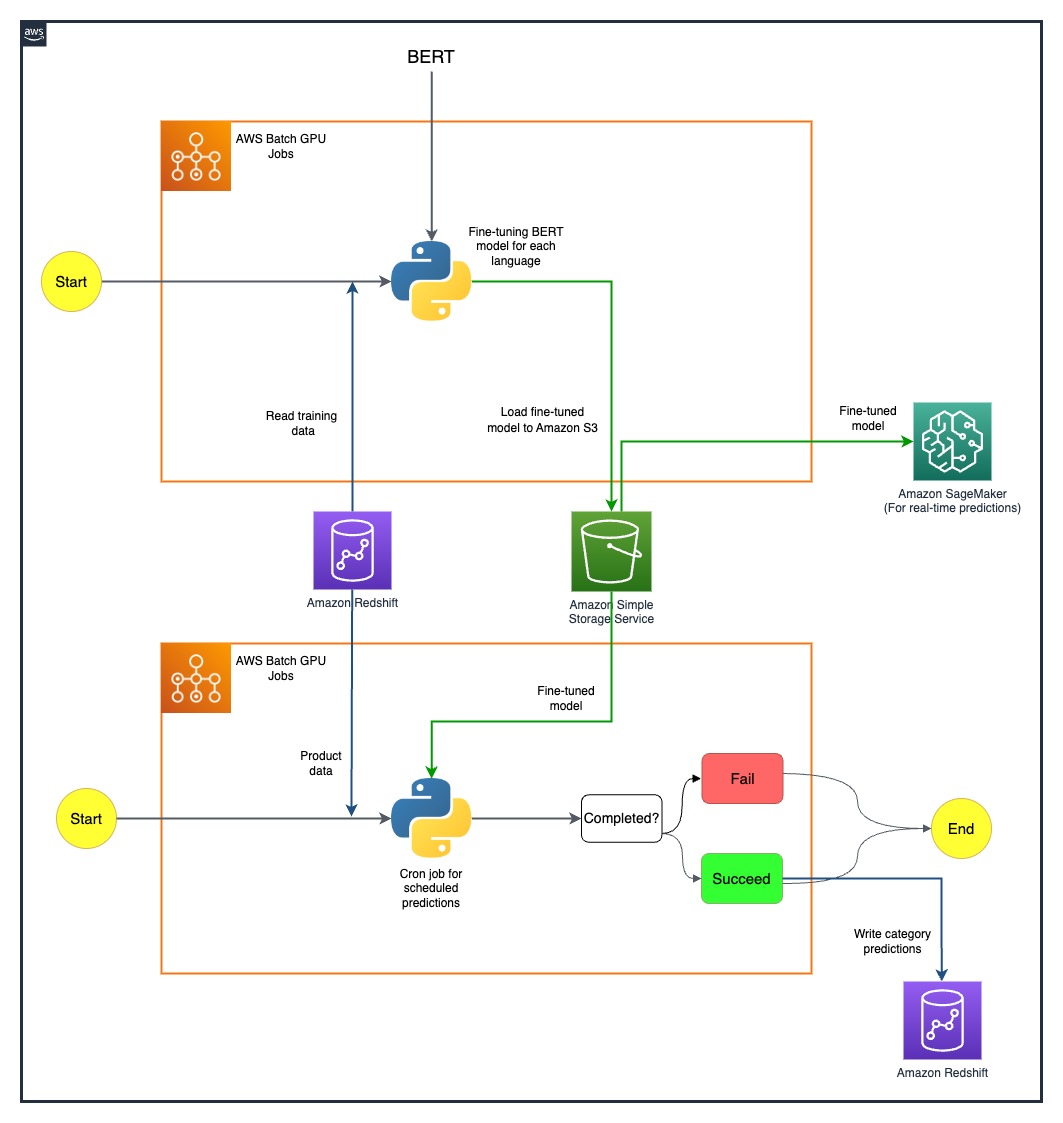

Diagram berikut menunjukkan arsitektur solusi.

Model pipeline dijalankan secara terpisah untuk setiap negara. Arsitekturnya mencakup dua tugas cron GPU AWS Batch untuk setiap negara, yang berjalan pada jadwal yang ditentukan.

Kami mengatasi beberapa tantangan dengan menerapkan sumber daya SageMaker dan AWS Batch GPU secara strategis. Proses yang digunakan untuk mengatasi setiap kesulitan dirinci di bagian berikut.

Menyempurnakan model BERT multibahasa dengan tugas GPU AWS Batch

Kami mencari solusi untuk mendukung berbagai bahasa untuk basis pengguna kami yang beragam. Model BERT adalah pilihan yang jelas karena kemampuannya untuk menangani tugas-tugas bahasa alami yang kompleks secara efektif. Untuk menyesuaikan model ini dengan kebutuhan kami, kami memanfaatkan kekuatan AWS dengan menggunakan pekerjaan instans GPU node tunggal. Hal ini memungkinkan kami menyempurnakan model BERT terlatih untuk masing-masing dari tujuh bahasa yang kami perlukan dukungannya. Melalui metode ini, kami memastikan presisi tinggi dalam memprediksi kategori produk, mengatasi potensi hambatan bahasa.

Penyimpanan model yang efisien menggunakan Amazon S3

Langkah kami selanjutnya adalah menangani penyimpanan dan pengelolaan model. Untuk ini, kami memilih Amazon S3, yang terkenal dengan skalabilitas dan keamanannya. Menyimpan model BERT kami yang telah disesuaikan di Amazon S3 memungkinkan kami memberikan akses mudah ke berbagai tim dalam organisasi kami, sehingga menyederhanakan proses penerapan kami secara signifikan. Ini adalah aspek penting dalam mencapai kelincahan dalam operasi kami dan integrasi upaya ML kami yang lancar.

Membuat alur prediksi ujung ke ujung

Diperlukan saluran pipa yang efisien untuk memanfaatkan model terlatih kami dengan sebaik-baiknya. Kami pertama kali menerapkan model ini di SageMaker, sebuah tindakan yang memungkinkan prediksi real-time dengan latensi rendah, sehingga meningkatkan pengalaman pengguna kami. Untuk prediksi batch berskala lebih besar, yang sama pentingnya bagi operasi kami, kami menggunakan tugas GPU AWS Batch. Hal ini memastikan penggunaan sumber daya kami secara optimal, memberikan kami keseimbangan sempurna antara kinerja dan efisiensi.

Menjelajahi kemungkinan masa depan dengan MME SageMaker

Saat kami terus berkembang dan mencari efisiensi dalam pipeline ML kami, salah satu cara yang ingin kami jelajahi adalah menggunakan titik akhir multi-model (MME) SageMaker untuk menerapkan model kami yang telah disesuaikan. Dengan MME, kami berpotensi menyederhanakan penerapan berbagai model yang telah disesuaikan, memastikan manajemen model yang efisien sekaligus memanfaatkan kemampuan asli SageMaker seperti varian bayangan, penskalaan otomatis, dan amazoncloudwatch integrasi. Eksplorasi ini sejalan dengan upaya berkelanjutan kami untuk meningkatkan kemampuan analisis prediktif dan memberikan pengalaman unggul kepada pelanggan kami.

Kesimpulan

Keberhasilan integrasi SageMaker dan AWS Batch tidak hanya mengatasi tantangan spesifik kami namun juga meningkatkan efisiensi operasional kami secara signifikan. Melalui penerapan jalur prediksi kategori produk yang canggih, kami dapat memberdayakan tim komersial kami dengan wawasan berbasis data, sehingga memfasilitasi pengambilan keputusan yang lebih efektif.

Hasil yang kami peroleh menunjukkan banyak hal tentang efektivitas pendekatan kami. Kami telah mencapai akurasi prediksi sebesar 80% di keempat tingkat perincian kategori, yang memainkan peran penting dalam membentuk pilihan produk untuk setiap negara yang kami layani. Tingkat presisi ini memperluas jangkauan kami melampaui kendala bahasa dan memastikan kami melayani beragam basis pengguna dengan akurasi maksimal.

Selain itu, dengan menggunakan tugas GPU AWS Batch terjadwal secara strategis, kami dapat mengurangi durasi pelatihan model sebesar 90%. Efisiensi ini semakin menyederhanakan proses kami dan meningkatkan ketangkasan operasional kami. Penyimpanan model yang efisien menggunakan Amazon S3 telah memainkan peran penting dalam pencapaian ini, menyeimbangkan prediksi real-time dan batch.

Untuk informasi lebih lanjut tentang cara mulai membangun pipeline ML Anda sendiri dengan SageMaker, lihat Sumber daya Amazon SageMaker. AWS Batch adalah pilihan terbaik jika Anda mencari solusi berbiaya rendah dan terukur untuk menjalankan pekerjaan batch dengan overhead operasional rendah. Untuk memulai, lihat Memulai dengan AWS Batch.

Tentang Penulis

Nafi Ahmet Turgut menyelesaikan gelar masternya di bidang Teknik Elektro & Elektronika dan bekerja sebagai ilmuwan peneliti pascasarjana. Fokusnya adalah membangun algoritma pembelajaran mesin untuk mensimulasikan anomali jaringan saraf. Dia bergabung dengan Getir pada tahun 2019 dan saat ini bekerja sebagai Senior Data Science & Analytics Manager. Timnya bertanggung jawab untuk merancang, menerapkan, dan memelihara algoritma pembelajaran mesin end-to-end dan solusi berbasis data untuk Getir.

Nafi Ahmet Turgut menyelesaikan gelar masternya di bidang Teknik Elektro & Elektronika dan bekerja sebagai ilmuwan peneliti pascasarjana. Fokusnya adalah membangun algoritma pembelajaran mesin untuk mensimulasikan anomali jaringan saraf. Dia bergabung dengan Getir pada tahun 2019 dan saat ini bekerja sebagai Senior Data Science & Analytics Manager. Timnya bertanggung jawab untuk merancang, menerapkan, dan memelihara algoritma pembelajaran mesin end-to-end dan solusi berbasis data untuk Getir.

Hasan Burak Yel menerima gelar sarjana di bidang Teknik Elektro & Elektronika di Universitas Boğaziçi. Dia bekerja di Turkcell, dengan fokus utama pada peramalan deret waktu, visualisasi data, dan otomatisasi jaringan. Dia bergabung dengan Getir pada tahun 2021 dan saat ini bekerja sebagai Manajer Ilmu Data & Analisis dengan tanggung jawab domain Penelusuran, Rekomendasi, dan Pertumbuhan.

Hasan Burak Yel menerima gelar sarjana di bidang Teknik Elektro & Elektronika di Universitas Boğaziçi. Dia bekerja di Turkcell, dengan fokus utama pada peramalan deret waktu, visualisasi data, dan otomatisasi jaringan. Dia bergabung dengan Getir pada tahun 2021 dan saat ini bekerja sebagai Manajer Ilmu Data & Analisis dengan tanggung jawab domain Penelusuran, Rekomendasi, dan Pertumbuhan.

Damla Şentürk menerima gelar sarjana Teknik Komputer di Universitas Galatasaray. Ia melanjutkan gelar masternya di bidang Teknik Komputer di Universitas Boğaziçi. Dia bergabung dengan Getir pada tahun 2022, dan telah bekerja sebagai Ilmuwan Data. Dia telah mengerjakan proyek komersial, rantai pasokan, dan terkait penemuan.

Damla Şentürk menerima gelar sarjana Teknik Komputer di Universitas Galatasaray. Ia melanjutkan gelar masternya di bidang Teknik Komputer di Universitas Boğaziçi. Dia bergabung dengan Getir pada tahun 2022, dan telah bekerja sebagai Ilmuwan Data. Dia telah mengerjakan proyek komersial, rantai pasokan, dan terkait penemuan.

Esra Kayabali adalah Arsitek Solusi Senior di AWS, yang berspesialisasi dalam domain analitik, termasuk pergudangan data, danau data, analitik data besar, streaming data batch dan real-time, serta integrasi data. Dia memiliki 12 tahun pengalaman pengembangan perangkat lunak dan arsitektur. Dia bersemangat mempelajari dan mengajarkan teknologi cloud.

Esra Kayabali adalah Arsitek Solusi Senior di AWS, yang berspesialisasi dalam domain analitik, termasuk pergudangan data, danau data, analitik data besar, streaming data batch dan real-time, serta integrasi data. Dia memiliki 12 tahun pengalaman pengembangan perangkat lunak dan arsitektur. Dia bersemangat mempelajari dan mengajarkan teknologi cloud.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :memiliki

- :adalah

- :bukan

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- kemampuan

- Sanggup

- Tentang Kami

- mengakses

- mengakses

- ketepatan

- tepat

- dicapai

- prestasi

- mencapai

- di seluruh

- Tindakan

- Selain itu

- alamat

- dialamatkan

- Keuntungan

- Setelah

- terhadap

- algoritma

- Rata

- Semua

- diizinkan

- memungkinkan

- sepanjang

- juga

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- analisis

- menganalisis

- dan

- dan infrastruktur

- kelainan

- Apa pun

- arsitektur

- ADALAH

- AS

- penampilan

- bermacam-macam

- At

- mobil

- secara otomatis

- Otomatisasi

- kesempatan

- AWS

- Saldo

- balancing

- hambatan

- mendasarkan

- berdasarkan

- BE

- menjadi

- menjadi

- patokan

- menguntungkan

- TERBAIK

- Luar

- Besar

- Big data

- Didorong

- kedua

- merek

- membangun

- Bangunan

- dibangun di

- bisnis

- tapi

- by

- CAN

- kemampuan

- kemampuan

- dikapitalisasi

- kategori

- Kategori

- melayani

- pusat

- rantai

- menantang

- tantangan

- pilihan

- awan

- menggabungkan

- komersial

- perusahaan

- menarik

- kompetitif

- pesaing

- Lengkap

- kompleks

- luas

- menghitung

- komputer

- Teknik Komputer

- komputasi

- konglomerat

- terus

- terus

- kontinu

- negara

- penciptaan

- kritis

- sangat penting

- Sekarang

- pelanggan

- pelanggan

- data

- Data Analytics

- ilmu data

- ilmuwan data

- visualisasi data

- Data-driven

- Pengambilan Keputusan

- didefinisikan

- Derajat

- pengiriman

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- merancang

- terperinci

- pengembang

- Pengembangan

- berbeda

- Kesulitan

- langsung

- distribusi

- beberapa

- berjenis

- domain

- domain

- dua

- lamanya

- setiap

- Mudah

- Efektif

- efektif

- efektivitas

- efisiensi

- efisiensi

- efisien

- efisien

- mudah

- upaya

- Elektronik

- memberdayakan

- diaktifkan

- meliputi

- ujung ke ujung

- Teknik

- ditingkatkan

- meningkatkan

- memastikan

- Memastikan

- memastikan

- Lingkungan Hidup

- sama

- mapan

- berkembang

- unggul

- ada

- pengalaman

- Pengalaman

- Menjelaskan

- eksplorasi

- menyelidiki

- Meluas

- Menghadapi

- memfasilitasi

- serba cepat

- Fitur

- bidang

- terakhir

- Pertama

- Fokus

- terfokus

- berikut

- Untuk

- kekuatan

- Ramalan

- empat

- dari

- sepenuhnya

- lebih lanjut

- masa depan

- pertemuan

- menghasilkan

- Jerman

- mendapatkan

- GPU

- GPU

- lulus

- Pertumbuhan

- Tamu

- tamu Post

- menangani

- Memiliki

- he

- membantu

- membantu

- dia

- High

- -nya

- host

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- http

- HTTPS

- if

- implementasi

- mengimplementasikan

- penting

- aspek penting

- in

- termasuk

- Termasuk

- informasi

- Infrastruktur

- mulanya

- inovatif

- wawasan

- install

- contoh

- integrasi

- interaksi

- ke

- tak ternilai

- inventaris

- Inventarisasi Manajemen

- IT

- NYA

- Diri

- Jobs

- bergabung

- jpg

- Tajam

- kunci

- dikenal

- danau

- bahasa

- Bahasa

- Latensi

- pengetahuan

- Dipimpin

- Tingkat

- adalah ide yang bagus

- 'like'

- mencari

- Rendah

- murah

- mesin

- Mesin belajar

- terutama

- mempertahankan

- membuat

- mengelola

- berhasil

- pengelolaan

- manajer

- cara

- banyak

- Pasar

- tuan

- metode

- Metodologi

- menit

- ML

- model

- model

- Bulan

- lebih

- multinasional

- beberapa

- asli

- Alam

- Arahkan

- Perlu

- kebutuhan

- Belanda

- jaringan

- berikutnya

- sembilan

- tidak

- obyek

- Jelas

- of

- menawarkan

- on

- ONE

- hanya

- operasional

- Operasi

- optimal

- dioptimalkan

- Mengoptimalkan

- pilihan

- or

- urutan

- organisasi

- kami

- mengatasi

- sendiri

- khususnya

- bergairah

- Konsultan Ahli

- sempurna

- prestasi

- tahap

- pipa saluran

- plato

- Kecerdasan Data Plato

- Data Plato

- dimainkan

- memainkan

- portofolio

- diposisikan

- kemungkinan

- Pos

- potensi

- berpotensi

- kekuasaan

- kuat

- Ketelitian

- memprediksi

- ramalan

- Prediksi

- Predictive Analytics

- kehadiran

- Masalah

- masalah

- proses

- proses

- Produk

- Produksi

- proyek

- memprojeksikan

- terbukti

- memberikan

- disediakan

- menyediakan

- pengejaran

- kuantitas

- segera

- rentang

- mencapai

- real-time

- data waktu nyata

- diterima

- Rekomendasi

- menurunkan

- mengurangi

- mengurangi

- memperhalus

- halus

- merupakan

- wajib

- penelitian

- Sumber

- tanggung jawab

- tanggung jawab

- Hasil

- merevolusi

- Peran

- Run

- berjalan

- pembuat bijak

- Skalabilitas

- terukur

- Skala

- skala

- dijadwalkan

- Ilmu

- ilmuwan

- ilmuwan

- mulus

- Pencarian

- bagian

- keamanan

- melihat

- Mencari

- ruas

- terpilih

- senior

- Seri

- melayani

- layanan

- Layanan

- set

- tujuh

- bayangan

- membentuk

- dia

- Pertunjukkan

- signifikan

- Sederhana

- tunggal

- So

- Perangkat lunak

- pengembangan perangkat lunak

- larutan

- Solusi

- Memecahkan

- beberapa

- mutakhir

- dicari

- berbicara

- khusus

- tertentu

- mulai

- Negara

- Langkah

- penyimpanan

- menyimpan

- Strategis

- Secara strategis

- Penyelarasan

- Streaming

- mempersingkat

- efisien

- pelurusan

- diperkuat

- kekuatan

- sukses

- unggul

- menyediakan

- supply chain

- mendukung

- memecahkan

- menyesuaikan

- tugas

- Pengajaran

- tim

- tim

- tech

- Perusahaan Teknologi

- Teknologi

- pengujian

- bahwa

- Grafik

- Belanda

- Inggris

- mereka

- Mereka

- kemudian

- dengan demikian

- karena itu

- Ini

- ini

- Melalui

- waktu

- Seri waktu

- untuk

- hari ini

- hari ini

- bersama

- alat

- perintis

- Pelatihan VE

- Pelatihan

- pohon

- Turki

- dua

- Uk

- payung

- bawah

- Serikat

- Amerika Serikat

- universitas

- us

- menggunakan

- bekas

- Pengguna

- Pengguna Pengalaman

- menggunakan

- dimanfaatkan

- sepenuhnya

- berbagai

- vertikal

- visualisasi

- vital

- volume

- adalah

- we

- jaringan

- layanan web

- minggu

- adalah

- yang

- sementara

- dengan

- dalam

- bekerja

- kerja

- bekerja

- tahun

- Kamu

- Anda

- zephyrnet.dll