Di dunia yang semakin berpusat pada data, perusahaan harus fokus pada pengumpulan informasi fisik yang berharga dan menghasilkan informasi yang mereka butuhkan tetapi tidak dapat ditangkap dengan mudah. Akses data, regulasi, dan kepatuhan merupakan sumber friksi yang semakin meningkat untuk inovasi dalam analitik dan kecerdasan buatan (AI).

Untuk sektor yang sangat diatur seperti Layanan Keuangan, Perawatan Kesehatan, Ilmu Kehidupan, Otomotif, Robotika, dan Manufaktur, masalahnya bahkan lebih besar. Ini menyebabkan hambatan pada desain sistem, berbagi data (Internal dan eksternal), monetisasi, analitik, dan pembelajaran mesin (ML).

Data sintetis adalah alat yang mengatasi banyak tantangan data, terutama AI dan masalah analitik seperti perlindungan privasi, kepatuhan terhadap peraturan, aksesibilitas, kelangkaan data, dan bias. Ini juga termasuk berbagi data dan waktu ke data (dan karena itu waktu ke pasar).

Data sintetis dihasilkan secara algoritme. Ini mencerminkan properti dan pola statistik dari data sumber. Namun yang terpenting, itu tidak mengandung poin data sensitif, pribadi, atau pribadi.

Anda mengajukan pertanyaan tentang data sintetik dan mendapatkan jawaban yang sama seperti yang Anda dapatkan dari data sebenarnya.

Dalam kami posting sebelumnya, kami mendemonstrasikan cara menggunakan jaringan adversarial seperti Generative Adversarial Networks (GANS) untuk menghasilkan kumpulan data tabular untuk meningkatkan pelatihan model penipuan kredit.

Bagi pemangku kepentingan bisnis untuk mengadopsi data sintetik untuk proyek ML dan analitik mereka, sangat penting untuk tidak hanya memastikan bahwa data sintetik yang dihasilkan akan sesuai dengan tujuan dan aplikasi hilir yang diharapkan, tetapi juga agar mereka dapat mengukur dan mendemonstrasikan kualitas data yang dihasilkan.

Dengan meningkatnya kewajiban hukum dan etika dalam menjaga privasi, salah satu kekuatan data sintetik adalah kemampuannya untuk menghapus informasi sensitif dan asli selama sintesisnya. Oleh karena itu, selain kualitas, kami memerlukan metrik untuk mengevaluasi risiko kebocoran informasi pribadi, jika ada, dan menilai bahwa proses pembuatan tidak “menghafal” atau menyalin data asli mana pun.

Untuk mencapai semua ini, kami dapat memetakan kualitas data sintetik ke dalam dimensi, yang membantu pengguna, pemangku kepentingan, dan kami untuk lebih memahami data yang dihasilkan.

Tiga dimensi evaluasi kualitas data sintetik

Data sintetik yang dihasilkan diukur terhadap tiga dimensi utama:

- Kesetiaan

- Kegunaan

- Privasi

Ini adalah beberapa pertanyaan tentang data sintetik yang dihasilkan yang harus dijawab oleh laporan kualitas data sintetik:

- Seberapa mirip data sintetik ini dibandingkan dengan set pelatihan asli?

- Seberapa berguna data sintetik ini untuk aplikasi hilir kami?

- Apakah ada informasi yang bocor dari data pelatihan asli ke dalam data sintetik?

- Apakah ada data yang dianggap sensitif di dunia nyata (dari kumpulan data lain yang tidak digunakan untuk melatih model) yang secara tidak sengaja disintesis oleh model kita?

Metrik yang menerjemahkan setiap dimensi ini untuk pengguna akhir agak fleksibel. Lagi pula, data yang dihasilkan dapat bervariasi dalam hal distribusi, ukuran, dan perilaku. Mereka juga harus mudah dipahami dan ditafsirkan.

Pada akhirnya, metrik harus sepenuhnya berbasis data, dan tidak memerlukan pengetahuan sebelumnya atau informasi khusus domain. Namun, jika pengguna ingin menerapkan aturan dan batasan khusus yang berlaku untuk domain bisnis tertentu, maka mereka harus dapat menentukannya selama proses sintesis untuk memastikan bahwa fidelitas khusus domain terpenuhi.

Kami melihat masing-masing metrik ini secara lebih mendetail di bagian berikut.

Metrik untuk memahami kesetiaan

Dalam proyek ilmu data apa pun, kita harus memahami apakah populasi sampel tertentu relevan dengan masalah yang sedang kita pecahkan. Demikian pula, untuk proses menilai relevansi data sintetik yang dihasilkan, kita harus mengevaluasinya dari segi kesetiaan dibandingkan dengan aslinya.

Representasi visual dari metrik ini membuatnya lebih mudah untuk dipahami. Kita dapat mengilustrasikan apakah kardinalitas dan rasio kategori dihormati, korelasi antara variabel yang berbeda dipertahankan, dan seterusnya.

Memvisualisasikan data tidak hanya membantu mengevaluasi kualitas data sintetik, tetapi juga cocok sebagai salah satu langkah awal dalam siklus hidup ilmu data untuk pemahaman data yang lebih baik.

Mari selami beberapa metrik fidelitas secara lebih mendetail.

Perbandingan statistik eksplorasi

Dalam perbandingan statistik eksplorasi, fitur dari kumpulan data asli dan sintetik dieksplorasi menggunakan ukuran statistik utama, seperti rata-rata, median, standar deviasi, nilai yang berbeda, nilai yang hilang, minima, maksima, rentang kuartil untuk fitur kontinu, dan jumlah catatan per kategori, nilai yang hilang per kategori, dan karakter yang paling sering muncul untuk atribut kategori.

Perbandingan ini harus dilakukan antara dataset hold-out asli dan data sintetik. Evaluasi ini akan mengungkapkan jika kumpulan data yang dibandingkan secara statistik serupa. Jika tidak, maka kita akan memahami fitur dan ukuran mana yang berbeda. Anda harus mempertimbangkan pelatihan ulang dan pembuatan ulang data sintetik dengan parameter yang berbeda jika terdapat perbedaan yang signifikan.

Tes ini bertindak sebagai penyaringan awal untuk memastikan bahwa data sintetik memiliki fidelitas yang masuk akal dengan kumpulan data asli dan oleh karena itu dapat menjalani pengujian yang lebih ketat.

Skor kesamaan histogram

Skor kesamaan histogram mengukur distribusi marjinal setiap fitur dari kumpulan data sintetik dan asli.

Skor kesamaan dibatasi antara nol dan satu, dengan skor satu menunjukkan bahwa distribusi data sintetik secara sempurna tumpang tindih dengan distribusi data asli.

Skor yang mendekati satu akan memberi pengguna keyakinan bahwa dataset holdout dan dataset sintetik serupa secara statistik.

Skor saling informasi

Skor informasi timbal balik mengukur ketergantungan timbal balik dari dua fitur, numerik atau kategori, yang menunjukkan berapa banyak informasi yang dapat diperoleh dari satu fitur dengan mengamati yang lain.

Saling informasi dapat mengukur hubungan non-linear, memberikan pemahaman yang lebih komprehensif tentang kualitas data sintetik karena memungkinkan kita memahami sejauh mana pelestarian hubungan variabel.

Skor satu menunjukkan bahwa ketergantungan timbal balik antar fitur telah ditangkap dengan sempurna dalam data sintetik.

Skor korelasi

Skor korelasi mengukur seberapa baik korelasi dalam kumpulan data asli telah ditangkap dalam data sintetik.

Korelasi antara dua kolom atau lebih sangat penting untuk aplikasi ML, yang membantu mengungkap hubungan antara fitur dan variabel target serta membantu membuat model yang terlatih dengan baik.

Skor korelasi dibatasi antara nol dan satu, dengan skor satu menunjukkan bahwa korelasi tersebut telah sangat cocok.

Tidak seperti data tabular terstruktur, yang biasa kita temui dalam masalah data, beberapa jenis data terstruktur memiliki perilaku tertentu di mana pengamatan masa lalu memiliki kemungkinan untuk mempengaruhi pengamatan berikutnya. Ini dikenal sebagai data deret waktu atau berurutan – misalnya, kumpulan data dengan pengukuran suhu ruangan setiap jam.

Perilaku ini berarti bahwa ada persyaratan untuk menentukan metrik tertentu yang secara khusus dapat mengukur kualitas kumpulan data deret waktu ini

Skor autokorelasi dan autokorelasi parsial

Meskipun mirip dengan korelasi, autokorelasi menunjukkan hubungan deret waktu pada nilai saat ini terkait dengan nilai sebelumnya. Menghapus efek dari jeda waktu sebelumnya menghasilkan autokorelasi parsial. Oleh karena itu, skor autokorelasi mengukur seberapa baik data sintetik menangkap autokorelasi yang signifikan, atau korelasi parsial, dari kumpulan data asli.

Metrik untuk memahami utilitas

Sekarang kita mungkin telah menyadari secara statistik bahwa data sintetik mirip dengan kumpulan data asli. Selain itu, kami juga harus menilai seberapa baik kinerja kumpulan data yang disintesis pada masalah ilmu data umum saat dilatih pada beberapa algoritme ML.

Menggunakan berikut ini kegunaan metrik, kami bertujuan untuk membangun keyakinan bahwa kami benar-benar dapat mencapai kinerja pada aplikasi hilir terkait dengan kinerja data asli.

Skor prediksi

Mengukur kinerja data sintetik dibandingkan dengan data nyata asli dapat dilakukan melalui model ML. Skor model downstream menangkap kualitas data sintetik dengan membandingkan performa model ML yang dilatih pada set data sintetis dan asli dan divalidasi pada data pengujian yang ditahan dari set data asli. Ini menyediakan a Latih skor Tes Sintetis Nyata (TSTR). dan Latih Ujian Nyata Nyata (TRTR) skor masing-masing.

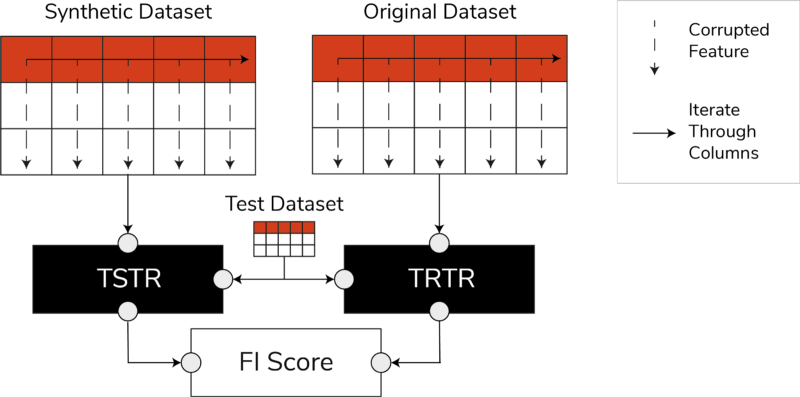

Skor TSTR, TRTR, dan Skor Kepentingan Fitur (Gambar oleh penulis)

Skor menggabungkan berbagai algoritme ML paling tepercaya untuk tugas regresi atau klasifikasi. Menggunakan beberapa pengklasifikasi dan regressor memastikan bahwa skor lebih dapat digeneralisasikan di sebagian besar algoritme, sehingga data sintetik dapat dianggap berguna di masa mendatang.

Pada akhirnya, jika skor TSTR dan skor TRTR sebanding, hal ini menunjukkan bahwa data sintetis memiliki kualitas untuk digunakan melatih model ML yang efektif untuk aplikasi dunia nyata.

Skor kepentingan fitur

Sangat terkait dengan skor prediksi, skor kepentingan fitur (FI) memperluasnya dengan menambahkan interpretabilitas ke skor TSTR dan TRTR.

Skor F1 membandingkan perubahan dan stabilitas urutan kepentingan fitur yang diperoleh dengan skor prediksi. Serangkaian data sintetik dianggap memiliki utilitas tinggi jika menghasilkan urutan kepentingan fitur yang sama dengan data asli yang sebenarnya.

Skor Q

Untuk memastikan bahwa model yang dilatih pada data yang baru kami buat akan menghasilkan jawaban yang sama untuk pertanyaan yang sama dengan model yang dilatih menggunakan data asli, kami menggunakan Qscore. Ini mengukur kinerja downstream data sintetik dengan menjalankan banyak kueri berbasis agregasi acak pada set data sintetik dan asli (dan penyimpanan).

Idenya di sini adalah bahwa kedua kueri ini harus mengembalikan hasil yang serupa.

QScore yang tinggi memastikan bahwa aplikasi hilir yang menggunakan kueri dan operasi agregasi dapat memberikan nilai yang hampir sama dengan dataset asli.

Metrik untuk memahami privasi

Dengan pribadi peraturan yang sudah ada, merupakan kewajiban etis dan persyaratan hukum untuk memastikan bahwa informasi sensitif dilindungi.

Sebelum data sintetik ini dapat dibagikan secara bebas dan digunakan untuk aplikasi hilir, kita harus mempertimbangkan metrik privasi yang dapat membantu pemangku kepentingan memahami posisi data sintetik yang dihasilkan dibandingkan dengan data asli dalam hal tingkat kebocoran informasi. Selain itu, kita harus membuat keputusan penting terkait bagaimana data sintetik dapat dibagikan dan digunakan.

Skor pertandingan yang tepat

Evaluasi privasi secara langsung dan intuitif adalah dengan mencari salinan data nyata di antara catatan sintetik. Skor kecocokan persis menghitung jumlah catatan nyata yang dapat ditemukan di antara set sintetis.

Skornya harus nol, yang menyatakan bahwa tidak ada informasi nyata yang ada dalam data sintetik. Metrik ini berfungsi sebagai mekanisme penyaringan sebelum kami mengevaluasi metrik privasi lebih lanjut.

skor privasi tetangga

Selain itu, skor privasi tetangga mengukur rasio catatan sintetik yang mungkin terlalu dekat kemiripannya dengan yang asli. Ini berarti bahwa, meskipun bukan salinan langsung, itu adalah titik potensial kebocoran privasi dan sumber informasi yang berguna untuk serangan inferensi.

Skor dihitung dengan melakukan pencarian tetangga terdekat berdimensi tinggi pada data sintetik yang tumpang tindih dengan data aslinya.

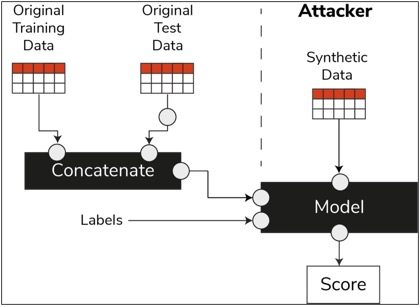

Skor inferensi keanggotaan

Dalam siklus hidup ilmu data, setelah model dilatih, model tidak lagi memerlukan akses ke sampel pelatihan dan dapat membuat prediksi pada data yang tidak terlihat. Demikian pula, dalam kasus kami, setelah model penyintesis dilatih, sampel data sintetik dapat dihasilkan tanpa memerlukan data asli.

Melalui jenis serangan yang disebut "serangan inferensi keanggotaan", penyerang dapat mencoba mengungkap data yang digunakan untuk membuat data sintetis, tanpa memiliki akses ke data asli. Ini menghasilkan kompromi privasi.

Skor inferensi keanggotaan mengukur kemungkinan keberhasilan serangan inferensi keanggotaan.

Skor rendah menunjukkan kelayakan inferensi bahwa catatan tertentu adalah anggota dari kumpulan data pelatihan yang mengarah pada pembuatan data sintetik. Dengan kata lain, serangan dapat menyimpulkan detail catatan individu, sehingga membahayakan privasi.

Skor inferensi keanggotaan yang tinggi menunjukkan bahwa penyerang tidak mungkin menentukan apakah catatan tertentu merupakan bagian dari kumpulan data asli yang digunakan untuk membuat data sintetik. Ini juga berarti bahwa tidak ada informasi individu yang disusupi melalui data sintetik.

Konsep bertahan

Praktik terbaik penting yang harus kita ikuti adalah memastikan bahwa data sintetik cukup umum dan tidak terlalu sesuai dengan data asli yang dilatihnya. Dalam alur sains data biasa, saat membuat model ML seperti pengklasifikasi Hutan Acak, kami menyisihkan data pengujian, melatih model menggunakan data pelatihan, dan mengevaluasi metrik pada data pengujian yang tidak terlihat.

Demikian pula, untuk data sintetik, kami menyisihkan sampel data asli – umumnya disebut sebagai kumpulan data tahan atau data uji ditahan tak terlihat – dan mengevaluasi data sintetik yang dihasilkan terhadap kumpulan data tahan.

Dataset holdout diharapkan menjadi representasi dari data asli, namun tidak terlihat saat data sintetik dibuat. Oleh karena itu, sangat penting untuk memiliki skor yang serupa untuk semua metrik saat membandingkan yang asli dengan kumpulan data sintetik dan ketidakhadiran.

Ketika skor serupa diperoleh, kita dapat menetapkan bahwa titik data sintetik bukanlah hasil dari menghafal titik data asli, sambil mempertahankan kesetiaan dan utilitas yang sama.

Pesan terakhir

Dunia mulai memahami kepentingan strategis dari data sintetik. Sebagai ilmuwan data dan pembuat data, adalah tugas kami untuk membangun kepercayaan pada data sintetik yang kami hasilkan dan memastikan bahwa itu untuk suatu tujuan.

Data sintetis berkembang menjadi perangkat yang harus dimiliki dalam perangkat pengembangan ilmu data. Tinjauan Teknologi MIT memiliki terkenal data sintetis sebagai salah satu teknologi terobosan tahun 2022. Kami tidak dapat membayangkan membangun model AI dengan nilai yang sangat baik tanpa data sintetis, klaim Gartner.

Menurut McKinsey, data sintetis meminimalkan biaya dan hambatan yang seharusnya Anda miliki saat mengembangkan algoritme atau mendapatkan akses ke data.

Pembuatan data sintetik adalah tentang mengetahui aplikasi hilir dan memahami pertukaran antara dimensi yang berbeda untuk kualitas data sintetik.

Kesimpulan

Sebagai pengguna data sintetik, penting untuk menentukan konteks kasus penggunaan di mana setiap sampel sintetik akan digunakan di masa mendatang. Sama seperti data nyata, kualitas data sintetik bergantung pada kasus penggunaan yang dimaksud, serta parameter yang dipilih untuk sintesis.

Misalnya, menjaga outlier dalam data sintetik seperti pada data asli berguna untuk kasus penggunaan deteksi penipuan. Namun, ini tidak berguna dalam kasus penggunaan perawatan kesehatan dengan masalah privasi, karena outlier umumnya dapat berupa kebocoran informasi.

Selain itu, ada tradeoff antara kesetiaan, utilitas, dan privasi. Data tidak dapat dioptimalkan untuk ketiganya secara bersamaan. Metrik ini memungkinkan pemangku kepentingan untuk memprioritaskan apa yang penting untuk setiap kasus penggunaan dan mengelola ekspektasi dari data sintetik yang dihasilkan.

Pada akhirnya, saat kita melihat nilai dari setiap metrik dan saat memenuhi ekspektasi, pemangku kepentingan dapat yakin dengan solusi yang mereka bangun menggunakan data sintetik.

Kasus penggunaan untuk data sintetik terstruktur mencakup keseluruhan aplikasi mulai dari data uji untuk pengembangan perangkat lunak hingga membuat lengan kendali sintetik dalam uji klinis.

Jangkau untuk mengeksplorasi peluang ini atau buat PoC untuk menunjukkan nilainya.

Faris Haddad adalah Pemimpin Data & Wawasan di tim Pengejaran Strategis AABG. Dia membantu perusahaan berhasil menjadi berbasis data.

Faris Haddad adalah Pemimpin Data & Wawasan di tim Pengejaran Strategis AABG. Dia membantu perusahaan berhasil menjadi berbasis data.

- Lanjutan (300)

- AI

- ai seni

- generator seni ai

- punya robot

- Pembelajaran Mesin Amazon

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- Petunjuk Teknis

- zephyrnet.dll