Pengiriman data dan wawasan yang hampir real-time memungkinkan bisnis merespons kebutuhan pelanggan mereka dengan cepat. Data waktu nyata dapat berasal dari berbagai sumber, termasuk media sosial, perangkat IoT, pemantauan infrastruktur, pemantauan pusat panggilan, dan banyak lagi. Karena luas dan dalamnya data yang diserap dari berbagai sumber, bisnis mencari solusi untuk melindungi privasi pelanggan mereka dan menjaga data sensitif agar tidak diakses dari sistem akhir. Anda sebelumnya harus mengandalkan mesin aturan informasi identitas pribadi (PII) yang dapat menandai kesalahan positif atau kehilangan data, atau Anda harus membuat dan memelihara model pembelajaran mesin (ML) kustom untuk mengidentifikasi PII dalam data streaming Anda. Anda juga perlu menerapkan dan memelihara infrastruktur yang diperlukan untuk mendukung mesin atau model ini.

Untuk membantu merampingkan proses ini dan mengurangi biaya, Anda dapat menggunakan Amazon Comprehend, layanan pemrosesan bahasa alami (NLP) yang menggunakan ML untuk menemukan wawasan dan hubungan seperti orang, tempat, sentimen, dan topik dalam teks tidak terstruktur. Anda sekarang dapat menggunakan kemampuan Amazon Comprehend ML untuk mendeteksi dan menyunting PII di email pelanggan, tiket dukungan, ulasan produk, media sosial, dan banyak lagi. Tidak diperlukan pengalaman ML. Misalnya, Anda dapat menganalisis tiket dukungan dan artikel pengetahuan untuk mendeteksi entitas PII dan menyunting teks sebelum mengindeks dokumen. Setelah itu, dokumen bebas dari entitas PII dan pengguna dapat menggunakan data tersebut. Menghapus entitas PII membantu Anda melindungi privasi pelanggan Anda dan mematuhi undang-undang dan peraturan setempat.

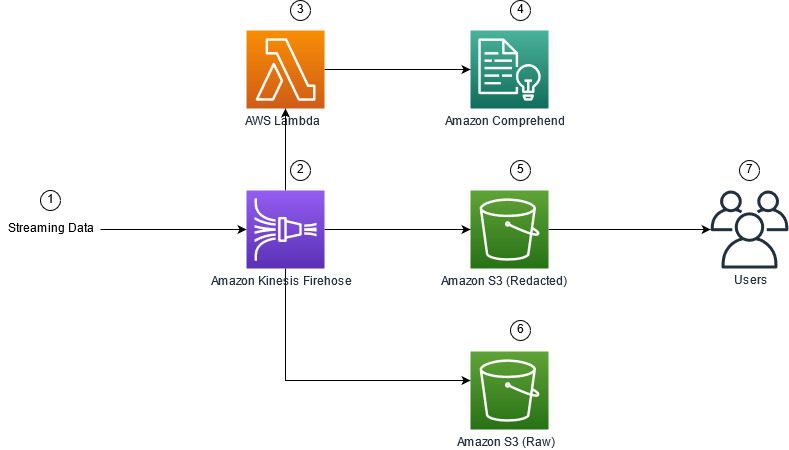

Dalam posting ini, Anda mempelajari cara mengimplementasikan Amazon Comprehend ke dalam arsitektur streaming Anda untuk menyunting entitas PII dalam waktu dekat menggunakan Firehose Data Amazon Kinesis dengan AWS Lambda.

Posting ini difokuskan pada menyunting data dari bidang tertentu yang diserap ke dalam arsitektur streaming menggunakan Kinesis Data Firehose, tempat Anda ingin membuat, menyimpan, dan memelihara salinan turunan tambahan dari data untuk dikonsumsi oleh pengguna akhir atau aplikasi hilir. Jika Anda menggunakan Aliran Data Amazon Kinesis atau memiliki kasus penggunaan tambahan di luar redaksi PII, lihat Terjemahkan, edit, dan analisis data streaming menggunakan fungsi SQL dengan Amazon Kinesis Data Analytics, Amazon Translate, dan Amazon Comprehend, di mana kami menunjukkan bagaimana Anda dapat menggunakan Studio Analisis Data Amazon Kinesis didukung oleh Apache Zeppelin dan Flash Apache untuk menganalisis, menerjemahkan, dan menyunting bidang teks secara interaktif dalam data streaming.

Ikhtisar solusi

Gambar berikut menunjukkan contoh arsitektur untuk melakukan redaksi PII streaming data secara real time, menggunakan Layanan Penyimpanan Sederhana Amazon (Amazon S3), Transformasi data Firehose Data Kinesis, Amazon Comprehend, dan AWS Lambda. Selain itu, kami menggunakan AWS SDK untuk Python (Boto3) untuk fungsi Lambda. Seperti yang ditunjukkan dalam diagram, bucket mentah S3 berisi data yang tidak diedit, dan bucket yang diedit S3 berisi data yang diedit setelah menggunakan Amazon Comprehend DetectPiiEntities API dalam fungsi Lambda.

Biaya yang terlibat

Selain biaya Kinesis Data Firehose, Amazon S3, dan Lambda, solusi ini akan dikenakan biaya penggunaan dari Amazon Comprehend. Jumlah yang Anda bayarkan merupakan faktor dari jumlah total catatan yang berisi PII dan karakter yang diproses oleh fungsi Lambda. Untuk informasi lebih lanjut, lihat Harga Amazon Kinesis Data Firehose, Harga Amazon Comprehend, dan Harga AWS Lambda.

Sebagai contoh, mari kita asumsikan Anda memiliki 10,000 catatan log, dan nilai kunci yang Anda inginkan untuk menyunting PII adalah 500 karakter. Dari 10,000 catatan log, 50 diidentifikasi mengandung PII. Rincian biayanya adalah sebagai berikut:

Berisi Biaya PII:

- Ukuran setiap nilai kunci = 500 karakter (1 unit = 100 karakter)

- Jumlah unit (100 karakter) per record (minimal 3 unit) = 5

- Total unit = 10,000 (rekaman) x 5 (unit per rekaman) x 1 (Permintaan Amazon Comprehend per rekaman) = 50,000

- Harga per unit = $ 0.000002

- Total biaya untuk mengidentifikasi catatan log dengan PII menggunakan API BerisiPiiEntities = $0.1 [50,000 unit x $0.000002]

Hapus Biaya PII:

- Total unit yang berisi PII = 50 (catatan) x 5 (unit per catatan) x 1 (Permintaan Amazon Comprehend per catatan) = 250

- Harga per unit = $ 0.0001

- Total biaya untuk mengidentifikasi lokasi PII menggunakan DetectPiiEntities API = [jumlah unit] x [biaya per unit] = 250 x $0.0001 = $0.025

Total Biaya untuk identifikasi dan redaksi:

- Biaya total: $0.1 (validasi jika bidang berisi PII) + $0.025 (edit bidang yang berisi PII) = $0.125

Terapkan solusi dengan AWS CloudFormation

Untuk postingan kali ini, kami menyediakan Formasi AWS Cloud streaming data redaksi Template, yang memberikan detail lengkap implementasi untuk memungkinkan penerapan berulang. Setelah penerapan, template ini membuat dua bucket S3: satu untuk menyimpan data sampel mentah yang diserap dari Amazon Kinesis Data Generator (KDG), dan satu lagi untuk menyimpan data yang telah diedit. Selain itu, ini menciptakan aliran pengiriman Kinesis Data Firehose dengan DirectPUT sebagai input, dan fungsi Lambda yang memanggil Amazon Comprehend BerisiPiiEntitas dan DeteksiPiiEntities API untuk mengidentifikasi dan menyunting data PII. Fungsi Lambda bergantung pada input pengguna dalam variabel lingkungan untuk menentukan nilai kunci apa yang perlu diperiksa untuk PII.

Fungsi Lambda dalam solusi ini memiliki ukuran muatan terbatas hingga 100 KB. Jika payload disediakan di mana teks lebih besar dari 100 KB, fungsi Lambda akan melewatinya.

Untuk menerapkan solusi, selesaikan langkah-langkah berikut:

- Luncurkan tumpukan CloudFormation di AS Timur (Virginia Utara)

us-east-1:

- Masukkan nama tumpukan, dan biarkan parameter lain tetap default

- Pilih Saya mengakui bahwa AWS CloudFormation dapat membuat sumber daya IAM dengan nama khusus.

- Pilih Buat tumpukan.

Terapkan sumber daya secara manual

Jika Anda lebih suka membangun arsitektur secara manual daripada menggunakan AWS CloudFormation, selesaikan langkah-langkah di bagian ini.

Buat ember S3

Buat bucket S3 Anda dengan langkah-langkah berikut:

- Pada konsol Amazon S3, pilih Ember di panel navigasi.

- Pilih Buat ember.

- Buat satu ember untuk data mentah Anda dan satu lagi untuk data Anda yang telah diedit.

- Catat nama-nama ember yang baru saja Anda buat.

Buat fungsi Lambda

Untuk membuat dan menerapkan fungsi Lambda, selesaikan langkah-langkah berikut:

- Pada konsol Lambda, pilih Buat fungsi.

- Pilih Penulis dari awal.

- Untuk Nama Fungsi, Masuk

AmazonComprehendPII-Redact. - Untuk Runtime, pilih Python 3.9.

- Untuk Arsitektur, pilih x86_64.

- Untuk Peran eksekusi, pilih Buat peran baru dengan izin Lambda.

- Setelah Anda membuat fungsi, masukkan kode berikut:

- Pilih Menyebarkan.

- Di panel navigasi, pilih Konfigurasi.

- Navigasi ke Variabel lingkungan.

- Pilih Edit.

- Untuk kunci, Masuk

keys. - Untuk Nilai, masukkan nilai kunci tempat Anda ingin menyunting PII, dipisahkan dengan koma dan spasi. Misalnya, masukkan

Tweet1,Tweet2jika Anda menggunakan data uji sampel yang disediakan di bagian selanjutnya dari posting ini. - Pilih Save.

- Navigasi ke Konfigurasi umum.

- Pilih Edit.

- Ubah nilai dari batas waktu sampai 1 menit.

- Pilih Save.

- Navigasi ke izin.

- Pilih nama peran di bawah Peran Eksekusi.

Anda dialihkan ke Identitas AWS dan Manajemen Akses (IAM) konsol. - Untuk Tambahkan izin, pilih Lampirkan kebijakan.

- Enter

Comprehendke dalam bilah pencarian dan pilih kebijakanComprehendFullAccess. - Pilih Lampirkan kebijakan.

Buat aliran pengiriman Firehose

Untuk membuat aliran pengiriman Firehose Anda, selesaikan langkah-langkah berikut:

- Pada konsol Firehose Data Kinesis, pilih Buat aliran pengiriman.

- Untuk sumber, pilih PUT langsung.

- Untuk Tujuan, pilih Amazon S3.

- Untuk Nama aliran pengiriman, Masuk

ComprehendRealTimeBlog. - Bawah Transformasikan catatan sumber dengan AWS Lambda, pilih Enabled.

- Untuk Fungsi AWS Lambda, masukkan ARN untuk fungsi yang Anda buat, atau telusuri fungsi

AmazonComprehendPII-Redact. - Untuk Ukuran buffer, atur nilainya menjadi 1 MB.

- Untuk Interval Penyangga, biarkan selama 60 detik.

- Bawah Pengaturan Tujuan, pilih bucket S3 yang Anda buat untuk data yang diedit.

- Bawah Pengaturan Cadangan, pilih bucket S3 yang Anda buat untuk data mentah.

- Bawah izin, buat atau perbarui peran IAM, atau pilih peran yang ada dengan izin yang sesuai.

- Pilih Buat aliran pengiriman.

Terapkan solusi data streaming dengan Kinesis Data Generator

Anda dapat menggunakan Kinesis Data Generator (KDG) untuk menyerap data sampel ke Kinesis Data Firehose dan menguji solusinya. Untuk menyederhanakan proses ini, kami menyediakan fungsi Lambda dan template CloudFormation untuk membuat Amazon Kognito pengguna dan memberikan izin yang sesuai untuk menggunakan KDG.

- pada Halaman Generator Data Amazon Kinesis, pilih Buat Pengguna Cognito dengan CloudFormation.Anda dialihkan ke konsol AWS CloudFormation untuk membuat tumpukan Anda.

- Berikan nama pengguna dan kata sandi untuk pengguna yang Anda gunakan untuk masuk ke KDG.

- Biarkan pengaturan lain pada default dan buat tumpukan Anda.

- pada Output tab, pilih tautan KDG UI.

- Masukkan nama pengguna dan kata sandi Anda untuk masuk.

Kirim catatan pengujian dan validasi redaksi di Amazon S3

Untuk menguji solusi, selesaikan langkah-langkah berikut:

- Masuk ke URL KDG yang Anda buat di langkah sebelumnya.

- Pilih Wilayah tempat tumpukan AWS CloudFormation diterapkan.

- Untuk Aliran/aliran pengiriman, pilih aliran pengiriman yang Anda buat (jika Anda menggunakan templat, itu memiliki format

accountnumber-awscomprehend-blog). - Biarkan pengaturan lainnya pada defaultnya.

- Untuk templat rekaman, Anda dapat membuat pengujian sendiri, atau menggunakan templat berikut. Jika Anda menggunakan data sampel yang disediakan di bawah ini untuk pengujian, Anda harus memperbarui variabel lingkungan di

AmazonComprehendPII-RedactFungsi lambda untukTweet1,Tweet2. Jika digunakan melalui CloudFormation, perbarui variabel lingkungan keTweet1,Tweet2dalam fungsi Lambda yang dibuat. Contoh data uji di bawah ini: - Pilih Kirim Data, dan tunggu beberapa detik hingga rekaman dikirim ke aliran Anda.

- Setelah beberapa detik, hentikan generator KDG dan periksa bucket S3 Anda untuk file yang dikirimkan.

Berikut ini adalah contoh data mentah di keranjang S3 mentah:

Berikut ini adalah contoh data yang diedit di bucket S3 yang diedit:

Informasi sensitif telah dihapus dari pesan yang disunting, memberikan keyakinan bahwa Anda dapat membagikan data ini dengan sistem akhir.

Membersihkan

Setelah selesai bereksperimen dengan solusi ini, bersihkan sumber daya Anda dengan menggunakan konsol AWS CloudFormation untuk menghapus semua sumber daya yang diterapkan dalam contoh ini. Jika Anda mengikuti langkah-langkah manual, Anda harus menghapus kedua ember secara manual, AmazonComprehendPII-Redact fungsi, ComprehendRealTimeBlog aliran, grup log untuk ComprehendRealTimeBlog streaming, dan peran IAM apa pun yang dibuat.

Kesimpulan

Posting ini menunjukkan kepada Anda cara mengintegrasikan redaksi PII ke arsitektur streaming hampir real-time Anda dan mengurangi waktu pemrosesan data dengan melakukan redaksi dalam penerbangan. Dalam skenario ini, Anda memberikan data yang telah diedit ke pengguna akhir Anda dan administrator data lake mengamankan keranjang mentah untuk digunakan nanti. Anda juga dapat membangun pemrosesan tambahan dengan Amazon Comprehend untuk mengidentifikasi nada atau sentimen, mengidentifikasi entitas dalam data, dan mengklasifikasikan setiap pesan.

Kami menyediakan langkah-langkah individual untuk setiap layanan sebagai bagian dari posting ini, dan juga menyertakan template CloudFormation yang memungkinkan Anda untuk menyediakan sumber daya yang diperlukan di akun Anda. Template ini harus digunakan untuk bukti konsep atau skenario pengujian saja. Lihat panduan pengembang untuk Amazon Comprehend, Lambda, dan Firehose Data Kinesis untuk setiap batas layanan.

Untuk memulai dengan identifikasi dan redaksi PII, lihat Informasi identitas pribadi (PII). Dengan arsitektur contoh dalam posting ini, Anda dapat mengintegrasikan semua API Amazon Comprehend dengan data hampir real-time menggunakan transformasi data Kinesis Data Firehose. Untuk mempelajari lebih lanjut tentang apa yang dapat Anda bangun dengan data hampir real-time Anda dengan Kinesis Data Firehose, lihat Panduan Pengembang Amazon Kinesis Data Firehose. Solusi ini tersedia di semua Wilayah AWS tempat Amazon Comprehend dan Kinesis Data Firehose tersedia.

Tentang penulis

Joe Morotti adalah Arsitek Solusi di Amazon Web Services (AWS), membantu pelanggan Perusahaan di seluruh Midwest AS. Dia telah memegang berbagai peran teknis dan menikmati menunjukkan seni pelanggan yang mungkin. Di waktu luangnya, ia menikmati menghabiskan waktu berkualitas bersama keluarganya menjelajahi tempat-tempat baru dan menganalisis kinerja tim olahraganya secara berlebihan.

Joe Morotti adalah Arsitek Solusi di Amazon Web Services (AWS), membantu pelanggan Perusahaan di seluruh Midwest AS. Dia telah memegang berbagai peran teknis dan menikmati menunjukkan seni pelanggan yang mungkin. Di waktu luangnya, ia menikmati menghabiskan waktu berkualitas bersama keluarganya menjelajahi tempat-tempat baru dan menganalisis kinerja tim olahraganya secara berlebihan.

Sriharsh Adari adalah Arsitek Solusi Senior di Amazon Web Services (AWS), di mana dia membantu pelanggan bekerja mundur dari hasil bisnis untuk mengembangkan solusi inovatif di AWS. Selama bertahun-tahun, dia telah membantu banyak pelanggan dalam transformasi platform data di seluruh vertikal industri. Bidang keahlian utamanya meliputi Strategi Teknologi, Analisis Data, dan Ilmu Data. Di waktu luangnya, ia menikmati bermain tenis, menonton acara TV, dan bermain Tabla.

Sriharsh Adari adalah Arsitek Solusi Senior di Amazon Web Services (AWS), di mana dia membantu pelanggan bekerja mundur dari hasil bisnis untuk mengembangkan solusi inovatif di AWS. Selama bertahun-tahun, dia telah membantu banyak pelanggan dalam transformasi platform data di seluruh vertikal industri. Bidang keahlian utamanya meliputi Strategi Teknologi, Analisis Data, dan Ilmu Data. Di waktu luangnya, ia menikmati bermain tenis, menonton acara TV, dan bermain Tabla.

- AI

- ai seni

- generator seni ai

- punya robot

- Amazon Kinesis

- analisis

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- Pembelajaran Mesin AWS

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Menengah (200)

- Firehose Data Kinesis

- Mesin belajar

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll