- Januari 20, 2014

- Vasilis Vriniotis

- . 5 Komentar

Dalam klasifikasi teks, pemilihan fitur adalah proses memilih subset tertentu dari istilah set pelatihan dan hanya menggunakannya dalam algoritma klasifikasi. Proses pemilihan fitur berlangsung sebelum pelatihan pengklasifikasi.

Pembaruan: Kerangka Pembelajaran Mesin Datumbox sekarang open-source dan bebas untuk Download. Lihat paket com.datumbox.framework.machinelearning.featureselection untuk melihat penerapan metode Seleksi Chi-square dan Mutual Information Feature di Java.

Keuntungan utama menggunakan algoritme pemilihan fitur adalah fakta yang mengurangi dimensi data kami, membuat pelatihan lebih cepat dan dapat meningkatkan akurasi dengan menghapus fitur yang berisik. Karena itu pemilihan fitur dapat membantu kita menghindari overfitting.

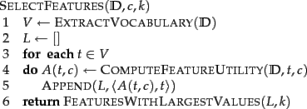

Algoritme pemilihan dasar untuk memilih k fitur terbaik disajikan di bawah ini (Manning dkk, 2008):

Pada bagian selanjutnya kami menyajikan dua algoritma pemilihan fitur yang berbeda: Mutual Information dan Chi Square.

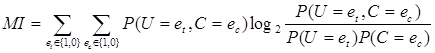

Saling Informasi

Salah satu metode pemilihan fitur yang paling umum adalah Mutual Information dari term t di kelas c (Manning dkk, 2008). Ini mengukur seberapa banyak informasi ada atau tidak adanya istilah tertentu yang berkontribusi untuk membuat keputusan klasifikasi yang benar pada c. Informasi timbal balik dapat dihitung dengan menggunakan rumus berikut:

[1]

[1]

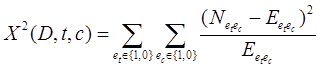

Dalam perhitungan kami, karena kami menggunakan Estimasi Kemungkinan Maksimum dari probabilitas, kami dapat menggunakan persamaan berikut:

![]() [2]

[2]

Dimana N adalah jumlah dokumen, Ntcadalah hitungan dokumen yang memiliki nilai et (kemunculan istilah t dalam dokumen; dibutuhkan nilai 1 atau 0) dan ec(kemunculan dokumen di kelas c; dibutuhkan nilai 1 atau 0) yang ditunjukkan oleh dua subskrip, ![]() dan

dan ![]() . Akhirnya kita harus mencatat bahwa semua variabel yang disebutkan di atas mengambil nilai non-negatif.

. Akhirnya kita harus mencatat bahwa semua variabel yang disebutkan di atas mengambil nilai non-negatif.

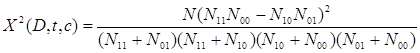

Kotak Chi

Metode pemilihan fitur umum lainnya adalah Kotak Chi. X2 tes digunakan dalam statistik, antara lain untuk menguji independensi dua peristiwa. Lebih khusus lagi dalam pemilihan fitur kami menggunakannya untuk menguji apakah kemunculan istilah tertentu dan kemunculan kelas tertentu adalah independen. Jadi kami memperkirakan jumlah berikut untuk setiap istilah dan kami memberi peringkat berdasarkan skornya:

[3]

[3]

Nilai tinggi pada x2 menunjukkan bahwa hipotesis nol (H0) independensi harus ditolak dan dengan demikian kemunculan istilah dan kelas tergantung. Jika tergantung maka kami memilih fitur untuk klasifikasi teks.

Rumus di atas dapat ditulis ulang sebagai berikut:

[4]

[4]

Jika kita menggunakan metode Chi Square, kita harus memilih hanya sejumlah fitur yang telah ditentukan sebelumnya yang memiliki ax2 skor tes lebih besar dari 10.83 yang menunjukkan signifikansi statistik pada tingkat 0.001.

Last but not least kita harus mencatat bahwa dari titik statistik pemilihan fitur Chi Square tidak akurat, karena satu derajat kebebasan dan Koreksi Yates sebaiknya digunakan sebagai gantinya (yang akan mempersulit pencapaian signifikansi statistik). Jadi kita harus mengharapkan bahwa dari total fitur yang dipilih, sebagian kecil dari mereka tidak tergantung pada kelas). Jadi kita harus mengharapkan bahwa dari total fitur yang dipilih, sebagian kecil dari mereka tidak bergantung pada kelas. Namun demikian sebagai Manning dkk (2008) menunjukkan, fitur berisik ini tidak terlalu memengaruhi keakuratan keseluruhan pengklasifikasi kami.

Menghapus fitur berisik / langka

Teknik lain yang dapat membantu kita menghindari overfitting, mengurangi konsumsi memori dan meningkatkan kecepatan, adalah dengan menghilangkan semua istilah langka dari kosakata. Misalnya seseorang dapat menghilangkan semua istilah yang muncul hanya sekali di semua kategori. Menghapus istilah tersebut dapat mengurangi penggunaan memori dengan faktor yang signifikan dan meningkatkan kecepatan analisis. Akhirnya kita tidak boleh menggunakan teknik ini bersama dengan algoritma pemilihan fitur di atas.

Apakah Anda suka artikelnya? Silakan luangkan waktu sebentar untuk membagikannya di Twitter. 🙂

- AI

- ai seni

- generator seni ai

- punya robot

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- kotak data

- belajar mendalam

- google itu

- Mesin belajar

- Pembelajaran Mesin & Statistik

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- skala ai

- sintaksis

- zephyrnet.dll