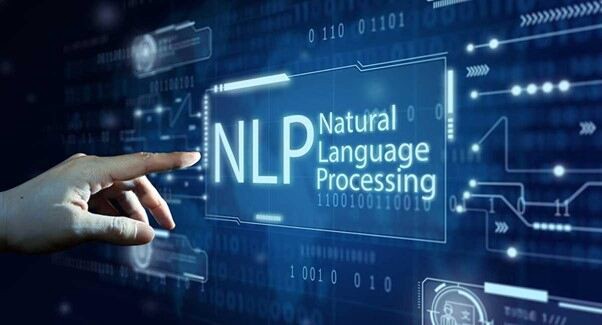

Mereka mengatakan 'Tindakan berbicara lebih keras daripada Kata-kata'. Namun, dalam beberapa kasus, kata-kata (diuraikan dengan tepat) dapat menentukan seluruh tindakan yang relevan dengan mesin dan model yang sangat cerdas. Pendekatan untuk membuat kata-kata lebih bermakna bagi mesin ini adalah NLP atau Pengolahan Bahasa alami.

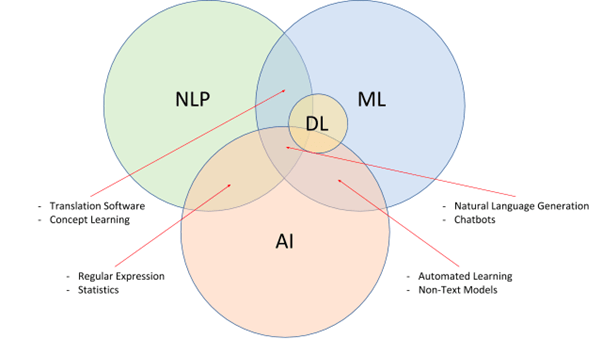

Untuk yang belum berpengalaman, NLP adalah subbidang Kecerdasan Buatan yang mampu memecah bahasa manusia dan memberi makan prinsip yang sama ke model cerdas. NLP, dipasangkan dengan NLU (Natural Language Understanding) dan NLG (Natural Language Generation), bertujuan untuk mengembangkan mesin pencari yang sangat cerdas dan proaktif, pemeriksa tata bahasa, terjemahan, asisten suara, dan banyak lagi.

Sederhananya, NLP memecah kompleksitas bahasa, menyajikan hal yang sama ke mesin sebagai kumpulan data untuk mengambil referensi, dan juga mengekstrak maksud dan konteks untuk mengembangkannya lebih lanjut. Namun, mengimplementasikannya memiliki tantangan tersendiri.

Apa itu NLP: Dari Perspektif Startup?

Sulit bagi manusia untuk mempelajari bahasa baru, apalagi mesin. Namun, jika kita membutuhkan mesin untuk membantu kita sepanjang hari, mereka perlu memahami dan menanggapi bahasa tipe manusia. Pemrosesan Bahasa Alami membuatnya mudah dengan memecah bahasa manusia menjadi bit yang dapat dimengerti mesin, digunakan untuk melatih model hingga sempurna.

Selain itu, NLP mendapat dukungan dari NLU, yang bertujuan untuk memecah kata dan kalimat dari sudut pandang kontekstual. Terakhir, ada NLG untuk membantu mesin merespons dengan membuat versi bahasa manusia mereka sendiri untuk komunikasi dua arah.

Startup yang berencana merancang dan mengembangkan chatbot, asisten suara, dan alat interaktif lainnya perlu mengandalkan layanan dan solusi NLP untuk mengembangkan mesin dengan kemampuan penguraian bahasa dan maksud yang akurat.

Tantangan NLP untuk Dipertimbangkan

Kata-kata dapat memiliki arti yang berbeda. Bahasa gaul bisa lebih sulit untuk dihilangkan secara kontekstual. Dan bahasa tertentu sulit untuk dimasukkan, karena kurangnya sumber daya. Meskipun menjadi salah satu teknologi yang paling banyak dicari, NLP hadir dengan tantangan AI yang berakar dan implementasi berikut.

Kurangnya Konteks untuk Homograf, Homofon, dan Homonim

'Kelelawar' bisa menjadi alat olahraga dan bahkan mamalia bersayap yang tergantung di pohon. Meskipun ejaannya sama, mereka berbeda dalam arti dan konteksnya. Demikian pula, 'Ada' dan 'Mereka' terdengar sama namun memiliki ejaan dan arti yang berbeda.

Bahkan manusia terkadang sulit memahami perbedaan halus dalam penggunaan. Oleh karena itu, meskipun NLP dianggap sebagai salah satu opsi yang lebih andal untuk melatih mesin dalam domain khusus bahasa, kata-kata dengan ejaan, suara, dan pengucapan yang mirip dapat membuang konteksnya secara signifikan.

Kemenduaan

Jika menurut Anda kata-kata belaka dapat membingungkan, berikut ini adalah kalimat ambigu dengan interpretasi yang tidak jelas.

“Saya memotret seorang anak di mal dengan kamera saya”- Jika diajak bicara, bisa jadi mesin menjadi bingung apakah anak itu dijepret menggunakan kamera atau ketika anak itu dijepret, dia punya kamera Anda.

Bentuk kebingungan atau ambiguitas ini cukup umum jika Anda mengandalkan solusi NLP yang tidak kredibel. Sejauh menyangkut kategorisasi, ambiguitas dapat dipisahkan sebagai Sintaksis (berbasis makna), Leksikal (berbasis kata), dan Semantik (berbasis konteks).

Kesalahan yang relevan dengan Kecepatan dan Teks

Mesin yang mengandalkan umpan semantik tidak dapat dilatih jika bit ucapan dan teks salah. Isu ini dianalogikan dengan keterlibatan kata-kata yang disalahgunakan atau bahkan salah eja, yang dapat membuat model tersebut berulah dari waktu ke waktu. Meskipun alat koreksi tata bahasa yang dikembangkan cukup baik untuk menghilangkan kesalahan spesifik kalimat, data pelatihan harus bebas dari kesalahan untuk memfasilitasi pengembangan yang akurat sejak awal.

Ketidakmampuan untuk menyesuaikan diri dengan bahasa gaul dan bahasa sehari-hari

Bahkan jika layanan NLP mencoba dan menskalakan melampaui ambiguitas, kesalahan, dan homonim, menyesuaikan dengan terak atau kata demi kata khusus budaya tidaklah mudah. Ada kata-kata yang tidak memiliki referensi kamus standar tetapi mungkin masih relevan dengan kumpulan audiens tertentu. Jika Anda berencana untuk merancang asisten atau model suara bertenaga AI khusus, penting untuk memasukkan referensi yang relevan untuk membuat sumber daya cukup tanggap.

Salah satu contohnya adalah chatbot khusus 'Teori Big Bang' yang memahami 'Buzzinga' dan bahkan merespons hal yang sama.

Apatis terhadap Lingo Khusus Vertikal

Seperti bahasa khusus budaya, bisnis tertentu menggunakan terminologi yang sangat teknis dan spesifik vertikal yang mungkin tidak sesuai dengan model bertenaga NLP standar. Oleh karena itu, jika Anda berencana untuk mengembangkan mode khusus bidang dengan kemampuan pengenalan suara, proses ekstraksi entitas, pelatihan, dan pengadaan data harus sangat dikurasi dan spesifik.

Kurangnya Data yang Dapat Digunakan

NLP bergantung pada konsep analisis sentimental dan linguistik bahasa, diikuti dengan pengadaan data, pembersihan, pelabelan, dan pelatihan. Namun, beberapa bahasa tidak memiliki banyak data yang dapat digunakan atau konteks historis untuk solusi NLP untuk diselesaikan.

Kurangnya R&D

Implementasi NLP tidak satu dimensi. Sebaliknya, itu membutuhkan teknologi bantu seperti jaringan saraf dan pembelajaran mendalam untuk berkembang menjadi sesuatu yang memecahkan jalan. Menambahkan algoritme khusus ke implementasi NLP tertentu adalah cara yang bagus untuk merancang model khusus - peretasan yang sering gagal karena kurangnya alat penelitian dan pengembangan yang memadai.

Skala Di Atas Masalah Ini, Hari Ini: Bagaimana Memilih Vendor yang Tepat?

Dari memperbaiki ambiguitas hingga kesalahan hingga masalah dengan pengumpulan data, penting untuk memiliki vendor yang tepat yang Anda inginkan untuk melatih dan mengembangkan Model NLP yang dibayangkan. Dan sementara beberapa faktor perlu dipertimbangkan, berikut adalah beberapa fitur yang lebih diinginkan untuk dipertimbangkan saat menghubungkan:

- Basis data khusus domain yang cukup besar (audio, ucapan, dan video), apa pun bahasanya.

- Kemampuan untuk menerapkan penandaan Part-of-Speech untuk menghilangkan ambiguitas.

- Dukungan untuk teknologi bantuan khusus seperti Penyematan Kalimat Mulingual untuk meningkatkan kualitas interpretasi.

- Anotasi data yang mulus untuk melabeli kumpulan data sesuai persyaratan.

- Basis data multibahasa dengan pilihan siap pakai untuk digunakan.

Vendor yang menawarkan sebagian besar atau bahkan beberapa fitur ini dapat dipertimbangkan untuk merancang model NLP Anda.

Wrap-Up

Tak perlu dikatakan, NLP telah berkembang menjadi salah satu teknologi bertenaga Artificial Intelligence yang diterima secara luas dan dipuji. Jika Anda lebih spesifik, pasar NLP diperkirakan akan tumbuh hampir 1400% pada tahun 2025, dibandingkan dengan tahun 2017. Sesuai ekspektasi dan ekstrapolasi, pasar NLP akan bernilai hampir 43 miliar pada akhir tahun 2025 — statista

Terlepas dari manfaatnya, Pemrosesan Bahasa Alami hadir dengan beberapa keterbatasan-sesuatu yang dapat Anda atasi saat terhubung dengan vendor AI yang andal.

Vatsal Ghiya, Pendiri Shaip, adalah seorang pengusaha dengan lebih dari 20 tahun pengalaman dalam perangkat lunak dan layanan kesehatan AI.

Awalnya diterbitkan pada https://thinkml.ai pada 1 Juni 2022.

![]()

Apa Tantangan Pemrosesan Bahasa Alami, dan Bagaimana Cara Memperbaikinya? awalnya diterbitkan di Kehidupan Chatbots on Medium, di mana orang-orang melanjutkan pembicaraan dengan menyoroti dan merespons cerita ini.

- Coinsmart. Pertukaran Bitcoin dan Crypto Terbaik Eropa.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. AKSES GRATIS.

- CryptoHawk. Radar Altcoin. Uji Coba Gratis.

- Source: https://chatbotslife.com/what-are-the-natural-language-processing-challenges-and-how-to-fix-6c1e185dd95?source=rss—-a49517e4c30b—4

- "

- 20 tahun

- 2022

- a

- tepat

- di seluruh

- Bertindak

- Tindakan

- alamat

- AI

- algoritma

- Kemenduaan

- analisis

- pendekatan

- sekitar

- buatan

- kecerdasan buatan

- Asisten

- para penonton

- audio

- makhluk

- Manfaat

- Luar

- Milyar

- istirahat

- bisnis

- kemampuan

- mampu

- kasus

- tertentu

- tantangan

- Pilih

- koleksi

- Umum

- Komunikasi

- dibandingkan

- kompleksitas

- kebingungan

- Menghubungkan

- Mempertimbangkan

- Percakapan

- dikuratori

- adat

- data

- Basis Data

- hari

- mendalam

- Mendesain

- merancang

- Meskipun

- Menentukan

- mengembangkan

- berkembang

- Pengembangan

- alat pengembangan

- berbeda

- berbeda

- domain

- turun

- entitas

- Pengusaha

- berkembang

- contoh

- harapan

- diharapkan

- pengalaman

- Ekstrak

- faktor

- Fitur

- Akhirnya

- Pertama

- cocok

- Memperbaiki

- berikut

- bentuk

- pendiri

- dari

- lebih lanjut

- menghasilkan

- generasi

- baik

- besar

- Tumbuh

- terjangan

- kesehatan

- membantu

- di sini

- sangat

- historis

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTTPS

- manusia

- Manusia

- melaksanakan

- implementasi

- mengimplementasikan

- penting

- memperbaiki

- Intelijen

- Cerdas

- maksud

- interaktif

- interpretasi

- isu

- masalah

- IT

- label

- pelabelan

- bahasa

- Bahasa

- BELAJAR

- pengetahuan

- mesin

- Mesin

- membuat

- MEMBUAT

- Membuat

- Pasar

- makna

- berarti

- medium

- mungkin

- kesalahan

- model

- model

- lebih

- paling

- Alam

- kebutuhan

- jaringan

- menawarkan

- Opsi

- Lainnya

- sendiri

- Konsultan Ahli

- perspektif

- perencanaan

- Titik

- Sudut pandang

- tepat

- masalah

- proses

- pengolahan

- kualitas

- relevan

- dapat diandalkan

- Persyaratan

- membutuhkan

- penelitian

- penelitian dan pengembangan

- sumber

- Sumber

- sama

- Skala

- Pencarian

- Mesin pencari

- Layanan

- set

- beberapa

- Share

- mirip

- Demikian pula

- Perangkat lunak

- Solusi

- beberapa

- sesuatu

- Bicara

- tertentu

- kecepatan

- standar

- Masih

- mendukung

- Teknis

- Teknologi

- Grafik

- karena itu

- waktu

- kali

- hari ini

- alat

- alat

- terhadap

- Pelatihan

- memahami

- pemahaman

- mengerti

- us

- menggunakan

- dihargai

- penjaja

- versi

- Video

- View

- Suara

- menyiangi

- Apa

- apakah

- sementara

- kata

- Kerja

- akan

- tahun

- Anda