Dengan Basis Pengetahuan untuk Batuan Dasar Amazon, Anda dapat menyambungkan model pondasi (FM) dengan aman Batuan Dasar Amazon ke data perusahaan Anda untuk Retrieval Augmented Generation (RAG). Akses terhadap data tambahan membantu model ini menghasilkan respons yang lebih relevan, spesifik konteks, dan akurat tanpa perlu melatih kembali FM.

Dalam postingan ini, kami membahas dua fitur baru Basis Pengetahuan untuk Amazon Bedrock khusus untuk RetrieveAndGenerate API: mengonfigurasi jumlah hasil maksimum dan membuat perintah khusus dengan templat perintah basis pengetahuan. Anda sekarang dapat memilih ini sebagai opsi kueri di samping jenis pencarian.

Ikhtisar dan manfaat fitur baru

Opsi jumlah hasil maksimum memberi Anda kendali atas jumlah hasil pencarian yang akan diambil dari penyimpanan vektor dan diteruskan ke FM untuk menghasilkan jawabannya. Hal ini memungkinkan Anda menyesuaikan jumlah informasi latar belakang yang disediakan untuk pembuatan, sehingga memberikan lebih banyak konteks untuk pertanyaan kompleks atau lebih sedikit untuk pertanyaan sederhana. Ini memungkinkan Anda mengambil hingga 100 hasil. Opsi ini membantu meningkatkan kemungkinan konteks yang relevan, sehingga meningkatkan akurasi dan mengurangi halusinasi dari respons yang dihasilkan.

Templat perintah basis pengetahuan kustom memungkinkan Anda mengganti templat perintah default dengan templat Anda sendiri untuk menyesuaikan perintah yang dikirimkan ke model untuk pembuatan respons. Hal ini memungkinkan Anda untuk menyesuaikan nada, format output, dan perilaku FM saat merespons pertanyaan pengguna. Dengan opsi ini, Anda dapat menyempurnakan terminologi agar lebih sesuai dengan industri atau domain Anda (seperti layanan kesehatan atau hukum). Selain itu, Anda dapat menambahkan instruksi dan contoh khusus yang disesuaikan dengan alur kerja spesifik Anda.

Di bagian berikut, kami menjelaskan bagaimana Anda dapat menggunakan fitur-fitur ini dengan Konsol Manajemen AWS atau SDK.

Prasyarat

Untuk mengikuti contoh-contoh ini, Anda harus memiliki basis pengetahuan yang ada. Untuk petunjuk cara membuatnya, lihat Buat basis pengetahuan.

Konfigurasikan jumlah hasil maksimum menggunakan konsol

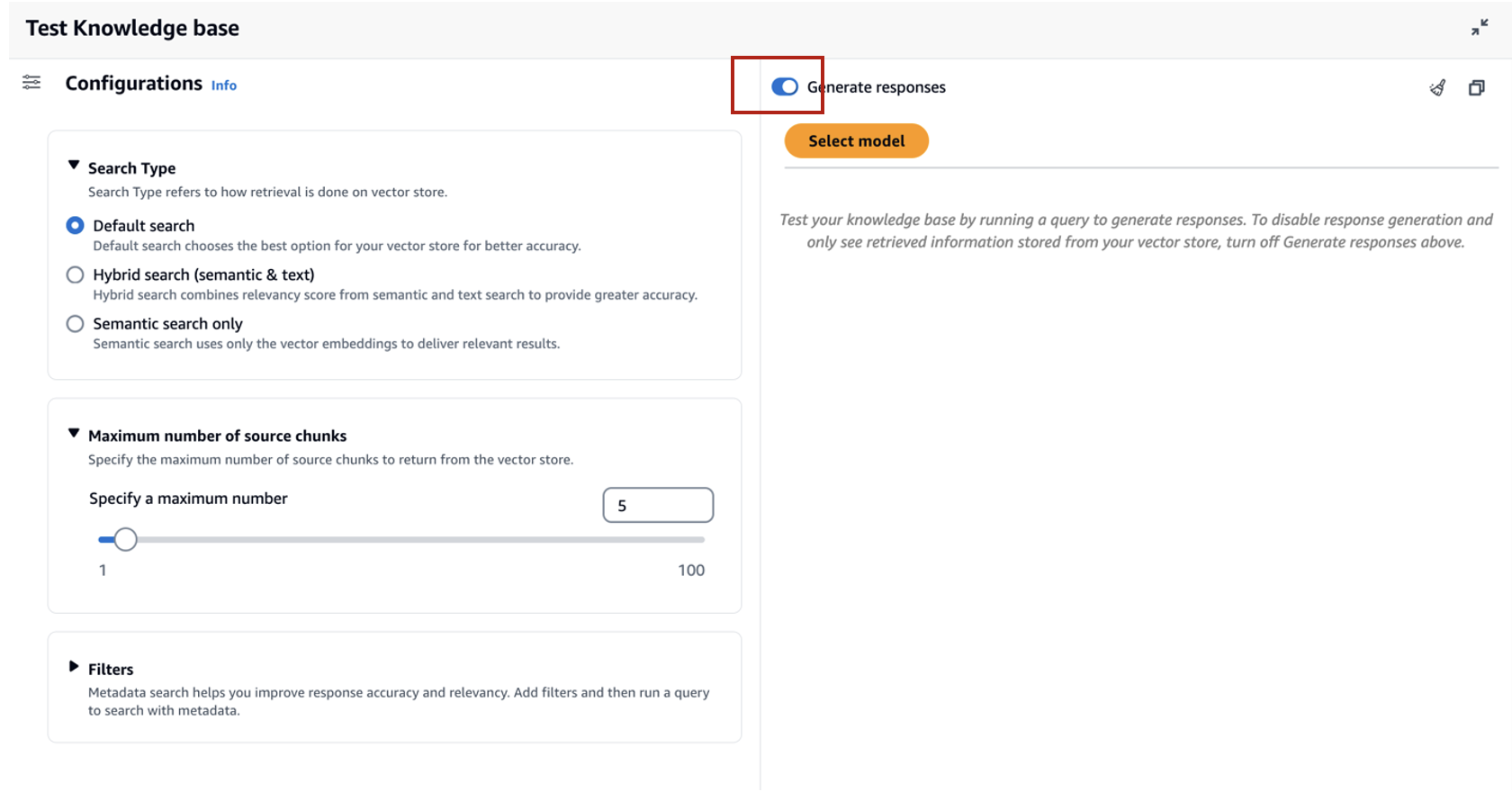

Untuk menggunakan opsi jumlah hasil maksimum menggunakan konsol, selesaikan langkah-langkah berikut:

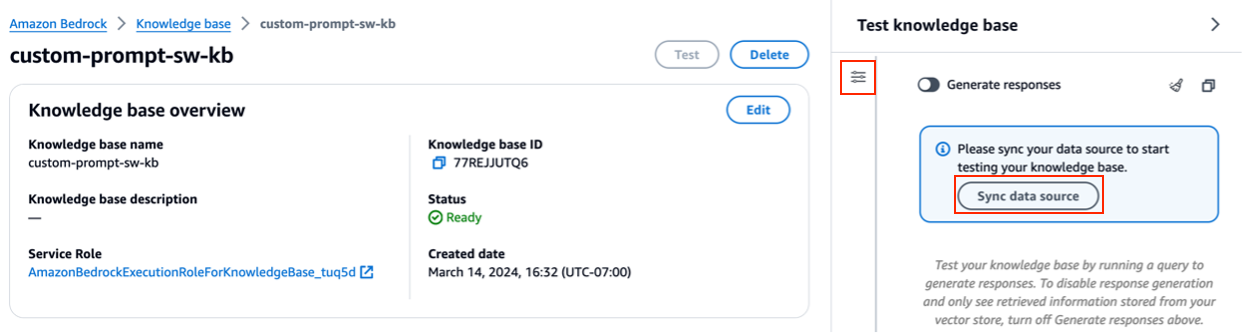

- Di konsol Amazon Bedrock, pilih Basis pengetahuan di panel navigasi kiri.

- Pilih basis pengetahuan yang Anda buat.

- Pilih Uji basis pengetahuan.

- Pilih ikon konfigurasi.

- Pilih Sinkronkan sumber data sebelum Anda mulai menguji basis pengetahuan Anda.

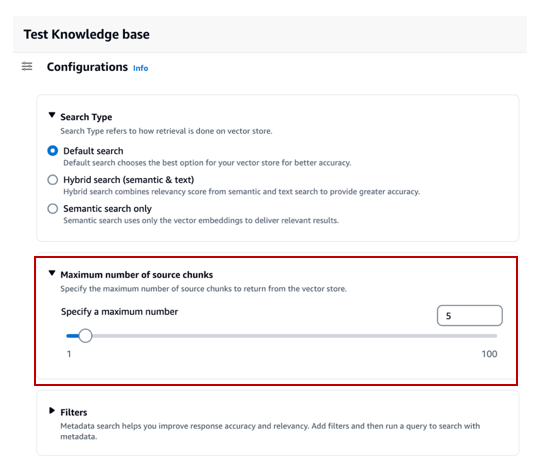

- Bawah Konfigurasi, Untuk Pencarian Tipe, pilih jenis pencarian berdasarkan kasus penggunaan Anda.

Untuk posting ini, kami menggunakan pencarian hybrid karena menggabungkan pencarian semantik dan teks untuk memberikan akurasi yang lebih besar pada penyedia. Untuk mempelajari lebih lanjut tentang pencarian hibrid, lihat Basis Pengetahuan untuk Amazon Bedrock kini mendukung pencarian hibrid.

- Lihat lebih lanjut Jumlah maksimum potongan sumber dan atur jumlah hasil maksimum Anda.

Untuk menunjukkan nilai fitur baru ini, kami menunjukkan contoh bagaimana Anda dapat meningkatkan keakuratan respons yang dihasilkan. Kami menggunakan Dokumen Amazon 10K untuk tahun 2023 sebagai sumber data untuk menciptakan basis pengetahuan. Kami menggunakan kueri berikut untuk eksperimen: “Pada tahun berapa pendapatan tahunan Amazon meningkat dari $245 miliar menjadi $434 miliar?”

Respons yang benar untuk pertanyaan ini adalah “Pendapatan tahunan Amazon meningkat dari $245 miliar pada tahun 2019 menjadi $434 miliar pada tahun 2022,” berdasarkan dokumen di basis pengetahuan. Kami menggunakan Claude v2 sebagai FM untuk menghasilkan respons akhir berdasarkan informasi kontekstual yang diambil dari basis pengetahuan. Claude 3 Soneta dan Claude 3 Haiku juga didukung sebagai generasi FM.

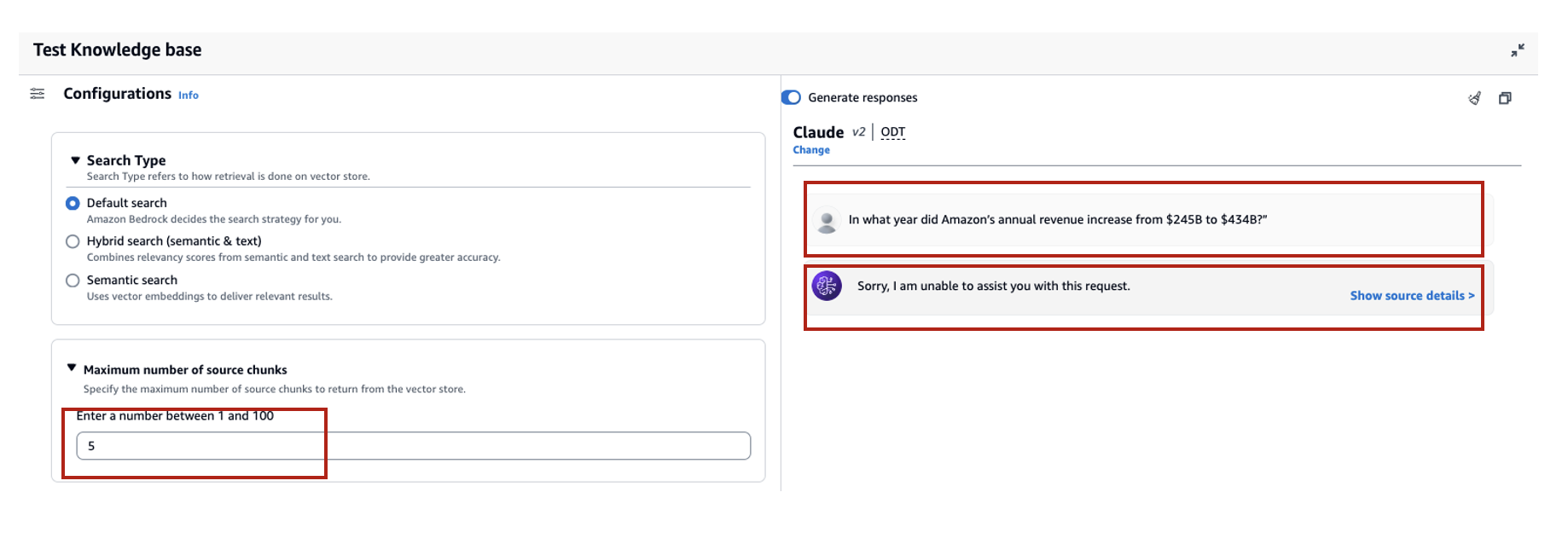

Kami menjalankan kueri lain untuk mendemonstrasikan perbandingan pengambilan dengan konfigurasi berbeda. Kami menggunakan kueri masukan yang sama (“Pada tahun berapa pendapatan tahunan Amazon meningkat dari $245 miliar menjadi $434 miliar?”) dan menetapkan jumlah hasil maksimum menjadi 5.

Seperti yang ditunjukkan pada tangkapan layar berikut, respons yang dihasilkan adalah “Maaf, saya tidak dapat membantu Anda dengan permintaan ini.”

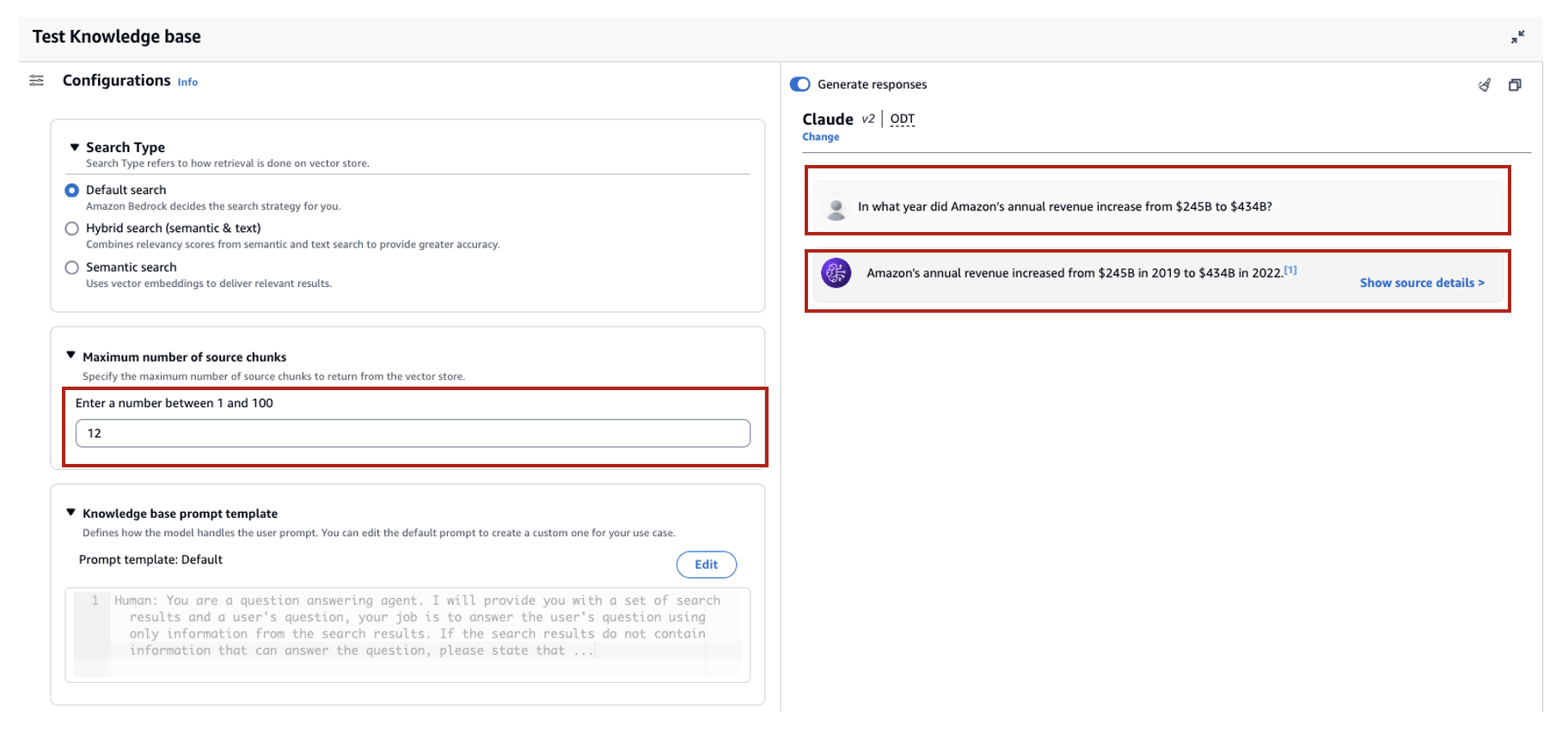

Selanjutnya, kita atur hasil maksimal menjadi 12 dan ajukan pertanyaan yang sama. Respons yang dihasilkan adalah “peningkatan pendapatan tahunan Amazon dari $245 miliar pada tahun 2019 menjadi $434 miliar pada tahun 2022.”

Seperti yang ditunjukkan dalam contoh ini, kami dapat mengambil jawaban yang benar berdasarkan jumlah hasil yang diambil. Jika Anda ingin mempelajari lebih lanjut tentang atribusi sumber yang merupakan hasil akhir, pilih Tampilkan detail sumber untuk memvalidasi jawaban yang dihasilkan berdasarkan basis pengetahuan.

Sesuaikan templat prompt basis pengetahuan menggunakan konsol

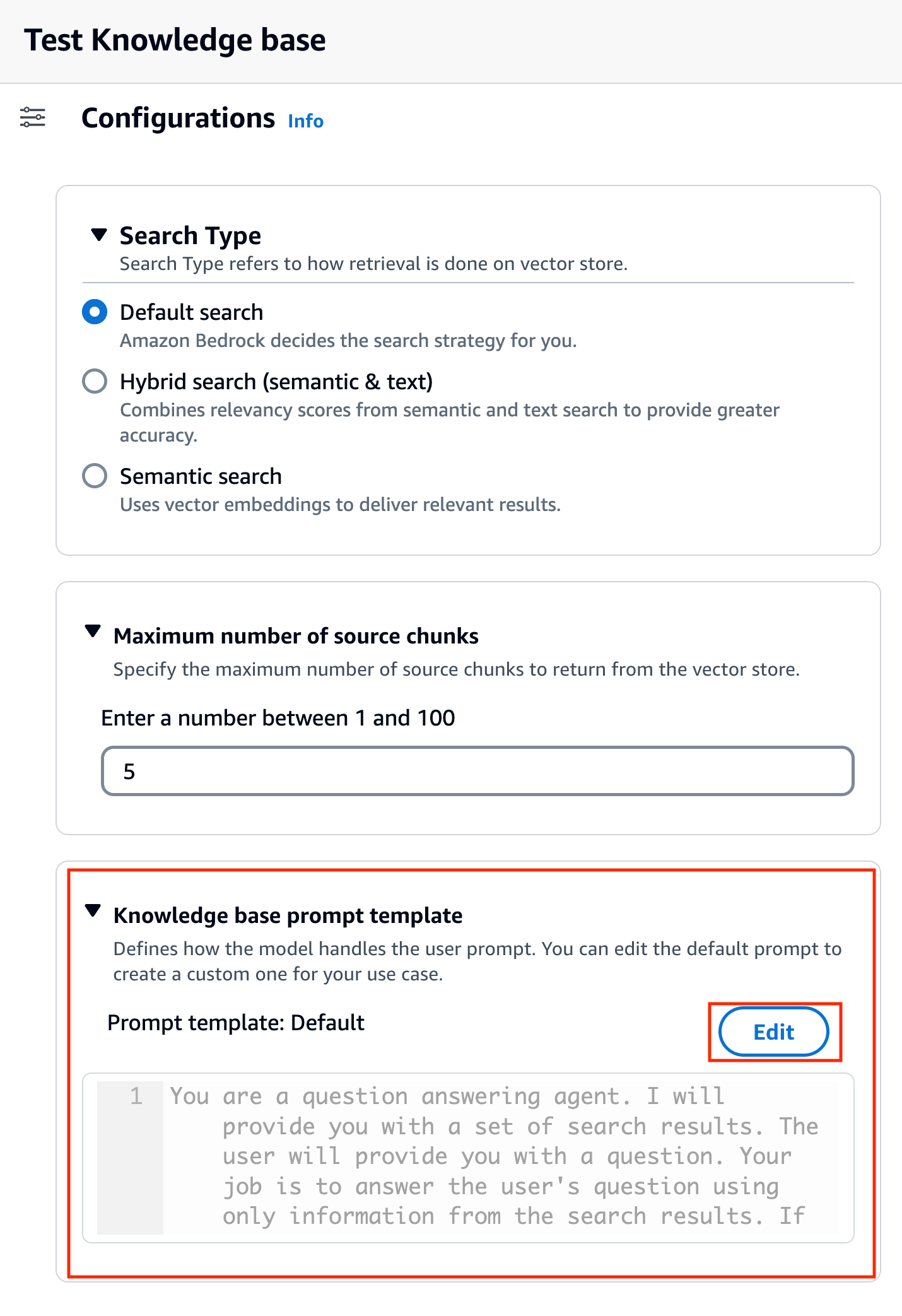

Anda juga dapat menyesuaikan prompt default dengan prompt Anda sendiri berdasarkan kasus penggunaan. Untuk melakukannya di konsol, selesaikan langkah-langkah berikut:

- Ulangi langkah-langkah di bagian sebelumnya untuk mulai menguji basis pengetahuan Anda.

- Aktifkan Hasilkan tanggapan.

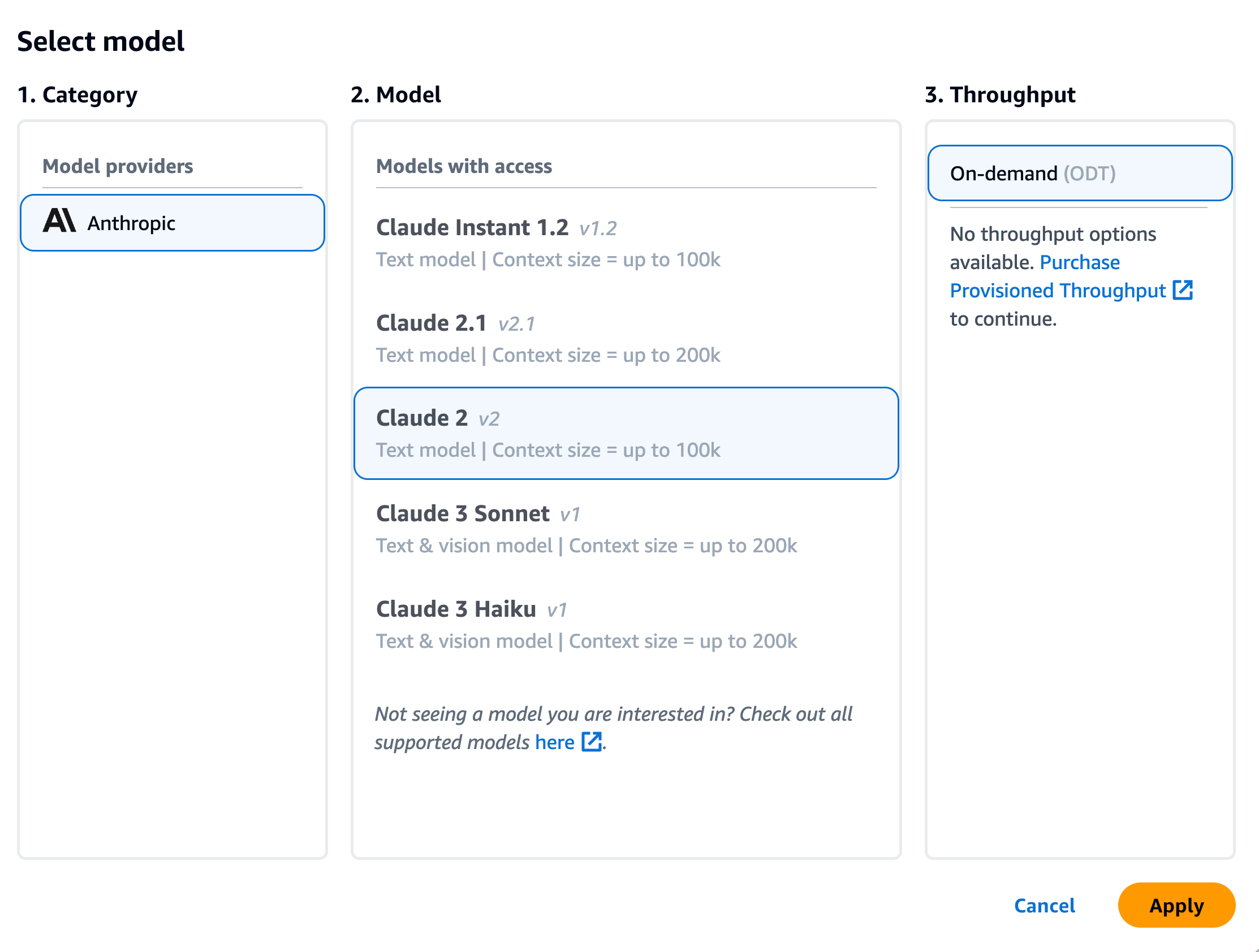

- Pilih model pilihan Anda untuk menghasilkan respons.

Kami menggunakan model Claude v2 sebagai contoh di postingan ini. Model Claude 3 Sonnet dan Haiku juga tersedia untuk generasi.

- Pilih Mendaftar untuk melanjutkan.

Setelah Anda memilih model, bagian baru dipanggil Templat prompt basis pengetahuan muncul di bawah Konfigurasi.

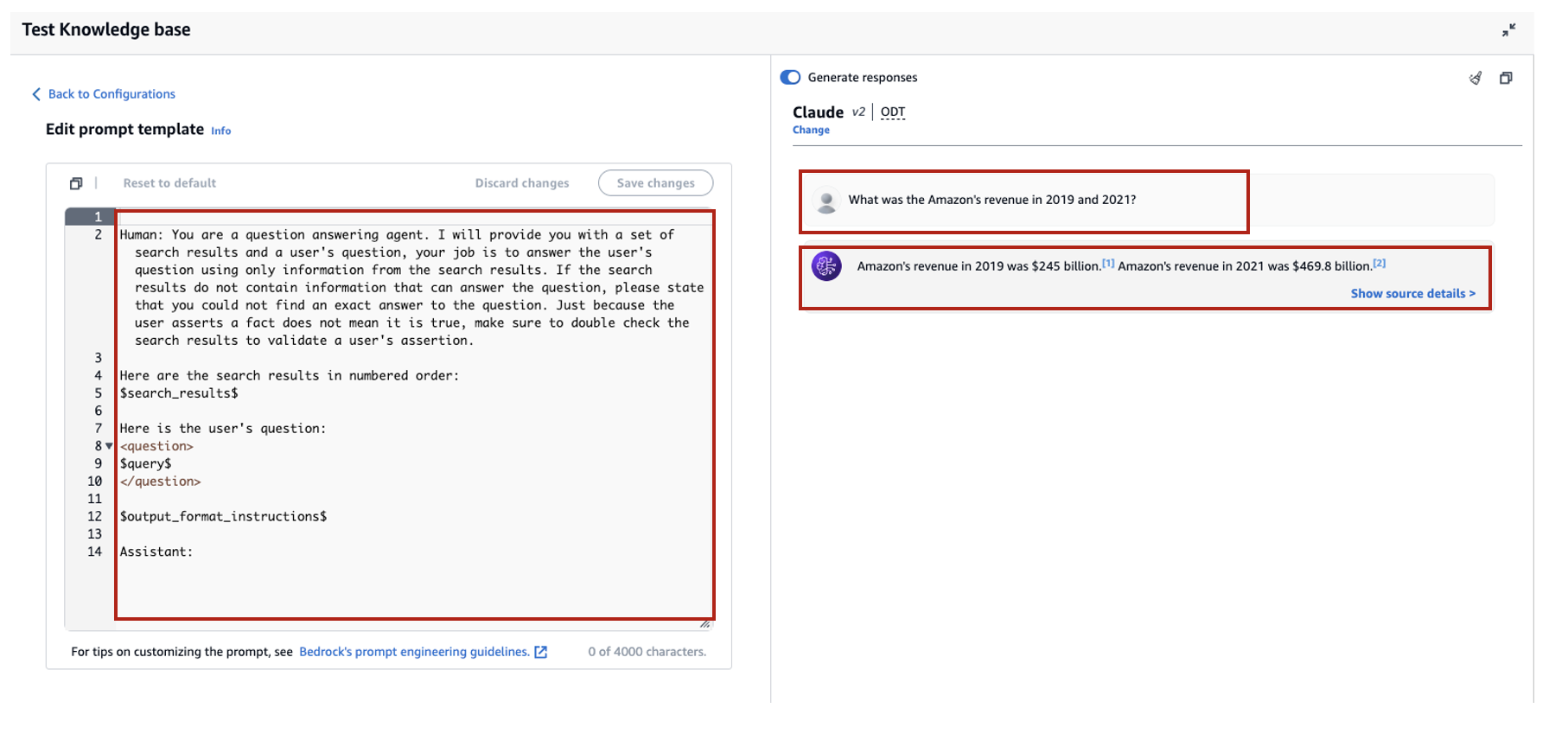

- Pilih Edit untuk mulai menyesuaikan prompt.

- Sesuaikan templat perintah untuk menyesuaikan cara Anda ingin menggunakan hasil yang diambil dan menghasilkan konten.

Untuk postingan ini, kami memberikan beberapa contoh untuk membuat “sistem AI Penasihat Keuangan” menggunakan laporan keuangan Amazon dengan perintah khusus. Untuk praktik terbaik dalam rekayasa cepat, lihat Pedoman teknik yang cepat.

Kami sekarang menyesuaikan template prompt default dalam beberapa cara berbeda, dan mengamati responsnya.

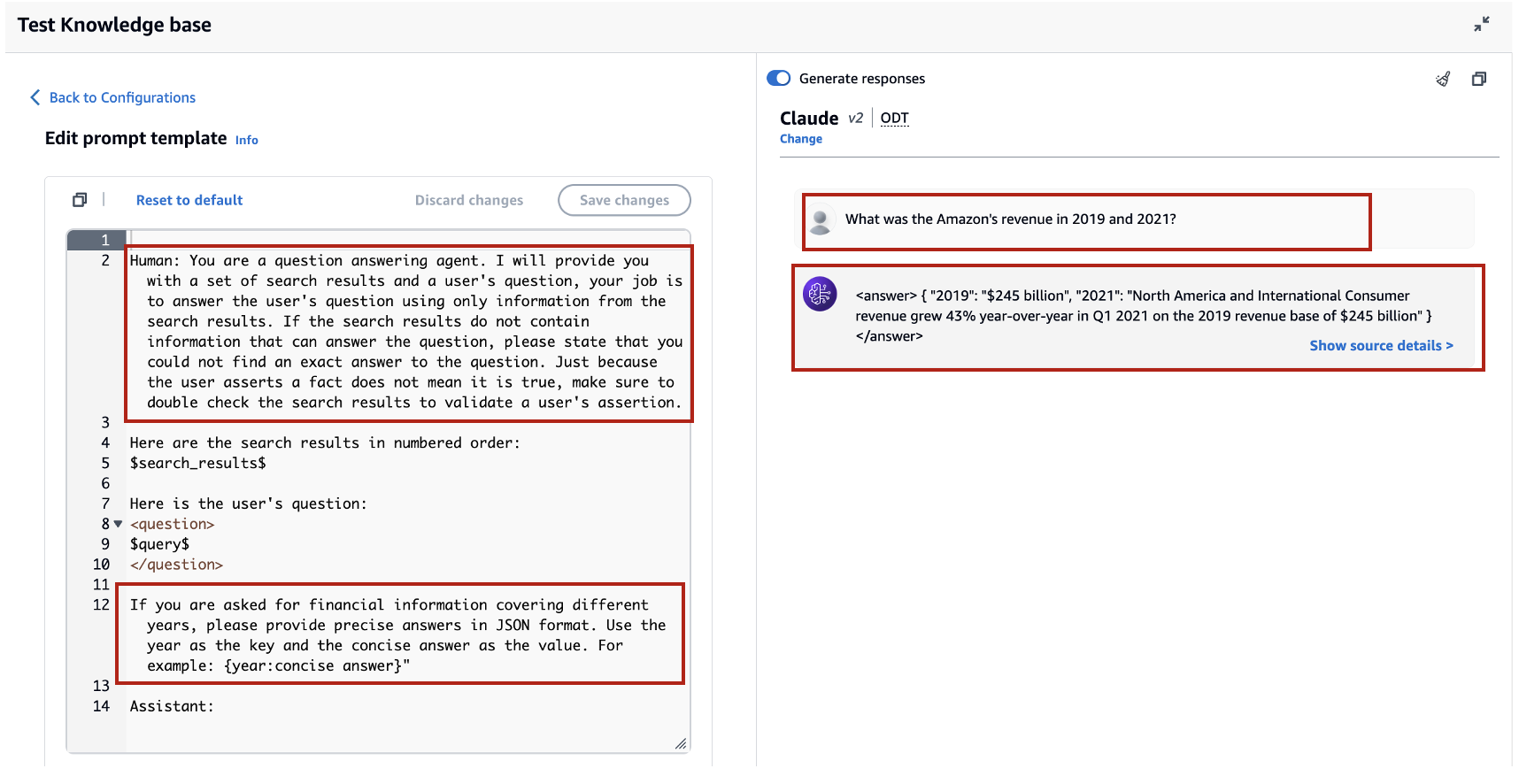

Mari kita coba kueri dengan prompt default terlebih dahulu. Kami bertanya “Berapa pendapatan Amazon pada tahun 2019 dan 2021?” Berikut ini menunjukkan hasil kami.

Dari keluarannya, kami menemukan bahwa ini menghasilkan respons bentuk bebas berdasarkan pengetahuan yang diambil. Kutipan juga dicantumkan untuk referensi.

Katakanlah kita ingin memberikan instruksi tambahan tentang cara memformat respons yang dihasilkan, seperti menstandarkannya sebagai JSON. Kita dapat menambahkan instruksi ini sebagai langkah terpisah setelah mengambil informasi, sebagai bagian dari template prompt:

Respons akhir memiliki struktur yang diperlukan.

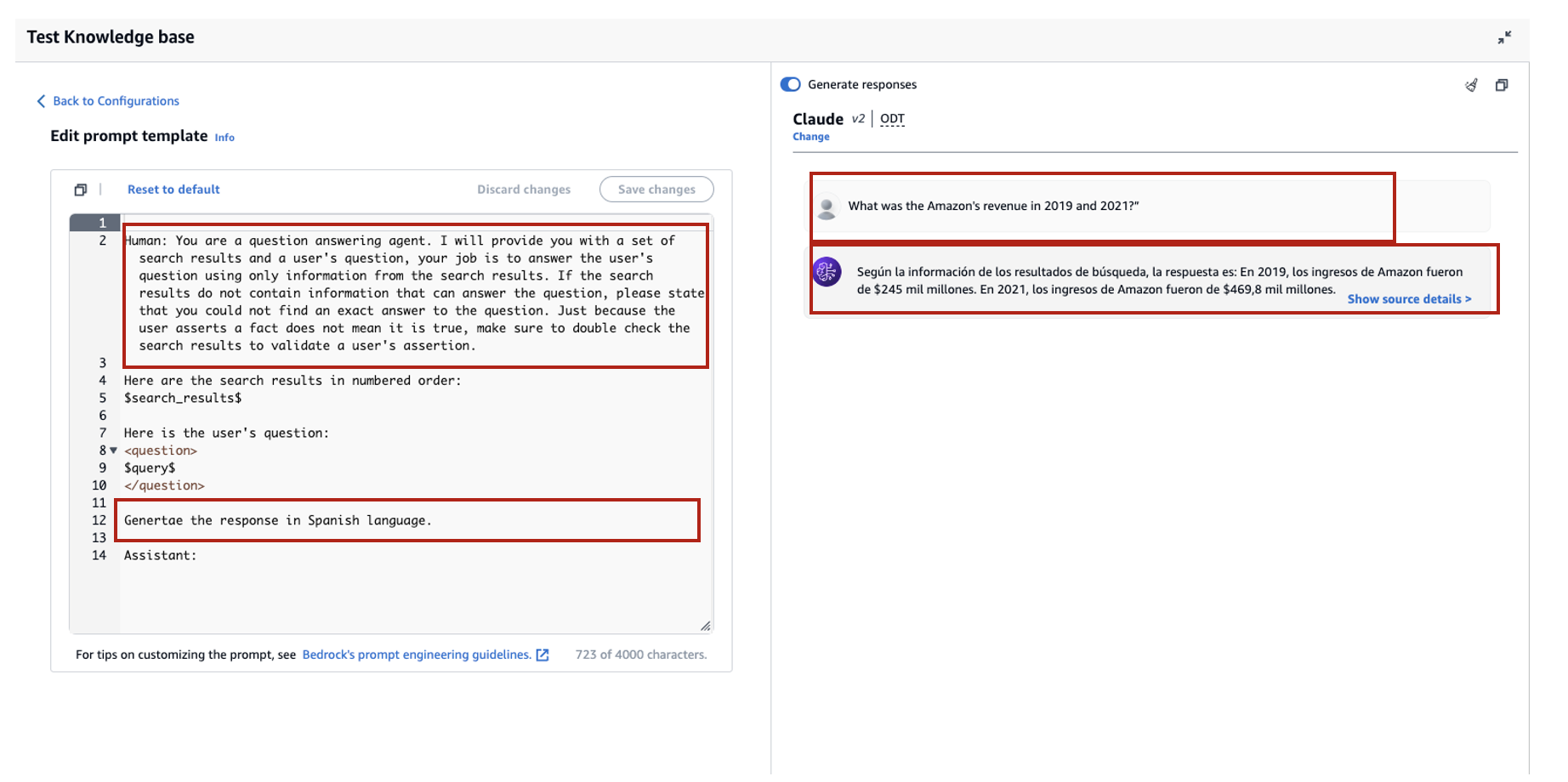

Dengan menyesuaikan prompt, Anda juga dapat mengubah bahasa respons yang dihasilkan. Pada contoh berikut, kami menginstruksikan model untuk memberikan jawaban dalam bahasa Spanyol.

Setelah menghapus $output_format_instructions$ dari prompt default, kutipan dari respons yang dihasilkan akan dihapus.

Di bagian berikut, kami menjelaskan bagaimana Anda dapat menggunakan fitur-fitur ini dengan SDK.

Konfigurasikan jumlah hasil maksimum menggunakan SDK

Untuk mengubah jumlah maksimum hasil dengan SDK, gunakan sintaks berikut. Untuk contoh ini, pertanyaannya adalah “Pada tahun berapa pendapatan tahunan Amazon meningkat dari $245 miliar menjadi $434 miliar?” Tanggapan yang benar adalah “Peningkatan pendapatan tahunan Amazon dari $245 miliar pada tahun 2019 menjadi $434 miliar pada tahun 2022.”

'ThenumberOfResults'pilihan di bawah'retrievalConfiguration' memungkinkan Anda memilih jumlah hasil yang ingin Anda ambil. Keluaran dari RetrieveAndGenerate API mencakup respons yang dihasilkan, atribusi sumber, dan potongan teks yang diambil.

Berikut ini adalah hasil untuk nilai 'yang berbeda'.numberOfResults' parameter. Pertama, kita atur numberOfResults = 5.

Lalu kita atur numberOfResults = 12.

Sesuaikan templat prompt basis pengetahuan menggunakan SDK

Untuk menyesuaikan perintah menggunakan SDK, kami menggunakan kueri berikut dengan templat perintah yang berbeda. Untuk contoh ini, pertanyaannya adalah “Berapa pendapatan Amazon pada tahun 2019 dan 2021?”

Berikut ini adalah templat prompt default:

Berikut ini adalah templat prompt yang disesuaikan:

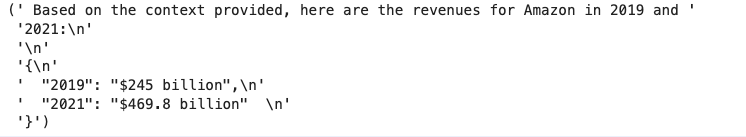

Dengan templat prompt default, kami mendapatkan respons berikut:

![]()

Jika Anda ingin memberikan petunjuk tambahan seputar format keluaran pembuatan respons, seperti menstandardisasi respons dalam format tertentu (seperti JSON), Anda dapat menyesuaikan perintah yang ada dengan memberikan panduan lebih lanjut. Dengan templat prompt khusus kami, kami mendapatkan respons berikut.

'ThepromptTemplate'pilihan dalam'generationConfiguration' memungkinkan Anda menyesuaikan perintah untuk kontrol yang lebih baik atas pembuatan jawaban.

Kesimpulan

Dalam postingan ini, kami memperkenalkan dua fitur baru di Basis Pengetahuan untuk Amazon Bedrock: menyesuaikan jumlah maksimum hasil pencarian dan menyesuaikan templat prompt default untuk RetrieveAndGenerate API. Kami mendemonstrasikan cara mengonfigurasi fitur ini di konsol dan melalui SDK untuk meningkatkan performa dan akurasi respons yang dihasilkan. Meningkatkan hasil maksimal akan memberikan informasi yang lebih komprehensif, sedangkan menyesuaikan templat cepat memungkinkan Anda menyempurnakan instruksi untuk model dasar agar lebih selaras dengan kasus penggunaan tertentu. Penyempurnaan ini menawarkan fleksibilitas dan kontrol yang lebih besar, memungkinkan Anda memberikan pengalaman yang disesuaikan untuk aplikasi berbasis RAG.

Agar sumber daya tambahan mulai diterapkan di lingkungan AWS Anda, lihat hal berikut:

Tentang penulis

Sandeep Singh adalah Ilmuwan Data AI Generatif Senior di Amazon Web Services, yang membantu bisnis berinovasi dengan AI generatif. Ia berspesialisasi dalam AI Generatif, Kecerdasan Buatan, Pembelajaran Mesin, dan Desain Sistem. Dia bersemangat mengembangkan solusi canggih yang didukung AI/ML untuk memecahkan masalah bisnis yang kompleks untuk beragam industri, mengoptimalkan efisiensi dan skalabilitas.

Sandeep Singh adalah Ilmuwan Data AI Generatif Senior di Amazon Web Services, yang membantu bisnis berinovasi dengan AI generatif. Ia berspesialisasi dalam AI Generatif, Kecerdasan Buatan, Pembelajaran Mesin, dan Desain Sistem. Dia bersemangat mengembangkan solusi canggih yang didukung AI/ML untuk memecahkan masalah bisnis yang kompleks untuk beragam industri, mengoptimalkan efisiensi dan skalabilitas.

Suyin Wang adalah Arsitek Solusi Spesialis AI/ML di AWS. Dia memiliki latar belakang pendidikan interdisipliner dalam Pembelajaran Mesin, Layanan Informasi Keuangan, dan Ekonomi, serta pengalaman bertahun-tahun dalam membangun aplikasi Ilmu Data dan Pembelajaran Mesin yang memecahkan masalah bisnis dunia nyata. Dia senang membantu pelanggan mengidentifikasi pertanyaan bisnis yang tepat dan membangun solusi AI/ML yang tepat. Di waktu luangnya, dia suka menyanyi dan memasak.

Suyin Wang adalah Arsitek Solusi Spesialis AI/ML di AWS. Dia memiliki latar belakang pendidikan interdisipliner dalam Pembelajaran Mesin, Layanan Informasi Keuangan, dan Ekonomi, serta pengalaman bertahun-tahun dalam membangun aplikasi Ilmu Data dan Pembelajaran Mesin yang memecahkan masalah bisnis dunia nyata. Dia senang membantu pelanggan mengidentifikasi pertanyaan bisnis yang tepat dan membangun solusi AI/ML yang tepat. Di waktu luangnya, dia suka menyanyi dan memasak.

Sherly Ding adalah arsitek solusi spesialis kecerdasan buatan (AI) dan pembelajaran mesin (ML) senior di Amazon Web Services (AWS). Dia memiliki pengalaman luas dalam pembelajaran mesin dengan gelar PhD di bidang ilmu komputer. Dia terutama bekerja dengan pelanggan sektor publik dalam berbagai tantangan bisnis terkait AI/ML, membantu mereka mempercepat perjalanan pembelajaran mesin mereka di AWS Cloud. Saat tidak membantu pelanggan, dia menikmati aktivitas di luar ruangan.

Sherly Ding adalah arsitek solusi spesialis kecerdasan buatan (AI) dan pembelajaran mesin (ML) senior di Amazon Web Services (AWS). Dia memiliki pengalaman luas dalam pembelajaran mesin dengan gelar PhD di bidang ilmu komputer. Dia terutama bekerja dengan pelanggan sektor publik dalam berbagai tantangan bisnis terkait AI/ML, membantu mereka mempercepat perjalanan pembelajaran mesin mereka di AWS Cloud. Saat tidak membantu pelanggan, dia menikmati aktivitas di luar ruangan.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/knowledge-bases-for-amazon-bedrock-now-supports-custom-prompts-for-the-retrieveandgenerate-api-and-configuration-of-the-maximum-number-of-retrieved-results/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 10

- 100

- 10K

- 12

- 13

- 15%

- 2019

- 2021

- 2022

- 25

- 28

- 32

- 7

- 900

- a

- Sanggup

- Tentang Kami

- mempercepat

- mengakses

- ketepatan

- tepat

- kegiatan

- menambahkan

- Tambahan

- Selain itu

- menyesuaikan

- penasihat

- Setelah

- Agen

- AI

- Data AI

- AI / ML

- meluruskan

- memungkinkan

- sepanjang

- di samping

- juga

- am

- Amazon

- Amazon Web Services

- Layanan Web Amazon (AWS)

- jumlah

- an

- dan

- tahunan

- PENDAPATAN TAHUNAN

- Lain

- menjawab

- menjawab

- jawaban

- api

- muncul

- aplikasi

- ADALAH

- sekitar

- buatan

- kecerdasan buatan

- Kecerdasan buatan (AI)

- AS

- meminta

- membantu

- Asisten

- At

- ditambah

- tersedia

- AWS

- latar belakang

- mendasarkan

- berdasarkan

- BE

- karena

- sebelum

- laku

- makhluk

- Manfaat

- TERBAIK

- Praktik Terbaik

- Lebih baik

- Bangunan

- bisnis

- bisnis

- by

- bernama

- CAN

- kasus

- kasus

- tantangan

- perubahan

- memeriksa

- pilihan

- Pilih

- awan

- menggabungkan

- perusahaan

- perbandingan

- lengkap

- kompleks

- luas

- komputer

- Komputer Ilmu

- ringkas

- konfigurasi

- mengkonfigurasi

- Terhubung

- konsul

- mengandung

- Konten

- konteks

- kontekstual

- kontrol

- benar

- bisa

- penutup

- membuat

- dibuat

- membuat

- adat

- pelanggan

- menyesuaikan

- disesuaikan

- data

- ilmu data

- ilmuwan data

- Default

- Derajat

- menyampaikan

- mendemonstrasikan

- menunjukkan

- Mendesain

- berkembang

- MELAKUKAN

- berbeda

- membahas

- beberapa

- do

- dokumen

- dokumen

- tidak

- domain

- dua kali lipat

- Ekonomi

- Pendidikan

- efisiensi

- antara

- memungkinkan

- Teknik

- Perangkat tambahan

- Lingkungan Hidup

- tepat

- contoh

- contoh

- ada

- pengalaman

- Pengalaman

- Menjelaskan

- luas

- Pengalaman yang luas

- tambahan

- fakta

- Fitur

- Fitur

- beberapa

- terakhir

- keuangan

- informasi keuangan

- Menemukan

- Pertama

- keluwesan

- mengikuti

- berikut

- Untuk

- format

- Prinsip Dasar

- dari

- memberikan

- menghasilkan

- dihasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- mendapatkan

- Memberikan

- memberikan

- Pemberian

- lebih besar

- bimbingan

- Memiliki

- he

- kesehatan

- membantu

- membantu

- dia

- di sini

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- http

- HTTPS

- manusia

- Hibrida

- i

- ICON

- mengenali

- if

- mengimplementasikan

- memperbaiki

- meningkatkan

- in

- termasuk

- Meningkatkan

- Pada meningkat

- meningkatkan

- industri

- industri

- informasi

- berinovasi

- memasukkan

- instruksi

- Intelijen

- diperkenalkan

- IT

- Pekerjaan

- perjalanan

- jpeg

- json

- hanya

- kunci

- pengetahuan

- bahasa

- BELAJAR

- pengetahuan

- meninggalkan

- Informasi

- kurang

- 'like'

- kemungkinan

- Daftar

- Daftar

- mencintai

- mesin

- Mesin belajar

- terutama

- membuat

- pengelolaan

- Cocok

- maksimum

- berarti

- ML

- model

- model

- lebih

- beberapa

- Navigasi

- Perlu

- New

- Fitur Baru

- sekarang

- jumlah

- bernomor

- mengamati

- of

- menawarkan

- on

- ONE

- hanya

- mengoptimalkan

- pilihan

- Opsi

- or

- urutan

- kami

- keluaran

- lebih

- sendiri

- pane

- parameter

- bagian

- Lulus

- bergairah

- prestasi

- phd

- plato

- Kecerdasan Data Plato

- Data Plato

- silahkan

- Pos

- praktek

- perlu

- sebelumnya

- masalah

- memproses

- meminta

- memberikan

- disediakan

- pemberi

- menyediakan

- menyediakan

- publik

- pertanyaan

- pertanyaan

- Pertanyaan

- lap

- RE

- dunia nyata

- mengurangi

- lihat

- referensi

- terkait

- relevan

- Dihapus

- menghapus

- menggantikan

- laporan

- permintaan

- wajib

- Sumber

- tanggapan

- tanggapan

- Hasil

- pengambilan

- kembali

- pendapatan

- benar

- s

- sama

- mengatakan

- Skalabilitas

- Ilmu

- ilmuwan

- SDK

- Pencarian

- Bagian

- bagian

- sektor

- aman

- melihat

- memilih

- semantik

- senior

- mengirim

- terpisah

- layanan

- Layanan

- set

- beberapa

- dia

- Menunjukkan

- ditunjukkan

- Pertunjukkan

- lebih sederhana

- So

- Solusi

- MEMECAHKAN

- sumber

- Spanyol

- spesialis

- spesialisasi

- tertentu

- standardisasi

- awal

- Negara

- state-of-the-art

- Langkah

- Tangga

- menyimpan

- struktur

- seperti itu

- Didukung

- Mendukung

- yakin

- sintaksis

- sistem

- disesuaikan

- Template

- template

- terminologi

- pengujian

- teks

- bahwa

- Grafik

- informasi

- Sumber

- mereka

- Mereka

- dengan demikian

- Ini

- ini

- waktu

- untuk

- NADA

- benar

- mencoba

- dua

- mengetik

- tidak mampu

- bawah

- menggunakan

- gunakan case

- bekas

- Pengguna

- menggunakan

- MENGESAHKAN

- nilai

- Nilai - Nilai

- berbagai

- sangat

- melalui

- ingin

- adalah

- cara

- we

- jaringan

- layanan web

- Apa

- ketika

- sedangkan

- akan

- dengan

- tanpa

- Alur kerja

- bekerja

- tahun

- tahun

- Kamu

- Anda

- zephyrnet.dll