Model Bahasa Besar (LLM) telah merevolusi bidang pemrosesan bahasa alami (NLP), meningkatkan tugas-tugas seperti terjemahan bahasa, peringkasan teks, dan analisis sentimen. Namun, seiring dengan bertambahnya ukuran dan kompleksitas model ini, pemantauan kinerja dan perilakunya menjadi semakin menantang.

Memantau kinerja dan perilaku LLM merupakan tugas penting untuk memastikan keamanan dan efektivitasnya. Arsitektur yang kami usulkan memberikan solusi terukur dan dapat disesuaikan untuk pemantauan LLM online, memungkinkan tim menyesuaikan solusi pemantauan Anda dengan kasus penggunaan dan kebutuhan spesifik Anda. Dengan menggunakan layanan AWS, arsitektur kami memberikan visibilitas real-time terhadap perilaku LLM dan memungkinkan tim dengan cepat mengidentifikasi dan mengatasi masalah atau anomali apa pun.

Dalam postingan ini, kami mendemonstrasikan beberapa metrik untuk pemantauan LLM online dan arsitekturnya masing-masing untuk penskalaan menggunakan layanan AWS seperti amazoncloudwatch dan AWS Lambda. Ini menawarkan solusi yang dapat disesuaikan melebihi apa yang mungkin dilakukan evaluasi model pekerjaan dengan Batuan Dasar Amazon.

Ikhtisar solusi

Hal pertama yang perlu dipertimbangkan adalah bahwa metrik yang berbeda memerlukan pertimbangan komputasi yang berbeda. Diperlukan arsitektur modular, di mana setiap modul dapat mengambil data inferensi model dan menghasilkan metriknya sendiri.

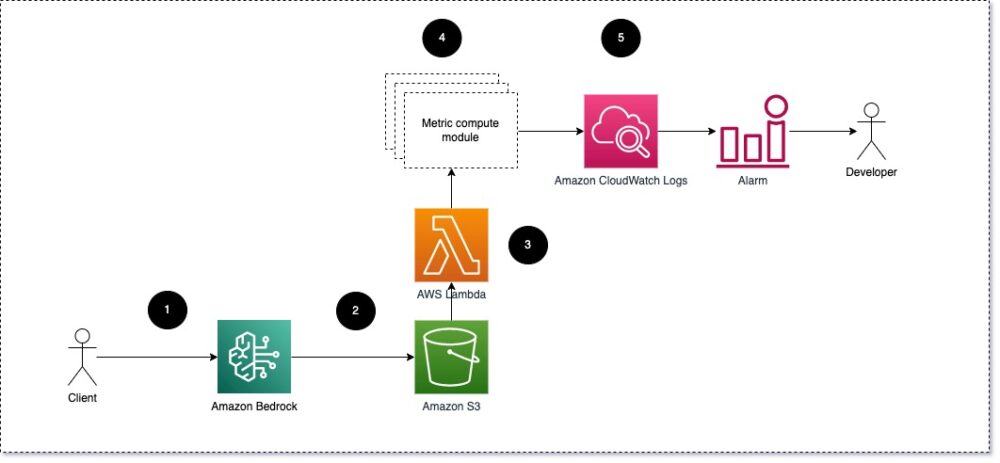

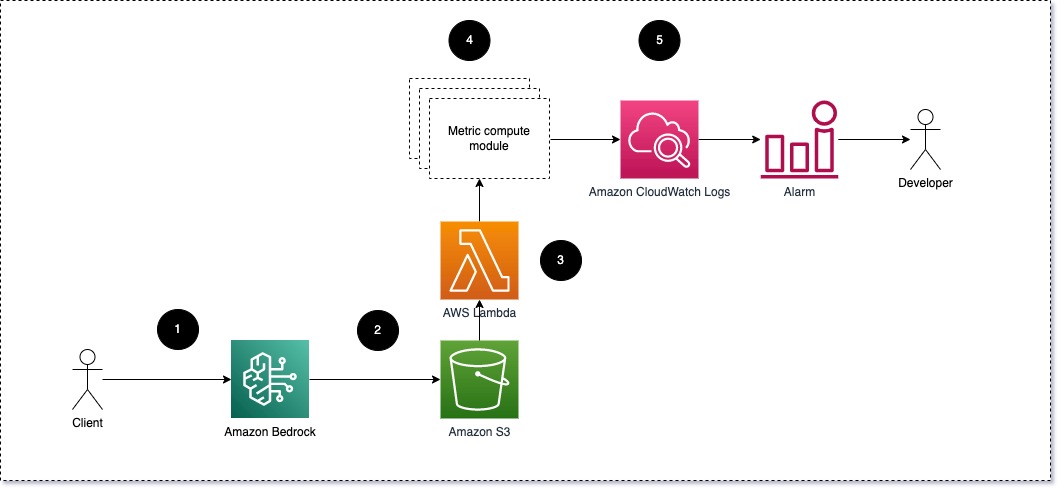

Kami menyarankan agar setiap modul menerima permintaan inferensi masuk ke LLM, meneruskan pasangan prompt dan penyelesaian (respons) ke modul komputasi metrik. Setiap modul bertanggung jawab untuk menghitung metriknya sendiri sehubungan dengan perintah masukan dan penyelesaian (respons). Metrik ini diteruskan ke CloudWatch, yang dapat menggabungkannya dan bekerja dengan alarm CloudWatch untuk mengirimkan pemberitahuan pada kondisi tertentu. Diagram berikut menggambarkan arsitektur ini.

Gambar 1: Modul komputasi metrik – ikhtisar solusi

Alur kerja meliputi langkah-langkah berikut:

- Pengguna membuat permintaan ke Amazon Bedrock sebagai bagian dari aplikasi atau antarmuka pengguna.

- Amazon Bedrock menyimpan permintaan dan penyelesaian (respons) di Layanan Penyimpanan Sederhana Amazon (Amazon S3) sesuai konfigurasi pencatatan pemanggilan.

- File yang disimpan di Amazon S3 menciptakan peristiwa yang memicu fungsi Lambda. Fungsi ini memanggil modul.

- Modul memposting metriknya masing-masing ke Metrik CloudWatch.

- Alarm dapat memberi tahu tim pengembangan tentang nilai metrik yang tidak terduga.

Hal kedua yang perlu dipertimbangkan ketika menerapkan pemantauan LLM adalah memilih metrik yang tepat untuk dilacak. Meskipun ada banyak metrik potensial yang dapat Anda gunakan untuk memantau kinerja LLM, kami menjelaskan beberapa metrik terluasnya di postingan ini.

Di bagian berikut, kami menyoroti beberapa metrik modul yang relevan dan arsitektur modul komputasi metriknya masing-masing.

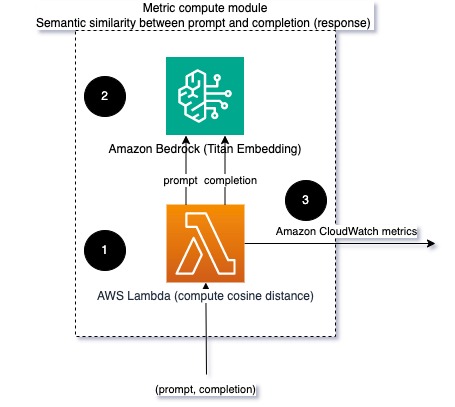

Kesamaan semantik antara prompt dan penyelesaian (respons)

Saat menjalankan LLM, Anda dapat mencegat perintah dan penyelesaian (respons) untuk setiap permintaan dan mengubahnya menjadi penyematan menggunakan model penyematan. Embeddings adalah vektor berdimensi tinggi yang mewakili makna semantik teks. Titan Amazon menyediakan model seperti itu melalui Titan Embeddings. Dengan mengambil jarak seperti kosinus antara dua vektor ini, Anda dapat mengukur seberapa mirip semantik prompt dan penyelesaian (respons). Anda dapat gunakan SciPy or scikit-belajar untuk menghitung jarak kosinus antar vektor. Diagram berikut mengilustrasikan arsitektur modul komputasi metrik ini.

Gambar 2: Modul komputasi metrik – kesamaan semantik

Alur kerja ini mencakup langkah-langkah penting berikut:

- Fungsi Lambda menerima pesan streaming melalui Amazon Kinesis berisi pasangan prompt dan penyelesaian (respon).

- Fungsi ini mendapatkan penyematan untuk prompt dan penyelesaian (respon), dan menghitung jarak kosinus antara dua vektor.

- Fungsi ini mengirimkan informasi tersebut ke metrik CloudWatch.

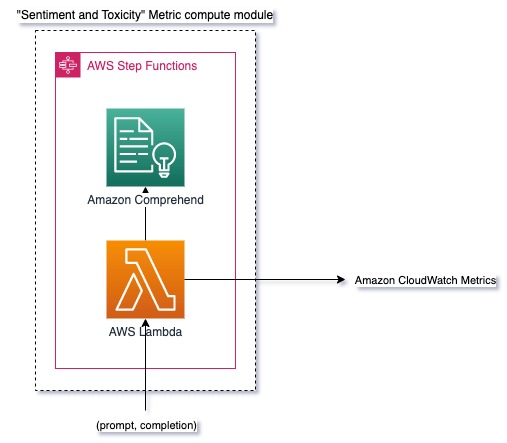

Sentimen dan toksisitas

Memantau sentimen memungkinkan Anda mengukur keseluruhan nada dan dampak emosional dari respons, sedangkan analisis toksisitas memberikan ukuran penting mengenai adanya bahasa yang menyinggung, tidak sopan, atau berbahaya dalam keluaran LLM. Setiap perubahan dalam sentimen atau toksisitas harus dipantau secara ketat untuk memastikan model tersebut berfungsi sesuai harapan. Diagram berikut mengilustrasikan modul komputasi metrik.

Gambar 3: Modul komputasi metrik – sentimen dan toksisitas

Alur kerja meliputi langkah-langkah berikut:

- Fungsi Lambda menerima pasangan prompt dan penyelesaian (respons) melalui Amazon Kinesis.

- Melalui orkestrasi AWS Step Functions, fungsi tersebut dipanggil Amazon Comprehend untuk mendeteksi sentimen dan kebisaan.

- Fungsi ini menyimpan informasi ke metrik CloudWatch.

Untuk informasi selengkapnya tentang mendeteksi sentimen dan toksisitas dengan Amazon Comprehend, lihat Bangun prediktor toksisitas berbasis teks yang kuat dan Tandai konten berbahaya menggunakan deteksi toksisitas Amazon Comprehend.

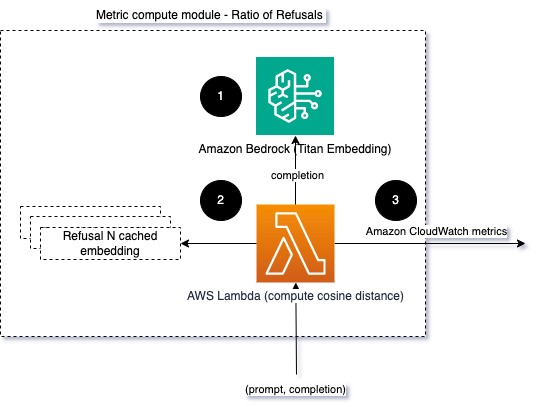

Rasio penolakan

Peningkatan penolakan, seperti ketika LLM menolak penyelesaian karena kurangnya informasi, dapat berarti bahwa pengguna jahat mencoba menggunakan LLM dengan cara yang dimaksudkan untuk melakukan jailbreak, atau harapan pengguna tidak terpenuhi dan mereka mendapatkan respons yang bernilai rendah. Salah satu cara untuk mengukur seberapa sering hal ini terjadi adalah dengan membandingkan penolakan standar dari model LLM yang digunakan dengan tanggapan sebenarnya dari LLM. Misalnya, berikut adalah beberapa frasa penolakan umum Anthropic's Claude v2 LLM:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

Pada serangkaian permintaan yang tetap, peningkatan penolakan ini dapat menjadi sinyal bahwa model menjadi terlalu berhati-hati atau sensitif. Kasus sebaliknya juga harus dievaluasi. Ini bisa menjadi sinyal bahwa model tersebut kini lebih rentan terlibat dalam percakapan beracun atau berbahaya.

Untuk membantu integritas model dan rasio penolakan model, kita dapat membandingkan respons dengan serangkaian frasa penolakan yang diketahui dari LLM. Ini bisa menjadi pengklasifikasi sebenarnya yang dapat menjelaskan mengapa model menolak permintaan tersebut. Anda dapat mengambil jarak kosinus antara respons dan respons penolakan yang diketahui dari model yang dipantau. Diagram berikut mengilustrasikan modul komputasi metrik ini.

Gambar 4: Modul komputasi metrik – rasio penolakan

Alur kerja terdiri dari langkah-langkah berikut:

- Fungsi Lambda menerima prompt dan penyelesaian (respons) dan mendapatkan penyematan dari respons menggunakan Amazon Titan.

- Fungsi ini menghitung jarak cosinus atau Euclidian antara respons dan permintaan penolakan yang ada yang disimpan dalam cache di memori.

- Fungsi ini mengirimkan rata-rata tersebut ke metrik CloudWatch.

Pilihan lainnya adalah menggunakan pencocokan kabur untuk pendekatan yang lugas namun kurang ampuh untuk membandingkan penolakan yang diketahui dengan keluaran LLM. Mengacu kepada Dokumentasi python sebagai contoh.

Kesimpulan

Observabilitas LLM adalah praktik penting untuk memastikan penggunaan LLM yang andal dan dapat dipercaya. Memantau, memahami, dan memastikan keakuratan dan keandalan LLM dapat membantu Anda memitigasi risiko yang terkait dengan model AI ini. Dengan memantau halusinasi, penyelesaian (respons) yang buruk, dan petunjuknya, Anda dapat memastikan LLM Anda tetap pada jalurnya dan memberikan nilai yang Anda dan pengguna Anda cari. Dalam postingan ini, kami membahas beberapa metrik untuk menampilkan contoh.

Untuk informasi lebih lanjut tentang mengevaluasi model pondasi, lihat Gunakan SageMaker Clarify untuk mengevaluasi model fondasi, dan jelajahi tambahan contoh buku catatan tersedia di repositori GitHub kami. Anda juga dapat mencari cara untuk mengoperasionalkan evaluasi LLM dalam skala besar Operasikan Evaluasi LLM dalam Skala Besar menggunakan layanan Amazon SageMaker Clarify dan MLOps. Terakhir, kami sarankan untuk merujuk ke Evaluasi model bahasa besar untuk kualitas dan tanggung jawab untuk mempelajari lebih lanjut tentang mengevaluasi LLM.

Tentang Penulis

Bruno Klein adalah Insinyur Pembelajaran Mesin Senior dengan Praktik Analisis Layanan Profesional AWS. Dia membantu pelanggan menerapkan solusi big data dan analitik. Di luar pekerjaan, dia senang menghabiskan waktu bersama keluarga, jalan-jalan, dan mencoba makanan baru.

Bruno Klein adalah Insinyur Pembelajaran Mesin Senior dengan Praktik Analisis Layanan Profesional AWS. Dia membantu pelanggan menerapkan solusi big data dan analitik. Di luar pekerjaan, dia senang menghabiskan waktu bersama keluarga, jalan-jalan, dan mencoba makanan baru.

Rushabh Lokhande adalah Insinyur Data & ML Senior dengan Praktik Analisis Layanan Profesional AWS. Dia membantu pelanggan menerapkan solusi big data, machine learning, dan analitik. Di luar pekerjaan, ia menikmati menghabiskan waktu bersama keluarga, membaca, berlari, dan bermain golf.

Rushabh Lokhande adalah Insinyur Data & ML Senior dengan Praktik Analisis Layanan Profesional AWS. Dia membantu pelanggan menerapkan solusi big data, machine learning, dan analitik. Di luar pekerjaan, ia menikmati menghabiskan waktu bersama keluarga, membaca, berlari, dan bermain golf.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :memiliki

- :adalah

- :bukan

- :Di mana

- 1

- 100

- 143

- 32

- 455

- 7

- a

- Tentang Kami

- ketepatan

- sebenarnya

- Tambahan

- alamat

- agregat

- AI

- Asisten AI

- Model AI

- memungkinkan

- juga

- Meskipun

- am

- Amazon

- Amazon Comprehend

- Amazon Kinesis

- Amazon SageMaker

- Amazon Web Services

- an

- analisis

- analisis

- dan

- kelainan

- Antropik

- Apa pun

- Aplikasi

- pendekatan

- pendekatan

- arsitektur

- ADALAH

- AS

- Asisten

- terkait

- At

- tersedia

- rata-rata

- AWS

- Layanan Profesional AWS

- Fungsi Langkah AWS

- Buruk

- BE

- menjadi

- laku

- makhluk

- antara

- Luar

- Besar

- Big data

- kedua

- tapi

- by

- Panggilan

- CAN

- tidak bisa

- kasus

- kasus

- berhati-hati

- menantang

- memilih

- penggolong

- rapat

- Umum

- membandingkan

- pembandingan

- penyelesaian

- kompleksitas

- memahami

- komputasi

- menghitung

- komputasi

- Kondisi

- konfigurasi

- Mempertimbangkan

- pertimbangan

- terdiri

- Konten

- konteks

- terus

- percakapan

- bisa

- dibuat

- menciptakan

- kritis

- pelanggan

- disesuaikan

- data

- memberikan

- mendemonstrasikan

- menemukan

- Pengembangan

- tim pengembangan

- diagram

- berbeda

- dibahas

- jarak

- do

- dua

- setiap

- efektivitas

- antara

- embedding

- memungkinkan

- memungkinkan

- mengikutsertakan

- insinyur

- cukup

- memastikan

- memastikan

- mengevaluasi

- dievaluasi

- mengevaluasi

- evaluasi

- evaluasi

- Acara

- contoh

- contoh

- ada

- harapan

- diharapkan

- Menjelaskan

- menyelidiki

- keluarga

- beberapa

- bidang

- ara

- File

- Akhirnya

- Pertama

- tetap

- berikut

- makanan

- Untuk

- Prinsip Dasar

- dari

- fungsi

- fungsi

- mengukur

- mendapat

- mendapatkan

- GitHub

- golf

- Tumbuh

- Kejadian

- berbahaya

- Memiliki

- he

- membantu

- bermanfaat

- membantu

- Menyoroti

- jujur

- Seterpercayaapakah Olymp Trade? Kesimpulan

- Namun

- HTML

- http

- HTTPS

- i

- mengenali

- menggambarkan

- Dampak

- melaksanakan

- mengimplementasikan

- penting

- meningkatkan

- in

- termasuk

- masuk

- Meningkatkan

- makin

- informasi

- memasukkan

- integritas

- dimaksudkan

- Antarmuka

- ke

- terbalik

- memanggil

- masalah

- IT

- NYA

- jailbreak

- Jobs

- jpg

- kunci

- dikenal

- Kekurangan

- bahasa

- besar

- BELAJAR

- pengetahuan

- kurang

- LLM

- mencari

- mesin

- Mesin belajar

- membuat

- MEMBUAT

- jahat

- banyak

- berarti

- makna

- mengukur

- Memori

- pesan

- bertemu

- metrik

- Metrik

- Mengurangi

- ML

- MLOps

- model

- model

- modular

- Modul

- Modul

- Memantau

- dipantau

- pemantauan

- lebih

- Alam

- Pengolahan Bahasa alami

- perlu

- New

- nLP

- pemberitahuan

- sekarang

- of

- serangan

- Penawaran

- sering

- on

- ONE

- yang

- secara online

- pilihan

- or

- teknik mengatur musik

- kami

- keluaran

- output

- di luar

- secara keseluruhan

- ikhtisar

- sendiri

- pasangan

- pasang

- bagian

- Lulus

- Lewat

- untuk

- prestasi

- frase

- plato

- Kecerdasan Data Plato

- Data Plato

- bermain

- mungkin

- Pos

- potensi

- kuat

- praktek

- kehadiran

- pengolahan

- menghasilkan

- profesional

- meminta

- diusulkan

- memberikan

- menyediakan

- Ular sanca

- kualitas

- segera

- perbandingan

- Bacaan

- real-time

- menerima

- sarankan

- lihat

- penolakan

- menolak

- relevan

- keandalan

- dapat diandalkan

- gudang

- mewakili

- permintaan

- permintaan

- membutuhkan

- Persyaratan

- menghormati

- itu

- tanggapan

- tanggapan

- tanggung jawab

- merevolusi

- benar

- risiko

- kuat

- berjalan

- Safety/keselamatan

- pembuat bijak

- disimpan

- terukur

- Skala

- Kedua

- bagian

- semantik

- mengirim

- mengirimkan

- senior

- peka

- sentimen

- Layanan

- set

- Pergeseran

- harus

- menampilkan

- Sinyal

- mirip

- Sederhana

- Ukuran

- larutan

- Solusi

- beberapa

- spasial

- tertentu

- Pengeluaran

- standar

- Langkah

- Tangga

- penyimpanan

- mudah

- streaming

- seperti itu

- menyarankan

- yakin

- menyesuaikan

- Mengambil

- pengambilan

- tugas

- tugas

- tim

- tim

- teknik

- teks

- bahwa

- Grafik

- informasi

- mereka

- Mereka

- Sana.

- Ini

- mereka

- hal

- ini

- Melalui

- waktu

- titan

- untuk

- NADA

- jalur

- Mengubah

- Terjemahan

- Perjalanan

- terpercaya

- mencoba

- dua

- pemahaman

- Tiba-tiba

- menggunakan

- bekas

- Pengguna

- User Interface

- Pengguna

- menggunakan

- nilai

- Nilai - Nilai

- melalui

- jarak penglihatan

- Cara..

- cara

- we

- jaringan

- layanan web

- Apa

- Apa itu

- ketika

- sedangkan

- yang

- mengapa

- Wikipedia

- dengan

- Kerja

- alur kerja

- Kamu

- Anda

- zephyrnet.dll