Oggi siamo lieti di annunciare che il modello di fondazione Falcon 180B sviluppato dal Technology Innovation Institute (TII) e addestrato su Amazon SageMaker è disponibile per i clienti tramite JumpStart di Amazon SageMaker da distribuire con un clic per eseguire l'inferenza. Con una dimensione di 180 miliardi di parametri e addestrato su un enorme set di dati di 3.5 trilioni di token, Falcon 180B è il modello più grande e uno dei più performanti con pesi liberamente accessibili. Puoi provare questo modello con SageMaker JumpStart, un hub di machine learning (ML) che fornisce accesso ad algoritmi, modelli e soluzioni ML in modo da poter iniziare rapidamente con il ML. In questo post spiegheremo come scoprire e distribuire il modello Falcon 180B tramite SageMaker JumpStart.

Cos'è il Falcon 180B

Falcon 180B è un modello rilasciato da IO ESSO che segue le versioni precedenti della famiglia Falcon. È una versione ingrandita di Falcon 40B e utilizza l'attenzione multi-query per una migliore scalabilità. È un modello linguistico autoregressivo che utilizza un'architettura di trasformatore ottimizzata. È stato addestrato su 3.5 trilioni di token di dati, costituiti principalmente da dati web provenienti da Web raffinato (circa 85%). Il modello ha due versioni: 180B e 180B-Chat. 180B è un modello grezzo e preaddestrato, che dovrebbe essere ulteriormente perfezionato per la maggior parte dei casi d'uso. 180B-Chat è più adatto a ricevere istruzioni generiche. Il modello Chat è stato perfezionato sui set di dati di chat e istruzioni insieme a diversi set di dati conversazionali su larga scala.

Il modello è reso disponibile con il Licenza TII Falcon-180B ed Acceptable Use Policy.

Falcon 180B è stato addestrato da TII Amazon Sage Maker, su un cluster di circa GPU A4 100K. Ha utilizzato una base di codice di addestramento distribuito personalizzata denominata Gigatron, che utilizza il parallelismo 3D con ZeRO e kernel Triton personalizzati e ad alte prestazioni. L'architettura di formazione distribuita utilizzata Servizio di archiviazione semplice Amazon (Amazon S3) come unico servizio unificato per il caricamento dei dati e la scrittura e lettura dei checkpoint, che ha contribuito in particolare all'affidabilità del carico di lavoro e alla semplicità operativa.

Cos'è SageMaker JumpStart

Con SageMaker JumpStart, i professionisti del machine learning possono scegliere da un elenco crescente di modelli di base con le migliori prestazioni. I professionisti del machine learning possono distribuire modelli di base su istanze SageMaker dedicate all'interno di un ambiente isolato di rete e personalizzare i modelli utilizzando Amazon SageMaker per l'addestramento e la distribuzione dei modelli.

Ora puoi scoprire e distribuire Falcon 180B con pochi clic Amazon Sage Maker Studio o a livello di programmazione tramite SageMaker Python SDK, consentendoti di derivare le prestazioni del modello e i controlli MLOps con funzionalità SageMaker come Pipeline di Amazon SageMaker, Debugger di Amazon SageMakero log del contenitore. Il modello viene distribuito in un ambiente sicuro AWS e sotto i controlli VPC, contribuendo a garantire la sicurezza dei dati. Falcon 180B è rilevabile e può essere distribuito nelle regioni in cui sono disponibili le istanze richieste. Al momento, le istanze ml.p4de sono disponibili negli Stati Uniti orientali (Virginia settentrionale) e negli Stati Uniti occidentali (Oregon).

Scopri i modelli

Puoi accedere ai modelli di base tramite SageMaker JumpStart nell'interfaccia utente di SageMaker Studio e SageMaker Python SDK. In questa sezione, esamineremo come scoprire i modelli in SageMaker Studio.

SageMaker Studio è un ambiente di sviluppo integrato (IDE) che fornisce un'unica interfaccia visiva basata sul Web in cui è possibile accedere a strumenti specifici per eseguire tutte le fasi di sviluppo ML, dalla preparazione dei dati alla creazione, formazione e distribuzione dei modelli ML. Per ulteriori dettagli su come iniziare e configurare SageMaker Studio, fare riferimento a Amazon Sage Maker Studio.

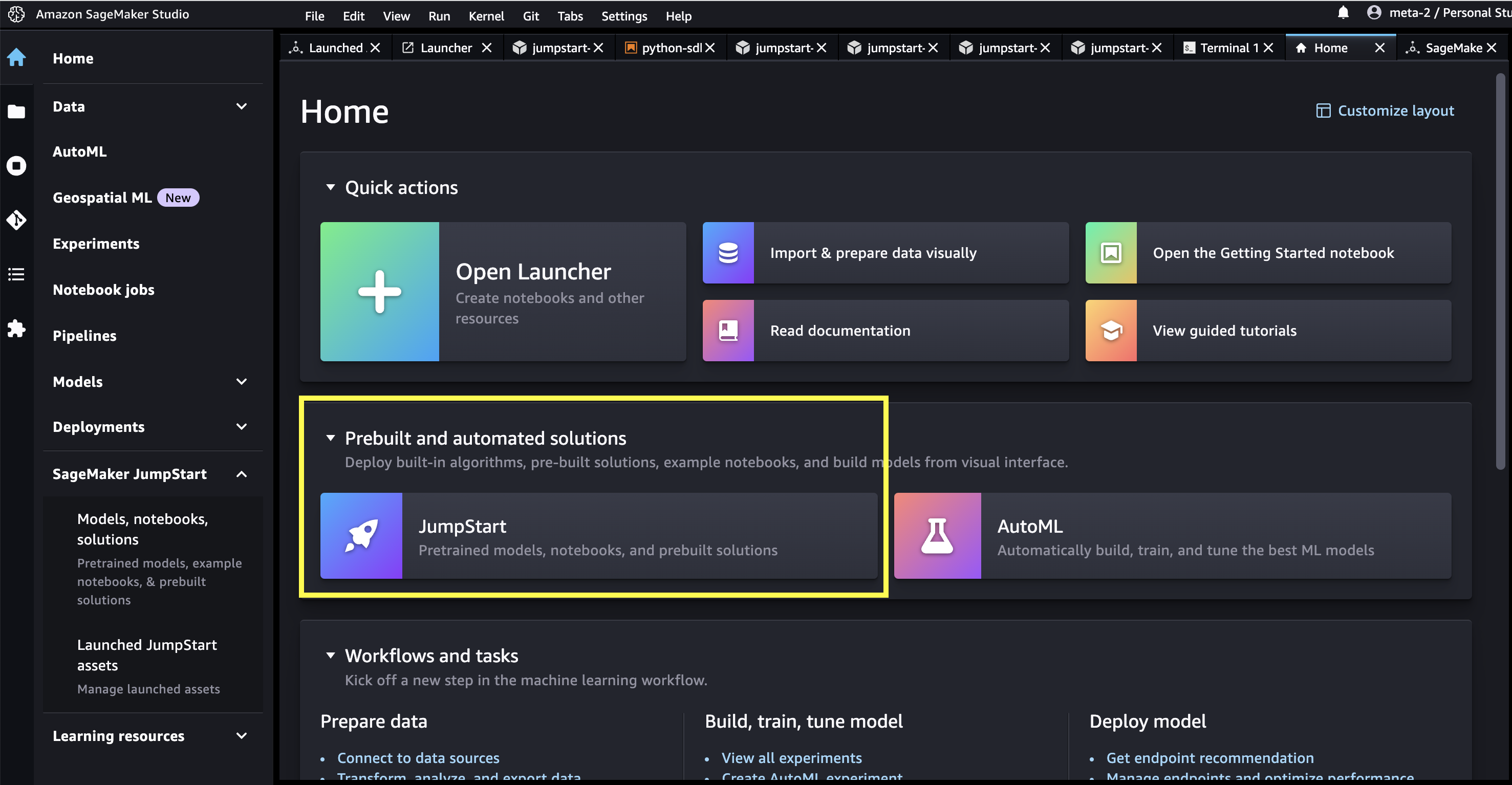

In SageMaker Studio è possibile accedere a SageMaker JumpStart, che contiene modelli pre-addestrati, notebook e soluzioni predefinite, in Soluzioni predefinite e automatizzate.

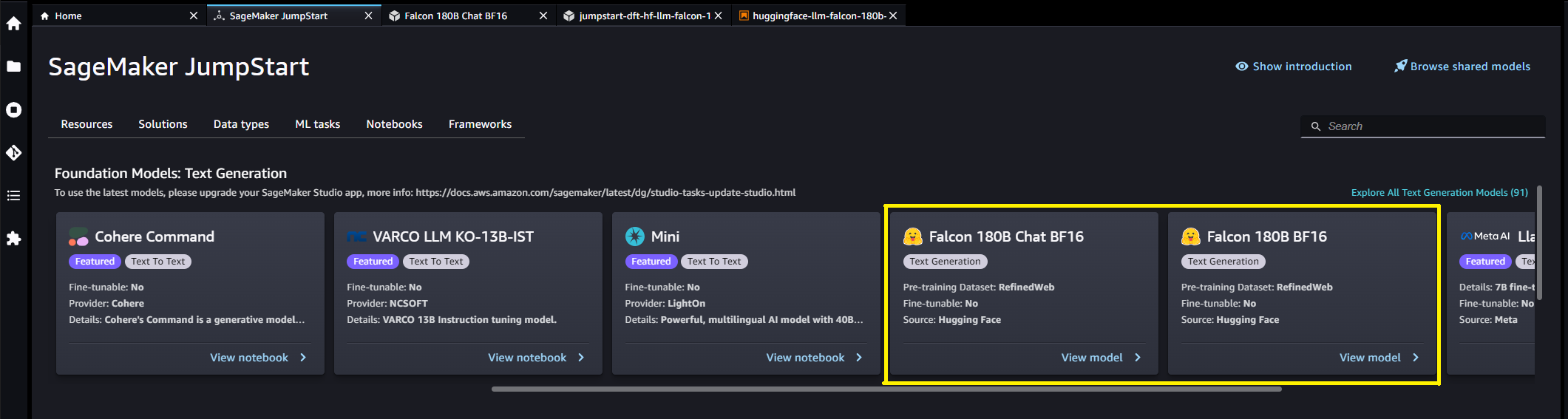

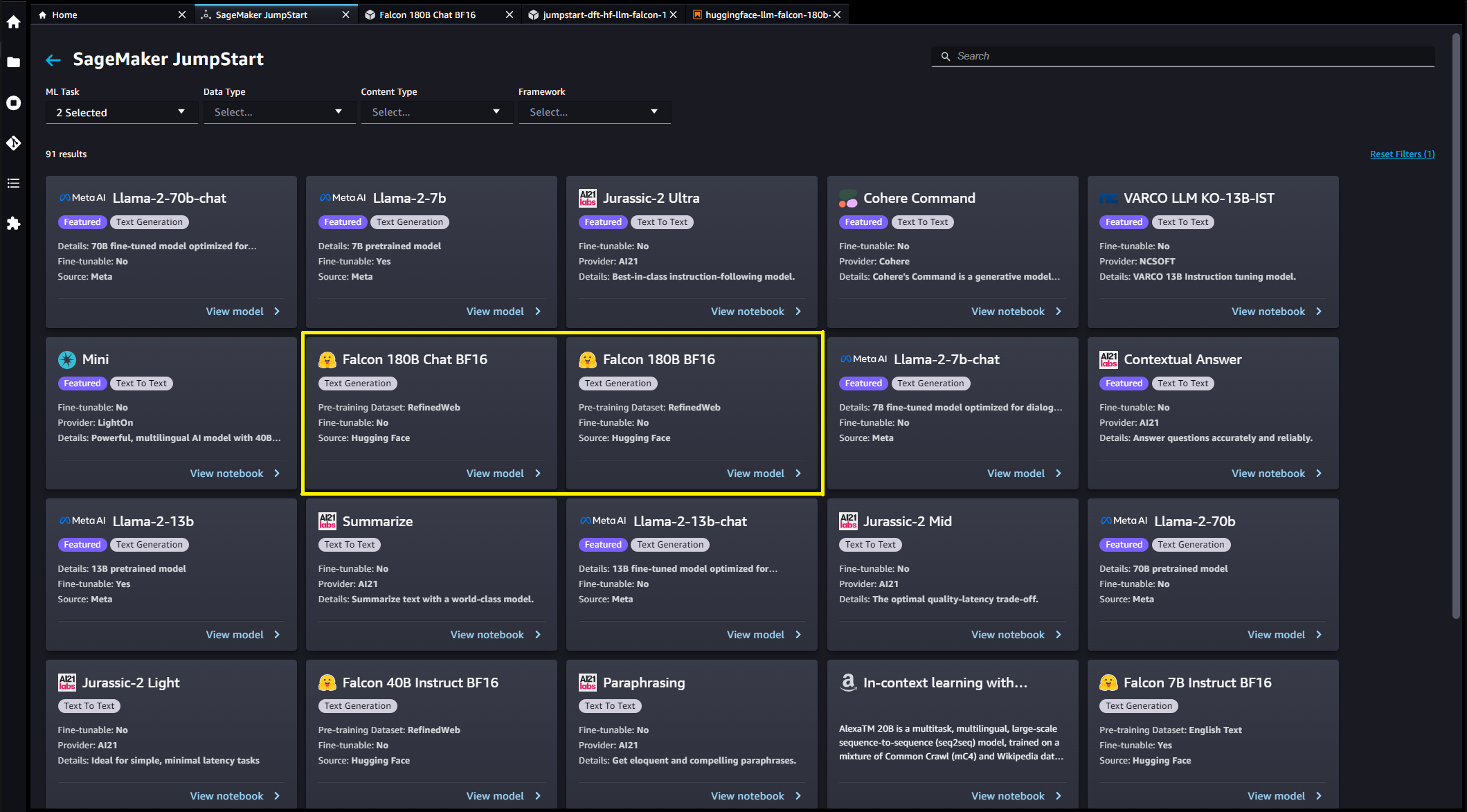

Dalla pagina di destinazione JumpStart di SageMaker è possibile cercare soluzioni, modelli, notebook e altre risorse. Puoi trovare Falcon 180B nel Modelli di fondazione: generazione di testo giostra

Puoi trovare anche altre varianti del modello scegliendo Esplora tutti i modelli di generazione di testo o cercando Falcon.

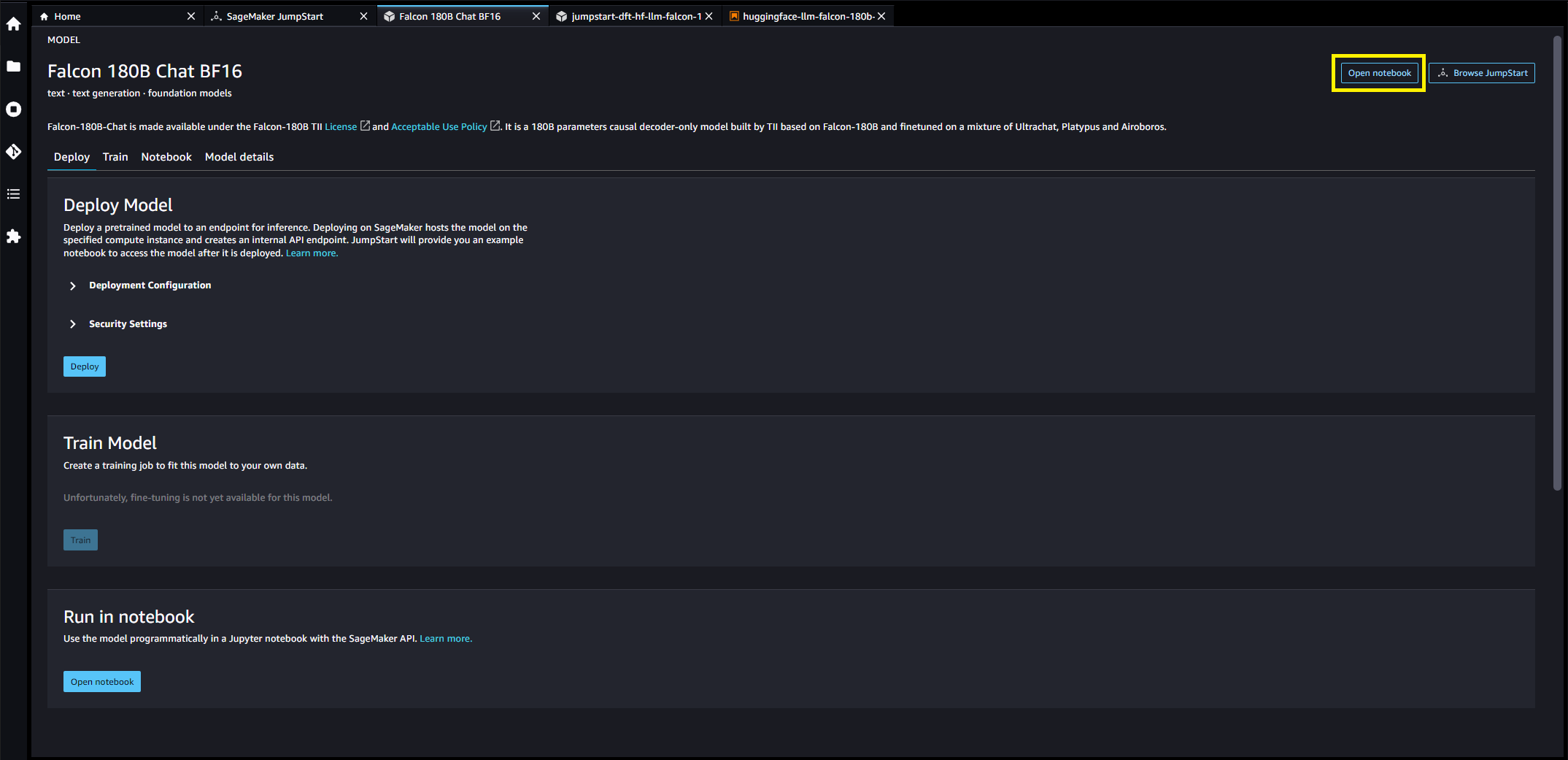

Puoi scegliere la scheda del modello per visualizzare i dettagli sul modello come licenza, dati utilizzati per l'addestramento e modalità di utilizzo. Troverai anche due pulsanti, Schierare ed Apri taccuino, che ti aiuterà a utilizzare il modello (lo screenshot seguente mostra il file Schierare opzione).

Distribuire modelli

Quando si sceglie Schierare, verrà avviata la distribuzione del modello. In alternativa, è possibile eseguire la distribuzione tramite il notebook di esempio visualizzato scegliendo Apri taccuino. Il notebook di esempio fornisce indicazioni end-to-end su come distribuire il modello per l'inferenza e pulire le risorse.

Per eseguire la distribuzione utilizzando un notebook, iniziamo selezionando un modello appropriato, specificato dal model_id. Puoi distribuire uno qualsiasi dei modelli selezionati su SageMaker con il seguente codice:

Questo distribuisce il modello su SageMaker con configurazioni predefinite, inclusi il tipo di istanza predefinito e le configurazioni VPC predefinite. È possibile modificare queste configurazioni specificando valori non predefiniti in JumpStartModel. Per saperne di più fare riferimento al Documentazione delle API. Dopo la distribuzione, puoi eseguire l'inferenza sull'endpoint distribuito tramite un predittore SageMaker. Vedere il seguente codice:

I parametri di inferenza controllano il processo di generazione del testo all'endpoint. Il controllo massimo di nuovi token si riferisce alla dimensione dell'output generato dal modello. Tieni presente che questo non è lo stesso numero di parole perché il vocabolario del modello non è lo stesso del vocabolario della lingua inglese e ogni token potrebbe non essere una parola della lingua inglese. La temperatura controlla la casualità nell'output. Una temperatura più elevata si traduce in risultati più creativi e allucinati. Tutti i parametri di inferenza sono facoltativi.

Questo modello con parametri da 180B è di 335 GB e richiede ancora più memoria GPU per eseguire un'inferenza sufficiente con una precisione a 16 bit. Attualmente, JumpStart supporta questo modello solo su istanze ml.p4de.24xlarge. È possibile distribuire un modello quantizzato a 8 bit su un'istanza ml.p4d.24xlarge fornendo il env={"HF_MODEL_QUANTIZE": "bitsandbytes"} argomento della parola chiave per il JumpStartModel costruttore e specificazione instance_type="ml.p4d.24xlarge" al metodo di distribuzione. Tuttavia, tieni presente che la latenza per token è circa 5 volte più lenta per questa configurazione quantizzata.

La tabella seguente elenca tutti i modelli Falcon disponibili in SageMaker JumpStart insieme agli ID modello, ai tipi di istanza predefiniti, al numero massimo di token totali (somma del numero di token di input e numero di token generati) supportati e alla tipica latenza di risposta per token per ciascuno di questi modelli.

| Nome del modello | ID modello | Tipo di istanza predefinito | Gettoni totali massimi | Latenza per token* |

| Falcon 7B | huggingface-llm-falcon-7b-bf16 |

ml.g5.2xgrande | 2048 | ms 34 |

| Falcon 7B Istruttore | huggingface-llm-falcon-7b-instruct-bf16 |

ml.g5.2xgrande | 2048 | ms 34 |

| Falcon 40B | huggingface-llm-falcon-40b-bf16 |

ml.g5.12xgrande | 2048 | ms 57 |

| Falcon 40B Istruttore | huggingface-llm-falcon-40b-instruct-bf16 |

ml.g5.12xgrande | 2048 | ms 57 |

| Falcon 180B | huggingface-llm-falcon-180b-bf16 |

ml.p4de.24xlarge | 2048 | ms 45 |

| Chatta sul Falcon 180B | huggingface-llm-falcon-180b-chat-bf16 |

ml.p4de.24xlarge | 2048 | ms 45 |

*la latenza per token è fornita per il tempo di risposta mediano dei prompt di esempio forniti in questo blog; questo valore varierà in base alla lunghezza delle sequenze di input e output.

Inferenza e suggerimenti di esempio per Falcon 180B

I modelli Falcon possono essere utilizzati per il completamento del testo per qualsiasi parte di testo. Attraverso la generazione del testo, puoi eseguire una serie di attività, come rispondere a domande, tradurre la lingua, analizzare il sentiment e molto altro. L'endpoint accetta il seguente schema di payload di input:

Puoi esplorare la definizione di questi parametri del cliente e i loro valori predefiniti all'interno del repository di inferenza di generazione di testo.

Di seguito sono riportati alcuni esempi di prompt e il testo generato dal modello. Tutti gli output qui sono generati con parametri di inferenza {"max_new_tokens": 768, "stop": ["<|endoftext|>", "###"]}.

La creazione di un sito web può essere eseguita in 10 semplici passaggi:

Potresti notare che questo modello preaddestrato genera lunghe sequenze di testo che non sono necessariamente ideali per i casi d'uso dei dialoghi. Prima di mostrare come funziona il modello di chat ottimizzato per un insieme più ampio di istruzioni basate su dialoghi, i prossimi due esempi illustrano come utilizzare i modelli Falcon con l'apprendimento in contesto con poche riprese, in cui forniamo esempi di formazione disponibili per il modello. Tieni presente che il "few-shot learning" non modifica i pesi del modello: durante questo processo eseguiamo solo inferenze sul modello distribuito, fornendo al contempo alcuni esempi nel contesto di input per aiutare l'output del modello di gilda.

Inferenza e suggerimenti di esempio per Falcon 180B-Chat

Con i modelli Falcon 180B-Chat, ottimizzati per i casi d'uso del dialogo, l'input agli endpoint del modello di chat può contenere la cronologia precedente tra l'assistente di chat e l'utente. Puoi porre domande contestuali alla conversazione avvenuta finora. Puoi anche fornire la configurazione del sistema, come i personaggi, che definiscono il comportamento dell'assistente chat. Il carico utile in ingresso all'endpoint è lo stesso del modello Falcon 180B tranne il inputs il valore stringa deve utilizzare il seguente formato:

Di seguito sono riportati alcuni esempi di prompt e il testo generato dal modello. Tutti gli output sono generati con parametri di inferenza {"max_new_tokens":256, "stop": ["nUser:", "<|endoftext|>", " User:", "###"]}.

Nell'esempio seguente, l'utente ha avuto una conversazione con l'assistente sui siti turistici di Parigi. Successivamente, l'utente chiede quale sia la prima opzione consigliata dall'assistente chat.

ripulire

Dopo aver terminato l'esecuzione del notebook, assicurati di eliminare tutte le risorse create nel processo in modo che la fatturazione venga interrotta. Utilizza il seguente codice:

Conclusione

In questo post ti abbiamo mostrato come iniziare con Falcon 180B in SageMaker Studio e distribuire il modello per l'inferenza. Poiché i modelli di base sono pre-addestrati, possono contribuire a ridurre i costi di formazione e infrastruttura e consentire la personalizzazione per il tuo caso d'uso. Visita subito SageMaker JumpStart in SageMaker Studio per iniziare.

Risorse

Informazioni sugli autori

Dottor Kyle Ulrich è uno scienziato applicato del team JumpStart di Amazon SageMaker. I suoi interessi di ricerca includono algoritmi scalabili di apprendimento automatico, visione artificiale, serie temporali, parametri bayesiani non parametrici e processi gaussiani. Ha conseguito il dottorato di ricerca presso la Duke University e ha pubblicato articoli su NeurIPS, Cell e Neuron.

Dottor Kyle Ulrich è uno scienziato applicato del team JumpStart di Amazon SageMaker. I suoi interessi di ricerca includono algoritmi scalabili di apprendimento automatico, visione artificiale, serie temporali, parametri bayesiani non parametrici e processi gaussiani. Ha conseguito il dottorato di ricerca presso la Duke University e ha pubblicato articoli su NeurIPS, Cell e Neuron.

Dottor Ashish Khetan è uno scienziato applicato senior presso Amazon SageMaker JumpStart e aiuta a sviluppare algoritmi di apprendimento automatico. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nel campo dell'apprendimento automatico e dell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dottor Ashish Khetan è uno scienziato applicato senior presso Amazon SageMaker JumpStart e aiuta a sviluppare algoritmi di apprendimento automatico. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nel campo dell'apprendimento automatico e dell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Olivier CruchanÈ Principal Machine Learning Specialist Solutions Architect presso AWS, con sede in Francia. Olivier aiuta i clienti AWS, dalle piccole startup alle grandi imprese, a sviluppare e distribuire applicazioni di machine learning di livello produttivo. Nel tempo libero gli piace leggere articoli di ricerca ed esplorare la natura selvaggia con amici e familiari.

Olivier CruchanÈ Principal Machine Learning Specialist Solutions Architect presso AWS, con sede in Francia. Olivier aiuta i clienti AWS, dalle piccole startup alle grandi imprese, a sviluppare e distribuire applicazioni di machine learning di livello produttivo. Nel tempo libero gli piace leggere articoli di ricerca ed esplorare la natura selvaggia con amici e familiari.

Carlo Albertsen guida l'hub del modello di base, gli algoritmi e i team di partnership di Amazon SageMaker.

Carlo Albertsen guida l'hub del modello di base, gli algoritmi e i team di partnership di Amazon SageMaker.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Grafico Prime. Migliora il tuo gioco di trading con ChartPrime. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/falcon-180b-foundation-model-from-tii-is-now-available-via-amazon-sagemaker-jumpstart/

- :ha

- :È

- :non

- :Dove

- $ SU

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 150

- 20

- 25

- 26%

- 3d

- 4k

- 7

- 8

- 9

- a

- WRI

- accetta

- accesso

- accessibile

- Raggiungere

- attivo

- aggiungere

- Inoltre

- indirizzo

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- Algoritmi

- Tutti

- consente

- lungo

- anche

- sempre

- am

- Amazon

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Web Services

- an

- .

- ed

- e infrastruttura

- Annunciare

- Un altro

- rispondere

- in qualsiasi

- chiunque

- attraente

- applicazioni

- applicato

- opportuno

- circa

- architettura

- SONO

- argomento

- Arte

- articolo

- AS

- chiedere

- Assistant

- At

- attenzione

- attrarre

- attrazione

- Automatizzata

- disponibile

- viali

- AWS

- basato

- batteria

- bayesiano

- BE

- bellissimo

- perché

- stato

- prima

- comportamento

- Meglio

- fra

- fatturazione

- Blog

- vanta

- del browser

- costruttore

- costruttori

- Costruzione

- affari

- ma

- by

- caffè

- Materiale

- capacità

- carta

- carosello

- Custodie

- casi

- il cambiamento

- dai un'occhiata

- Scegli

- la scelta

- scelto

- Città

- classificare

- Cluster

- cms

- codice

- codebase

- collezione

- colonne

- COM

- combinato

- Uncommon

- azienda

- completamento di una

- completamento

- computer

- Visione computerizzata

- conferenze

- Configurazione

- Consistente

- contatti

- contenere

- Contenitore

- contiene

- contenuto

- contesto

- contestuale

- continuamente

- contribuito

- di controllo

- controlli

- Conversazione

- discorsivo

- Costi

- creare

- creato

- Creazione

- Creative

- Coppa

- Corrente

- Attualmente

- costume

- cliente

- Assistenza clienti

- Clienti

- personalizzazione

- personalizzare

- dati

- la sicurezza dei dati

- dataset

- giorno

- decisione

- dedicato

- Predefinito

- definire

- definizione

- dimostrare

- Dipendente

- schierare

- schierato

- distribuzione

- deployment

- Distribuisce

- Design

- destinazione

- dettagli

- Determinare

- sviluppare

- sviluppato

- Mercato

- dialogo

- Dialogo

- diverso

- scopri

- distribuito

- formazione distribuita

- do

- effettua

- dominio

- Domain Name

- NOMI DI DOMINIO

- fatto

- sogni

- Duca

- Università del Duca

- durante

- ogni

- alleviare

- facilmente

- est

- facile

- enable

- consentendo

- da un capo all'altro

- endpoint

- energia

- Ingegneria

- Inglese

- garantire

- aziende

- Ambiente

- particolarmente

- Anche

- esempio

- Esempi

- Tranne

- eccitato

- competenza

- esplora

- Esplorare

- espresso

- estensione

- estensioni

- estensivo

- famiglia

- famoso

- lontano

- affascinante

- Caratteristiche

- pochi

- Trovate

- Nome

- galleggiante

- i seguenti

- segue

- Nel

- formato

- Ex

- Fondazione

- quattro

- TELAIO

- Francia

- Francese

- amici

- da

- funzionamento

- ulteriormente

- Giardini

- gemma

- generare

- generato

- genera

- ELETTRICA

- ottenere

- vetro.

- Go

- scopo

- Obiettivi

- andando

- buono

- ha ottenuto

- GPU

- GPU

- grande

- Crescita

- guida

- gilda

- ha avuto

- successo

- odio

- Avere

- avendo

- he

- Cuore

- Aiuto

- utile

- aiutare

- aiuta

- qui

- nascosto

- Gemma nascosta

- Alte prestazioni

- superiore

- il suo

- storia

- Casa

- host

- di hosting

- Come

- Tutorial

- Tuttavia

- HTML

- HTTPS

- Hub

- i

- iconico

- ID

- ideale

- ids

- if

- Illinois

- Immagine

- immagini

- importare

- impressionante

- in

- includere

- Compreso

- incredibile

- informazioni

- Infrastruttura

- Innovazione

- ingresso

- Ingressi

- esempio

- Istituto

- istruzioni

- integrato

- interessato

- interessi

- Interfaccia

- ai miglioramenti

- isolato

- IT

- SUO

- jpg

- conosciuto

- kyle

- atterraggio

- Lingua

- grandi

- Grandi imprese

- larga scala

- superiore, se assunto singolarmente.

- maggiore

- Latenza

- con i più recenti

- lanciare

- Legislazione

- disposizione

- Leads

- IMPARARE

- apprendimento

- Lunghezza

- Licenza

- leggera

- foderato

- LINK

- Collegamento

- Lista

- elenchi

- Caricamento in corso

- Lunghi

- inferiore

- Lussemburgo

- macchina

- machine learning

- fatto

- make

- Fare

- gestione

- gestisce

- molti

- meraviglia

- Massa

- massiccio

- max

- massimo

- Maggio..

- significato

- si intende

- Media

- medievale

- Memorie

- messaggio

- metodo

- forza

- Miscelazione

- miscela

- ML

- MLOp

- modello

- modelli

- Scopri di più

- maggior parte

- movimento

- Museo di Capodimonte

- Musica

- my

- Nome

- Detto

- nomi

- Navigare

- Navigazione

- necessariamente

- Bisogno

- negativo.

- rete

- Rete

- Neutres

- New

- GENERAZIONE

- notte

- no

- taccuino

- Avviso..

- adesso

- numero

- osservatori

- of

- Offerte

- Olio

- Oliva

- on

- una volta

- ONE

- esclusivamente

- apertamente

- operativa

- ottimizzati

- Opzione

- Opzioni

- or

- Oregon

- Altro

- su

- delineato

- produzione

- ancora

- pagina

- pagine

- Palazzo

- documenti

- parametro

- parametri

- Parigi

- Parco

- particolarmente

- partnership

- Pagamento

- metodo di pagamento

- Persone

- per

- perfetta

- Eseguire

- performance

- esegue

- phd

- telefono

- Fisica

- pezzo

- piano

- Platone

- Platone Data Intelligence

- PlatoneDati

- per favore

- positivo

- possibile

- Post

- Post

- Precisione

- Predictor

- preparazione

- presenti

- precedente

- principalmente

- Direttore

- problemi

- processi

- i processi

- Prodotto

- promuoverlo

- propriamente

- fornire

- purché

- fornitore

- fornisce

- fornitura

- pubblicato

- scopo

- metti

- Python

- Domande

- rapidamente

- casualità

- Crudo

- Lettura

- ricetta

- raccomandato

- riferimento

- si riferisce

- Indipendentemente

- regioni

- registro

- registrazione

- registrare

- Iscrizione

- parente

- relatività

- rilasciato

- Uscite

- pertinente

- problemi di

- affidabile

- ricorda

- deposito

- rappresenta

- richiede

- requisito

- riparazioni

- ricercatore

- Risorse

- risposta

- Risultati

- Ricco

- VIAGGIO

- Diritti

- Correre

- running

- s

- sagemaker

- sale

- stesso

- Scalabilità

- scalabile

- Scala

- Scienziato

- sdk

- MARE

- Cerca

- ricerca

- Stagione

- Secondo

- Sezione

- sicuro

- problemi di

- vedere

- seme

- selezionato

- Selezione

- anziano

- sentimento

- Serie

- servizio

- Servizi

- set

- impostazioni

- alcuni

- Condividi

- negozi

- Corti

- dovrebbero

- mostrare attraverso le sue creazioni

- ha mostrato

- Spettacoli

- segno

- Un'espansione

- semplicità

- semplicemente

- singolo

- Siti

- Taglia

- Lentamente

- piccole

- So

- finora

- Social

- Social Media

- Post sui social media

- Soluzioni

- alcuni

- qualcosa

- Fonte

- lo spazio

- specialista

- specificato

- velocità

- inizia a

- iniziato

- Startup

- stati

- stazione

- statistiche

- Passi

- Fermare

- fermato

- conservazione

- Tornare al suo account

- strada

- Corda

- studio

- Stupendo

- tale

- supporto

- supportato

- supporti

- sicuro

- simbolo

- sistema

- tavolo

- Fai

- presa

- task

- chiavi

- team

- le squadre

- Tecnologia

- Innovazione tecnologica

- modello

- test

- testo

- che

- Il

- il mondo

- loro

- Li

- tema

- poi

- teoria

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- Terza

- questo

- Attraverso

- tempo

- Serie storiche

- a

- insieme

- token

- Tokens

- strumenti

- Totale

- Torre

- Treni

- allenato

- Training

- trasformatore

- tradurre

- Traduzione

- Trilione

- viaggio

- tritone

- prova

- Tweet

- seconda

- Digitare

- Tipi di

- tipico

- ui

- per

- unificato

- unico

- Università

- fino a quando

- Caricamento

- us

- uso

- caso d'uso

- utilizzato

- Utente

- utenti

- usa

- utilizzando

- Vuoto

- APPREZZIAMO

- Valori

- varietà

- vario

- versione

- versioni

- via

- Vibe

- Video

- Video

- Visualizza

- visualizzazioni

- Virginia

- visione

- Visita

- visitatori

- visivamente

- camminare

- volere

- Prima

- filigrana

- we

- sito web

- servizi web

- Web-basata

- Sito web

- settimana

- Settimane

- WELL

- ovest

- Che

- Che cosa è l'

- quando

- quale

- while

- volere

- finestre

- con

- entro

- senza

- Word

- parole

- mondo

- scrittura

- sì

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro

- zero