In questi giorni, non dobbiamo aspettare molto fino alla prossima svolta intelligenza artificiale (AI) impressiona tutti con capacità che prima appartenevano solo alla fantascienza.

Nel 2022, Strumenti di generazione artistica AI come DALL-E 2 di Open AI, Imagen di Google e Stable Diffusion hanno preso d'assalto Internet, con gli utenti che generano immagini di alta qualità dalle descrizioni testuali.

A differenza degli sviluppi precedenti, questi strumenti di conversione da testo a immagine hanno trovato rapidamente la loro strada dai laboratori di ricerca a cultura tradizionale, portando a fenomeni virali come la funzione "Magic Avatar" nell'app Lensa AI, che crea immagini stilizzate dei suoi utenti.

A dicembre, un chatbot chiamato ChatGPT ha sbalordito gli utenti con il suo capacità di scrittura, portando a previsioni che la tecnologia sarà presto in grado di fare superare gli esami professionali. Secondo quanto riferito, ChatGPT ha guadagnato un milione di utenti in meno di una settimana. Alcuni funzionari scolastici lo hanno già fatto vietato per paura che gli studenti lo usino per scrivere saggi. Microsoft lo è riferito prevede di incorporare ChatGPT nella sua ricerca Web Bing e nei prodotti Office entro la fine dell'anno.

Cosa significa l'inarrestabile progresso dell'IA per il prossimo futuro? Ed è probabile che l'intelligenza artificiale minacci determinati posti di lavoro negli anni a venire?

Nonostante questi impressionanti risultati recenti dell'IA, dobbiamo riconoscere che esistono ancora limiti significativi a ciò che i sistemi di intelligenza artificiale possono fare.

L'intelligenza artificiale eccelle nel riconoscimento dei modelli

I recenti progressi nell'intelligenza artificiale si basano principalmente su algoritmi di apprendimento automatico che individuano schemi e relazioni complessi da grandi quantità di dati. Questa formazione viene quindi utilizzata per attività come la previsione e la generazione di dati.

Lo sviluppo dell'attuale tecnologia IA si basa sull'ottimizzazione del potere predittivo, anche se l'obiettivo è generare nuovo output.

Per esempio, GPT-3, il modello linguistico alla base di ChatGPT, è stato addestrato per prevedere ciò che segue una parte di testo. GPT-3 sfrutta quindi questa capacità predittiva per continuare un testo di input fornito dall'utente.

Le "IA generative" come ChatGPT e DALL-E 2 si sono scatenate molto dibattito sul fatto che l'intelligenza artificiale possa essere veramente creativa e persino rivaleggiare con gli umani in questo senso. Tuttavia, la creatività umana attinge non solo ai dati del passato, ma anche alla sperimentazione e all'intera gamma dell'esperienza umana.

Causa ed effetto

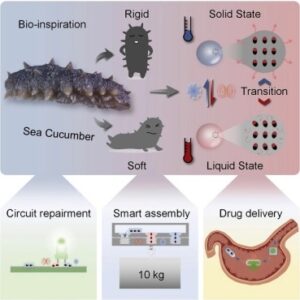

Molti problemi importanti richiedono di prevedere gli effetti delle nostre azioni in ambienti complessi, incerti e in continua evoluzione. In questo modo, possiamo scegliere la sequenza di azioni più probabile per raggiungere i nostri obiettivi. Ma gli algoritmi non possono imparare su cause ed effetti dai soli dati. Il machine learning puramente basato sui dati può solo trovare correlazioni.

Per capire perché questo è un problema per l'IA, possiamo confrontare i problemi della diagnosi di una condizione medica rispetto alla scelta di un trattamento. I modelli di apprendimento automatico sono spesso utili per trovare anomalie nelle immagini mediche; questo è un problema di riconoscimento del modello. Non dobbiamo preoccuparci della causalità perché le anomalie sono già presenti o meno.

Ma scegliere il miglior trattamento per una diagnosi è un problema fondamentalmente diverso. Qui, l'obiettivo è influenzare il risultato, non solo riconoscere uno schema. Per determinare l'efficacia di un trattamento, i ricercatori medici eseguono studi controllati randomizzati. In questo modo, possono cercare di controllare eventuali fattori che potrebbero influenzare il trattamento.

La confusione tra questi due tipi di problemi a volte porta a applicazioni subottimali del machine learning nelle organizzazioni.

Mentre il successo del recente lavoro sull'intelligenza artificiale dimostra il valore dei modelli basati sui dati, molti dei problemi che vorremmo che i computer risolvessero richiedono una comprensione della causalità.

Gli attuali sistemi di intelligenza artificiale mancano di questa capacità, a parte applicazioni specializzate come giochi da tavolo.

Ragionamento di buon senso

Modelli linguistici come GPT-3 e ChatGPT possono risolvere con successo alcuni compiti che richiedono un ragionamento basato sul buon senso.

Tuttavia, la seguente interazione con ChatGPT, adattata da un esperimento di Gary Marco, suggerisce che non è del tutto affidabile al riguardo.

Ho otto anni. Quando sono nato, mia madre biologica era a Barcellona e mio padre era a Tokyo. Dove sono nato? Pensa a questo passo dopo passo.

Non è detto dove sei nato. Tutto quello che sappiamo è che tua madre biologica era a Barcellona e tuo padre era a Tokyo al momento della tua nascita.

Se i sistemi di intelligenza artificiale come ChatGPT possano raggiungere il buon senso è oggetto di un vivace dibattito tra gli esperti.

Gli scettici come Marcus sottolineano che non possiamo fidarci dei modelli linguistici per mostrare in modo robusto il buon senso poiché non lo hanno incorporato né sono direttamente ottimizzati per questo. Gli ottimisti sostengono che mentre i sistemi attuali sono imperfetti, il buon senso può farlo emergono spontaneamente in modelli linguistici sufficientemente avanzati.

Valori umani

Ogni volta che vengono rilasciati sistemi di intelligenza artificiale rivoluzionari, articoli di notizie e post sui social media documentano razzista, sessistae altri tipi di parziale ed comportamenti dannosi inevitabilmente seguono.

Questo difetto è inerente agli attuali sistemi di intelligenza artificiale, che sono destinati a riflettere i loro dati. I valori umani come la verità e l'equità non sono fondamentalmente incorporati negli algoritmi; è qualcosa che i ricercatori non sanno ancora come fare.

Mentre i ricercatori lo sono imparando le lezioni da episodi passati e facendo progressi nell'affrontare i pregiudizi, il campo dell'IA ha ancora un lunga strada da percorrere per allineare in modo efficace i sistemi di intelligenza artificiale con i valori e le preferenze umane.![]()

Questo articolo è ripubblicato da The Conversation sotto una licenza Creative Commons. Leggi il articolo originale.

Immagine di credito: Mahdis Musavi/Unsplash

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://singularityhub.com/2023/01/13/ai-might-be-seemingly-everywhere-but-there-are-still-plenty-of-things-it-cant-do-for-now/

- 1

- 10

- 2022

- a

- ABC

- capacità

- capace

- WRI

- sopra

- Raggiungere

- realizzazioni

- azioni

- indirizzamento

- Avanzate

- avanzamenti

- influenzare

- Dopo shavasana, sedersi in silenzio; saluti;

- AI

- Algoritmi

- Tutti

- da solo

- già

- tra

- importi

- ed

- a parte

- App

- applicazioni

- discutere

- Arte

- articolo

- news

- artificiale

- opere d'arte

- Barcellona

- perché

- dietro

- sotto

- MIGLIORE

- fra

- pregiudizio

- Bing

- Dezen Dezen

- Bound

- sfondamento

- costruito

- pulsante

- detto

- non può

- funzionalità

- Custodie

- cause

- certo

- cambiando

- chatbot

- ChatGPT

- Scegli

- la scelta

- codice

- raccogliere

- COM

- Uncommon

- Popolo

- complesso

- computer

- condizione

- confusione

- costantemente

- continua

- contrasto

- di controllo

- controllata

- Conversazione

- contatore

- crea

- Creative

- la creatività

- credito

- Corrente

- dall's

- dati

- data-driven

- Giorni

- dibattito

- Dicembre

- Determinare

- Mercato

- sviluppi

- diverso

- direttamente

- Dsiplay

- fare

- Dont

- efficacia

- effetti

- o

- interamente

- ambienti

- Anche

- tutti

- esempio

- esperienza

- esperimento

- esperti

- Occhi

- Fattori

- equità

- paura

- caratteristica

- Fantasia

- campo

- Trovate

- ricerca

- difetto

- seguire

- i seguenti

- segue

- essere trovato

- da

- pieno

- fondamentalmente

- futuro

- generare

- generato

- la generazione di

- ELETTRICA

- ottenere

- gif

- dato

- scopo

- Obiettivi

- innovativo

- utile

- qui

- alta qualità

- Come

- Tutorial

- Tuttavia

- HTML

- HTTPS

- umano

- Esperienza umana

- Gli esseri umani

- Immagine

- immagini

- importante

- impressionante

- in

- incorporare

- inevitabilmente

- influenza

- info

- inerente

- ingresso

- interazione

- Internet

- IT

- Offerte di lavoro

- Sapere

- Labs

- Dipingere

- Lingua

- principale

- Leads

- apprendimento

- leveraggi

- Licenza

- probabile

- limiti

- limiti

- Lunghi

- macchina

- machine learning

- molti

- Marcus

- max-width

- Media

- medicale

- menzionato

- Microsoft

- forza

- milione

- modello

- modelli

- Scopri di più

- maggior parte

- madre

- Vicino

- Bisogno

- Nessuno dei due

- rete

- New

- notizie

- GENERAZIONE

- Nozione

- NYU

- Office

- Vecchio

- ONE

- aprire

- ottimizzati

- ottimizzazione

- organizzazioni

- Altro

- lineamenti

- passato

- Cartamodello

- modelli

- Eseguire

- cronologia

- dati personali

- pezzo

- pianificazione

- Platone

- Platone Data Intelligence

- PlatoneDati

- per favore

- Abbondanza

- punto

- Poligono

- Post

- energia

- predire

- previsione

- predizione

- Previsioni

- prevalentemente

- preferenze

- presenti

- precedente

- in precedenza

- Problema

- problemi

- Prodotti

- professionale

- Progressi

- puramente

- rapidamente

- Randomizzato

- gamma

- Leggi

- recente

- riconoscimento

- riconoscere

- riflessione

- Relazioni

- rilasciato

- affidabile

- rimuovere

- rappresentato

- richiedere

- riparazioni

- ricercatori

- Rivale

- Correre

- di moto

- Scienze

- Fantascienza

- Cerca

- senso

- Sequenza

- alcuni

- significativa

- da

- situazioni

- Social

- Social Media

- Post sui social media

- RISOLVERE

- alcuni

- qualcosa

- Fonte

- specializzata

- stabile

- step

- Ancora

- Tempesta

- Gli studenti

- soggetto

- il successo

- Con successo

- tale

- suggerisce

- SISTEMI DI TRATTAMENTO

- TAG

- task

- Tecnologia

- Il

- loro

- cose

- quest'anno

- minacciare

- Attraverso

- tempo

- a

- Tokyo

- strumenti

- allenato

- Training

- trattamento

- studi clinici

- Affidati ad

- Tipi di

- Incerto

- capire

- e una comprensione reciproca

- Inaspettato

- uso

- Utente

- utenti

- APPREZZIAMO

- Valori

- Fisso

- contro

- VOX

- aspettare

- sito web

- settimana

- Che

- se

- quale

- while

- volere

- Lavora

- sarebbe

- scrivere

- anno

- anni

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro