Intelligenza artificiale (AI) recentemente ha creato scalpore con la sua possibilità di rivoluzionare il modo in cui le persone affrontano e risolvono compiti diversi e problemi complessi. Dall’assistenza sanitaria alla finanza, l’intelligenza artificiale e i modelli di apprendimento automatico ad essa associati hanno dimostrato il loro potenziale per semplificare processi complessi, migliorare i modelli decisionali e scoprire informazioni preziose.

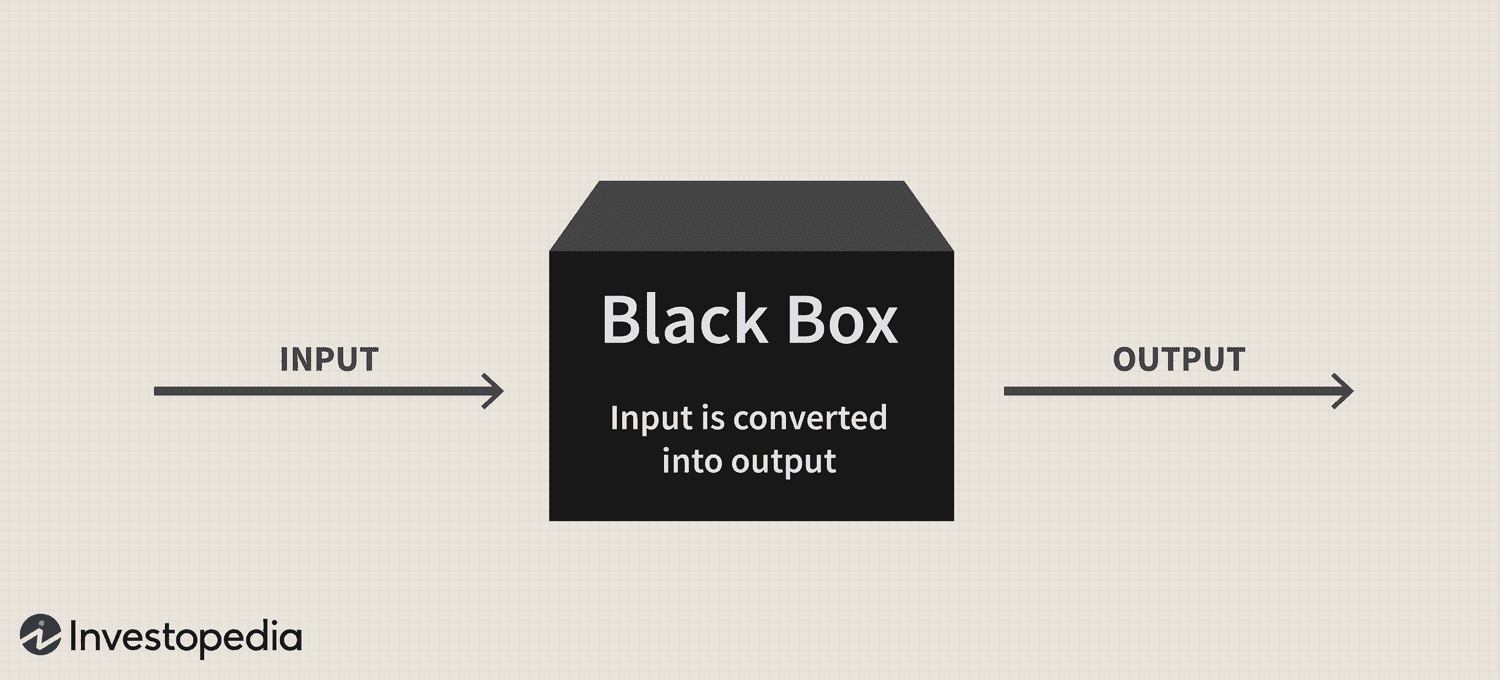

Tuttavia, nonostante l'immenso potenziale della tecnologia, un persistente problema di "scatola nera" ha continuato a rappresentare una sfida significativa per la sua adozione, sollevando interrogativi sulla trasparenza e l'interpretabilità di questi sistemi sofisticati.

In breve, il problema della scatola nera nasce dalla difficoltà di comprendere come i sistemi di intelligenza artificiale e i modelli di apprendimento automatico elaborano i dati e generano previsioni o decisioni. Questi modelli spesso si basano su algoritmi complessi che non sono facilmente comprensibili per gli esseri umani, portando a una mancanza di responsabilità e fiducia.

Pertanto, poiché l'IA diventa sempre più integrata in vari aspetti della nostra vita, affrontare questo problema è fondamentale per garantire l'uso responsabile ed etico di questa potente tecnologia.

La scatola nera: una panoramica

La metafora della "scatola nera" deriva dall'idea che i sistemi di intelligenza artificiale e i modelli di apprendimento automatico operino in un modo nascosto alla comprensione umana, proprio come il contenuto di una scatola sigillata e opaca. Questi sistemi sono costruiti su complessi modelli matematici e set di dati ad alta dimensione, che creano intricate relazioni e modelli che guidano i loro processi decisionali. Tuttavia, questi meccanismi interni non sono facilmente accessibili o comprensibili agli esseri umani.

In termini pratici, il problema della scatola nera dell'IA è la difficoltà di decifrare il ragionamento dietro le previsioni o le decisioni di un sistema di intelligenza artificiale. Questo problema è particolarmente diffuso nei modelli di deep learning come le reti neurali, in cui più livelli di nodi interconnessi elaborano e trasformano i dati in modo gerarchico. La complessità di questi modelli e le trasformazioni non lineari che eseguono rendono estremamente difficile tracciare la logica alla base dei loro risultati.

Nikita Brudnov, CEO di BR Group, un dashboard di analisi di marketing basato sull'intelligenza artificiale, ha dichiarato a Cointelegraph che la mancanza di trasparenza nel modo in cui i modelli di intelligenza artificiale arrivano a determinate decisioni e previsioni potrebbe essere problematica in molti contesti, come diagnosi mediche, processi decisionali finanziari e procedimenti legali, con un impatto significativo sulla prosecuzione dell'adozione dell'IA.

Magazine: Joe Lubin: la verità sulla separazione dei fondatori di ETH e su "Crypto Google"

"Negli ultimi anni, è stata prestata molta attenzione allo sviluppo di tecniche per interpretare e spiegare le decisioni prese dai modelli di intelligenza artificiale, come la generazione di punteggi di importanza delle caratteristiche, la visualizzazione dei limiti delle decisioni e l'identificazione di spiegazioni ipotetiche controfattuali", ha affermato, aggiungendo:

"Tuttavia, queste tecniche sono ancora agli inizi e non vi è alcuna garanzia che saranno efficaci in tutti i casi".

Brudnov ritiene inoltre che con un ulteriore decentramento, le autorità di regolamentazione potrebbero richiedere che le decisioni prese dai sistemi di intelligenza artificiale siano più trasparenti e responsabili per garantirne la validità etica e l'equità complessiva. Ha anche suggerito che i consumatori potrebbero esitare a utilizzare prodotti e servizi basati sull'intelligenza artificiale se non comprendono come funzionano e il loro processo decisionale.

James Wo, il fondatore di DFG, una società di investimento che investe attivamente in tecnologie legate all'intelligenza artificiale, ritiene che il problema della scatola nera non influirà sull'adozione per il prossimo futuro. Per Wo, alla maggior parte degli utenti non interessa necessariamente come funzionano i modelli di intelligenza artificiale esistenti e sono felici di trarne semplicemente utilità, almeno per ora.

“A medio termine, una volta svanita la novità di queste piattaforme, ci sarà sicuramente più scetticismo sulla metodologia della scatola nera. Le domande aumenteranno anche man mano che l'uso dell'intelligenza artificiale entrerà nelle criptovalute e nel Web3, dove ci sono interessi finanziari e conseguenze da considerare ", ha ammesso.

Impatto sulla fiducia e sulla trasparenza

Un dominio in cui l'assenza di trasparenza può avere un impatto sostanziale sulla fiducia è la diagnostica medica basata sull'intelligenza artificiale. Ad esempio, i modelli di intelligenza artificiale possono analizzare dati medici complessi nel settore sanitario per generare diagnosi o raccomandazioni terapeutiche. Tuttavia, quando medici e pazienti non riescono a comprendere la logica alla base di questi suggerimenti, potrebbero mettere in dubbio l'affidabilità e la validità di queste intuizioni. Questo scetticismo può ulteriormente portare all'esitazione nell'adozione di soluzioni di intelligenza artificiale, ostacolando potenzialmente i progressi nella cura del paziente e nella medicina personalizzata.

Nel regno finanziario, i sistemi di intelligenza artificiale possono essere impiegati per il punteggio del credito, il rilevamento delle frodi e la valutazione del rischio. Tuttavia, il problema della scatola nera può creare incertezza per quanto riguarda l'equità e l'accuratezza di questi punteggi di credito o il ragionamento alla base degli avvisi di frode, limitando la capacità della tecnologia di digitalizzare il settore.

Anche l'industria delle criptovalute deve affrontare le ripercussioni del problema della scatola nera. Ad esempio, le risorse digitali e la tecnologia blockchain sono radicate nel decentramento, nell'apertura e nella verificabilità. I sistemi di intelligenza artificiale che mancano di trasparenza e interpretabilità rischiano di creare uno scollamento tra le aspettative degli utenti e la realtà delle soluzioni basate sull'intelligenza artificiale in questo spazio.

Preoccupazioni normative

Da un punto di vista normativo, il problema della scatola nera dell'IA presenta sfide uniche. Per cominciare, l'opacità dei processi di intelligenza artificiale può rendere sempre più difficile per le autorità di regolamentazione valutare la conformità di questi sistemi alle regole e alle linee guida esistenti. Inoltre, la mancanza di trasparenza può complicare la capacità delle autorità di regolamentazione di sviluppare nuovi quadri in grado di affrontare i rischi e le sfide poste dalle applicazioni di IA.

I legislatori possono avere difficoltà a valutare l'equità, i pregiudizi e le pratiche sulla privacy dei sistemi di intelligenza artificiale e il loro potenziale impatto sui diritti dei consumatori e sulla stabilità del mercato. Inoltre, senza una chiara comprensione dei processi decisionali dei sistemi basati sull'intelligenza artificiale, le autorità di regolamentazione potrebbero incontrare difficoltà nell'identificare potenziali vulnerabilità e garantire che siano in atto adeguate misure di salvaguardia per mitigare i rischi.

Uno sviluppo normativo notevole riguardante questa tecnologia è stato l'Artificial Intelligence Act dell'Unione Europea, che si avvicina a diventare parte dello statuto del blocco dopo aver raggiunto un accordo politico provvisorio il 27 aprile.

Fondamentalmente, la legge sull'IA mira a creare un ambiente affidabile e responsabile per lo sviluppo dell'IA all'interno dell'UE. I legislatori hanno adottato un sistema di classificazione che classifica i diversi tipi di IA in base al rischio: inaccettabile, alto, limitato e minimo. Questo quadro è progettato per affrontare varie preoccupazioni relative al problema della scatola nera dell'IA, comprese le questioni relative alla trasparenza e alla responsabilità.

L'incapacità di monitorare e regolamentare efficacemente i sistemi di intelligenza artificiale ha già messo a dura prova le relazioni tra diversi settori e organismi di regolamentazione.

All'inizio del mese scorso, il popolare chatbot AI ChatGPT è stato vietato in Italia per 29 giorni, principalmente a causa delle preoccupazioni sulla privacy sollevate dall'agenzia nazionale per la protezione dei dati per sospette violazioni del Regolamento generale sulla protezione dei dati (GDPR) dell'UE. Tuttavia, alla piattaforma è stato consentito di riprendere i suoi servizi il 29 aprile dopo che il CEO Sam Altman ha annunciato che lui e il suo team avevano adottato misure specifiche per conformarsi alle richieste dell'autorità di regolamentazione, inclusa la rivelazione delle sue pratiche di elaborazione dei dati e l'implementazione della sua implementazione delle norme sull'età. misure di gating.

Una regolamentazione inadeguata dei sistemi di intelligenza artificiale potrebbe erodere la fiducia del pubblico nelle applicazioni di intelligenza artificiale poiché gli utenti diventano sempre più preoccupati per i pregiudizi intrinseci, le imprecisioni e le implicazioni etiche.

Affrontare il problema della scatola nera

Per affrontare efficacemente il problema della scatola nera dell'IA, è essenziale utilizzare una combinazione di approcci che promuovano la trasparenza, l'interpretazione e la responsabilità. Due di queste strategie complementari sono l'AI spiegabile (XAI) e i modelli open source.

XAI è un'area di ricerca dedicata a colmare il divario tra la complessità dei sistemi di intelligenza artificiale e la necessità di interpretabilità umana. XAI si concentra sullo sviluppo di tecniche e algoritmi in grado di fornire spiegazioni comprensibili all'uomo per le decisioni guidate dall'IA, offrendo approfondimenti sul ragionamento alla base di queste scelte.

I metodi spesso impiegati in XAI includono modelli surrogati, analisi dell'importanza delle caratteristiche, analisi della sensibilità e spiegazioni locali interpretabili indipendenti dal modello. L'implementazione di XAI in tutti i settori può aiutare le parti interessate a comprendere meglio i processi basati sull'IA, migliorando la fiducia nella tecnologia e facilitando la conformità ai requisiti normativi.

In tandem con XAI, promuovere l'adozione di modelli di intelligenza artificiale open source può essere una strategia efficace per affrontare il problema della scatola nera. I modelli open source garantiscono l'accesso completo agli algoritmi e ai dati che guidano i sistemi di intelligenza artificiale, consentendo a utenti e sviluppatori di esaminare e comprendere i processi sottostanti.

Questa maggiore trasparenza può contribuire a creare fiducia e favorire la collaborazione tra sviluppatori, ricercatori e utenti. Inoltre, l'approccio open source può creare sistemi di intelligenza artificiale più solidi, responsabili ed efficaci.

Il problema della scatola nera nello spazio crittografico

Il problema della scatola nera ha ramificazioni significative per vari aspetti dello spazio crittografico, tra cui strategie di trading, previsioni di mercato, misure di sicurezza, tokenizzazione e contratti intelligenti.

Nel regno delle strategie di trading e delle previsioni di mercato, i modelli guidati dall'intelligenza artificiale stanno guadagnando popolarità mentre gli investitori cercano di capitalizzare il trading algoritmico. Tuttavia, il problema della scatola nera ostacola la comprensione da parte degli utenti di come funzionano questi modelli, rendendo difficile valutarne l'efficacia ei potenziali rischi. Di conseguenza, questa opacità può anche tradursi in una fiducia ingiustificata nelle decisioni di investimento guidate dall'intelligenza artificiale o rendere gli investitori eccessivamente dipendenti dai sistemi automatizzati.

L'intelligenza artificiale svolgerà un ruolo cruciale nel migliorare le misure di sicurezza all'interno dell'ecosistema blockchain rilevando transazioni fraudolente e attività sospette. Tuttavia, il problema della scatola nera complica il processo di verifica per queste soluzioni di sicurezza basate sull'intelligenza artificiale. La mancanza di trasparenza nel processo decisionale può erodere la fiducia nei sistemi di sicurezza, sollevando preoccupazioni sulla loro capacità di salvaguardare le risorse e le informazioni degli utenti.

Anche la tokenizzazione e i contratti intelligenti, due componenti vitali dell'ecosistema blockchain, stanno assistendo a una maggiore integrazione dell'intelligenza artificiale. Tuttavia, il problema della scatola nera può oscurare la logica alla base dei token generati dall'intelligenza artificiale o dell'esecuzione di contratti intelligenti.

Mentre l'intelligenza artificiale rivoluziona vari settori, affrontare il problema della scatola nera sta diventando sempre più pressante. Promuovendo la collaborazione tra ricercatori, sviluppatori, responsabili politici e parti interessate del settore, è possibile sviluppare soluzioni per promuovere la trasparenza, la responsabilità e la fiducia nei sistemi di intelligenza artificiale. Pertanto, sarà interessante vedere come questo nuovo paradigma tecnologico continua ad evolversi.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Acquista e vendi azioni in società PRE-IPO con PREIPO®. Accedi qui.

- Fonte: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :ha

- :È

- :non

- :Dove

- 2023

- 27

- a

- capacità

- Chi siamo

- accesso

- accessibile

- responsabilità

- responsabile

- precisione

- operanti in

- Legge

- attivamente

- attività

- l'aggiunta di

- Inoltre

- indirizzo

- indirizzamento

- adottato

- Adottando

- Adozione

- avanzamenti

- influenzare

- Dopo shavasana, sedersi in silenzio; saluti;

- agenzia

- Accordo

- AI

- Legge sull'IA

- AI chatbot

- AI-alimentato

- mira

- Avvisi

- algoritmica

- trading algoritmico

- Algoritmi

- Tutti

- già

- anche

- tra

- an

- .

- analitica

- analizzare

- ed

- ha annunciato

- applicazioni

- approccio

- approcci

- opportuno

- Aprile

- SONO

- RISERVATA

- in giro

- artificiale

- intelligenza artificiale

- AS

- aspetti

- valutazione

- Attività

- associato

- At

- attenzione

- Automatizzata

- BE

- diventare

- diventa

- diventando

- stato

- dietro

- crede

- Meglio

- fra

- pregiudizio

- pregiudizi

- Nero

- blockchain

- ecosistema blockchain

- La tecnologia blockchain

- corpi

- libro

- confini

- Scatola

- bridging

- costruire

- costruire fiducia

- costruito

- aziende

- by

- Materiale

- non può

- capitalizzare

- che

- casi

- ceo

- certo

- Challenge

- sfide

- impegnativo

- chatbot

- ChatGPT

- scelte

- classificazione

- sistema di classificazione

- pulire campo

- i medici

- Cointelegraph

- collaborazione

- combinazione

- complementare

- complesso

- complessità

- conformità

- componenti

- comprendere

- interessato

- preoccupazioni

- Conseguenze

- conseguentemente

- Prendere in considerazione

- Consumer

- Diritti dei consumatori

- Consumatori

- testuali

- contesti

- continua

- continua

- contratto

- contratti

- Nucleo

- potuto

- Paese del

- creare

- creato

- credito

- cruciale

- crypto

- Industria criptata

- spazio crypto

- cruscotto

- dati

- privacy dei dati

- elaborazione dati

- protezione dati

- set di dati

- Decentramento

- decisione

- Decision Making

- decisioni

- dedicato

- deep

- apprendimento profondo

- decisamente

- richieste

- dimostrato

- progettato

- Nonostante

- rivelazione

- sviluppare

- sviluppato

- sviluppatori

- in via di sviluppo

- Mercato

- diverso

- difficile

- le difficoltà

- Livello di difficoltà

- digitale

- Risorse digitali

- digitalizzare

- do

- dominio

- Dont

- guidare

- dovuto

- facilmente

- ecosistema

- Efficace

- in maniera efficace

- efficacia

- occupato

- consentendo

- accrescere

- migliorando

- garantire

- assicurando

- entra

- Ambiente

- essential

- ETH

- etico

- EU

- europeo

- valutare

- evolvere

- esempio

- esecuzione

- esistente

- le aspettative

- spiegando

- Faccia

- facce

- facilitando

- equità

- caratteristica

- finanziare

- finanziario

- Impresa

- si concentra

- Nel

- prevedibile

- modulo

- Favorire

- promozione

- fondatore

- fondatori

- Contesto

- quadri

- frode

- rilevazione di frodi

- fraudolenti

- da

- pieno

- function

- ulteriormente

- Inoltre

- futuro

- guadagnando

- divario

- GDPR

- Generale

- dati generali

- generare

- la generazione di

- concedere

- Gruppo

- di garanzia

- guida

- linee guida

- ha avuto

- contento

- Avere

- he

- assistenza sanitaria

- Aiuto

- Alta

- ostacola

- il suo

- Come

- Tuttavia

- HTTPS

- umano

- Gli esseri umani

- identificazione

- if

- immenso

- Impact

- impatto

- implementazione

- Implementazione

- implicazioni

- importanza

- in

- incapacità

- includere

- Compreso

- Aumento

- è aumentato

- sempre più

- industrie

- industria

- informazioni

- inerente

- intuizioni

- integrato

- integrazione

- Intelligence

- interconnesso

- interesse

- interessante

- ai miglioramenti

- investimento

- Investitori

- investe

- problema

- sicurezza

- IT

- Italia

- SUO

- Dipingere

- Cognome

- legislatori

- galline ovaiole

- portare

- principale

- apprendimento

- meno

- Legale

- azioni legali

- piace

- Limitato

- Lives

- locale

- logica

- macchina

- machine learning

- fatto

- make

- Fare

- modo

- molti

- Rappresentanza

- previsioni di mercato

- Marketing

- matematico

- Maggio..

- analisi

- medicale

- dati medici

- medicina

- Metodologia

- forza

- minimo

- Ridurre la perdita dienergia con una

- modelli

- Monitorare

- Mese

- Scopri di più

- Inoltre

- maggior parte

- in movimento

- molti

- multiplo

- necessariamente

- Bisogno

- reti

- reti neurali

- tuttavia

- New

- no

- nodi

- notevole

- Nozione

- romanzo

- novità

- adesso

- of

- MENO

- offerta

- di frequente

- on

- una volta

- opaco

- open source

- Apertura

- operare

- or

- nostro

- complessivo

- pagato

- paradigma

- parte

- particolarmente

- paziente

- pazienti

- modelli

- Persone

- Eseguire

- Personalizzata

- posto

- piattaforma

- Piattaforme

- Platone

- Platone Data Intelligence

- PlatoneDati

- Giocare

- politici

- politico

- Popolare

- popolarità

- possibilità

- potenziale

- potenzialmente

- potente

- Pratico

- pratiche

- Previsioni

- presenti

- regali

- atleta

- principalmente

- Privacy

- Problema

- problemi

- procedimento

- processi

- i processi

- lavorazione

- Prodotti

- promuoverlo

- promuovere

- protezione

- fornire

- provvisorio

- la percezione

- fiducia pubblica

- domanda

- Domande

- sollevato

- raccolta

- fondamento logico

- raggiungendo

- Realtà

- regno

- recente

- recentemente

- raccomandazioni

- per quanto riguarda

- Regolare

- Regolamento

- normativa

- Regolatori

- normativo

- relazionato

- Relazioni

- problemi di

- fare affidamento

- ripercussioni

- richiedere

- Requisiti

- riparazioni

- ricercatori

- responsabile

- colpevole

- curriculum vitae

- rivoluzionare

- rivoluziona

- diritti

- Rischio

- valutazione del rischio

- rischi

- robusto

- Ruolo

- norme

- garanzie

- Suddetto

- Sam

- Sam Altman

- punteggio

- problemi di

- Misure di sicurezza

- vedere

- Cercare

- Sensibilità

- Servizi

- Set

- mostrare attraverso le sue creazioni

- significativa

- significativamente

- semplicemente

- Scetticismo

- smart

- smart contract

- Smart Contract

- Soluzioni

- RISOLVERE

- sofisticato

- Fonte

- lo spazio

- specifico

- dividere

- Stabilità

- stakeholder

- stare in piedi

- si

- deriva

- Passi

- Ancora

- strategie

- Strategia

- snellire

- Lotta

- tale

- sospettoso

- sistema

- SISTEMI DI TRATTAMENTO

- Tandem

- task

- team

- Tech

- tecniche

- Tecnologie

- Tecnologia

- condizioni

- che

- I

- loro

- Li

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- a

- tokenizzazione

- Tokens

- Traccia

- Trading

- Strategie di Trading

- Le transazioni

- Trasformare

- trasformazioni

- Trasparenza

- trasparente

- trattamento

- Affidati ad

- affidabili sul mercato

- Verità

- seconda

- Tipi di

- Incertezza

- scoprire

- sottostante

- capire

- comprensibile

- e una comprensione reciproca

- unico

- su

- us

- uso

- Utente

- utenti

- utilità

- Prezioso

- vario

- Convalida

- Violazioni

- importantissima

- vulnerabilità

- Prima

- Web3

- quando

- quale

- volere

- con

- entro

- senza

- testimoniando

- wo

- Lavora

- lavorazioni

- anni

- zefiro