Le truffe su Internet potrebbero diventare molto più pericolose ora, grazie ai truffatori che hanno accesso senza ostacoli a ChatGPT, Techradar rapporti.

Il popolare chatbot basato sull'intelligenza artificiale, ChatGPT, continua a fare notizia. Con la sua capacità di scrivere qualsiasi cosa, dal debug del codice iframe al complesso codice di programmazione per computer, ChatGPT ha stabilito che l'AI sia la parola d'ordine tecnologica dell'anno.

Nonostante la sua enorme popolarità e impegno, ChatGPT ha suscitato preoccupazioni su etica e regolamentazione.

Leggi anche: Utenti ChatGPT 'Jailbreak' AI, Scatena Dan Alter Ego

Una recente rapporto pubblicato dai ricercatori di sicurezza informatica di Norton Labs, ha delineato tre modi principali in cui gli attori delle minacce potrebbero abusare di ChatGPT. Il rapporto ha indicato che ChatGPT potrebbe essere oggetto di abusi per realizzare truffe su Internet in modo più efficace: attraverso la generazione di contenuti deep-fake, la creazione di phishing e la creazione di malware.

"Norton Labs prevede che i truffatori stiano anche osservando le capacità di modelli linguistici di grandi dimensioni e testando modi per migliorare i loro crimini informatici per renderli più realistici e credibili", afferma il rapporto.

La capacità dello strumento di produrre "disinformazione o disinformazione di alta qualità su larga scala" potrebbe aiutare i bot farm a intensificare la discordia in modo più efficace. Ciò potrebbe consentire agli attori malintenzionati di "instillare dubbi e manipolare narrazioni in più lingue" senza sforzo, secondo Norton.

"Disinformazione" altamente convincente

Scrivere piani aziendali, strategie e descrizioni aziendali in modo convincente è un gioco da ragazzi per ChatGPT. Tuttavia, questo potenziale aumenta anche i rischi di disinformazione, che può trasformarsi in una truffa.

"Non solo il contenuto generato da ChatGPT a volte è involontariamente errato, ma un malintenzionato può anche utilizzare questi strumenti per creare intenzionalmente contenuti utilizzati per danneggiare le persone in qualche modo", afferma il rapporto.

La sua capacità di generare "disinformazione o disinformazione di alta qualità su larga scala potrebbe portare a sfiducia e dare forma a narrazioni in lingue diverse".

Scrivere recensioni sui prodotti è diventato sempre più facile con ChatGPT, che non può essere tracciato perché genera ogni volta risposte individuali con le stesse informazioni fornite. Nonostante la sua abilità, pone la sfida di "individuare recensioni false e prodotti scadenti".

È preoccupante che lo strumento possa essere utilizzato anche per il bullismo.

"L'uso di questi strumenti nelle campagne di molestie sui social media per mettere a tacere o intimidire le persone è anche un possibile risultato che avrebbe un effetto agghiacciante sulla parola", osserva il rapporto.

ChatGPT nelle campagne di phishing

ChatGPT è particolarmente bravo a generare testo dal suono umano in diverse lingue, con i lettori che non sanno se il testo è stato prodotto dall'intelligenza artificiale o dall'uomo. Anche OpenAI, lo sviluppatore di ChatGPT, non è in grado di identificare se un testo è stato scritto dall'IA, affermando che "è impossibile rilevare in modo affidabile tutto il testo scritto dall'IA".

La prospettiva che ChatGPT venga utilizzato nelle campagne di phishing è reale.

"Gli attori malintenzionati possono utilizzare ChatGPT per creare e-mail di phishing o post sui social media che sembrano provenire da fonti legittime, rendendo più difficile rilevare e difendersi da questo tipo di minacce", afferma il rapporto.

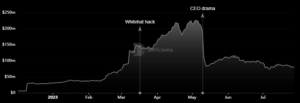

Con l'aumentare della sua popolarità, un probabile corollario è un aumento del numero di "campagne di phishing e della loro complessità".

Il rapporto ha suggerito che "gli attori malintenzionati possono alimentare ChatGPT con esempi di vita reale di messaggi non dannosi delle aziende che vogliono impersonare e ordinare all'intelligenza artificiale di crearne di nuovi basati sullo stesso stile con intenti dannosi".

Tali campagne potrebbero rivelarsi di grande successo nell'ingannare le persone a divulgare informazioni personali o inviare denaro a entità criminali. Norton Labs ha consigliato ai consumatori di essere cauti quando "fanno clic sui collegamenti o forniscono informazioni personali".

ChatGPT può creare malware

La generazione di codice e l'adattamento di diversi linguaggi di programmazione è semplicemente parte integrante dei servizi di ChatGPT. Quindi non c'è da meravigliarsi che i truffatori lo utilizzino per generare malware.

"Con il prompt giusto, gli autori di malware inesperti possono descrivere cosa vogliono fare e ottenere frammenti di codice funzionanti", secondo il rapporto. Ciò rappresenta una seria minaccia di attacchi di malware sufficientemente avanzati da provocare il caos.

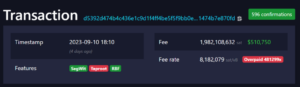

"Un esempio è generare codice per rilevare quando un indirizzo di portafoglio bitcoin viene copiato negli appunti in modo che possa essere sostituito con un indirizzo dannoso controllato dall'autore del malware", ha spiegato il rapporto.

Di conseguenza, la disponibilità di un tale chatbot causerà un aumento della sofisticatezza del malware.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://metanews.com/chatgpt-is-being-used-to-make-quality-scams/

- :È

- 7

- 8

- a

- capacità

- capace

- WRI

- abuso

- accesso

- Secondo

- attori

- indirizzo

- Avanzate

- contro

- AI

- AI-alimentato

- aiuto

- Tutti

- ed

- anticipando

- apparire

- SONO

- AS

- At

- attacchi

- autore

- gli autori

- disponibilità

- Vasca

- basato

- BE

- perché

- diventare

- essendo

- Bitcoin

- Bitcoin Wallet

- Bot

- bullismo

- affari

- by

- Responsabile Campagne

- Materiale

- non può

- funzionalità

- Ultra-Grande

- Causare

- cauto

- Challenge

- chatbot

- ChatGPT

- codice

- Aziende

- azienda

- complesso

- computer

- preoccupazioni

- Consumatori

- contenuto

- Generazione di contenuti

- continuamente

- controllata

- potuto

- artigianali

- creare

- creazione

- Azione Penale

- Cybersecurity

- Pericoloso

- descrivere

- Costruttori

- diverso

- difficile

- Divulgazione

- discordia

- Le disinformazioni sanitarie

- dubbio

- ogni

- effetto

- Efficace

- in maniera efficace

- enable

- Fidanzamento

- entità

- sviluppate

- etica

- Anche

- qualunque cosa

- esempio

- Esempi

- ha spiegato

- falso

- Farms

- Nel

- truffatori

- da

- generare

- generato

- genera

- la generazione di

- ELETTRICA

- ottenere

- buono

- Avere

- avendo

- Notizie

- vivamente

- Tuttavia

- HTTPS

- Enorme

- umano

- identificare

- impossibile

- in

- Aumento

- Aumenta

- sempre più

- indicato

- individuale

- individui

- informazioni

- intento

- apposta

- Internet

- IT

- SUO

- Le

- Labs

- Lingua

- Le Lingue

- grandi

- portare

- Vita

- Collegamento

- piccolo

- lotto

- make

- Fare

- il malware

- max-width

- Media

- messaggi

- forza

- Disinformazione

- sfiducia

- modelli

- soldi

- Scopri di più

- multiplo

- narrazione

- New

- Note

- novizio

- numero

- of

- on

- ONE

- OpenAI

- minimo

- Risultato

- parte

- particolarmente

- Persone

- cronologia

- phishing

- piani

- Platone

- Platone Data Intelligence

- PlatoneDati

- Giocare

- Gioca per

- Popolare

- popolarità

- pone

- possibile

- Post

- potenziale

- produrre

- Prodotto

- Prodotti

- Programmazione

- linguaggi di programmazione

- prospettiva

- Dimostra

- purché

- fornitura

- pubblicato

- Leggi

- lettori

- di rose

- vita reale

- realistico

- recente

- Regolamento

- sostituito

- rapporto

- ricercatori

- colpevole

- Recensioni

- rischi

- stesso

- Scala

- Truffa

- Truffatori

- truffe

- invio

- grave

- Servizi

- Forma

- Silenzio

- semplicemente

- So

- Social

- Social Media

- Post sui social media

- alcuni

- fonti

- discorso

- dispetto

- ha dichiarato

- strategie

- style

- di successo

- tale

- Tech

- Testing

- Grazie

- che

- Il

- loro

- Li

- Strumenti Bowman per analizzare le seguenti finiture:

- minaccia

- attori della minaccia

- minacce

- tre

- Attraverso

- tempo

- a

- strumenti

- TURNO

- Tipi di

- sguinzagliare

- uso

- utenti

- Portafoglio

- Modo..

- modi

- Che

- se

- quale

- ampiamente

- volere

- con

- lavoro

- sarebbe

- scrivere

- scritto

- zefiro