Nel dinamico mondo dello streaming Amazon Musica, ogni ricerca di un brano, un podcast o una playlist racchiude una storia, uno stato d'animo o un flusso di emozioni in attesa di essere svelato. Queste ricerche fungono da porta d'accesso a nuove scoperte, esperienze preziose e ricordi duraturi. La barra di ricerca non serve solo a trovare una canzone; si tratta di milioni di utenti attivi che iniziano il loro viaggio personale nel mondo ricco e diversificato che Amazon Music ha da offrire.

Offrire un'esperienza cliente superiore per trovare immediatamente la musica che gli utenti cercano richiede una piattaforma che sia intelligente e reattiva. Amazon Music utilizza la potenza dell'intelligenza artificiale per raggiungere questo obiettivo. Tuttavia, ottimizzare l'esperienza del cliente gestendo al tempo stesso i costi di formazione e inferenza dei modelli di intelligenza artificiale che alimentano le funzionalità della barra di ricerca, come il controllo ortografico in tempo reale e la ricerca vettoriale, è difficile durante le ore di punta del traffico.

Amazon Sage Maker fornisce una serie di servizi end-to-end che consentono ad Amazon Music di creare, addestrare e distribuire sul cloud AWS con il minimo sforzo. Prendendosi cura del lavoro pesante indifferenziato, SageMaker ti consente di concentrarti sul lavoro sui tuoi modelli di machine learning (ML) e di non preoccuparti di cose come l'infrastruttura. Nell'ambito del modello di responsabilità condivisa, SageMaker si assicura che i servizi forniti siano affidabili, performanti e scalabili, mentre tu ti assicuri che l'applicazione dei modelli ML utilizzi al meglio le funzionalità fornite da SageMaker.

In questo post, ripercorriamo il percorso intrapreso da Amazon Music per ottimizzare prestazioni e costi utilizzando SageMaker e NVIDIA Triton Inference Server e TensorRT. Ci immergiamo in profondità nel mostrare come funziona quella barra di ricerca apparentemente semplice, ma intricata, garantendo un viaggio ininterrotto nell'universo di Amazon Music con ritardi di battitura frustranti minimi o nulli e risultati di ricerca pertinenti in tempo reale.

Amazon SageMaker e NVIDIA: offrono funzionalità di ricerca vettoriale e controllo ortografico veloci e precise

Amazon Music offre una vasta libreria di oltre 100 milioni di brani e milioni di episodi di podcast. Tuttavia, trovare il brano o il podcast giusto può essere difficile, soprattutto se non conosci il titolo esatto, l'artista o il nome dell'album oppure se la query di ricerca è molto ampia, come "podcast di notizie".

Amazon Music ha adottato un duplice approccio per migliorare il processo di ricerca e recupero. Il primo passo è introdurre la ricerca vettoriale (nota anche come recupero basato sull'incorporamento), una tecnica ML che può aiutare gli utenti a trovare il contenuto più pertinente che stanno cercando utilizzando la semantica del contenuto. Il secondo passaggio prevede l'introduzione di un modello di correzione ortografica basato su Transformer nello stack di ricerca. Ciò può essere particolarmente utile durante la ricerca di musica, poiché gli utenti potrebbero non sempre conoscere l'ortografia esatta del titolo di un brano o del nome dell'artista. La correzione ortografica può aiutare gli utenti a trovare la musica che stanno cercando anche se commettono errori di ortografia nella query di ricerca.

L'introduzione di modelli Transformer in una pipeline di ricerca e recupero (nella generazione di incorporamento delle query necessaria per la ricerca vettoriale e nel modello generativo Seq2Seq Transformer nella correzione ortografica) può portare a un aumento significativo della latenza complessiva, incidendo negativamente sull'esperienza del cliente. Pertanto, è diventata una priorità assoluta per noi ottimizzare la latenza di inferenza in tempo reale per i modelli di ricerca vettoriale e di correzione ortografica.

Amazon Music e NVIDIA si sono uniti per offrire la migliore esperienza possibile al cliente nella barra di ricerca, utilizzando SageMaker per implementare funzionalità di controllo ortografico rapide e accurate e suggerimenti di ricerca semantica in tempo reale utilizzando tecniche basate sulla ricerca vettoriale. La soluzione include l'utilizzo dell'hosting SageMaker basato su istanze G5 che utilizzano GPU NVIDIA A10G Tensor Core, contenitore NVIDIA Triton Inference Server supportato da SageMaker e il NVIDIA TensorRT formato del modello. Riducendo la latenza di inferenza del modello di controllo ortografico a 25 millisecondi nei picchi di traffico e riducendo la latenza di generazione dell'incorporamento delle query di ricerca in media del 63% e i costi del 73% rispetto all'inferenza basata sulla CPU, Amazon Music ha aumentato le prestazioni della barra di ricerca.

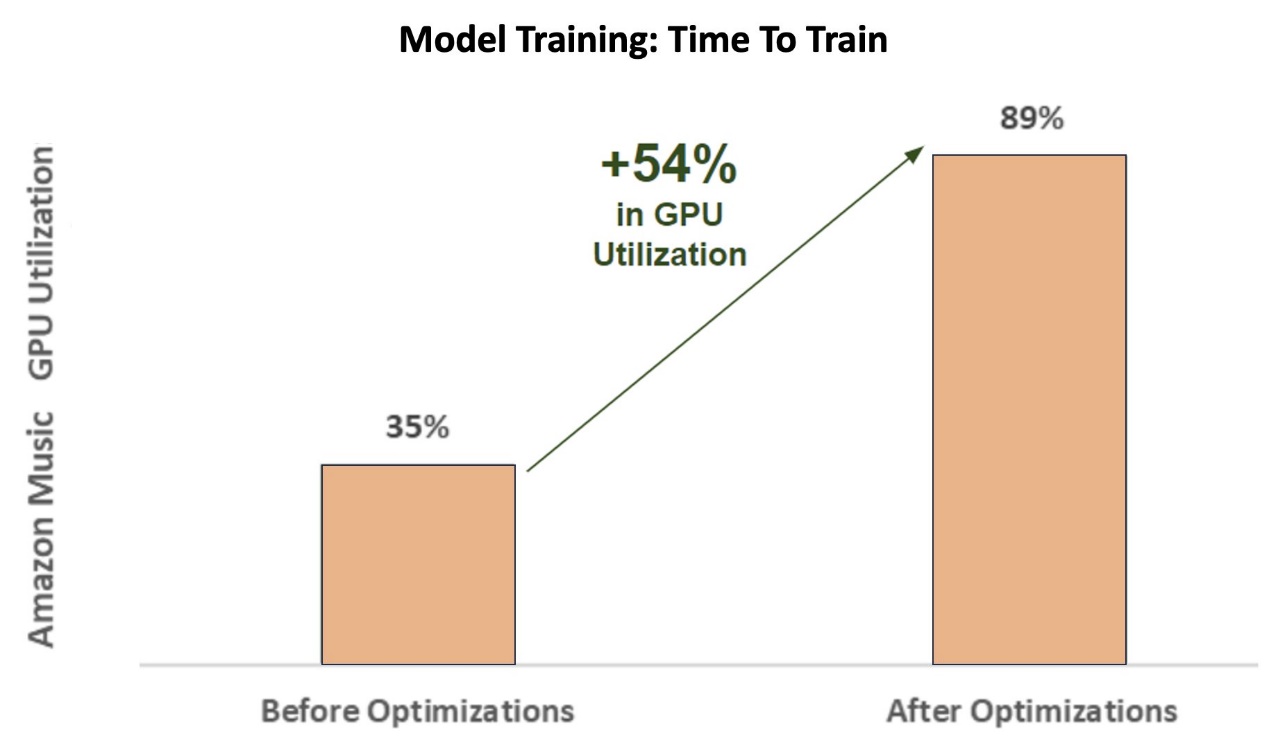

Inoltre, durante l'addestramento del modello AI per fornire risultati accurati, Amazon Music ha ottenuto un'enorme accelerazione di 12 volte nel tempo di addestramento per il modello di trasformatore di correzione ortografica sequenza per sequenza BART, risparmiando tempo e denaro, ottimizzando l'utilizzo della GPU.

Amazon Music ha collaborato con NVIDIA per dare priorità all'esperienza di ricerca dei clienti e creare una barra di ricerca con funzionalità di controllo ortografico e ricerca vettoriale ben ottimizzate. Nelle sezioni seguenti, condivideremo ulteriori informazioni su come sono state orchestrate queste ottimizzazioni.

Ottimizzazione della formazione con le GPU NVIDIA Tensor Core

Ottenere l'accesso a una GPU NVIDIA Tensor Core per l'addestramento di modelli linguistici di grandi dimensioni non è sufficiente per catturarne il vero potenziale. Esistono passaggi chiave di ottimizzazione che devono essere eseguiti durante l'addestramento per massimizzare completamente l'utilizzo della GPU. Tuttavia, una GPU sottoutilizzata porterà senza dubbio a un uso inefficiente delle risorse, a durate di formazione prolungate e a maggiori costi operativi.

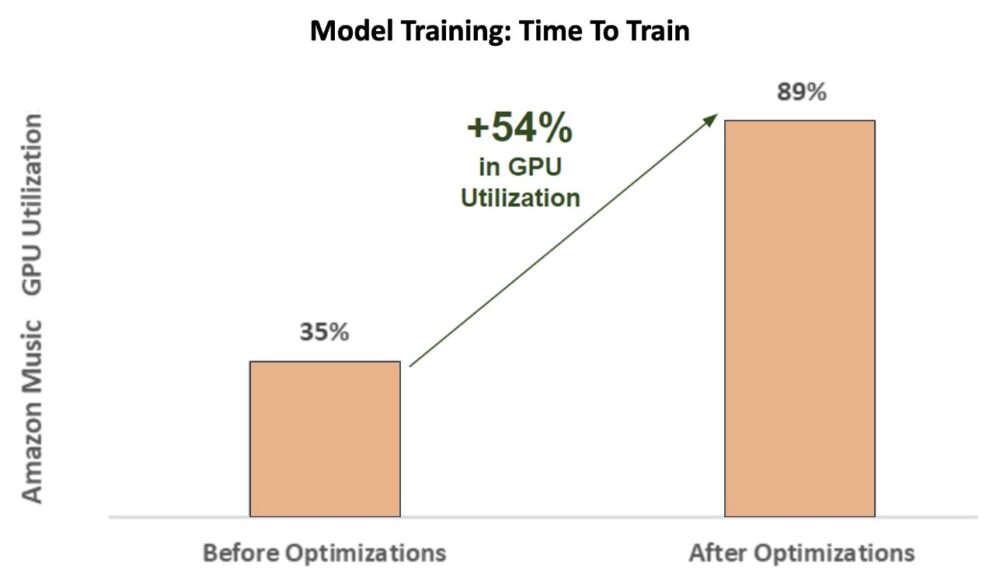

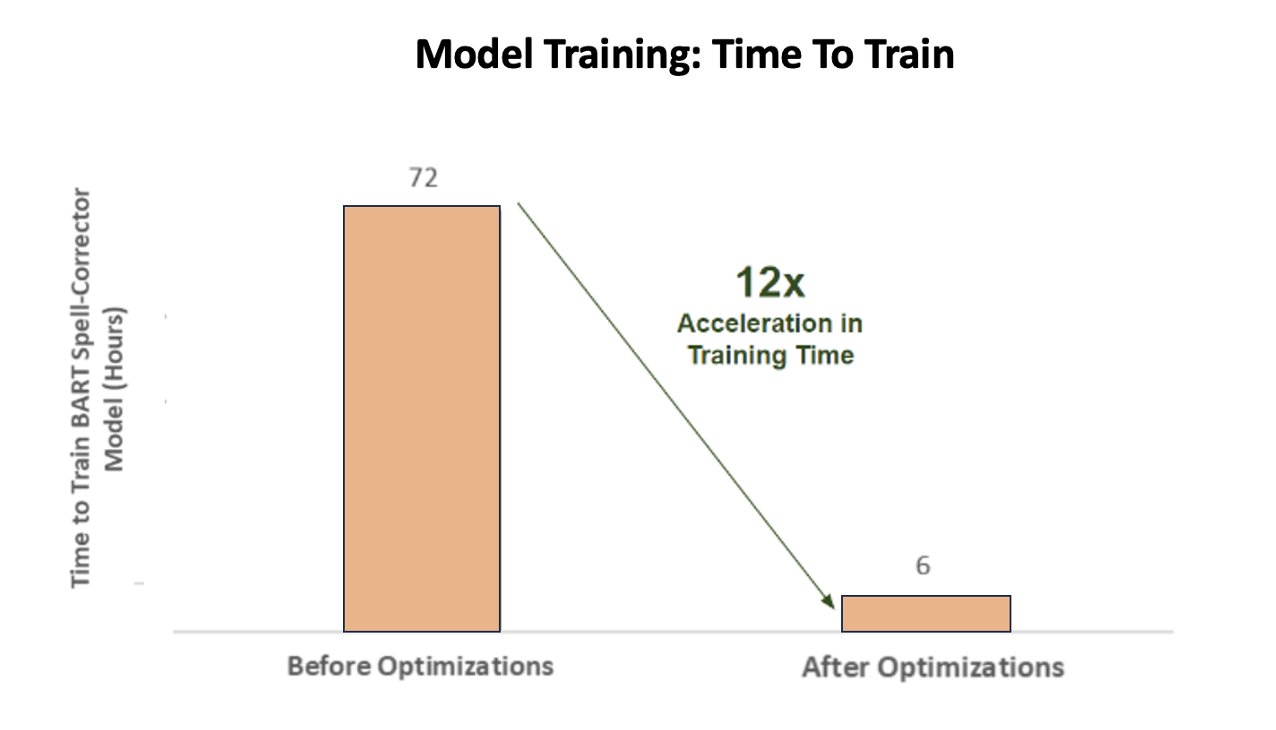

Durante le fasi iniziali dell'addestramento del correttore ortografico BART (bart-base) su un'istanza SageMaker ml.p3.24xlarge (8 GPU NVIDIA V100 Tensor Core), l'utilizzo della GPU di Amazon Music è stato di circa il 35%. Per massimizzare i vantaggi della formazione accelerata da GPU NVIDIA, gli architetti di soluzioni AWS e NVIDIA hanno supportato Amazon Music nell'identificazione delle aree di ottimizzazione, in particolare riguardo alle dimensioni del batch e ai parametri di precisione. Questi due parametri cruciali influenzano l’efficienza, la velocità e l’accuratezza dell’addestramento dei modelli di deep learning.

Le ottimizzazioni risultanti hanno prodotto un utilizzo nuovo e migliorato della GPU V100, stabile intorno all'89%, riducendo drasticamente il tempo di formazione di Amazon Music da 3 giorni a 5-6 ore. Cambiando la dimensione del batch da 32 a 256 e utilizzando tecniche di ottimizzazione come l'esecuzione allenamento automatico di precisione misto invece di utilizzare solo la precisione FP32, Amazon Music è stata in grado di risparmiare tempo e denaro.

Il grafico seguente illustra l'aumento del 54% in punti percentuali nell'utilizzo della GPU dopo le ottimizzazioni.

La figura seguente illustra l'accelerazione del tempo di addestramento.

Questo aumento delle dimensioni dei batch ha consentito alla GPU NVIDIA di elaborare una quantità significativamente maggiore di dati contemporaneamente su più Tensor Core, con conseguente accelerazione dei tempi di training. Tuttavia, è importante mantenere un delicato equilibrio con la memoria, poiché batch di dimensioni maggiori richiedono più memoria. Sia l'aumento delle dimensioni dei batch che l'impiego di precisione mista possono essere fondamentali per sfruttare la potenza delle GPU NVIDIA Tensor Core.

Dopo che il modello è stato addestrato alla convergenza, era giunto il momento di ottimizzare la distribuzione dell'inferenza sulla barra di ricerca di Amazon Music.

Correzione ortografica: inferenza del modello BART

Con l'aiuto delle istanze SageMaker G5 e di NVIDIA Triton Inference Server (un software di inferenza open source), nonché di NVIDIA TensorRT, un SDK per l'inferenza di deep learning ad alte prestazioni che include un ottimizzatore di inferenza e un runtime, Amazon Music limita il controllo ortografico BART (bart-base) modella la latenza di inferenza del server a soli 25 millisecondi nei picchi di traffico. Ciò include spese generali come bilanciamento del carico, preelaborazione, inferenza del modello e tempi di postelaborazione.

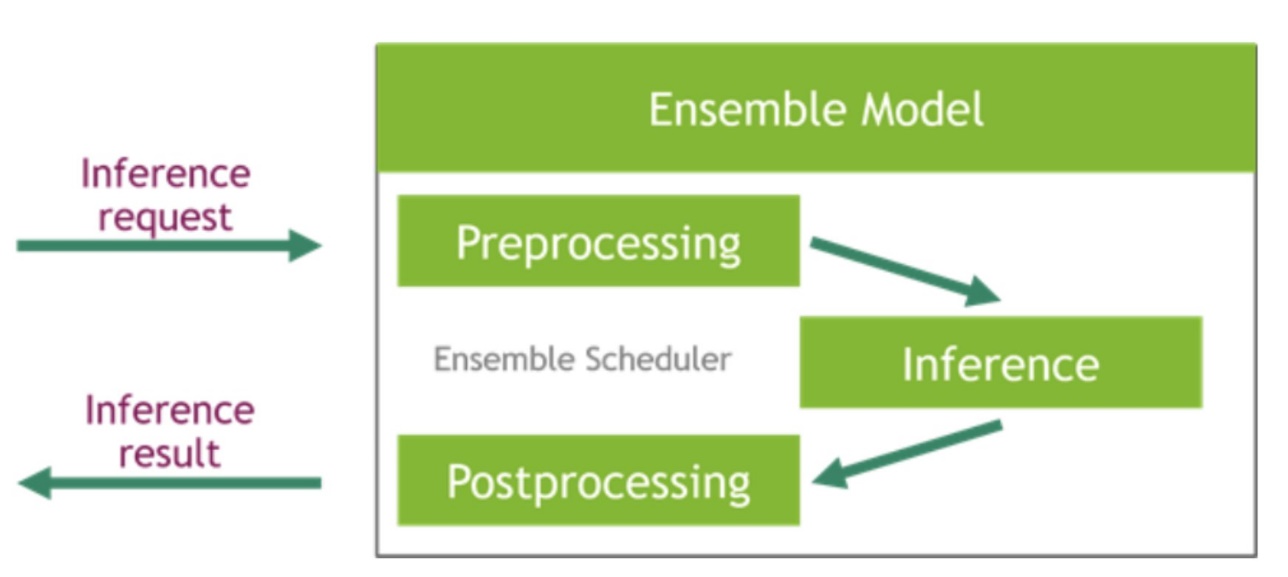

NVIDIA Triton Inference Server fornisce due diversi tipi di backend: uno per l'hosting di modelli su GPU e un backend Python in cui puoi portare il tuo codice personalizzato da utilizzare nelle fasi di preelaborazione e postelaborazione. La figura seguente illustra il schema di insieme del modello.

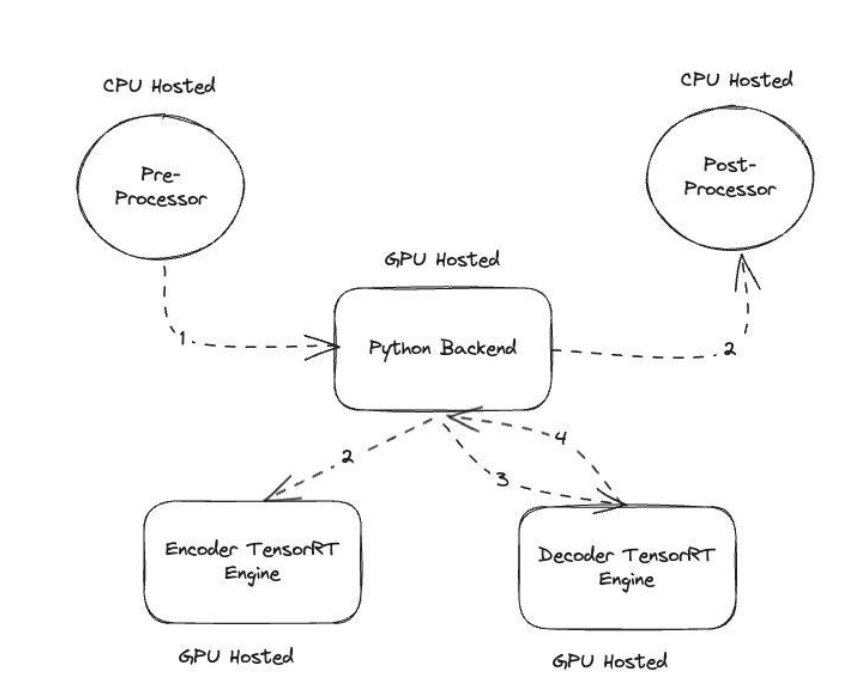

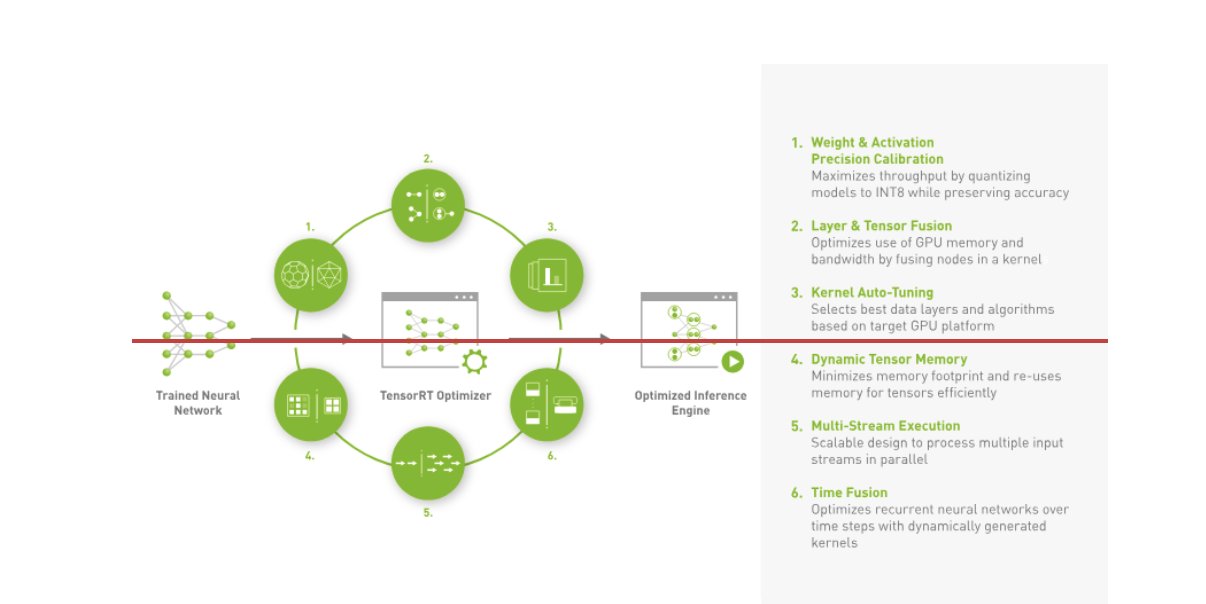

Amazon Music ha costruito il suo BART pipeline di inferenza eseguendo sia i passaggi di preelaborazione (tokenizzazione del testo) che quelli di postelaborazione (token in testo) sulle CPU, mentre il passaggio di esecuzione del modello viene eseguito su GPU NVIDIA A10G Tensor Core. Un backend Python si trova al centro delle fasi di preelaborazione e postelaborazione ed è responsabile della comunicazione con i modelli BART convertiti in TensorRT e con le reti codificatore/decodificatore. TensorRT migliora le prestazioni di inferenza con calibrazione di precisione, fusione di livelli e tensori, ottimizzazione automatica del kernel, memoria tensore dinamica, esecuzione multi-stream e fusione temporale.

La figura seguente illustra la progettazione di alto livello dei moduli chiave che compongono la pipeline di inferenza del modello BART del correttore ortografico.

Ricerca vettoriale: incorporamento di query, generazione di frasi, inferenza al modello BERT

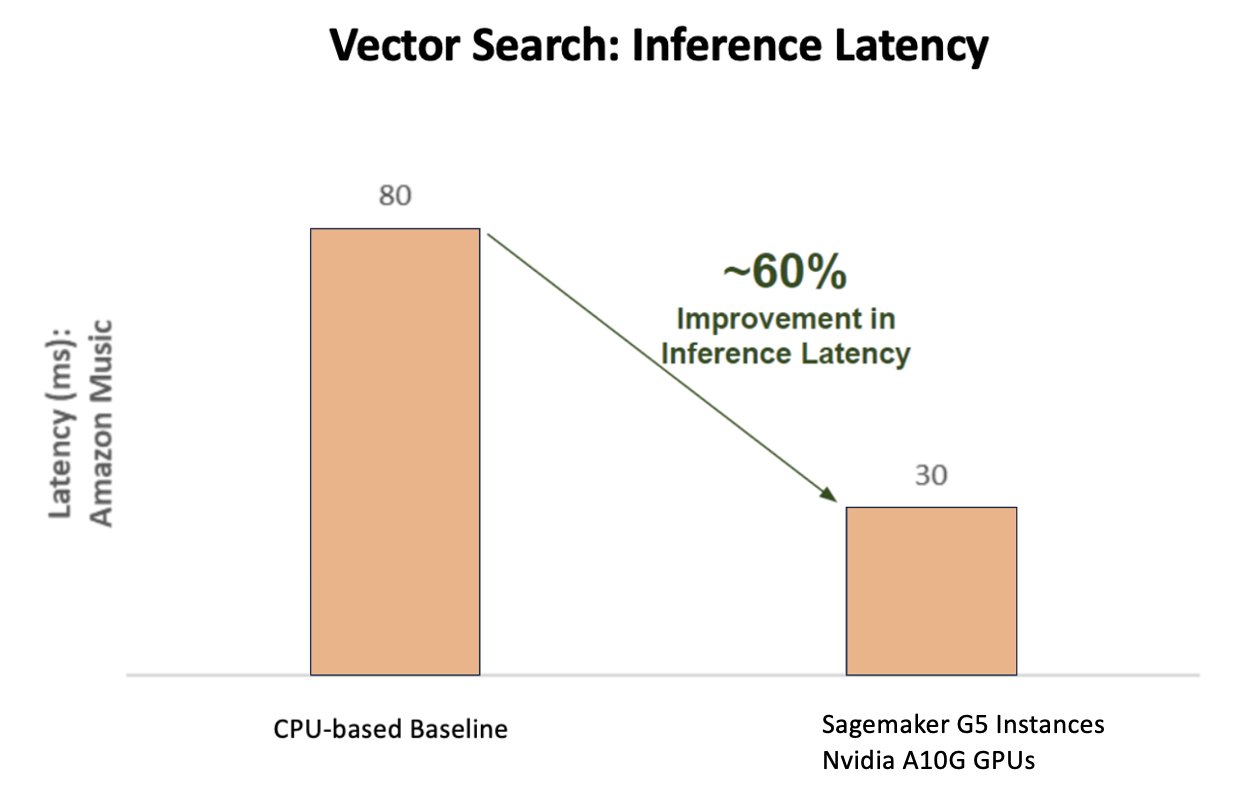

Il grafico seguente illustra il miglioramento del 60% della latenza (che serve p90 800–900 TPS) quando si utilizza la piattaforma di inferenza AI NVIDIA rispetto a una base di riferimento basata su CPU.

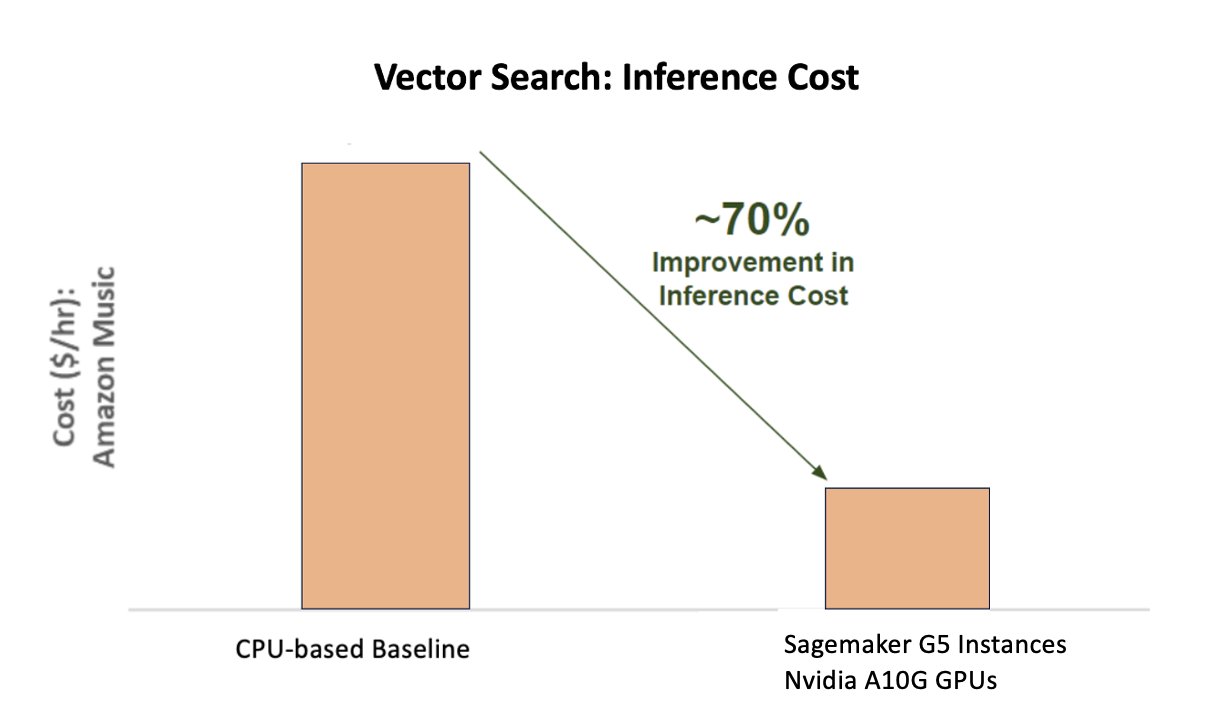

Il grafico seguente mostra un miglioramento del 70% dei costi quando si utilizza la piattaforma di inferenza AI NVIDIA rispetto a una base di riferimento basata su CPU.

La figura seguente illustra un SDK per l'inferenza di deep learning ad alte prestazioni. Include un ottimizzatore di inferenza e un runtime di deep learning che offrono bassa latenza e throughput elevato per le applicazioni di inferenza.

Per ottenere questi risultati, Amazon Music ha sperimentato diversi parametri di distribuzione Triton utilizzando Analizzatore del modello Triton, uno strumento che aiuta a trovare la migliore configurazione del modello NVIDIA Triton per implementare un'inferenza efficiente. Per ottimizzare l'inferenza del modello, Triton offre funzionalità come il batching dinamico e l'esecuzione simultanea del modello e dispone del supporto del framework per altre funzionalità di flessibilità. Il batching dinamico raccoglie le richieste di inferenza, raggruppandole perfettamente in coorti al fine di massimizzare il throughput, il tutto garantendo risposte in tempo reale per gli utenti di Amazon Music. La funzionalità di esecuzione simultanea del modello migliora ulteriormente le prestazioni di inferenza ospitando più copie del modello sulla stessa GPU. Infine, utilizzando Analizzatore del modello Triton, Amazon Music è riuscita a mettere a punto con attenzione il batching dinamico e i parametri di hosting dell'inferenza di concorrenza del modello per trovare impostazioni ottimali che massimizzino le prestazioni di inferenza utilizzando il traffico simulato.

Conclusione

L'ottimizzazione delle configurazioni con Triton Inference Server e TensorRT su SageMaker ha consentito ad Amazon Music di ottenere risultati eccezionali sia per le pipeline di training che per quelle di inferenza. La piattaforma SageMaker è la piattaforma aperta end-to-end per l'intelligenza artificiale di produzione, che offre un rapido time-to-value e la versatilità per supportare tutti i principali casi d'uso dell'intelligenza artificiale sia su hardware che su software. Ottimizzando l'utilizzo della GPU V100 per l'addestramento e il passaggio dalle CPU alle istanze G5 utilizzando le GPU NVIDIA A10G Tensor Core, nonché utilizzando software NVIDIA ottimizzato come Triton Inference Server e TensorRT, aziende come Amazon Music possono risparmiare tempo e denaro migliorando al tempo stesso le prestazioni in entrambi i casi. formazione e inferenza, che si traducono direttamente in una migliore esperienza del cliente e minori costi operativi.

SageMaker gestisce il lavoro pesante indifferenziato per la formazione e l'hosting ML, consentendo ad Amazon Music di fornire operazioni ML affidabili e scalabili sia su hardware che su software.

Ti invitiamo a verificare che i tuoi carichi di lavoro siano ottimizzati utilizzando SageMaker valutando sempre le tue scelte hardware e software per vedere se esistono modi per ottenere prestazioni migliori con costi ridotti.

Per ulteriori informazioni sull'intelligenza artificiale NVIDIA in AWS, fare riferimento a quanto segue:

Circa gli autori

Siddhart Sharma è un responsabile tecnico del machine learning presso il team Science & Modeling di Amazon Music. È specializzato in problemi di modellazione relativi alla ricerca, al recupero, al posizionamento e alla PNL. Siddharth ha una ricca esperienza di lavoro su problemi di machine learning su larga scala sensibili alla latenza, ad esempio targeting degli annunci, recupero multimodale, comprensione delle query di ricerca ecc. Prima di lavorare presso Amazon Music, Siddharth ha lavorato presso aziende come Meta, Walmart Labs, Rakuten sui problemi di ML incentrati sull'e-commerce. Siddharth ha trascorso la prima parte della sua carriera lavorando con startup ad-tech della Bay Area.

Siddhart Sharma è un responsabile tecnico del machine learning presso il team Science & Modeling di Amazon Music. È specializzato in problemi di modellazione relativi alla ricerca, al recupero, al posizionamento e alla PNL. Siddharth ha una ricca esperienza di lavoro su problemi di machine learning su larga scala sensibili alla latenza, ad esempio targeting degli annunci, recupero multimodale, comprensione delle query di ricerca ecc. Prima di lavorare presso Amazon Music, Siddharth ha lavorato presso aziende come Meta, Walmart Labs, Rakuten sui problemi di ML incentrati sull'e-commerce. Siddharth ha trascorso la prima parte della sua carriera lavorando con startup ad-tech della Bay Area.

TarunSharma è un responsabile dello sviluppo software che guida la rilevanza della ricerca musicale su Amazon. Il suo team di scienziati e ingegneri ML è responsabile di fornire risultati di ricerca contestualmente pertinenti e personalizzati ai clienti Amazon Music.

TarunSharma è un responsabile dello sviluppo software che guida la rilevanza della ricerca musicale su Amazon. Il suo team di scienziati e ingegneri ML è responsabile di fornire risultati di ricerca contestualmente pertinenti e personalizzati ai clienti Amazon Music.

James Park è un architetto di soluzioni presso Amazon Web Services. Collabora con Amazon.com per progettare, creare e distribuire soluzioni tecnologiche su AWS e ha un interesse particolare per l'intelligenza artificiale e il machine learning. Nel tempo libero ama scoprire nuove culture, nuove esperienze e tenersi aggiornato sulle ultime tendenze tecnologiche. Lo puoi trovare su LinkedIn.

James Park è un architetto di soluzioni presso Amazon Web Services. Collabora con Amazon.com per progettare, creare e distribuire soluzioni tecnologiche su AWS e ha un interesse particolare per l'intelligenza artificiale e il machine learning. Nel tempo libero ama scoprire nuove culture, nuove esperienze e tenersi aggiornato sulle ultime tendenze tecnologiche. Lo puoi trovare su LinkedIn.

Kshitiz Gupta è un architetto di soluzioni presso NVIDIA. Gli piace educare i clienti del cloud sulle tecnologie di intelligenza artificiale GPU che NVIDIA ha da offrire e assisterli nell'accelerazione delle loro applicazioni di machine learning e deep learning. Al di fuori del lavoro, gli piace correre, fare escursioni e osservare la fauna selvatica.

Kshitiz Gupta è un architetto di soluzioni presso NVIDIA. Gli piace educare i clienti del cloud sulle tecnologie di intelligenza artificiale GPU che NVIDIA ha da offrire e assisterli nell'accelerazione delle loro applicazioni di machine learning e deep learning. Al di fuori del lavoro, gli piace correre, fare escursioni e osservare la fauna selvatica.

Jiahong Liu è un Solution Architect nel team di Cloud Service Provider di NVIDIA. Assiste i clienti nell'adozione di soluzioni di apprendimento automatico e intelligenza artificiale che sfruttano l'informatica accelerata NVIDIA per affrontare le loro sfide di formazione e inferenza. Nel tempo libero ama gli origami, i progetti fai-da-te e gioca a basket.

Jiahong Liu è un Solution Architect nel team di Cloud Service Provider di NVIDIA. Assiste i clienti nell'adozione di soluzioni di apprendimento automatico e intelligenza artificiale che sfruttano l'informatica accelerata NVIDIA per affrontare le loro sfide di formazione e inferenza. Nel tempo libero ama gli origami, i progetti fai-da-te e gioca a basket.

Tugrul Konuk è un Senior Solution Architect presso NVIDIA, specializzato in formazione su larga scala, deep learning multimodale e calcolo scientifico ad alte prestazioni. Prima di NVIDIA, ha lavorato nel settore energetico, concentrandosi sullo sviluppo di algoritmi per l'imaging computazionale. Nell'ambito del suo dottorato di ricerca, ha lavorato sul deep learning basato sulla fisica per simulazioni numeriche su larga scala. Nel tempo libero gli piace leggere, suonare la chitarra e il pianoforte.

Tugrul Konuk è un Senior Solution Architect presso NVIDIA, specializzato in formazione su larga scala, deep learning multimodale e calcolo scientifico ad alte prestazioni. Prima di NVIDIA, ha lavorato nel settore energetico, concentrandosi sullo sviluppo di algoritmi per l'imaging computazionale. Nell'ambito del suo dottorato di ricerca, ha lavorato sul deep learning basato sulla fisica per simulazioni numeriche su larga scala. Nel tempo libero gli piace leggere, suonare la chitarra e il pianoforte.

Rohil Bhargava è un Product Marketing Manager presso NVIDIA, specializzato nella distribuzione di framework applicativi e SDK NVIDIA su piattaforme CSP specifiche.

Rohil Bhargava è un Product Marketing Manager presso NVIDIA, specializzato nella distribuzione di framework applicativi e SDK NVIDIA su piattaforme CSP specifiche.

Eliuth Triana Isaza è un Developer Relations Manager presso NVIDIA che consente agli esperti MLOps, DevOps, scienziati ed AWS di AI di Amazon di padroneggiare lo stack di elaborazione NVIDIA per accelerare e ottimizzare i modelli Generative AI Foundation che spaziano dalla cura dei dati, alla formazione su GPU, all'inferenza di modelli e alla distribuzione di produzione su istanze GPU di AWS . Inoltre, Eliuth è un appassionato ciclista di mountain bike, sciatore, tennis e giocatore di poker.

Eliuth Triana Isaza è un Developer Relations Manager presso NVIDIA che consente agli esperti MLOps, DevOps, scienziati ed AWS di AI di Amazon di padroneggiare lo stack di elaborazione NVIDIA per accelerare e ottimizzare i modelli Generative AI Foundation che spaziano dalla cura dei dati, alla formazione su GPU, all'inferenza di modelli e alla distribuzione di produzione su istanze GPU di AWS . Inoltre, Eliuth è un appassionato ciclista di mountain bike, sciatore, tennis e giocatore di poker.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :ha

- :È

- :non

- :Dove

- $ SU

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- capace

- WRI

- accelerata

- accelerando

- accelerazione

- accesso

- realizzare

- precisione

- preciso

- Raggiungere

- raggiunto

- operanti in

- attivo

- aggiunta

- indirizzo

- Adottando

- Ads - Annunci

- che interessano

- Dopo shavasana, sedersi in silenzio; saluti;

- AI

- Modelli AI

- casi d'uso ai

- Album

- Algoritmi

- Tutti

- consentire

- permesso

- Consentire

- consente

- anche

- sempre

- Amazon

- Amazon Web Services

- Amazon.com

- an

- ed

- Applicazioni

- applicazioni

- approccio

- architetti

- SONO

- RISERVATA

- aree

- in giro

- artista

- AS

- assistere

- assist

- At

- media

- AWS

- BACKEND

- Equilibrio

- bilanciamento

- bar

- basato

- Linea di base

- Pallacanestro

- Baia

- BE

- è diventato

- perché

- vantaggi

- MIGLIORE

- Meglio

- potenziamento

- aumenta

- entrambi

- portare

- ampio

- costruire

- costruito

- by

- Materiale

- funzionalità

- capacità

- catturare

- che

- Career

- attentamente

- casi

- sfide

- impegnativo

- Grafico

- dai un'occhiata

- amato

- scelte

- clienti

- Cloud

- codice

- COM

- Venire

- comunicare

- Aziende

- rispetto

- computazionale

- informatica

- concorrente

- Configurazione

- Contenitore

- contenuto

- Convergenza

- Nucleo

- Costo

- Costi

- artigianali

- critico

- cruciale

- CSP

- curation

- costume

- cliente

- esperienza del cliente

- Clienti

- dati

- Data

- Giorni

- diminuita

- deep

- apprendimento profondo

- ritardi

- consegnare

- consegna

- fornisce un monitoraggio

- Richiesta

- schierare

- distribuzione

- deployment

- Design

- Costruttori

- in via di sviluppo

- Mercato

- diverso

- difficile

- direttamente

- immersione

- paesaggio differenziato

- fai da te

- Dont

- drasticamente

- durante

- dinamico

- e

- e-commerce

- Presto

- educare

- efficienza

- efficiente

- sforzo

- elevata

- incorporamento

- emozioni

- impiegando

- che abilita

- abilitato

- incoraggiare

- da un capo all'altro

- energia

- Ingegneri

- Migliora

- abbastanza

- assicurando

- particolarmente

- eccetera

- la valutazione

- Anche

- Ogni

- esecuzione

- esperienza

- Esperienze

- esperti

- FAST

- Caratteristiche

- figura

- Infine

- Trovate

- ricerca

- Nome

- Flessibilità

- alluvione

- Focus

- concentrato

- messa a fuoco

- i seguenti

- Nel

- formato

- Fondazione

- Contesto

- quadri

- da

- frustrante

- completamente

- funzionalità

- ulteriormente

- fusione

- porta

- ELETTRICA

- generativo

- AI generativa

- GPU

- GPU

- Maniglie

- accadere

- Hardware

- Avere

- he

- pesante

- sollevamento pesante

- Aiuto

- utile

- aiuta

- Alta

- alto livello

- Alte prestazioni

- lui

- il suo

- detiene

- di hosting

- ORE

- Come

- Tuttavia

- HTML

- HTTPS

- identificazione

- if

- illustra

- Imaging

- realizzare

- importante

- competenze

- migliorata

- miglioramento

- in

- inclusi

- Aumento

- è aumentato

- crescente

- industria

- inefficiente

- influenza

- Infrastruttura

- inizialmente

- esempio

- immediatamente

- invece

- interesse

- ai miglioramenti

- introdurre

- l'introduzione di

- IT

- SUO

- viaggio

- jpg

- ad appena

- Le

- Genere

- Sapere

- conosciuto

- Labs

- Lingua

- grandi

- larga scala

- superiore, se assunto singolarmente.

- duraturo

- Latenza

- con i più recenti

- strato

- portare

- principale

- IMPARARE

- apprendimento

- Leva

- Biblioteca

- di sollevamento

- piace

- limiti

- caricare

- cerca

- Basso

- inferiore

- macchina

- machine learning

- mantenere

- maggiore

- make

- FA

- direttore

- gestione

- Marketing

- Mastercard

- Massimizzare

- Maggio..

- memorie

- Memorie

- Meta

- In mezzo

- milione

- milioni

- millisecondi

- minimo

- errore

- misto

- ML

- MLOp

- modello

- modellismo

- modelli

- moduli

- soldi

- Scopri di più

- maggior parte

- La Montagna

- Multi

- multiplo

- Musica

- devono obbligatoriamente:

- Nome

- di applicazione

- negativamente

- reti

- New

- nlp

- Nvidia

- of

- offrire

- Offerte

- on

- ONE

- esclusivamente

- aprire

- open source

- operativo

- operativa

- Operazioni

- ottimale

- ottimizzazione

- OTTIMIZZA

- ottimizzati

- ottimizzazione

- or

- orchestrato

- minimo

- Altro

- su

- al di fuori

- eccezionale

- ancora

- complessivo

- proprio

- parametri

- parte

- particolare

- particolarmente

- collaborato

- appassionato

- Corrente di

- percentuale

- performance

- cronologia

- Personalizzata

- phd

- conduttura

- piattaforma

- Piattaforme

- Platone

- Platone Data Intelligence

- PlatoneDati

- giocatore

- gioco

- Podcast

- Podcast

- punto

- poker

- possibile

- Post

- potenziale

- energia

- alimentato

- Precisione

- Precedente

- Dare priorità

- priorità

- problemi

- processi

- Prodotto

- Produzione

- progetti

- fornire

- fornitore

- fornisce

- fornitura

- Python

- Presto

- Posizione

- Lettura

- tempo reale

- riducendo

- riferimento

- relazionato

- relazioni

- rilevanza

- pertinente

- affidabile

- richieste

- richiede

- Risorse

- risposte

- responsabilità

- responsabile

- di risposta

- risultante

- Risultati

- Ricco

- destra

- running

- corre

- runtime

- sagemaker

- stesso

- Risparmi

- risparmio

- scalabile

- Scala

- Scienze

- scientifico

- scienziati

- sdk

- sdk

- senza soluzione di continuità

- Cerca

- Ricerche

- ricerca

- Secondo

- sezioni

- vedere

- cerca

- apparentemente

- semantica

- anziano

- delicata

- condanna

- servire

- server

- servizio

- Provider di servizi

- Servizi

- servizio

- set

- impostazioni

- alcuni

- Condividi

- condiviso

- Spettacoli

- significativa

- significativamente

- Un'espansione

- siede

- Taglia

- Dimensioni

- smart

- Software

- lo sviluppo del software

- soluzione

- Soluzioni

- canzone

- Fonte

- tensione

- specializzata

- specializzata

- specifico

- velocità

- SILLABARE

- ortografia

- esaurito

- pila

- Di partenza

- Startup

- soggiorno

- costante

- step

- Passi

- Storia

- Streaming

- tale

- superiore

- supporto

- supportato

- sicuro

- preso

- presa

- mira

- team

- Tech

- Consulenza

- per l'esame

- tecniche

- Tecnologie

- Tecnologia

- testo

- che

- Il

- loro

- Li

- Là.

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cose

- questo

- Attraverso

- portata

- tempo

- volte

- Titolo

- a

- insieme

- tokenizzazione

- Tokens

- ha preso

- top

- tps

- traffico

- Treni

- allenato

- Training

- trasformatore

- tendenze

- tritone

- vero

- seconda

- e una comprensione reciproca

- indubbiamente

- Universo

- sblocco

- svelato

- us

- uso

- utilizzato

- utenti

- usa

- utilizzando

- Utilizzando

- APPREZZIAMO

- Fisso

- versatilità

- molto

- In attesa

- camminare

- Walmart

- Prima

- guardare

- modi

- we

- sito web

- servizi web

- WELL

- sono stati

- quando

- mentre

- while

- volere

- con

- Lavora

- lavorato

- lavoro

- lavori

- mondo

- preoccuparsi

- ancora

- dato

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro