Nel perseguimento della nostra missione, ci impegniamo a garantire che l'accesso, i benefici e l'influenza su AI e AGI siano diffusi. Riteniamo che siano necessari almeno tre elementi costitutivi per raggiungere questi obiettivi nel contesto del comportamento del sistema di intelligenza artificiale.[^ambito]

1. Migliora il comportamento predefinito. Vogliamo che il maggior numero possibile di utenti trovi i nostri sistemi di intelligenza artificiale utili per loro "out of the box" e senta che la nostra tecnologia comprende e rispetta i loro valori.

A tal fine, stiamo investendo nella ricerca e nell'ingegneria per ridurre i pregiudizi evidenti e sottili nel modo in cui ChatGPT risponde ai diversi input. In alcuni casi ChatGPT attualmente rifiuta gli output che non dovrebbe e, in alcuni casi, non rifiuta quando dovrebbe. Crediamo che il miglioramento in entrambi gli aspetti sia possibile.

Inoltre, abbiamo margini di miglioramento in altre dimensioni del comportamento del sistema, come il sistema che "inventa le cose". Il feedback degli utenti è prezioso per apportare questi miglioramenti.

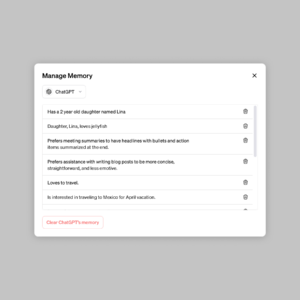

2. Definisci i valori della tua IA, entro ampi limiti. Crediamo che l'IA debba essere uno strumento utile per le singole persone, e quindi personalizzabile da ciascun utente fino ai limiti definiti dalla società. Pertanto, stiamo sviluppando un aggiornamento a ChatGPT per consentire agli utenti di personalizzarne facilmente il comportamento.

Ciò significherà consentire output di sistema con cui altre persone (noi compresi) potrebbero essere fortemente in disaccordo. Trovare il giusto equilibrio qui sarà impegnativo: portare la personalizzazione all'estremo rischierebbe di abilitare usi dannosi della nostra tecnologia e delle IA adulatrici che amplificano insensatamente le convinzioni esistenti delle persone.

Ci saranno quindi sempre dei limiti al comportamento del sistema. La sfida è definire quali sono questi limiti. Se proviamo a prendere tutte queste decisioni da soli, o se proviamo a sviluppare un unico sistema di IA monolitico, falliremo nell'impegno che prendiamo nella nostra Carta di "evitare un'indebita concentrazione di potere".

3. Input pubblico su valori predefiniti e hard bound. Un modo per evitare un'indebita concentrazione di potere è dare alle persone che utilizzano o sono influenzate da sistemi come ChatGPT la possibilità di influenzare le regole di tali sistemi.

Riteniamo che molte decisioni sulle nostre inadempienze e limiti rigidi debbano essere prese collettivamente e, sebbene l'implementazione pratica sia una sfida, miriamo a includere quante più prospettive possibili. Come punto di partenza, abbiamo cercato input esterni sulla nostra tecnologia sotto forma di squadra rossa. Abbiamo anche iniziato di recente sollecitare il contributo del pubblico sull'intelligenza artificiale nell'istruzione (un contesto particolarmente importante in cui viene impiegata la nostra tecnologia).

Siamo nelle prime fasi degli sforzi pilota per sollecitare il contributo del pubblico su argomenti come il comportamento del sistema, i meccanismi di divulgazione (come il watermarking) e le nostre politiche di implementazione più in generale. Stiamo inoltre esplorando partnership con organizzazioni esterne per condurre audit di terze parti sui nostri sforzi in materia di sicurezza e policy.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://openai.com/blog/how-should-ai-systems-behave

- :È

- $ SU

- 1

- a

- capacità

- WRI

- accesso

- Raggiungere

- AGI

- AI

- Tutti

- Consentire

- sempre

- ed

- SONO

- AS

- At

- audit

- Equilibrio

- BE

- CREDIAMO

- vantaggi

- Blocchi

- ampio

- in linea di massima

- Costruzione

- by

- casi

- Challenge

- ChatGPT

- collettivamente

- impegno

- impegnata

- concentrazione

- Segui il codice di Condotta

- contesto

- Attualmente

- personalizzabile

- personalizzazione

- personalizzare

- decide

- decisioni

- Predefinito

- defaults

- definito

- definizione

- schierato

- deployment

- sviluppare

- in via di sviluppo

- diverso

- dimensioni

- Rivelazione

- non

- ogni

- Presto

- facilmente

- Istruzione

- sforzi

- Ingegneria

- assicurando

- errore

- Esplorare

- esterno

- estremo

- feedback

- Trovate

- Nel

- modulo

- da

- Dare

- Obiettivi

- Hard

- Avere

- qui

- Come

- HTTPS

- implementazione

- importante

- competenze

- miglioramento

- miglioramenti

- in

- In altre

- includere

- incluso

- individuale

- influenza

- ingresso

- inestimabile

- investire

- IT

- piace

- limiti

- fatto

- make

- Fare

- molti

- Missione

- Monolitico

- Scopri di più

- of

- on

- ONE

- OpenAI

- minimo

- organizzazioni

- Altro

- proprio

- particolarmente

- partnership

- Persone

- persone

- prospettive

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- Termini e Condizioni

- possibile

- energia

- Pratico

- la percezione

- recentemente

- ridurre

- necessario

- riparazioni

- Rischio

- Prenotazione sale

- norme

- Sicurezza

- dovrebbero

- singolo

- Società

- alcuni

- tappe

- Di partenza

- fortemente

- tale

- sistema

- SISTEMI DI TRATTAMENTO

- Tecnologia

- che

- Il

- Li

- perciò

- Strumenti Bowman per analizzare le seguenti finiture:

- cose

- di parti terze standard

- tre

- a

- Argomenti

- capisce

- upgrade

- uso

- Utente

- utenti

- Valori

- Modo..

- Che

- quale

- while

- OMS

- molto diffuso

- volere

- con

- entro

- sarebbe

- Trasferimento da aeroporto a Sharm

- zefiro