I ricercatori di OpenAI, Università di Cambridge, Università di Harvard e Università di Toronto hanno offerto un approccio “esplorativo” idee su come regolare i chip e l'hardware dell'intelligenza artificialee in che modo le politiche di sicurezza potrebbero prevenire l’abuso dell’intelligenza artificiale avanzata.

Le raccomandazioni forniscono modalità per misurare e verificare lo sviluppo e l’uso di sistemi di intelligenza artificiale avanzati e dei chip che li alimentano. Le raccomandazioni per l’applicazione delle policy includono la limitazione delle prestazioni dei sistemi e l’implementazione di funzionalità di sicurezza che possono disabilitare da remoto i chip non autorizzati.

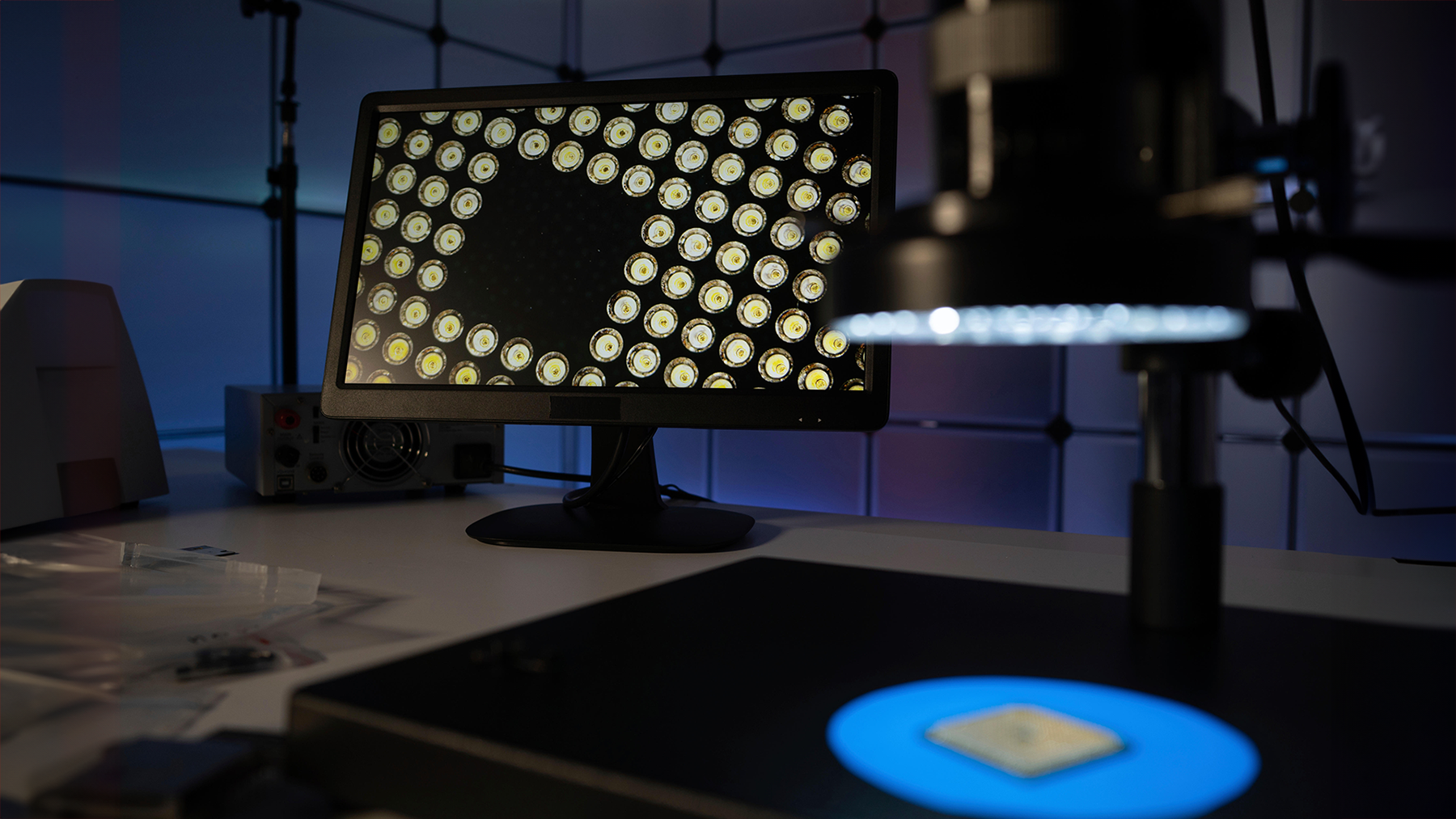

“L’addestramento di sistemi di intelligenza artificiale altamente capaci attualmente richiede l’accumulo e l’orchestrazione di migliaia di chip di intelligenza artificiale”, hanno scritto i ricercatori. “[Se] questi sistemi sono potenzialmente pericolosi, limitare questa potenza di calcolo accumulata potrebbe servire a limitare la produzione di sistemi di intelligenza artificiale potenzialmente pericolosi”.

I governi si sono concentrati in gran parte sul software per le politiche sull’intelligenza artificiale, e il documento è un complemento che copre il lato hardware del dibattito, afferma Nathan Brookwood, principale analista di Insight 64.

Tuttavia, avverte, l’industria non accoglierà con favore alcuna funzionalità di sicurezza che influenzi le prestazioni dell’intelligenza artificiale. Rendere l'intelligenza artificiale sicura attraverso l'hardware “è un'aspirazione nobile, ma non vedo nessuno che ce la faccia. Il genio è uscito dalla lampada e buona fortuna per farlo rientrare", dice.

Limitazione delle connessioni tra cluster

Una delle proposte suggerite dai ricercatori è un limite per limitare la capacità di elaborazione di calcolo disponibile per i modelli di intelligenza artificiale. L’idea è quella di mettere in atto misure di sicurezza in grado di identificare l’abuso dei sistemi di intelligenza artificiale e di interrompere e limitare l’uso dei chip.

Nello specifico, suggeriscono un approccio mirato per limitare la larghezza di banda tra memoria e cluster di chip. L’alternativa più semplice, ovvero impedire l’accesso ai chip, non era l’ideale in quanto avrebbe influenzato le prestazioni complessive dell’intelligenza artificiale, hanno scritto i ricercatori.

Il documento non suggerisce modi per implementare tali barriere di sicurezza o come rilevare l’abuso dei sistemi di intelligenza artificiale.

"Determinare il limite di larghezza di banda ottimale per la comunicazione esterna è un'area che merita ulteriori ricerche", hanno scritto i ricercatori.

I sistemi di intelligenza artificiale su larga scala richiedono un’enorme larghezza di banda di rete e i sistemi di intelligenza artificiale come Eagle di Microsoft ed Eos di Nvidia sono tra i più popolari. i 10 supercomputer più veloci al mondo. Esistono modi per limitare le prestazioni di rete per i dispositivi che supportano il linguaggio di programmazione P4, che può analizzare il traffico di rete e riconfigurare router e switch.

Ma buona fortuna se si chiede ai produttori di chip di implementare meccanismi di sicurezza dell’intelligenza artificiale che potrebbero rallentare chip e reti, afferma Brookwood.

“Arm, Intel e AMD sono tutti impegnati a costruire i chip più veloci e più scadenti che possano costruire per essere competitivi. Non so come puoi rallentare", dice.

Le possibilità remote comportano alcuni rischi

I ricercatori hanno anche suggerito di disabilitare i chip da remoto, cosa che Intel ha integrato nei suoi chip per server più recenti. La funzionalità On Demand è un servizio in abbonamento che consentirà ai clienti Intel di attivare e disattivare funzionalità su chip come le estensioni AI come sedili riscaldati in una Tesla.

I ricercatori hanno anche suggerito uno schema di attestazione in cui i chip consentono solo alle parti autorizzate di accedere ai sistemi di intelligenza artificiale tramite certificati digitali firmati crittograficamente. Il firmware potrebbe fornire linee guida sugli utenti e sulle applicazioni autorizzati, che potrebbero essere modificate con gli aggiornamenti.

Anche se i ricercatori non hanno fornito raccomandazioni tecniche su come farlo, l’idea è simile a come l’informatica riservata protegge le applicazioni sui chip tramite attestante gli utenti autorizzati. Intel ed AMD dispongono di computer confidenziali sui propri chip, ma siamo ancora agli inizi per la tecnologia emergente.

Ci sono anche rischi nell’applicare le politiche da remoto. “I meccanismi di applicazione remota presentano notevoli svantaggi e possono essere giustificati solo se il danno atteso dall’intelligenza artificiale è estremamente elevato”, hanno scritto i ricercatori.

Brookwood è d'accordo.

“Anche se potessi, ci saranno dei cattivi che lo perseguiranno. Mettere vincoli artificiali per i bravi ragazzi sarà inefficace”, dice.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.darkreading.com/cyber-risk/what-using-security-to-regulate-ai-chips-could-look-like

- :ha

- :È

- :non

- :Dove

- 10

- 7

- a

- abuso

- AC

- accesso

- Accumulato

- Avanzate

- influenzare

- concorda

- AI

- Modelli AI

- Sistemi di intelligenza artificiale

- Tutti

- consentire

- anche

- alternativa

- AMD

- tra

- an

- analista

- analizzare

- ed

- in qualsiasi

- applicazioni

- approccio

- SONO

- RISERVATA

- ARM

- artificiale

- AS

- chiedendo

- aspirazione

- revisione

- autorizzato

- disponibile

- precedente

- Vasca

- Larghezza di banda

- BE

- fra

- costruire

- Costruzione

- costruito

- occupato

- ma

- by

- cambridge

- Materiale

- berretto

- capace

- Ultra-Grande

- trasportare

- certificato

- cambiato

- patata fritta

- Chips

- Venire

- Comunicazione

- compagno

- competitivo

- Calcolare

- informatica

- potenza di calcolo

- riservato

- Connessioni

- vincoli

- potuto

- copertura

- crittograficamente

- Attualmente

- Clienti

- taglio

- taglio

- Pericoloso

- Giorni

- dibattito

- Richiesta

- rilevato

- determinazione

- Mercato

- dispositivi

- DID

- digitale

- do

- don

- fatto

- giù

- aspetti negativi

- aquila

- Presto

- più facile

- emergenti del mondo

- Tecnologia emergente

- applicazione

- far rispettare

- EOS

- Anche

- esistere

- previsto

- estensioni

- esterno

- estremamente

- più veloce

- caratteristica

- Caratteristiche

- concentrato

- Nel

- da

- ulteriormente

- Genio

- ottenere

- andando

- buono

- linee guida

- Hardware

- nuocere

- harvard

- Università di Harvard

- Avere

- he

- Alta

- vivamente

- Come

- Tutorial

- HTTPS

- i

- idea

- ideale

- identificare

- if

- realizzare

- Implementazione

- in

- includere

- industria

- intuizione

- Intel

- ai miglioramenti

- IT

- SUO

- Sapere

- Lingua

- maggiormente

- piace

- LIMITE

- limitativo

- Guarda

- una

- fortuna

- Makers

- Fare

- Maggio..

- misurare

- analisi

- meccanismi di

- Memorie

- meriti

- Microsoft

- modelli

- Rete

- traffico di rete

- reti

- Nuovi Arrivi

- Nobile

- Nvidia

- of

- MENO

- offerto

- on

- ONE

- esclusivamente

- OpenAI

- ottimale

- or

- orchestrare

- su

- complessivo

- Carta

- parti

- performance

- pezzo

- posto

- Platone

- Platone Data Intelligence

- PlatoneDati

- Termini e Condizioni

- politica

- possibilità

- potenzialmente

- energia

- prevenire

- Direttore

- lavorazione

- Produzione

- Programmazione

- proposte

- fornire

- perseguire

- metti

- Mettendo

- raccomandazioni

- Regolare

- a distanza

- da remoto

- richiede

- riparazioni

- ricercatori

- Rischio

- rischi

- s

- sicura

- dice

- schema

- Protegge

- problemi di

- Misure di sicurezza

- politiche di sicurezza

- vedere

- servire

- server

- servizio

- lato

- firmato

- significativa

- simile

- rallentare

- Software

- alcuni

- qualcosa

- Sponsored

- Ancora

- sottoscrizione

- tale

- suggerire

- Supporto

- SISTEMI DI TRATTAMENTO

- mirata

- Consulenza

- Tecnologia

- che

- Il

- loro

- Li

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- quelli

- migliaia

- Attraverso

- a

- toronto

- traffico

- Training

- enorme

- TURNO

- Università

- Aggiornamenti

- uso

- utenti

- utilizzando

- via

- avverte

- modi

- il benvenuto

- Che

- quale

- OMS

- volere

- con

- sarebbe

- ha scritto

- ancora

- Tu

- zefiro