Le aziende cercano di sfruttare il potenziale del Machine Learning (ML) per risolvere problemi complessi e migliorare i risultati. Fino a poco tempo fa, la creazione e l'implementazione di modelli ML richiedevano livelli profondi di competenze tecniche e di codifica, tra cui l'ottimizzazione dei modelli ML e il mantenimento di pipeline operative. Dalla sua introduzione nel 2021, Tela di Amazon SageMaker ha consentito agli analisti aziendali di creare, distribuire e utilizzare una varietà di modelli ML, tra cui tabulari, visione artificiale ed elaborazione del linguaggio naturale, senza scrivere una riga di codice. Ciò ha accelerato la capacità delle aziende di applicare il machine learning a casi d’uso quali previsioni di serie temporali, previsione del tasso di abbandono dei clienti, analisi del sentiment, rilevamento di difetti industriali e molti altri.

Come annunciato il Ottobre 5, 2023, SageMaker Canvas ha ampliato il supporto dei modelli ai Foundation Model (FM), modelli linguistici di grandi dimensioni utilizzati per generare e riassumere i contenuti. Con il Uscita del 12 ottobre 2023, SageMaker Canvas consente agli utenti di porre domande e ottenere risposte basate sui dati aziendali. Ciò garantisce che i risultati siano specifici del contesto, aprendo ulteriori casi d'uso in cui è possibile applicare il machine learning senza codice per risolvere problemi aziendali. Ad esempio, i team aziendali ora possono formulare risposte coerenti con il vocabolario e i principi specifici di un'organizzazione e possono interrogare più rapidamente documenti lunghi per ottenere risposte specifiche e basate sui contenuti di tali documenti. Tutti questi contenuti vengono eseguiti in modo privato e sicuro, garantendo che tutti i dati sensibili siano accessibili con governance e protezioni adeguate.

Per iniziare, un amministratore cloud configura e popola Amazon Kendra indici con dati aziendali come origini dati per SageMaker Canvas. Gli utenti Canvas selezionano l'indice in cui si trovano i loro documenti e possono ideare, ricercare ed esplorare sapendo che l'output sarà sempre supportato dalle loro fonti di verità. SageMaker Canvas utilizza FM all'avanguardia da Roccia Amazzonica ed JumpStart di Amazon SageMaker. È possibile avviare conversazioni con più FM fianco a fianco, confrontando i risultati e rendendo l'intelligenza artificiale generativa davvero accessibile a tutti.

In questo post esamineremo la funzionalità rilasciata di recente, discuteremo l'architettura e presenteremo una guida passo passo per consentire a SageMaker Canvas di eseguire query sui documenti della tua knowledge base, come mostrato nella seguente schermata.

Panoramica della soluzione

I modelli di base possono produrre allucinazioni: risposte generiche, vaghe, non correlate o sostanzialmente errate. Recupero della generazione aumentata (RAG) è un approccio utilizzato frequentemente per ridurre le allucinazioni. Le architetture RAG vengono utilizzate per recuperare dati dall'esterno di un FM, che vengono poi utilizzati per eseguire l'apprendimento in contesto per rispondere alla query dell'utente. Ciò garantisce che il FM possa utilizzare i dati di una base di conoscenza affidabile e utilizzare tale conoscenza per rispondere alle domande degli utenti, riducendo il rischio di allucinazioni.

Con RAG, i dati esterni a FM e utilizzati per aumentare i prompt degli utenti possono provenire da più origini dati disparate, come repository di documenti, database o API. Il primo passo è convertire i tuoi documenti e qualsiasi query dell'utente in un formato compatibile per eseguire la ricerca semantica di pertinenza. Per rendere compatibili i formati, una raccolta di documenti o libreria di conoscenze e le query inviate dagli utenti vengono convertite in rappresentazioni numeriche utilizzando modelli di incorporamento.

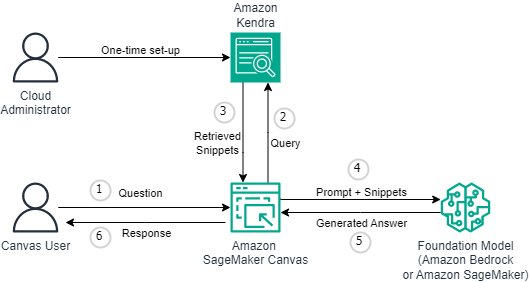

Con questa versione, la funzionalità RAG viene fornita senza codice e senza interruzioni. Le aziende possono arricchire l'esperienza di chat in Canvas con Amazon Kendra come sistema di gestione della conoscenza sottostante. Il diagramma seguente illustra l'architettura della soluzione.

La connessione di SageMaker Canvas ad Amazon Kendra richiede una configurazione una tantum. Descriviamo il processo di configurazione in dettaglio in Configurazione di Canvas per interrogare i documenti. Se non hai già configurato il tuo dominio SageMaker, fai riferimento a Integrazione nel dominio Amazon SageMaker.

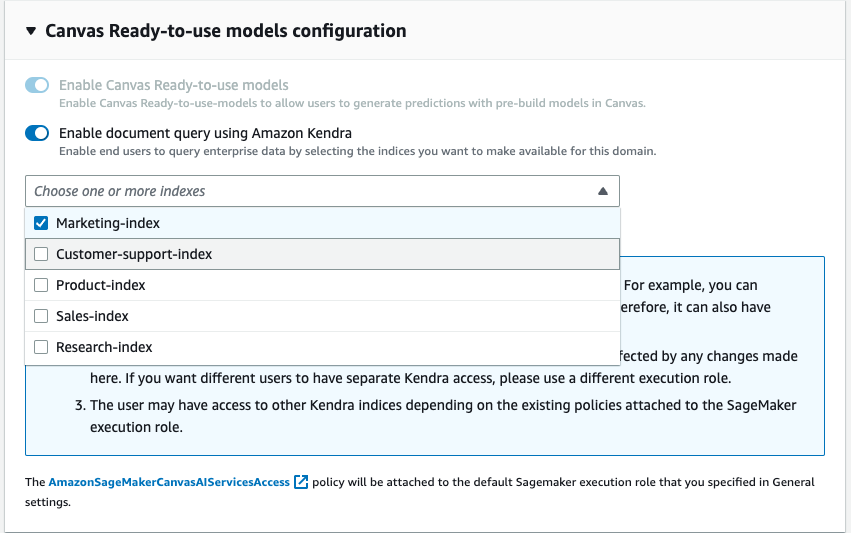

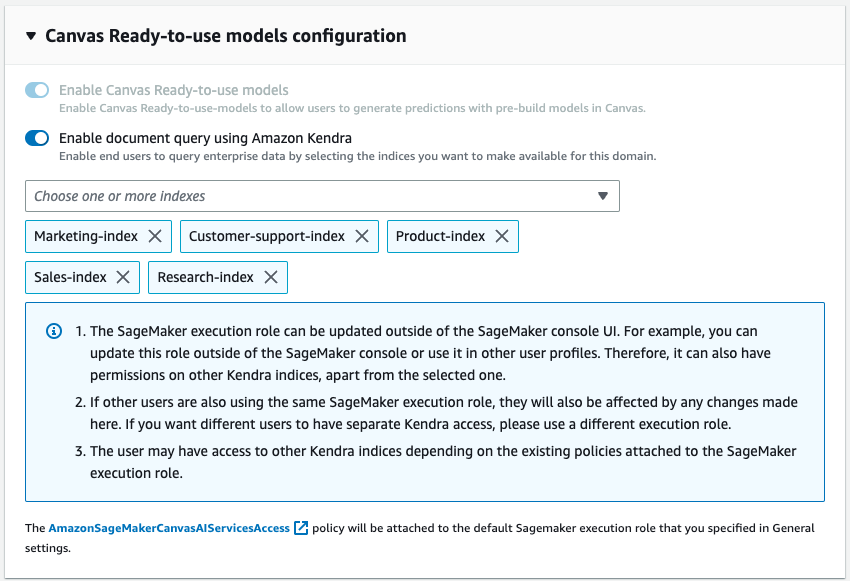

Come parte della configurazione del dominio, un amministratore cloud può scegliere uno o più indici Kendra che l'analista aziendale può interrogare quando interagisce con FM tramite SageMaker Canvas.

Dopo che gli indici Kendra sono stati idratati e configurati, gli analisti aziendali li utilizzano con SageMaker Canvas avviando una nuova chat e selezionando l'interruttore "Query documenti". SageMaker Canvas gestirà quindi la comunicazione sottostante tra Amazon Kendra e il FM prescelto per eseguire le seguenti operazioni:

- Interroga gli indici Kendra con la domanda proveniente dall'utente.

- Recupera gli snippet (e le fonti) dagli indici Kendra.

- Progetta il prompt con gli snippet con la query originale in modo che il modello di fondazione possa generare una risposta dai documenti recuperati.

- Fornire all'utente la risposta generata, insieme ai riferimenti alle pagine/documenti utilizzati per formulare la risposta.

Configurazione di Canvas per interrogare i documenti

In questa sezione ti guideremo attraverso i passaggi per configurare Canvas per interrogare i documenti serviti tramite gli indici Kendra. Dovresti avere i seguenti prerequisiti:

- Configurazione del dominio SageMaker – Integrazione nel dominio Amazon SageMaker

- Creare un Indice Kendra (o più di uno)

- Configura il connettore Kendra Amazon S3: segui le istruzioni Connettore Amazon S3 – e caricare file PDF e altri documenti nel bucket Amazon S3 associato all'indice Kendra

- Configura IAM in modo che Canvas disponga delle autorizzazioni appropriate, comprese quelle necessarie per chiamare gli endpoint Amazon Bedrock e/o SageMaker: segui le istruzioni Configura la chat su tela documentazione

Adesso puoi aggiornare il Dominio affinché possa accedere agli indici desiderati. Sulla console SageMaker, per il dominio specificato, seleziona Modifica nella scheda Impostazioni dominio. Abilita l'interruttore "Abilita documenti di query con Amazon Kendra" che puoi trovare nella fase Impostazioni Canvas. Una volta attivato, scegli uno o più indici Kendra che desideri utilizzare con Canvas.

Questo è tutto ciò che serve per configurare la funzionalità dei documenti di query Canvas. Gli utenti possono ora entrare in una chat all'interno di Canvas e iniziare a utilizzare le basi di conoscenza che sono state allegate al dominio tramite gli indici Kendra. I manutentori della knowledge base possono continuare ad aggiornare la fonte della verità e con la funzionalità di sincronizzazione di Kendra, gli utenti della chat saranno automaticamente in grado di utilizzare le informazioni aggiornate in modo fluido.

Utilizzo della funzione Interroga documenti per la chat

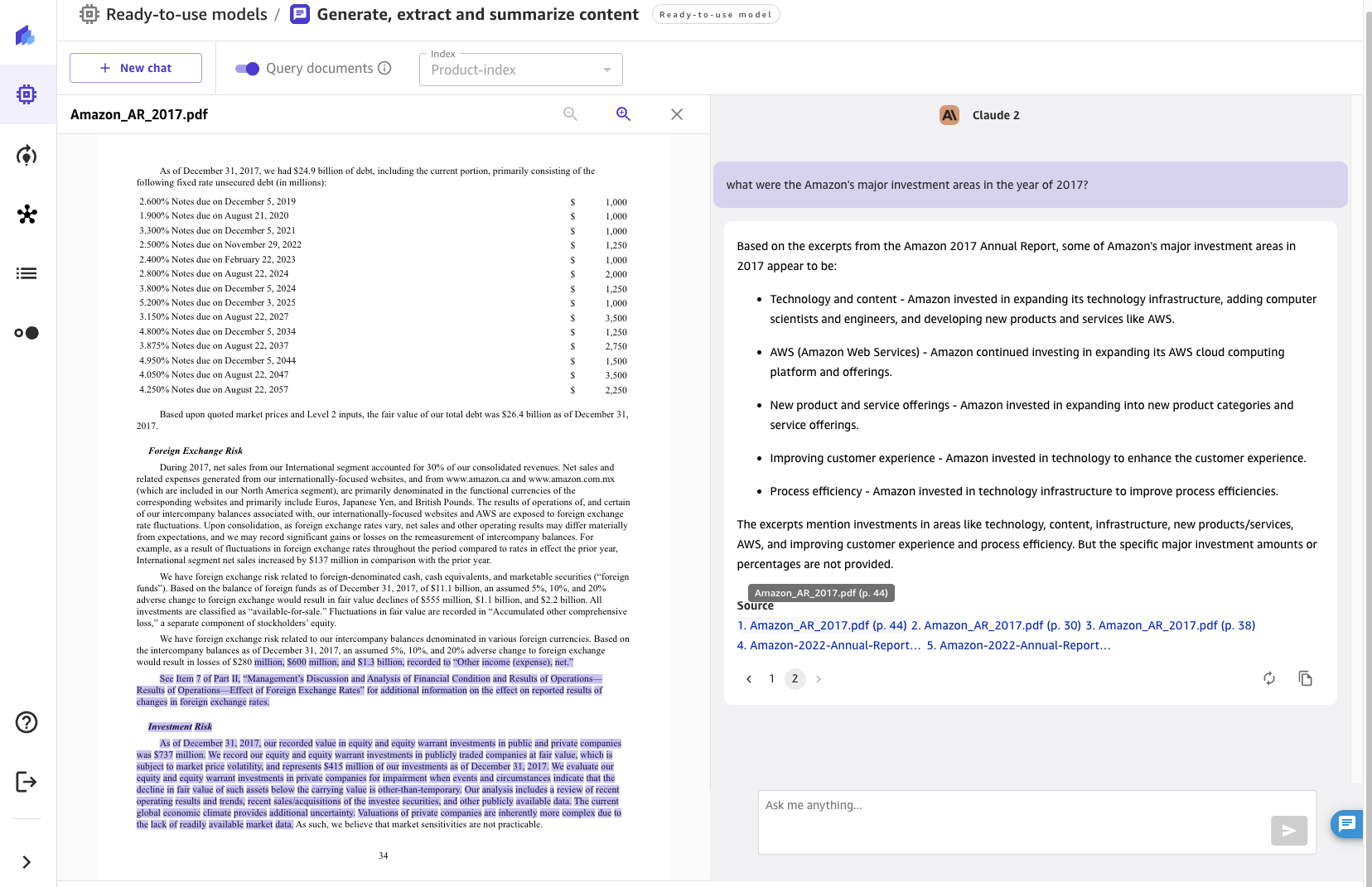

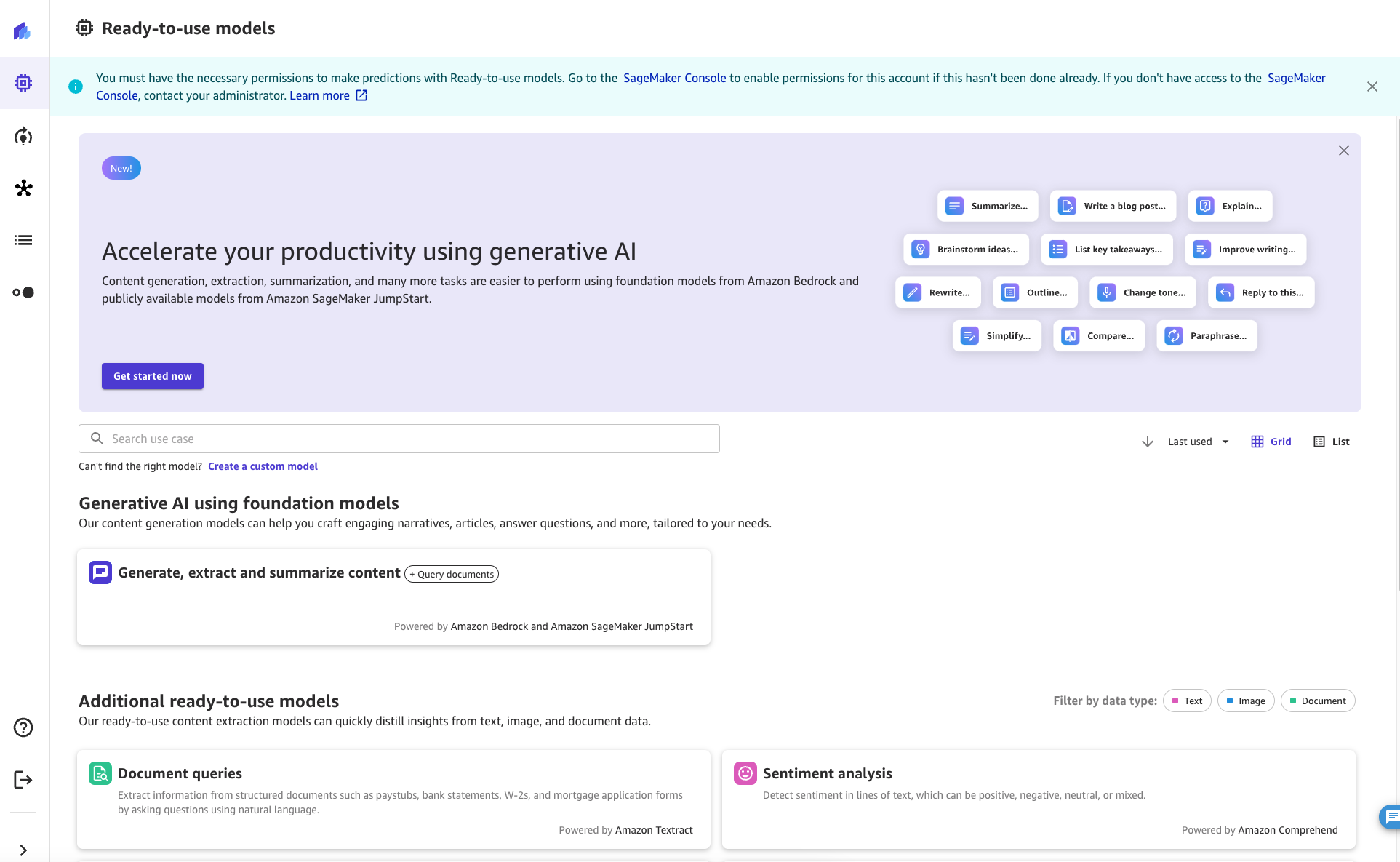

Come utente SageMaker Canvas, è possibile accedere alla funzione Interroga documenti da una chat. Per avviare la sessione di chat, fai clic o cerca il pulsante "Genera, estrai e riepiloga contenuti" dalla scheda Modelli pronti all'uso in SageMaker Canvas.

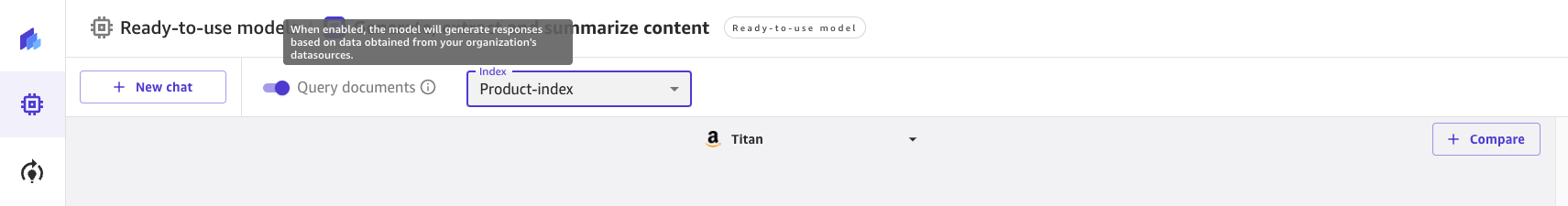

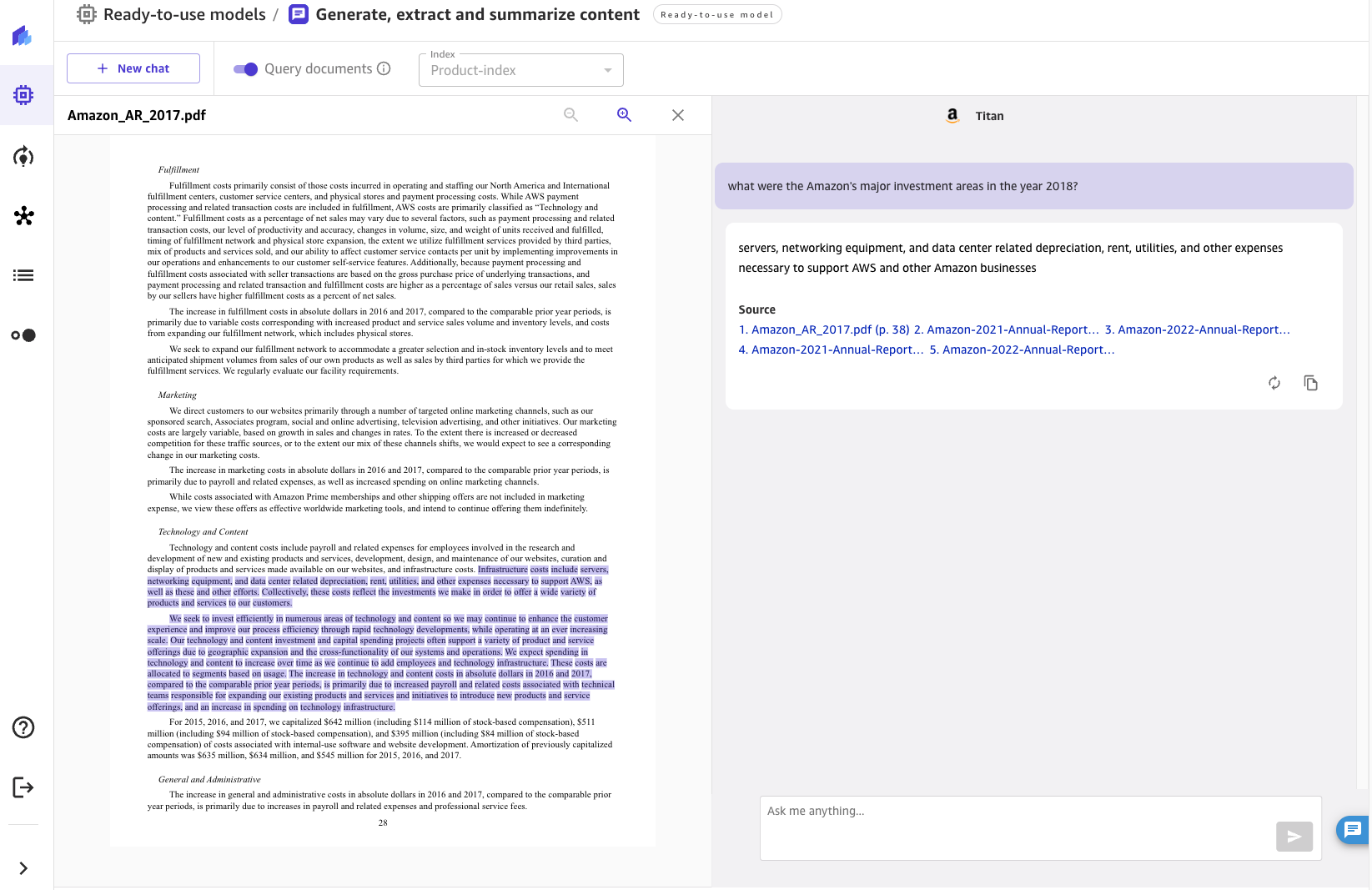

Una volta lì, puoi attivare e disattivare Interroga documenti con l'interruttore nella parte superiore dello schermo. Controlla la richiesta di informazioni per saperne di più sulla funzionalità.

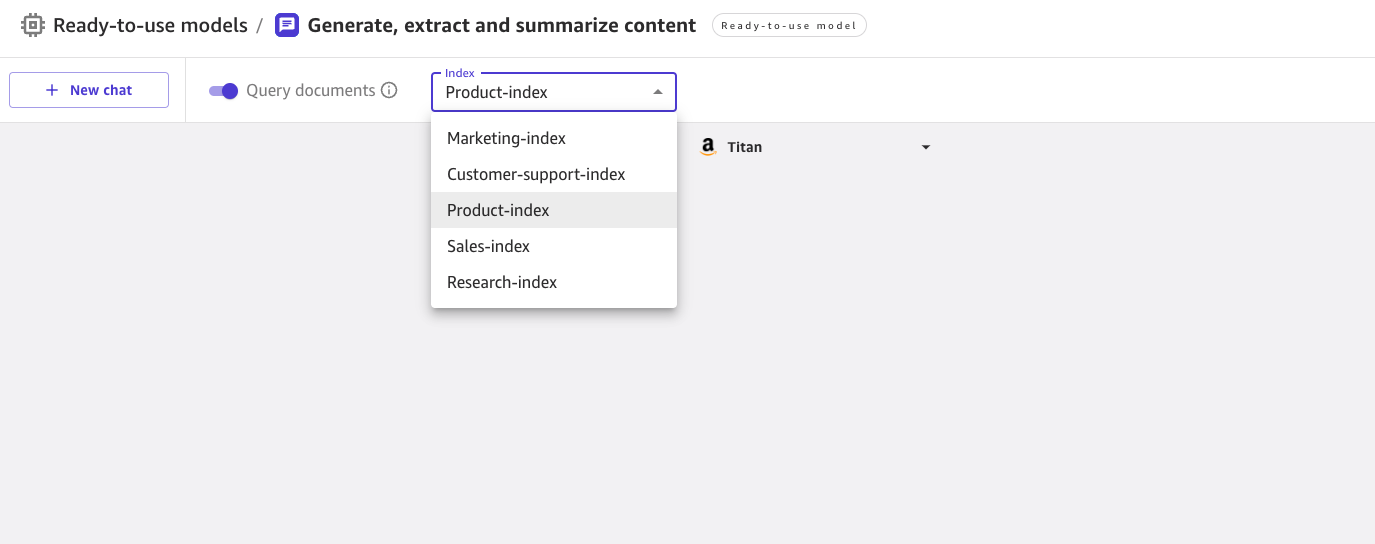

Quando Interroga documenti è abilitato, puoi scegliere da un elenco di indici Kendra abilitati dall'amministratore cloud.

Puoi selezionare un indice quando avvii una nuova chat. È quindi possibile porre una domanda nell'UX con la conoscenza proveniente automaticamente dall'indice selezionato. Tieni presente che dopo l'avvio di una conversazione su un indice specifico, non è possibile passare a un altro indice.

Per le domande poste, la chat mostrerà la risposta generata dal FM insieme ai documenti sorgente che hanno contribuito a generare la risposta. Quando si fa clic su uno qualsiasi dei documenti di origine, Canvas apre un'anteprima del documento, evidenziando l'estratto utilizzato dal FM.

Conclusione

L'intelligenza artificiale conversazionale ha un immenso potenziale per trasformare l'esperienza dei clienti e dei dipendenti fornendo un assistente simile a quello umano con interazioni naturali e intuitive come:

- Eseguire ricerche su un argomento o cercare e sfogliare la knowledge base dell'organizzazione

- Riepilogare volumi di contenuti per raccogliere rapidamente informazioni

- Ricerca di entità, sentimenti, PII e altri dati utili e aumento del valore aziendale dei contenuti non strutturati

- Generazione di bozze per documenti e corrispondenza commerciale

- Creazione di articoli di conoscenza da diverse fonti interne (incidenti, registri di chat, wiki)

L'integrazione innovativa di interfacce chat, recupero di conoscenza e FM consente alle aziende di fornire risposte accurate e pertinenti alle domande degli utenti utilizzando la conoscenza del dominio e le fonti della verità.

Collegando SageMaker Canvas alle basi di conoscenza in Amazon Kendra, le organizzazioni possono mantenere i propri dati proprietari all'interno del proprio ambiente beneficiando comunque delle funzionalità all'avanguardia del linguaggio naturale dei FM. Con il lancio della funzionalità Query Documents di SageMaker Canvas, stiamo rendendo semplice per qualsiasi azienda utilizzare i LLM e la propria conoscenza aziendale come fonte di verità per alimentare un'esperienza di chat sicura. Tutte queste funzionalità sono disponibili in formato senza codice, consentendo alle aziende di evitare di gestire attività ripetitive e non specializzate.

Per saperne di più su SageMaker Canvas e su come aiuta a rendere più semplice per tutti iniziare con il Machine Learning, consulta il Annuncio di SageMaker Canvas. Scopri di più su come SageMaker Canvas aiuta a promuovere la collaborazione tra data scientist e analisti aziendali leggendo il Crea, condividi e distribuisci post. Infine, per sapere come creare il proprio flusso di lavoro di recupero generazione aumentata, fare riferimento a SageMaker JumpStart RAG.

Riferimenti

Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., Küttler, H., Lewis, M., Yih, W., Rocktäschel, T., Riedel, S., Kiela, D. (2020). Generazione aumentata di recupero per attività di PNL ad alta intensità di conoscenza. Progressi nei sistemi di elaborazione delle informazioni neurali, 33, 9459-9474.

Informazioni sugli autori

Davide Gallitelli è un Senior Specialist Solutions Architect per AI/ML. Ha sede a Bruxelles e lavora a stretto contatto con clienti in tutto il mondo che desiderano adottare tecnologie di machine learning Low-Code/No-Code e intelligenza artificiale generativa. È stato uno sviluppatore fin da quando era molto giovane, iniziando a programmare all'età di 7 anni. Ha iniziato a studiare AI/ML all'università e da allora se ne è innamorato.

Davide Gallitelli è un Senior Specialist Solutions Architect per AI/ML. Ha sede a Bruxelles e lavora a stretto contatto con clienti in tutto il mondo che desiderano adottare tecnologie di machine learning Low-Code/No-Code e intelligenza artificiale generativa. È stato uno sviluppatore fin da quando era molto giovane, iniziando a programmare all'età di 7 anni. Ha iniziato a studiare AI/ML all'università e da allora se ne è innamorato.

Bilal Alam è un Enterprise Solutions Architect presso AWS con particolare attenzione al settore dei servizi finanziari. Quasi tutti i giorni Bilal aiuta i clienti a creare, migliorare e proteggere il loro ambiente AWS per distribuire i carichi di lavoro più critici. Ha una vasta esperienza nelle telecomunicazioni, nel networking e nello sviluppo di software. Più recentemente, ha esaminato l'utilizzo dell'intelligenza artificiale/ML per risolvere i problemi aziendali.

Bilal Alam è un Enterprise Solutions Architect presso AWS con particolare attenzione al settore dei servizi finanziari. Quasi tutti i giorni Bilal aiuta i clienti a creare, migliorare e proteggere il loro ambiente AWS per distribuire i carichi di lavoro più critici. Ha una vasta esperienza nelle telecomunicazioni, nel networking e nello sviluppo di software. Più recentemente, ha esaminato l'utilizzo dell'intelligenza artificiale/ML per risolvere i problemi aziendali.

Pashmen Mistry è un Senior Product Manager presso AWS. Al di fuori del lavoro, Pashmeen ama le escursioni avventurose, la fotografia e trascorrere del tempo con la sua famiglia.

Pashmen Mistry è un Senior Product Manager presso AWS. Al di fuori del lavoro, Pashmeen ama le escursioni avventurose, la fotografia e trascorrere del tempo con la sua famiglia.

Dan Sinnreich è Senior Product Manager presso AWS e contribuisce a democratizzare l'apprendimento automatico low-code/no-code. Prima di AWS, Dan ha creato e commercializzato piattaforme SaaS aziendali e modelli di serie temporali utilizzati dagli investitori istituzionali per gestire il rischio e costruire portafogli ottimali. Al di fuori del lavoro, lo si può trovare a giocare a hockey, a fare immersioni subacquee e a leggere fantascienza.

Dan Sinnreich è Senior Product Manager presso AWS e contribuisce a democratizzare l'apprendimento automatico low-code/no-code. Prima di AWS, Dan ha creato e commercializzato piattaforme SaaS aziendali e modelli di serie temporali utilizzati dagli investitori istituzionali per gestire il rischio e costruire portafogli ottimali. Al di fuori del lavoro, lo si può trovare a giocare a hockey, a fare immersioni subacquee e a leggere fantascienza.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/empower-your-business-users-to-extract-insights-from-company-documents-using-amazon-sagemaker-canvas-generative-ai/

- :ha

- :È

- :non

- :Dove

- ][P

- $ SU

- 100

- 12

- 2020

- 2021

- 2023

- 225

- 7

- a

- capacità

- capace

- Chi siamo

- accelerata

- accesso

- accessibile

- accessibile

- preciso

- aggiuntivo

- adottare

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- AI

- AI / ML

- Tutti

- Consentire

- lungo

- già

- sempre

- Amazon

- Amazon Kendra

- Amazon Sage Maker

- Tela di Amazon SageMaker

- Amazon Web Services

- tra

- an

- .

- analista

- Gli analisti

- ed

- ha annunciato

- Un altro

- rispondere

- in qualsiasi

- API

- applicato

- APPLICA

- approccio

- opportuno

- architettura

- SONO

- in giro

- news

- AS

- chiedere

- Assistant

- associato

- At

- aumentare

- aumentata

- automaticamente

- disponibile

- evitare

- AWS

- Backed

- base

- basato

- BE

- stato

- essendo

- beneficiando

- fra

- Bruxelles

- costruire

- Costruzione

- costruito

- affari

- aziende

- pulsante

- by

- chiamata

- Materiale

- tela

- funzionalità

- capacità

- catturare

- casi

- dai un'occhiata

- scegliere

- Scegli

- clicca

- strettamente

- Cloud

- codice

- codifica

- collaborazione

- collezione

- Venire

- arrivo

- Comunicazione

- azienda

- confronto

- compatibile

- complesso

- computer

- Visione computerizzata

- Configurazione

- configurato

- Collegamento

- coerente

- consolle

- costruire

- contenuto

- testuali

- continua

- contribuito

- Conversazione

- Conversazioni

- convertire

- convertito

- creare

- critico

- cliente

- Clienti

- dati

- banche dati

- Giorni

- deep

- democratizzare

- schierare

- distribuzione

- descrivere

- desiderato

- dettaglio

- rivelazione

- Costruttori

- Mercato

- discutere

- disparato

- immersione

- documento

- documenti

- dominio

- e

- più facile

- facile

- incorporamento

- Dipendente

- e potenza

- enable

- abilitato

- Abilita

- arricchire

- assicura

- assicurando

- Impresa

- aziende

- entità

- Ambiente

- tutti

- esempio

- ampliato

- esperienza

- esplora

- estensivo

- Conclamata Esperienza

- esterno

- estratto

- Caduto

- famiglia

- caratteristica

- Fantasia

- File

- Infine

- finanziario

- servizi finanziari

- Nome

- Focus

- seguire

- i seguenti

- Nel

- formato

- Favorire

- essere trovato

- Fondazione

- frequentemente

- da

- funzionalità

- raccogliere

- generare

- generato

- la generazione di

- ELETTRICA

- generativo

- AI generativa

- ottenere

- dato

- globo

- la governance

- guida

- Manovrabilità

- cintura da arrampicata

- Avere

- he

- aiutare

- aiuta

- mettendo in evidenza

- escursioni

- il suo

- Come

- Tutorial

- HTML

- http

- HTTPS

- if

- illustra

- immenso

- competenze

- in

- Compreso

- crescente

- Index

- indici

- Indici

- industriale

- industria

- informazioni

- creativi e originali

- intuizioni

- Istituzioni

- investitori instituzionali

- integrazione

- si interagisce

- interazioni

- interfacce

- interno

- ai miglioramenti

- Introduzione

- intuitivo

- Investitori

- IT

- SUO

- jpg

- saltare

- mantenere

- Conoscere

- conoscenze

- Gestione della conoscenza

- Lingua

- grandi

- lanciare

- IMPARARE

- apprendimento

- Consente di

- livelli

- Lewis

- Biblioteca

- linea

- Lista

- cerca

- amore

- macchina

- machine learning

- Mantenere

- make

- Fare

- gestire

- gestione

- direttore

- modo

- molti

- ML

- modello

- modelli

- Scopri di più

- maggior parte

- multiplo

- Naturale

- Elaborazione del linguaggio naturale

- di applicazione

- internazionale

- neurale

- New

- nlp

- adesso

- of

- MENO

- on

- una volta

- ONE

- apertura

- apre

- operativa

- Operazioni

- ottimale

- or

- organizzazioni

- i

- Altro

- Altri

- su

- risultati

- produzione

- uscite

- al di fuori

- proprio

- parte

- Eseguire

- eseguita

- permessi

- fotografia

- immagine

- Piattaforme

- Platone

- Platone Data Intelligence

- PlatoneDati

- gioco

- portafogli

- possibile

- Post

- potenziale

- energia

- predizione

- prerequisiti

- presenti

- Anteprima

- precedente

- un bagno

- problemi

- processi

- lavorazione

- produrre

- Prodotto

- product manager

- corretto

- proprio

- fornire

- purché

- fornitura

- query

- domanda

- Domande

- rapidamente

- rapidamente

- Lettura

- recentemente

- ridurre

- riducendo

- riferimento

- Riferimenti

- rilasciare

- rilasciato

- pertinente

- ripetitivo

- necessario

- richiede

- riparazioni

- risposta

- risposte

- Risultati

- recensioni

- Rischio

- s

- SaaS

- garanzie

- sagemaker

- Scienze

- Fantascienza

- scienziati

- allo

- senza soluzione di continuità

- Cerca

- Sezione

- sicuro

- fissaggio

- Cercare

- selezionato

- Selezione

- anziano

- delicata

- sentimento

- sentimenti

- Servizi

- Sessione

- set

- regolazione

- impostazioni

- flessibile.

- Condividi

- dovrebbero

- mostrare attraverso le sue creazioni

- mostrato

- da

- abilità

- So

- Software

- lo sviluppo del software

- soluzione

- Soluzioni

- RISOLVERE

- Fonte

- source

- fonti

- specialista

- specifico

- Spendere

- inizia a

- iniziato

- Di partenza

- state-of-the-art

- step

- Passi

- Ancora

- tale

- riassumere

- supporto

- Interruttore

- sistema

- task

- le squadre

- Consulenza

- Tecnologie

- Telco

- dogmi

- di

- che

- I

- le informazioni

- L’ORIGINE

- loro

- Li

- poi

- Là.

- questo

- quelli

- Attraverso

- tempo

- a

- top

- argomento

- Trasformare

- veramente

- di fiducia

- TURNO

- per

- sottostante

- Università

- fino a quando

- up-to-date

- Aggiornanento

- uso

- utilizzato

- Utente

- utenti

- usa

- utilizzando

- ux

- APPREZZIAMO

- varietà

- molto

- visione

- volumi

- W

- camminare

- volere

- Prima

- we

- sito web

- servizi web

- sono stati

- quando

- quale

- while

- volere

- con

- entro

- senza

- Lavora

- flusso di lavoro

- lavori

- scrittura

- Tu

- giovane

- Trasferimento da aeroporto a Sharm

- zefiro