Questo post sul blog è stato scritto in collaborazione con Hwalsuk Lee di Upstage.

Oggi siamo entusiasti di annunciare che il Solare il modello di fondazione sviluppato da Upstage è ora disponibile per i clienti che utilizzano JumpStart di Amazon SageMaker. Solar è un modello linguistico di grandi dimensioni (LLM) pre-addestrato al 100%. Amazon Sage Maker che supera e utilizza le sue dimensioni compatte e i suoi potenti track record per specializzarsi nella formazione mirata, rendendolo versatile in tutte le lingue, domini e attività.

Ora puoi usare il Mini chat solare ed Mini chat solare – Quant modelli preaddestrati all'interno di SageMaker JumpStart. SageMaker JumpStart è l'hub di machine learning (ML) di SageMaker che fornisce l'accesso ai modelli di base oltre agli algoritmi integrati per aiutarti a iniziare rapidamente con il ML.

In questo post spiegheremo come scoprire e distribuire il modello solare tramite SageMaker JumpStart.

Cos'è il modello solare?

Solar è un modello compatto e potente per le lingue inglese e coreana. È specificatamente ottimizzato per scopi di chat multi-turno, dimostrando prestazioni migliorate in un'ampia gamma di attività di elaborazione del linguaggio naturale.

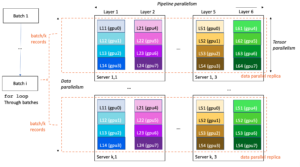

Il modello Solar Mini Chat è basato su Solare 10.7B, con un 32 strati lama 2 struttura e inizializzata con pesi pre-addestrati da Maestrale 7B compatibile con l'architettura Llama 2. Questa messa a punto gli conferisce la capacità di gestire conversazioni estese in modo più efficace, rendendolo particolarmente adatto per le applicazioni interattive. Utilizza un metodo di ridimensionamento chiamato ingrandimento della profondità (DUS), che comprende il ridimensionamento in profondità e il pre-addestramento continuo. DUS consente un ingrandimento molto più semplice ed efficiente di modelli più piccoli rispetto ad altri metodi di ridimensionamento come miscela di esperti (MdE).

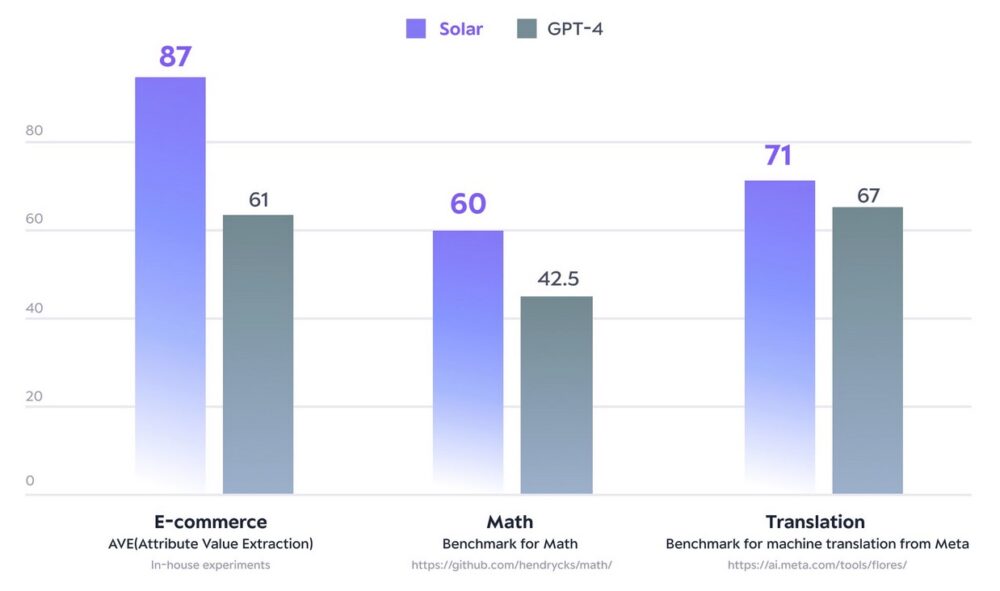

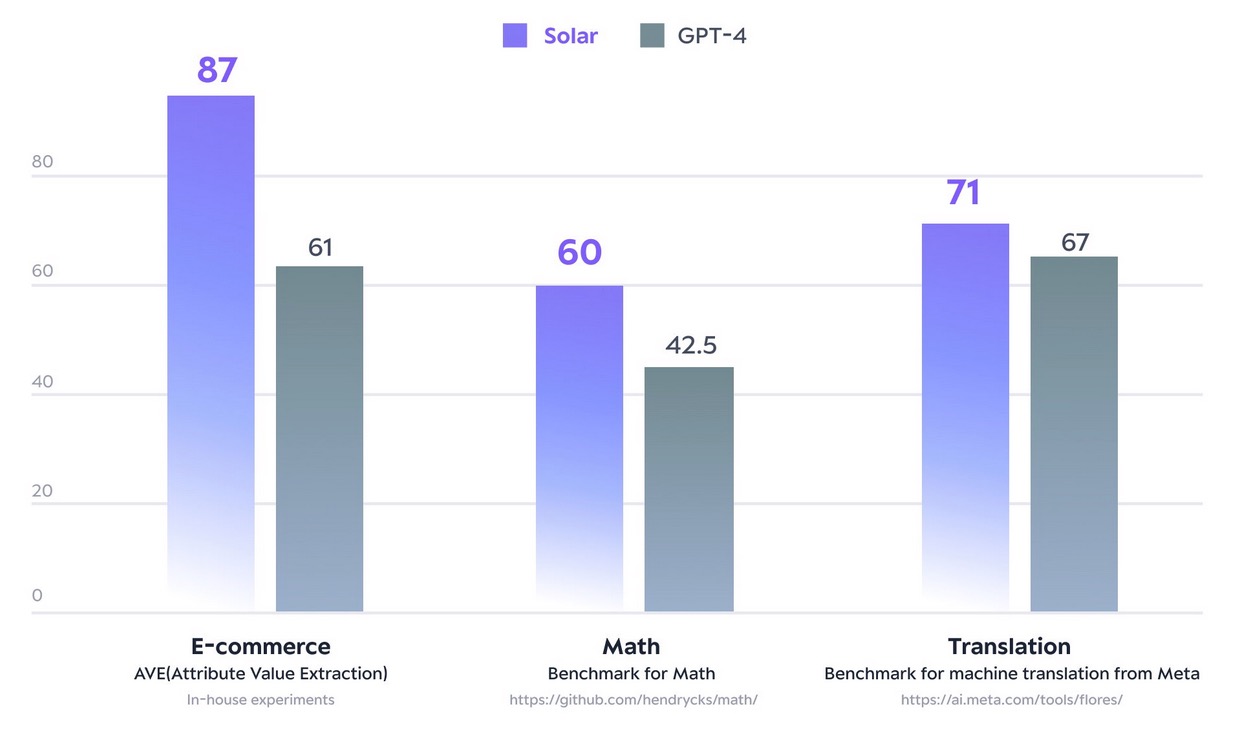

Nel dicembre 2023, il modello Solar 10.7B ha fatto scalpore raggiungendo l'apice del pianeta Apri la classifica LLM del viso che abbraccia. Utilizzando un numero notevolmente inferiore di parametri, Solar 10.7B fornisce risposte paragonabili a GPT-3.5, ma è 2.5 volte più veloce. Oltre a raggiungere la vetta della classifica Open LLM, Solar 10.7B supera GPT-4 con modelli appositamente formati su determinati domini e attività.

La figura seguente illustra alcune di queste metriche:

Con SageMaker JumpStart puoi distribuire modelli pre-addestrati basati su Solar 10.7B: Solar Mini Chat e una versione quantizzata di Solar Mini Chat, ottimizzata per applicazioni di chat in inglese e coreano. Il modello Solar Mini Chat fornisce una conoscenza avanzata delle sfumature della lingua coreana, che migliora significativamente le interazioni dell'utente negli ambienti di chat. Fornisce risposte precise agli input dell'utente, garantendo una comunicazione più chiara e una risoluzione dei problemi più efficiente nelle applicazioni di chat inglese e coreana.

Inizia con i modelli solari in SageMaker JumpStart

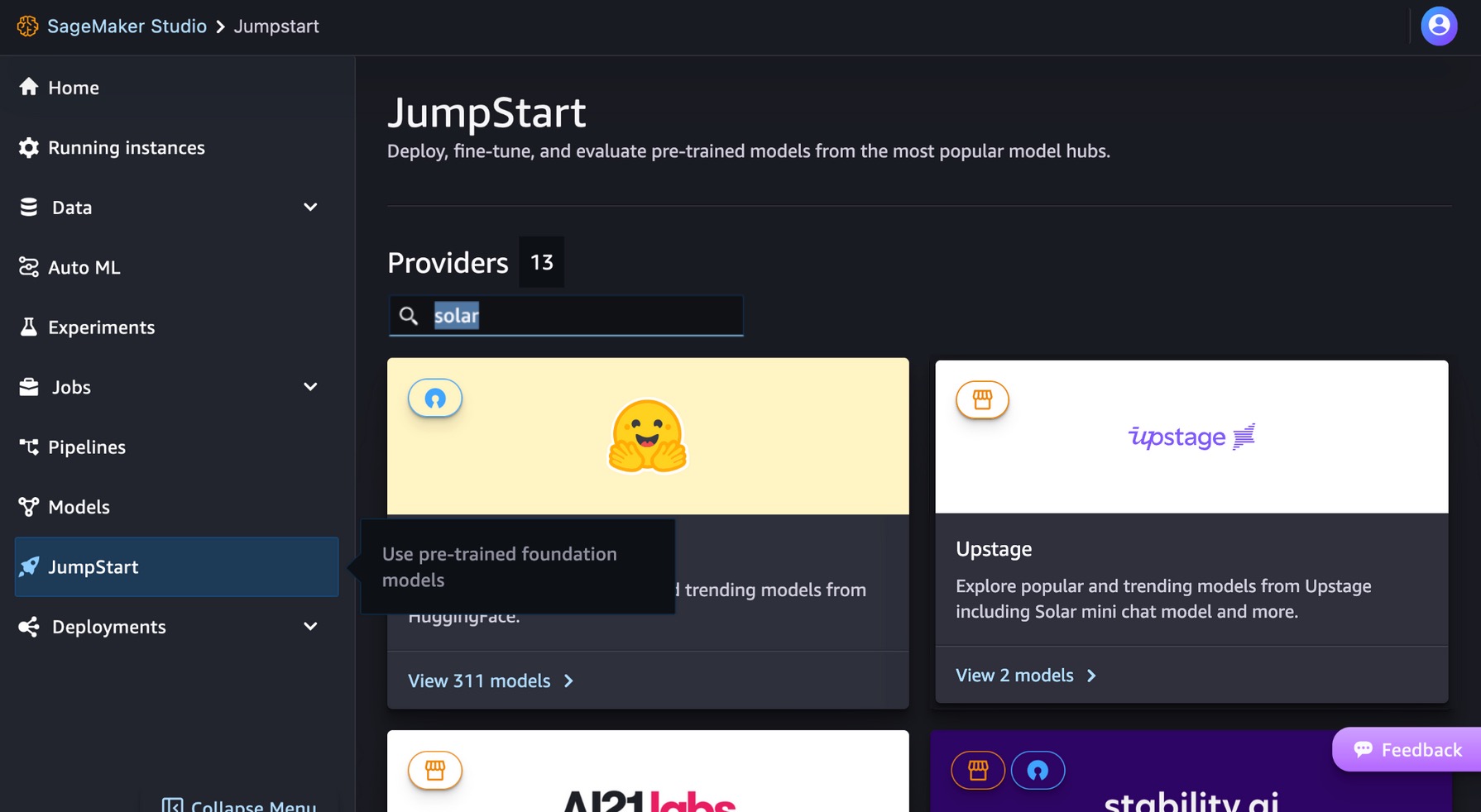

Per iniziare con i modelli solari, puoi utilizzare SageMaker JumpStart, un servizio hub ML completamente gestito per distribuire modelli ML predefiniti in un ambiente ospitato pronto per la produzione. È possibile accedere ai modelli solari tramite SageMaker JumpStart in Amazon Sage Maker Studio, un ambiente di sviluppo integrato (IDE) basato sul Web in cui puoi accedere a strumenti specifici per eseguire tutte le fasi di sviluppo ML, dalla preparazione dei dati alla creazione, formazione e distribuzione dei modelli ML.

Nella console di SageMaker Studio, scegli inizio di salto nel riquadro di navigazione. Puoi inserire "solare" nella barra di ricerca per trovare i modelli solari di Upstage.

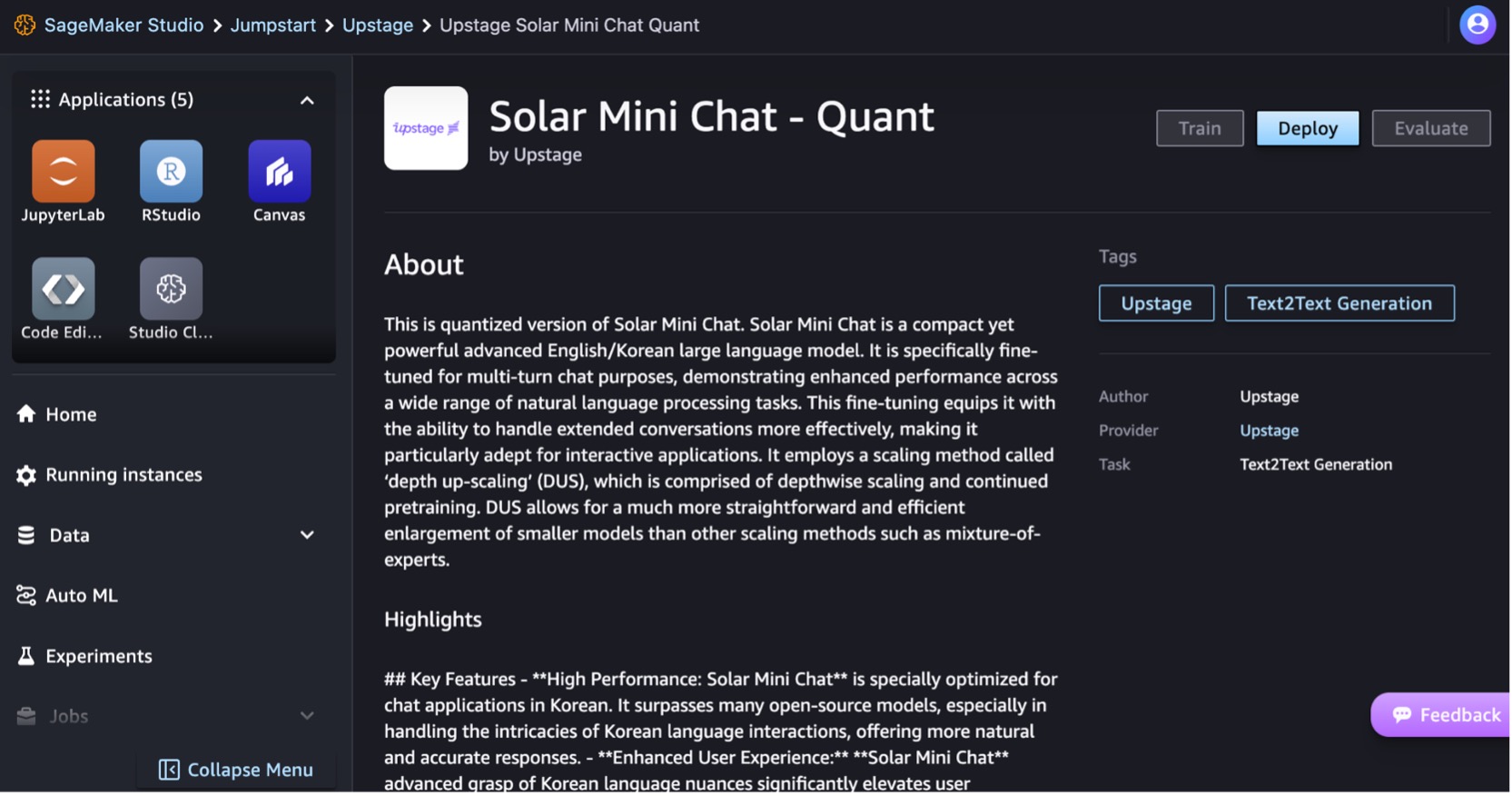

Implementiamo il modello Solar Mini Chat – Quant. Scegli la scheda del modello per visualizzare i dettagli sul modello come la licenza, i dati utilizzati per l'addestramento e come utilizzare il modello. Troverai anche un Schierare opzione, che ti porta a una pagina di destinazione in cui puoi testare l'inferenza con un payload di esempio.

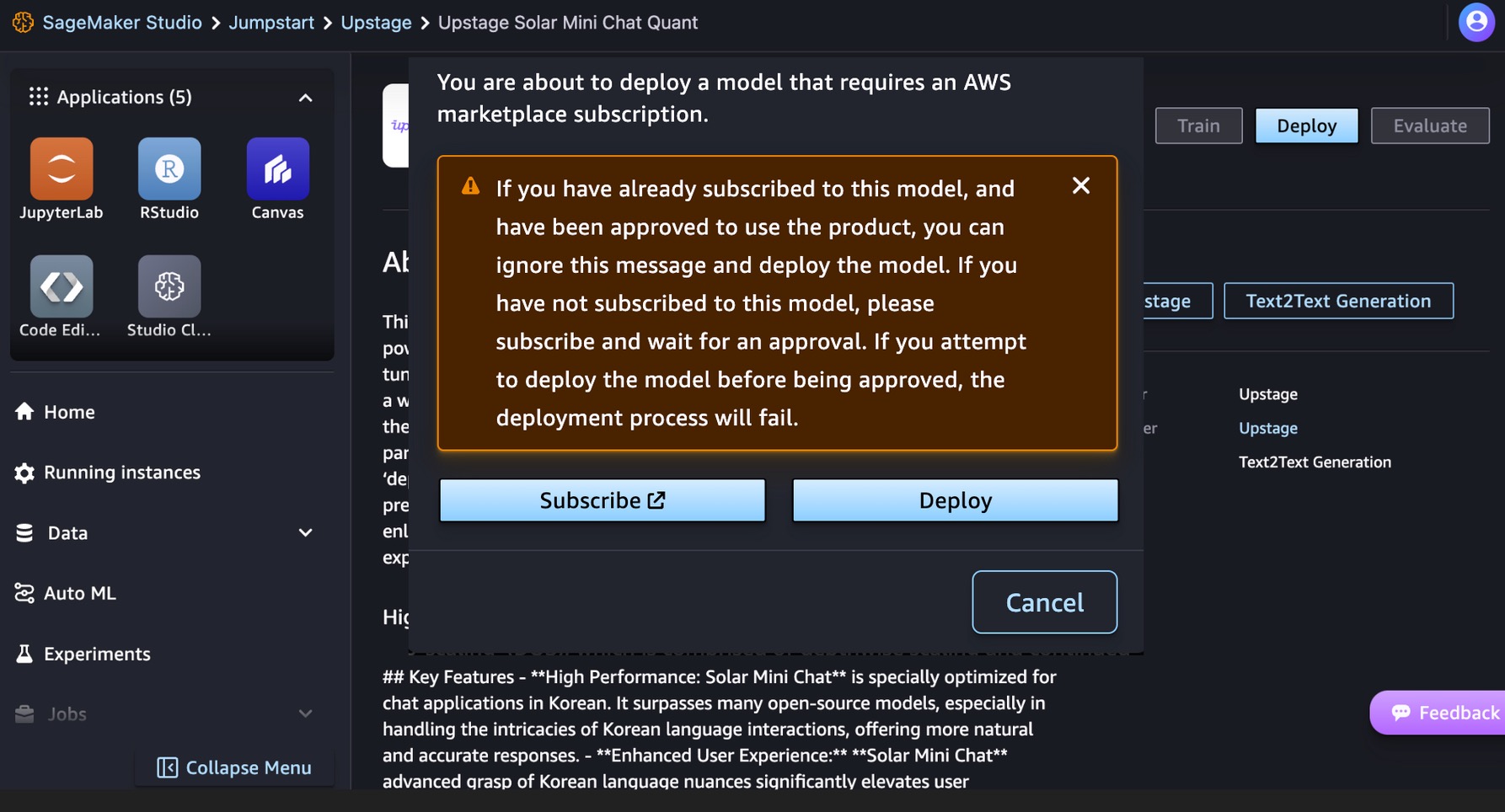

Questo modello richiede un Mercato AWS sottoscrizione. Se sei già abbonato a questo modello e sei stato approvato per utilizzare il prodotto, puoi distribuire direttamente il modello.

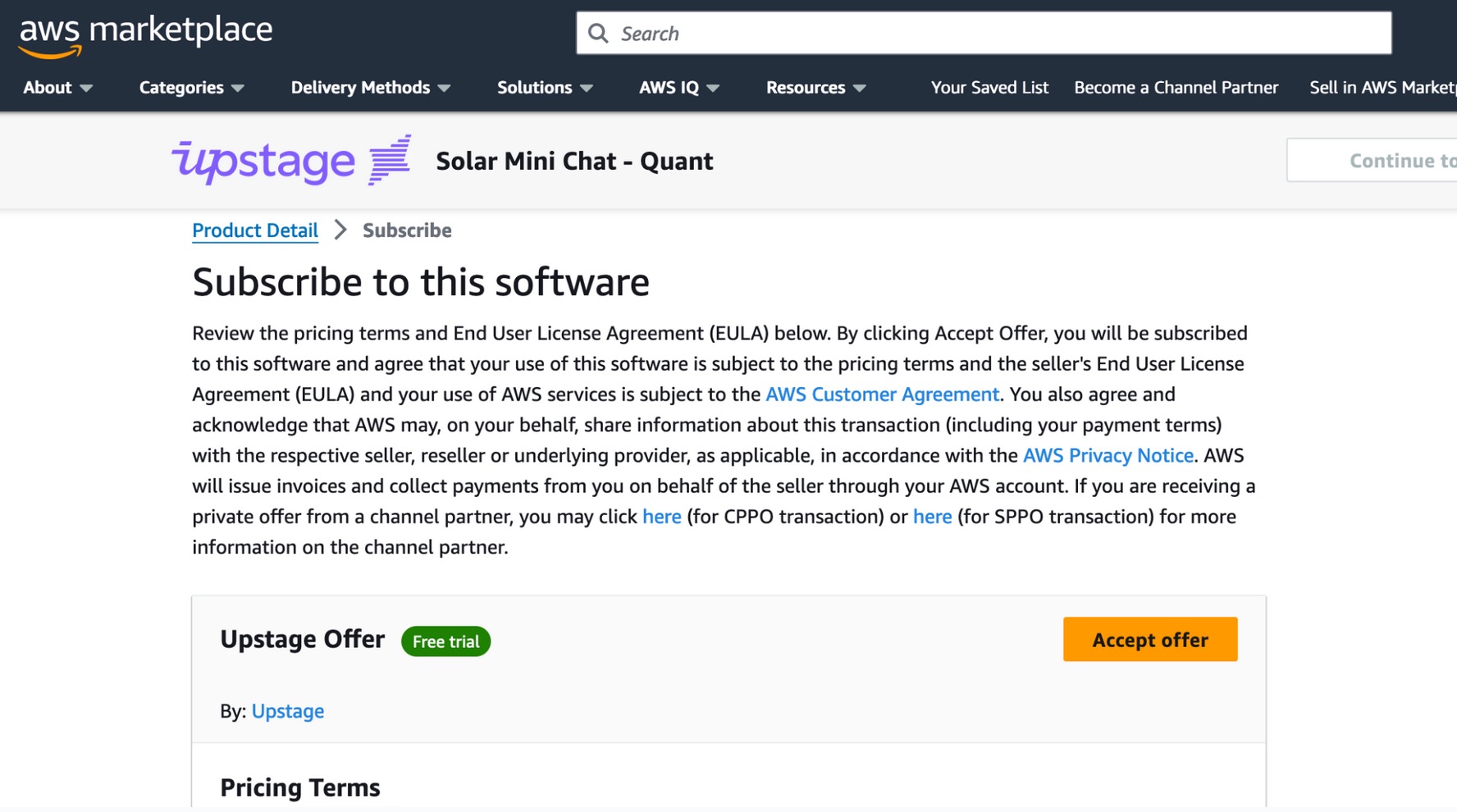

Se non sei iscritto a questo modello, scegli Sottoscrivi, vai su AWS Marketplace, esamina i termini dei prezzi e il contratto di licenza con l'utente finale (EULA) e scegli Accettare un'offerta.

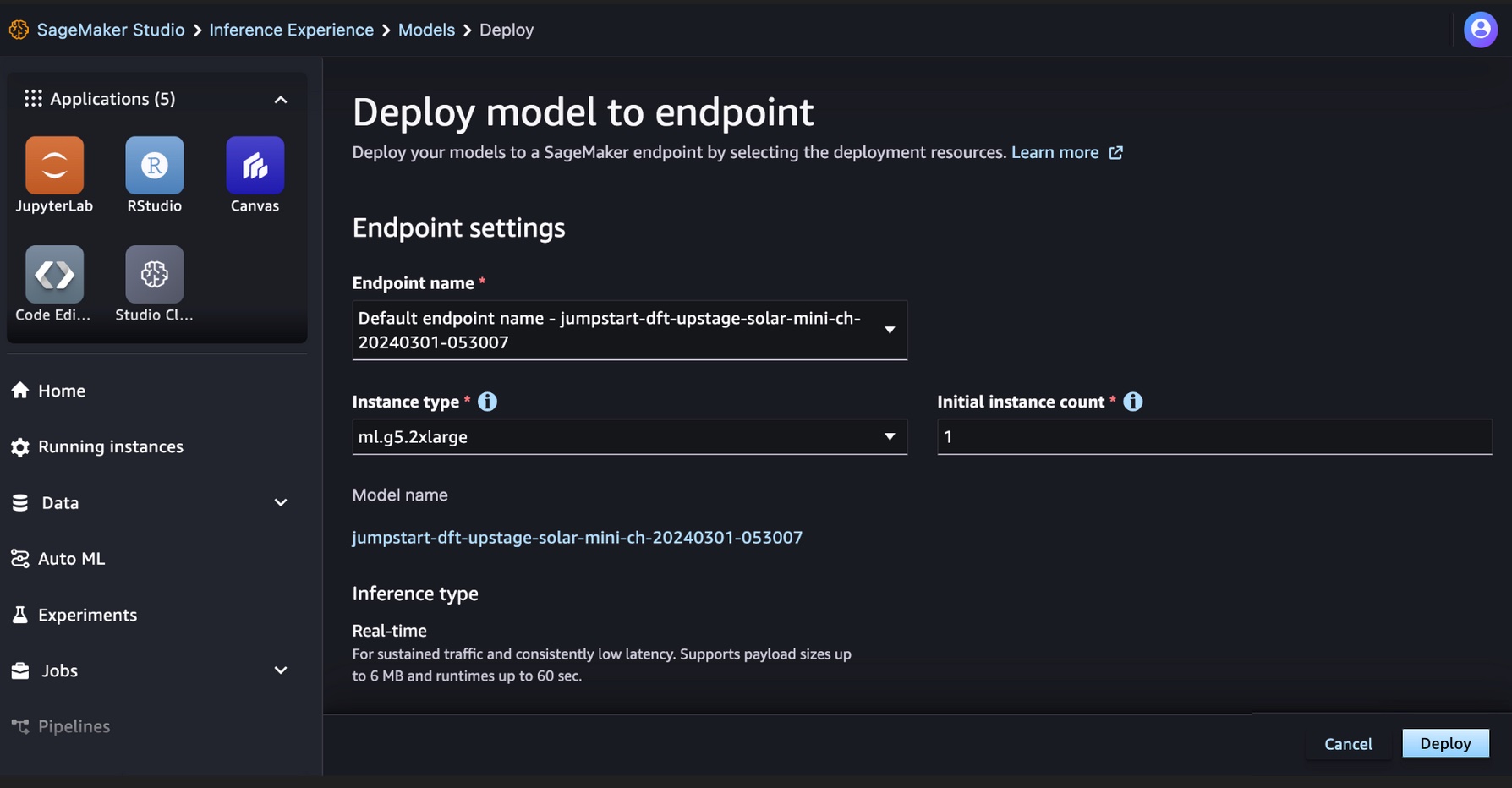

Dopo esserti iscritto al modello, puoi distribuire il tuo modello su un endpoint SageMaker selezionando le risorse di distribuzione, come il tipo di istanza e il conteggio iniziale delle istanze. Scegliere Schierare e attendere la creazione di un endpoint per l'inferenza del modello. È possibile selezionare un ml.g5.2xlarge ad esempio come opzione più economica per l’inferenza con il modello solare.

Una volta creato correttamente il tuo endpoint SageMaker, puoi testarlo attraverso i vari ambienti applicativi SageMaker.

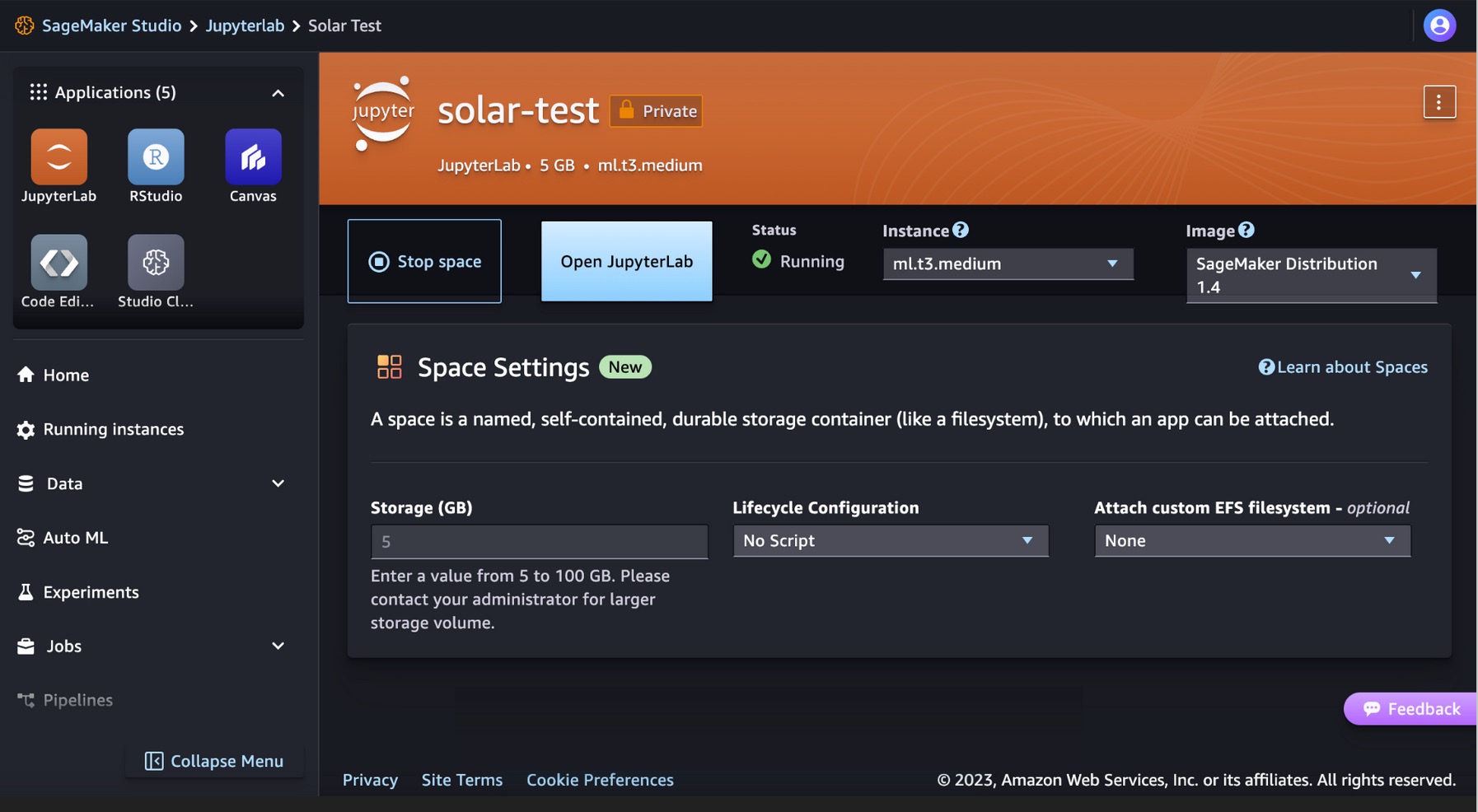

Esegui il codice per i modelli solari in SageMaker Studio JupyterLab

SageMaker Studio supporta vari ambienti di sviluppo di applicazioni, tra cui JupyterLab, un insieme di funzionalità che ampliano l'offerta di notebook completamente gestiti. Include kernel che si avviano in pochi secondi, un runtime preconfigurato con la scienza dei dati più diffusa, framework ML e storage a blocchi privato ad alte prestazioni. Per ulteriori informazioni, vedere SageMaker JupyterLab.

Crea uno spazio JupyterLab all'interno di SageMaker Studio che gestisca le risorse di archiviazione e di elaborazione necessarie per eseguire l'applicazione JupyterLab.

Puoi trovare il codice che mostra la distribuzione dei modelli solari su SageMaker JumpStart e un esempio di come utilizzare il modello distribuito nella pagina Repository GitHub. Ora puoi distribuire il modello utilizzando SageMaker JumpStart. Il codice seguente utilizza l'istanza predefinita ml.g5.2xlarge per l'endpoint di inferenza del modello Solar Mini Chat – Quant.

I modelli solari supportano un payload di richiesta/risposta compatibile con l'endpoint di completamento della chat di OpenAI. Puoi testare esempi di chat a turno singolo o multi turno con Python.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultHai eseguito con successo un'inferenza in tempo reale con il modello Solar Mini Chat.

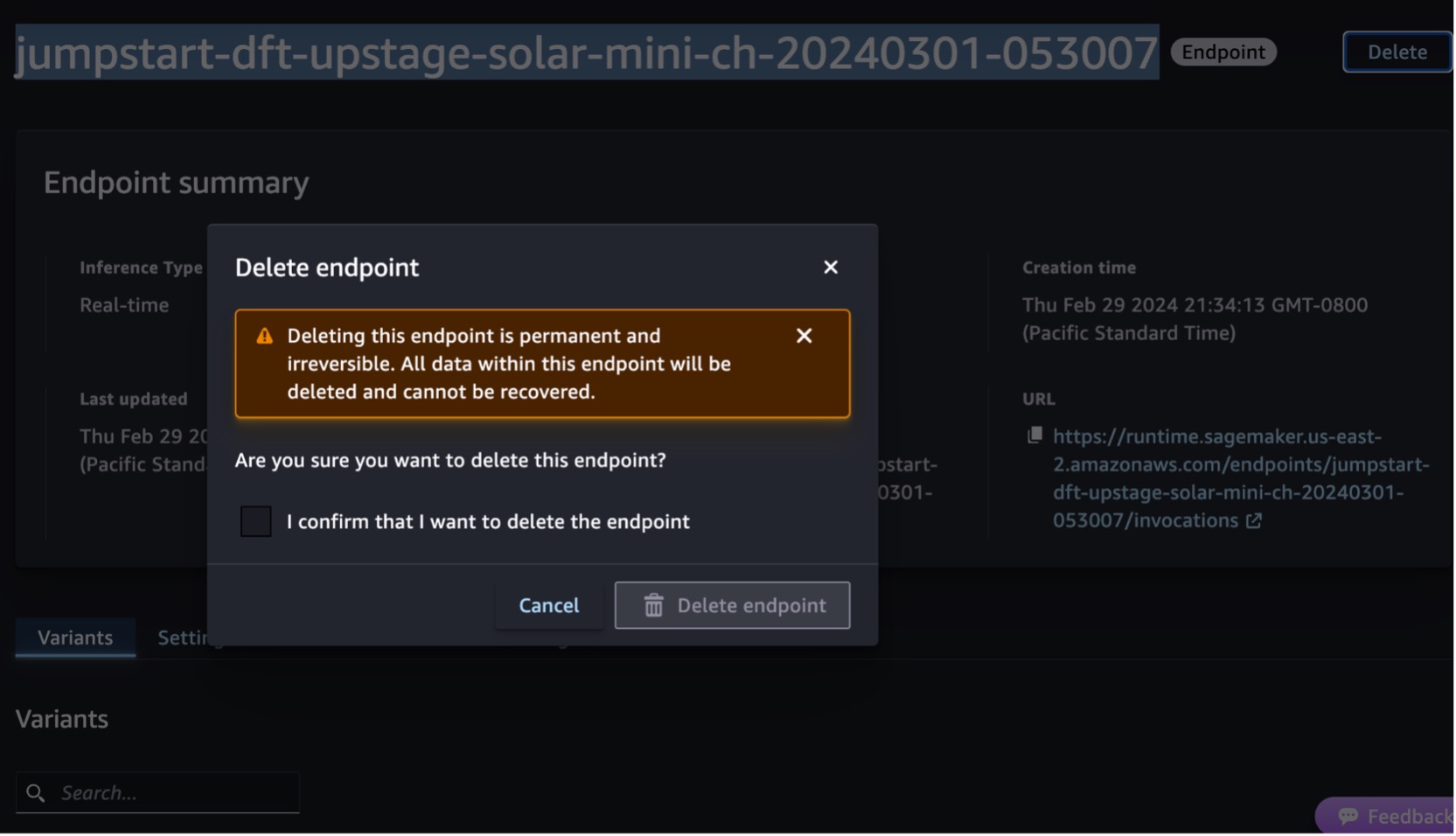

ripulire

Dopo aver testato l'endpoint, elimina l'endpoint di inferenza SageMaker ed elimina il modello per evitare addebiti.

Puoi anche eseguire il codice seguente per eliminare l'endpoint e la modalità nel notebook di SageMaker Studio JupyterLab:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()Per ulteriori informazioni, vedere Elimina endpoint e risorse. Inoltre, puoi chiudere le risorse di SageMaker Studio che non sono più necessari.

Conclusione

In questo post ti abbiamo mostrato come iniziare con i modelli solari di Upstage in SageMaker Studio e distribuire il modello per l'inferenza. Ti abbiamo anche mostrato come eseguire il codice di esempio Python su SageMaker Studio JupyterLab.

Poiché i modelli solari sono già pre-addestrati, possono contribuire a ridurre i costi di formazione e infrastruttura e consentire la personalizzazione delle applicazioni di intelligenza artificiale generativa.

Provalo su Console SageMaker JumpStart or Console SageMaker Studio! Puoi anche guardare il seguente video, Prova "Solare" con Amazon SageMaker.

Questa guida è solo a scopo informativo. Dovresti comunque eseguire la tua valutazione indipendente e adottare misure per garantire il rispetto delle tue pratiche e standard specifici di controllo della qualità e delle norme, leggi, regolamenti, licenze e termini di utilizzo locali che si applicano a te, ai tuoi contenuti, e il modello di terze parti a cui si fa riferimento nella presente guida. AWS non ha alcun controllo o autorità sul modello di terze parti a cui si fa riferimento in queste linee guida e non rilascia alcuna dichiarazione o garanzia che il modello di terze parti sia sicuro, privo di virus, operativo o compatibile con l'ambiente e gli standard di produzione. AWS non rilascia alcuna dichiarazione o garanzia che qualsiasi informazione contenuta in questa guida comporterà un risultato o un risultato particolare.

Informazioni sugli autori

Channy Yun è un principale sostenitore degli sviluppatori presso AWS e la sua passione è aiutare gli sviluppatori a creare applicazioni moderne sugli ultimi servizi AWS. È uno sviluppatore pragmatico e un blogger nel cuore e ama l'apprendimento guidato dalla comunità e la condivisione della tecnologia.

Channy Yun è un principale sostenitore degli sviluppatori presso AWS e la sua passione è aiutare gli sviluppatori a creare applicazioni moderne sugli ultimi servizi AWS. È uno sviluppatore pragmatico e un blogger nel cuore e ama l'apprendimento guidato dalla comunità e la condivisione della tecnologia.

Hwalsuk Lee è Chief Technology Officer (CTO) presso Upstage. Ha lavorato per Samsung Techwin, NCSOFT e Naver come ricercatore AI. Sta conseguendo il dottorato di ricerca in ingegneria informatica ed elettrica presso il Korea Advanced Institute of Science and Technology (KAIST).

Hwalsuk Lee è Chief Technology Officer (CTO) presso Upstage. Ha lavorato per Samsung Techwin, NCSOFT e Naver come ricercatore AI. Sta conseguendo il dottorato di ricerca in ingegneria informatica ed elettrica presso il Korea Advanced Institute of Science and Technology (KAIST).

Brandon Lee è un Senior Solutions Architect presso AWS e aiuta principalmente i grandi clienti di tecnologia educativa nel settore pubblico. Ha oltre 20 anni di esperienza nella guida dello sviluppo di applicazioni presso aziende globali e grandi aziende.

Brandon Lee è un Senior Solutions Architect presso AWS e aiuta principalmente i grandi clienti di tecnologia educativa nel settore pubblico. Ha oltre 20 anni di esperienza nella guida dello sviluppo di applicazioni presso aziende globali e grandi aziende.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- :ha

- :È

- :non

- :Dove

- 10

- 120

- 152

- 20

- 20 anni

- 2023

- 7

- 990

- a

- capacità

- Chi siamo

- Accetta

- accesso

- operanti in

- aggiunta

- Inoltre

- abile

- Avanzate

- avvocato

- Accordo

- AI

- Algoritmi

- Tutti

- consente

- lungo

- già

- anche

- Amazon

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Web Services

- an

- ed

- e infrastruttura

- Annunciare

- in qualsiasi

- Applicazioni

- Sviluppo di applicazioni

- applicazioni

- APPLICA

- approvato

- architettura

- SONO

- AS

- valutazione

- Assistant

- At

- aumentare

- autorità

- disponibile

- evitare

- AWS

- Mercato AWS

- bar

- basato

- BE

- stato

- Bloccare

- Blog

- stile di vita

- Brandon

- costruire

- Costruzione

- incassato

- ma

- by

- detto

- Materiale

- funzionalità

- carta

- certo

- oneri

- chiacchierare

- più economico

- capo

- Chief Technology Officer

- Scegli

- più chiaro

- codice

- Comunicazione

- Guidato dalla comunità

- compatto

- Aziende

- paragonabile

- compatibile

- completamento

- ottemperare

- Compreso

- Calcolare

- computer

- consolle

- contenuto

- continua

- di controllo

- Conversazioni

- Corporazioni

- Costi

- contare

- creare

- creato

- CTO

- Clienti

- personalizzazione

- dati

- scienza dei dati

- Dicembre

- Predefinito

- fornisce un monitoraggio

- dimostrando

- schierare

- schierato

- distribuzione

- deployment

- dettagli

- sviluppato

- Costruttori

- sviluppatori

- Mercato

- direttamente

- scopri

- effettua

- domini

- giù

- educativo

- in maniera efficace

- efficiente

- eleva

- impiega

- enable

- fine

- endpoint

- Ingegneria

- Inglese

- migliorata

- garantire

- assicurando

- entrare

- Ambiente

- ambienti

- esempio

- Esempi

- eccitato

- esperienza

- Faccia

- più veloce

- meno

- figura

- Trovare

- i seguenti

- Nel

- Fondazione

- quadri

- da

- completamente

- function

- generativo

- AI generativa

- ottenere

- globali

- Go

- afferrala

- garanzie

- guida

- maniglia

- Avere

- he

- Cuore

- Aiuto

- utile

- aiutare

- aiuta

- qui

- Alte prestazioni

- il suo

- ospitato

- Come

- Tutorial

- HTML

- HTTPS

- Hub

- if

- illustra

- in

- inclusi

- Compreso

- studente indipendente

- informazioni

- Informativo

- Infrastruttura

- inizialmente

- ingresso

- Ingressi

- esempio

- Istituto

- integrato

- interazioni

- interattivo

- ai miglioramenti

- IT

- SUO

- jpg

- json

- Corea

- Coreano

- atterraggio

- Lingua

- Le Lingue

- grandi

- con i più recenti

- Legislazione

- leaderboard

- principale

- apprendimento

- sottovento

- Licenza

- licenze

- elenchi

- Lama

- LLM

- locale

- più a lungo

- ama

- inferiore

- macchina

- machine learning

- fatto

- make

- Fare

- gestito

- gestisce

- mercato

- analisi

- Unire

- messaggi

- Meta

- metodo

- metodi

- Metrica

- ML

- Moda

- modello

- modelli

- moderno

- Scopri di più

- più efficiente

- molti

- Naturale

- Elaborazione del linguaggio naturale

- Naver

- Navigazione

- di applicazione

- no

- segnatamente

- taccuino

- adesso

- ombreggiatura

- of

- offrire

- offerta

- Responsabile

- on

- esclusivamente

- aprire

- operativa

- ottimizzati

- Opzione

- or

- Altro

- su

- Risultato

- Sorpassa

- ancora

- proprio

- pagina

- vetro

- parametri

- particolare

- particolarmente

- appassionato

- Eseguire

- performance

- eseguita

- phd

- foto

- Pinnacle

- Platone

- Platone Data Intelligence

- PlatoneDati

- Popolare

- Post

- potente

- pratiche

- pragmatico

- bisogno

- preparazione

- prezzi

- principalmente

- Direttore

- Stampa

- un bagno

- Problema

- lavorazione

- Prodotto

- Produzione

- fornire

- fornisce

- la percezione

- fini

- Python

- qualità

- Quant

- rapidamente

- gamma

- raggiungendo

- di rose

- tempo reale

- record

- riferimento

- normativa

- necessario

- richiede

- ricercatore

- Risoluzione

- Risorse

- risposta

- risposte

- colpevole

- ritorno

- recensioni

- Ruolo

- norme

- Correre

- runtime

- sagemaker

- Inferenza di SageMaker

- campione

- Samsung

- scala

- Scienze

- Scienza e Tecnologia

- copione

- Cerca

- secondo

- settore

- sicuro

- vedere

- select

- Selezione

- anziano

- servizio

- Servizi

- set

- compartecipazione

- dovrebbero

- ha mostrato

- mostra

- significativamente

- Taglia

- inferiore

- solare

- Soluzioni

- alcuni

- lo spazio

- specializzarsi

- specifico

- in particolare

- standard

- inizia a

- iniziato

- Passi

- Ancora

- conservazione

- lineare

- La struttura

- studio

- sottoscrivi

- sottoscrizione

- Con successo

- tale

- supporto

- supporti

- sicuro

- sistema

- Fai

- prende

- task

- Tecnologia

- condizioni

- test

- testato

- di

- che

- I

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- di parti terze standard

- questo

- Attraverso

- tempo

- volte

- a

- strumenti

- pista

- Treni

- Training

- seconda

- Digitare

- uso

- utilizzato

- Utente

- usa

- utilizzando

- vario

- versatile

- versione

- via

- Video

- Visualizza

- aspettare

- camminare

- garanzie

- Orologio

- onde

- we

- sito web

- servizi web

- Web-basata

- quale

- largo

- Vasta gamma

- volere

- con

- entro

- lavorato

- anni

- Tu

- Trasferimento da aeroporto a Sharm

- youtube

- zefiro