Il rilevamento automatico dei difetti mediante la visione artificiale aiuta a migliorare la qualità e ridurre i costi di ispezione. Il rilevamento dei difetti implica l'identificazione della presenza di un difetto, la classificazione dei tipi di difetti e l'identificazione della posizione dei difetti. Molti processi di produzione richiedono il rilevamento a bassa latenza, con risorse di calcolo limitate e con connettività limitata.

Amazon Lookout per la visione è un servizio di machine learning (ML) che aiuta a individuare i difetti dei prodotti utilizzando la visione artificiale per automatizzare il processo di ispezione della qualità nelle linee di produzione, senza che sia richiesta alcuna esperienza di machine learning. Lookout for Vision ora include la possibilità di fornire la posizione e il tipo di anomalie utilizzando i modelli ML di segmentazione semantica. Questi modelli ML personalizzati possono essere distribuiti nel cloud AWS utilizzando API cloud o all'hardware edge personalizzato utilizzando AWS IoT Greengrass. Lookout for Vision ora supporta l'inferenza su una piattaforma di elaborazione x86 che esegue Linux con o senza un acceleratore GPU NVIDIA e su qualsiasi dispositivo edge basato su NVIDIA Jetson. Questa flessibilità consente il rilevamento di difetti su hardware esistente o nuovo.

In questo post, ti mostriamo come rilevare le parti difettose utilizzando i modelli Lookout for Vision ML in esecuzione su un'appliance edge, che simuliamo utilizzando un Cloud di calcolo elastico di Amazon (Amazon EC2). Eseguiamo l'addestramento dei nuovi modelli di segmentazione semantica, esportandoli come componenti AWS IoT Greengrass ed eseguendo l'inferenza in modalità solo CPU con codice di esempio Python.

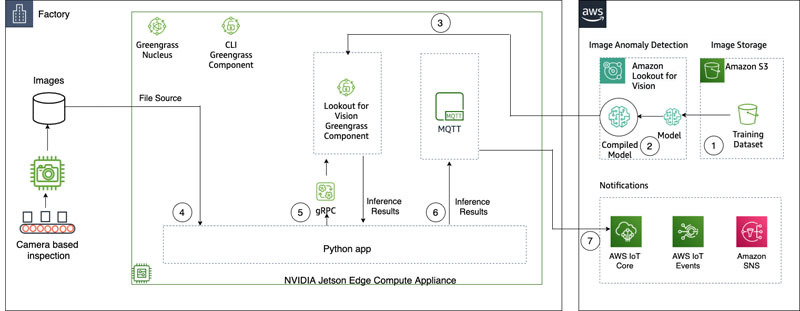

Panoramica della soluzione

In questo post, utilizziamo una serie di immagini di alieni giocattolo composto da immagini normali e difettose come arti, occhi o altre parti mancanti. Formiamo un modello Lookout for Vision nel cloud per identificare gli alieni giocattolo difettosi. Compiliamo il modello su una CPU X86 di destinazione, impacchettamo il modello Lookout for Vision addestrato come componente AWS IoT Greengrass e distribuiamo il modello a un'istanza EC2 senza GPU utilizzando la console AWS IoT Greengrass. Infine, dimostriamo un'applicazione di esempio basata su Python in esecuzione sull'istanza EC2 (C5a.2xl) che origina le immagini degli alieni giocattolo dal file system del dispositivo perimetrale, esegue l'inferenza sul modello Lookout for Vision utilizzando il gRPC interfaccia e invia i dati di inferenza a un MQTT argomento nel cloud AWS. Lo script restituisce un'immagine che include il colore e la posizione dei difetti sull'immagine anomala.

Il diagramma seguente illustra l'architettura della soluzione. È importante notare che per ogni tipo di difetto che si desidera rilevare nella localizzazione, è necessario disporre di 10 immagini di anomalia contrassegnate in training e 10 nei dati di test, per un totale di 20 immagini di quel tipo. Per questo post, cerchiamo gli arti mancanti sul giocattolo.

La soluzione ha il seguente flusso di lavoro:

- Carica un set di dati di addestramento e un set di dati di test su Servizio di archiviazione semplice Amazon (Amazon S3).

- Usa la nuova interfaccia utente Lookout for Vision per aggiungere un tipo di anomalia e contrassegnare dove si trovano tali anomalie nelle immagini di addestramento e test.

- Addestra un modello Lookout for Vision nel cloud.

- Compila il modello nell'architettura di destinazione (X86) e distribuisci il modello nell'istanza EC2 (C5a.2xl) utilizzando la console AWS IoT Greengrass.

- Immagini di origine dal disco locale.

- Esegui inferenze sul modello distribuito tramite l'interfaccia gRPC e recupera un'immagine di maschere di anomalia sovrapposte all'immagine originale.

- Pubblica i risultati dell'inferenza su un client MQTT in esecuzione sull'istanza perimetrale.

- Ricevi il messaggio MQTT su un argomento in AWS IoT Core nel cloud AWS per un ulteriore monitoraggio e visualizzazione.

I passaggi 5, 6 e 7 sono coordinati con l'applicazione Python di esempio.

Prerequisiti

Prima di iniziare, completa i seguenti prerequisiti. Per questo post, utilizziamo un'istanza EC2 c5.2xl e installiamo AWS IoT Greengrass V2 su di essa per provare le nuove funzionalità. Se vuoi eseguire su una NVIDIA Jetson, segui i passaggi nel nostro post precedente, Amazon Lookout for Vision ora supporta l'ispezione visiva dei difetti del prodotto ai margini.

- Crea un account AWS.

- Avvia un'istanza EC2 su cui possiamo installare AWS IoT Greengrass e utilizza la nuova modalità di inferenza solo CPU. Puoi anche utilizzare una macchina Intel X86 a 64 bit con 8 gigabyte di ram o più (usiamo un c5a.2xl, ma qualsiasi cosa con maggiore di 8 gigabyte su piattaforma x86 dovrebbe funzionare) con Ubuntu 20.04.

- Installa AWS IoT Greengrass V2:

- Installa il sistema necessario e le dipendenze Python 3 (Ubuntu 20.04):

Carica il set di dati e addestra il modello

Usiamo il set di dati di alieni giocattolo per dimostrare la soluzione. Il set di dati contiene immagini normali e anomale. Ecco alcune immagini di esempio dal set di dati.

L'immagine seguente mostra un normale alieno giocattolo.

L'immagine seguente mostra un alieno giocattolo a cui manca una gamba.

L'immagine seguente mostra un alieno giocattolo a cui manca una testa.

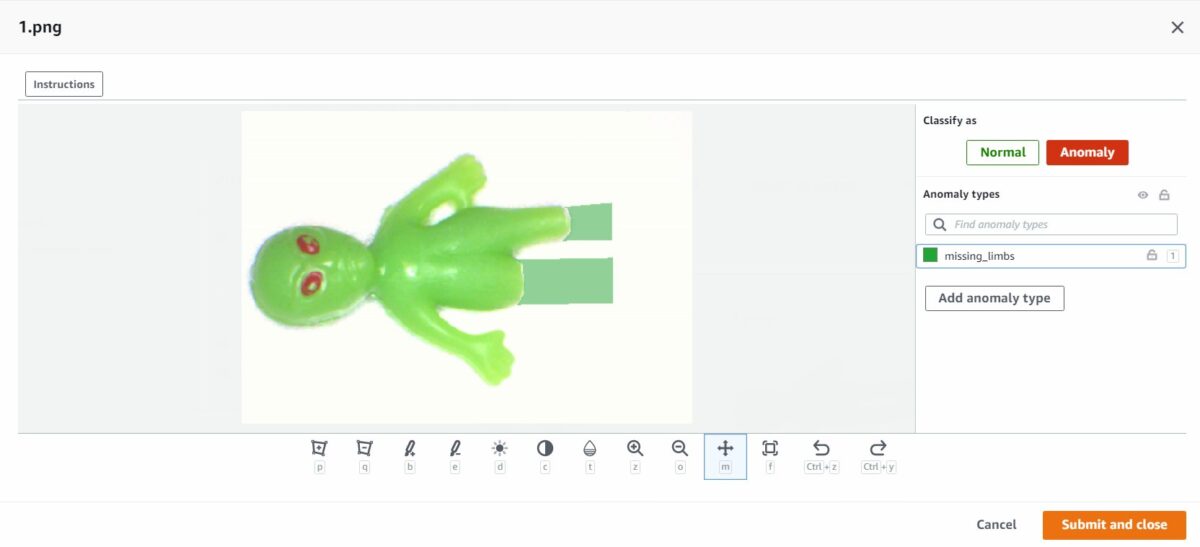

In questo post, cerchiamo gli arti mancanti. Utilizziamo la nuova interfaccia utente per disegnare una maschera attorno ai difetti nei nostri dati di addestramento e test. Questo dirà ai modelli di segmentazione semantica come identificare questo tipo di difetto.

- Inizia caricando il tuo set di dati, tramite Amazon S3 o dal tuo computer.

- Ordinali in cartelle intitolate

normaledanomaly. - Quando crei il tuo set di dati, seleziona Allega automaticamente etichette alle immagini in base al nome della cartella.Questo ci permette di smistare le immagini anomale in un secondo momento e di disegnare nelle aree da etichettare con un difetto.

- Prova a trattenere alcune immagini per testare in seguito entrambe

normaledanomaly. - Dopo che tutte le immagini sono state aggiunte al set di dati, scegli Aggiungi etichette di anomalia.

- Inizia a etichettare i dati scegliendo Inizia a etichettare.

- Per velocizzare il processo, puoi selezionare più immagini e classificarle come

NormalorAnomaly.

Se vuoi evidenziare le anomalie oltre a classificarle, devi evidenziare dove si trovano le anomalie. - Scegli l'immagine che desideri annotare.

- Usa gli strumenti di disegno per mostrare l'area in cui manca una parte del soggetto o disegna una maschera sul difetto.

- Scegli Invia e chiudi per mantenere questi cambiamenti.

- Ripeti questo processo per tutte le tue immagini.

- Quando hai finito, scegli Risparmi per mantenere le tue modifiche. Ora sei pronto per addestrare il tuo modello.

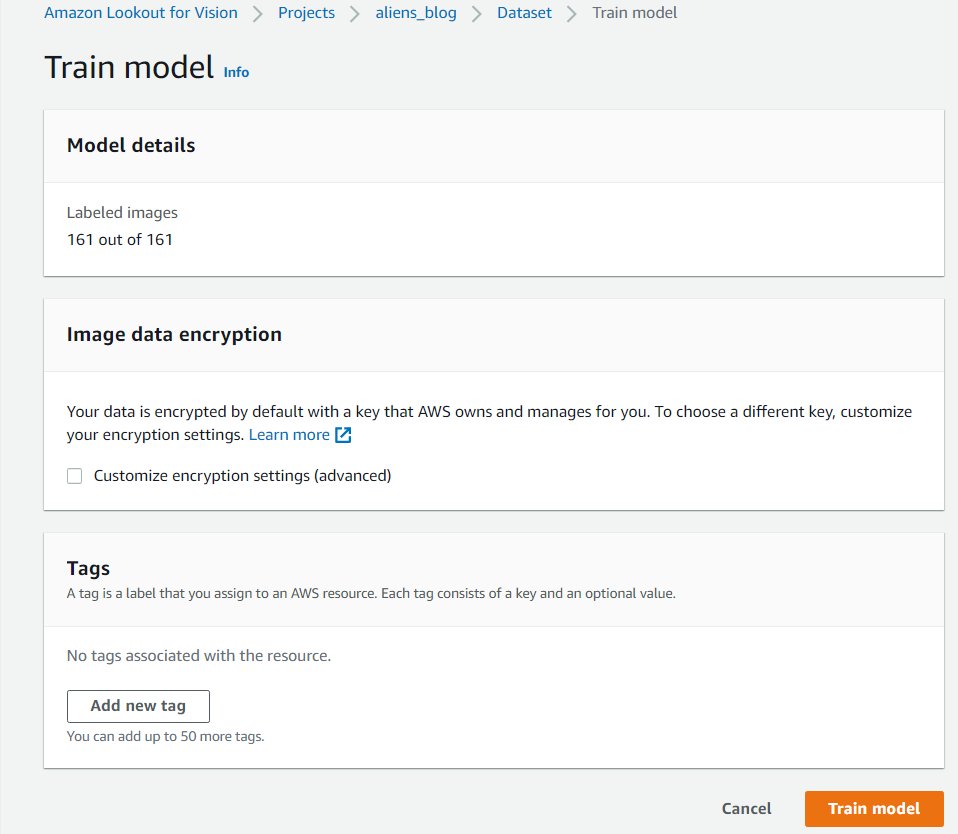

- Scegli Modello di treno.

Dopo aver completato questi passaggi, puoi passare al progetto e al file Modelli pagina per verificare le prestazioni del modello addestrato. È possibile avviare il processo di esportazione del modello nel dispositivo edge di destinazione in qualsiasi momento dopo il training del modello.

Riqualificare il modello con immagini corrette

A volte l'etichettatura delle anomalie potrebbe non essere del tutto corretta. Hai la possibilità di aiutare il tuo modello ad apprendere meglio le tue anomalie. Ad esempio, l'immagine seguente è identificata come un'anomalia, ma non mostra il missing_limbs etichetta.

Apriamo l'editor e risolviamo questo problema.

Scorri tutte le immagini che trovi in questo modo. Se trovi che è stata contrassegnata un'anomalia in modo errato, puoi utilizzare lo strumento gomma per rimuovere il tag errato.

Ora puoi addestrare di nuovo il tuo modello e ottenere una migliore precisione.

Compila e impacchetta il modello come componente AWS IoT Greengrass

In questa sezione, esamineremo i passaggi per compilare il modello di alieno giocattolo sul nostro dispositivo edge target e impacchettare il modello come componente AWS IoT Greengrass.

- Nella console Lookout for Vision, scegli il tuo progetto.

- Nel pannello di navigazione, scegli Pacchetti modello Edge.

- Scegli Crea un lavoro di confezionamento del modello.

- Nel Nome del lavoro, inserisci un nome.

- Nel Descrizione del lavoro, inserisci una descrizione facoltativa.

- Scegli Sfoglia i modelli.

- Seleziona la versione del modello (il modello di alieno giocattolo costruito nella sezione precedente).

- Scegli Scegli.

- Se lo stai eseguendo su Amazon EC2 o un dispositivo X86-64, seleziona Piattaforma di destinazione e scegli Linux, X86e CPU.

Se utilizzi la CPU, puoi lasciare vuote le opzioni del compilatore se non sei sicuro e non hai una GPU NVIDIA. Se disponi di una piattaforma basata su Intel che supporta AVX512, puoi aggiungere queste opzioni del compilatore per ottimizzare e ottenere prestazioni migliori:{"mcpu": "skylake-avx512"}. Puoi vedere il nome e lo stato del tuo lavoro visualizzati come

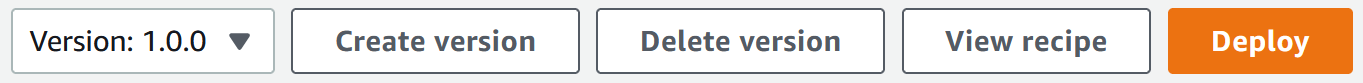

Puoi vedere il nome e lo stato del tuo lavoro visualizzati come In progress. Il completamento del processo di confezionamento del modello potrebbe richiedere alcuni minuti. Quando il processo di confezionamento del modello è completo, lo stato viene visualizzato comeSuccess. - Scegli il nome del tuo lavoro (nel nostro caso è

aliensblogcpux86) per vedere i dettagli del lavoro.

- Scegli Crea un lavoro di confezionamento del modello.

- Inserisci i dettagli per Nome del componente, Descrizione del componente (opzionale), Versione componentee Posizione del componente.Lookout for Vision archivia le ricette e gli artefatti dei componenti in questa posizione Amazon S3.

- Scegli Continua la distribuzione in Greengrass per distribuire il componente al dispositivo perimetrale di destinazione.

Il componente AWS IoT Greengrass e gli artefatti del modello sono stati creati nel tuo account AWS.

Distribuire il modello

Assicurati di aver installato AWS IoT Greengrass V2 sul dispositivo di destinazione per il tuo account prima di continuare. Per istruzioni, fare riferimento a Installa il software AWS IoT Greengrass Core.

In questa sezione, esamineremo i passaggi per distribuire il modello di alieno giocattolo sul dispositivo perimetrale utilizzando la console AWS IoT Greengrass.

- Nella console AWS IoT Greengrass, accedi al tuo dispositivo perimetrale.

- Scegli Schierare per avviare le fasi di distribuzione.

- Seleziona Dispositivo principale (perché la distribuzione è su un singolo dispositivo) e immettere un nome per Nome dell'obiettivo.Il nome di destinazione è lo stesso che hai utilizzato per nominare il dispositivo principale durante il processo di installazione di AWS IoT Greengrass V2.

- Scegli il tuo componente. Nel nostro caso, il nome del componente è

aliensblogcpux86, che contiene il modello di alieno giocattolo. - Scegli Avanti.

- Configurare il componente (opzionale).

- Scegli Avanti.

- Espandere Politiche di distribuzione.

- Nel Politica di aggiornamento dei componenti, selezionare Avvisare i componenti.Ciò consente al componente già distribuito (una versione precedente del componente) di posticipare un aggiornamento finché non sei pronto per l'aggiornamento.

- Nel Politica di gestione dei guasti, selezionare Non tornare indietro.In caso di errore, questa opzione ci consente di indagare sugli errori nella distribuzione.

- Scegli Avanti.

- Esaminare l'elenco dei componenti che verranno distribuiti sul dispositivo di destinazione (edge).

- Scegli Avanti.Dovresti vedere il messaggio

Deployment successfully created. - Per convalidare l'esito positivo della distribuzione del modello, eseguire il comando seguente sul dispositivo perimetrale:

Dovresti vedere un output simile che esegue il file aliensblogcpux86 script di avvio del ciclo di vita:

Componenti attualmente in esecuzione in Greengrass:

Esegui inferenze sul modello

Note:: Se stai eseguendo Greengrass come un altro utente rispetto a quello con cui hai effettuato l'accesso, dovrai modificare le autorizzazioni del file /tmp/aws.iot.lookoutvision.EdgeAgent.sock:

Ora siamo pronti per eseguire inferenze sul modello. Sul tuo dispositivo perimetrale, esegui il comando seguente per caricare il modello (sostituisci con il nome del modello utilizzato nel componente):

Per generare inferenze, eseguire il comando seguente con il nome del file di origine (replace con il percorso e il nome del file dell'immagine da controllare e sostituire con il nome del modello utilizzato per il tuo componente):

Il modello prevede correttamente l'immagine come anomala (missing_limbs) con un punteggio di confidenza di 0.9996867775917053. Ci dice la maschera del tag di anomalia missing_limbs e l'area percentuale. La risposta contiene anche dati bitmap che puoi decodificare di ciò che ha trovato.

Scarica e apri il file blended.png, che assomiglia all'immagine seguente. Notare l'area evidenziata con il difetto intorno alle gambe.

Storie dei clienti

Con AWS IoT Greengrass e Lookout for Vision, ora puoi automatizzare l'ispezione visiva con la visione artificiale per processi come il controllo qualità e la valutazione dei difetti, il tutto al limite e in tempo reale. È possibile identificare in modo proattivo problemi quali danni alle parti (come ammaccature, graffi o scarsa saldatura), componenti del prodotto mancanti o difetti con schemi ripetuti sulla linea di produzione stessa, risparmiando tempo e denaro. Clienti come Tyson e Baxter stanno scoprendo il potere di Lookout for Vision per aumentare la qualità e ridurre i costi operativi automatizzando l'ispezione visiva.

“L'eccellenza operativa è una priorità chiave per Tyson Foods. La manutenzione predittiva è una risorsa essenziale per raggiungere questo obiettivo migliorando continuamente l'efficacia complessiva delle apparecchiature (OEE). Nel 2021, Tyson Foods ha lanciato un progetto di visione artificiale basato sull'apprendimento automatico per identificare i portatori di prodotti difettosi durante la produzione per evitare che influiscano sulla sicurezza, sulle operazioni o sulla qualità del prodotto dei membri del team. I modelli addestrati utilizzando Amazon Lookout for Vision si sono comportati bene. Il modello di rilevamento dei pin ha raggiunto una precisione del 95% in entrambe le classi. Il modello Amazon Lookout for Vision è stato ottimizzato per funzionare con una precisione del 99.1% in caso di rilevamento dei pin non riusciti. Il risultato di gran lunga più entusiasmante di questo progetto è stato l'accelerazione dei tempi di sviluppo. Sebbene questo progetto utilizzi due modelli e un codice applicativo più complesso, il completamento degli sviluppatori ha richiesto il 12% di tempo in meno. Questo progetto per il monitoraggio delle condizioni dei trasportatori di prodotti presso Tyson Foods è stato completato in tempi record utilizzando servizi gestiti da AWS come Amazon Lookout for Vision".

—Audrey Timmerman, sviluppatore di applicazioni senior, Tyson Foods.

“La latenza e la velocità di inferenza sono fondamentali per la valutazione in tempo reale e i controlli di qualità critici dei nostri processi di produzione. Amazon Lookout for Vision edge su un dispositivo CPU ci offre la possibilità di raggiungere questo obiettivo su apparecchiature di livello produttivo, consentendoci di fornire soluzioni di visione AI convenienti su larga scala".

—AK Karan, Global Senior Director – Digital Transformation, Integrated Supply Chain, Baxter International Inc.

Pulire

Completa i seguenti passaggi per rimuovere le risorse che hai creato dal tuo account ed evitare qualsiasi fatturazione in corso:

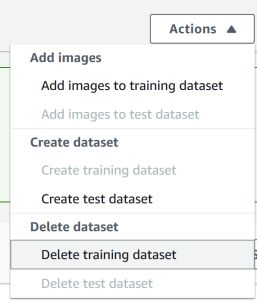

- Nella console Lookout for Vision, vai al tuo progetto.

- Sulla Azioni menu, elimina i set di dati.

- Elimina i tuoi modelli.

- Sulla console Amazon S3, svuota i bucket che hai creato, quindi elimina i bucket.

- Sulla console Amazon EC2, elimina l'istanza in cui hai iniziato a eseguire AWS IoT Greengrass.

- Nella console AWS IoT Greengrass, scegli Distribuzioni nel pannello di navigazione.

- Elimina le versioni dei componenti.

- Sulla console AWS IoT Greengrass, elimina le cose, i gruppi e i dispositivi di AWS IoT.

Conclusione

In questo post, abbiamo descritto uno scenario tipico per il rilevamento di difetti industriali ai margini utilizzando la localizzazione dei difetti e distribuito su un dispositivo solo CPU. Abbiamo esaminato i componenti chiave del ciclo di vita del cloud e dell'edge con un esempio end-to-end utilizzando Lookout for Vision e AWS IoT Greengrass. Con Lookout for Vision, abbiamo addestrato un modello di rilevamento delle anomalie nel cloud utilizzando il set di dati alieni giocattolo, ha compilato il modello su un'architettura di destinazione e ha impacchettato il modello come componente AWS IoT Greengrass. Con AWS IoT Greengrass, abbiamo distribuito il modello su un dispositivo edge. Abbiamo dimostrato un'applicazione di esempio basata su Python che genera immagini aliene giocattolo dal file system locale del dispositivo perimetrale, esegue le inferenze sul modello Lookout for Vision all'edge utilizzando l'interfaccia gRPC e invia i dati di inferenza a un argomento MQTT in AWS Nube.

In un post futuro, mostreremo come eseguire inferenze su un flusso di immagini in tempo reale utilizzando una pipeline multimediale GStreamer.

Inizia il tuo viaggio verso il rilevamento e l'identificazione delle anomalie industriali visitando il Amazon Lookout per la visione ed AWS IoT Greengrass pagine di risorse.

Circa gli autori

Manish Talreja è un Senior Industrial ML Practice Manager con AWS Professional Services. Aiuta i clienti AWS a raggiungere i loro obiettivi di business progettando e costruendo soluzioni innovative che utilizzano i servizi AWS ML e IoT sul cloud AWS.

Manish Talreja è un Senior Industrial ML Practice Manager con AWS Professional Services. Aiuta i clienti AWS a raggiungere i loro obiettivi di business progettando e costruendo soluzioni innovative che utilizzano i servizi AWS ML e IoT sul cloud AWS.

Ryan Vanderwerf è un architetto di soluzioni partner presso Amazon Web Services. In precedenza ha fornito consulenza incentrata sulla macchina virtuale Java e sviluppo di progetti come ingegnere del software presso OCI nel team di Grails e Micronaut. È stato capo architetto/direttore dei prodotti presso ReachForce, con particolare attenzione al software e all'architettura di sistema per le soluzioni AWS Cloud SaaS per la gestione dei dati di marketing. Ryan ha creato diverse soluzioni SaaS in diversi domini come società finanziarie, dei media, delle telecomunicazioni e dell'e-learning dal 1996.

Ryan Vanderwerf è un architetto di soluzioni partner presso Amazon Web Services. In precedenza ha fornito consulenza incentrata sulla macchina virtuale Java e sviluppo di progetti come ingegnere del software presso OCI nel team di Grails e Micronaut. È stato capo architetto/direttore dei prodotti presso ReachForce, con particolare attenzione al software e all'architettura di sistema per le soluzioni AWS Cloud SaaS per la gestione dei dati di marketing. Ryan ha creato diverse soluzioni SaaS in diversi domini come società finanziarie, dei media, delle telecomunicazioni e dell'e-learning dal 1996.

Prakash Krishnan è un Senior Software Development Manager presso Amazon Web Services. Guida i team di ingegneri che stanno costruendo sistemi distribuiti su larga scala per applicare algoritmi veloci, efficienti e altamente scalabili a problemi di riconoscimento di immagini e video basati sul deep learning.

Prakash Krishnan è un Senior Software Development Manager presso Amazon Web Services. Guida i team di ingegneri che stanno costruendo sistemi distribuiti su larga scala per applicare algoritmi veloci, efficienti e altamente scalabili a problemi di riconoscimento di immagini e video basati sul deep learning.

- AI

- oh arte

- generatore d'arte

- un robot

- Amazon Lookout per la visione

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- AWS IoT Greengrass

- Apprendimento automatico di AWS

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- zefiro