Introduzione

Nell'apprendimento automatico, il compromesso tra bias e varianza è un concetto fondamentale che influisce sulle prestazioni di qualsiasi modello predittivo. Si riferisce al delicato equilibrio tra errore di polarizzazione ed errore di varianza di un modello, in quanto è impossibile minimizzare contemporaneamente entrambi. Trovare il giusto equilibrio è fondamentale per ottenere prestazioni ottimali del modello.

In questo breve articolo definiremo bias e varianza, spiegheremo come influenzano un modello di machine learning e forniremo alcuni consigli pratici su come gestirli nella pratica.

Comprensione di bias e varianza

Prima di approfondire la relazione tra bias e varianza, definiamo cosa rappresentano questi termini nell'apprendimento automatico.

L'errore di polarizzazione si riferisce alla differenza tra la previsione di un modello e i valori corretti che tenta di prevedere (verità fondamentale). In altre parole, il bias è l'errore che un modello commette a causa delle sue ipotesi errate sulla distribuzione dei dati sottostanti. I modelli ad alta distorsione sono spesso troppo semplicistici, non riescono a catturare la complessità dei dati, portando a un adattamento insufficiente.

L'errore di varianza, d'altra parte, si riferisce alla sensibilità del modello a piccole fluttuazioni nei dati di addestramento. I modelli ad alta varianza sono eccessivamente complessi e tendono ad adattarsi al rumore nei dati, piuttosto che al modello sottostante, portando all'overfitting. Ciò si traduce in scarse prestazioni su dati nuovi e invisibili.

Un bias elevato può portare a un underfitting, in cui il modello è troppo semplice per catturare la complessità dei dati. Fa forti presupposti sui dati e non riesce a catturare la vera relazione tra variabili di input e output. D'altra parte, un'elevata varianza può portare all'overfitting, in cui il modello è troppo complesso e apprende il rumore nei dati piuttosto che la relazione sottostante tra variabili di input e output. Pertanto, i modelli di overfitting tendono ad adattarsi troppo strettamente ai dati di addestramento e non si generalizzeranno bene ai nuovi dati, mentre i modelli di underfitting non sono nemmeno in grado di adattare accuratamente i dati di addestramento.

Come accennato in precedenza, bias e varianza sono correlati e un buon modello bilancia tra errore di bias ed errore di varianza. Il compromesso bias-variance è il processo per trovare l'equilibrio ottimale tra queste due fonti di errore. Un modello con bassa distorsione e bassa varianza probabilmente funzionerà bene sia sull'addestramento che sui nuovi dati, riducendo al minimo l'errore totale.

Il compromesso Bias-Variance

Raggiungere un equilibrio tra la complessità del modello e la sua capacità di generalizzare a dati sconosciuti è il fulcro del compromesso bias-varianza. In generale, un modello più complesso avrà un bias più basso ma una varianza più alta, mentre un modello più semplice avrà un bias più alto ma una varianza più bassa.

Poiché è impossibile minimizzare contemporaneamente bias e varianza, trovare l'equilibrio ottimale tra di essi è fondamentale per costruire un solido modello di machine learning. Ad esempio, aumentando la complessità di un modello, aumentiamo anche la varianza. Questo perché è più probabile che un modello più complesso si adatti al rumore nei dati di addestramento, il che porterà a un overfitting.

D'altra parte, se manteniamo il modello troppo semplice, aumenteremo il bias. Questo perché un modello più semplice non sarà in grado di catturare le relazioni sottostanti nei dati, il che porterà a un adattamento insufficiente.

L'obiettivo è addestrare un modello sufficientemente complesso da acquisire le relazioni sottostanti nei dati di addestramento, ma non così complesso da adattarsi al rumore nei dati di addestramento.

Compromesso Bias-Variance in pratica

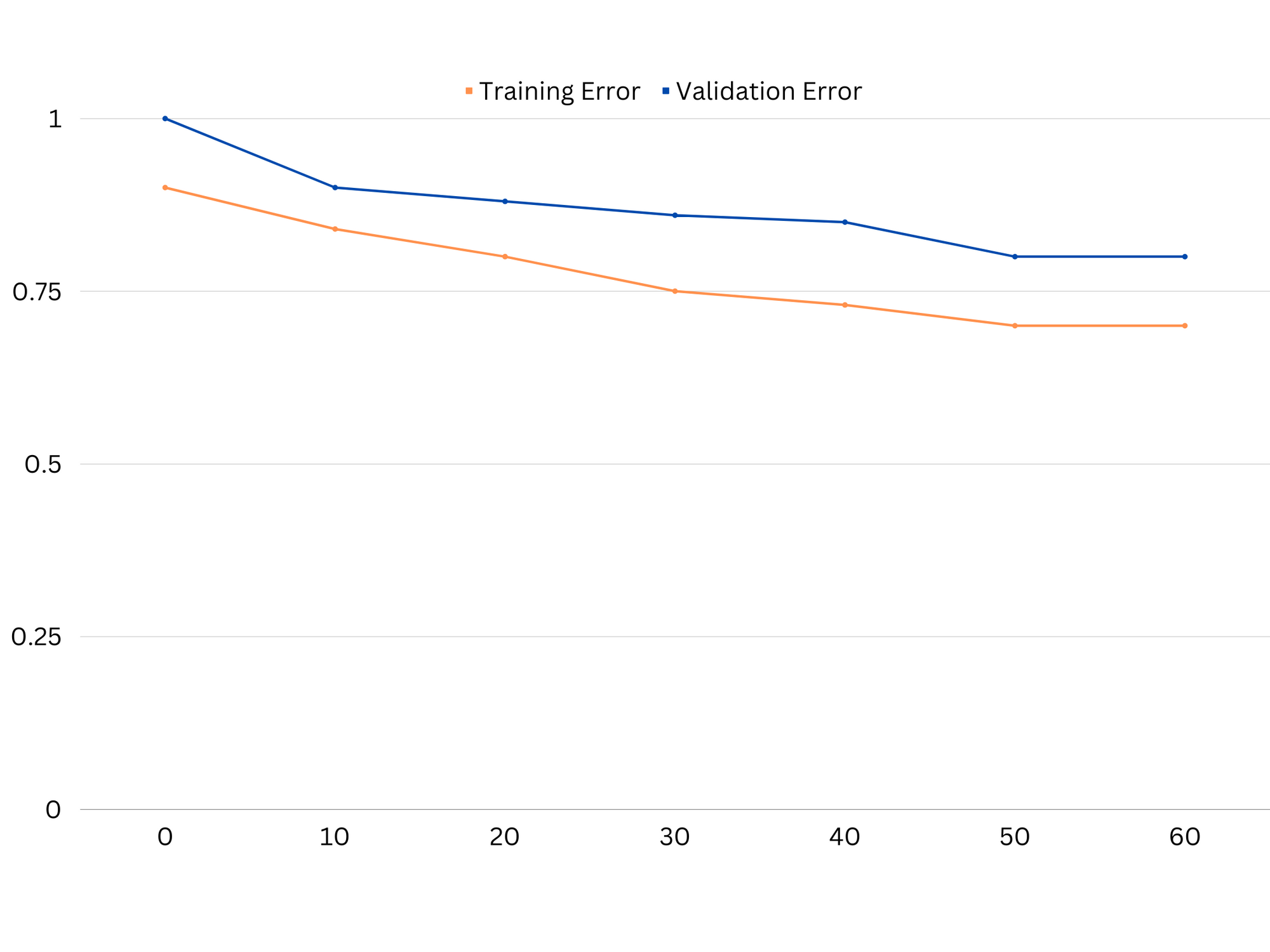

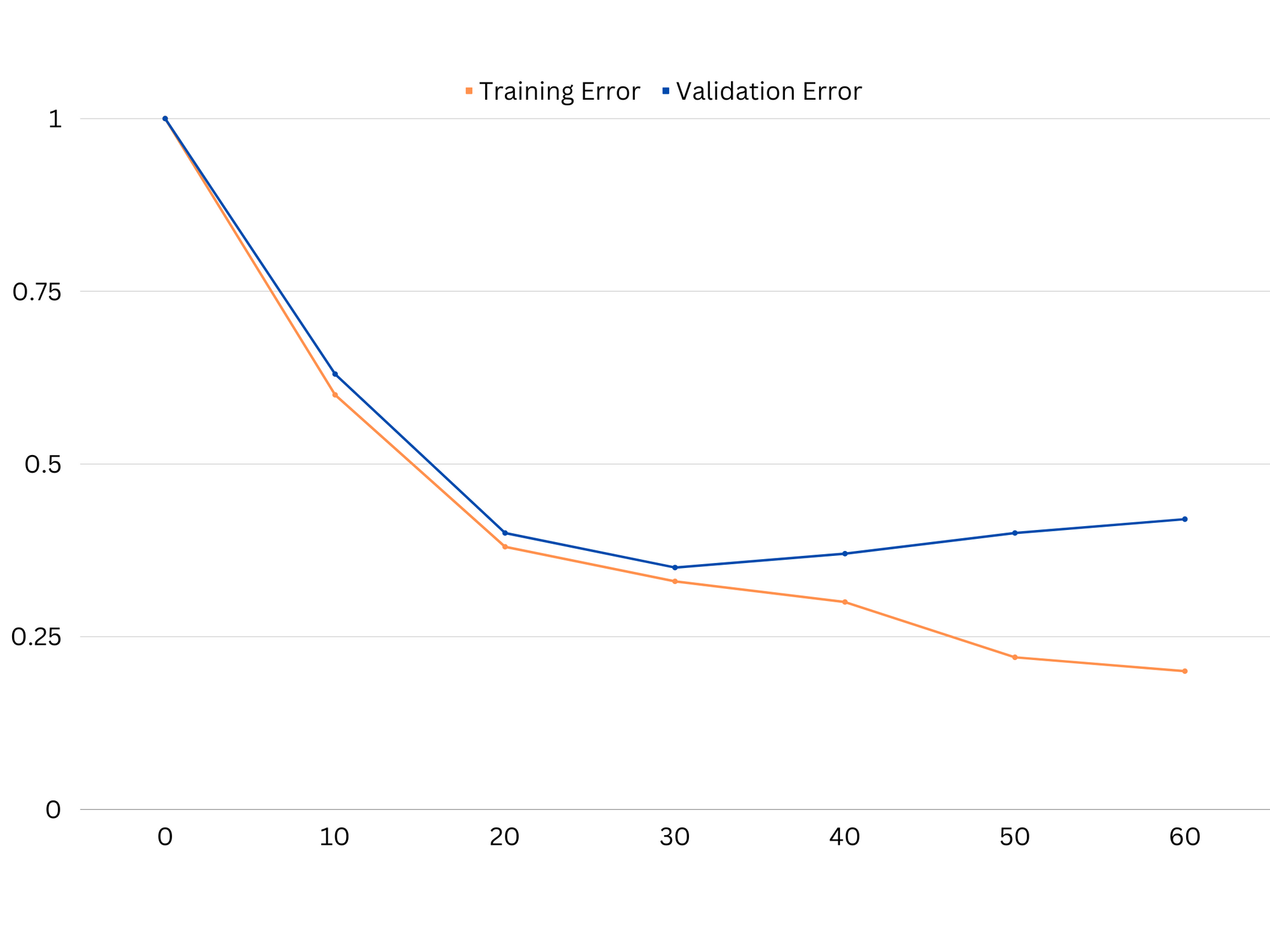

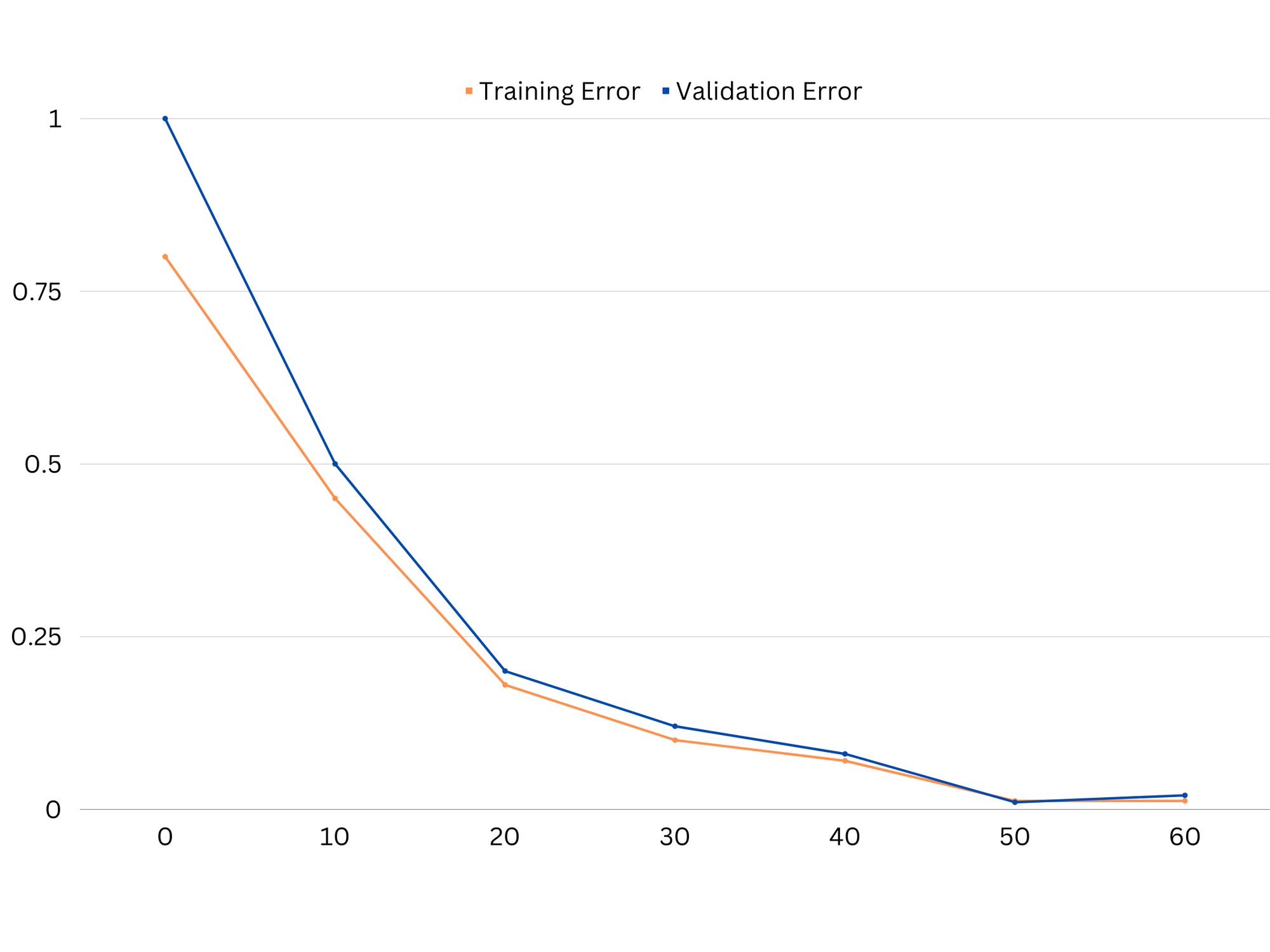

Per diagnosticare le prestazioni del modello, in genere calcoliamo e confrontiamo gli errori di addestramento e convalida. Uno strumento utile per visualizzarlo è un grafico delle curve di apprendimento, che mostra le prestazioni del modello sia sul treno che sui dati di convalida durante tutto il processo di addestramento. Esaminando queste curve, possiamo determinare se un modello è overfitting (alta varianza), underfitting (alta distorsione) o ben adattato (equilibrio ottimale tra bias e varianza).

Esempio di curve di apprendimento di un modello underfitting. Sia l'errore di traino che l'errore di convalida sono alti.

In pratica, le scarse prestazioni sia sui dati di addestramento che di convalida suggeriscono che il modello è troppo semplice, portando a un adattamento insufficiente. D'altra parte, se il modello funziona molto bene sui dati di addestramento ma scarso sui dati di test, è probabile che la complessità del modello sia troppo elevata, con conseguente overfitting. Per affrontare l'underfitting, possiamo provare ad aumentare la complessità del modello aggiungendo più funzionalità, modificando l'algoritmo di apprendimento o scegliendo diversi iperparametri. Nel caso di overfitting, dovremmo prendere in considerazione la regolarizzazione del modello o l'utilizzo di tecniche come la convalida incrociata per migliorare le sue capacità di generalizzazione.

Esempio di curve di apprendimento di un modello di overfitting. L'errore di addestramento diminuisce mentre l'errore di convalida inizia ad aumentare. Il modello non è generalizzabile.

La regolarizzazione è una tecnica che può essere utilizzata per ridurre l'errore di varianza nei modelli di machine learning, aiutando ad affrontare il compromesso tra bias e varianza. Esistono diverse tecniche di regolarizzazione, ognuna con i propri vantaggi e svantaggi. Alcune tecniche di regolarizzazione popolari includono la regressione della cresta, la regressione del lazo e la regolarizzazione della rete elastica. Tutte queste tecniche aiutano a prevenire l'overfitting aggiungendo un termine di penalità alla funzione obiettivo del modello, che scoraggia i valori estremi dei parametri e incoraggia modelli più semplici.

Regressione della cresta, nota anche come regolarizzazione L2, aggiunge un termine di penalizzazione proporzionale al quadrato dei parametri del modello. Questa tecnica tende a produrre modelli con valori di parametro più piccoli, che possono portare a una varianza ridotta e a una migliore generalizzazione. Tuttavia, non esegue la selezione delle funzioni, quindi tutte le funzioni rimangono nel modello.

Dai un'occhiata alla nostra guida pratica e pratica per l'apprendimento di Git, con le migliori pratiche, gli standard accettati dal settore e il cheat sheet incluso. Smetti di cercare su Google i comandi Git e in realtà imparare esso!

Regressione con lazo, o regolarizzazione L1, aggiunge un termine di penalizzazione proporzionale al valore assoluto dei parametri del modello. Questa tecnica può portare a modelli con valori di parametro sparsi, eseguendo in modo efficace la selezione delle funzionalità impostando alcuni parametri su zero. Ciò può portare a modelli più semplici che sono più facili da interpretare.

Regolarizzazione rete elastica è una combinazione di regolarizzazione sia L1 che L2, consentendo un equilibrio tra regressione cresta e lazo. Controllando il rapporto tra i due termini di penalizzazione, la rete elastica può ottenere i vantaggi di entrambe le tecniche, come una migliore generalizzazione e selezione delle caratteristiche.

Esempio di curve di apprendimento del modello di buon adattamento.

Conclusioni

Il compromesso bias-varianza è un concetto cruciale nell'apprendimento automatico che determina l'efficacia e la bontà di un modello. Mentre un bias elevato porta a underfitting e un'alta varianza porta a overfitting, trovare l'equilibrio ottimale tra i due è necessario per costruire modelli robusti che si generalizzino bene ai nuovi dati.

Con l'aiuto delle curve di apprendimento, è possibile identificare i problemi di overfitting o underfitting e, regolando la complessità del modello o implementando tecniche di regolarizzazione, è possibile migliorare le prestazioni sia sui dati di addestramento e convalida, sia sui dati di test.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Acquista e vendi azioni in società PRE-IPO con PREIPO®. Accedi qui.

- Fonte: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :È

- :non

- :Dove

- 1

- 12

- 20

- 8

- a

- capacità

- capace

- WRI

- Assoluta

- con precisione

- Raggiungere

- il raggiungimento

- effettivamente

- l'aggiunta di

- indirizzo

- Aggiunge

- vantaggi

- consigli

- influenzare

- che interessano

- algoritmo

- Tutti

- Consentire

- anche

- an

- ed

- in qualsiasi

- SONO

- articolo

- AS

- Equilibrio

- saldi

- BE

- perché

- vantaggi

- fra

- pregiudizio

- sistema

- entrambi

- Costruzione

- ma

- by

- calcolare

- Materiale

- funzionalità

- catturare

- Custodie

- cambiando

- la scelta

- strettamente

- combinazione

- confrontare

- complesso

- complessità

- concetto

- Prendere in considerazione

- controllo

- Nucleo

- correggere

- cruciale

- dati

- affare

- diminuisce

- Determinare

- determina

- differenza

- diverso

- display

- distribuzione

- effettua

- dovuto

- ogni

- In precedenza

- più facile

- in maniera efficace

- efficacia

- incoraggia

- abbastanza

- errore

- errori

- Anche

- esaminando

- esempio

- Spiegare

- estremo

- in mancanza di

- fallisce

- caratteristica

- Caratteristiche

- ricerca

- in forma

- adatto

- fluttuazioni

- Focus

- Nel

- function

- fondamentale

- Generale

- Idiota

- scopo

- buono

- Terra

- guida

- cura

- mani su

- Avere

- Aiuto

- aiutare

- Alta

- superiore

- librarsi

- Come

- Tutorial

- Tuttavia

- HTTPS

- identificare

- if

- Implementazione

- impossibile

- competenze

- migliorata

- in

- In altre

- includere

- incluso

- Aumento

- crescente

- ingresso

- ai miglioramenti

- Introduzione

- IT

- SUO

- mantenere

- conosciuto

- L1

- l2

- portare

- principale

- Leads

- apprendimento

- lasciare

- LG

- piace

- probabile

- ll

- Basso

- inferiore

- macchina

- machine learning

- FA

- menzionato

- minimizzando

- modello

- modelli

- Scopri di più

- necessaria

- rete

- New

- Rumore

- numero

- obiettivo

- of

- di frequente

- on

- ottimale

- or

- Altro

- nostro

- su

- produzione

- proprio

- parametro

- parametri

- Cartamodello

- Eseguire

- performance

- esecuzione

- esegue

- Platone

- Platone Data Intelligence

- PlatoneDati

- povero

- Popolare

- possibile

- Pratico

- pratica

- predire

- predizione

- prevenire

- problemi

- processi

- fornire

- piuttosto

- rapporto

- ridurre

- Ridotto

- si riferisce

- relazionato

- rapporto

- Relazioni

- rimanere

- rappresentare

- colpevole

- risultante

- Risultati

- destra

- Anello

- robusto

- s

- prodotti

- Sensibilità

- regolazione

- Shadow

- foglio

- Corti

- dovrebbero

- Un'espansione

- contemporaneamente

- piccole

- inferiore

- So

- alcuni

- fonti

- quadrato

- Impilamento

- standard

- Fermare

- forte

- tale

- suggerisce

- tecniche

- termine

- condizioni

- test

- di

- che

- Il

- loro

- Li

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- per tutto

- a

- pure

- Totale

- Treni

- Training

- transizione

- vero

- Verità

- prova

- seconda

- tipicamente

- incapace

- sottostante

- Sconosciuto

- utilizzato

- utilizzando

- convalida

- APPREZZIAMO

- Valori

- molto

- we

- WELL

- Che

- se

- quale

- while

- volere

- con

- parole

- zefiro

- zero