Man mano che sempre più organizzazioni adottano tecnologie di intelligenza artificiale generativa, per creare presentazioni, completare domande di sovvenzione e scrivere codice standard — i team di sicurezza si stanno rendendo conto della necessità di affrontare una nuova domanda: come si proteggono gli strumenti di intelligenza artificiale?

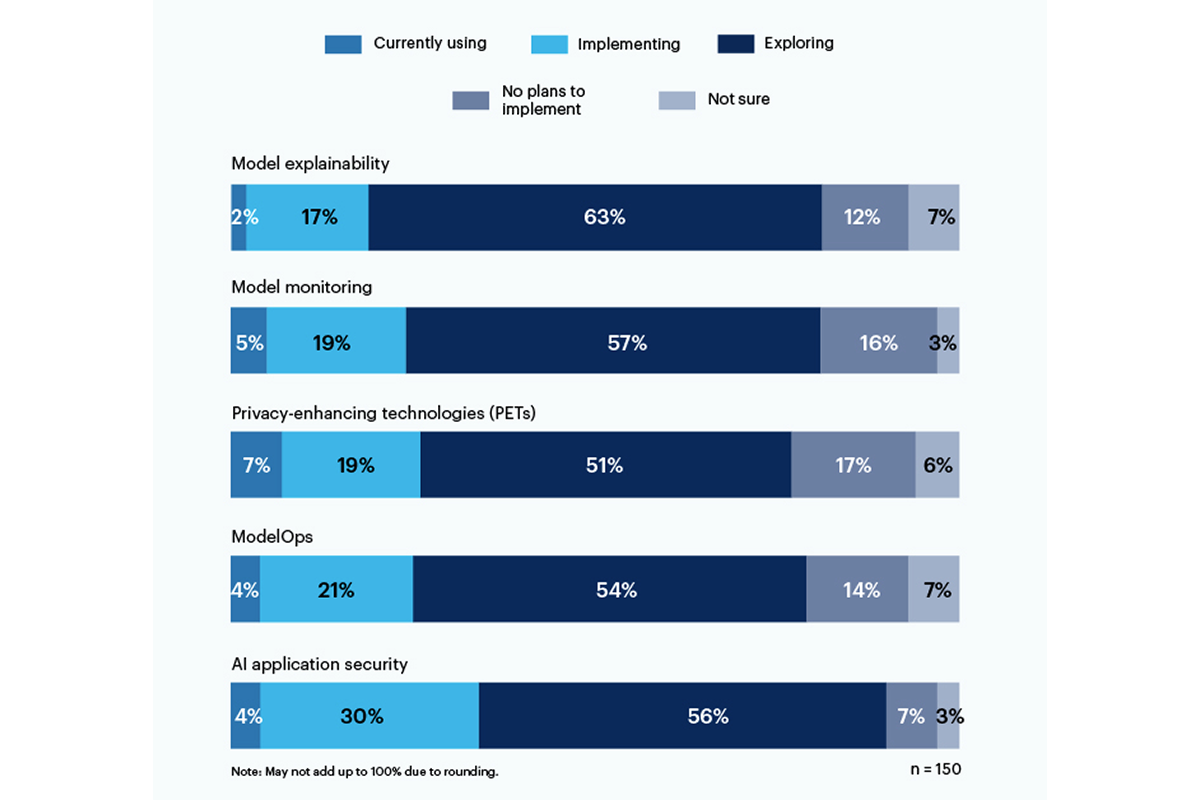

Un terzo degli intervistati in un recente sondaggio di Gartner ha riferito entrambe le cose utilizzando o implementando strumenti di sicurezza delle applicazioni basati sull'intelligenza artificiale per affrontare i rischi posti dall’uso dell’intelligenza artificiale generativa nella loro organizzazione.

Le tecnologie di miglioramento della privacy (PET) hanno mostrato il maggiore utilizzo attuale, presso il 7% degli intervistati, con un solido 19% di aziende che le implementano; questa categoria include modi per proteggere i dati personali, come ad esempio crittografia omomorfica, Dati sintetici generati dall'intelligenza artificiale, calcolo sicuro multipartitico, apprendimento federatoe privacy differenziale. Tuttavia, un buon 17% non ha intenzione di introdurre la PET nel proprio ambiente.

Solo il 19% utilizza o implementa strumenti per la spiegabilità dei modelli, ma c’è un interesse significativo (56%) tra gli intervistati nell’esplorare e comprendere questi strumenti per affrontare il rischio dell’IA generativa. Secondo Gartner, la spiegabilità, il monitoraggio dei modelli e gli strumenti di sicurezza delle applicazioni IA possono essere utilizzati su modelli open source o proprietari per ottenere l'affidabilità e l'affidabilità di cui gli utenti aziendali hanno bisogno.

I rischi che preoccupano maggiormente gli intervistati includono risultati errati o distorti (58%) e vulnerabilità o segreti trapelati nel codice generato dall’intelligenza artificiale (57%). Significativamente, il 43% ha citato potenziali problemi di copyright o di licenza derivanti dai contenuti generati dall’intelligenza artificiale come i principali rischi per la propria organizzazione.

“Non c’è ancora trasparenza sui modelli di dati su cui si sta formando, quindi il rischio associato a bias e privacy è molto difficile da comprendere e stimare”, ha scritto un dirigente di alto livello in risposta al sondaggio di Gartner.

Nel mese di giugno, l'Istituto Nazionale di Standard e Tecnologia (NIST) ha lanciato un gruppo di lavoro pubblico per aiutare a rispondere a questa domanda, sulla base del suo quadro di gestione del rischio AI di gennaio. Come mostrano i dati Gartner, le aziende non aspettano per le direttive NIST.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :È

- :non

- 7

- a

- WRI

- Secondo

- Raggiungere

- indirizzo

- adottare

- AI

- Tutti

- tra

- ed

- Applicazioni

- sicurezza delle applicazioni

- applicazioni

- SONO

- AS

- associato

- At

- basato

- BE

- pregiudizio

- parziale

- ma

- by

- C-suite

- Materiale

- Categoria

- citato

- codice

- Aziende

- completamento di una

- interessato

- contenuto

- copyright

- artigianali

- Corrente

- dati

- difficile

- direttive

- do

- o

- Impresa

- Ambiente

- stima

- esecutivo

- Esplorare

- Nel

- Contesto

- da

- Gartner

- generativo

- AI generativa

- concedere

- maggiore

- Avere

- Aiuto

- Come

- Tuttavia

- HTTPS

- Implementazione

- in

- includere

- inclusi

- Istituto

- interesse

- sicurezza

- IT

- SUO

- Gennaio

- giugno

- lanciato

- Licenze

- gestione

- metodi

- modello

- modelli

- monitoraggio

- Scopri di più

- maggior parte

- multiplo

- il

- Bisogno

- New

- nista

- no

- of

- on

- aprire

- open source

- or

- organizzazione

- organizzazioni

- cronologia

- dati personali

- Animali

- piazzole

- piani

- Platone

- Platone Data Intelligence

- PlatoneDati

- posto

- potenziale

- Privacy

- proprio

- protegge

- la percezione

- domanda

- realizzando

- recente

- problemi di

- fare affidamento

- Segnalati

- intervistati

- risposta

- Rischio

- gestione del rischio

- rischi

- segreti

- sicuro

- problemi di

- ha mostrato

- Spettacoli

- significativa

- significativamente

- So

- solido

- Fonte

- standard

- Ancora

- tale

- Indagine

- sintetico

- le squadre

- Tecnologie

- Tecnologia

- che

- Il

- loro

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- questo

- a

- strumenti

- top

- Training

- Trasparenza

- attendibilità

- capire

- e una comprensione reciproca

- uso

- utilizzato

- utenti

- utilizzando

- molto

- vulnerabilità

- modi

- con

- lavoro

- scrivere

- ha scritto

- Tu

- zefiro